DifFlow3D:場(chǎng)景流估計(jì)新SOTA,擴(kuò)散模型又下一城!

本文經(jīng)自動(dòng)駕駛之心公眾號(hào)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請(qǐng)聯(lián)系出處。

原標(biāo)題:DifFlow3D: Toward Robust Uncertainty-Aware Scene Flow Estimation with Iterative Diffusion-Based Refinement

論文鏈接:https://arxiv.org/pdf/2311.17456.pdf

代碼鏈接:https://github.com/IRMVLab/DifFlow3D

作者單位:上海交通大學(xué) 劍橋大學(xué) 浙江大學(xué) 鑒智機(jī)器人

論文思路:

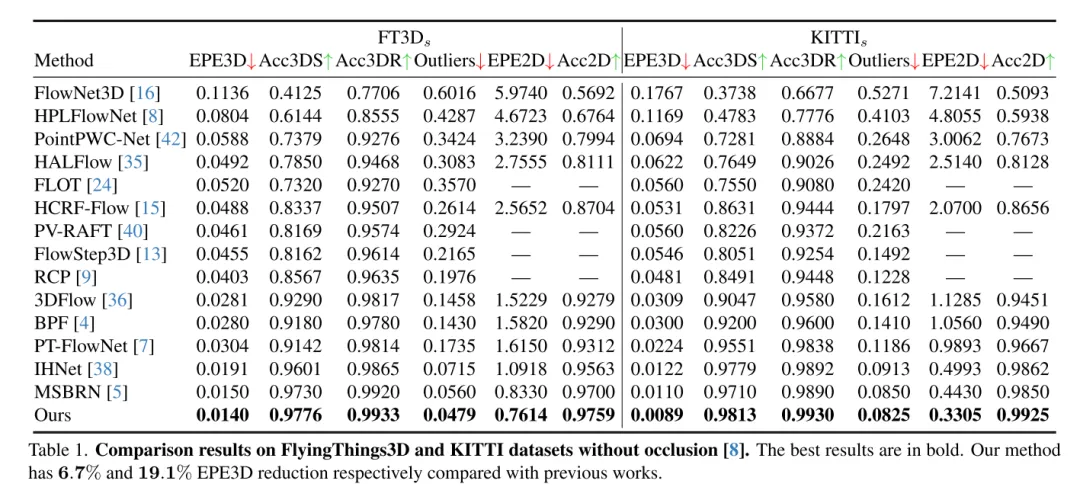

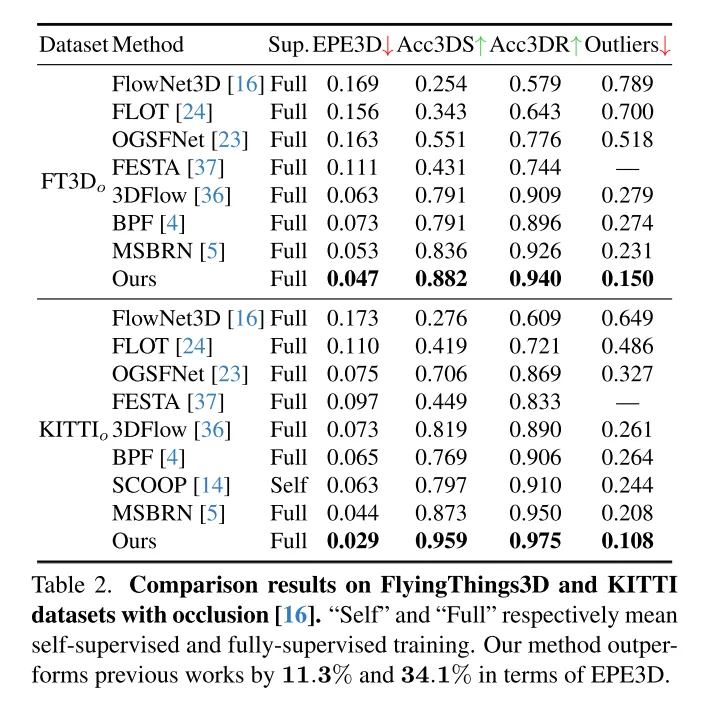

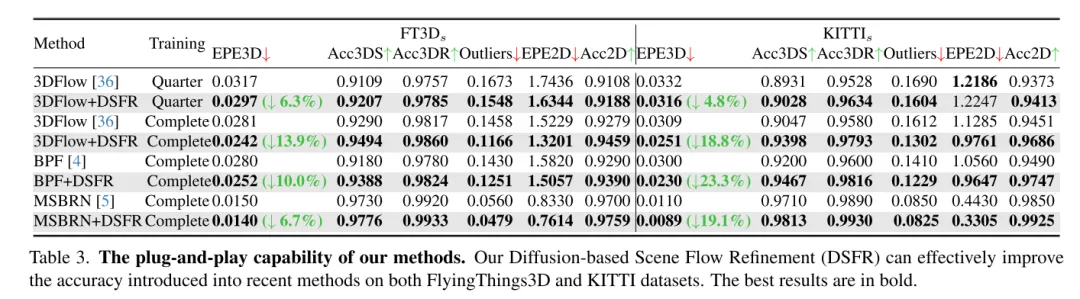

場(chǎng)景流估計(jì)旨在預(yù)測(cè)動(dòng)態(tài)場(chǎng)景中每個(gè)點(diǎn)的3D位移變化,是計(jì)算機(jī)視覺(jué)領(lǐng)域的一個(gè)基礎(chǔ)任務(wù)。然而,以往的工作常常受到局部約束搜索范圍引起的不可靠相關(guān)性的困擾,并且在從粗到細(xì)的結(jié)構(gòu)中積累不準(zhǔn)確性。為了緩解這些問(wèn)題,本文提出了一種新穎的不確定性感知場(chǎng)景流估計(jì)網(wǎng)絡(luò)(DifFlow3D),該網(wǎng)絡(luò)采用了擴(kuò)散概率模型。設(shè)計(jì)了迭代擴(kuò)散式細(xì)化(Iterative diffusion-based refinement)來(lái)增強(qiáng)相關(guān)性的魯棒性,并對(duì)困難情況(例如動(dòng)態(tài)、噪聲輸入、重復(fù)模式等)具有較強(qiáng)的適應(yīng)性。為了限制生成的多樣性,本文的擴(kuò)散模型中利用了三個(gè)關(guān)鍵的與流相關(guān)的特征作為條件。此外,本文還在擴(kuò)散中開(kāi)發(fā)了一個(gè)不確定性估計(jì)模塊,以評(píng)估估計(jì)場(chǎng)景流的可靠性。本文的 DifFlow3D 在 FlyingThings3D 和 KITTI 2015 數(shù)據(jù)集上分別實(shí)現(xiàn)了6.7%和19.1%的三維端點(diǎn)誤差(EPE3D)降低,并在KITTI數(shù)據(jù)集上實(shí)現(xiàn)了前所未有的毫米級(jí)精度(EPE3D為0.0089米)。另外,本文的基于擴(kuò)散的細(xì)化范式可以作為一個(gè)即插即用的模塊,輕松集成到現(xiàn)有的場(chǎng)景流網(wǎng)絡(luò)中,顯著提高它們的估計(jì)精度。

主要貢獻(xiàn):

為了實(shí)現(xiàn)魯棒的場(chǎng)景流估計(jì),本文提出了一種新穎的即插即用型基于擴(kuò)散的細(xì)化流程。據(jù)本文所知,這是首次在場(chǎng)景流任務(wù)中利用擴(kuò)散概率模型。

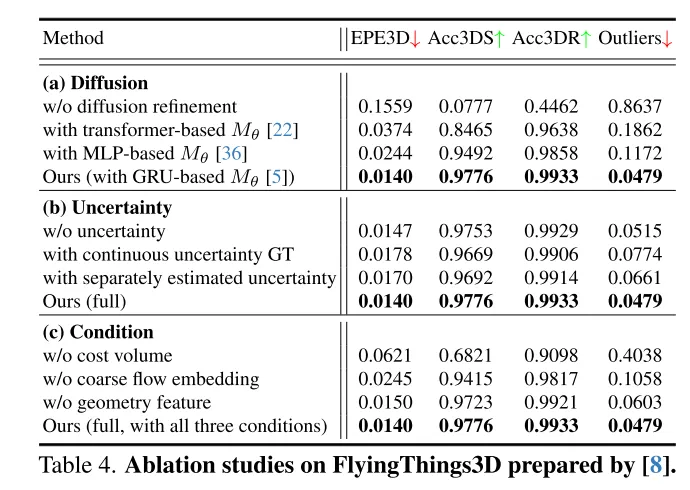

本文通過(guò)結(jié)合粗流嵌入、幾何編碼和跨幀成本體積(coarse flow embeddings, geometry encoding, cross-frame cost volume),設(shè)計(jì)了強(qiáng)有力的條件引導(dǎo)來(lái)控制生成的多樣性。

為了評(píng)估本文估計(jì)流的可靠性并識(shí)別不準(zhǔn)確的點(diǎn)匹配,本文還在本文的擴(kuò)散模型中引入了每個(gè)點(diǎn)的不確定性估計(jì)。

本文的方法在 FlyingThings3D 和 KITTI 數(shù)據(jù)集上均優(yōu)于所有現(xiàn)有方法。特別是,本文的 DifFlow3D 首次在 KITTI 數(shù)據(jù)集上實(shí)現(xiàn)了毫米級(jí)的端點(diǎn)誤差(EPE3D)。與以往的工作相比,本文的方法對(duì)于具有挑戰(zhàn)性的情況具有更強(qiáng)的魯棒性,例如噪聲輸入、動(dòng)態(tài)變化等。

網(wǎng)絡(luò)設(shè)計(jì):

場(chǎng)景流作為計(jì)算機(jī)視覺(jué)中的一項(xiàng)基礎(chǔ)任務(wù),指的是從連續(xù)的圖像或點(diǎn)云中估計(jì)出的三維運(yùn)動(dòng)場(chǎng)。它為動(dòng)態(tài)場(chǎng)景的低層次感知提供了信息,并且有著各種下游應(yīng)用,例如自動(dòng)駕駛[21]、姿態(tài)估計(jì)[9]和運(yùn)動(dòng)分割[1]。早期的工作集中在使用立體[12]或RGB-D圖像[10]作為輸入。隨著3D傳感器,例如激光雷達(dá)的日益普及,近期的工作通常直接以點(diǎn)云作為輸入。

作為開(kāi)創(chuàng)性的工作,F(xiàn)lowNet3D[16]使用 PointNet++[25] 提取層次化特征,然后迭代回歸場(chǎng)景流。PointPWC[42] 通過(guò)金字塔、變形和成本體積結(jié)構(gòu)[31]進(jìn)一步改進(jìn)了它。HALFlow[35] 跟隨它們,并引入了注意力機(jī)制以獲得更好的流嵌入。然而,這些基于回歸的工作通常遭受不可靠的相關(guān)性和局部最優(yōu)問(wèn)題[17]。原因主要有兩個(gè)方面:(1)在他們的網(wǎng)絡(luò)中,使用K最近鄰(KNN)來(lái)搜索點(diǎn)對(duì)應(yīng)關(guān)系,這并不能考慮到正確但距離較遠(yuǎn)的點(diǎn)對(duì),也存在匹配噪聲[7]。(2)另一個(gè)潛在問(wèn)題來(lái)自于以往工作[16, 35, 36, 42]中廣泛使用的粗到細(xì)結(jié)構(gòu)。基本上,最初的流在最粗糙的層上估計(jì),然后在更高分辨率中迭代細(xì)化。然而,流細(xì)化的性能高度依賴于初始粗流的可靠性,因?yàn)楹罄m(xù)的細(xì)化通常受限于初始化周?chē)男〉目臻g范圍內(nèi)。

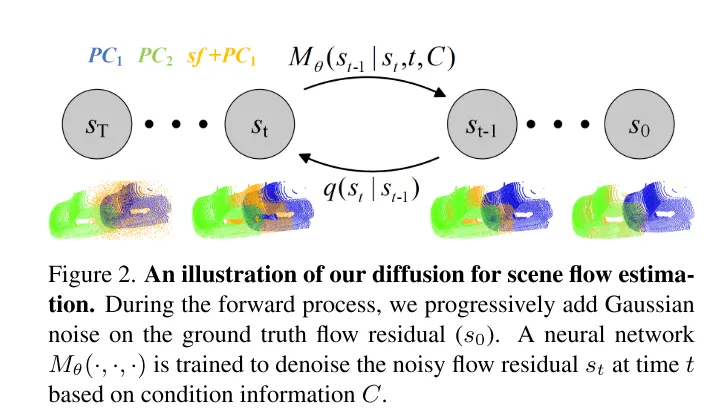

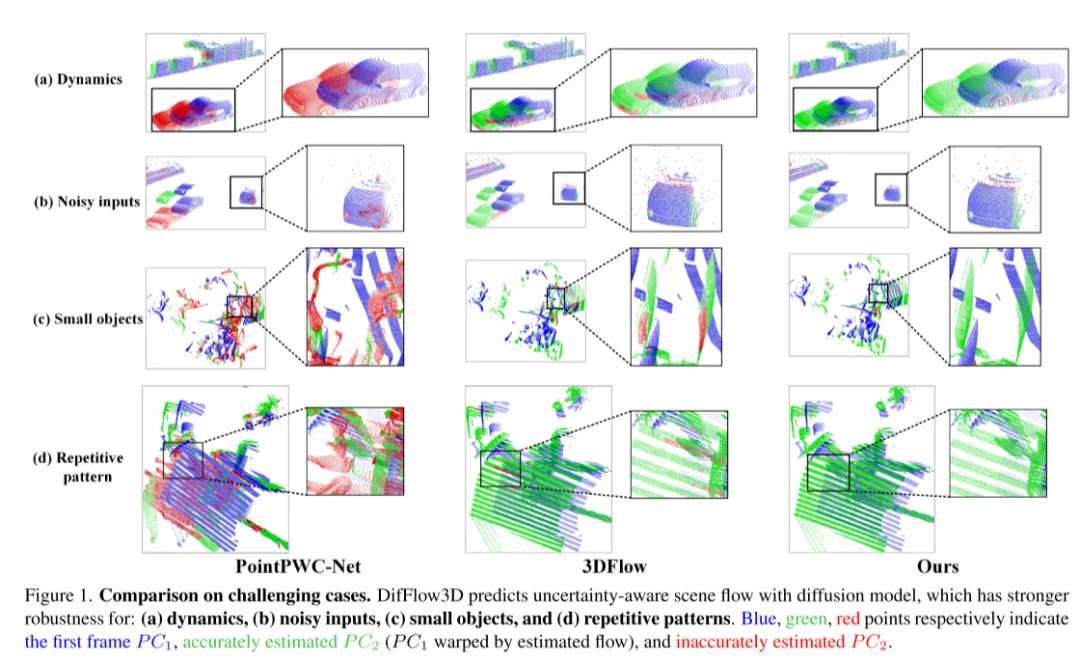

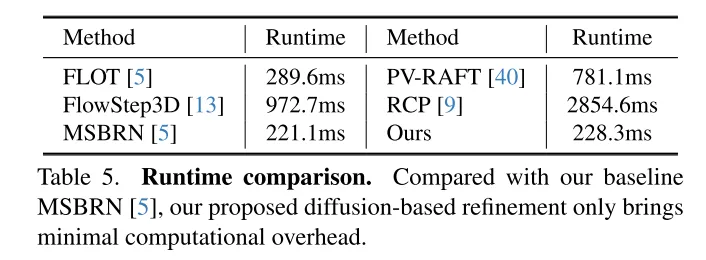

為了解決不可靠性的問(wèn)題,3DFlow[36] 設(shè)計(jì)了一個(gè) all-to-all 的點(diǎn)收集模塊,并加入了反向驗(yàn)證。類(lèi)似地,Bi-PointFlowNet[4] 及其擴(kuò)展MSBRN[5] 提出了一個(gè)雙向網(wǎng)絡(luò),具有前向-后向相關(guān)性。IHNet[38] 利用一個(gè)帶有高分辨率引導(dǎo)和重采樣方案的循環(huán)網(wǎng)絡(luò)。然而,這些網(wǎng)絡(luò)大多因其雙向關(guān)聯(lián)或循環(huán)迭代而在計(jì)算成本上遇到了困難。本文發(fā)現(xiàn)擴(kuò)散模型也可以增強(qiáng)相關(guān)性的可靠性和對(duì)匹配噪聲的韌性,這得益于其去噪本質(zhì)(如圖1所示)。受到[30]中的發(fā)現(xiàn)的啟發(fā),即注入隨機(jī)噪聲有助于跳出局部最優(yōu),本文用概率擴(kuò)散模型重新構(gòu)建了確定性流回歸任務(wù)(deterministic flow regression task),如圖2所示。此外,本文的方法可以作為一個(gè)即插即用的模塊服務(wù)于先前的場(chǎng)景流網(wǎng)絡(luò),這種方法更為通用,并且?guī)缀醪辉黾佑?jì)算成本(第4.5節(jié))。

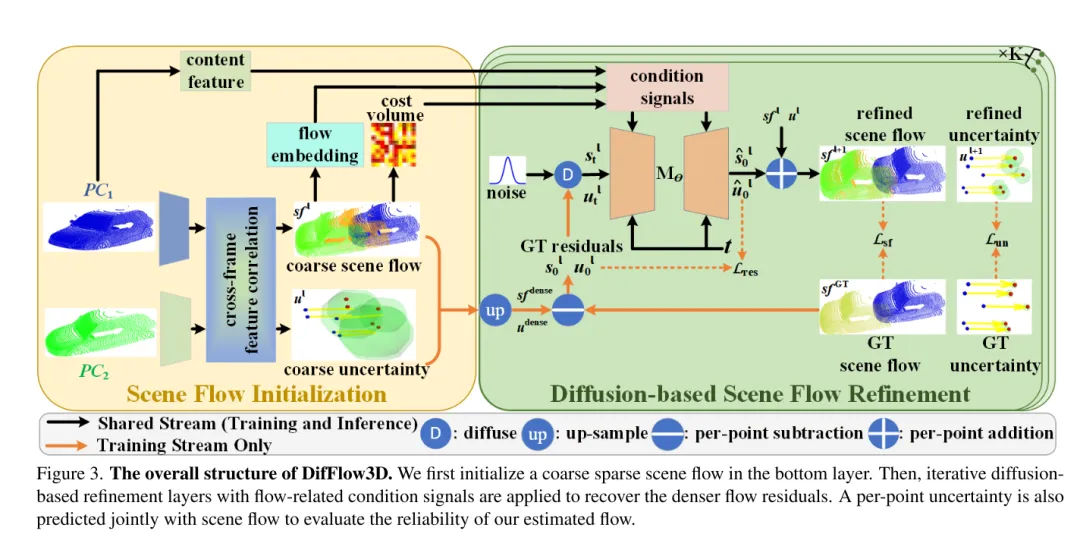

然而,在本文的任務(wù)中利用生成模型是相當(dāng)具有挑戰(zhàn)性的,因?yàn)閿U(kuò)散模型固有的生成多樣性。與需要多樣化輸出樣本的點(diǎn)云生成任務(wù)不同,場(chǎng)景流預(yù)測(cè)是一個(gè)確定性任務(wù),它計(jì)算精確的每點(diǎn)運(yùn)動(dòng)向量。為了解決這個(gè)問(wèn)題,本文利用強(qiáng)條件信息來(lái)限制多樣性,并有效控制生成的流。具體來(lái)說(shuō),首先初始化一個(gè)粗糙的稀疏場(chǎng)景流,然后通過(guò)擴(kuò)散迭代生成流殘差(flow residuals)。在每個(gè)基于擴(kuò)散的細(xì)化層中,本文利用粗流嵌入、成本體積和幾何編碼作為條件。在這種情況下,擴(kuò)散被應(yīng)用于實(shí)際學(xué)習(xí)從條件輸入到流殘差的概率映射。

此外,先前的工作很少探索場(chǎng)景流估計(jì)的置信度和可靠性。然而,如圖1所示,在噪聲、動(dòng)態(tài)變化、小物體和重復(fù)模式的情況下,密集流匹配容易出錯(cuò)。因此,了解每個(gè)估計(jì)的點(diǎn)對(duì)應(yīng)關(guān)系是否可靠是非常重要的。受到最近在光流任務(wù)中不確定性估計(jì)成功的啟發(fā)[33],本文在擴(kuò)散模型中提出了逐點(diǎn)不確定性,以評(píng)估本文的場(chǎng)景流估計(jì)的可靠性。

圖3。DifFlow3D 的總體結(jié)構(gòu)。本文首先在 bottom layer 初始化一個(gè)粗糙的稀疏場(chǎng)景流。隨后,將迭代擴(kuò)散式細(xì)化層與流相關(guān)的條件信號(hào)結(jié)合使用,以恢復(fù)更密集的流殘差。為了評(píng)估本文估計(jì)的流的可靠性,還將與場(chǎng)景流一起聯(lián)合預(yù)測(cè)每個(gè)點(diǎn)的不確定性。

圖2。本文用于場(chǎng)景流估計(jì)的擴(kuò)散過(guò)程示意圖。

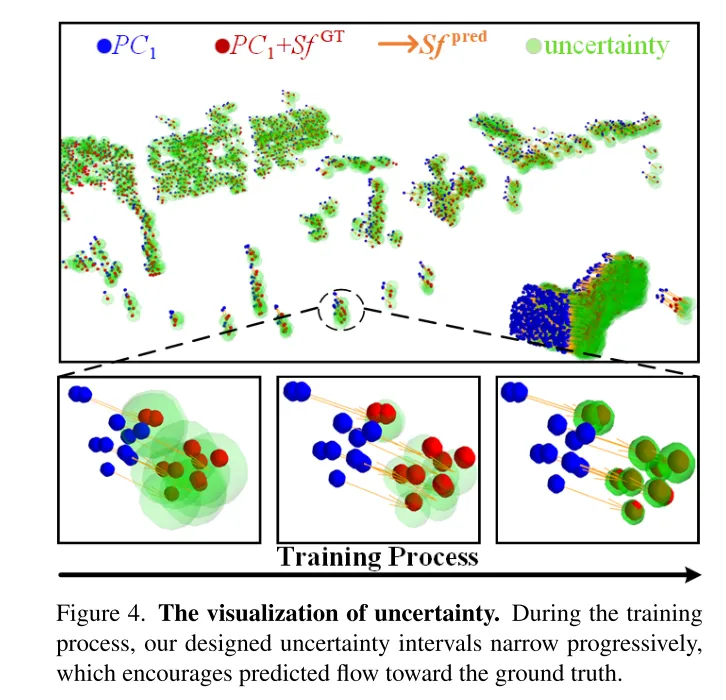

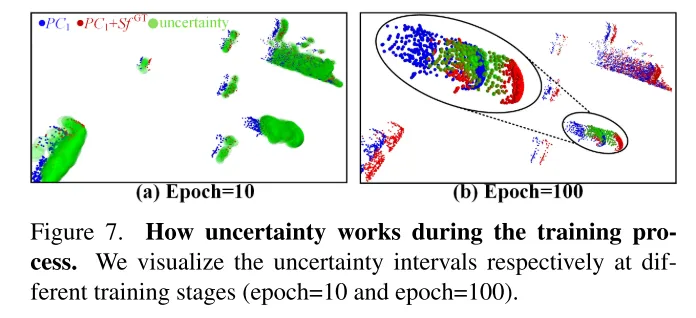

圖4。不確定性的可視化。在訓(xùn)練過(guò)程中,本文設(shè)計(jì)的不確定性區(qū)間逐漸縮小,這促使預(yù)測(cè)的流向真實(shí)值靠攏。

實(shí)驗(yàn)結(jié)果:

圖1。在具有挑戰(zhàn)性的情況下的比較。DifFlow3D 使用擴(kuò)散模型預(yù)測(cè)具有不確定性感知的場(chǎng)景流,該模型對(duì)以下情況具有更強(qiáng)的魯棒性:(a)動(dòng)態(tài)變化,(b)噪聲干擾的輸入,(c)小物體,以及(d)重復(fù)模式。

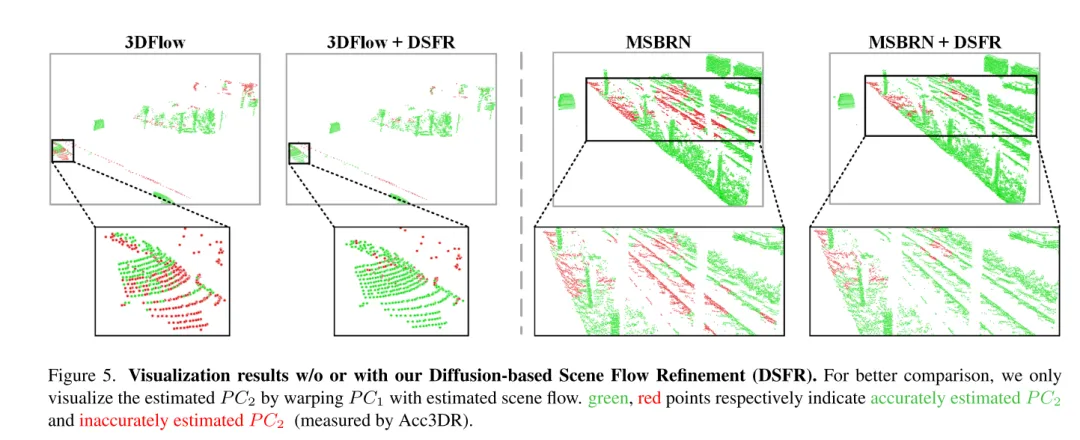

圖 5. 未使用或使用基于擴(kuò)散的場(chǎng)景流細(xì)化 (DSFR) 的可視化結(jié)果。

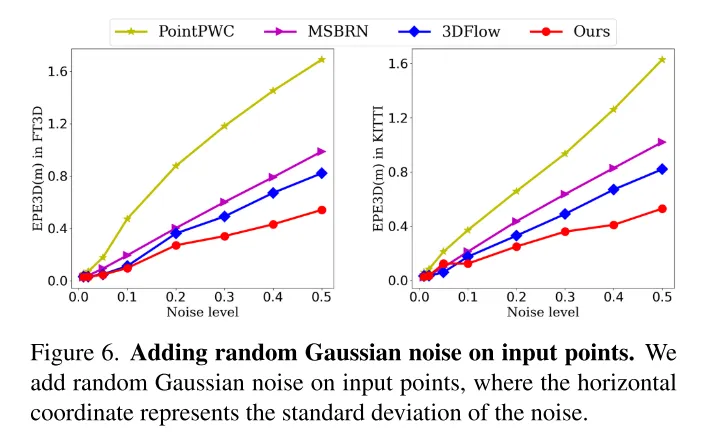

圖6。在輸入點(diǎn)上添加隨機(jī)高斯噪聲。

圖7。不確定性在訓(xùn)練過(guò)程中的作用。本文分別在不同的訓(xùn)練階段(第10輪和第100輪)可視化了不確定性區(qū)間。

總結(jié):

本文創(chuàng)新性地提出了一個(gè)基于擴(kuò)散的場(chǎng)景流細(xì)化網(wǎng)絡(luò),該網(wǎng)絡(luò)能夠感知估計(jì)的不確定性。本文采用多尺度擴(kuò)散細(xì)化來(lái)生成細(xì)粒度的密集流殘差。為了提高估計(jì)的魯棒性,本文還引入了與場(chǎng)景流一起聯(lián)合生成的逐點(diǎn)不確定性。廣泛的實(shí)驗(yàn)表明了本文的 DifFlow3D 的優(yōu)越性和泛化能力。值得注意的是,本文的基于擴(kuò)散的細(xì)化可以作為即插即用模塊應(yīng)用于以往的工作,并為未來(lái)的研究提供新的啟示。

引用:

Liu J, Wang G, Ye W, et al. DifFlow3D: Toward Robust Uncertainty-Aware Scene Flow Estimation with Diffusion Model[J]. arXiv preprint arXiv:2311.17456, 2023.