撰文丨伊風

出品 | 51CTO技術棧(微信號:blog51cto)

辛苦工作一天后,你躺在沙發上,有一個能為你遞上香蕉的機器人怎么樣?這聽起來就像擁有一只會叼拖鞋的狗狗一樣酷!

RFM-1 可以!他可以聽懂你的指令,在一堆食物中準確的識別香蕉并進行抓取。

就像Sora一樣,RFM-1通過大量的數據理解真實世界的物理規律,并進行理解和推理——只是不生產視頻,而是作為機器人與真實世界進行交互。

圖片

圖片

創造RFM-1的公司名叫Covariant,中文意思為“協變”,頗有與時俱進、順勢而為的意思。這家公司的聯合創始人兼CEO彼得-陳(Peter Chen),曾在2016年進入OpenAI工作,是最早期的發起者之一,一年后他離開OpenAI創立了covariant.ai。

圍繞Sora的爭議帶火了“世界模型”概念。很多人相信AI能模擬和理解現實世界的各種現象和過程的“奇點”即將到達。而 Covariant 也瞄準這一定位,野心是將AI技術的突破擴展到物理領域(相對于ChatGPT、Sora等一眾AI發力的數字領域)。

AI大佬Jim也對RFM-1給出很高的評價。比起使用真實數據進行訓練的RFM-1,其他機器人就像是玩具一樣。

圖片

圖片

那么,RFM-1都可以做什么?又是如何做到的?

1.真實數據訓練,機器人要走出象牙塔

我們知道大多數現有的機器人的樣子——遲鈍、笨拙地在實驗室中緩慢地穿行著。因為他們的訓練數據就來自實驗環境,主要在相對靜態的條件下與物體進行交互。

而Covariant卻選擇使用真實世界的數據創建RFM-1。

雖然很難,但這使得RFM-1能夠在要求苛刻的真實世界環境中工作,并保持符合水準的精度和性能。簡而言之,機器人終于不再那么脆弱了!

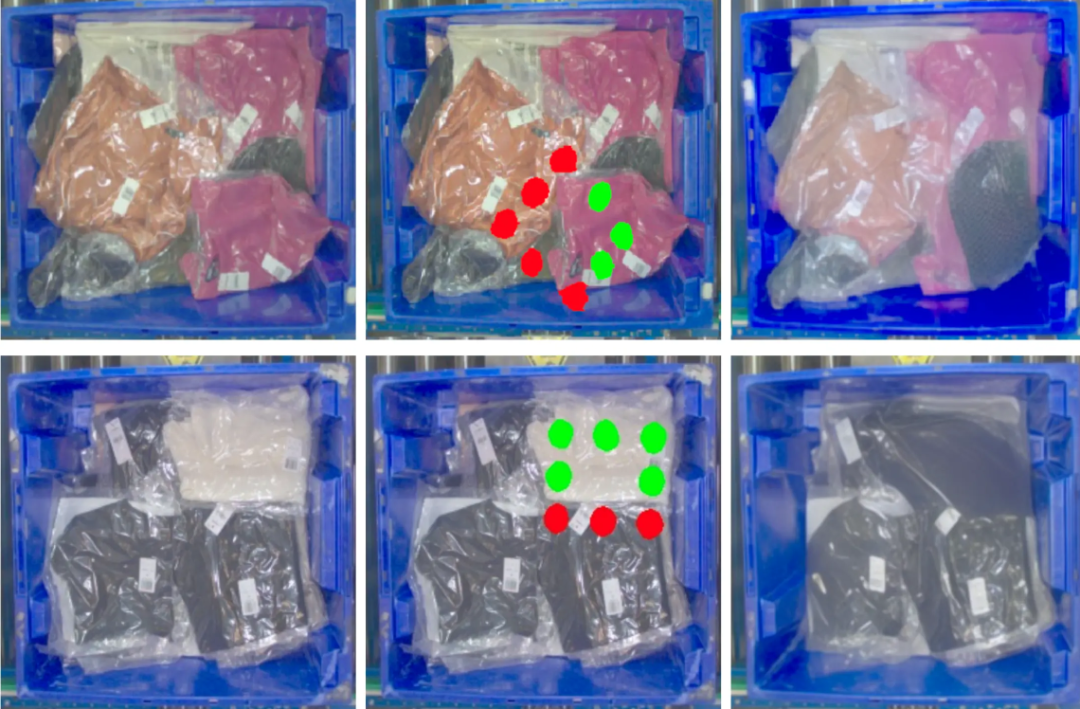

因為是在真實世界,因此機器人要理解參差多態的事物,理解物體材質的輕與重、硬與軟。更復雜的,還涉及到物體的形變、遮擋、需要推理不同材料的不同吸力動態、處理運動中不規則形狀物體的混亂,直至能處理從化妝品和衣服到雜貨和機械零件等各種物體。(這么想想我們人類真的很厲害。)

圖片

圖片

也因為是真實世界,因此機器人需要了解并能處理意外情況。RFM-1在真實工作場景中訓練到許多實驗室環境中很難遇到的長尾事件,如下面這個魚一般滾動在軌道外的物體,有可能會讓許多機器人“一臉懵”。

圖片

圖片

2.更懂世界的RFM-1是怎么做到的?

RFM-1 是一個多模態任意序列模型( any-to-any sequence model),采用一個80 億參數變換器,能精準地學習和處理各種復雜的信息。

RFM-1 將所有模態標記到一個共同空間,并執行自回歸下一個標記預測,從而利用其廣泛的輸入和輸出模態實現多樣化應用。可以說,RFM-1 就像一個多面手,擅長處理各種不同類型的信息。它有一個大大的魔法袋,可以裝下文本、圖像、視頻、機器人動作和各種數字傳感器的讀數。然后,這些信息可以互相交流、互相影響。

,時長00:23

這樣,RFM-1 可以可以為場景分析任務(如分割和識別)執行圖像到圖像學習,把一張圖片變成另一張圖片;它還能夠把文字說明和圖片結合起來,生成一系列動作或者運動的序列;或者把場景的圖片和目標的圖片配對起來,以視頻形式預測結果。

3.補物理:機器人“成為”人類的必修課

Covariant明白學習世界模型是機器人的未來。

從RFM-1的表現來看,這條路走對了!世界模型的預測能力可以讓機器人擁有人類生活中至關重要的物理直覺。

像很多短視頻時代出生的小孩,RFM-1 理解世界也是靠看視頻開始的:通過輸入初始圖像標記和機器人動作,它可以作為物理世界模型預測未來。實際上沒有聽起來那么玄乎!這種預測包括,把一件物品從垃圾箱取走后,箱子會變成什么樣子,通過圖像的比對,機器人可以判斷任務是否執行成功。

圖片

圖片

AlphaGo 等之前的AI研究成果表明,在世界模型中進行規劃很可能是實現超人類水平性能的關鍵。此外,物理理解力直接增強了 RFM-1 的其他能力,如將圖像映射到機器人的行動中。

4.學語言:不止交互、還能尋求人類幫助

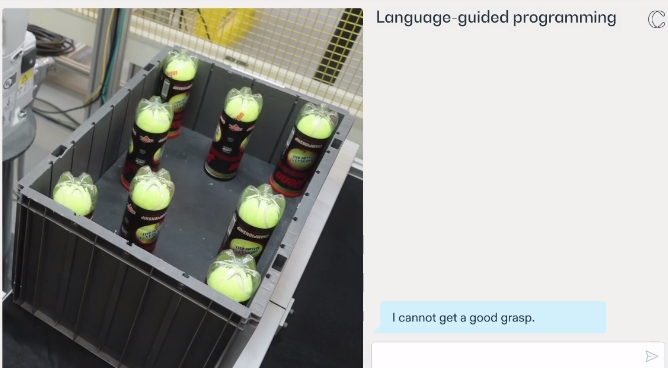

這個我抓不住,怎么辦?”這樣的求助不再是人類幼崽的專屬,機器人將主動向人請教和學習。

當機器人發現它執行某項任務遇到困難時,操作員可以向機器人提供新的運動策略,例如通過移動或撞擊物體來擾動物體,從而找到更好的抓取點。

今后,機器人可以將這種新策略應用到未來的行動中。看來,機器人進化的步伐會越來越快了。

5.從OpenAI走出的華人團隊

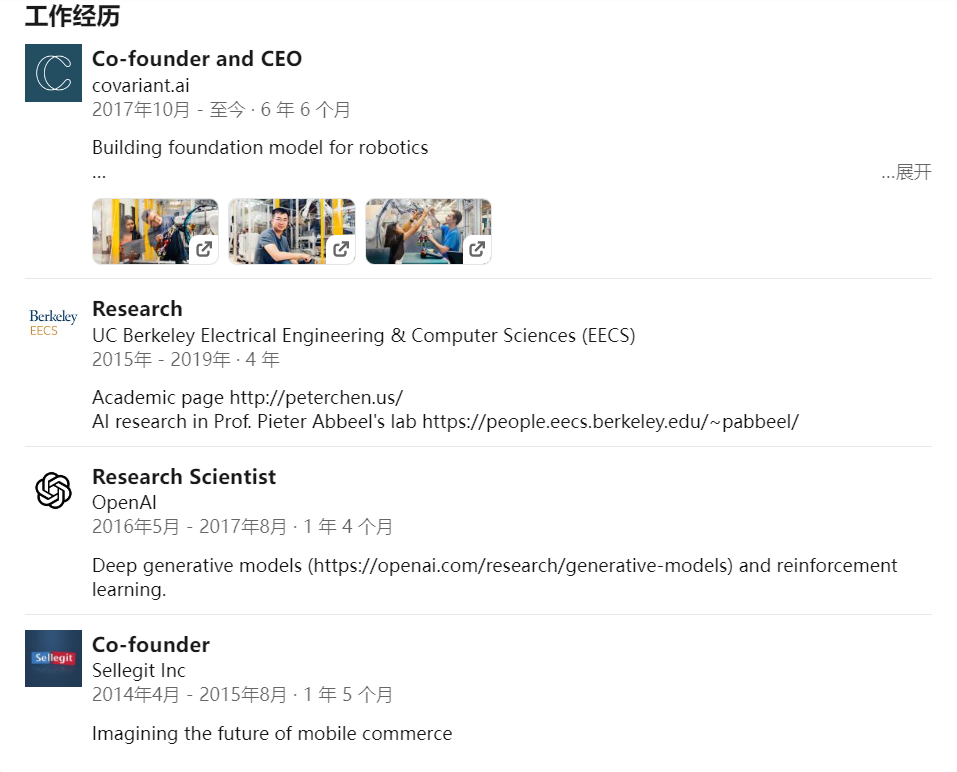

Covariant 由加州大學伯克利分校教授Pieter Abbeel和他的三名學生Peter Chen、Rocky Duan and Tianhao Zhang創立,都有非常好的AI技術背景。

聯合創始人兼CEO Peter Chen,2016年進入OpenAI工作,參與了深度生成模型 (https://openai.com/research/generative-models) 和強化學習方面的研究。Peter的領英主頁的語言技能標注了英語、普通話以及粵語三種語言。

圖片

圖片

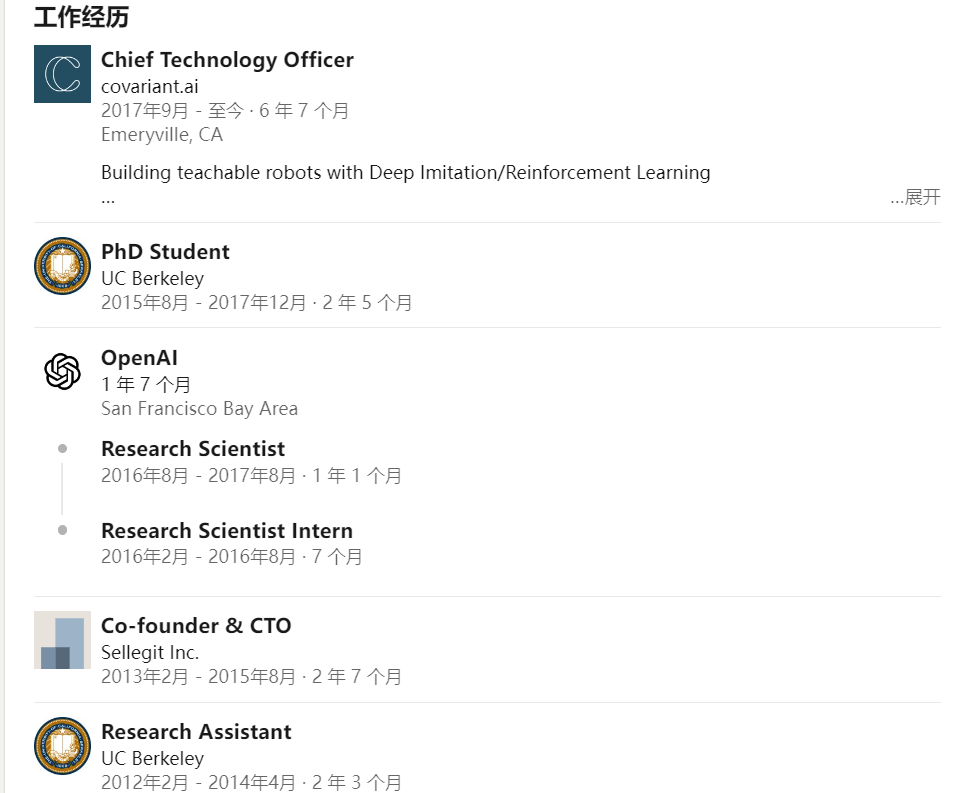

擔任CTO的Rocky Duan同樣有一段長達兩年在OpenAI工作和實習的經歷。

圖片

圖片

另外一位聯合創始人,則在博士期間有一段微軟的實習經歷,在校期間承擔自然語言處理的研究項目。

圖片

圖片

他們從一個倉庫機器人系統開始,逐步完善自己的技術。該公司在成立的七年中,Covariant 通過攝像頭和其他傳感器收集數據,以了解機器人是如何運行的并優化訓練。

Peter Chen 非常重視數據的意義。通過從數字數據(物理世界中發生的數十萬個實例)中學習,機器人能應對各種意外情況。當這些操作與語言相結合時,機器人還能像聊天機器人一樣,對文字和語音建議做出回應。

就像Peter采訪中說過的,“數字數據中的內容可以移植到現實世界中”。

毫無疑問,與ChatGPT和Sora一樣,機器人也將更加強大。

參考鏈接:

1.https://covariant.ai/insights/introducing-rfm-1-giving-robots-human-like-reasoning-capabilities/

2.https://www.nytimes.com/2024/03/11/technology/ai-robots-technology.html