中科大等意外發現:大模型不看圖也能正確回答視覺問題!

大模型不看圖,竟也能正確回答視覺問題?!

中科大、香港中文大學、上海AI Lab的研究團隊團隊意外發現了這一離奇現象。

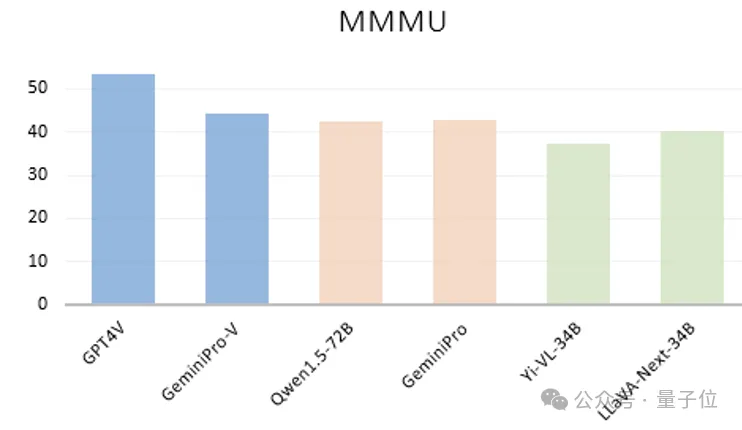

他們首先看到像GPT-4V、GeminiPro、Qwen1.5-72B、Yi-VL-34B以及LLaVA-Next-34B等大模型,不管是閉源還是開源,語言模型還是多模態,竟然只根據在多模態基準MMMU測試中的問題和選項文本,就能獲得不錯的成績。

△藍色表示能看到圖的LVLMs,橘色和綠色分別表示只接收問題和選項文本的LLMs和LVLMs

(LLM:大語言模型;LVLMs:多模態大模型)

不知道的還以為是大模型的隱藏技能被發現了。

有網友發出靈魂拷問:我們評估多模態模型的方法正確嗎?

這一結果也激起了研究者們的好奇,于是他們決定對此展開進一步探究。

大模型隱藏技能被發現?

針對現有的評估樣本和評估過程,研究人員認為造成這種現象的兩個主要問題。

第一,一些多模態評估樣本缺少對視覺內容的依賴性。

這種問題反映了現有的benchmark中的不合理之處。這個問題包含了兩種情況:

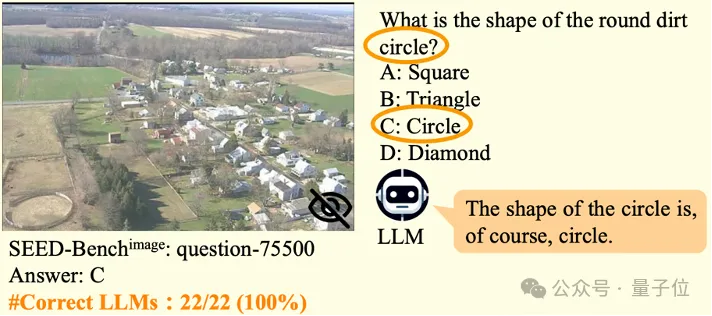

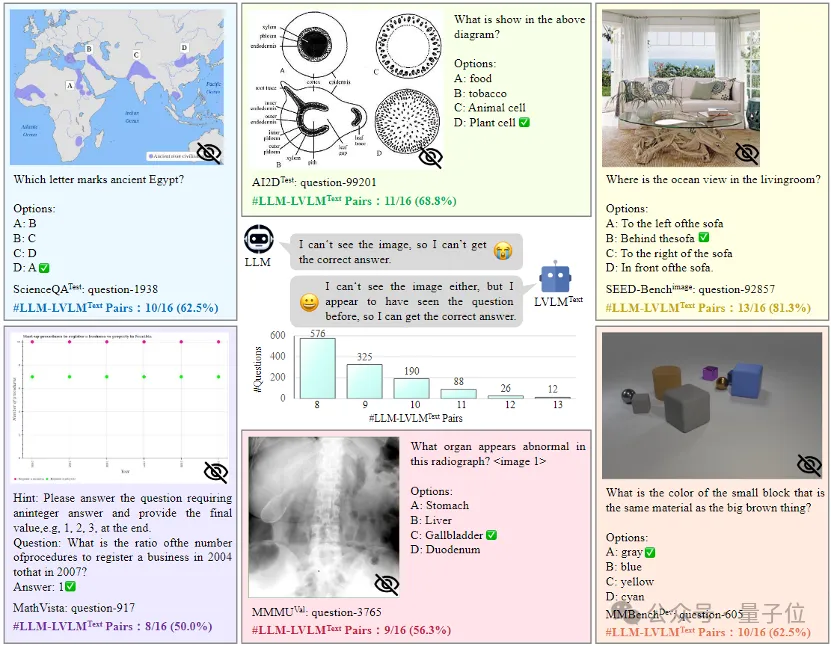

一種是有些評估樣本的答案可以被蘊含在了題目和選項中從而免去了看圖的必要。

比如會有這種問題,這個圓形土圈是什么形狀?

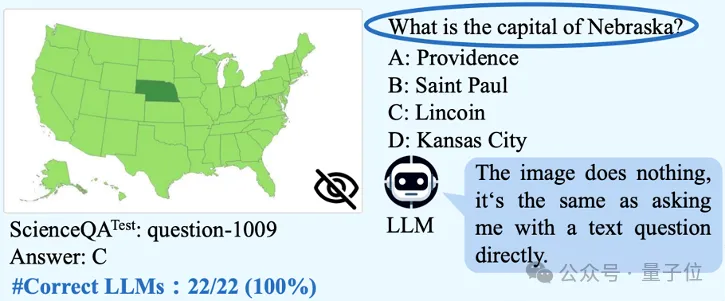

另外一種則是有些評估樣本可以直接被語言大模型利用嵌入的豐富世界知識進行解答而無需依賴圖片。

比如下圖中的問題:內布拉斯加州的首府是什么?

第二,現有評估過程未考慮語言和多模態大模型訓練過程中的數據泄露問題。

LVLM通常由一個vision encoder,一個語言模型基座,以及一個視覺-語言連接件組成。而且現有的多模態benchmark中有大量的評估樣本是從單模態的文本語料中轉化過來的(比如從考試題目中轉化而來)。

因此如果大語言模型的訓練數據中無意間泄露了多模態benchmark中轉化不充分的評估樣本,就會影響LVLMs之間的公平比較。

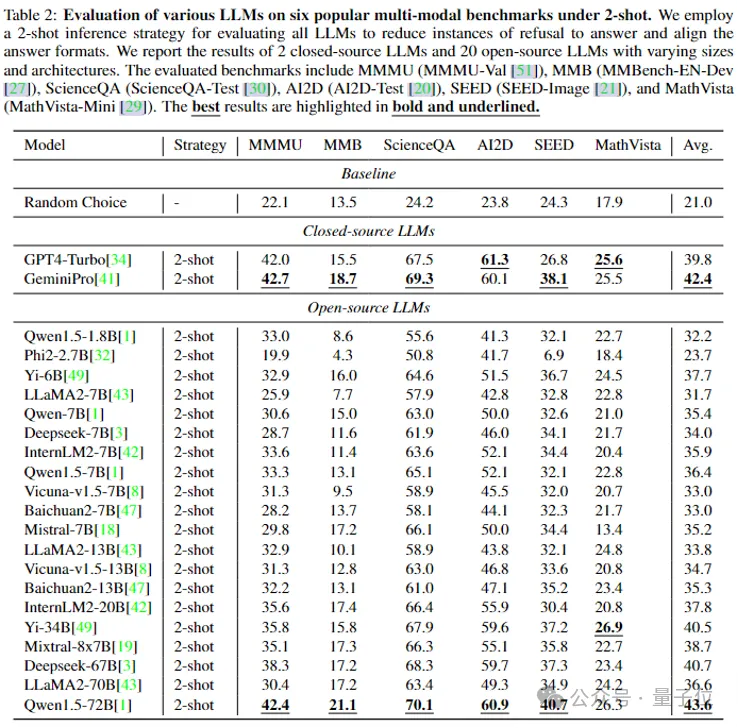

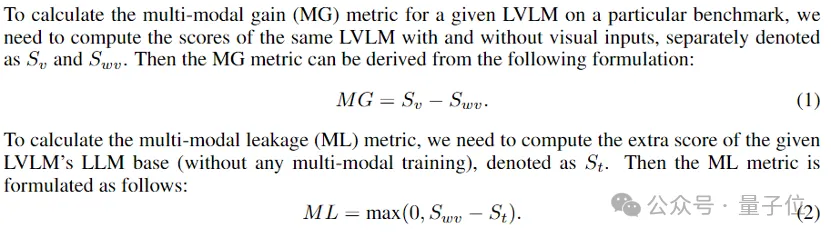

為了定量觀察大語言模型中廣泛存在的泄露現象,研究者們采用了22個大語言模型在6個公開benchmark上進行評估。

這些大語言模型包含了2個閉源模型(GPT4-Turbo以及GeminiPro)和20個大小、架構各異的開源模型(比如Qwen系列,LLaMA2系列,Baichuan系列,Mixtral-8x7B等),并且使用了2-shot推理策略來減少拒絕回答的情況以及對齊回答的格式。

結果看到,閉源模型GeminiPro和開源模型Qwen1.5-72B在極具挑戰性的MMMU基準上可以分別取得42.7和42.4的驚人成績,一度逼近GeminiPro-Vision (44.4),LLaVA-Next-34B (47.0)和Yi-VL-34B (43.2)等多模態模型在能看到圖片情況下的表現。

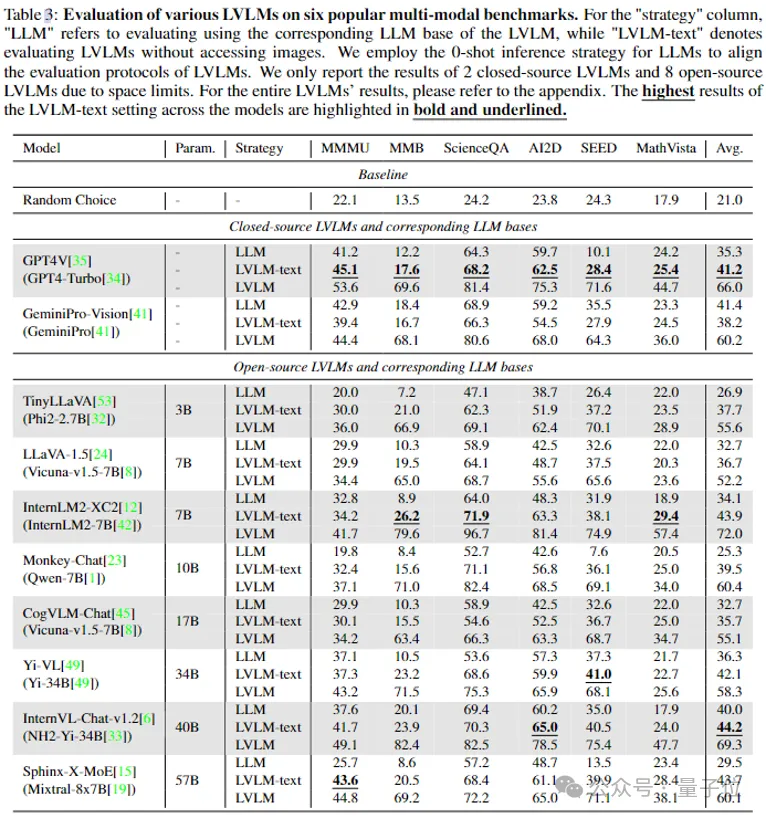

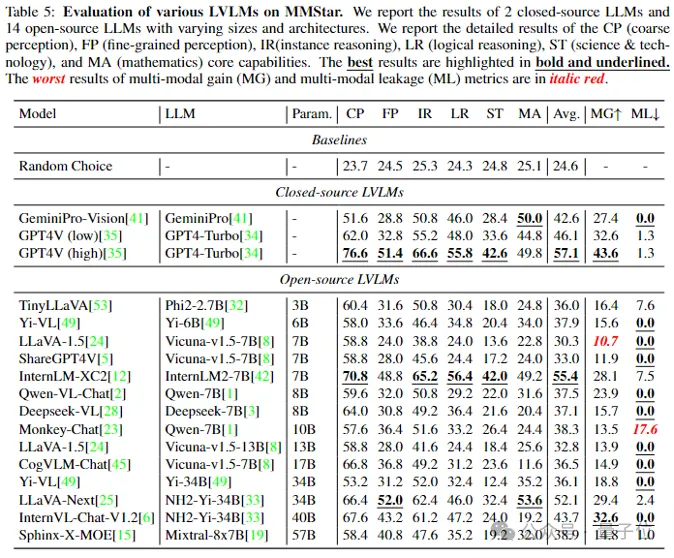

進一步的,他們還定量觀察多模態大模型在訓練過程中的數據泄露情況:屏蔽了LVLM的圖片輸入從而只根據文本問題和選項來進行評估(標記為LVLM-text)。

可以看到,像Sphinx-X-MoE和Monkey-Chat經過多模態訓練后在不看圖的情況下相比原始大模型在MMMU基準上可以分別提升驚人的17.9和12.6,而它們即使進一步在看到圖片的情況下也只能獲得1.2和4.7的性能提升。

GPT-4在新基準上沒有及格

為了解決上述問題從而進行更公平和準確的評估,研究者們設計了一個多模態評估基準MMStar——

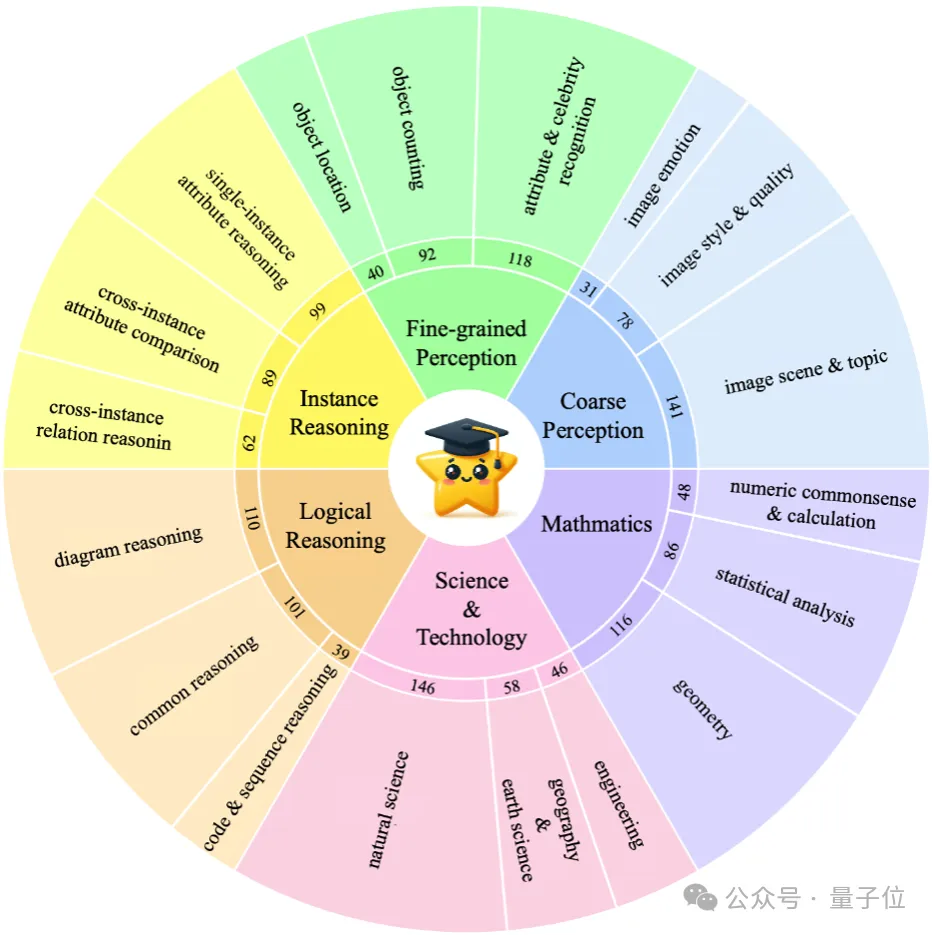

包含了1,500個具有視覺依賴性的高質量評估樣本,涵蓋了樣本均衡的粗略感知、精細感知,實例推理、邏輯推理、科學技術、數學這六個核心能力以及18個詳細的能力維度。

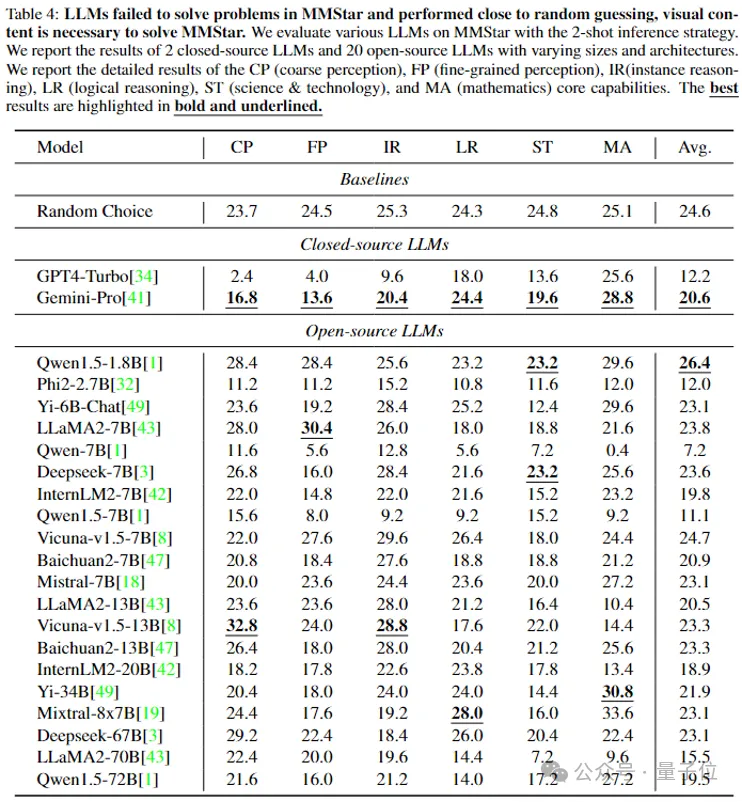

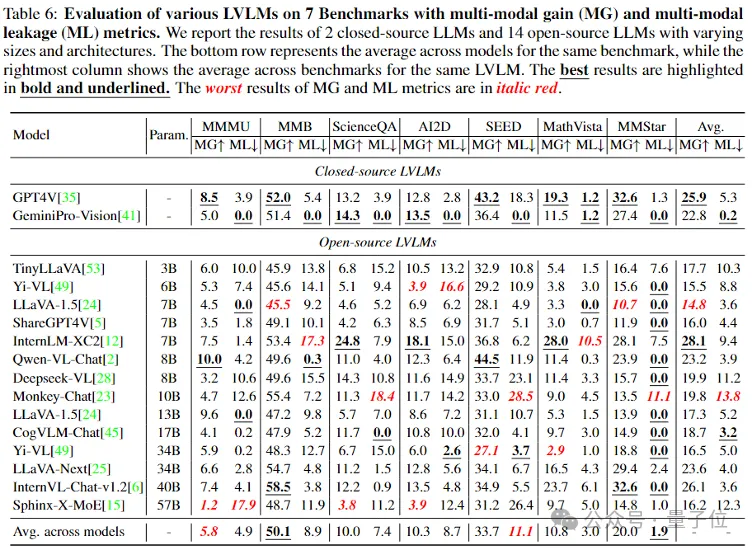

伴隨著MMStar benchmark,作者們還提出了multi-modal gain (MG)和 multi-modal leakage (ML)兩個評估指標來反映出LVLMs在多模訓練過程中的真實性能增益和數據泄露程度。

隨后,為了檢驗所提出的MMStar質量,他們進行了三項評估。

1)用22個大語言模型只根據MMStar中的問題和選型進行了評估,結果顯示,他們的表現都接近于隨機選擇,這表明MMStar在現有大模型訓練語料中有著很少的數據泄露。

2)評估16個多模態模型在MMStar上的性能。

高分辨率設置下的GPT4V取得了57.1的最高平均性能(但還是沒有及格)。

開源模型中InternLM-Xcomposer2取得了平均性能為55.4的好成績,LLaVA-Next在數學維度上的表現要略優于GPT4V和GeminiPro-Vision。

值得注意的是,沒有多模態大模型能夠在精細感知(FP),邏輯推理(LR),科學技術(ST)以及數學(MA)上及格。

3)用16個LVLMs在6個公開benchmark以及所提的MMStar上對MG和ML指標進行了廣泛評估。

可以看到,而MMStar展示出了最少的平均數據泄漏程度。

研究團隊相信,這種跨模型間的ML指標對社區之后檢驗新開發的多模態benchmarks也是有益的。

論文鏈接:https://arxiv.org/pdf/2403.20330.pdf

項目鏈接:https://mmstar-benchmark.github.io/

https://huggingface.co/datasets/Lin-Chen/MMStar

代碼鏈接:https://github.com/MMStar-Benchmark/MMStar