一文讀懂 LLM 的構建模塊:向量、令牌和嵌入

在當今信息爆炸的時代,我們不斷面臨著海量文本數據的挑戰。為了有效地處理和理解這些數據,自然語言處理(NLP)領域的研究者們一直在不斷探索和創新。而其中一個重要的研究方向就是語言模型(Language Model)。

在這篇文章中,我們將一起探索和理解 LLM 的構建模塊,即向量、令牌和嵌入。這些構建模塊是構成語言模型的關鍵要素,它們為我們處理文本數據提供了強大的工具和技術。

1.Vectors-向量:機器理解語言的基石

什么是向量?

著名科學家羅伊·凱恩斯曾經給出了一個精辟的定義:"嵌入是一種學習轉換,使數據更具價值和意義"。在自然語言處理領域,神經網絡通過學習將原始的文本數據轉換為高維連續向量空間中的向量表示,這種向量恰恰能夠編碼和體現文本所承載的實際語義信息,因此被稱為"語義向量嵌入"。

相較于傳統的離散符號表示方式,語義向量嵌入的核心優勢在于,它可以自動捕捉并編碼單詞之間的同義關系、語法關聯以及上下文語義信息,從而使得具有語義相似性的詞語在向量空間中彼此臨近。這種連續的向量表示不僅大幅簡化了底層數據結構的復雜度,更為關鍵的是,它為神經網絡模型提供了一種高度緊致且信息豐富的內部數據形式,從而有效提升了模型的學習能力和表現力。

要真正領會向量在人工智能中的重要意義,我們通常需要從數學和物理學的基本原理著手。在這些學科領域中,向量通常被定義為同時具有大小和方向的物理量。而從幾何視角來看,向量可以采用有向線段表示,線段長度代表其大小,箭頭方向則對應向量指向。向量是一種復合量度,能夠準確描述簡單的標量無法完整刻畫的多維概念,如力、速度或位移等。

然而,在現代人工智能領域,向量的應用則更為抽象和創新。在 LLM 中,向量被用作表示和編碼文本或數據的數字化形式,這種表示通常被稱為"嵌入"。嵌入是高維實數向量,能夠精準捕捉單詞、句子乃至整個文檔所蘊含的豐富語義信息。

將自然語言文本轉化為嵌入向量的過程,賦予了 LLM 理解和處理人類語言的本質能力。有了這種嵌入表示,LLM 就可以在連續的向量空間中捕捉單詞和短語之間的語義聯系,從而完成諸如文本生成、情感分析、語義理解等高級自然語言處理任務。

事實上,嵌入向量是構筑現代 LLM 和生成式人工智能系統的數學基石。隨著模型規模和復雜度不斷提高,能夠高效穩定地學習和利用語義向量嵌入,將成為決定人工智能性能上限的關鍵因素。透徹掌握向量和嵌入的本質概念,對于全面理解和進一步推進大語言模型至關重要。

從某種意義上而言:向量是一個單維數組。

下面的代碼片段介紹了向量的基本思想。正如大家所看到的,“向量”是一個簡單的一維數組,具體如下:

import numpy as np

# Creating a vector from a list

vector = np.array([1, 2, 3])

print("Vector:", vector)

# Vector addition

vector2 = np.array([4, 5, 6])

sum_vector = vector + vector2

print("Vector addition:", sum_vector)

# Scalar multiplication

scalar = 2

scaled_vector = vector * scalar

print("Scalar multiplication:", scaled_vector)2.Tokens-令牌:LLM 的基石

LLM Tokens 是 LLM 中的一個關鍵概念,直接影響著模型的輸入表示和計算效率。作為一種文本數據在模型內部的表示形式,在文本上下文中,令牌可以是單詞、單詞的一部分(子詞)或甚至單個字符,這取決于具體的令牌化策略。

例如,句子 “I love natural language processing” 在不同的令牌化策略下可能會被分割為不同的令牌序列:

- 字符級: ['I',' ','l','o','v','e',...]

- 單詞級: ['I','love','natural','language','processing']

- 子詞級: ['I', 'love', 'nat', 'ural', 'lan', 'guage', 'pro', 'cess', 'ing']

令牌化是將原始文本轉換為模型可解釋的離散符號序列的過程。在這個過程中,令牌器根據預定義的編碼方案,將輸入文本按照特定的規則(如基于字節對編碼 BPE、WordPiece 等)拆分為一系列令牌,并將每個令牌映射為一個特殊的向量表示,使之可以被 LLM 理解和操作。

在實際的場景中,令牌化策略對 LLM 的性能有著深遠影響。合理的策略不僅可以減小詞匯表大小、解決未知詞問題,更重要的是能夠為模型提供更好的語義信號,提高泛化能力。不同的 LLM 通常會采用不同的令牌化方案,以最大限度地發揮模型的潛力。

然而,令牌并非是一成不變的,在模型輸出時也需要經過逆向的解碼過程,將生成的令牌序列譯回可讀的文本形式。這個解碼過程與令牌化策略相對應,確保了數據在模型內外的無縫轉換。

LLM 的上下文長度,即模型一次可以接受和生成的最大令牌數,是衡量其性能的關鍵指標之一。受限于計算資源,模型通常無法處理任意長度的文本,因此,需要采用上下文窗口或序列截斷等策略對超長輸入進行分塊處理。合理設置上下文長度不僅可以充分利用硬件能力,更重要的是能夠最大化模型對上下文語義的捕捉能力。

因此,總的來說,令牌是 LLM 內部處理文本數據的基礎單元。通過高效的令牌化策略和解碼機制,LLM 能夠無縫地在離散符號和連續文本之間轉換,展現出卓越的自然語言理解和生成能力。令牌化技術的不斷創新和上下文長度的持續擴展,將繼續推動 LLM 在各領域的廣泛應用。

從本質上來講,令牌是向量形式的文本表示。

對于 LLM 而言,將輸入文本轉換為模型可解釋的令牌序列是一個關鍵環節。無論是開源的 Llama 2 等模型,還是商業化的 GPT-4,其底層的令牌化過程都有著一些共通之處,但也存在各自的特色。

以下代碼片段基于流行的 Hugging Face Transformers 庫和 OpenAI 的 Tiktoken 工具包,展示了如何將原始文本分詞并編碼為不同 LLM 可接受的令牌表示。

對于 Hugging Face 的模型如 Llama 2:

rom transformers import LlamaTokenizer

tokenizer = LlamaTokenizer.from_pretrained("decaphr-research/llama-7b-hf")

text = "This is a sample text to tokenize."

tokens = tokenizer.encode(text, return_tensors="pt")此處,我們先實例化一個 LlamaTokenizer 對象,該對象包含了 Llama 2 模型的詞匯表和編碼規則。接著使用 tokenizer.encode() 方法將文本轉換為對應的令牌張量表示。

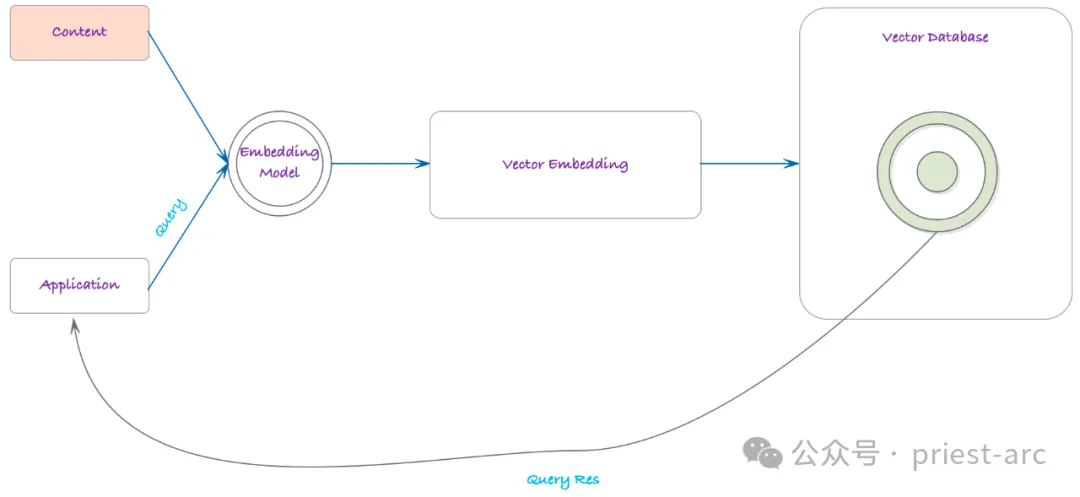

3.Embeddings-嵌入:語義空間

Embeddings-嵌入,是賦予令牌以語義語境的關鍵環節。如果令牌是文本的向量表示,那么嵌入就是融入了語義語境的令牌表征,代表了文本的意義和上下文信息。如果令牌是由令牌器編碼或解碼的,那么嵌入模型則負責生成以向量形式存在的文本嵌入表示。

嵌入賦予了 LLM 理解語境、微妙語義和詞語/短語所蘊含細微差異的能力,是模型從大量文本數據中學習獲得的,不僅編碼了令牌的身份,更重要的是捕捉了令牌之間的關系。

通常而言,嵌入是 LLM 的根基性組成部分。正是通過嵌入,LLM 獲得了對語言的深入理解,從而能夠在諸如情感分析、文本摘要和問答等任務中展現出細致入微的理解和生成能力。作為 LLM 的入口,嵌入也可被用于 LLM 之外,將文本轉換為保留語義語境的向量表示。

當文本通過嵌入模型時,會生成一個包含對應嵌入的向量。以下是來自開源嵌入模型 sentence-transformers/all-MiniLM-L6-v2 和 OpenAI 的 text-embedding-3-small 模型的嵌入示例:

# 開源嵌入模型示例

from sentence_transformers import SentenceTransformer

model = SentenceTransformer('all-MiniLM-L6-v2')

sentences = ["This is an example sentence", "Each sentence is converted to a vector"]

embeddings = model.encode(sentences)

# OpenAI嵌入模型示例

import openai

openai.api_key = "YOUR_API_KEY"

text = "This is another example sentence."

response = openai.Embedding.create(

input=text, model="text-embedding-ada-002"

)

embedding = response["data"][0]["embedding"]這些嵌入向量能夠有效地捕捉文本的語義信息,使之可以被機器學習模型理解和操作。在自然語言處理的許多任務中,將原始文本轉換為嵌入向量是必不可少的第一步,而嵌入的質量也直接影響著模型的整體性能表現。

因此,嵌入技術在 LLM 中扮演著極為重要的角色。高質量的嵌入不僅使得 LLM 能夠充分理解輸入文本的豐富語義信息,更是賦予模型在各類自然語言處理任務中展現出人類水平甚至超人類水平能力的關鍵所在。伴隨著深度學習技術的不斷進步,嵌入技術也在持續演進,為 LLM 注入越來越強大的語言理解和生成能力。

隨著 LLM 在諸多領域的廣泛應用,嵌入技術必將得到更多關注和創新。無論是在提高嵌入質量、擴展嵌入應用場景還是開發高效的嵌入算法上,都有大量的研究和實踐空間值得開拓。可以預見,在不久的將來,更先進的嵌入技術將出現,進一步催化 LLM 在自然語言處理乃至人工智能整個領域的飛速發展。

因此,可以毫不避諱的認為:嵌入是 LLM 的基本特性

4.向量、令牌和嵌入,三者之間的關系

基于上述所述,LLM 的處理管道中,令牌、向量和嵌入是三個密切相關卻又有所區別的核心組件。

令牌是語言的最小單元,可以是單詞、子詞或字符,是 LLM 理解和生成自然語言的基石。每個令牌都會在模型的底層表示為一個向量,即一組數值,使之可被機器高效計算和處理。

向量為令牌提供了數學框架,使語言單元可被量化和建模。但并非所有向量都能準確反映語義信息。這就需要借助嵌入技術了。

嵌入是經過專門訓練,能夠捕捉語義關聯和上下文依賴的特殊向量表示。與簡單的 one-hot 編碼不同,嵌入向量能夠體現詞語/短語之間的相似性、類比關系等豐富語義,為 LLM 提供更為細致入微的語義理解基礎。

由令牌到嵌入,代表了從離散的語言符號到連續的語義空間的邁進。LLM 首先將輸入文本進行令牌化,得到一系列與語言單元相對應的離散標記;隨后通過嵌入層,這些離散令牌被映射到語義向量空間中,賦予上下文語境。

因此,掌握令牌、向量和嵌入,是理解 LLM 處理自然語言的基礎。令牌作為數據單元的載體,向量為機器計算奠定數學基礎,而嵌入則賦予了語義理解的能力。三者缺一不可,共同構筑了 LLM 技術的支柱。

正是這些組件的高效協同,賦予了 LLM 卓越的語言理解和生成能力,使其能以人性化的方式,極高的準確性和多功能性完成諸如問答、摘要、對話等復雜的自然語言處理任務,推動 AI 應用程序的飛速發展。

未來,令牌化、向量化和嵌入技術必將持續演進,以支持更加強大的 LLM 模型。例如新穎的子詞分割算法、更高效的稀疏向量編碼方案以及融合注意力機制的高階嵌入等創新,都將進一步提升 LLM 在語言理解和生成方面的性能。

與此同時,我們也需要反思這些底層機制可能存在的潛在缺陷和偏見,并致力于開發更加公平、可靠和透明的 LLM 技術,使之能夠持續為人類社會帶來價值。總的來說,掌握了語言技術的基本組成單元,將有助于更深入地理解 LLM 的本質,把握其發展方向,并為構建更加智能、公正、可信的人工智能系統指明方向。