編譯 | 伊風

出品 | 51CTO技術棧(微信號:blog51cto)

眾所周知,LLMs的工作原理是對下一個token進行預測。

讀者朋友們有沒有曾這樣想過:如果LLM一次預測n個token呢?那是不是就快n倍?Meta也是這樣想的!并且付諸實踐。

在最近的一項研究中,Meta、以及巴黎高科橋路學院和巴黎-薩克雷大學的研究人員建議,通過讓人工智能大型語言模型(LLMs)同時預測多個token,來提高大模型的準確性和速度。

這個大膽的設想,跳出了自回歸語言模型的經典結構——一次僅僅預測一個token。

在某些領域,這一方法呈現了顯著的優勢,速度提高了三倍,生成任務的性能也更好!

雖然多標記預測并不一定成為每種模型和語言任務的通用解決方案,且該方法還存在很大的改進空間。但Meta的研究驗證了該思路的可行性,這項技術可能讓某些LLM應用大幅進化,例如時下熱議的AI編程。

1.只預測下一個token的局限性

訓練LLMs的經典方法是所謂的“下一個token預測”,這是一種自監督學習技術,模型被給予一系列token,并預測下一個。

然后大模型會將預測的標記添加到輸入中,并重復這個過程,一次一個token。通過在大量文本語料庫上一遍又一遍地這樣做,模型學習到一般模式,使其能夠輸出連貫的文本段落。

研究人員已經研究并記錄了下一個標記預測在獲取語言、世界知識和推理能力方面的局限性:例如,僅僅關注一個標記,模型變得對局部模式過于敏感,忽略了需要對更長視野進行推理的預測。在下一個標記預測上訓練的模型還需要大量的數據才能達到人類用更少文本就能獲得的流暢度。

Meta的新研究正基于這樣的假設:“訓練語言模型一次預測多個token,可以提高樣本效率。”

2.新技術:一次預測多個token

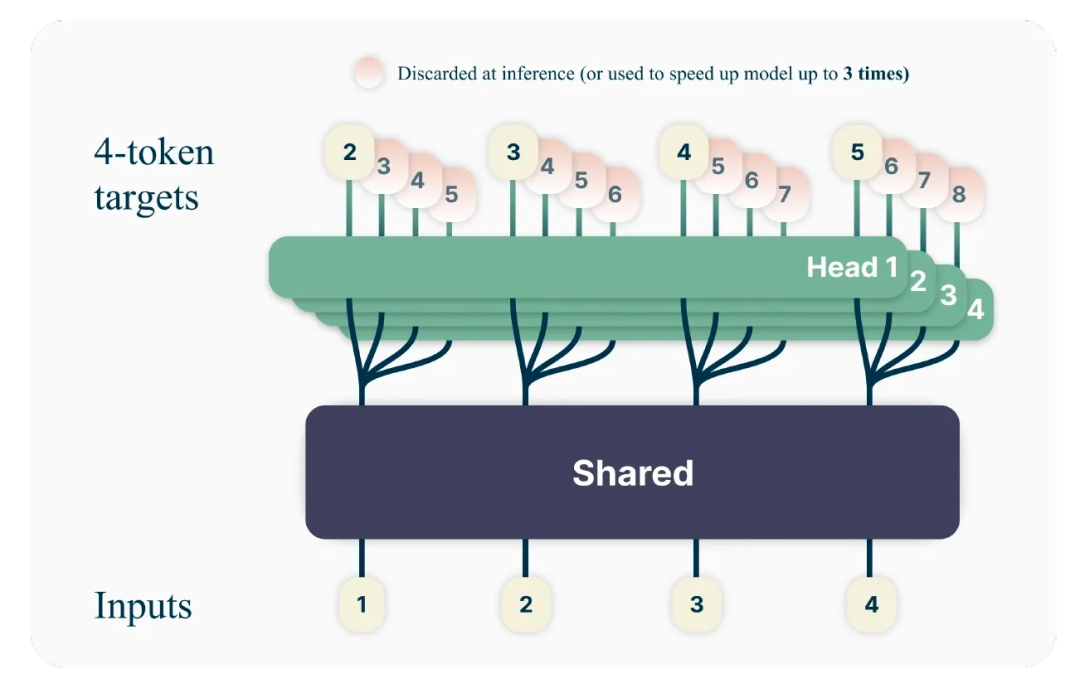

多標記預測指示LLM從訓練語料庫中的每個位置同時預測多個未來的token。研究人員提出了一個簡單的多標記預測架構,不需要額外的訓練時間或內存開銷。

多標記預測語言模型基于大多數LLMs使用的Transformer架構,盡管有一些修改。模型使用Transformer的主要結構,雖然不再輸出單個token,但每個token都有獨立的輸出頭,每個要預測的標記一個。

圖片

圖片

在推理過程中,模型使用每個預測頭去做基本的下一個token預測方案,并使用額外的輸出頭來加速解碼過程。該模型綜合利用了該領域中的幾項相關的成果。

“在不增加額外成本且保持簡單的同時,多標記預測是對訓練更強大、更快的Transformer模型的有效調整,”研究人員寫道。

3.多標記預測技術的改進效果

研究人員在300百萬到130億參數的各種任務上測試了新的多標記預測方案。

他們的發現包括幾個有趣的觀測結果。例如,在較小的模型上,多標記預測會導致更差的結果,但隨著模型大小的增加,它變得越來越有用。例如,在訓練4個標記預測時,6.7億和130億參數的模型在MBPP編碼基準測試上比基線單標記預測提高了幾個百分點。“在相同的計算預算下,使用多標記預測,可以在固定數據集上從大型語言模型中擠出更多的性能,”研究人員寫道。

根據研究人員的說法,多標記預測還使模型在跨廣泛批量大小的推理時間上快了多達三倍。“使用多標記預測進行預訓練,額外的頭部(Head)比簡單的下一個標記預測模型的微調更準確,我們讓模型可以釋放自我推測解碼的全部潛力,”研究人員寫道。

該研究還表明,多標記預測促進了學習長期模式,特別是在模型被訓練在“字節級標記化”(byte-level tokenization)上的實驗中,其中每個字節都被視為一個單獨的標記。在這些實驗中,多字節預測以很大的優勢超過了基線單字節預測模型。

這對于沒有預定義詞匯表并且模型必須學習使用非常小的信息塊的應用尤其重要。

多標記預測仍有改進空間。例如,要預測的標記的最優數量取決于任務類型和模型大小。科學家們正在考慮多個未來的研究方向,包括自動選擇要預測的標記的最優數量的技術,以及研究詞匯表大小和多標記預測之間的動態。

這項研究及其未來的迭代可能對企業應用有用,因為它們有潛力為生成任務(如代碼完成)提供更快的推理和更高的準確性,而幾乎沒有或沒有額外的成本。由于它還保留了大部分LLM架構,因此可以與Transformer塊的其他優化技術兼容,具備很強的迭代潛力。

參考鏈接:https://venturebeat.com/ai/metas-new-multi-token-prediction-makes-ai-models-up-to-3x-faster/