眾包新玩法!LLM競技場誕生基準測試,嚴格分離學渣學霸

大模型排行榜哪家強?還看LLM競技場~

截至此刻,已有共計90名LLM加入戰斗,用戶總投票數超過了77萬。

圖片

圖片

然而,在網友們吃瓜調侃新模型沖榜、老模型喪失尊嚴的同時,

人家競技場背后的組織LMSYS,已經悄悄完成了成果轉化:從實戰中誕生的最有說服力的基準測試——Arena-Hard。

圖片

圖片

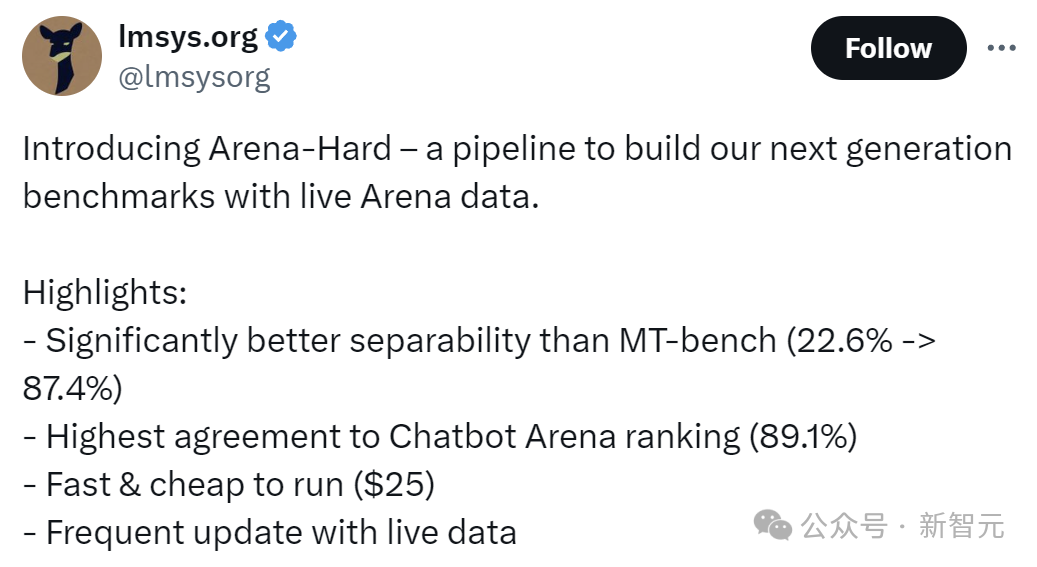

而Arena-Hard所展現出的四項優勢,也正是當前的LLM基準測試最需要的:

-可分離性(87.4%)明顯優于MT-bench(22.6%);

-與Chatbot Arena的排名最相近,達到89.1%;

-運行速度快,價格便宜(25美元)

-頻繁更新實時數據

中譯中一下就是,首先這個大模型的考試要有區分度,不能讓學渣也考到90分;

其次,考試的題目應該更貼合實際,并且打分的時候要嚴格對齊人類偏好;

最后一定不能泄題,所以測試數據要經常更新,保證考試的公平;

——后兩項要求對于LLM競技場來說,簡直像是量身定做。

我們來看一下新基準測試的效果:

圖片

圖片

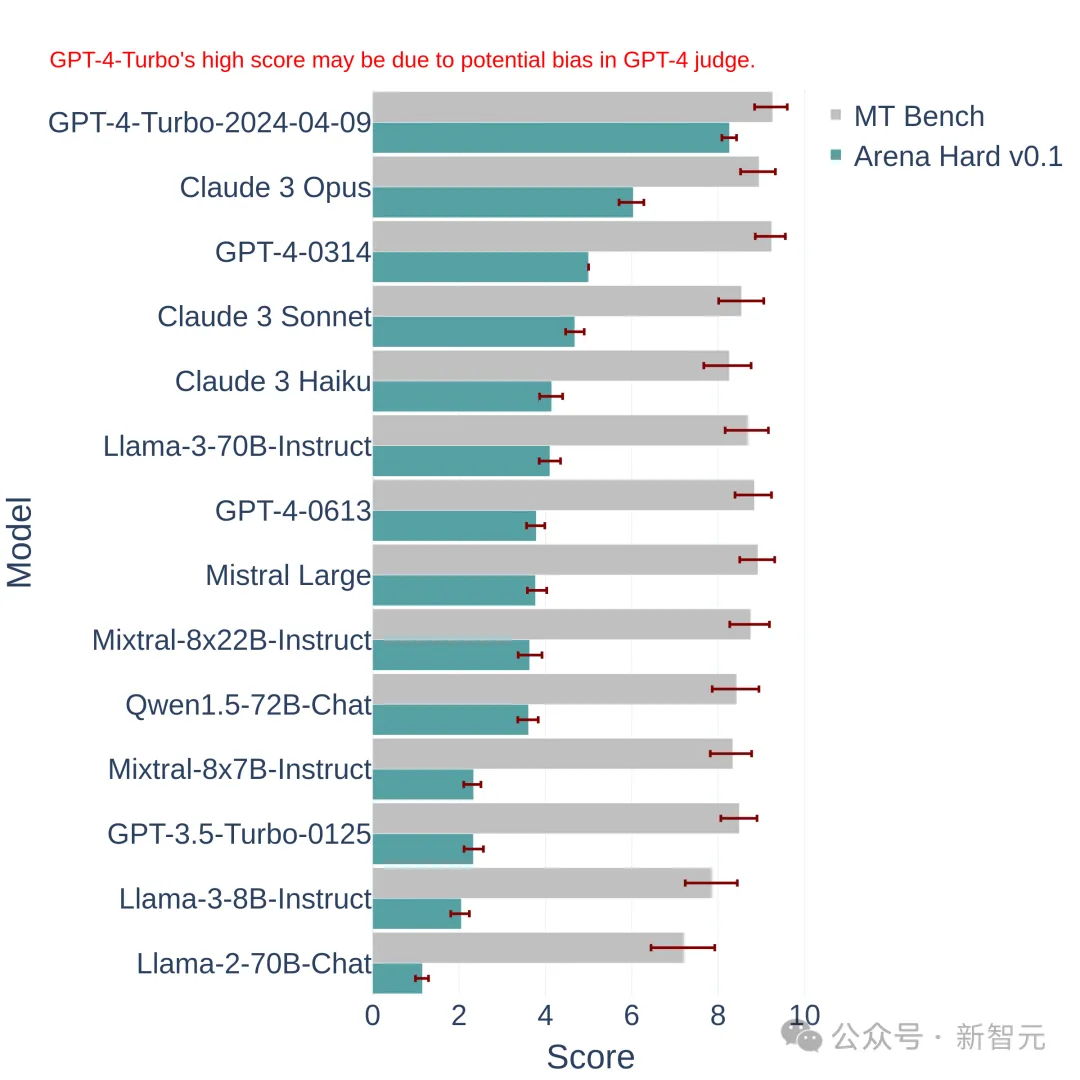

上圖中將Arena Hard v0.1,與之前的SOTA基準測試MT Bench進行了比較。

我們可以發現,Arena Hard v0.1與MT Bench相比,具有更強的可分離性(從22.6%飆升到了87.4%),并且置信區間也更窄。

另外,看下這個排名,與下面最新的LLM競技場排行榜是基本一致的:

圖片

圖片

這說明Arena Hard的評測非常接近人類的偏好(89.1%)。

——Arena Hard也算是開辟了眾包的新玩法:

網友獲得了免費的體驗,官方平臺獲得了最有影響力的排行榜,以及新鮮的、高質量的數據——沒有人受傷的世界完成了。

給大模型出題

下面看下如何構建這個基準測試。

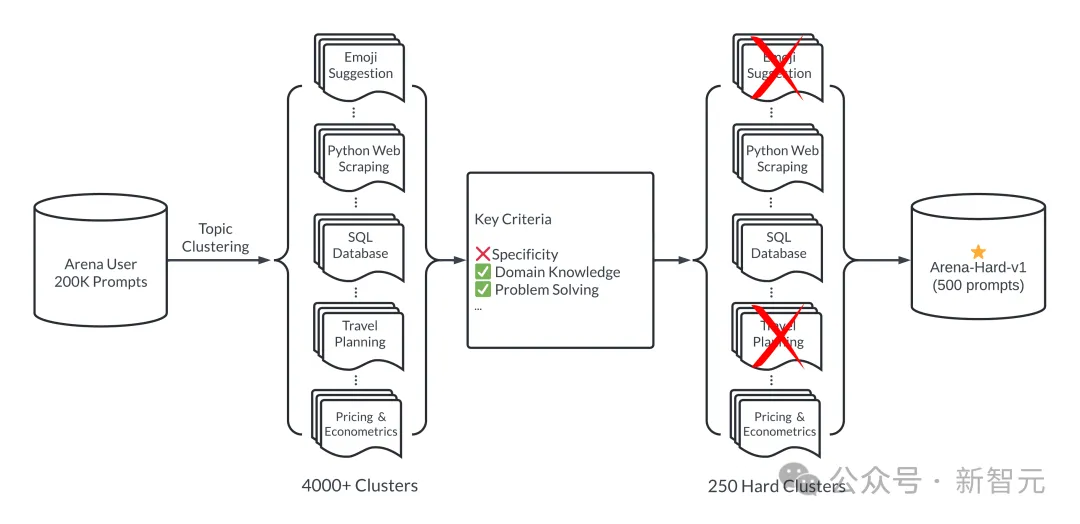

簡單來說,就是怎么從競技場的20萬個用戶提示(問題)中,挑出來一些比較好的。

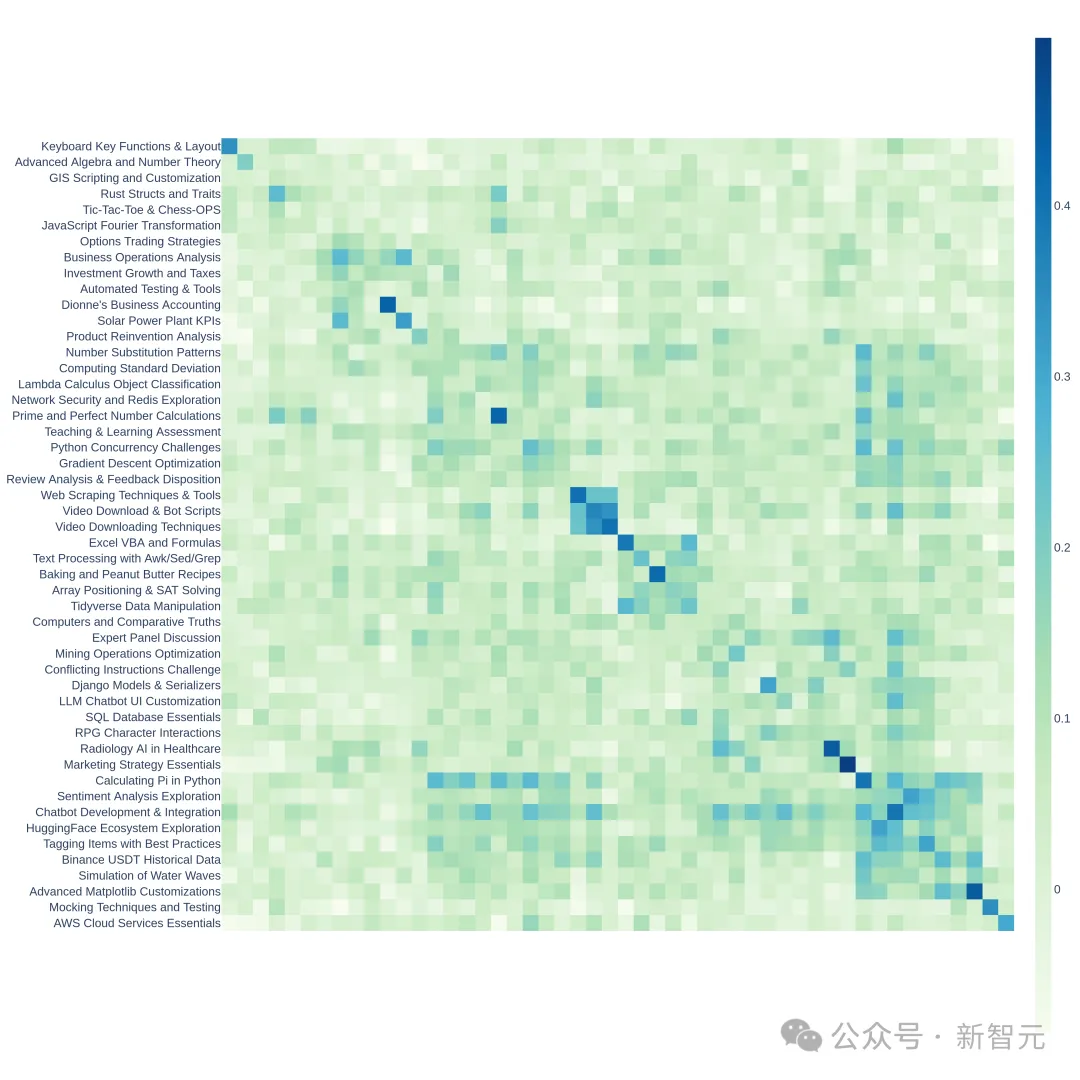

這個「好」體現在兩方面:多樣性和復雜性。下圖展示了Arena-Hard的工作流:

圖片

圖片

總結一波:首先對所有提示進行分類(這里分了4000多個主題),然后人為制定一些標準,對每個提示進行打分,同一類別的提示算平均分。

得分高的類別可以認為復雜性(或者質量)高——也就是Arena-Hard中「Hard」的含義。

選取前250個得分最高的類別(250保證了多樣性),每個類別隨機抽2位幸運提示,組成最終的基準測試集(500 prompts)。

下面詳細展開:

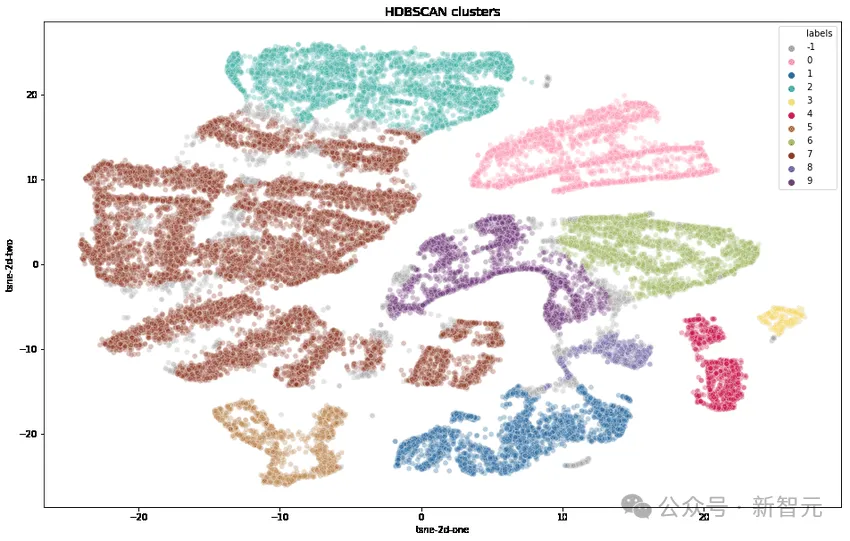

多樣性

研究人員首先使用OpenAI的text-embedding-3-small轉換每個提示,使用UMAP減少維度,并使用基于分層的聚類算法(HDBSCAN)來識別聚類,然后使用GPT-4-turbo進行匯總。

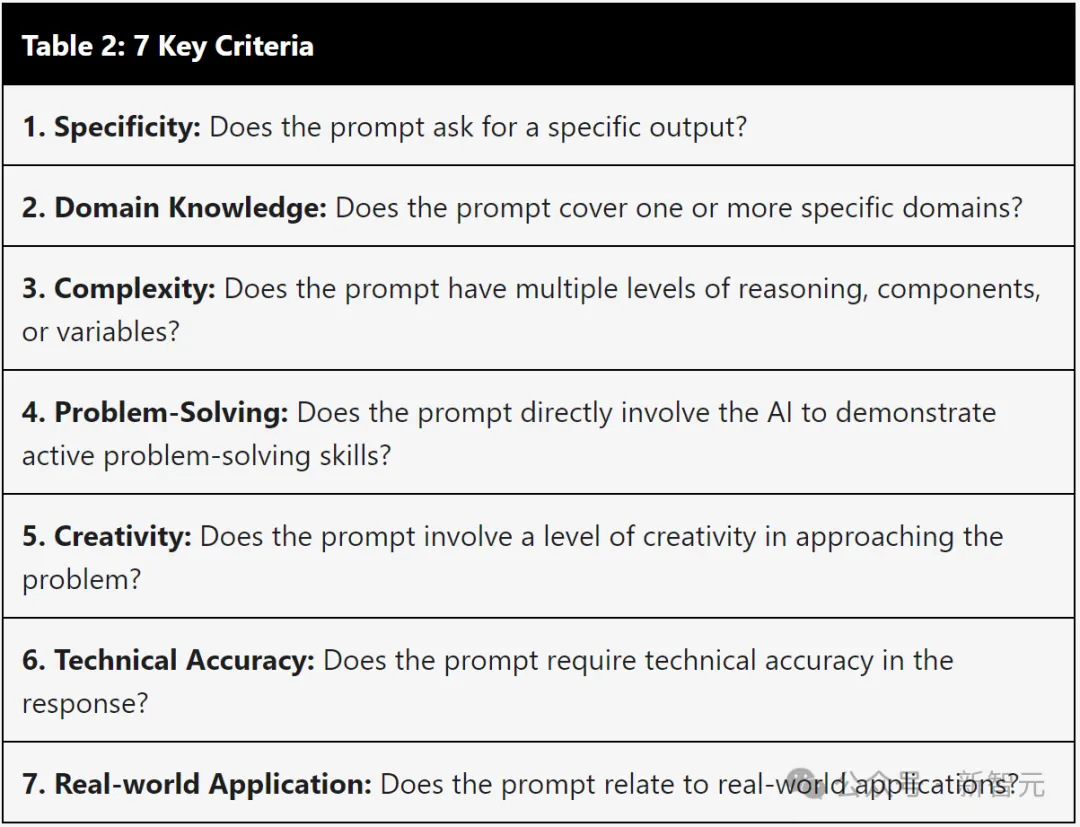

復雜性

通過下表的七個關鍵標準來選擇高質量的用戶查詢:

圖片

圖片

1.提示是否要求提供特定的輸出?

2.是否涵蓋一個或多個特定領域?

3.是否具有多個級別的推理、組件或變量?

4.是否直接讓AI展示解決問題的能力?

5.是否涉及一定程度的創造力?

6.是否要求響應的技術準確性?

7.是否與實際應用相關?

對于每個提示,使用LLM(GPT-3.5-Turbo、GPT-4-Turbo)標注其滿足了多少個標準(打分0到7),然后,計算每組提示(聚類)的平均分數。

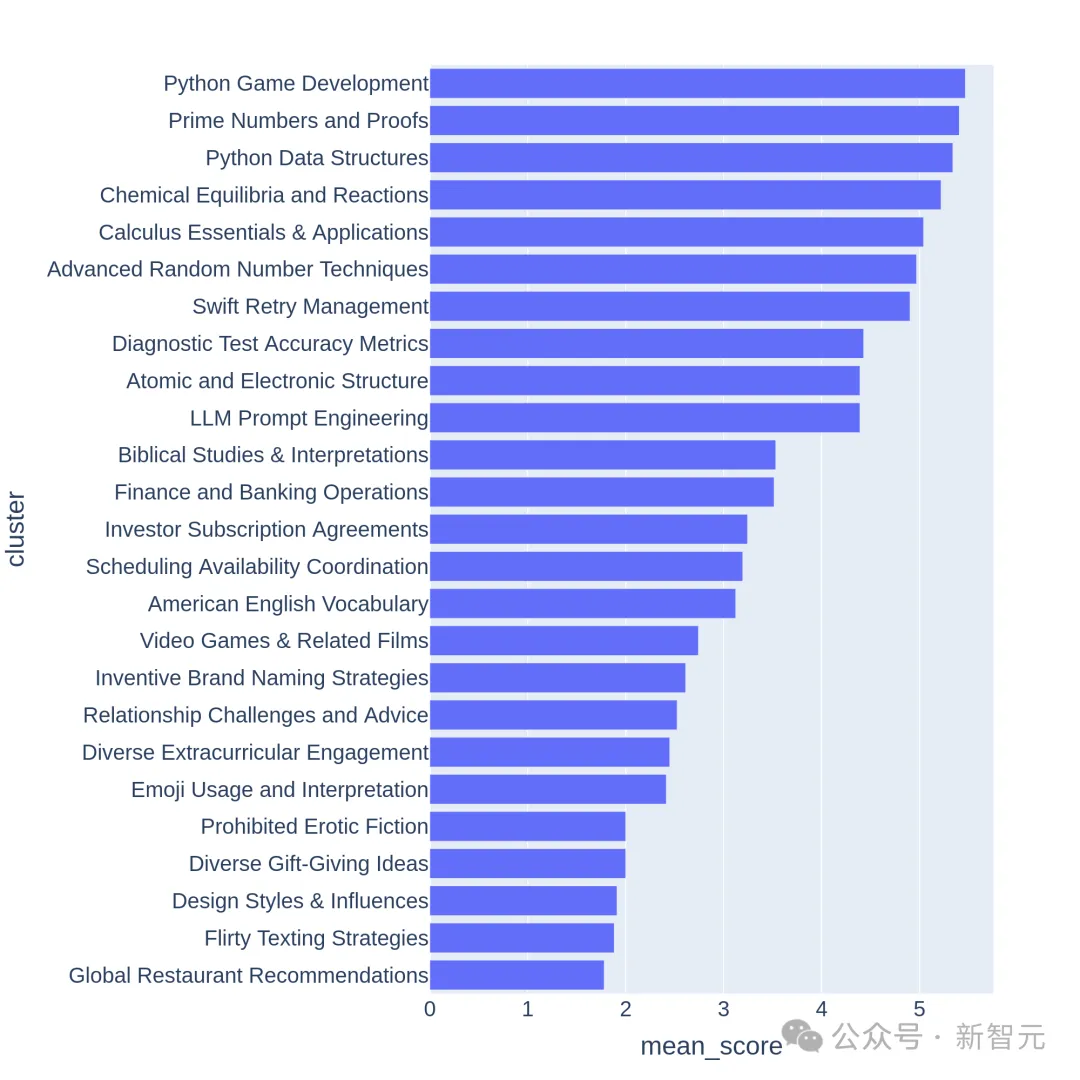

下圖展示了部分聚類的平均分排序:

圖片

圖片

我們可以觀察到,得分較高的聚類通常是比較有挑戰性的主題(比如游戲開發、數學證明),而分數較低的聚類則屬于瑣碎或模棱兩可的問題。

有了這個復雜性,就可以拉開學霸與學渣之間的差距,我們看下面的實驗結果:

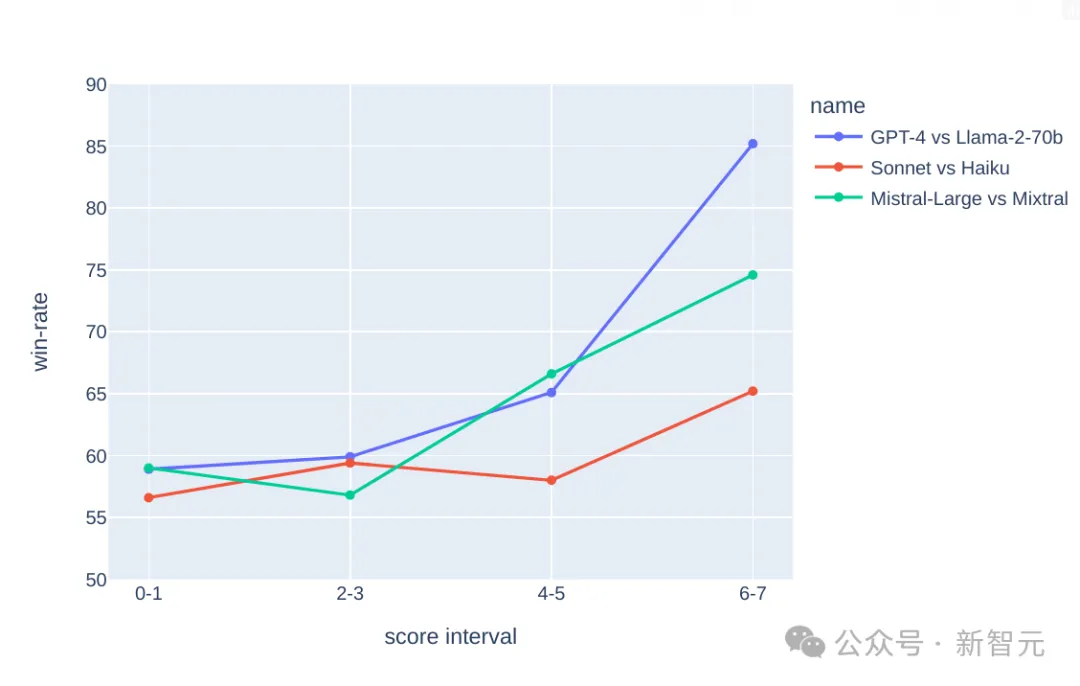

圖片

圖片

在上面的3個比較中,假設GPT-4比Llama2-70b強、Claude的大杯比中杯強,Mistral-Large比Mixtral強,

我們可以看到,隨著(復雜性)分數的增加,更強的模型的勝率也在提高——學霸獲得區分、學渣獲得過濾。

因為分數越好高(問題越復雜),區分度越好,所以最終選取了250 個平均得分>=6分(滿分7分)的高質量分類。

然后,隨機抽取每個類別的2個提示,形成了這版基準測試—— Arena-Hard-v0.1。

判卷老師靠譜嗎?

試卷出完了,誰來判卷是個問題。

人工當然是最準的,而且因為這是「Hard模式」,很多涉及領域知識的問題還需要專家前來評估——這顯然不行。

那么退而求其次,選擇目前公認的最聰明的模型GPT-4來當判卷老師。

比如上面的那些圖表中,涉及打分的環節,都是交給GPT-4來做的。另外,研究人員使用CoT提示LLM,在做出判決之前先生成答案。

GPT-4 判出的結果

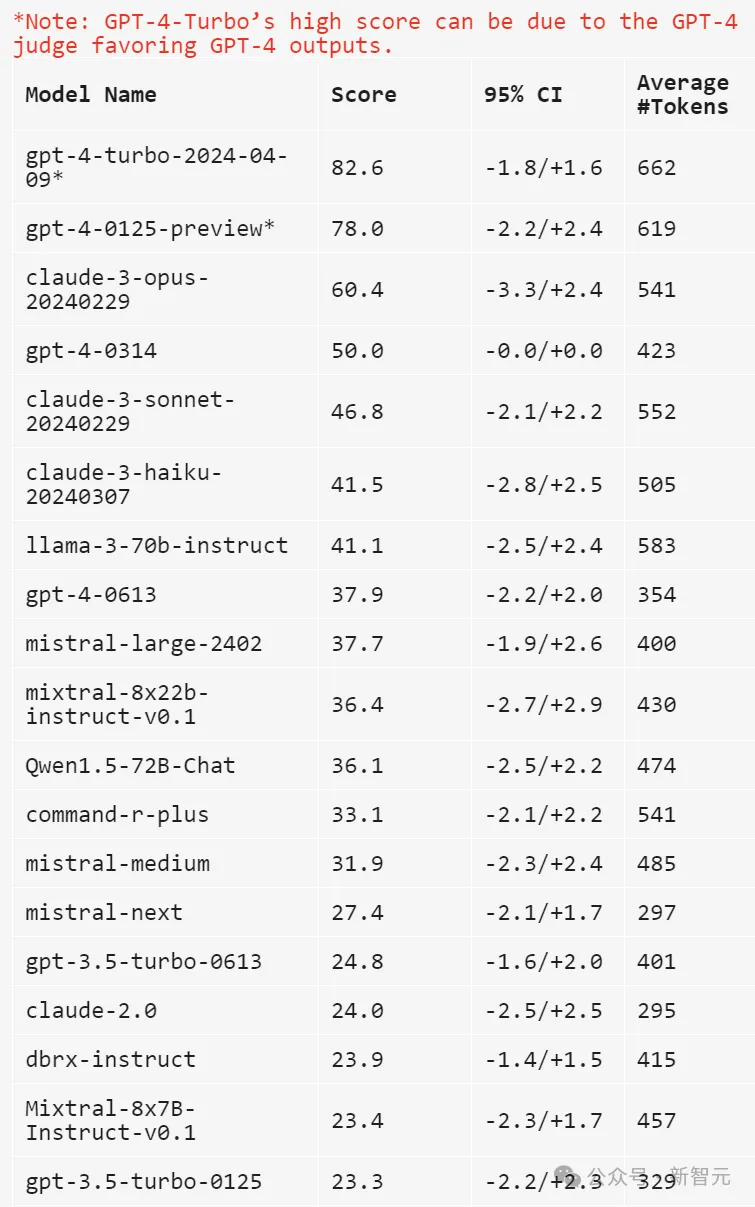

下面使用gpt-4-1106-preview作為判斷模型,用于比較的基線采用gpt-4-0314。

圖片

圖片

上表中比較并計算了每個模型的Bradley-Terry系數,并轉換為相對于基線的勝率作為最終分數。95%置信區間是通過100輪引導計算得出的。

克勞德表示不服

——我Claude-3 Opus也是排行榜并列第一啊,憑啥讓GPT當判卷老師?

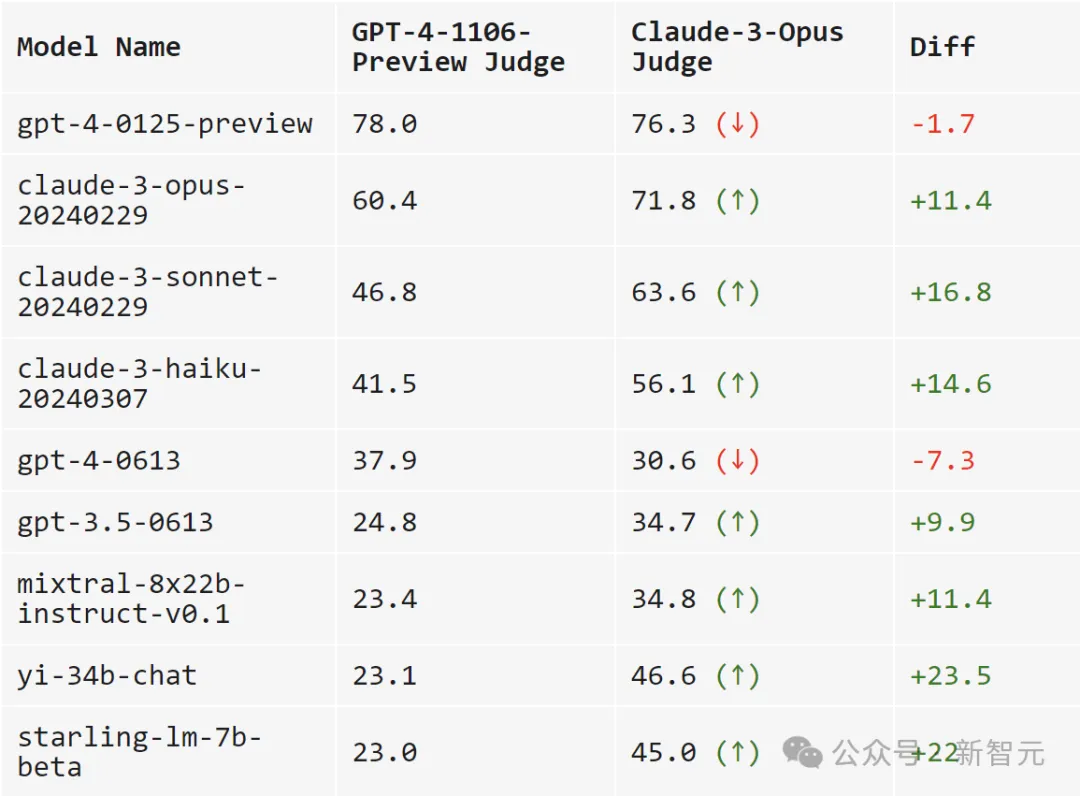

于是,研究人員比較GPT-4-1106-Preview和Claude-3 Opus作為判卷老師的表現。

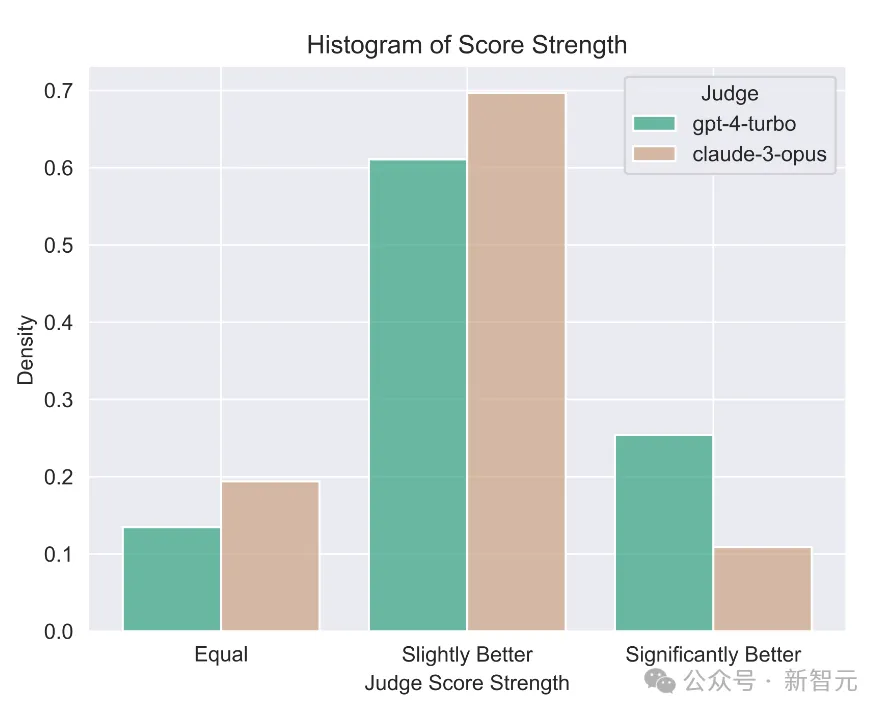

一句話總結:GPT-4是嚴父,Claude-3是慈母。

圖片

圖片

當使用GPT-4打分時,跨模型的可分離性更高(范圍從23.0到78.0)。

而當使用Claude-3時,模型的得分大多都提高了不少:自家的模型肯定要照顧,開源模型也很喜歡(Mixtral、Yi、Starling),gpt-4-0125-preview也確實比我更好。

Claude-3甚至愛gpt-3.5-0613勝過gpt-4-0613。

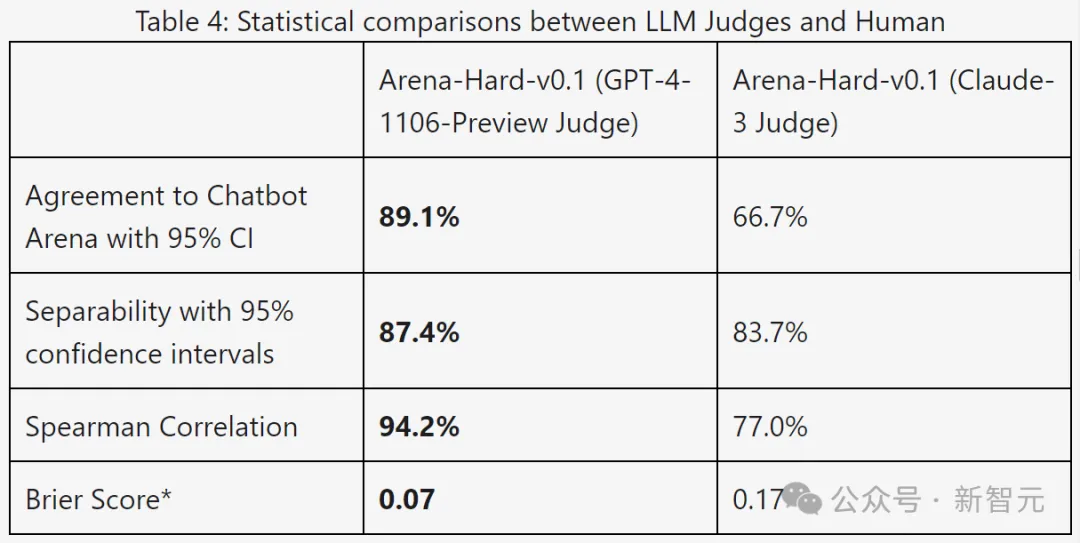

下表使用可分離性和一致性指標進一步比較了GPT-4和Claude-3:

圖片

圖片

從結果數據來看,GPT-4在所有指標上都明顯更好。

通過手動比較了GPT-4和Claude-3之間的不同判斷示例,可以發現,當兩位LLM意見不一致時,通常可以分為兩大類:

保守評分,以及對用戶提示的不同看法。

Claude-3-Opus在給分時比較寬容,給出苛刻分數的可能性要小得多——它特別猶豫是否要宣稱一個回答比另一個回答「好得多」。

相比之下,GPT-4-Turbo會識別模型響應中的錯誤,并以明顯較低的分數懲罰模型。

另一方面,Claude-3-Opus有時會忽略較小的錯誤。即使Claude-3-Opus確實發現了這些錯誤,它也傾向于將它們視為小問題,并在評分過程中非常寬容。

即使是在編碼和數學問題中,小錯誤實際上會完全破壞最終答案,但Claude-3-Opus仍然對這些錯誤給予寬大處理,GPT-4-Turbo則不然。

圖片

圖片

對于另外一小部分提示,Claude-3-Opus和GPT-4-Turbo以根本不同的角度進行判斷。

例如,給定一個編碼問題,Claude-3-Opus傾向于不依賴外部庫的簡單結構,這樣可以為用戶提供最大教育價值的響應。

而GPT-4-Turbo可能會優先考慮提供最實用答案的響應,而不管它對用戶的教育價值如何。

雖然這兩種解釋都是有效的判斷標準,但GPT-4-Turbo的觀點可能與普通用戶更接近。

有關不同判斷的具體例子,參見下圖,其中許多都表現出這種現象。

圖片

圖片

局限性測試

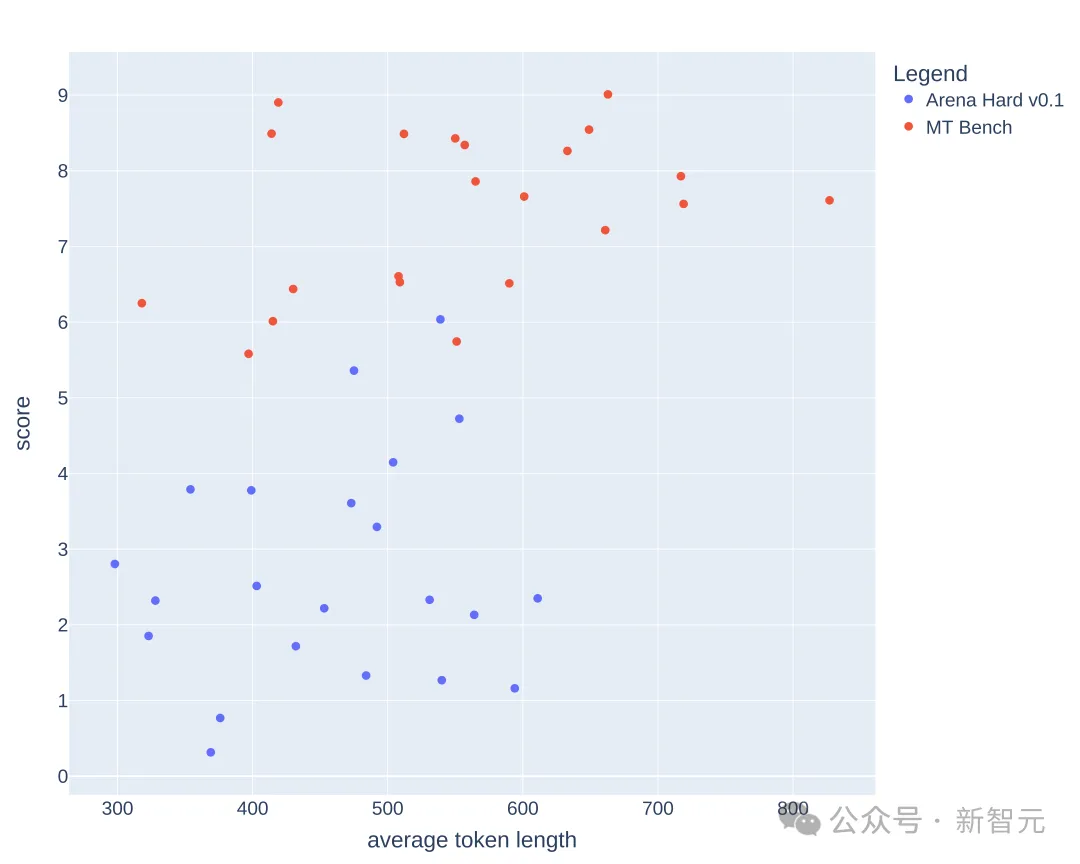

LLM喜歡更長的回答嗎?

下面繪制了在MT-Bench和Arena-Hard-v0.1上,每個模型的平均token長度和分數。從視覺上看,分數和長度之間沒有很強的相關性。

圖片

圖片

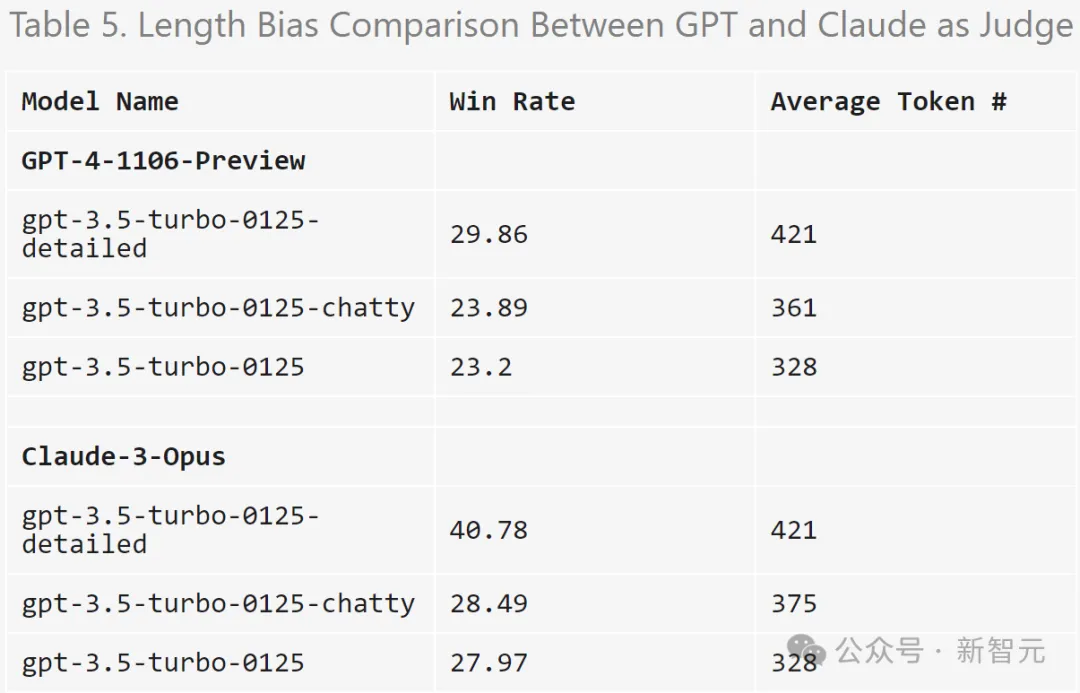

為了進一步檢查潛在的冗長偏差,研究人員使用GPT-3.5-Turbo對三種不同的系統提示(原始、健談、詳細)進行了消融。

結果表明,GPT-4-Turbo和Claude-3-Opus的判斷都可能受到更長輸出的影響,而Claude受到的影響更大(因為GPT-3.5-Turbo對GPT-4-0314的勝率超過40%)。

有趣的是,「健談」對兩位裁判的勝率影響不大,這表明輸出長度不是唯一的因素,更詳細的答案也可能受到LLM評委的青睞。

圖片

圖片

實驗使用的提示:

detailed: You are a helpful assistant who thoroughly explains things with as much detail as possible.

chatty: You are a helpful assistant who is chatty.

GPT-4 判斷的方差

研究人員發現,即使溫度=0,GPT-4-Turbo仍可能產生略有不同的判斷。

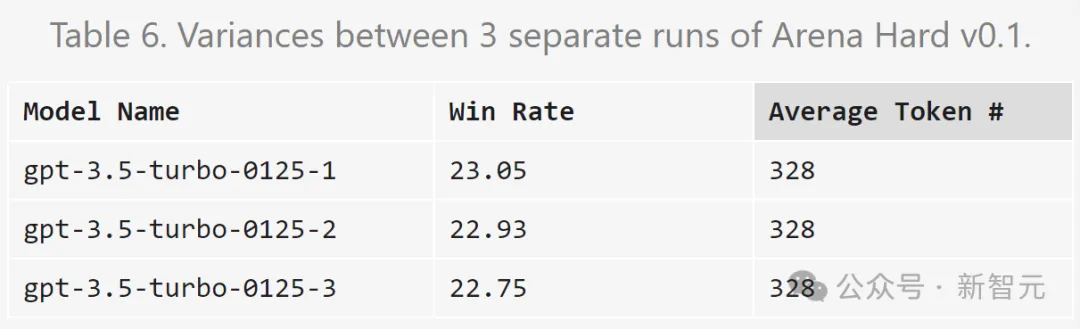

下面對gpt-3.5-turbo-0125的判斷重復三次并計算方差。

圖片

圖片

由于預算有限,這里只對所有模型進行一次評估。不過作者建議使用置信區間來確定模型分離。