開源模型打敗GPT-4!LLM競技場最新戰報,Cohere Command R+上線

GPT-4又又又被超越了!

近日,LLM競技場更新了戰報,人們震驚地發現:居然有一個開源模型干掉了GPT-4!

這就是Cohere在一周多前才發布的Command R+。

排行榜地址:https://huggingface.co/spaces/lmsys/chatbot-arena-leaderboard

截至小編碼字的這個時間,競技場排行榜更新到了4月11號,Command R+拿到了2.3萬的投票,

綜合得分超越了早期版本的GPT-4(0613),和GPT-4-0314版本并列第7位,——而它可是一個開源模型(不允許商用)。

這邊建議Altman,不管是GPT-4.5還是GPT-5,趕緊端上來吧,不然家都被偷沒了。

不過事實上OpenAI也沒閑著,在被Claude 3一家屠榜,忍受了短暫的屈辱之后,很快就放出了一個新版本(GPT-4-Turbo-2024-04-09),直接重歸王座。

這也導致排行榜上大家的排名瞬間都掉了一位,本來Command R+在9號的版本中是排位全球第6的。

——大哥你不講武德!

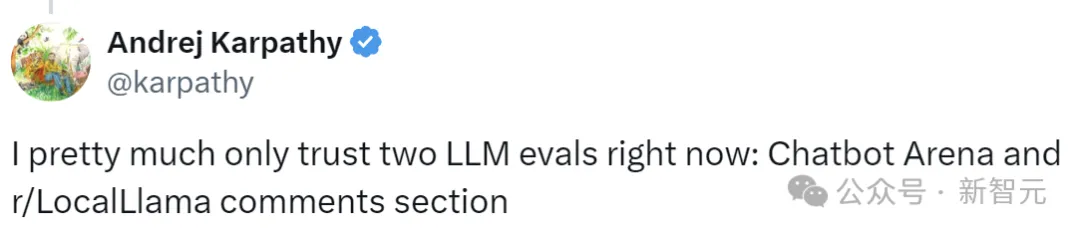

盡管如此,Command R+作為首個擊敗了GPT-4的開源模型,也算是讓開源社區揚眉吐氣了一把,而且這可是大佬認可的堂堂正正的對決。

Cohere的機器學習總監Nils Reimers還表示,這還不是Command R+的真實實力,它的優勢區間是RAG和工具使用的能力,而這些能力在LLM競技場中沒有用到。

事實上,在Cohere官方將Command R+描述為「RAG優化模型」。

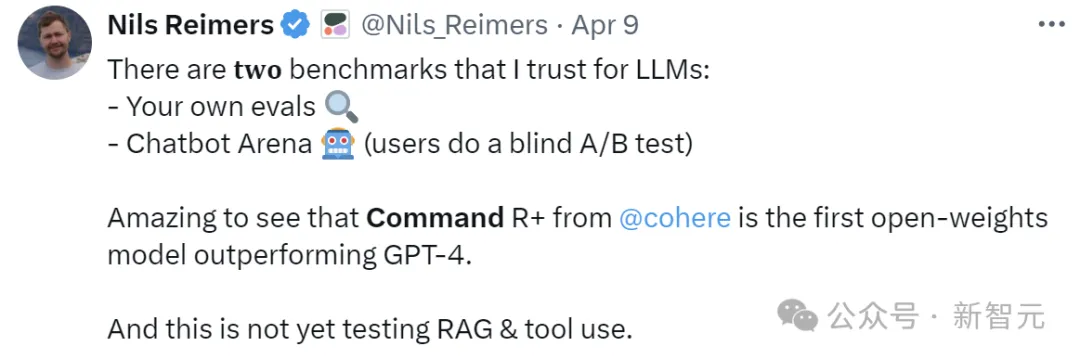

「割麥子」和最大的開源模型

毫無疑問,Cohere是當前AI領域的獨角獸,而它的聯合創始人兼CEO,正是大名鼎鼎的「Transformer八子」之一的「割麥子」(Aidan Gomez)。

Aidan Gomez

作為Transformer最年輕的作者,一出手就是最大規模的開源模型:

- 正面對戰claude-3, mistral-large, gpt-4 turbo;

- 1040億參數;

- 使用多步驟工具和RAG構建;

- 支持10種語言;

- 上下文長度為128K;

- 基于上下文的引用和響應;

- 針對代碼能力進行了優化;

- 提供4位和8位的量化版本。

Command R+專為實際企業用例而構建,專注于平衡高效率和高精度,使企業能夠超越概念驗證,并通過AI進入生產。

- huggingface地址:https://huggingface.co/CohereForAI/c4ai-command-r-plus

- 量化版本:https://huggingface.co/CohereForAI/c4ai-command-r-plus-4bit

——當然了,1040億的參數量,相比于前段時間Musk開源的Grok-1(3140億)還差了一些,但Command R+并非Grok那種MoE架構,

所以這1040億參數是實打實的完全用于推理,而Grok-1的活躍參數為860億——從這個角度來看,說Command R+是目前規模最龐大的開源模型也不為過。

作為Command R的進化版本,進一步全面提高了性能。主要優勢包括:

- 高級檢索增強生成(RAG)與引用以減少幻覺

- 10種主要語言的多語言覆蓋,支持全球業務運營

- 工具的運用以自動化復雜的業務流程

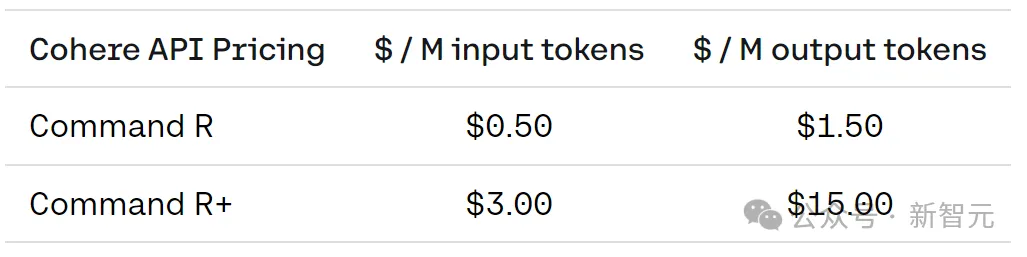

在性能優于競品的同時,Command R+還提供了相對低得多的價格。

目前,Cohere已經與多家大廠合作,并將LLM部署到了Amazon Sagemaker和Microsoft Azure。

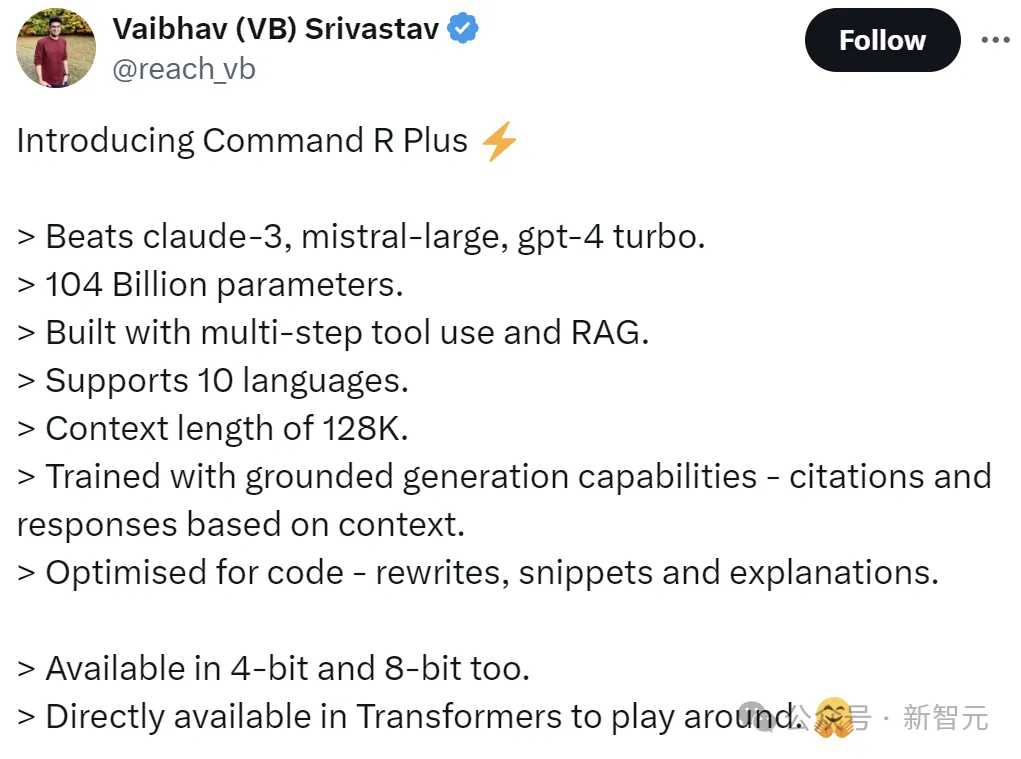

上面左圖展示了Azure上可用的模型,在三個關鍵功能方面的性能比較(模型在基準測試中的平均得分):多語言、RAG和工具使用。

右圖比較了Azure上可用模型的每百萬個輸入和輸出token成本。

行業領先的RAG解決方案

企業想通過專有數據定制自己的LLM,就必然繞不開RAG。

Command R+針對高級RAG進行了優化,可提供高度可靠、可驗證的解決方案。

新模型提高了響應的準確性,并提供了減輕幻覺的內聯引用,可幫助企業使用AI進行擴展,以快速找到最相關的信息,

支持跨財務、人力資源、銷售、營銷和客戶支持等業務職能部門的任務。

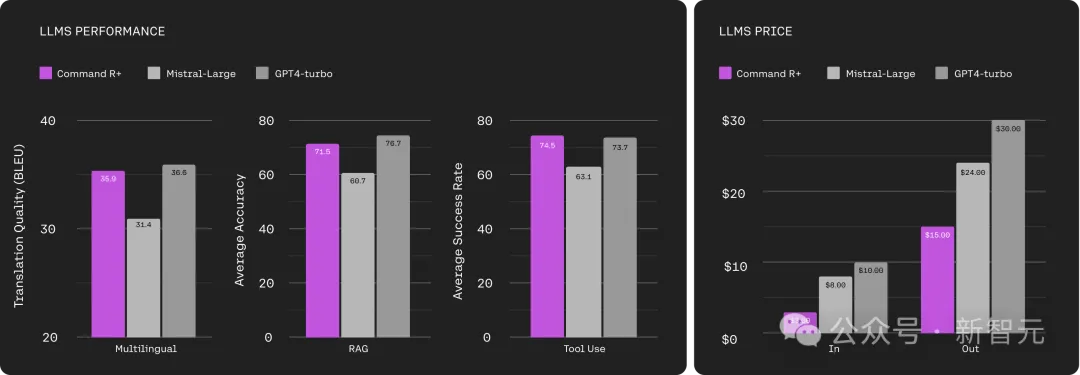

上面左圖是在人類偏好上的評估比較結果,包括文本流暢度、引文質量和整體效用,其中引文是在連接到源文檔塊的摘要上衡量的。

這里使用了250個高度多樣化的文檔和摘要請求的專有測試集,包含類似于API數據的復雜指令。基線模型經過了廣泛的提示設計,而 Command R+使用RAG-API。

右圖衡量了由各種模型提供支持的多跳REACT代理的準確性,可以訪問從維基百科(HotpotQA)和互聯網(Bamboogle、StrategyQA) 檢索的相同搜索工具。

HotpotQA和Bamboogle的準確性由提示評估者(Command R、GPT3.5和Claude3-Haiku)的三方多數投票來判斷, 以減少已知的模型內偏差。

這里使用人工注釋對一千個示例子集進行了驗證。StrategyQA的準確性是使用以是/否判斷結尾的長格式答案來判斷的。

使用工具自動執行復雜流程

作為大語言模型,除了攝取和生成文本的能力,還應該能夠充當核心推理引擎:能夠做出決策并使用工具來自動化需要智能才能解決的困難任務。

為了提供這種能力,Command R+提供了工具使用功能,可通過API和LangChain訪問,以無縫地自動化復雜的業務工作流程。

企業用例包括:自動更新客戶關系管理(CRM)任務、活動和記錄。

Command R+還支持多步驟工具使用,它允許模型在多個步驟中組合多個工具來完成困難的任務,——甚至可以在嘗試使用工具并失敗時進行自我糾正,以提高成功率。

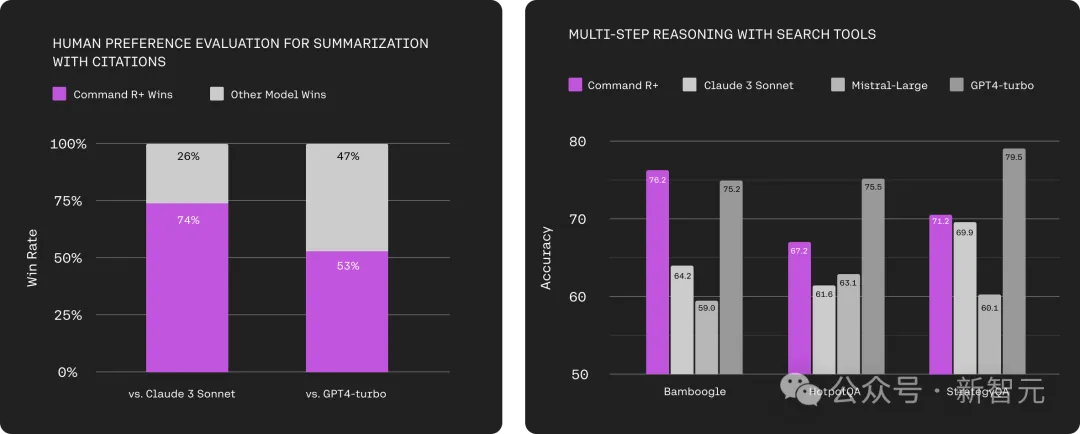

上圖為使用Microsoft的ToolTalk(Hard)基準測試,和伯克利的函數調用排行榜(BFCL)評估對話工具使用和單輪函數調用功能。

對于ToolTalk,預測的工具調用是根據基本事實進行評估的,總體對話成功指標取決于模型召回所有工具調用和避免不良操作(即具有不良副作用的工具調用)的可能性。

對于BFCL,這里使用了2024年3月的版本,在評估中包含了錯誤修復,并報告了可執行子類別的平均函數成功率得分。通過額外的人工評估清理步驟驗證了錯誤修復,以防止誤報。

多語言支持

Command R+在全球業務的10種關鍵語言中表現出色:中文、英語、法語、西班牙語、意大利語、德語、葡萄牙語、日語、韓語、阿拉伯語。

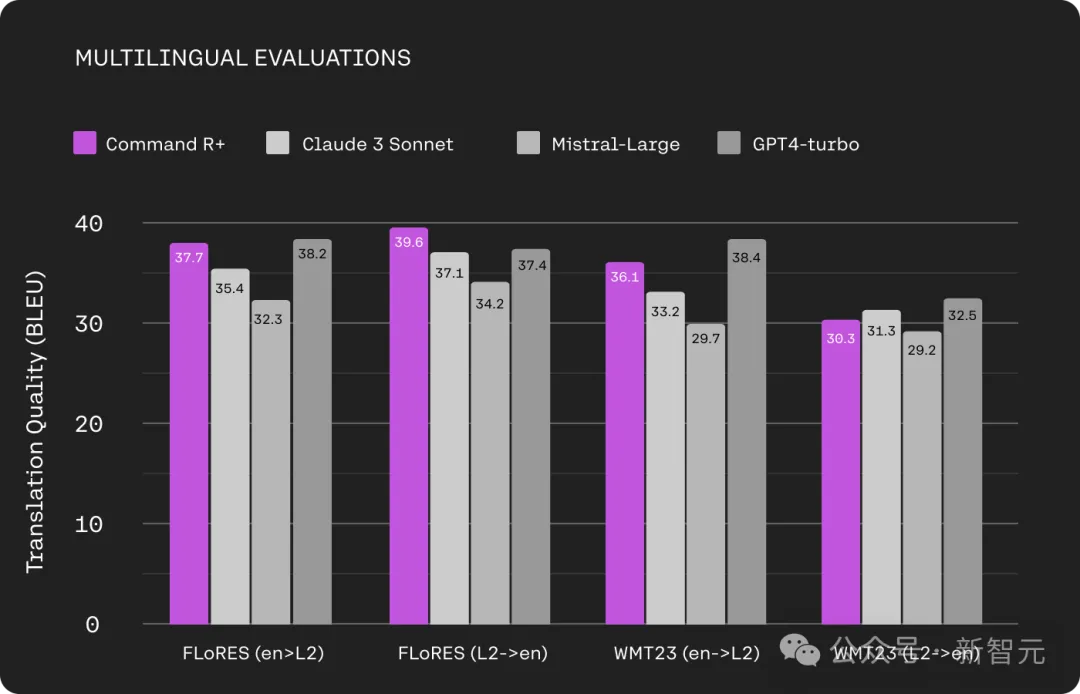

上圖為FLoRES(法語、西班牙語、意大利語、德語、葡萄牙語、日語、韓語、阿拉伯語和中文)以及WMT23(德語、日語和中文)翻譯任務的模型比較。

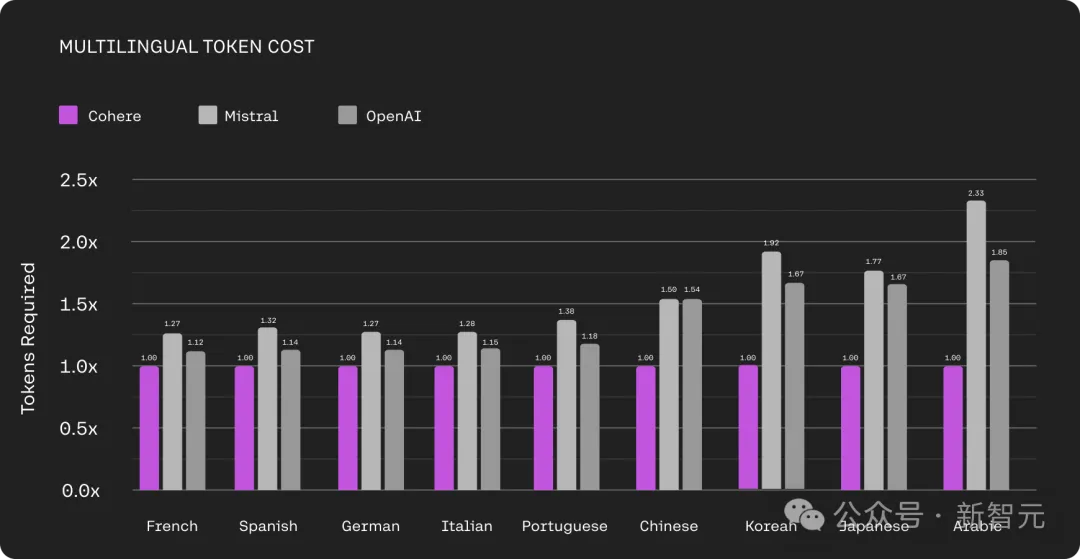

此外,Command R+還具有一個優秀的分詞器,可以比市場上其他模型使用的分詞器更好地壓縮非英語文本,能夠實現高達57%的成本降低。

上圖比較了Cohere、Mistral和OpenAI分詞器為不同語言生成的token數量。

Cohere分詞器生成的表示相同文本的token要少得多,尤其在非拉丁文字語言上減少的幅度特別大。比如在日語中,OpenAI分詞器輸出的token數量是Cohere分詞器的1.67倍。

價格

網友評價

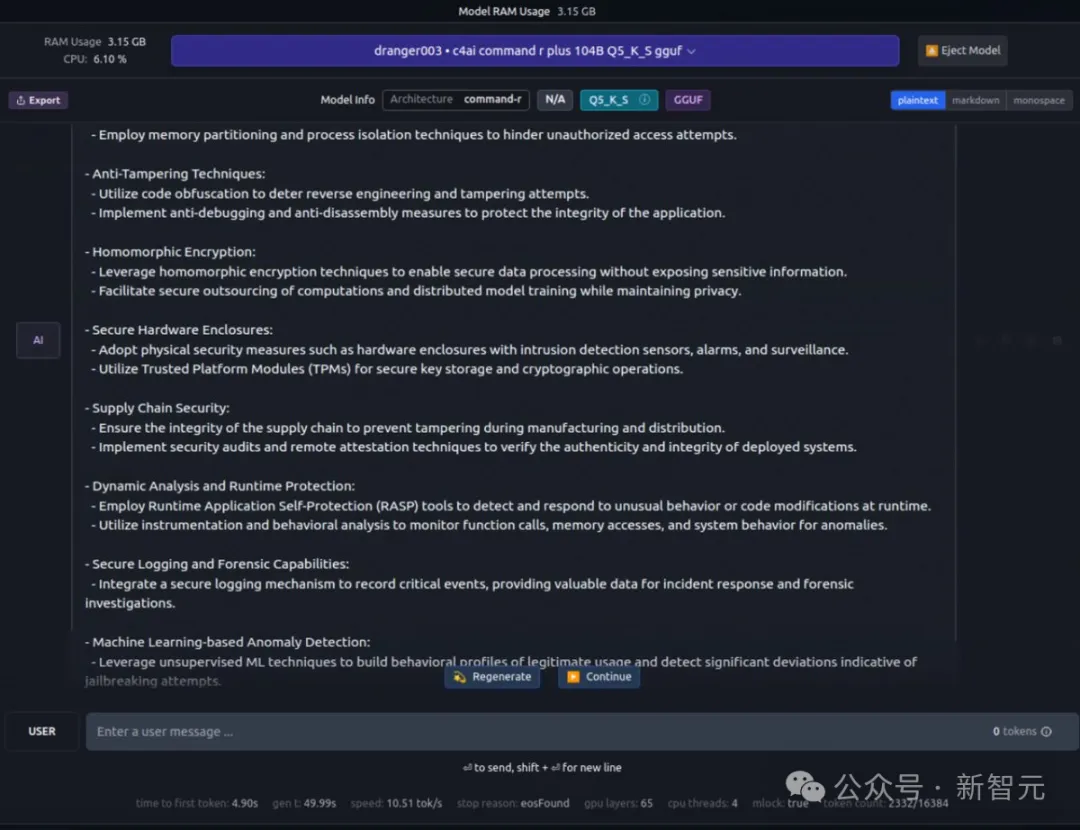

Command R+的開源點燃了網友們的熱情,網友表示:「GPT-4級性能,在家運行」。

不知道這3.15G的內存占用是什么情況?

「感謝Cohere做了Mistral沒有做的事情」。

「根據我有限的初始測試,這是目前可用的最好的模型之一......而且它絕對有一種風格,感覺很好。感覺不像是ChatGPT主義的填充模型。」

——是時候為自己加一塊顯卡了!

上線HuggingChat

目前,Command R+已經上線HuggingChat(https://huggingface.co/chat),最強開源模型,大家趕快玩起來!

問:等紅燈是在等紅燈還是等綠燈?

解釋一下咖啡因來自咖啡果:

請回答弱智吧問題:隕石為什么每次都能精準砸到隕石坑?

我想配個6000多的電腦,大概要多少錢?

HuggingFace聯創Thomas Wolf曾表示,最近在LLM競技場上的情況發生了巨大變化:

Anthropic 的Claude 3家族成了閉源模型的贏家(曾經);而Cohere的Command R+是開源模型的新領導者。

2024年,在開源和閉源兩條道路上,LLM都發展迅猛。

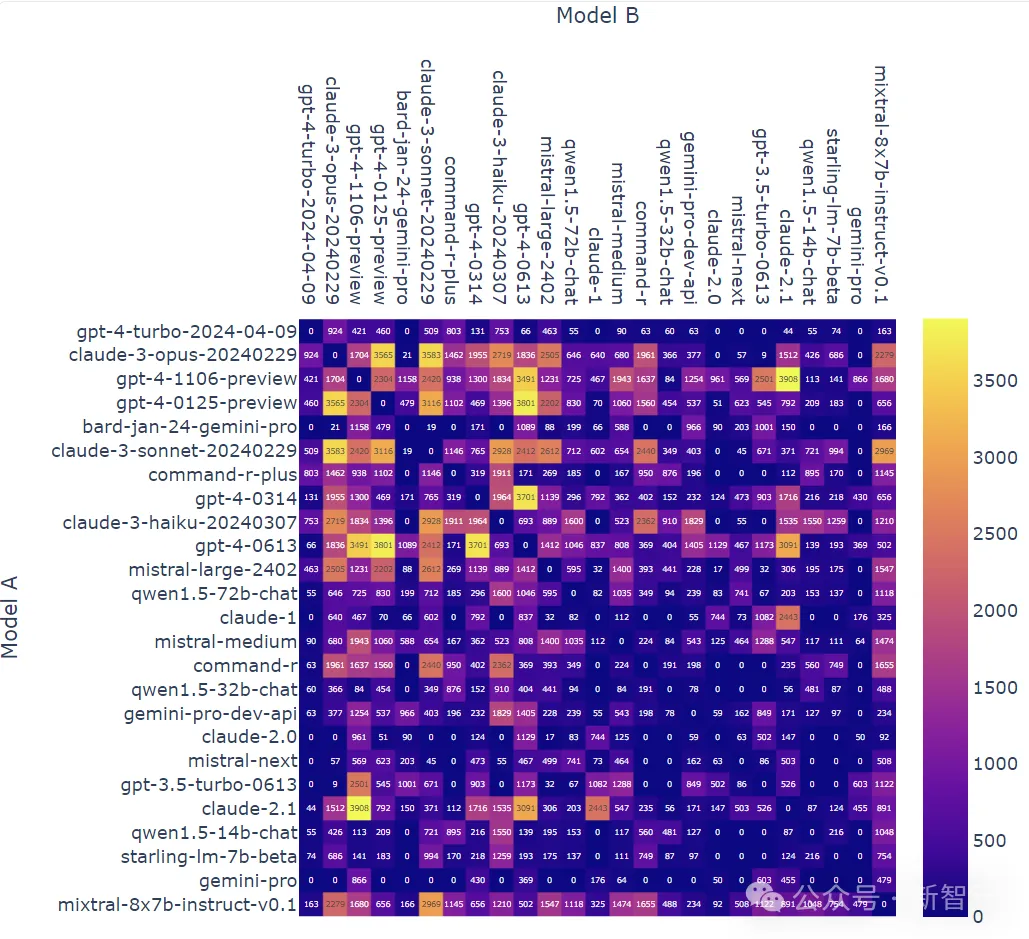

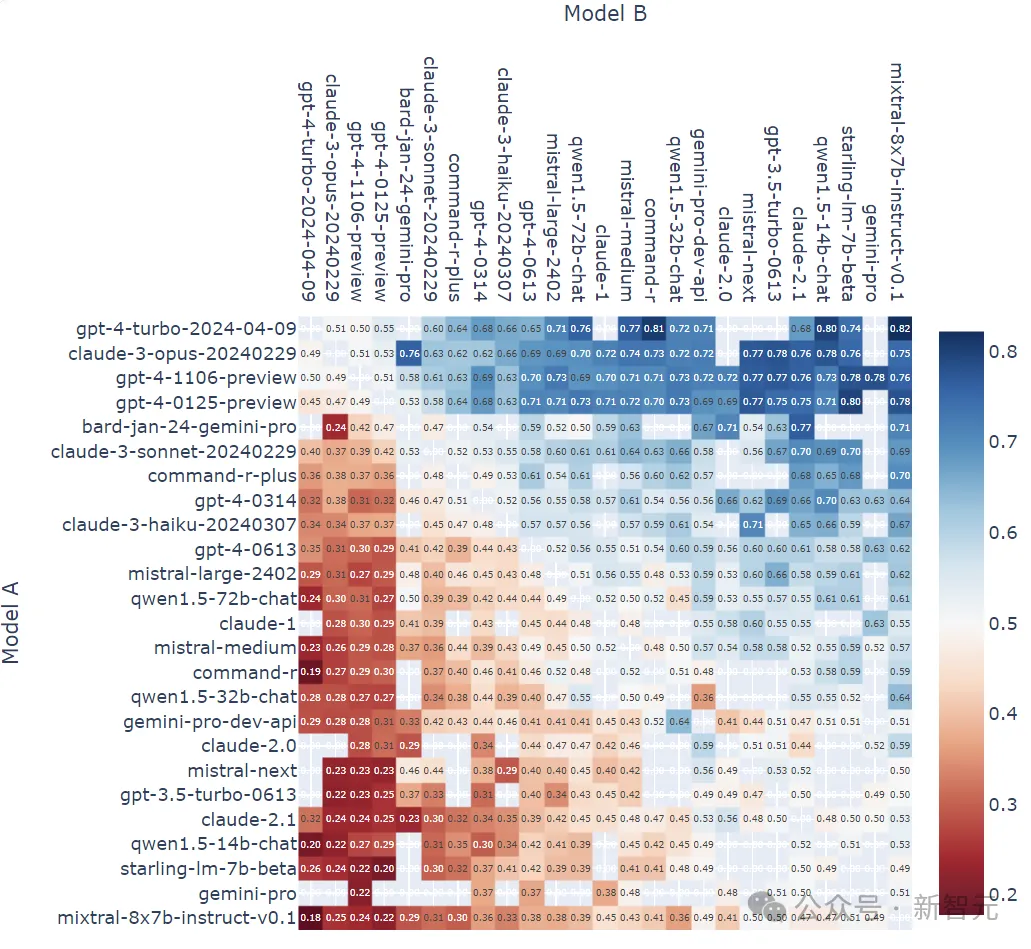

最后,放上兩張LLM競技場的當前戰況:

模型A在所有非平局A與B戰斗中獲勝的比例:

每種模型組合的戰斗計數(無平局):