MonoDETRNext:下一代準確高效的單目3D檢測方法!

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

寫在前面&筆者的個人理解

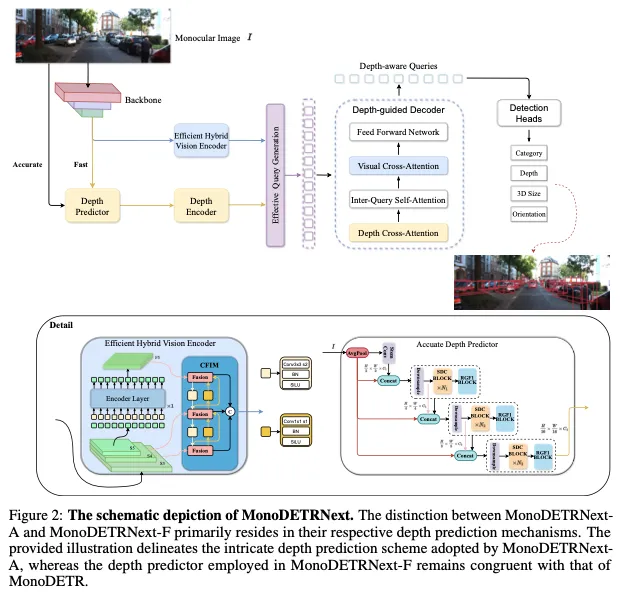

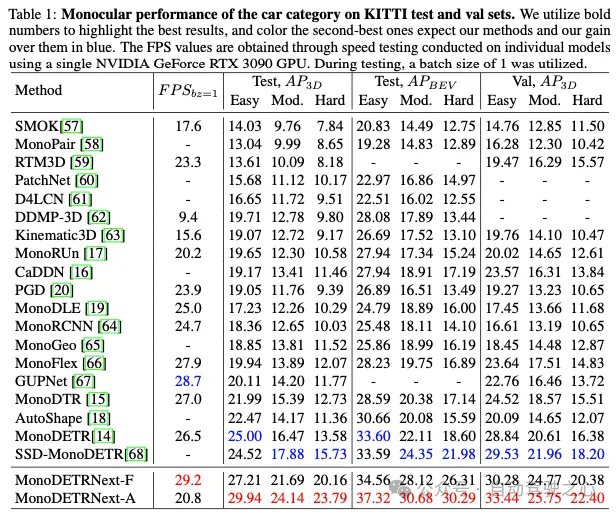

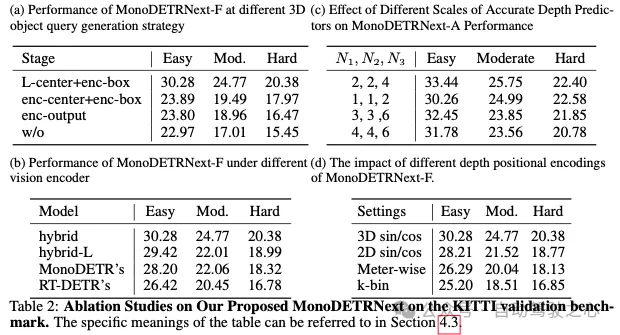

基于單目視覺的3D目標檢測在各個領域都至關重要,但現有方法在準確性和計算效率方面面臨著重大挑戰。在2D檢測和深度估計的成功策略的基礎上,本文提出了MonoDETRNext,它尋求在精度和處理速度之間取得最佳平衡。我們的方法包括開發高效的混合視覺編碼器,增強深度預測機制,以及引入創新的查詢生成策略,并通過高級深度預測器進行增強。在MonoDETR的基礎上,MonoDETRNext引入了兩種變體:強調速度的MonoDETRNext-F和注重精度的MonoDETRNext-A。我們認為MonoDETRNext為單目3D物體檢測建立了一個新的基準,并為未來的研究開辟了道路。我們進行了詳盡的評估,證明了該模型相對于現有解決方案的優越性能。值得注意的是,與MonoDETR相比,MonoDETRNext-A在KITTI測試基準上的AP3D指標提高了4.60%,而MonoDETRNext-F提高了2.21%。此外,MonoDETRNext-F的計算效率略高于其前身。

總結來說,本文的主要貢獻如下:

- 提出了兩種新的單目3D物體檢測模型,即MonoDETRNext-F和MonoDETRNext-A,前者充分平衡了速度和精度,而后者強調了以精度為中心的目標。

- 構建用于3D目標檢測的混合視覺編碼器,精通對單目3D目標檢測任務至關重要的特征的有效提取,以及集成精細但輕便的深度估計模塊,可視化以提高檢測精度。

- 利用迄今為止在2D目標檢測范式中根深蒂固的方法,我們提出了一種有說服力的目標查詢生成策略,該策略以精心設計的訓練策略為基礎,旨在有效優化模型性能,以適應單目3D目標檢測的需求。

相關工作回顧

目前的3D目標檢測方法通常可以分為兩類:基于相機的方法和集成激光雷達和其他傳感器的融合方法。

基于相機的方法可以根據輸入視點的數量進一步分為單目(單視圖)和多視圖方法。單色探測器僅使用前向圖像作為輸入,以有限的2D信息處理更復雜的任務。多視圖檢測器同時對周圍場景的圖像進行編碼,利用視點之間的關系來理解3D空間。另一方面,基于激光雷達和其他傳感器集成的融合方法依賴于來自深度相機和激光雷達等設備的輸入,這些設備提供了各種傳感器數據類型的融合,包括圖像和點云。因此,他們可以獲得更豐富、更全面的深度信息。盡管成本較高,但這些方法通常在復雜環境中表現出更大的魯棒性和準確性,因為它們可以利用多個傳感器的優勢并集成來自不同數據源的信息。

MonoDETR and other monocular 3D detection

MonoDETR是一種最先進的方法,它利用渲染傳輸從單個RGB圖像預測深度圖。與傳統的單目深度估計方法相比,通過捕捉輸入圖像中的細微線索,MonoDETR實現了對不同照明條件的準確度和魯棒性的提高。

近年來,已經提出了其他幾種單目3D重建方法。例如,MonoDTR是一個深度學習模型,使用基于Transformer的架構從單個RGB圖像預測深度圖。雖然MonoDTR實現了高精度,但它需要額外的激光雷達數據來輔助訓練。同時,CaDDN和Monorun不僅在訓練過程中需要激光雷達數據,而且在推理過程中也需要數據。Autoshape將CAD數據集成到模型中,以增強受限制的3D提示。MonoDETR需要最小的2D-3D幾何先驗,并且不需要額外的注釋。我們的MonoDETRNext繼承了這一特性。

如MonoDLE、PGD和PackNet所示,替代方法集成了多尺度特征融合和注意力機制,用于深度圖估計和誤差分析,從而提高了性能。盡管這些方法具有很高的準確性,但會產生大量的計算成本,并需要大量的內存資源。相反,MonoDETR的特點是其重量輕、效率高。此外,MonoDETRNext-F在速度和效率方面超過了它,而MonoDETRNext-A表現出明顯優越的性能。

Multi-view 3D object detection

為了從周圍視圖中聯合提取特征,DETR3D最初采用一組3D目標查詢,然后將其反向投影到多視圖圖像上以聚合特征。PETR系列進一步介紹了3D位置特征的生成,避免了不穩定的投影,并探索了前一幀的時間信息的優勢。

或者,BEVFormer及其改進使用可學習的BEV查詢生成BEV(鳥瞰圖)特征,并引入用于視覺特征聚合的時空BEV轉換器。隨后的研究還研究了跨模態蒸餾和mask圖像建模以提高性能。

LiDAR and multi-source information fusion 3D object detection

DeepFusion和PointPainting等方法代表了激光雷達點云數據與相機圖像集成的顯著進步,以促進三維空間環境中的精確目標檢測。這種融合策略最佳地利用了不同傳感器模態固有的協同效應,將空間深度線索與顏色紋理信息融合在一起,從而增強了檢測結果的彈性和準確性。

BevFusion將BEVFormer的原理集成到融合范式中,促進了進一步的改進,最終提高了精度,MV2D和Futr3d中描述的示例模型證明了這一點。mmFusion最近的端點通過集成來自多個傳感器(包括相機、激光雷達和雷達)的數據,擴展了融合方法的范圍,從而在性能上取得了顯著進步。

與此同時,該領域見證了大規模架構的出現,例如OMNI3D和GLEE,它們在3D目標檢測任務中表現出了顯著的效率。利用豐富的訓練數據和以數十億個或更多參數為特征的復雜模型架構,這些框架已經使用先進的優化算法進行了訓練,從而提高了檢測性能和精度。

方法

Efficient Hybrid Vision Encoder

根據[36]中的研究結果,可變形DETR將其49%的計算工作量分配給編碼器,但該組件僅對平均精度(AP)指標貢獻11%。

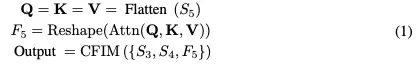

受RT-DETR架構的啟發,我們設計了一種創新的高效混合視覺編碼器,專門為3D目標檢測任務量身定制。該編碼器的特點是減少了計算占用,同時保持了特征提取的效率。如圖2所示,我們提出的編碼器包括兩個集成元件:奇異編碼器層和基于CNN的跨尺度特征集成模塊(CFIM)。如圖3所示,CFIM起著融合單元的作用,將形容詞特征融合成新穎的表征。該融合過程如以下公式:

Accurate Depth Predictor

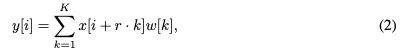

The Sequential Dilated Convolution (SDC)模塊,利用膨脹卷積提取多尺度局部特征。與lite-mono類似,我們采用了一種分階段的方法,通過插入具有不同膨脹率的多個連續膨脹卷積來有效地聚合多尺度上下文。

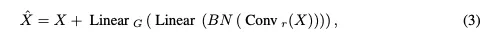

The Regional-Global Feature Interaction (RGFI)的操作如下:給定輸入特征圖X,它被線性投影到查詢、鍵和值中。交叉協方差注意力用于增強輸入X:

Effective Query Generation and Overall Loss

實驗結果

結論和限制

結論:本文介紹了一種新的基于單目視覺的3D目標檢測方法。利用2D檢測領域的進步,我們提出了高效而精確的MonoDETRNext。在MonoDETR奠定的基礎上,我們引入了兩種變體:MonoDETRNext-F優先考慮速度,MonoDETRNext-A強調準確性。我們的方法包括開發高效的混合視覺編碼器、增強深度預測機制以及改進目標查詢生成。通過綜合性能評估,我們確定了我們的模型相對于現有方法的優勢。通過優化精度和計算效率,MonoDETRNext在單目3D目標檢測方面樹立了一個新的基準,促進了未來在各種現實世界場景中的研究和應用。

局限性:盡管MonoDETRNext在提高單目3D物體檢測的準確性和計算效率方面取得了實質性進展,但仍存在某些局限性。由于單目視覺方法的固有限制,與采用多視圖方法或傳感器融合技術(如激光雷達與相機的集成)的方法相比,在精度和性能方面仍然存在顯著差異。