27歲華裔天才少年對打UC伯克利,首發SEAL大模型排行榜!Claude 3 Opus數學封神

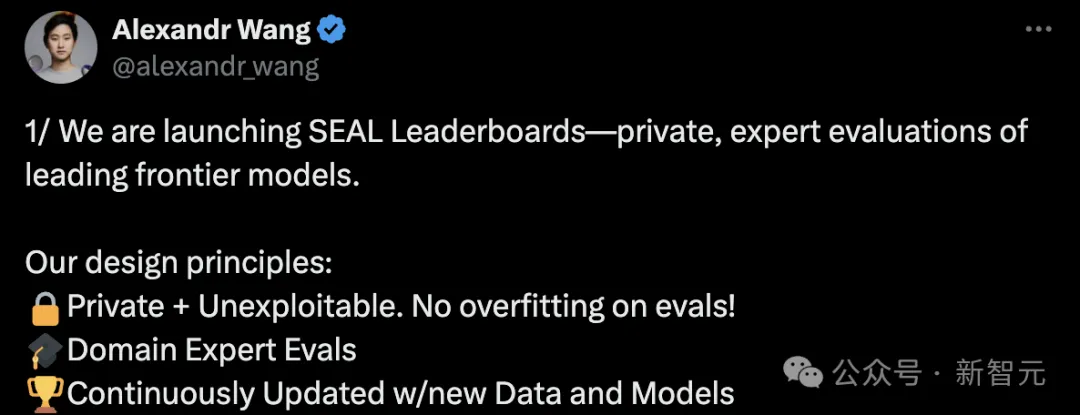

前段時間,由27歲的華裔創始人Alexandr Wang領導的Scale AI剛剛因為融資圈了一波關注。

今天,他又在推特上官宣推出全新LLM排行榜——SEAL,對前沿模型開展專業評估。

SEAL排行榜主打三個特色:

- 私有數據

Scale AI的專有私有評估數據集無法被操控,確保了結果的公正性和無污染。

- 不斷發展

定期使用新的數據集和模型更新排行榜,營造一個動態的競賽環境。

- 專家評估

評估由經過嚴格審查的專家進行,確保最高的質量和可信度。

榜單地址:https://scale.com/leaderboard

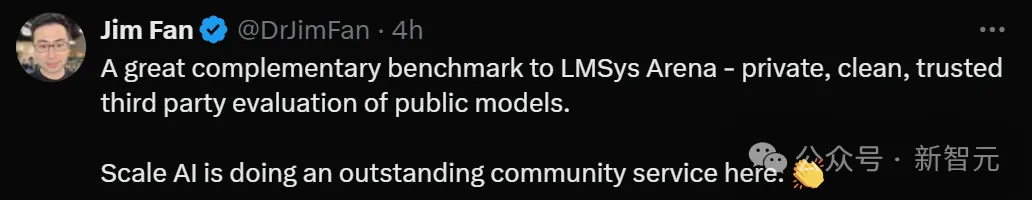

這篇推特獲得了Jim Fan大佬的轉發,他認為SEAL是LMSys的非常好的補充和參照,提供公開模型的私密、安全、可信的第三方評估。

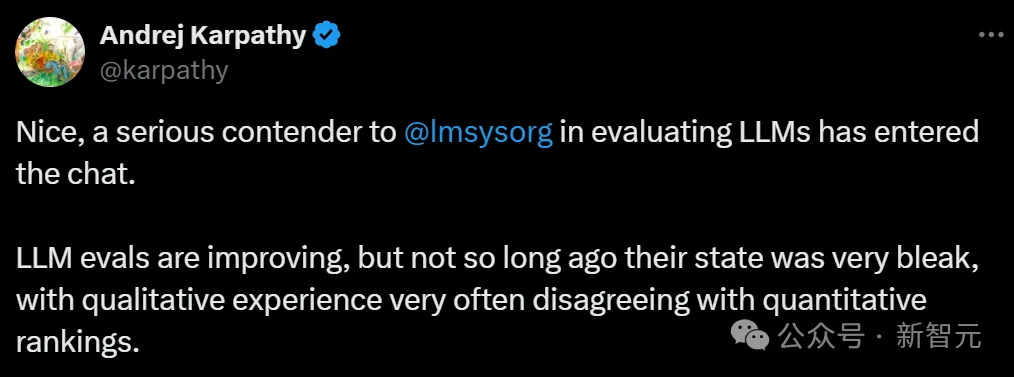

對此,Andrej Karpathy也深以為然。

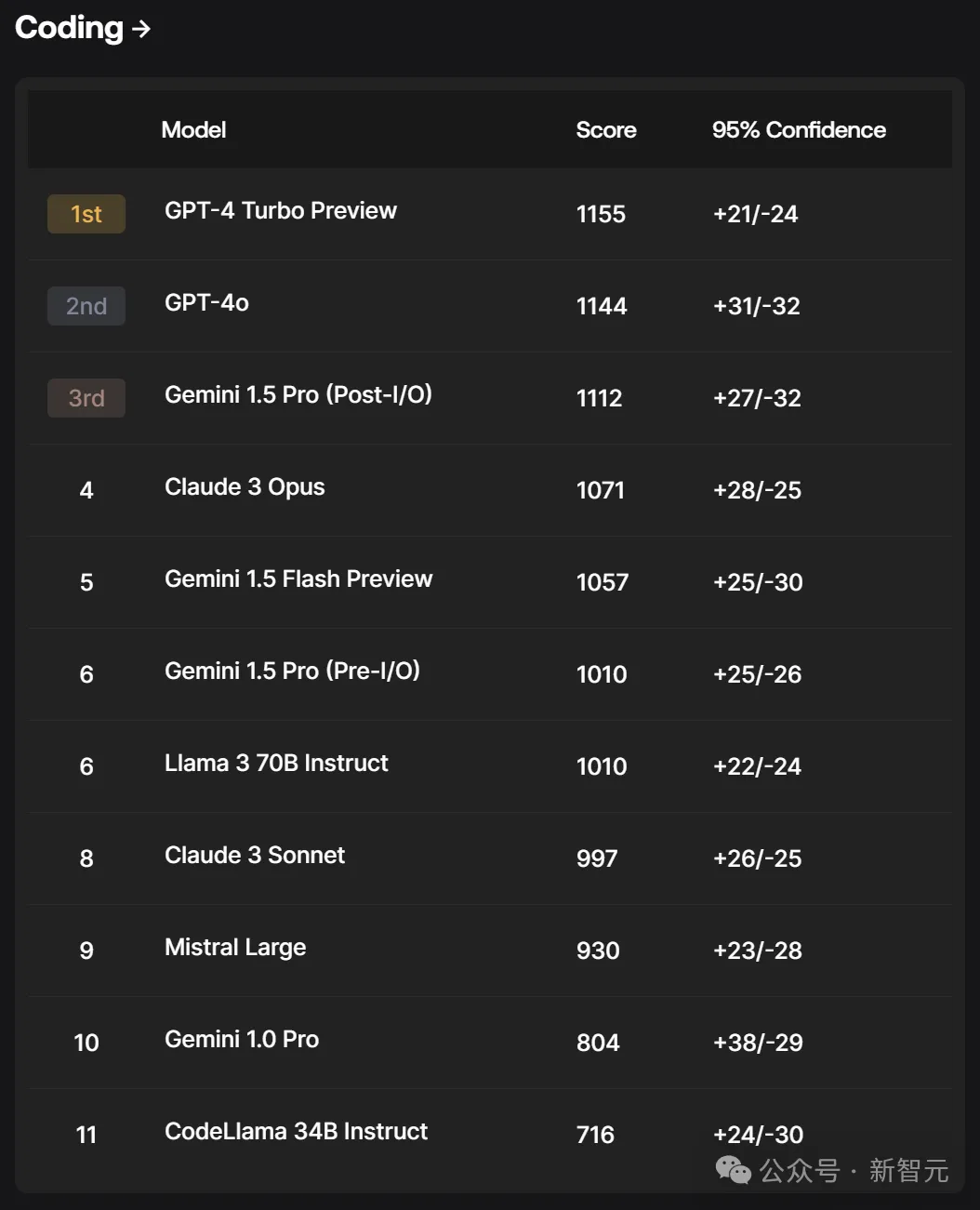

代碼

在代碼任務中,GPT-4 Turbo Preview位列第一,然后是GPT-4o、Gemini 1.5 Pro(Post-I/O)。

而專門訓練的代碼模型CodeLlama 34B Instruct排在了第11位。

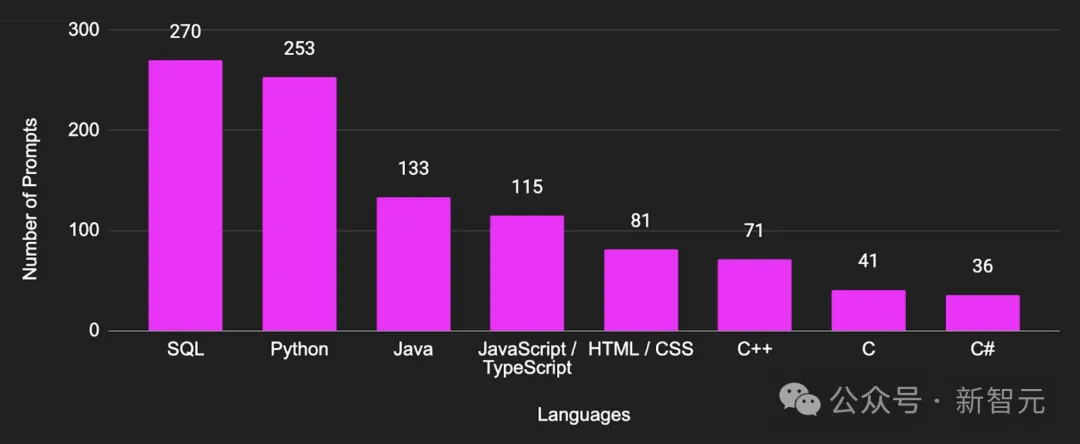

Scale AI編碼提示集包含1,000個提示,涵蓋各種編程語言、學科和編程任務,從調試到代碼優化,從文檔生成到理解復雜代碼庫,等等。

諸如HumanEva、Pass@k、MBPP、SWE-Bench、LiveCodeBench等評估基準在首次出現時很有用,但隨著模型開始過擬合,它們已經變得不那么有價值了。

此外,這些模型與這些基準進行評估的方法往往不標準化,缺乏跨測試或隨時間比較分數的核心要求。

Scale編碼評估提供了一個標準化的LLM評估框架,能夠跨模型進行比較并識別其優缺點。目前,它涵蓋了最常請求的編程語言的用例集。

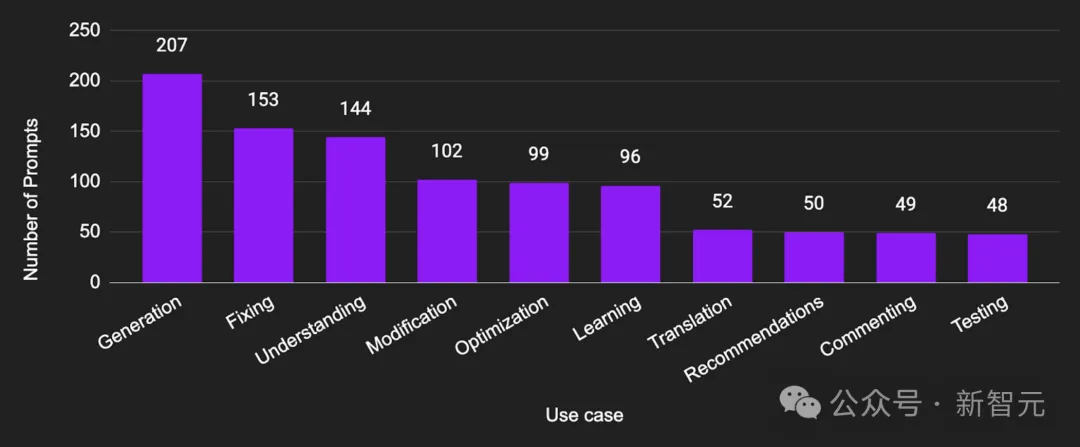

代碼生成:根據給定的自然語言規范或描述創建新代碼。

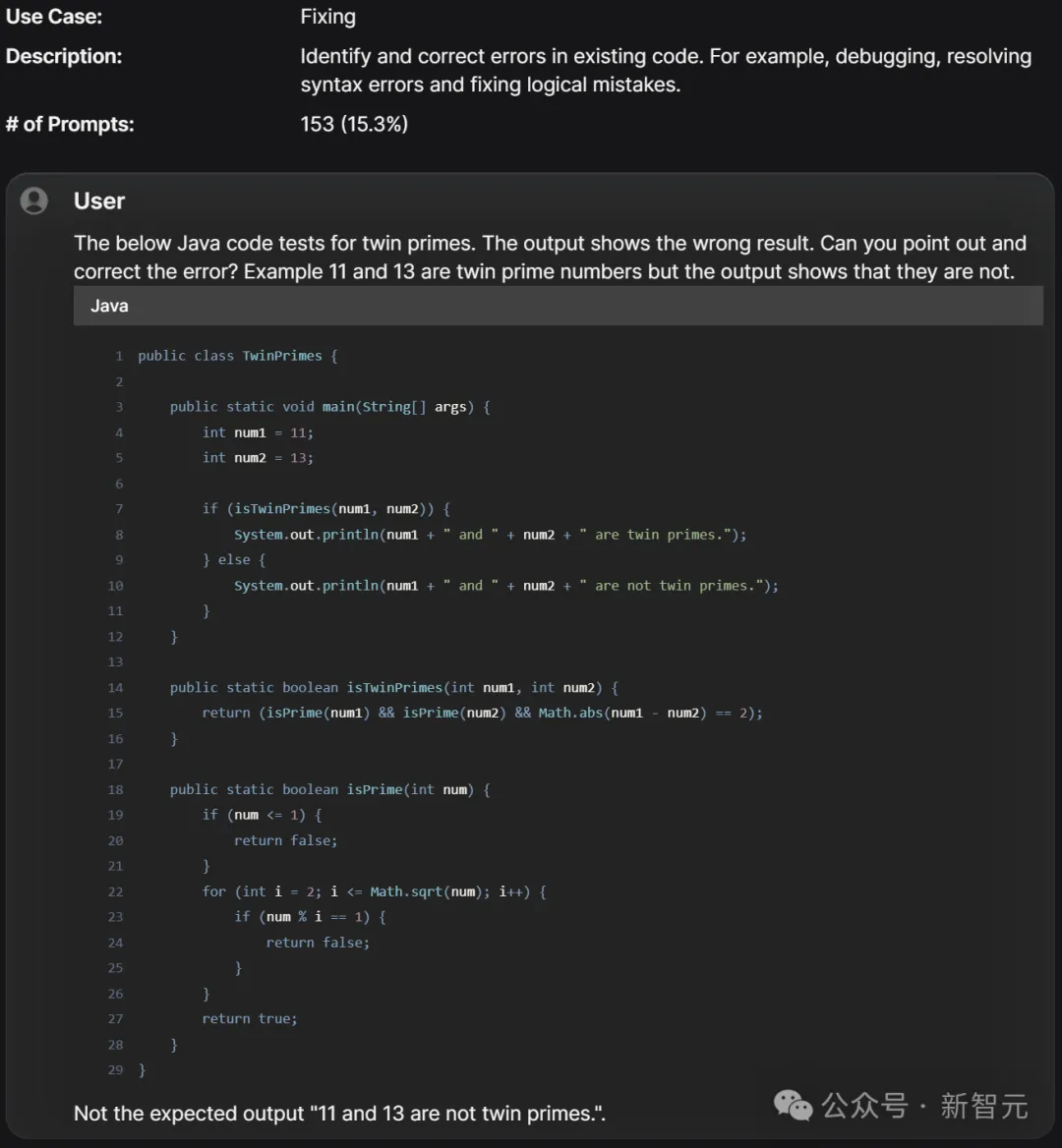

代碼修復:識別并糾正現有代碼中的錯誤。例如,調試、解決語法錯誤和修復邏輯錯誤。

代碼理解:解釋、闡明或澄清現有代碼。例如,闡明某些代碼段的工作原理,分解復雜算法。

代碼修改:對現有代碼進行更改或調整以滿足新要求或條件。例如,更改功能,更新或增強特性。

代碼優化:提高現有代碼的性能。例如,提高效率,減少資源消耗(如內存或處理時間)。

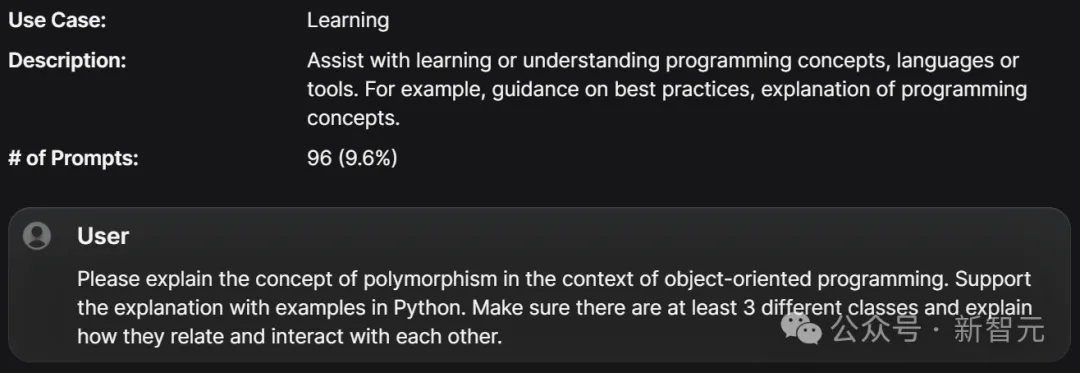

學習輔助:幫助學習或理解編程概念、語言或工具。例如,提供最佳實踐指導,解釋編程概念。

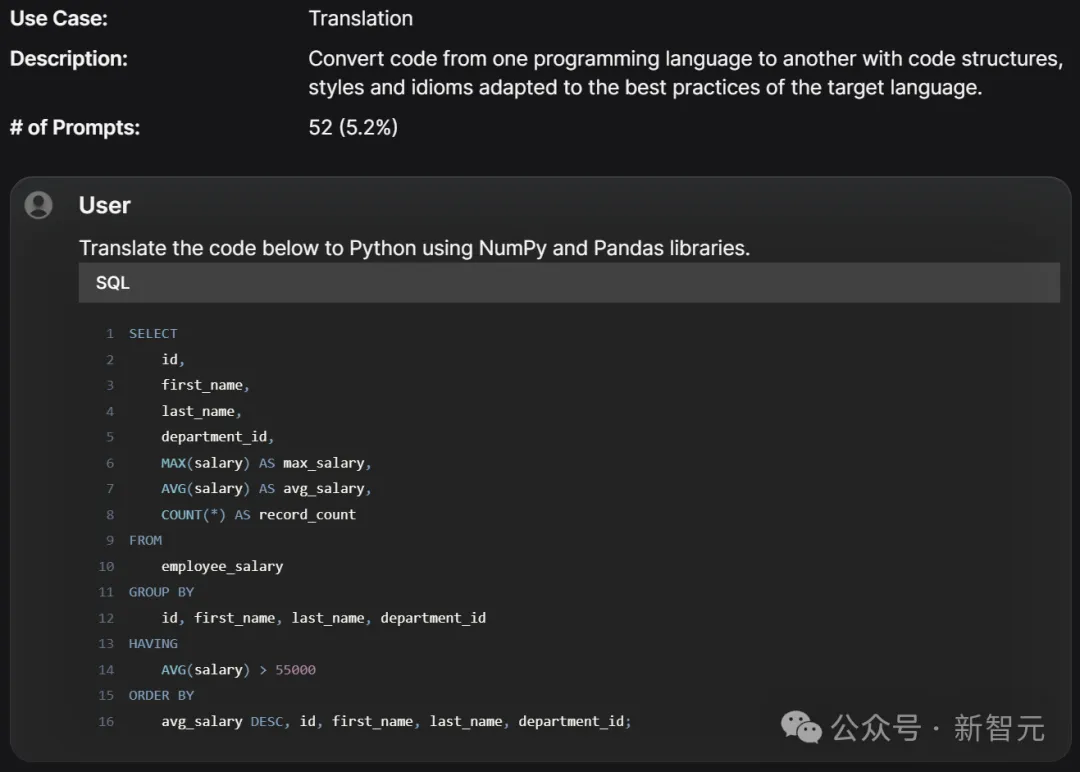

代碼翻譯:將代碼從一種編程語言轉換為另一種語言,并根據目標語言的最佳實踐調整代碼結構、風格和習慣用法。

建議提供:提供關于編碼實踐、工具、庫或框架的建議或意見。

注釋改進:在現有代碼中添加或改進注釋。

測試開發:開發、增強或修復現有代碼的測試。

用例分布

編碼語言分布

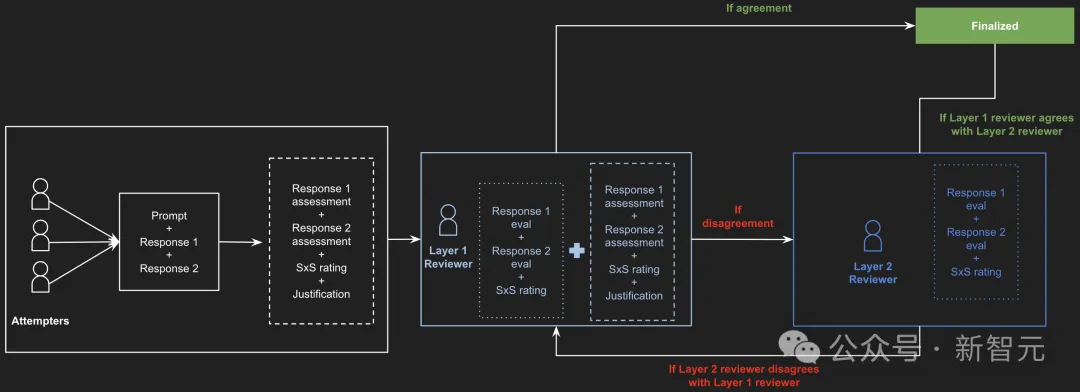

為了確保評估過程的徹底性和可靠性,每個任務由不同的人工注釋員并行執行了三次。

評分經過兩個階段的審查:初步審查層和最終審查層。

這種評估方法不僅生成總體排名,還有助于突出模型在不同領域的優勢和劣勢,并回答以下問題:

- 模型在SQL、Java、HTML/CSS和C++提示上的表現如何?

- 模型在復雜場景中的競爭力如何?

評估方法

測試栗子

結果分析

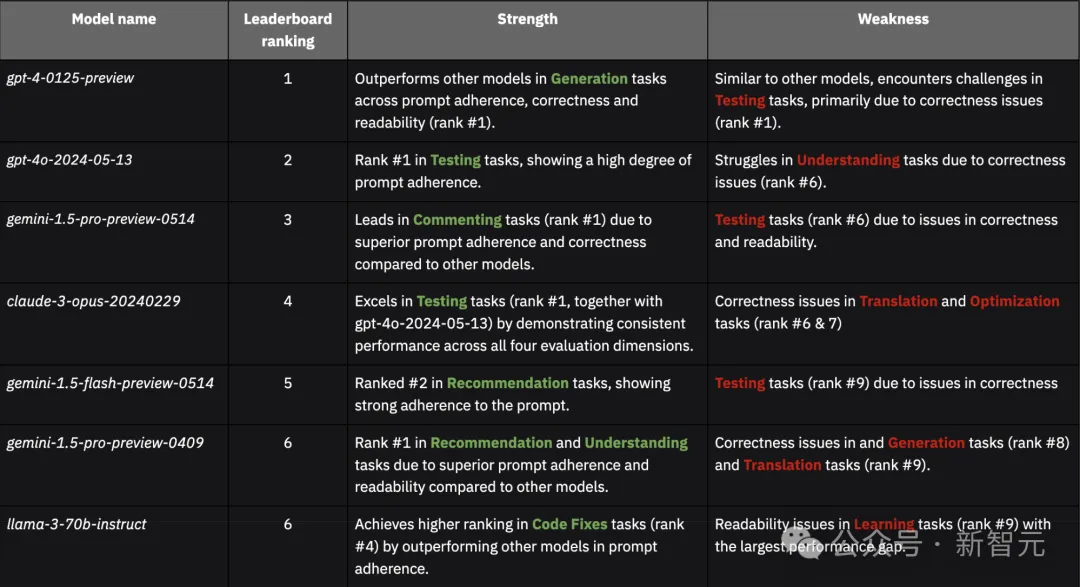

模型通常在「注釋」和「理解」任務中表現良好,但在「翻譯」和「生成」任務中常遇到困難。

此外,「正確性/功能性」和「可讀性/文檔」也是所有模型的兩個主要錯誤來源。

- GPT

兩個GPT-4模型在各種用例中表現最為一致。其中,較新的gpt-4o-2024-05-13相比gpt-4-0125-preview更容易出現可讀性問題,有時會不必要地重復提示中的代碼,導致響應更加冗長。

- Gemini

所有三個Gemini模型在建議任務中表現出色,分別排名第1、第2和第3,但在測試任務中表現較差。新的gemini-1.5-pro-preview-0514相比之前的gemini-1.5-pro-preview-0409有顯著提升,特別是在「正確性/功能性」和「可讀性/文檔」方面。

- Claude

claude-3-opus-20240229通常比claude-3-sonnet-20240229表現更好,特別是在「正確性/功能性」類別中錯誤更少,除了某些翻譯任務。

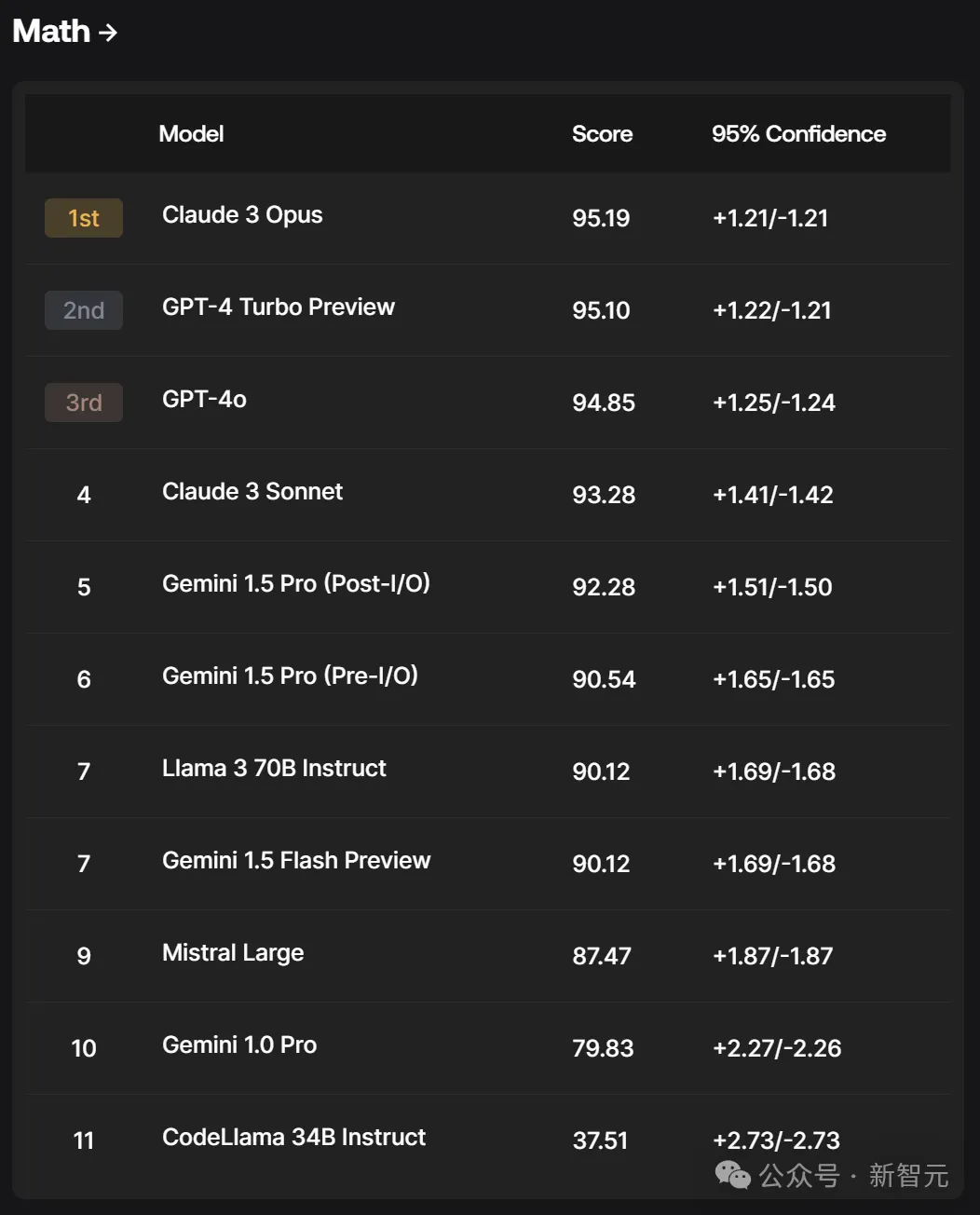

數學

在數學分類榜中,Claude 3 Opus竟打敗了GPT-4 Turbo Preview霸占榜首,然后第三名是GPT-4o.

另外,Claude 3的「中杯」模型Sonnet,都超過了Gemini系列的模型。

不得不說,在數學這塊,還是Claude3是王者。

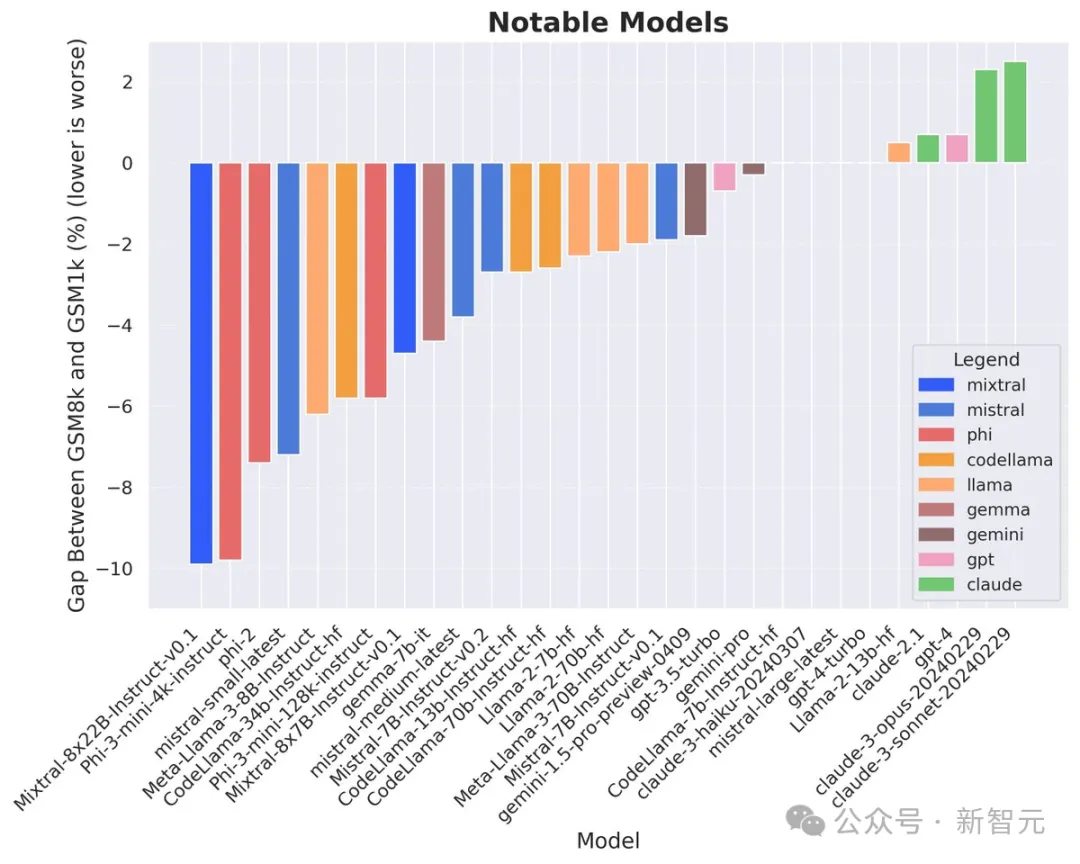

數學和推理仍然是當前大語言模型(LLM)面臨的主要未解決問題之一。然而,現有的公共基準如GSM8k卻存在著致命的數據污染問題。

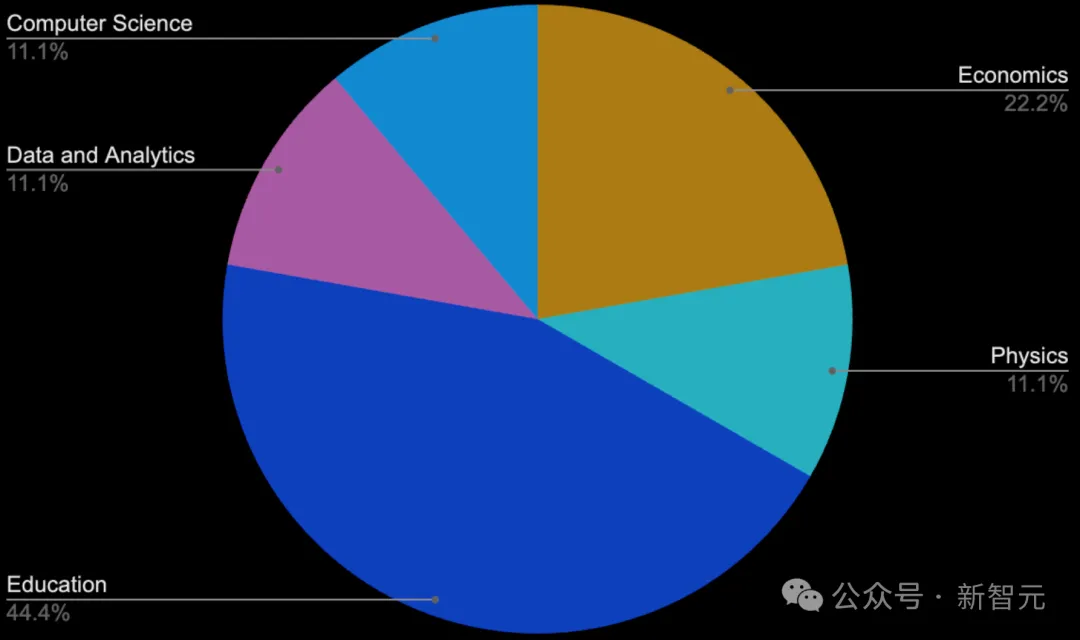

為全面評估模型的各方面能力,Scale AI設計了一個全新的數學和推理數據集——GSM1k。

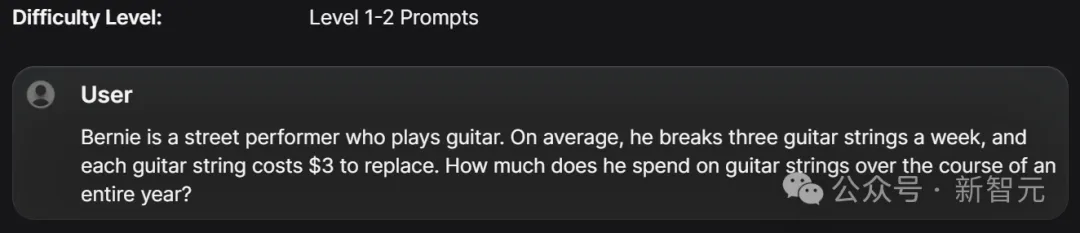

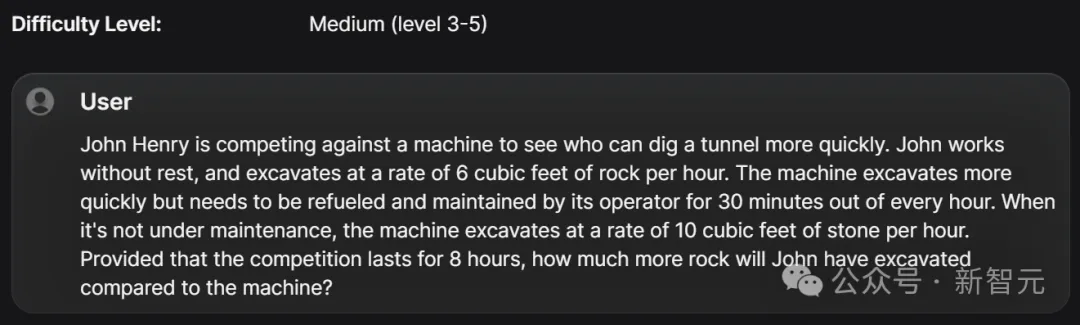

GSM1k基于GSM8k基準的分布和難度,并引入全新的一組問題。其中,包含了一系列相當于五年級數學考試水平的數學問題。

它的構建花了不到3周的時間,標注團隊的成員包括小學數學教育者和具有教育、數據分析、計算機科學、物理和經濟學背景的專家。

值得注意的是,GSM1k的數據收集過程并沒有用到LLM的幫助。

此外,為了防止模型在GSM1k上過擬合,團隊決定僅公開1,000個問題中的50個樣本。

測試栗子

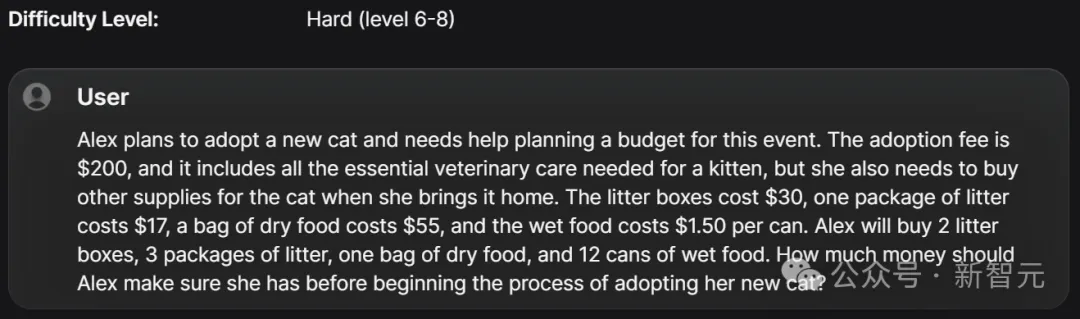

指令跟隨

針對模型指令跟隨測試,GPT-4o、GPT-4 Turbo Preview、Llama 3 70B Instruct分別躍居前三。

同時,Mistral Large的實力也不輸其他的模型。

這說明在能否準確遵循人類提示方面,GPT-4系列模型還是更厲害些。

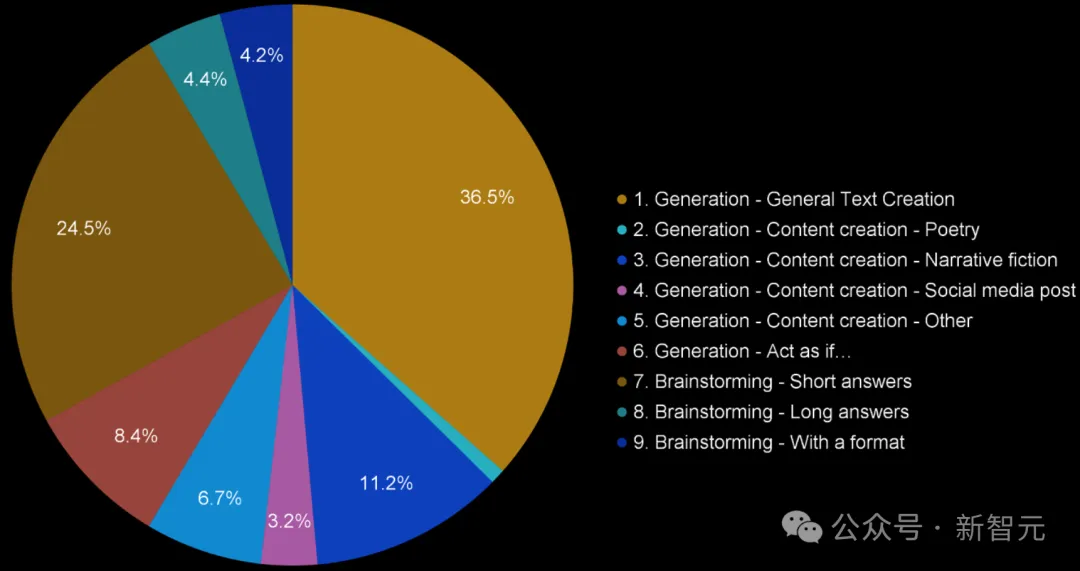

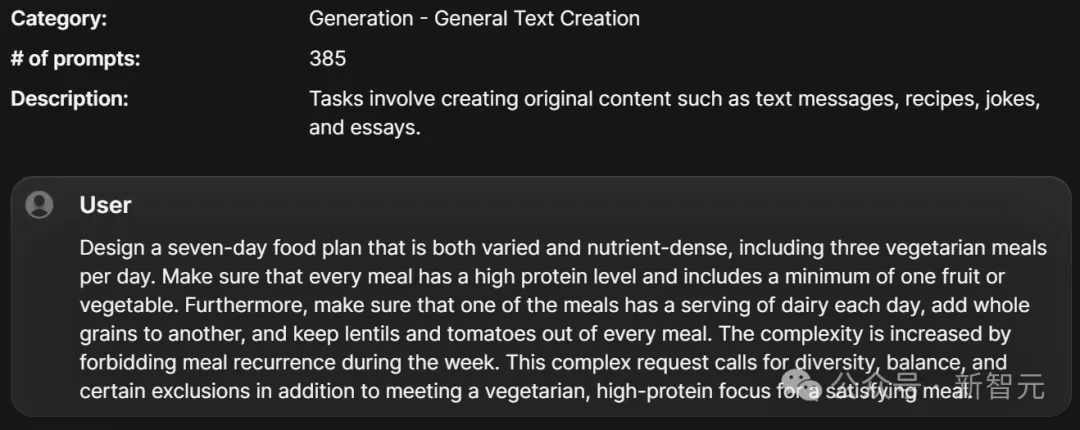

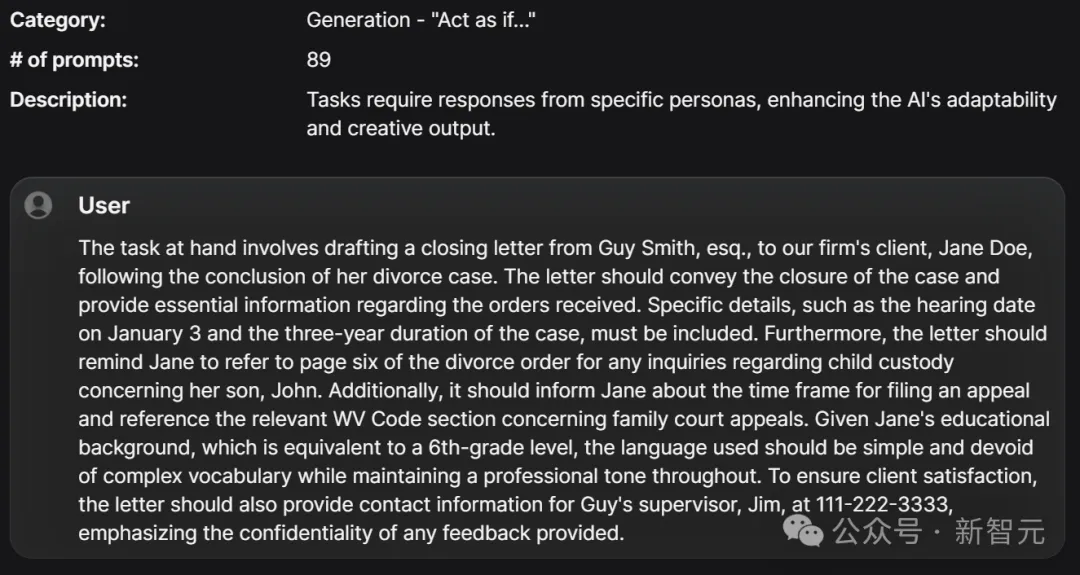

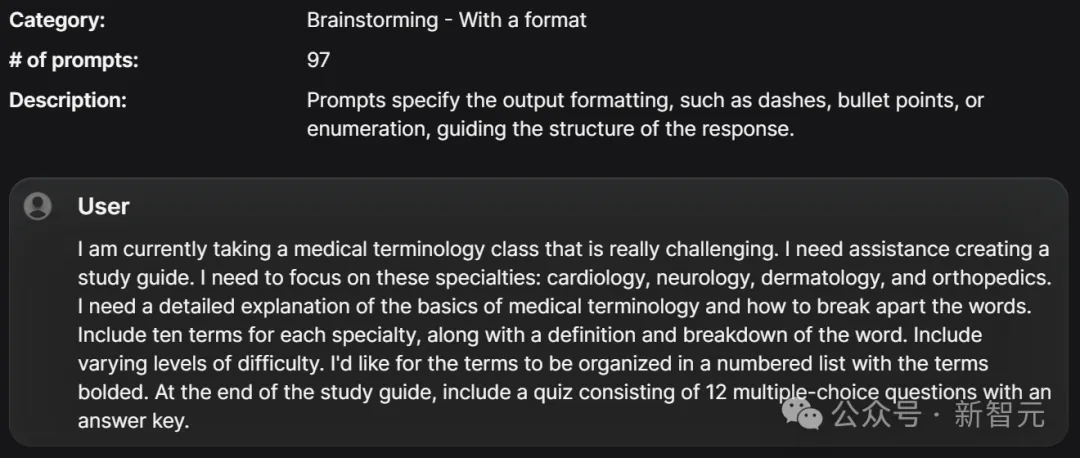

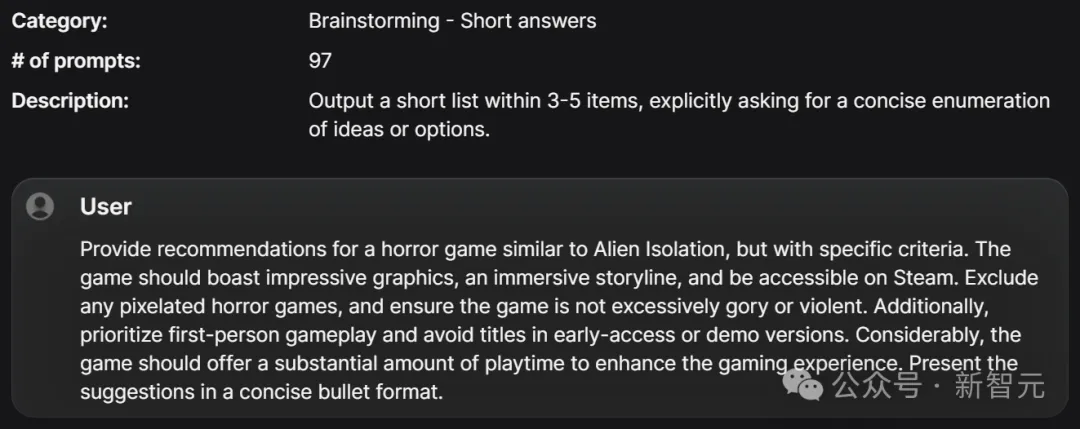

Scale AI精確指令跟隨提示數據集包含1,054個指令跟隨提示,目的是評估AI模型解釋和執行詳細命令的能力,重點在于精確性和具體性,并解決過擬合問題。

數據集中的提示共分為9類,包括「扮演……的角色」、內容創作和頭腦風暴,并涵蓋指令跟隨任務的實際應用和用例。

它由一個40多名人工標注員組成的多樣化團隊生成,并通過五個步驟的開發,確保提示能夠測試模型理解和執行具體指令的能力。

最終,實現對模型對這些提示集的響應進行人工評估。

測試栗子

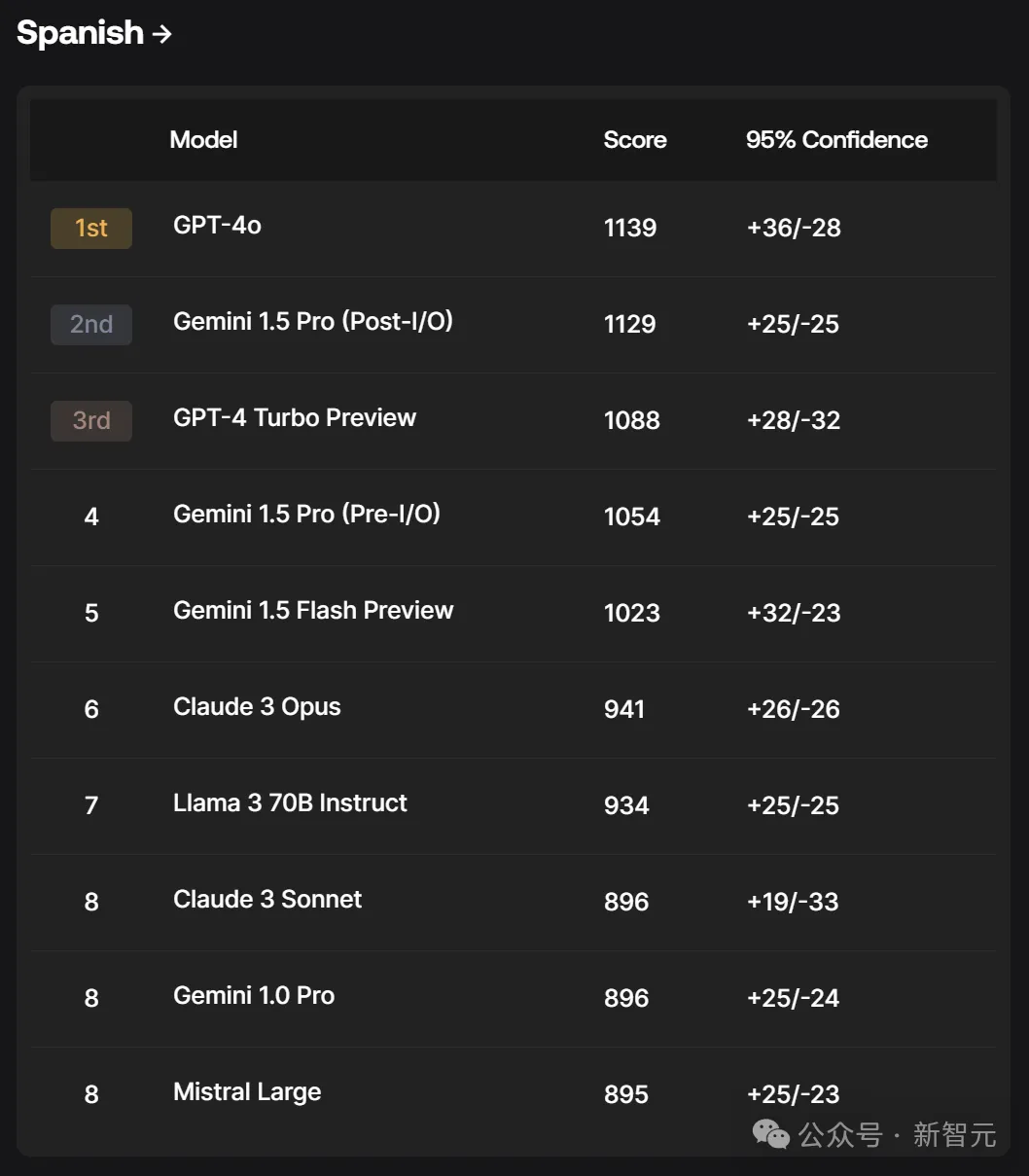

西班牙語

在西班牙語測試上,GPT-4o霸榜第一,而Gemini 1.5 Pro(Post-I/O)超過了GPT-4 Turbo Preview。

隨后,Gemini另外兩個模型也進入榜單前五。

在Scale AI多語言提示數據集中,每個語種都包含1,000個提示,目的是提升模型在多種語言中的交互能力。

數據集特別針對西班牙用戶,包括來自西班牙、墨西哥和拉丁美洲其他地區的用戶。

雖然排行榜目前只包含西班牙語,但在未來的更新中,會擴展到更多語言。

方法

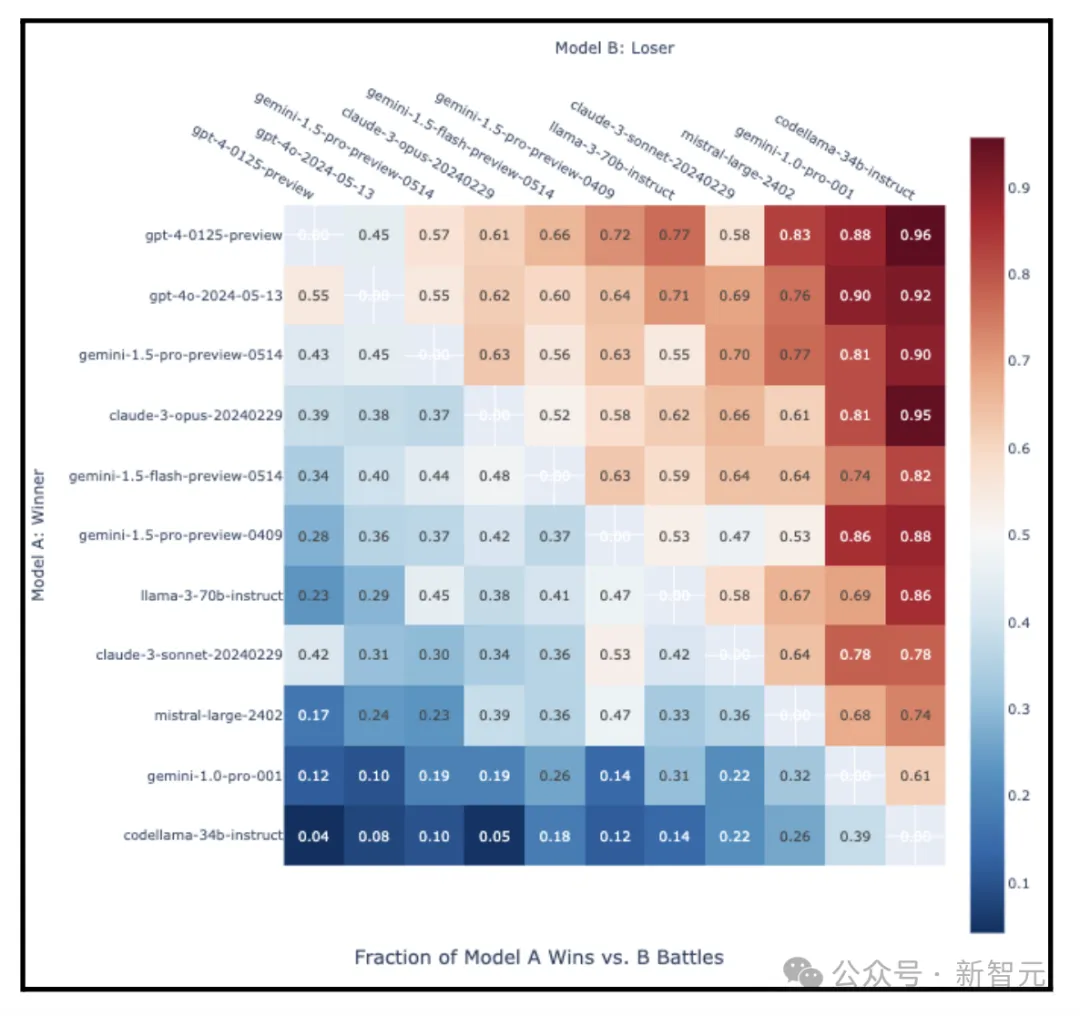

如何計算Elo評分排名

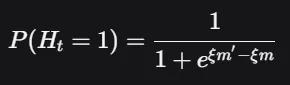

在評估過程中,人工評審會比較兩個模型對同一提示的回答,并在多個方面評估哪個更好。根據這些評分,便可以確定哪個模型贏了、哪個輸了,或者打平。

此外,團隊還采用了與Chatbot Arena相同的方法,使用Bradley-Terry模型對我們的數據點進行重新權重的最大似然估計。

首先是一些定義:

對于??個模型,用??={(??,??′):??<??′, and ??,??′∈[??]}表示比較數據集。

在??∈??時,向人工評審提供一對模型????∈??,并記錄評審的回應????∈[0,0.5,1]。

其中,1表示模型??優于模型??′,而0.5則表示兩個模型同樣受歡迎。

通過Bradley-Terry,利用邏輯關系來模擬這種情況發生的概率:

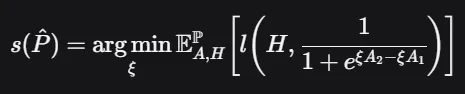

其中,??是一個M長的BT系數向量。然后,通過最小化二元交叉熵損失來估計BT系數:

其中,??是二進制交叉熵損失:

??(?,??)=?(?log?(??)+(1??)log?(1???))

此外,還需使用反向加權??(????)來最小化這一損失,目標是使分數在??上呈現均勻分布。盡管這種反向加權并不是絕對必要的,因為模型之間的成對比較已經非常接近相等。

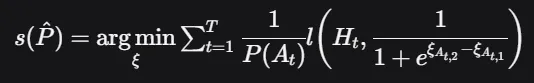

接著,使用下面的公式來計算最終的BT分數:

其中????~??。利用簡單轉換1000+??(??^)×400將該分數轉換為Elo評分,然后進行排序,得出最終排名。

置信區間

為了更好地理解Elo評分的Bradley-Terry評級的可靠性,團隊使用自舉法(Bootstrapping)來估計置信區間。自舉法是一種重采樣技術,通過從數據中反復抽樣來評估估計值的變異性。

1. 生成自舉樣本:從數據集中反復抽樣,生成多個自舉樣本。每個樣本的大小與原始數據集相同,但由于重采樣的特性,樣本中會包含一些重復的觀測值。

2. 計算每個樣本的Elo評分:對于每個自舉樣本,使用前面提到的最大似然估計方法來計算Elo評分。

3. 匯總結果:在計算了大量自舉樣本的Elo評分(例如1000輪)后,匯總這些結果,估計每個模型的Elo評分分布。

4. 估計置信區間:根據匯總的自舉結果,確定每個模型的Elo評分的置信區間。

LLM評估的重要性

Karpathy在轉發Wang的推特時,打了很長一段文字,描述LLM評估的困難與重要性。

LLM評估正在改進,但不久前他們的狀態非常黯淡,定性經驗常常與定量排名不一致。

這是因為良好的評估非常難以構建。

在特斯拉,我可能將1/3的時間花在數據上,1/3的時間花在評估上,1/3 的時間花在其他事情上。評估必須全面、有代表性、高質量,并測量梯度信號(即梯度下降不能太容易,也不能太難)。而且將定性和定量評估對齊之前,需要解決很多細節,其中有一些微妙的地方。

另一個不容易發現的地方是,任何開放(非私有)測試數據集都不可避免地泄漏到訓練集中。人們直覺上的強烈懷疑這一點,這也是最近GSM1k流行的原因。

即使LLM開發人員盡最大努力,防止測試集滲透到訓練集(以及模型記住答案)也很困難。當然,你可以盡力過濾掉訓練集中與測試集完全匹配的內容,還可以過濾掉n-gram識別的近似匹配。但是,如何過濾掉合成數據重寫或網上對數據的討論內容?如果定期訓練多模態模型,如何過濾數據的圖像/屏幕截圖?如何防止開發人員將訓練數據(比如embedding)放到測試集中,并專門使用與測試集高度對齊(在向量空間)的數據進行訓練?

最后一點是,并非所有我們關心的LLM任務都是可自動評估的(例如思考總結等),此時你希望讓人類參與進來。但如何控制所有涉及的變量?例如人類評估者在多大程度上關注實際答案內容,或者長度、文字風格,或者如何看待模型拒絕回答的行為等等。

不管怎樣,反直覺的一點是,良好的評估是困難的,且需要高度密集的工作,但非常重要,所以我很高興看到更多的組織加入,努力做好這件事。

Karpathy指路了一個GitHub博客,探討了為什么在Eleuther AI創建的公開LLM排行榜上,Llama模型得到的MMLU測評分數低于論文提供的數字。

項目地址:https://github.com/huggingface/blog/blob/main/open-llm-leaderboard-mmlu.md

此外,他談到的測試數據泄露問題,Open AI研究員Jason Wei在最新的一篇博客中也提到過。

文章地址:https://www.jasonwei.net/blog/evals

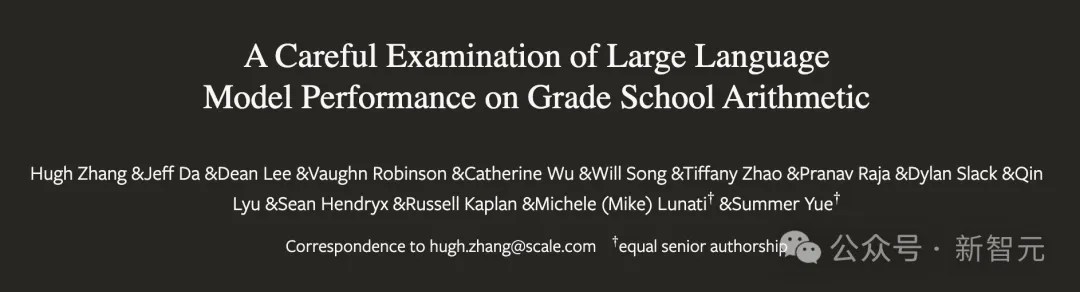

而且最近的一篇論文中有比較充分的證據。

論文地址:https://arxiv.org/html/2405.00332

他們發現,許多公開的模型在GSM-8K數據集上有明顯的過擬合表現,而且在同類的GSK-1K上測試時,多數模型都會有很大程度的性能下降。

論文地址:https://arxiv.org/html/2405.00332