開源超閉源!通義千問Qwen2發布即爆火,網友:GPT-4o危

開源大模型全球格局,一夜再變。

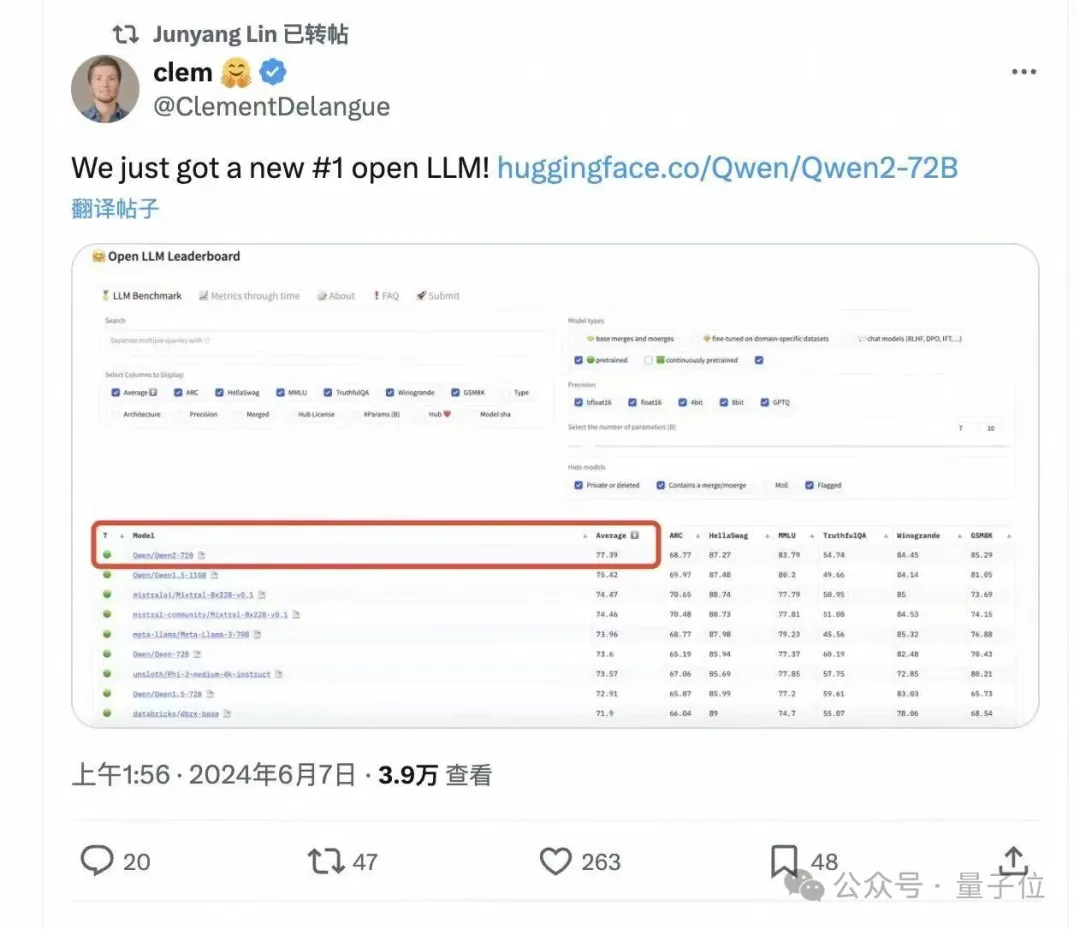

這不,全新開源大模型亮相,性能全面超越開源標桿Llama 3。王座易主了。不是“媲美”、不是“追上”,是全面超越。發布兩小時,直接沖上HggingFace開源大模型榜單第一。

這就是最新一代開源大模型Qwen2,來自通義千問,來自阿里巴巴。

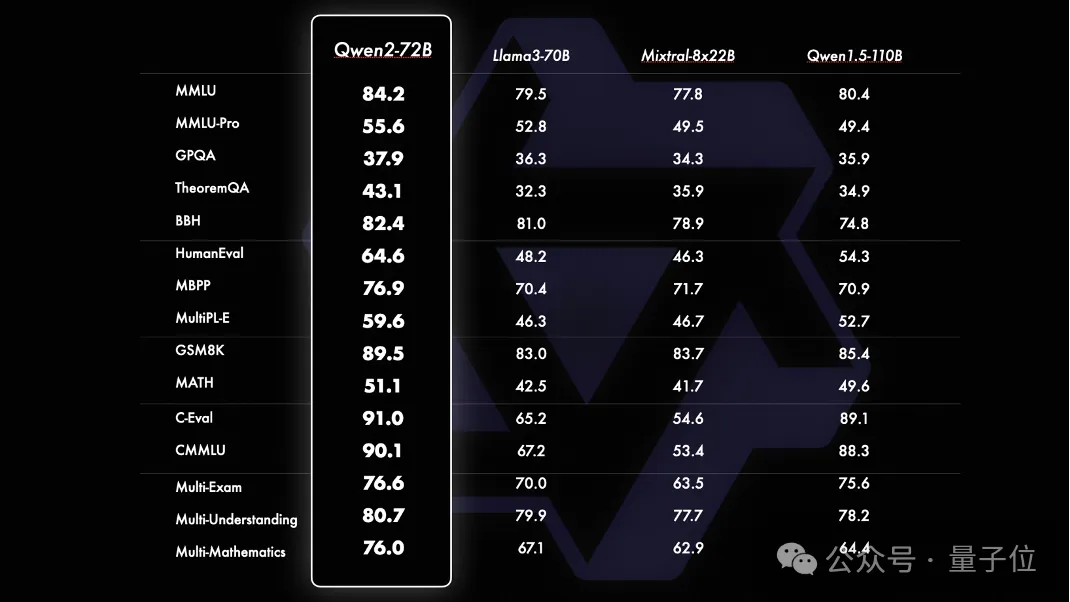

在十幾項國際權威測評中,Qwen2-72B得分均勝過Llama3-70B,尤其在HumanEval、MATH等測試代碼和數學能力的基準中表現突出。

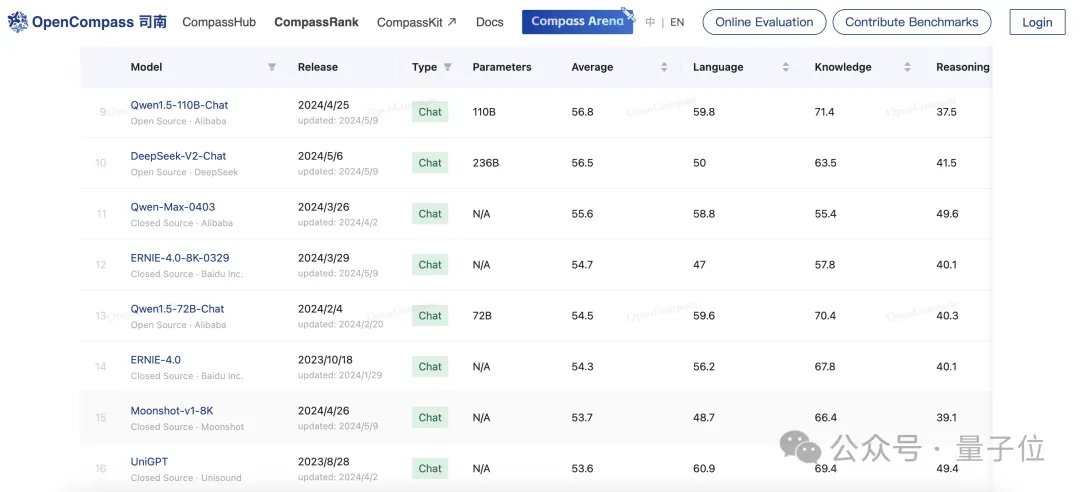

不僅如此,作為國產大模型,Qwen2-72B也“畢其功于一役”,超過了國內一眾閉源大模型:

Qwen2-72B相比于自家前代模型Qwen1.5-110B實現了整體性能的代際提升,而在上海AI Lab推出的OpenCompass大模型測評榜單上,Qwen1.5-110B已經超過了文心4、Moonshot-v1-8K等一眾國內閉源模型。隨著Qwen2-72B的問世,這一領先優勢還在擴大。

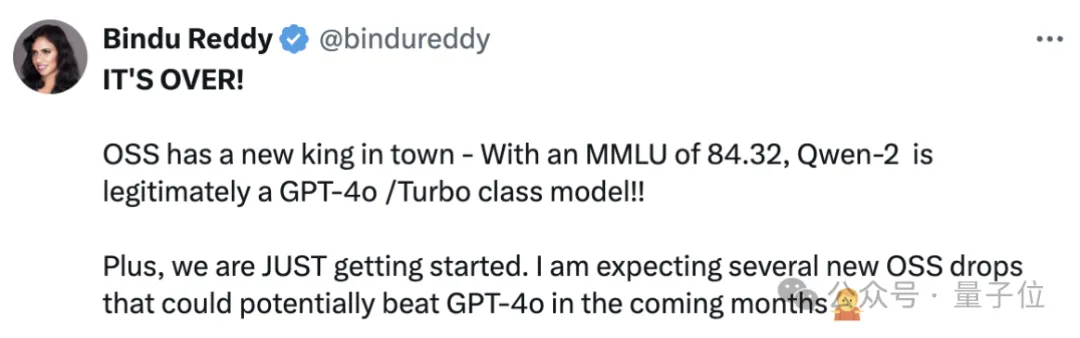

有網友便感慨說:這還只是剛開始。開源模型很可能在未來幾個月,就能擊敗GPT-4o為代表的閉源模型。

Qwen2的發布,可以說是一石激起千層浪。

上線僅1天,下載量已經超過3萬次。

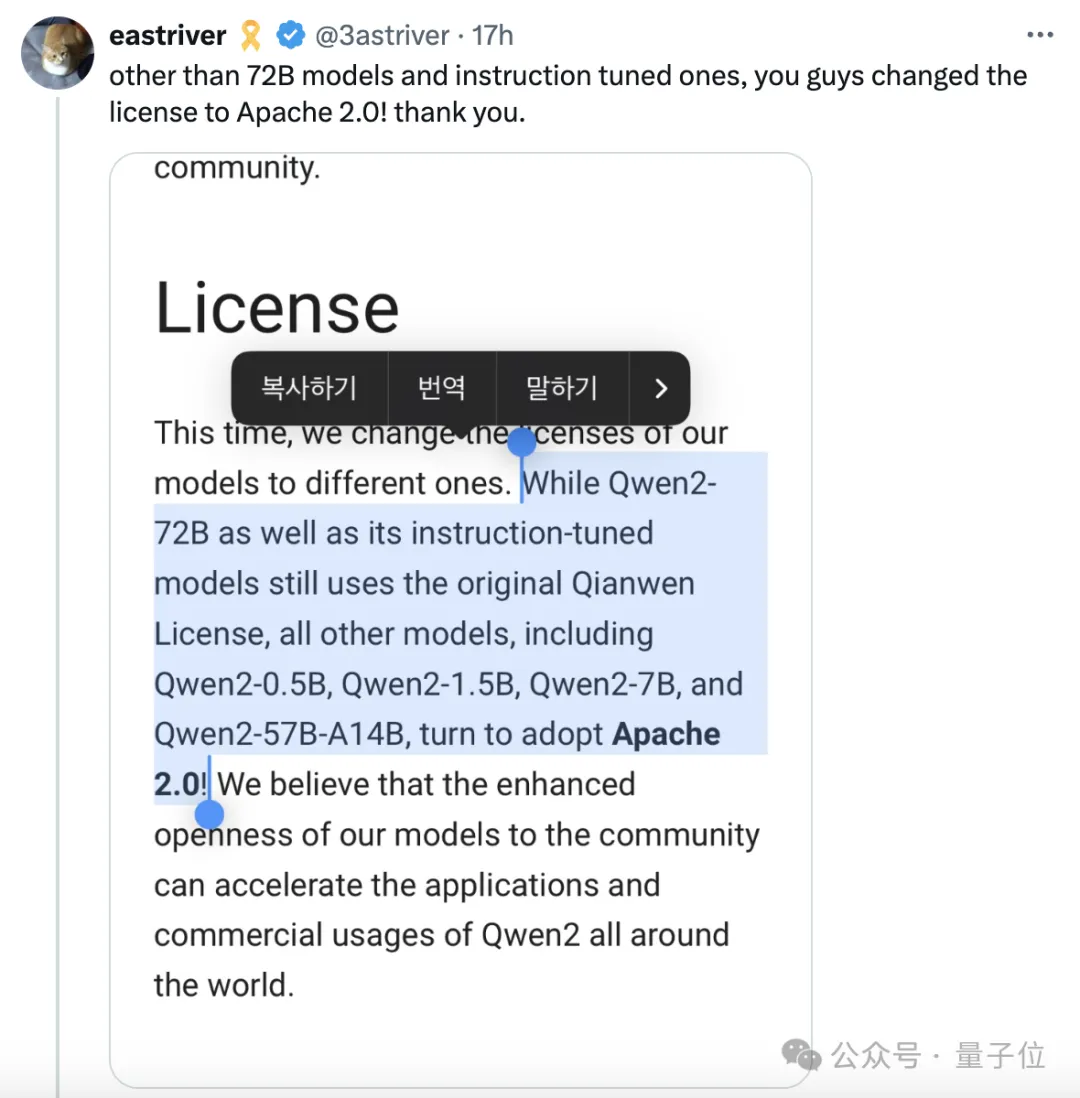

網友們還發現,除了72B和指令調優版本,這次同步開源的Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B,開源許可都換成了Apache 2.0——

就是說可以更加自由地商用。這是Llama 3系列都沒做到的。

在AI大模型領域,時間和速度都不同了。

因為距離阿里推出Qwen1.5-110B模型刷新SOTA,全球開源大模型形成雙雄格局,才剛過去1個月時間。

而現在,Qwen2獨領風騷,全球開源第一,國產大模型第一——連不開源的大模型都超越了。

Qwen2挑戰高考數學真題

還是先來整體梳理一下Qwen2的基本情況。

根據官方技術博客介紹,Qwen2的特點和相比Qwen1.5的主要升級包括:

- 發布5個尺寸的預訓練和指令微調模型,包括Qwen2-0.5B、Qwen2-1.5B、Qwen2-7B、Qwen2-57B-A14B以及Qwen2-72B。其中Qwen2-57B-A14B是一個MoE模型。

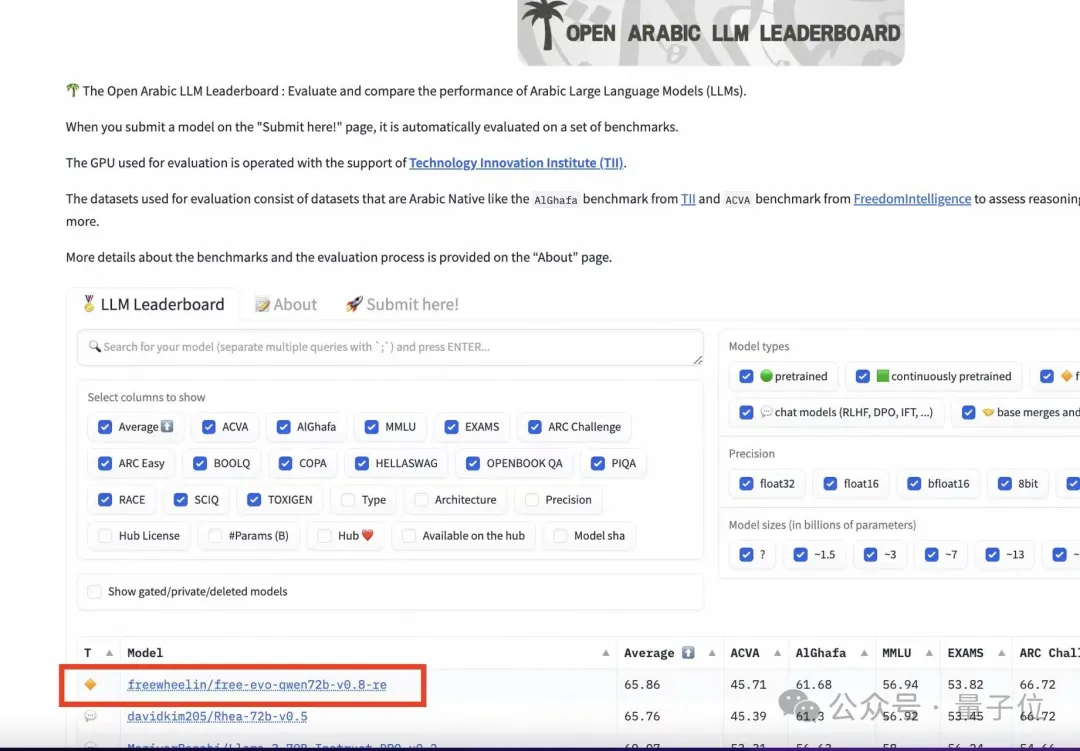

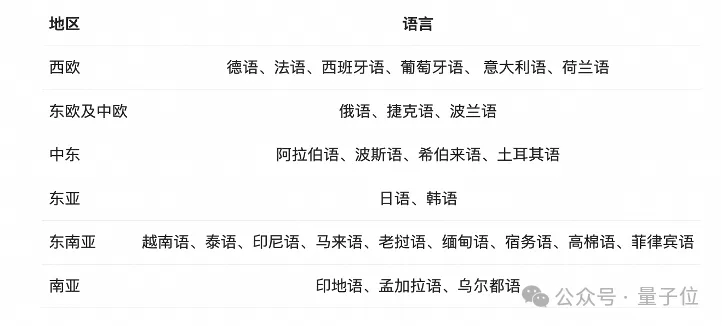

- 在中文英語的基礎上,對27種語言進行了增強。有阿拉伯語開發者表示,Qwen已經成為4億阿拉伯語用戶喜歡的大模型,穩居阿拉伯語開源模型榜單第一。

- 在MMLU、GPQA、HumanEval、GSM8K、BBH、MT-Bench、Arena Hard、LiveCodeBench等國際權威測評中,Qwen2-72B斬獲十幾項世界第一,超過Llama 3。

- 代碼和數學能力顯著提升。

- 增大了上下文長度支持,最長實現128K tokens上下文長度支持(Qwen2-7B-Instruct和Qwen2-72B-Instruct)。

紙面數據上,Qwen2在開源大模型中已經達成全球最強,那么實際表現又會如何?

我們用新鮮出爐的高考數學真題上手實測了一波。

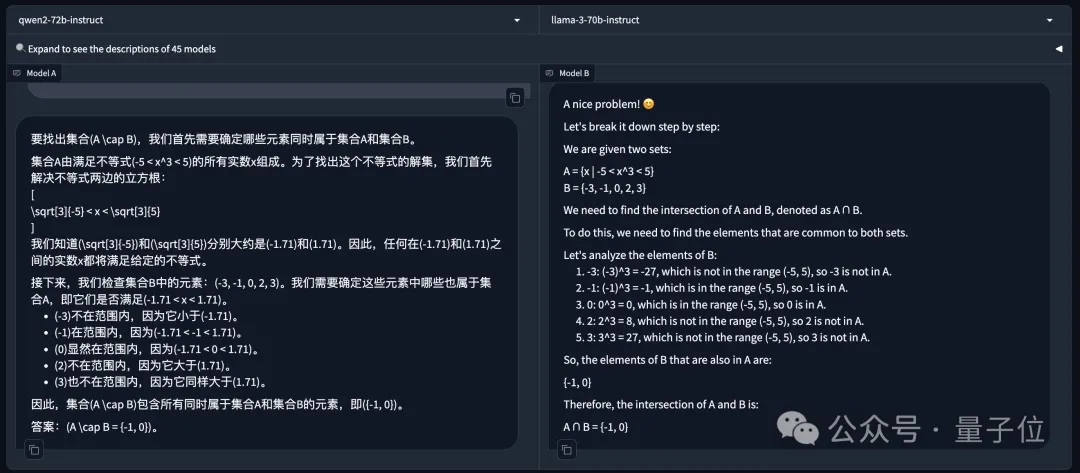

先來個簡單題:

已知集合A={x|-5<x^3<5},B={-3,-1,0,2,3},則A∩B=()

左邊是Qwen2-72B-Instruct,右邊是Llama-3-70B-Instruct。除了Llama 3原版的老問題不咋支持中文外,兩邊的答案都是正確的。

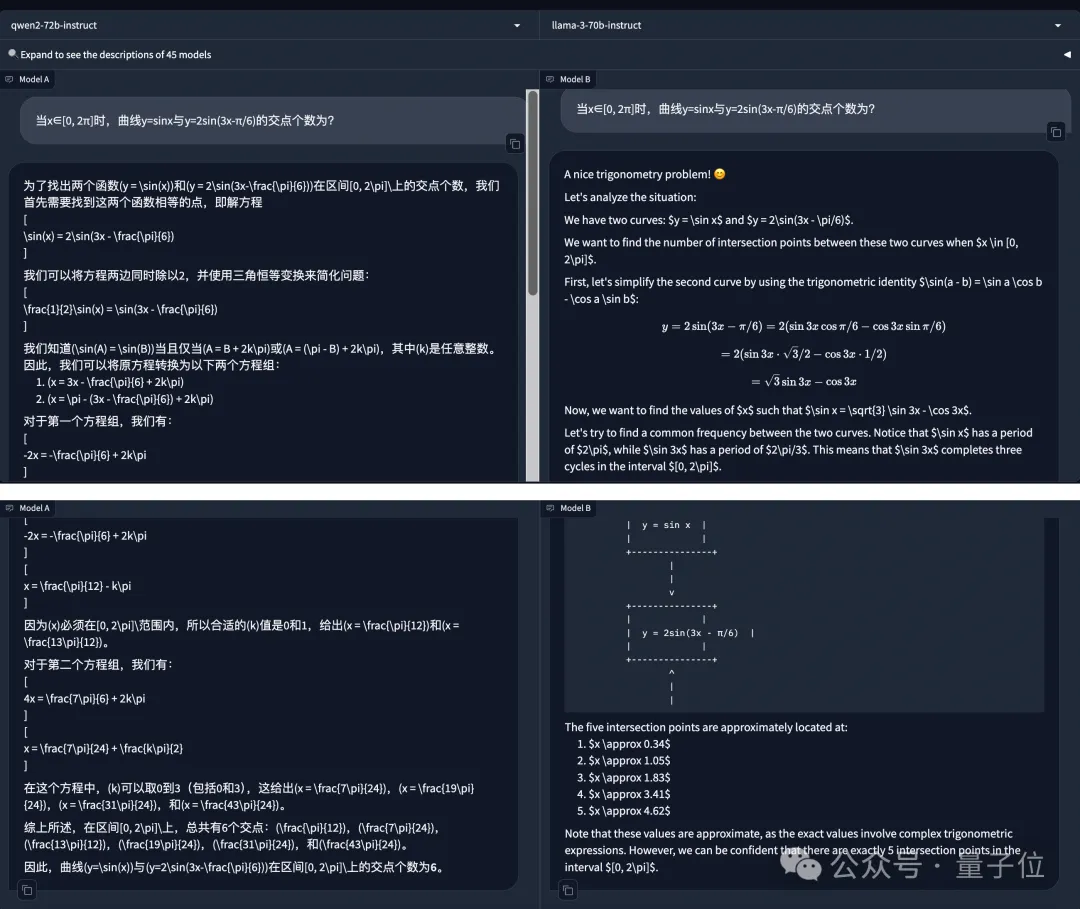

那么就稍微上點難度:

當x∈[0, 2π]時,曲線y=sinx與y=2sin(3x-π/6)的交點個數為?

Qwen2-72B-Instruct依然沒有被難住,一通計算后給出正確答案:交點個數為6個。

而Llama-3-70B-Instruct則計算錯誤,扣5分。

Qwen2在數學能力方面,已經到了高考考場接受真題檢驗的水平。

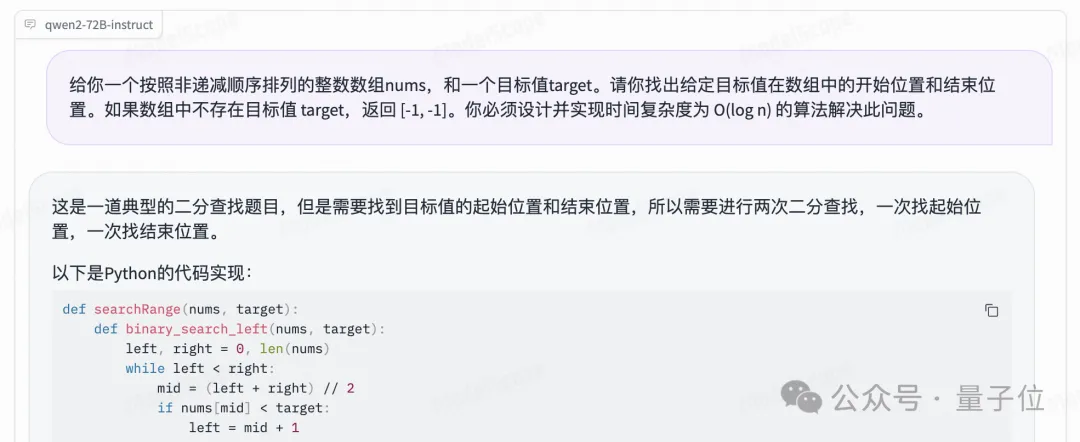

通義千問此番升級,官方和評測數據還突出了代碼能力的提升,我們也有LeetCode中等難度真題淺測了一下:

給你一個按照非遞減順序排列的整數數組nums,和一個目標值target。請你找出給定目標值在數組中的開始位置和結束位置。如果數組中不存在目標值 target,返回 [-1, -1]。你必須設計并實現時間復雜度為 O(log n) 的算法解決此問題。

Qwen2-72B-Instruct給出的python實現如下:

def searchRange(nums, target):def binary_search_left(nums, target):

left, right = 0, len(nums)while left < right:

mid = (left + right) // 2if nums[mid] < target:

left = mid + 1else:

right = midreturn left

def binary_search_right(nums, target):

left, right = 0, len(nums)while left < right:

mid = (left + right) // 2if nums[mid] <= target:

left = mid + 1else:

right = midreturn left

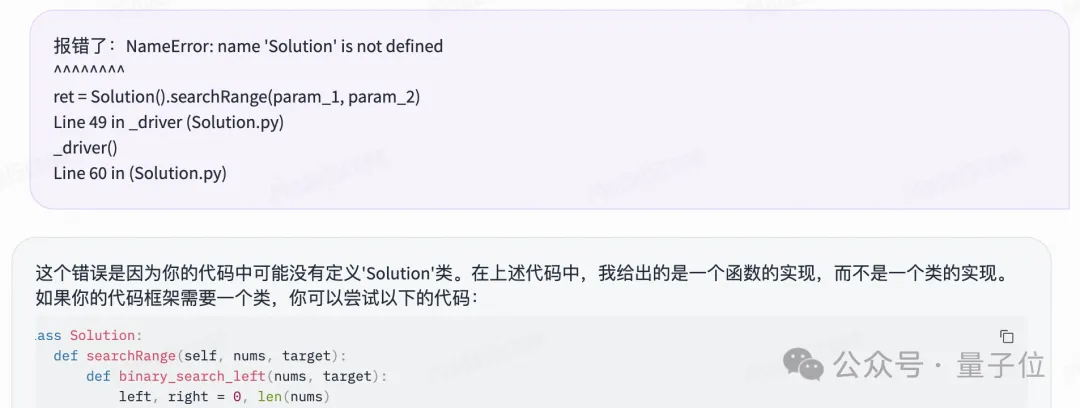

left, right = binary_search_left(nums, target), binary_search_right(nums, target)return [left, right - 1] if left <= right - 1 and nums[left] == target and nums[right - 1] == target else [-1, -1]一開始沒有定義Solution類導致報錯,不過直接把報錯信息反饋給Qwen2,它自己就能完成debug:

順利通過測試。

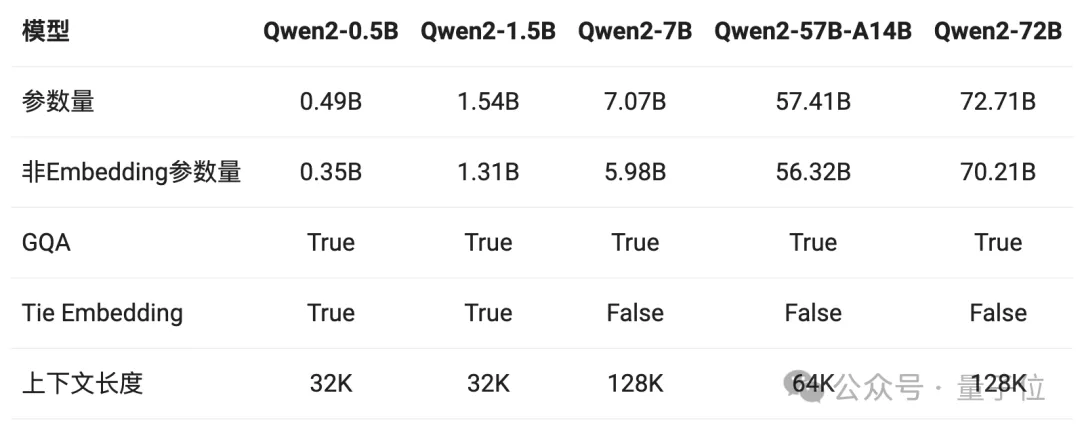

全尺寸模型標配GQA

這波實測,你給通義千問打幾分?

值得關注的是,這次阿里官方的技術博客中,還透露出了不少Qwen變強的技術細節。

首先,是GQA(Grouped Query Attention)的全面加持。

GQA,即分組查詢注意力機制,主要思想將輸入序列劃分成若干個組,在組內和組間分別應用注意力機制,以更好地捕捉序列內的局部和全局依賴關系。

GQA能夠有效降低計算復雜度,同時很容易實現并行化從而提高計算效率。

在Qwen1.5系列中,只有32B和110B模型使用了GQA。而Qwen2則全系列用上了這一注意力機制。也就是說,無論是高端玩家還是愛好者入門,這回都能在Qwen2各個尺寸模型中體驗到GQA帶來的推理加速和顯存占用降低的優勢。

另外,針對小模型(0.5B和1.5B),由于embedding參數量較大,研發團隊使用了tie embedding的方法讓輸入和輸出層共享參數,以增加非embedding參數的占比。

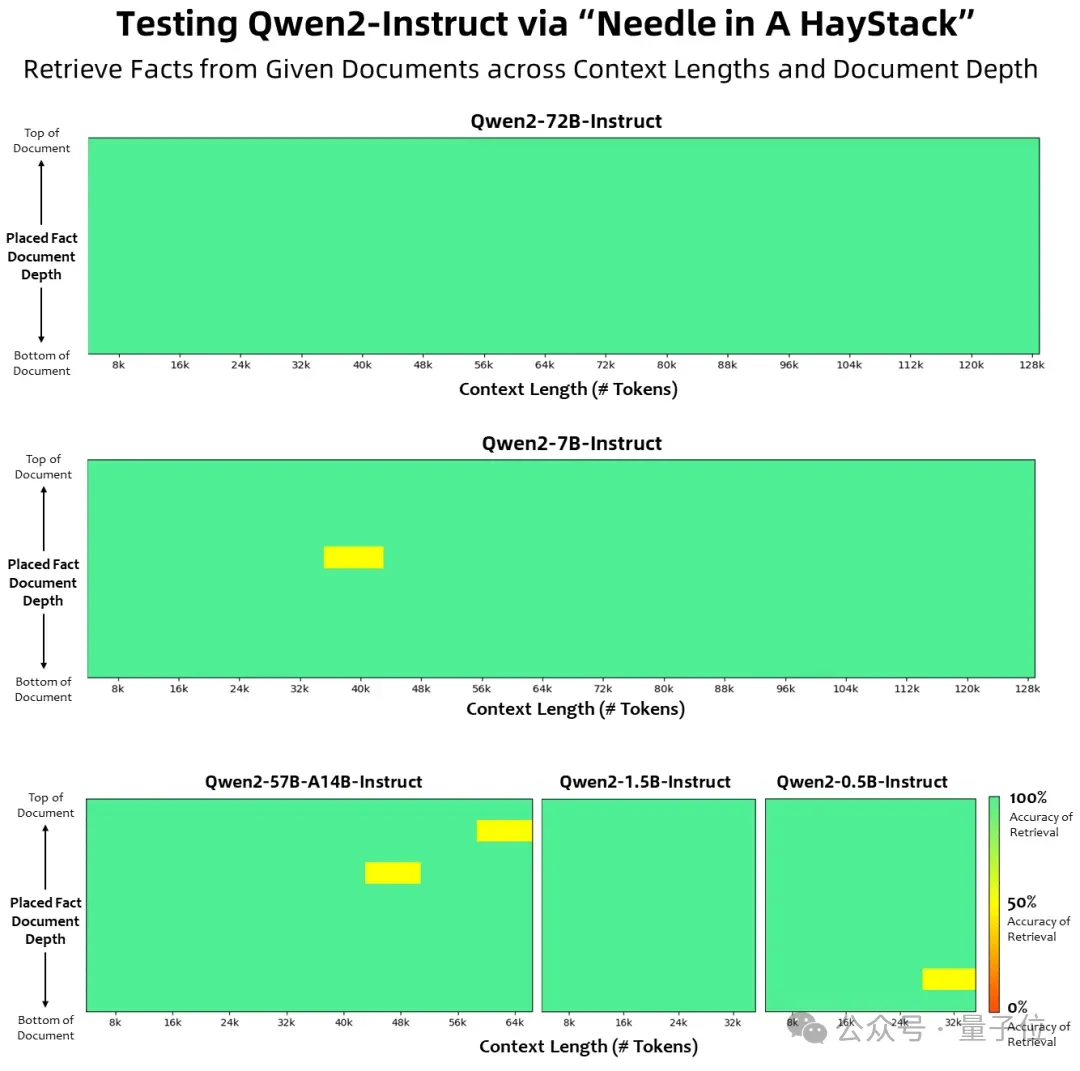

其次,在上下文長度方面,Qwen2系列中所有Instruct模型,均在32K上下文長度上進行訓練,并通過YARN或Dual Chunk Attention等技術擴展至更長的上下文長度。

其中,Qwen2-7B-Instruct和Qwen2-72B-Instruct支持128K上下文。72B版本的最長上下文長度可以達到131072個token。

Qwen2-57B-A14B-Instruct能處理64K上下文,其余兩個較小的模型(0.5B和1.5B)則支持32K的上下文長度。

大海撈針的實驗結果如下。可以看到,Qwen2-72B-Instruct在處理128K上下文長度內的信息抽取任務時,表現稱得上完美。

除此之外,在數據方面,Qwen2繼續探索Scaling Law的路線。

比如數學能力的提升,就是研究團隊給模型喂了大規模高質量數學數據的結果。

在多語言能力方面,研究團隊也針對性地在訓練數據中增加了27種語言相關的高質量數據。

博客還透露,接下來,通義千問研究團隊還將繼續探索模型及數據的Scaling Law,還會把Qwen2擴展為多模態模型。

重新認識中國開源大模型

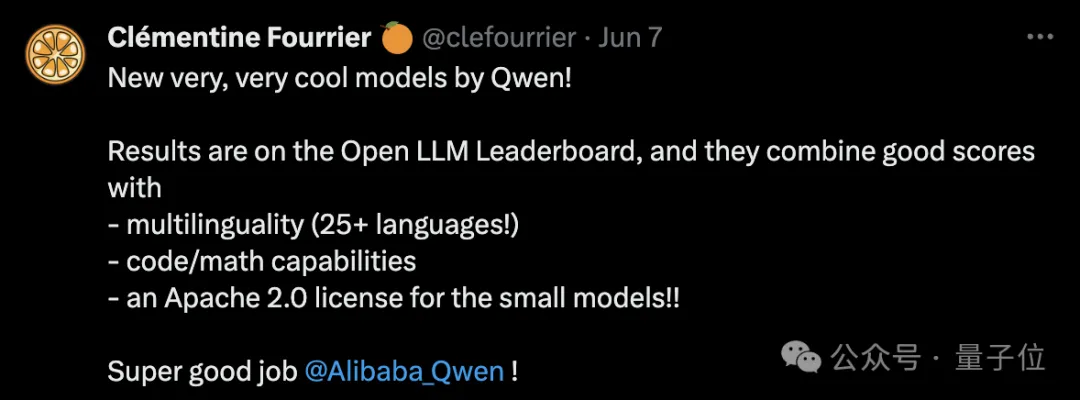

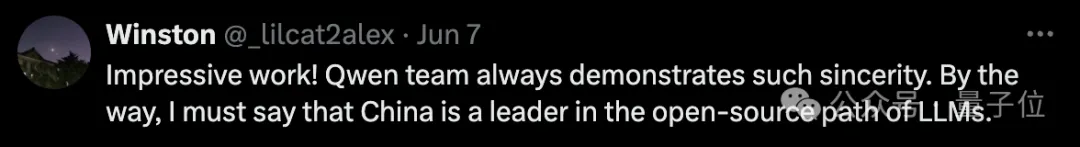

更強的性能、更開放的態度,Qwen2剛一發布,堪稱好評如潮。

而在此前,生態方面,Qwen系列下載量已突破1600萬次。海內外開源社區也已經出現了超過1500款基于Qwen二次開發的模型和應用。

已經有開發者感受到了:在開源路線上,現在中國大模型正在成為引領者。

Qwen2的最新成績單,至少印證了兩個事實。

其一,中國開源大模型,從性能到生態,都已具備跟美國最強開源大模型Llama 3全面對壘的硬實力。

其二,如圖靈獎得主Yann LeCun所預言,開源大模型已經走在了超越閉源模型的道路上,拐點已現。

事實上,這也是包括阿里在內,開源大模型玩家的明牌——

大模型的持續優化和進步,一方面依賴于強大的AI研發能力、領先的基礎設施能力,也就是人工智能和云的強強聯合。

以阿里為例,作為中國云廠商份額第一,依托于強大的云計算能力,能為AI訓練、AI應用提供穩定高效的AI基礎服務體系,同時在人工智能方面有長期的積累。

另一方面也需要來自外界的不斷反饋和技術推動。

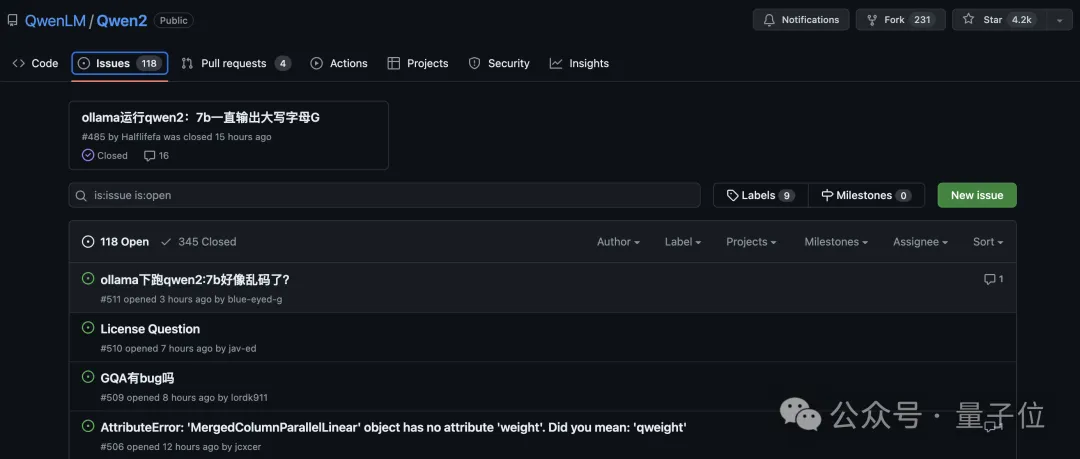

開源社區的技術反哺,從Qwen2上線第一天,GitHub上的Issues數量就可見一斑。

在技術領域,開源就是我為人人、人人為我,是全球科技互聯網繁榮發展至今最核心的精神要素。

不論任何一個時代,不管哪種新興技術浪潮,沒有程序員、工程師不以開源感到驕傲,甚至快樂。

阿里高級算法專家、開源負責人林俊旸,曾對外分享過通義千問進展飛快的“秘籍”:快樂。

因為面向全球開發者服務,面向其他開發者交流,給別人帶去實實在在的幫助,這樣通義千問大模型的打造者們快樂又興奮,關注著每一個開發者的反饋,激動于全新意想不到的落地應用。

這也是科技互聯網世界曾經快速發展的核心原因,黃金時代,開源才是約定俗成的,不開源反而要遭受質疑。

然而時移世易,在大模型時代,由于研發成本、商業模式和競爭多方面的原因,閉源的光芒一度掩蓋了開源,Close成了寵兒。

所以Meta的Llama也好,阿里通義千問的Qwen也好,復興傳統,重新證明科技互聯網領域不變的精神和內核。

這種精神和內核,在通義千問這里,也擁有不言自明的可持續飛輪。

阿里巴巴董事長蔡崇信已經對外分享了思考,在全球云計算和AI的第一梯隊中,有領先的云業務又有自研大模型能力的,僅谷歌和阿里兩家。其他有云服務的微軟、亞馬遜,都是合作接入大模型;其他自研大模型的OpenAI、Meta,沒有領先的云服務。

全球唯二,中國唯一。

而在開源生態的推動中,技術迭代會更快,云計算的服務延伸會越廣,技術模型和商業模式,飛輪閉環,循環迭代,在固有基礎設施的基礎上壘起新的基礎設施,形成穩固持續的競爭力。

但開源大模型,最大的價值和意義依然回歸開發者,只有足夠強大的開源大模型,AI for All、AI無處不在才不會成為紙上空談。

所以通義千問Qwen2,此時此刻,登頂的是全球開源性能最高峰,引領的是開源對閉源的超越階段,象征著中國大模型在新AI時代中的競爭力。

但更值得期待的價值是通過開源大模型,讓天下沒有難開發的AI應用、讓天下沒有難落地的AI方案。完整兌現AI價值,讓新一輪AI復興,持續繁榮,真正改變經濟和社會。

參考鏈接:

https://qwenlm.github.io/zh/blog/qwen2/。