最強(qiáng)數(shù)學(xué)大模型易主!阿里千問新模型成績超GPT-4o,網(wǎng)友:這才是真“草莓”

最強(qiáng)數(shù)學(xué)大模型,現(xiàn)在易主!

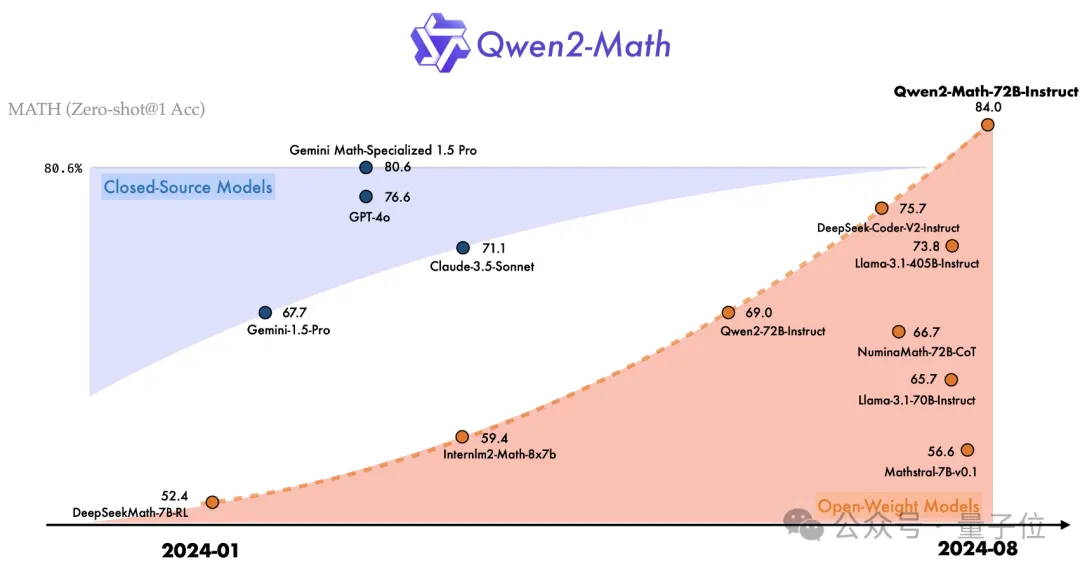

阿里千問大模型團(tuán)隊(duì)發(fā)布的Qwen2-Math,不僅超越了Llama 3.1-405B,也戰(zhàn)勝了GPT-4o、Claude 3.5等一系列閉源模型。

而且還會(huì)解決競賽級(jí)試題,在GPT-4只能做對一道的AIME 24中,Qwen2-Math答對的題目數(shù)量達(dá)到了兩位數(shù)。

Qwen2-Math一共有三個(gè)參數(shù)量的版本——72B,7B和1.5B。

最強(qiáng)的72B版本,在MATH數(shù)據(jù)集上比GPT-4o多得了7分,按比例算高出了9.6%。

7B版本也用不到十分之一的參數(shù)量,超過了72B的開源數(shù)學(xué)模型NuminaMath。

而且這個(gè)NuminaMath來頭不小,它的7B版本在全球首屆AIMO中獲獎(jiǎng),獎(jiǎng)項(xiàng)由數(shù)學(xué)大牛陶哲軒頒發(fā)。

阿里高級(jí)算法專家林俊旸激動(dòng)地宣布,千問團(tuán)隊(duì)把Qwen2模型變成了一個(gè)數(shù)學(xué)高手。

fast.ai創(chuàng)始人Jeremy Howard看了直呼amazing。

網(wǎng)友更是驚嘆,原來這才是真正的“草莓”,這是開源的勝利,也是所有人的勝利。

超越GPT4o,會(huì)做競賽級(jí)試題

如前文所說,Qwen2-Math共有72B、7B和1.5B三個(gè)參數(shù)規(guī)模,分別由對應(yīng)規(guī)模的Qwen2基礎(chǔ)模型改造而成。

在基礎(chǔ)模型之上,團(tuán)隊(duì)使用精心設(shè)計(jì)的數(shù)學(xué)專用語料庫進(jìn)行了預(yù)訓(xùn)練,訓(xùn)練數(shù)據(jù)包含大規(guī)模高質(zhì)量的數(shù)學(xué)網(wǎng)絡(luò)文本、書籍、代碼、考試題目,以及由Qwen2模型合成的數(shù)學(xué)預(yù)訓(xùn)練數(shù)據(jù)。

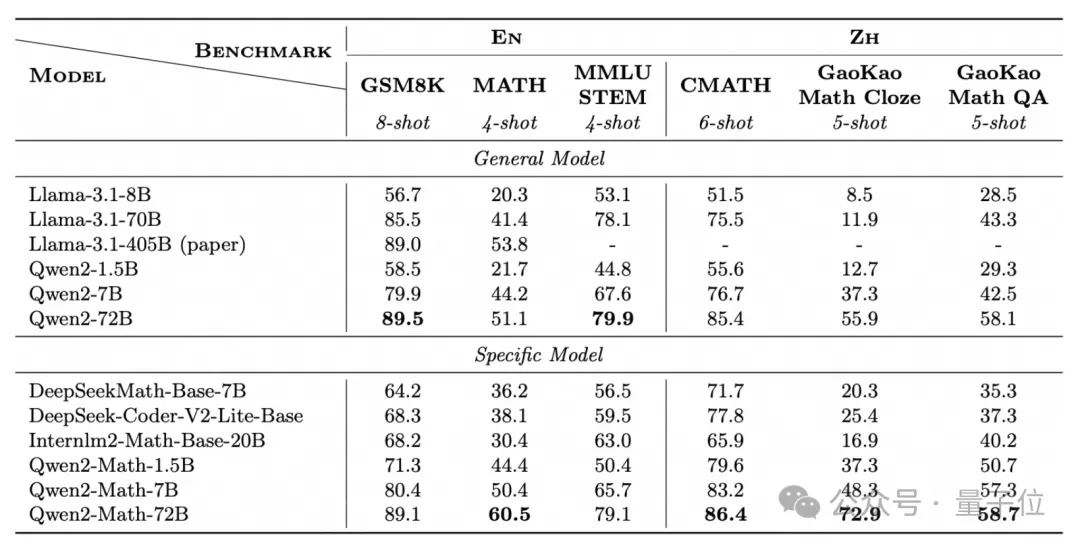

結(jié)果,在GSM8K、MATH等經(jīng)典數(shù)學(xué)測試集上,Qwen2-Math-72B的數(shù)學(xué)能力都超過了405B的Llama-3.1。

這些數(shù)據(jù)集,涉及到問題涵蓋了代數(shù)、幾何、計(jì)數(shù)與概率、數(shù)論等多種類型。

除了這些英文的數(shù)據(jù)集,Qwen2-Math還專門挑戰(zhàn)了中文數(shù)據(jù)集CMATH,還有高考試題。

在中文數(shù)據(jù)集上,1.5B版本的成績就超過了70B的Llama 3.1,而且三個(gè)版本相當(dāng)于同規(guī)模的Qwen2基礎(chǔ)模型,成績都有明顯提升。

在Qwen2-Math的基礎(chǔ)之上,千問團(tuán)隊(duì)還微調(diào)出了Instruct版本。

具體來說,團(tuán)隊(duì)基于Qwen2-Math-72B訓(xùn)練一個(gè)數(shù)學(xué)專用的獎(jiǎng)勵(lì)模型,將獎(jiǎng)勵(lì)信號(hào)與正誤判斷信號(hào)結(jié)合作為學(xué)習(xí)標(biāo)簽,再通過拒絕采樣構(gòu)建監(jiān)督微調(diào)(SFT)數(shù)據(jù),最后在SFT模型基礎(chǔ)上使用GRPO方法優(yōu)化。

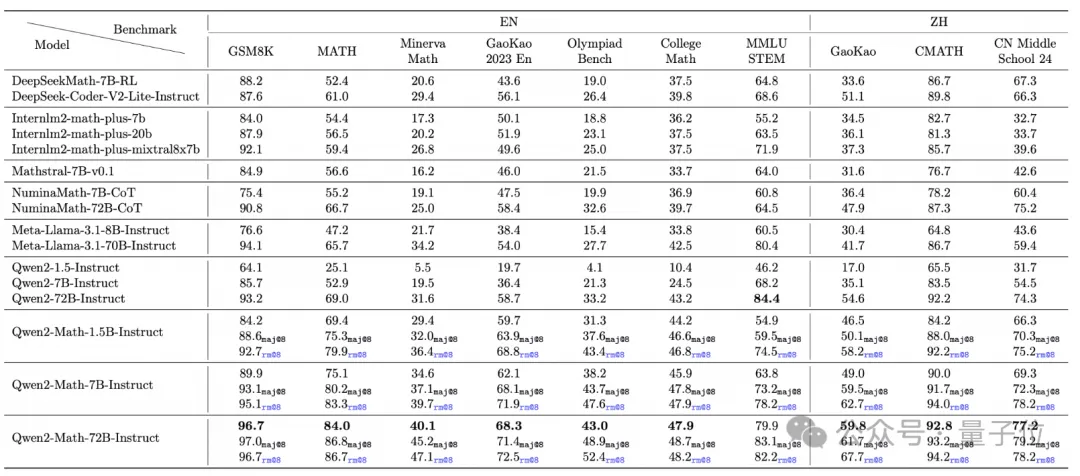

在MATH數(shù)據(jù)集上的零樣本測試顯示,1.5B的Instruct就能取得70%的準(zhǔn)確率,比70B的Llama 3.1還高。

此外,研究團(tuán)隊(duì)還引入了難度更大的OlympiadBench、CollegeMath和英譯版高考試題等更困難的測試集。

作者讓Qwen2-Math采用了貪心(greedy)、RM@8和Maj@8三種策略,結(jié)果無論是哪一種,Qwen2-Math的成績?nèi)汲^了同規(guī)模的Llama 3.1。

中文數(shù)據(jù)集方面,Qwen2-Math還挑戰(zhàn)了今年最新的中高考試題,與Llama 3.1相比優(yōu)勢十分明顯。

值得一提的是,為了減少測試成績當(dāng)中的“水分”,千問團(tuán)隊(duì)專門從訓(xùn)練數(shù)據(jù)集中去除了所有和測試集重疊的部分。

而且除了精確匹配,還運(yùn)用了更嚴(yán)格的13-gram去重策略,只要最長公共序列的比率應(yīng)大于0.6就會(huì)被去除。

后訓(xùn)練的過程也是如此,涉及的數(shù)據(jù)集,甚至測試成績中沒展示的Aqua、SAT Math,全都被從數(shù)據(jù)當(dāng)中剔除。

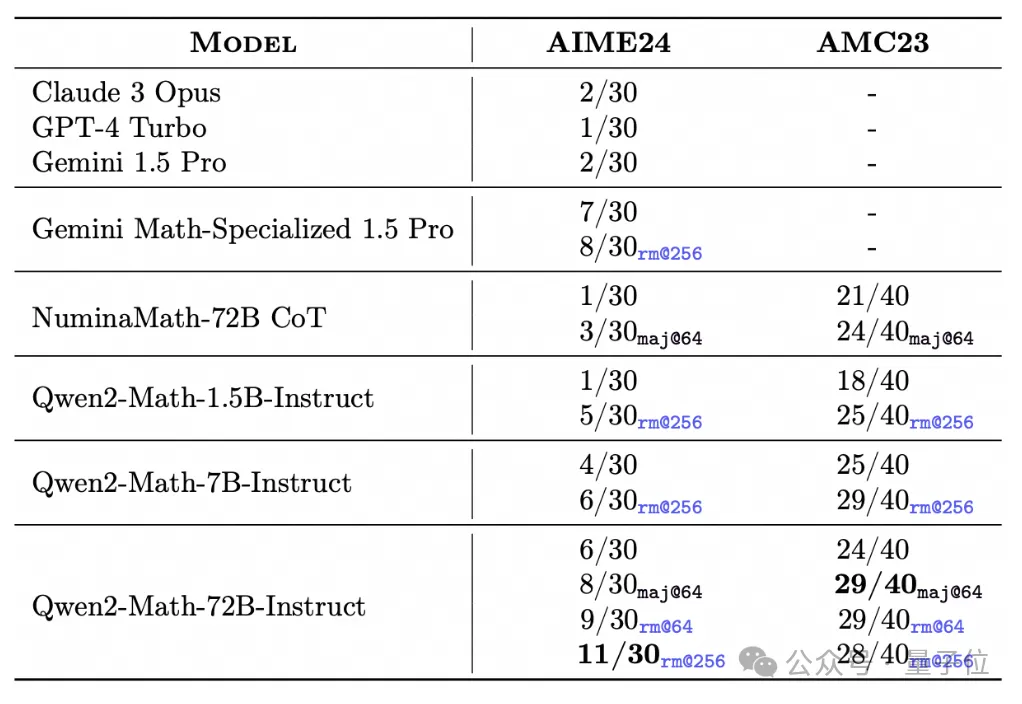

另外,Qwen2-Math-Instruct已經(jīng)具備了解決一些簡單的競賽級(jí)試題的能力。

比如在AIME 24的30道題當(dāng)中,Qwen2-Math-72B-Instruct用rm@256策略能夠做對11道。

像GPT-4 Turbo、Claude 3 Opus和Gemini 1.5 PRo這些先進(jìn)模型都只能做對一兩道。

而且最小的1.5B版本也能在rm@256的條件下做對五道題,已經(jīng)超過了這三家模型。

另外,Gemini 1.5 Pro有一個(gè)專門針對數(shù)學(xué)任務(wù)的版本,但也只能做對七八道題目,Qwen2-Math-72B-Instruct是第一個(gè)做對的題目數(shù)量達(dá)到兩位數(shù)的模型。

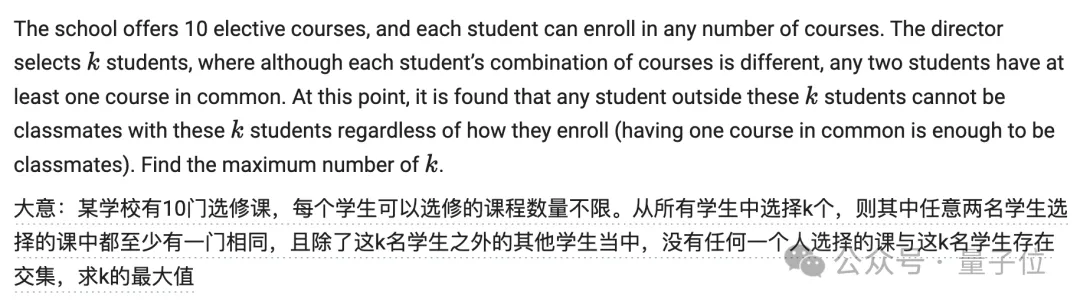

在官方文檔中,千問團(tuán)隊(duì)也展示了一些示例,比如奧賽級(jí)數(shù)學(xué)測試集Math Odyssey當(dāng)中有這樣一道題目。

這道題目涉及到組合數(shù)學(xué)和圖論,具體又包括了完全圖、二部圖等概念。

此外還需要理解如何將這些概念應(yīng)用于特定性質(zhì)結(jié)構(gòu)的構(gòu)建,需要較強(qiáng)的抽象思維能力和對圖論結(jié)構(gòu)的深刻理解。

Qwen2-Math的解決方案是這樣的,從中可以看出確實(shí)是運(yùn)用到了圖論方法。

最終,Qwen2-Math正確地回答了這道題目。

△中文為機(jī)翻,僅供參考

不過,目前發(fā)布的Qwen2-Math主要針對英文場景,中英雙語版本將會(huì)在之后推出。

另外,根據(jù)Qwen2-Math的許可協(xié)議,該模型對大部分用戶來說可以免費(fèi)商用,但對于72B版本,如果每月活躍用戶數(shù)超過1億,就需要向千問團(tuán)隊(duì)申請?jiān)S可了。

項(xiàng)目主頁:https://qwenlm.github.io/zh/blog/qwen2-math/