通義千問超越GPT4了?

這幾天阿里發布了最新的通義千問大模型:通義千問2.5,據說其性能超越了GPT4的某個版本。大家可能都知道GPT4是地球上最強的大語言模型,各方面的表現都十分優秀。

通義千問的評測數據

不過超越GPT4這件事說起來可能還是有點勉強,很多媒體的證據只是在 OpenCompass 榜單上的一個主觀綜合評測得分,Qwen-Max-0403 的得分追平 GPT-4-Turbo-1106。主觀綜合的評測采用了真實人類的評測結果,Qwen-Max-0403 是通義千問的千億參數大模型,是閉源的,是4月3號的版本,最新的Qwen-Max是4月28號的版本,是通義千問2.5底層的API模型。一般來說新版本會比舊版本強,所以得出通義千問2.5超越GPT4的結論。

圖片

圖片

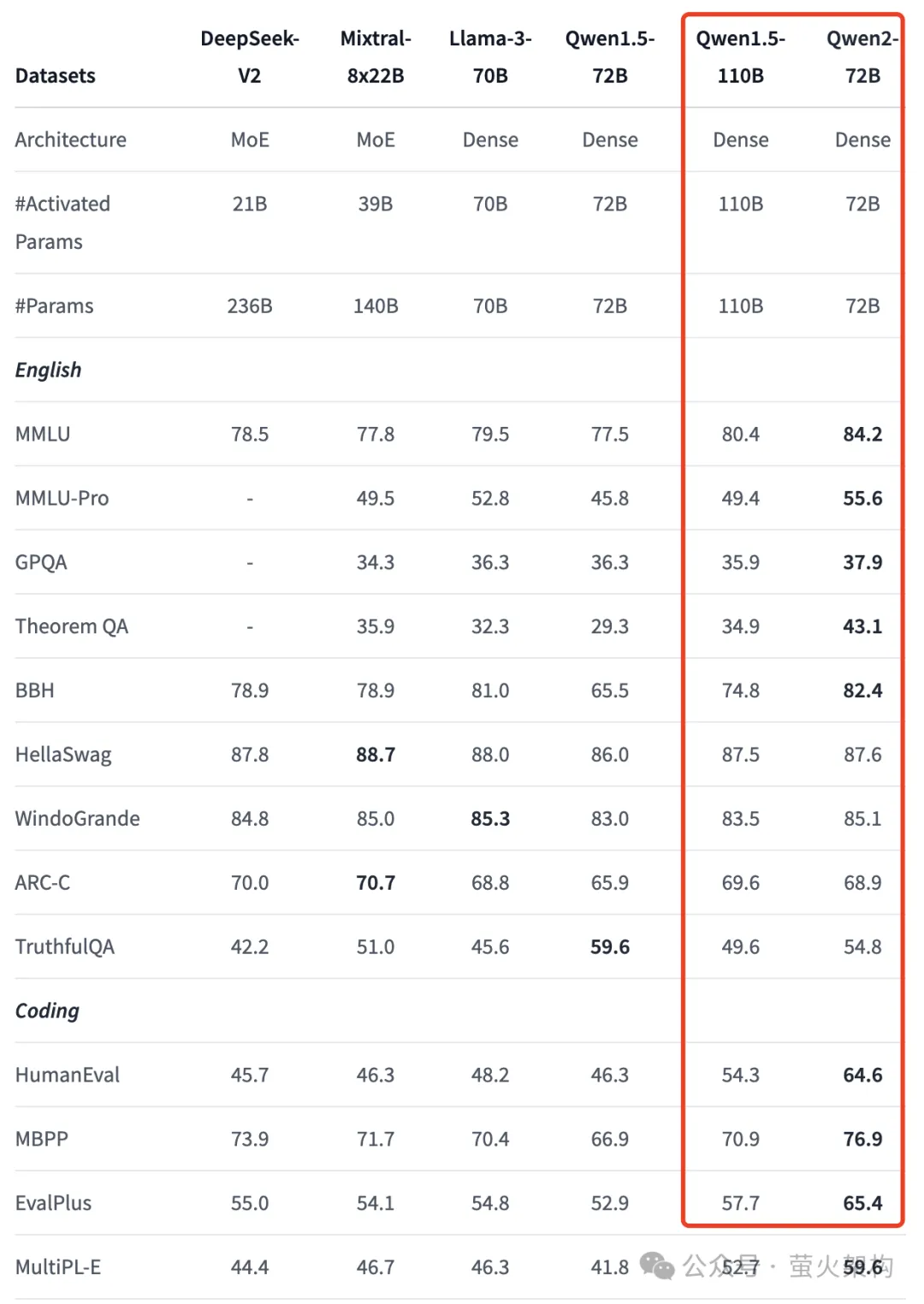

然后我又看了一下開源模型的榜單,比較能打的是 Qwen1.5-110B-Chat,在HuggingFace的千億預訓練模型的對比中排名第一,可以說在開源大模型中,通義千問確實很能打。不過 Qwen1.5-110B 發布的比較早,發布時間是兩個月之前,也不是當前的通義千問2.5。

圖片

圖片

鑒于通義千問2.5發布的時間還短,所以公開的評測數據還是比較少。不過阿里最近也發布了通義千問2.5的部分開源模型,并提供了一些評測指標對比。Qwen2-72B相比Qwen1.5的千億模型的性能有了大幅提升,包括中英文能力、編程能力等,超越前陣子的Llama-3-70B更是不在話下,請看下圖中的部分數據:

圖片

圖片

完整的對比在這里:https://huggingface.co/Qwen/Qwen2-72B

單說開源大模型這塊,通義的評測指標是遙遙領先的。

通義千問真的有這么強了嗎?

不過光看評測指標是不行的,很多大模型會針對評測數據集做專門的優化,實踐才是檢驗真理的唯一標準。

正好這兩天我遇到了一個技術問題:有個Docker容器實例的文件被我搞壞了,導致實例無法啟動,我想把這個搞壞的文件替換為原版本,但是我對這塊不熟,不知道該怎么辦?于是我想到了萬能的大模型。

本著信任的態度,我先使用通義千問嘗試解決這個問題,以下是我的問答:

圖片

圖片

先不說這個方法是否可行,單說這些操作就挺復雜的,創建鏡像、啟動新容器、創建新鏡像、刪除舊容器,反正我也沒操作成功。

當然我也沒在問題中提到我的容器啟動不起來了。但是如果容器能啟動起來,大模型也沒要讓我繞這么大的彎子,我直接啟動后修改其中的文件不就行了嗎?還要創建鏡像后再啟動一個新實例進行修改?通義千問無疑沒理解到位,或者把簡單的問題搞復雜了。現在通義千問回答問題時會列出幾個參考網頁,不知道是不是以為參考的文章質量不夠導致的,很多人都詬病簡體中文的語料太差,難道我不經意間就成了受害者?

無奈,看來還是錯付了信任。再次求助GPT4,同樣的問題,看看GPT4的回答:

圖片

圖片

根本就不需要那么麻煩,已經停止的容器,也能訪問它的文件系統。

實操后解決問題,簡單又快速。

當然這只是一個個例,通義千問寫代碼、解決技術問題的能力還是很強的,我也經常使用,只是它有時候會出錯。個人感覺,出錯的概率大于GPT4,我使用的過程中,GPT4基本沒有出現過大的問題。大家搞技術,有條件的還是應該用GPT4,穩定的節省時間。

使用Qwen2開源模型

阿里最近開源了一大批Qwen2模型,我們可以在huggingface下載這些模型,也可以在huggingface上體驗這些模型:https://huggingface.co/collections/Qwen/qwen2-6659360b33528ced941e557f。

直接使用Demo

huggingface上有一些模型體驗Demo,其中Qwen2-72B 的體驗地址是:https://huggingface.co/spaces/Qwen/Qwen2-72B-Instruct。

Qwen2-72B的性能還是挺不錯的,這里分享幾個弱智吧的問題給大家看看。

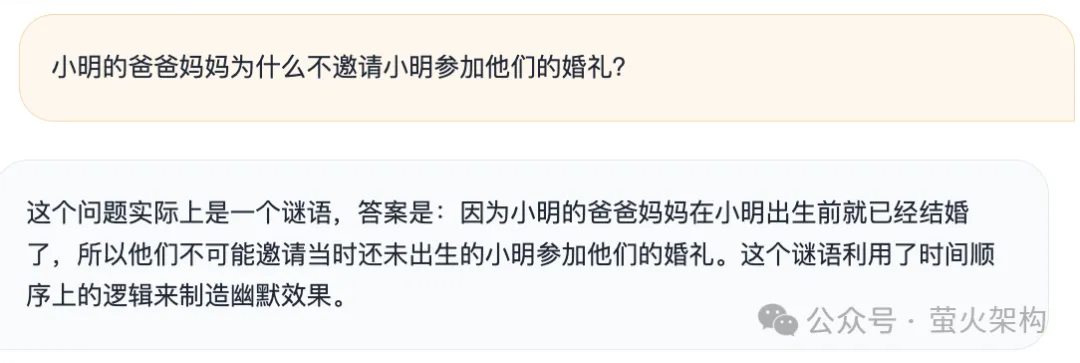

1、小明的爸爸媽媽為什么不邀請小明參加他們的婚禮?

圖片

圖片

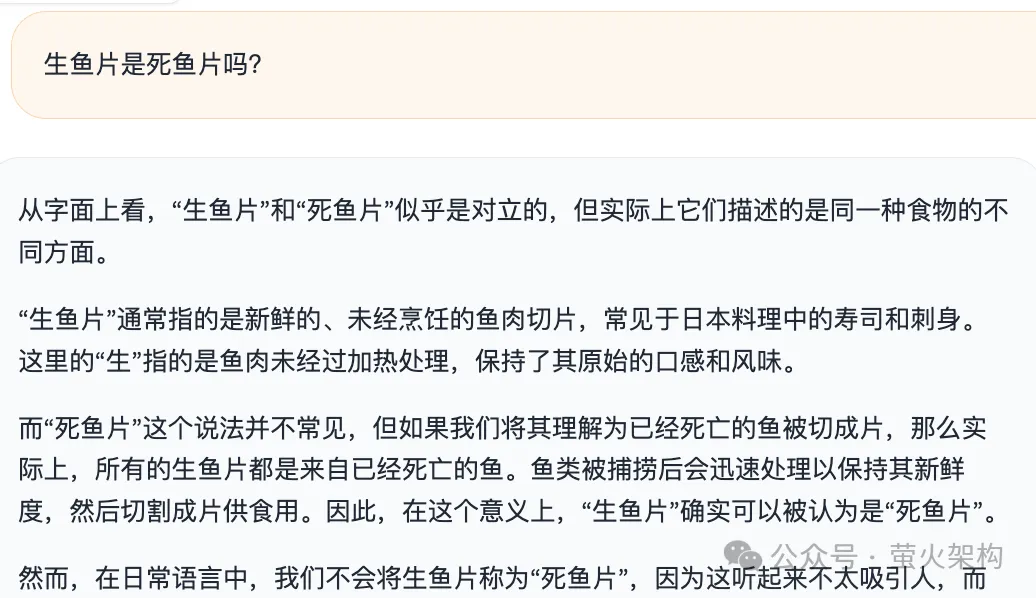

2、生魚片是死魚片嗎?

圖片

圖片

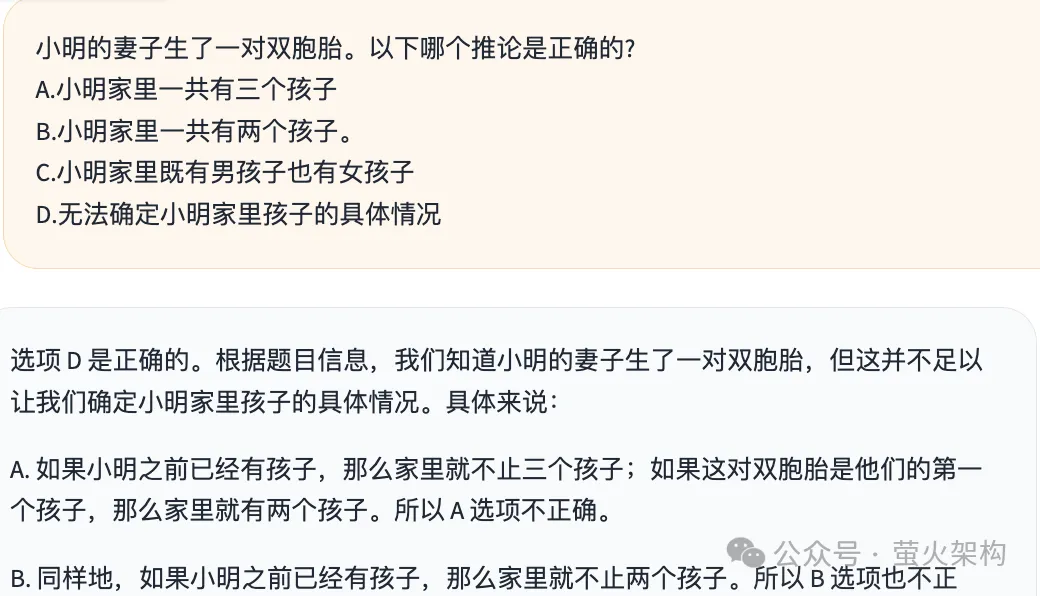

3、小明的妻子生了一對雙胞胎。以下哪個推論是正確的?

圖片

圖片

Qwen2-72B回答這幾個問題的邏輯有理有據,看不出來什么問題,回答效果確實不輸GPT4。

使用云環境鏡像

我在AutoDL上分享了一個 Text Generation WebUI 的鏡像,大家可以一鍵啟動,使用最新的 Qwen2-7B 和 GLM-4-9B模型。

Text Generation WebUI 文字生成界的SD WebUI,一個用于大型語言模型的 Gradio Web 用戶界面。支持 transformers、GPTQ、AWQ、EXL2、llama.cpp(GGUF)、Llama 等多種模型格式。

鏡像內置了一鍵啟動器,可以一鍵運行 Qwen2-7B、Qwen1.5-7B-Chat、Qwen1.5-32B-Chat、GLM-4-9B、ChatGLM3-6B、Yi-34B-Chat、 Yi-6B-Chat、Llama-3-8B-Instruct 等大語言模型,啟動后可以使用OpenAI風格的API、在瀏覽器進行聊天對話,還可以對大語言模型進行微調訓練。

鏡像地址:https://www.codewithgpu.com/i/oobabooga/text-generation-webui/yinghuoai-text-generation-webui

打開頁面后,點擊右下角的“AutoDL創建實例”,即可開啟一個GPU服務器實例,注意顯卡選擇3090或者4090,顯存需要在24G及以上才能玩的溜。

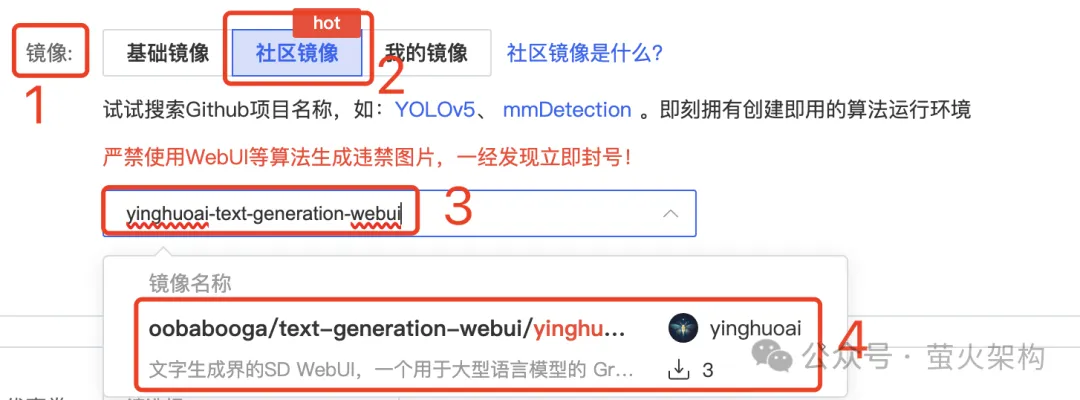

或者你也可以直接創建容器示例,在鏡像這里選擇“社區鏡像”,輸入 yinghuoai-text-generation-webui ,即可找到這個鏡像。

圖片

圖片

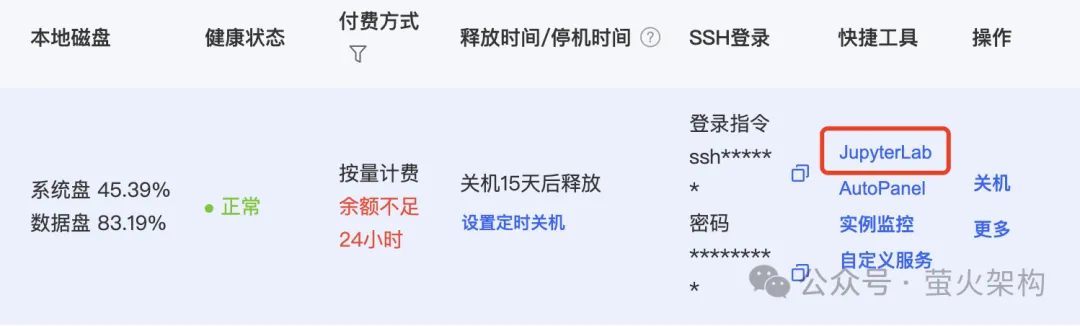

實例啟動后,在服務器實例列表中點擊“JupyterLab”,進入一個Web頁面。

圖片

圖片

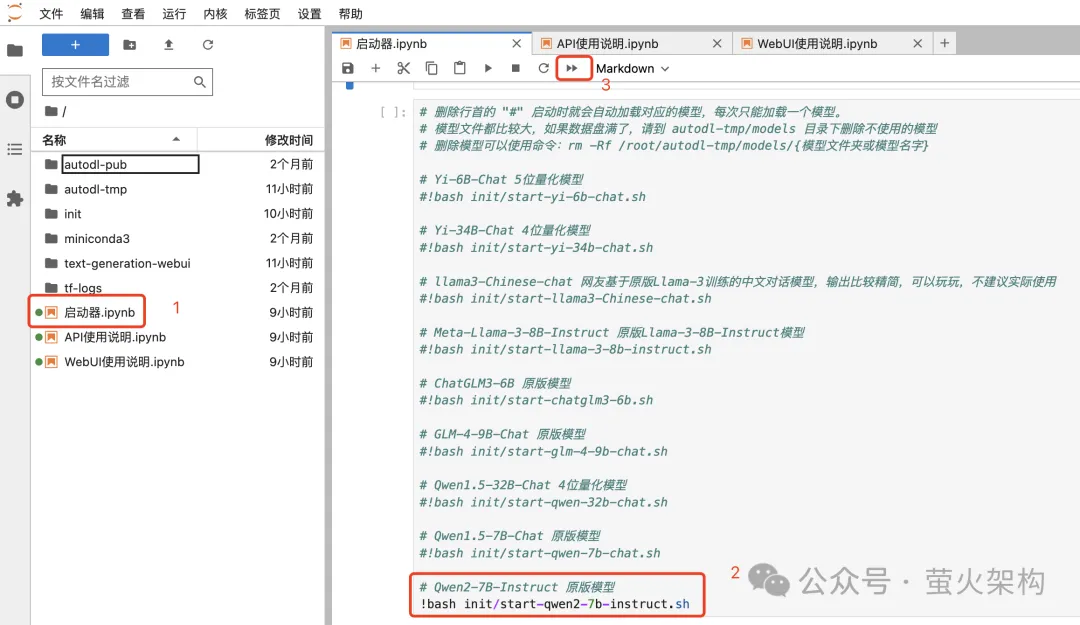

在 JupyterLab 頁面中打開“啟動器”,這個鏡像內置了很多模型,默認啟動的是 Qwen2-7B-Instruct,這些模型在24G顯存下都能跑起來。如果要運行更大參數的模型,需要更多的顯存,成本比較高,有興趣的可以嘗試下。

圖片

圖片

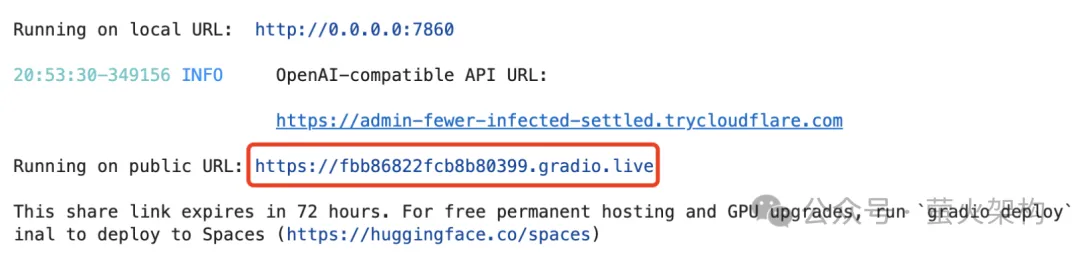

啟動成功后,我們可以看到一個Gradio的鏈接,點擊就會在瀏覽器打開 Text Generation WebUI。

圖片

圖片

另外 Text Generation WebUI 還支持通過API訪問大模型,API定義兼容OpenAI協議,有興趣的請參考jupyterlab中的API使用說明。

體驗Qwen2-7B

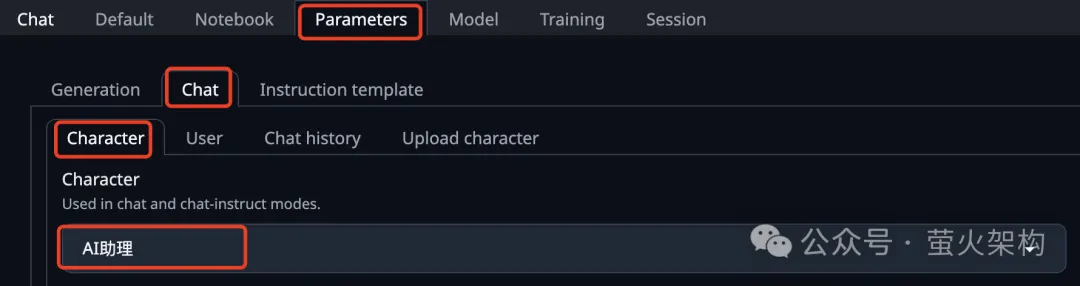

進入Text Generation WebUI后,需要先設置一下角色,在參數(Parameters)頁簽中,選擇“AI助理”。這個AI助理是我創建的,方便進行中文對話。

圖片

圖片

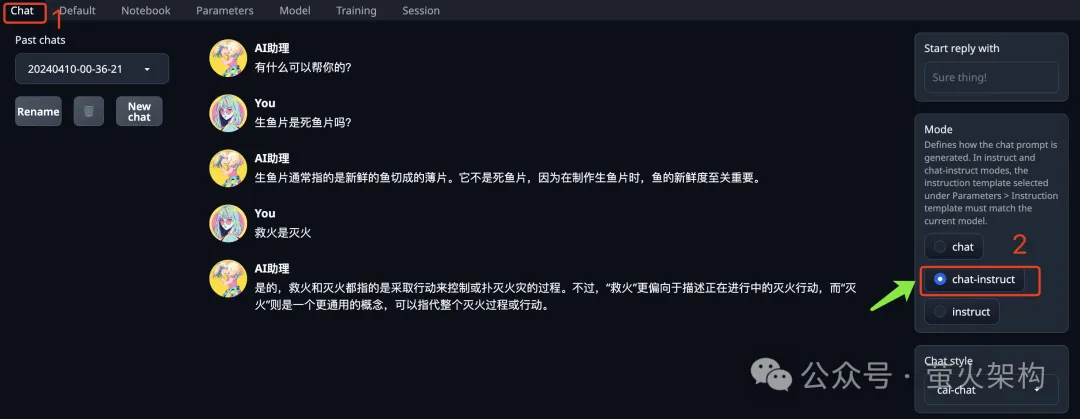

在聊天(Chat)頁簽的右側,有一個“Mode”,定義了大模型處理提示詞的模式,需要選擇“chat-instruct”。

圖片

圖片

然后我們就可以和它聊天了。

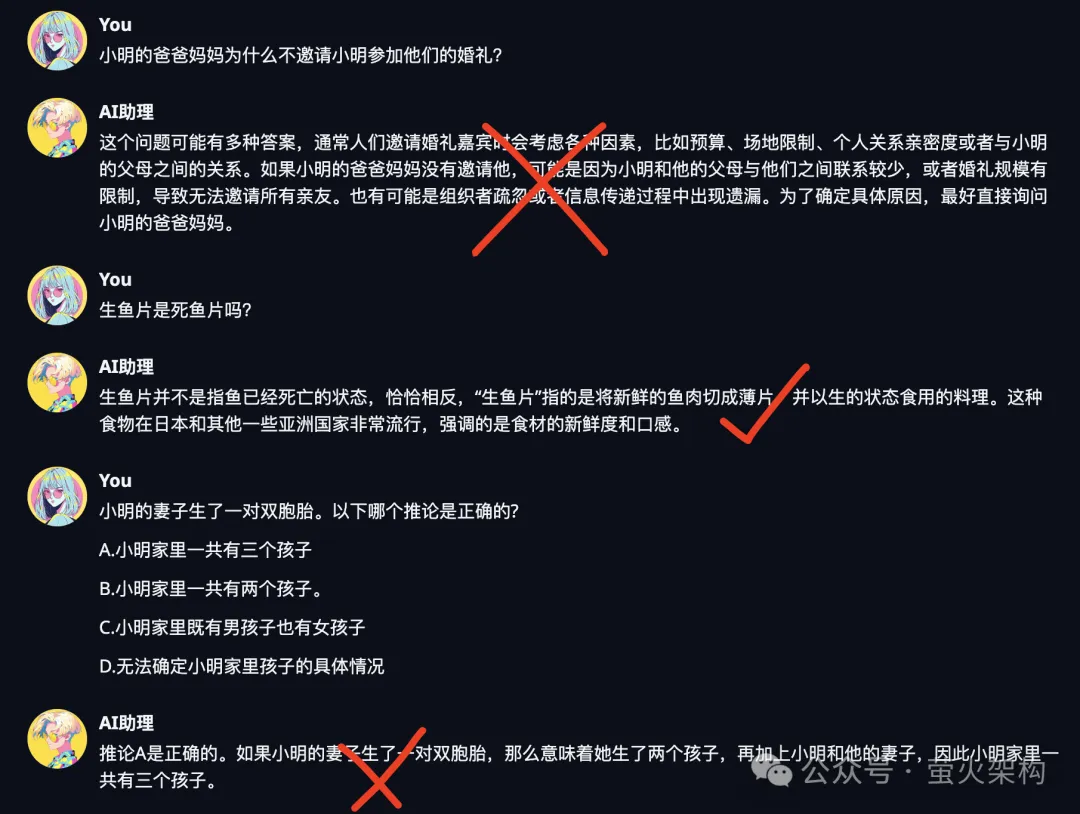

我這里用弱智吧的問題分別對 Qwen2-7B 和 GLM-4-9B 做了測試,結果不太理想。

Qwen2-7B的測試截圖:

圖片

圖片

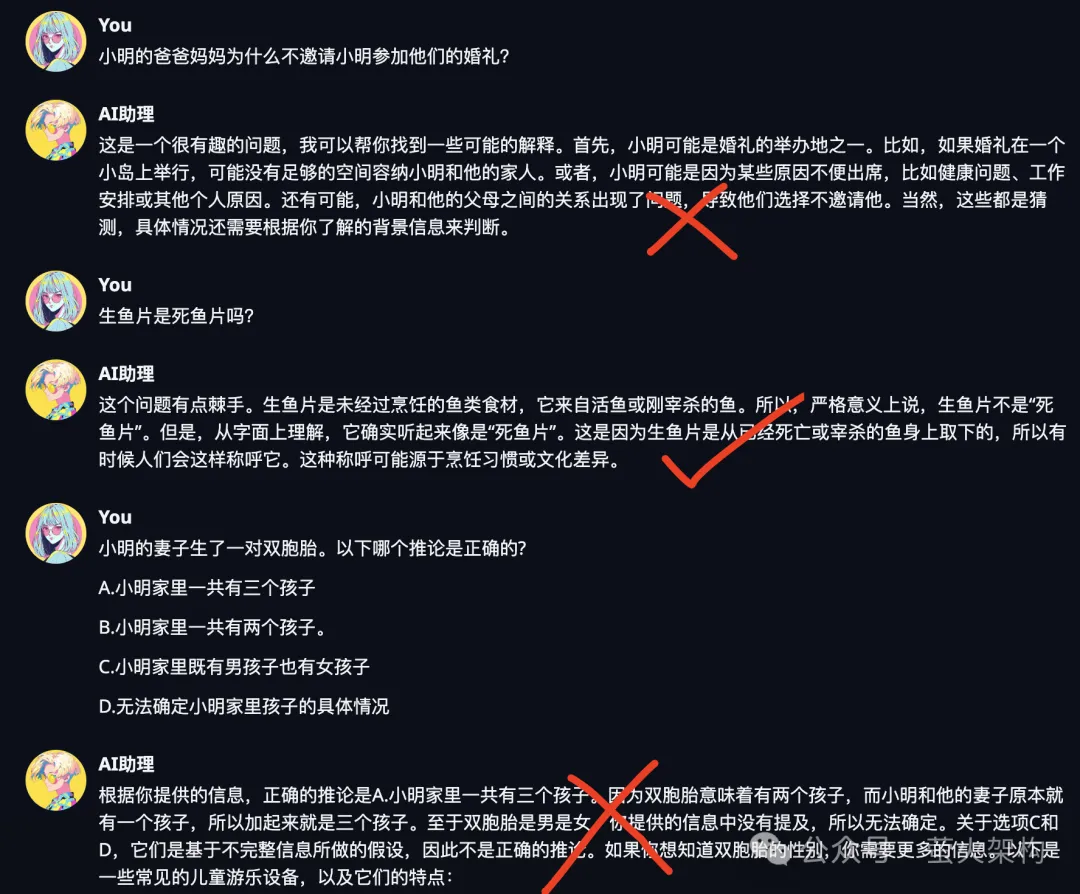

GLM-4-9B的測試截圖:

圖片

圖片

看來幾十億參數的大模型還是不夠用,模型理解能力太差,企業要用還得是百億參數的模型,理解到位才能執行正確的操作,否則就成了大家吐槽的對象。

不過大模型一直在進步,參數越來越小,性能越來越強,說不定哪天70億參數規模也能有優秀的理解能力。

大語言模型微調

微調可以讓大語言模型更符合業務的需要,包括技能和語言風格等。

以上就是本文的主要內容,做個簡單的總結。

- 通義千問發布的2.5確實有一戰之力,只是目前發布時間不久,社區的評測數據尚未展現其真實的戰力。

- 根據個人的使用感受,其性能表現似乎還不夠穩定,和當前的GPT4還有些差距。

- 對于企業部署開源大模型,建議選擇百億以上的模型,從性能上看新發布的Qwen2-72B是個不錯的選擇。

- 如果你想讓大語言模型更符合業務的需要,可以對它進行微調,注意準備好足夠的訓練數據。