揭秘WWDC24蘋果AI核心技術:智能端云基礎模型系統

在2024年全球開發者大會上,蘋果介紹了蘋果智能(Apple Intelligence),這是一個深度集成到iOS 18、iPadOS 18和macOS Sequoia中的個人智能系統。

蘋果智能由多個高度能產的生成模型組成,這些模型專門針對我們用戶的日常任務,并能夠即時適應當前活動。內置于蘋果智能的基礎模型已經針對諸如寫作和精煉文本、優先排序和總結通知、為與家人和朋友的對話創建有趣的圖像,以及簡化應用程序間交互的應用程序內操作等用戶體驗進行了微調。

在以下概述中,我們將詳細介紹這兩個模型——一個約30億參數的設備上語言模型,以及一個更大的基于服務器的語言模型,該模型可通過私有云計算使用,并運行在蘋果服務器上——它們是如何構建和適應以高效、準確、負責任地執行專業任務的。這兩個基礎模型是蘋果創建的更大家族生成模型的一部分,以支持用戶和開發者;這包括一個編碼模型,用于在Xcode中構建智能,以及一個擴散模型,幫助用戶在信息應用中等視覺上表達自己。

我們對負責任AI開發的專注

蘋果智能的設計在每一步都體現了我們的核心價值,并建立在突破性隱私創新的基礎上。

此外,我們制定了一套負責任的AI原則,以指導我們如何開發AI工具以及支撐這些工具的模型:

- 用智能工具賦予用戶權力:我們確定AI可以負責任地使用的領域,以創建解決特定用戶需求的工具。我們尊重用戶選擇使用這些工具來實現他們的目標的方式。

- 代表我們的用戶:我們構建深度個性化的產品,目標是真實地代表全球用戶。我們持續努力避免在我們的AI工具和模型中延續刻板印象和系統性偏見。

- 用心設計:我們在流程的每個階段都采取預防措施,包括設計、模型訓練、功能開發和質量評估,以識別我們的AI工具可能如何被濫用或導致潛在傷害。我們將在用戶反饋的幫助下,持續主動改進我們的AI工具。

- 保護隱私:我們通過強大的設備上處理和像私有云計算這樣的突破性基礎設施來保護我們用戶的隱私。我們在訓練我們的基礎模型時,不使用用戶的私人個人數據或用戶交互。

這些原則反映在整個架構中,該架構使蘋果智能成為可能,將功能和工具與專業模型相連接,并掃描輸入和輸出,為每個功能提供其正常運行所需的信息。

在本概述的其余部分,我們將提供有關我們如何開發高度能產、快速和節能的模型的決策的詳細信息;我們如何接近這些模型的訓練;我們的適配器如何針對特定用戶需求進行微調;以及我們如何評估模型性能,以幫助性和意外傷害為標準。

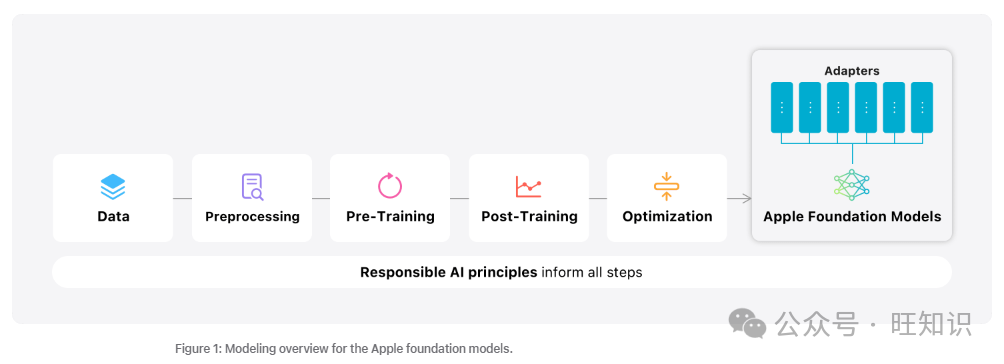

圖1:蘋果基礎模型的建模概述。

圖1:蘋果基礎模型的建模概述。

預訓練

我們的基礎模型是在蘋果的AXLearn框架上訓練的,這是我們在2023年發布的一個開源項目。它建立在JAX和XLA之上,允許我們在各種訓練硬件和云平臺上,包括TPU和云及本地GPU上,以高效率和可擴展性訓練模型。我們使用了數據并行、張量并行、序列并行和完全分片數據并行(FSDP)的組合,來沿著數據、模型和序列長度等多個維度擴展訓練。

我們在授權數據上訓練我們的基礎模型,包括為增強特定功能而選擇的數據,以及我們的網絡爬蟲AppleBot收集的公開可用數據。網絡發布者可以選擇退出使用他們的網頁內容進行蘋果智能訓練的數據使用控制。

我們從不使用用戶的私人個人數據或用戶交互來訓練我們的基礎模型,我們應用過濾器來刪除公開可用的個人身份信息,如社會安全號碼和信用卡號。我們還過濾掉褻瀆和其他低質量內容,以防止其包含在訓練語料庫中。除了過濾,我們還執行數據提取、去重和應用基于模型的分類器來識別高質量的文檔。

后訓練

我們發現數據質量對模型成功至關重要,因此我們在訓練管道中采用了混合數據策略,結合了人工注釋和合成數據,并進行了徹底的數據策劃和過濾程序。我們在后訓練中開發了兩種新算法:(1)帶有教師委員會的拒絕抽樣微調算法,以及(2)具有鏡像下降策略優化和留一法優勢估計器的人類反饋強化學習(RLHF)算法。我們發現這兩種算法顯著提高了模型的指令遵循質量。

技術優化

除了確保我們的生成模型高度能產外,我們還使用了一系列創新技術來優化它們在設備上和我們的私有云上的速度和效率。我們為第一令牌和擴展令牌推理性能應用了廣泛的優化集。

設備上和服務器模型都使用分組查詢注意力。我們使用共享的輸入和輸出詞匯嵌入表來減少內存需求和推理成本。這些共享的嵌入張量在沒有重復的情況下映射。設備上模型使用49K的詞匯量,而服務器模型使用100K的詞匯量,其中包含額外的語言和技術標記。

對于設備上推理,我們使用低比特調色板,這是一個關鍵的優化技術,實現了必要的內存、功耗和性能要求。為了保持模型質量,我們開發了一個新的框架,使用LoRA適配器,結合了混合2位和4位配置策略——平均每權重3.5位——以實現與未壓縮模型相同的準確性。

此外,我們使用交互式模型延遲和功耗分析工具Talaria,以更好地指導每個操作的比特率選擇。我們還利用激活量化和嵌入量化,并開發了一種方法,使我們的神經引擎能夠高效地更新鍵值(KV)緩存。

通過這套優化,我們在iPhone 15 Pro上能夠達到每個提示令牌的首次令牌延遲約為0.6毫秒,生成速率為每秒30個令牌。值得注意的是,這種性能是在沒有使用令牌推測技術之前獲得的,從這些技術中我們看到了代幣生成速率的進一步提高。

模型適應

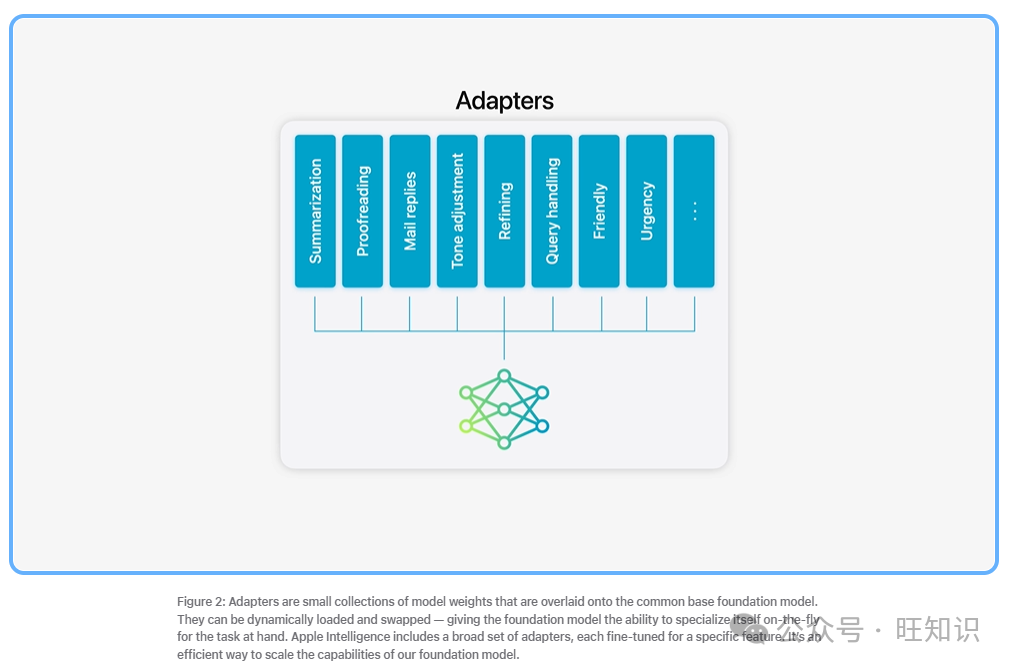

我們的基礎模型針對用戶的日常生活活動進行了微調,并且可以動態地針對手頭的任務即時專業化。我們使用適配器,這是可以插入預訓練模型各個層的小神經網絡模塊,來微調我們的模型以執行特定任務。對于我們的模型,我們適應了注意力矩陣、注意力投影矩陣以及點式前饋網絡中的全連接層,以適應變換器架構的適當解碼層集。

通過僅微調適配器層,原始預訓練模型的參數保持不變,同時保留模型的一般知識,同時定制適配器層以支持特定任務。

圖片

圖片

圖2:適配器是覆蓋在通用基礎基礎模型上的小型模型權重集合。它們可以動態加載和交換——賦予基礎模型即時專業化以應對手頭任務的能力。蘋果智能包括一系列適配器,每個適配器都針對特定功能進行了微調。這是一種有效的方式來擴展我們基礎模型的能力。

我們使用16位表示適配器參數的值,對于約30億參數的設備上模型,一個16級適配器的參數通常需要幾十兆字節。適配器模型可以動態加載,臨時緩存在內存中,并交換——賦予我們的基礎模型即時專業化以應對手頭任務的能力,同時有效管理內存并保證操作系統的響應性。

為了促進適配器的訓練,我們創建了一個高效的基礎設施,允許我們在基礎模型或訓練數據更新時快速重新訓練、測試和部署適配器。適配器參數使用優化部分介紹的準確性恢復適配器進行初始化。

性能和評估

我們的重點是提供能夠使用戶能夠在蘋果產品上進行通信、工作、表達自己和完成任務的生成模型。在對模型進行基準測試時,我們專注于人類評估,因為我們發現這些結果與我們產品中的用戶體驗高度相關。我們對特定功能適配器和基礎模型進行了性能評估。

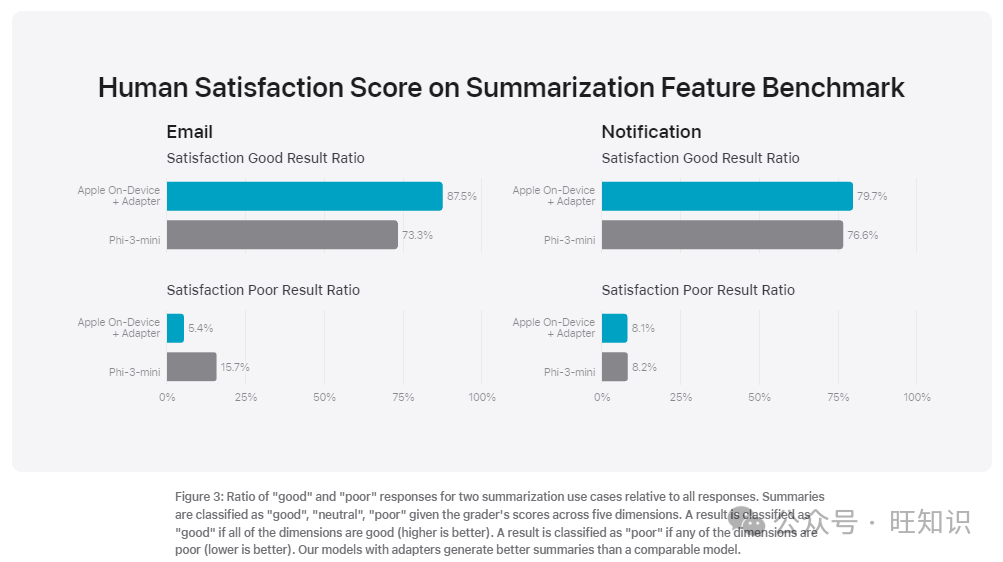

為了說明我們的方法,我們看看我們如何評估我們的摘要適配器。由于產品對電子郵件和通知摘要的要求在微妙但重要的方式上有所不同,我們在調色板模型上微調了準確性恢復低秩(LoRA)適配器,以滿足這些特定要求。我們的訓練數據基于由更大的服務器模型生成的合成摘要,并通過拒絕抽樣策略進行過濾,只保留高質量的摘要。

為了評估特定產品的摘要,我們使用了針對每種用例精心采樣的750個響應。這些評估數據集強調了我們的產品功能在生產中可能面臨的多樣化輸入,并包括了不同內容類型和長度的單一和堆疊文檔的分層混合。作為產品功能,評估性能對于代表真實用例的數據集非常重要。我們發現,我們的帶有適配器的模型生成的摘要比可比模型更好。

作為負責任開發的一部分,我們確定了并評估了摘要固有的特定風險。例如,摘要有時會以不受歡迎的方式移除重要的細微差別或其他細節。然而,我們發現摘要適配器在超過99%的目標對抗性示例中沒有放大敏感內容。我們繼續對抗性探測以識別未知的傷害,并擴大評估以幫助指導進一步的改進。

圖片

圖片

圖3: 對比兩種摘要使用案例的“好”和“差”響應比例。摘要根據評分者的評分分為“好”、“中”、“差”三類。如果所有維度都是好的(越高越好),則結果被分類為“好”。如果任何一個維度是差的(越低越好),則結果被分類為“差”。我們的模型配備適配器生成的摘要比可比模型更好。

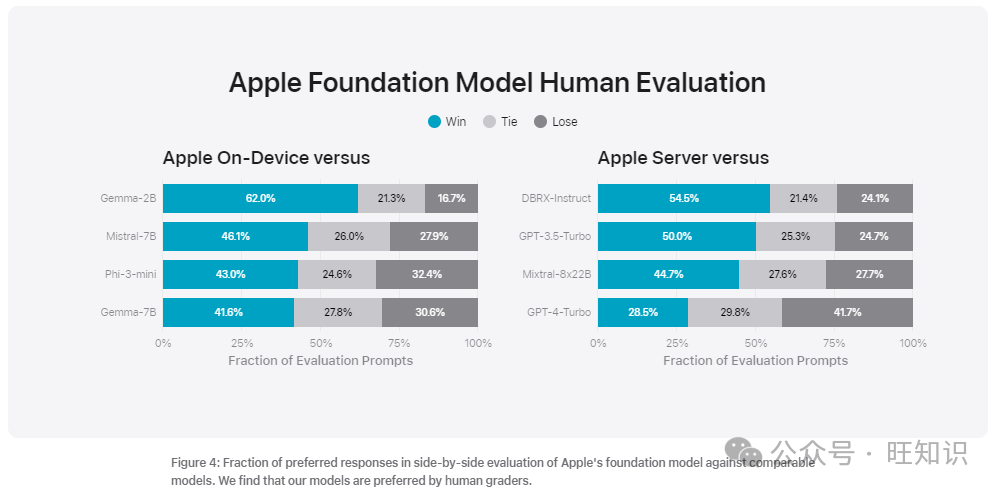

除了評估由基礎模型和適配器驅動的特定功能性能外,我們還評估了設備上和基于服務器的模型的一般能力。我們使用一套全面的現實世界提示的評估集來測試一般模型能力。這些提示在不同難度級別上多樣化,并涵蓋了主要類別,如頭腦風暴、分類、封閉問題回答、編碼、提取、數學推理、開放問題回答、重寫、安全性、摘要和寫作。

我們將我們的模型與開源模型(Phi-3、Gemma、Mistral、DBRX)和大小相當的商業模型(GPT-3.5-Turbo、GPT-4-Turbo)進行比較。我們發現我們的模型在大多數可比競爭模型中更受人類評分者的青睞。在這個基準測試中,我們的設備上模型,大約有30億參數,超過了包括Phi-3-mini、Mistral-7B和Gemma-7B在內的更大模型。我們的服務器模型與DBRX-Instruct、Mixtral-8x22B和GPT-3.5-Turbo相比具有高度效率,同時表現良好。

圖片

圖片

圖4: 蘋果基礎模型與可比模型的并排評估中首選響應的比例。我們發現我們的模型更受人類評分者的青睞。

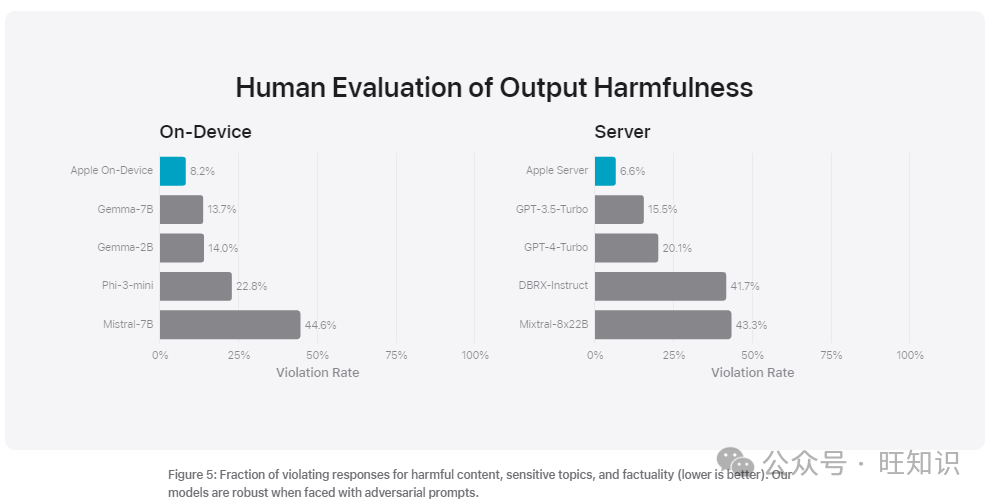

我們使用一系列多樣化的對抗性提示來測試模型在有害內容、敏感話題和事實性方面的表現。我們通過人類評分者在評估集上評估的違規率來衡量每個模型,數字越低越理想。設備上和服務器模型在面對對抗性提示時都很穩健,違規率低于開源和商業模型。

圖片

圖片

圖5: 有害內容、敏感話題和事實性的違規響應比例(越低越好)。我們的模型在面對對抗性提示時很穩健。

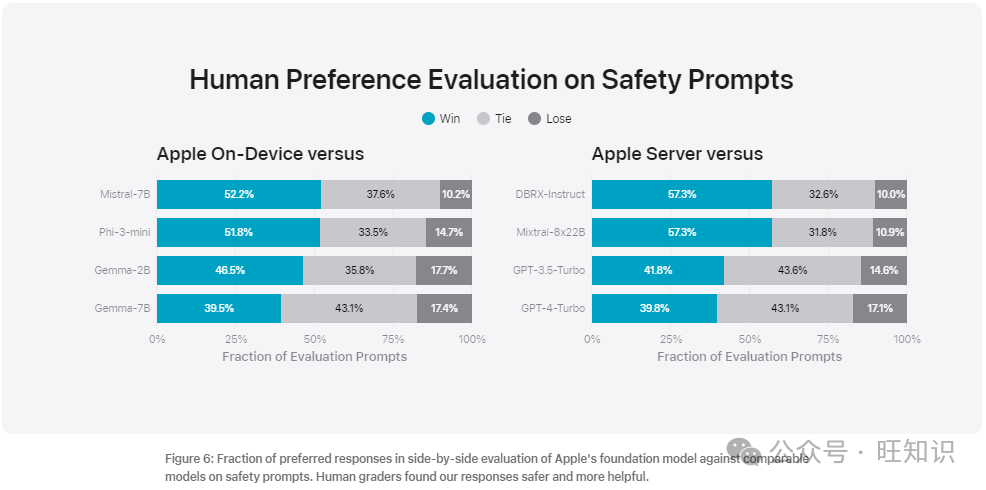

我們的模型在這些提示上被人類評分者認為是安全和有幫助的,優于競爭模型。然而,考慮到大型語言模型的廣泛能力,我們理解我們安全基準測試的局限性。我們正在積極與內部和外部團隊一起進行手動和自動紅隊測試,以繼續評估我們模型的安全性。

圖片

圖片

圖6: 蘋果基礎模型與可比模型在安全提示上的并排評估中首選響應的比例。人類評分者發現我們的響應更安全、更有幫助。

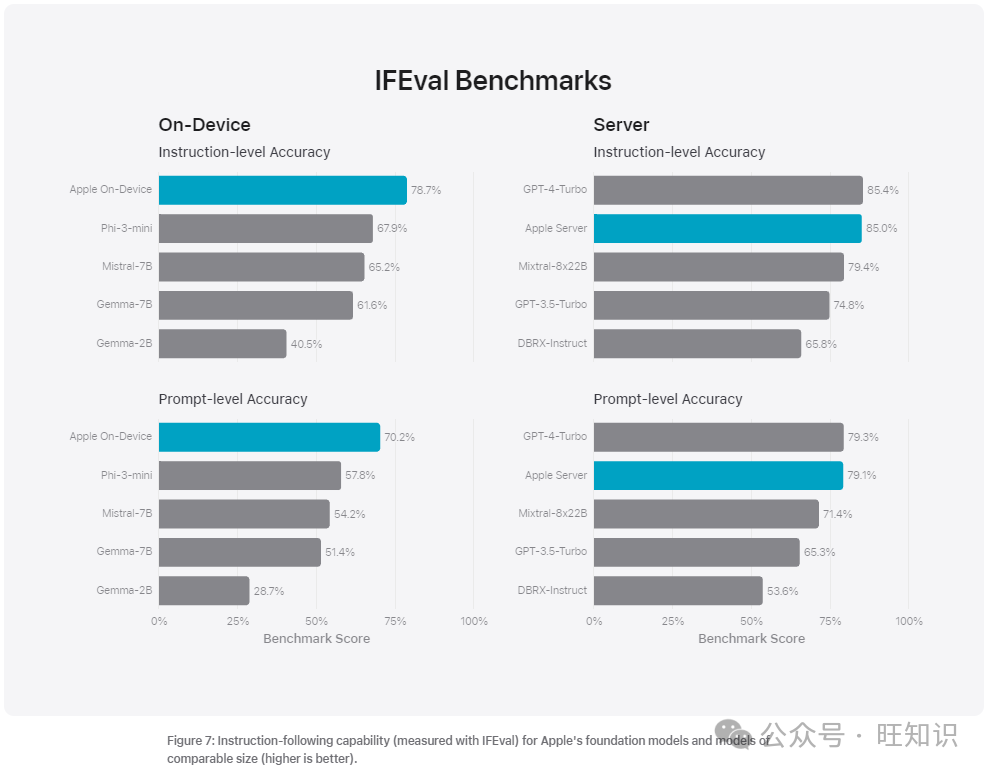

為了進一步評估我們的模型,我們使用指令遵循評估(IFEval)基準來比較它們與大小相當的模型的指令遵循能力。結果表明,我們的設備上和服務器模型比開源和商業模型更好地遵循詳細指令。

圖片

圖片

圖7: 蘋果基礎模型和大小相當的模型的指令遵循能力(用IFEval測量,越高越好)。

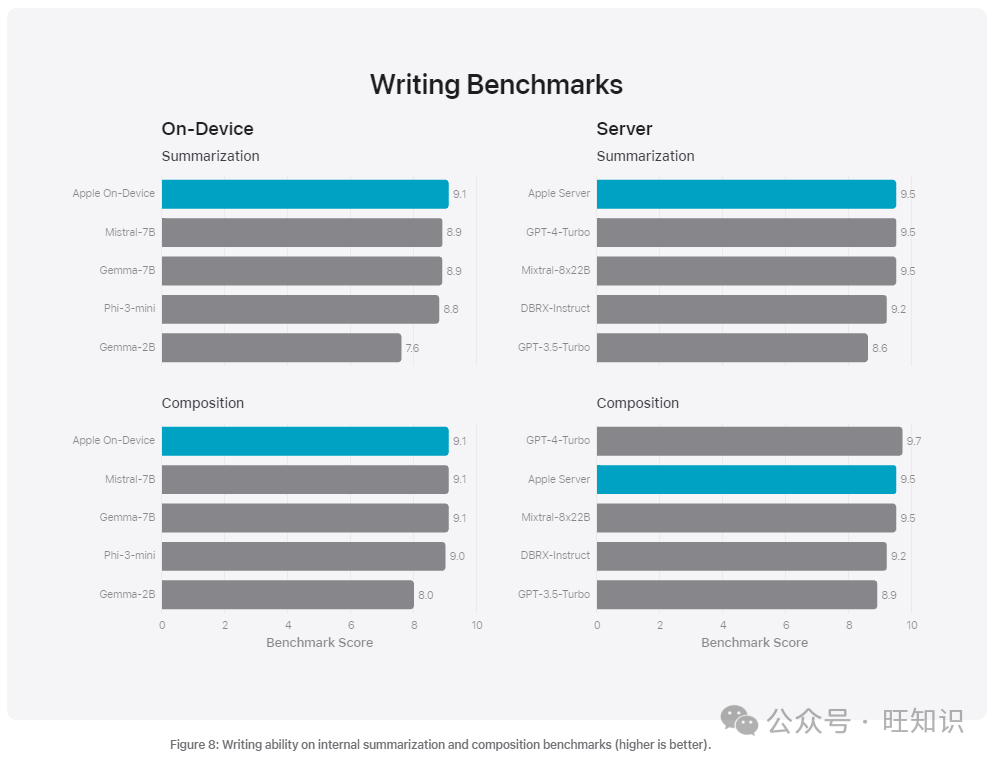

我們還在內部摘要和寫作基準上評估了我們模型的寫作能力,包括各種寫作指令。這些結果不是指我們在圖3中看到的特定摘要適配器,我們也沒有專注于寫作的適配器。

圖8: 在內部摘要和寫作基準上的寫作能力(越高越好)。

圖8: 在內部摘要和寫作基準上的寫作能力(越高越好)。

結論

在2024年全球開發者大會上介紹的蘋果基礎模型和適配器構成了蘋果智能,這是一個新的個人智能系統,深度集成到iPhone、iPad和Mac中,并在語言、圖像、動作和個人上下文方面提供了強大的能力。我們的模型創建的目的是幫助用戶在他們的蘋果產品上完成日常活動,并在每個階段負責任地開發,并以蘋果的核心價值為指導。

我們比較了以下模型版本:gpt-3.5-turbo-0125, gpt-4-0125-preview, Phi-3-mini-4k-instruct, Mistral-7B-Instruct-v0.2, Mixtral-8x22B-Instruct-v0.1, Gemma-1.1-2B, 和 Gemma-1.1-7B。開源和蘋果模型都在bfloat16精度下進行評估。

參考資料

- Apple Machine Learning Research, Introducing Apple’s On-Device and Server Foundation Models.

- 旺新知#本周重要AI技術進展:手機超腦Phi-3,蘋果OpenELM,企業AI大模型Arctic,開源多模態大模型

- 蘋果一夜重塑iPhone!GPT-4o加持Siri,AI深入所有APP,庫克:開啟蘋果AI下一章