CVPR 2024自動(dòng)駕駛挑戰(zhàn)賽Mapless Driving無圖智駕賽道論文解讀

本文經(jīng)自動(dòng)駕駛之心公眾號(hào)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請(qǐng)聯(lián)系出處。

比賽介紹

CVPR 2024 Autonomous Grand Challenge Track Mapless Driving無圖智駕賽道的任務(wù)是檢測(cè)車道線和交通元素(紅綠燈、道路標(biāo)牌等),并且推理車道之間、車道與交通要素之間的拓?fù)潢P(guān)系。在線建立局部高精度地圖,從而擺脫自動(dòng)駕駛對(duì)高精地圖(HD)的依賴。比賽基于OpenLaneV2數(shù)據(jù)集進(jìn)行。

無圖自動(dòng)駕駛和擴(kuò)城,是2023年各大廠商主要卷的方向。在CVPR 2023自動(dòng)駕駛挑戰(zhàn)賽中,無圖自動(dòng)駕駛包含兩個(gè)賽道:OpenLane Topology和Online HD Map Construction。今年的比賽相比去年的比賽相比,數(shù)據(jù)增加了標(biāo)清地圖(SD Map)。因此,今年的方案相比去年方案主要的改進(jìn)就是將SD Map信息輸入模型。

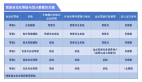

今年比賽的前三名被中國的隊(duì)伍包攬。

CVPR 2024 Autonomous Grand Challenge Track Mapless Driving Leaderboard

論文解讀

#1 LGmap: Local-to-Global Mapping Network for Online Long-Range Vectorized HD Map Construction

今年的冠軍LGmap提出三個(gè)創(chuàng)新點(diǎn):首先,提出了對(duì)稱視圖變換(symmetric view transformation, SVT)。克服了前向稀疏特征表示的局限性,利用深度感知和SD Map先驗(yàn)信息的。其次,提出了層級(jí)時(shí)序融合(hierarchical temporal fusion, HTF)。它利用局部和全局的時(shí)序信息,有利于為構(gòu)建具有高穩(wěn)定性的遠(yuǎn)距離的HD Map。最后,提出了一種新的人行橫道重采樣方法。簡化的人行道表示方法加快模型收斂性能。

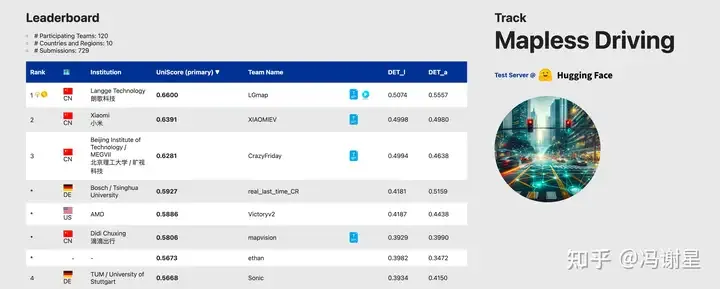

Diagram

論文的框架圖如下圖:

LGmap流程圖

Encoder

輸入圖片首先經(jīng)過Image Backbone,提取特征,得到PV(perspective view)特征。經(jīng)過論文提出的SVT,轉(zhuǎn)為BEV特征。所謂SVT,就是同時(shí)使用前向投影方法Lift-Splat-Shoot(LSS)和反向投影方法BEVFormer進(jìn)行特征轉(zhuǎn)換。LSS部分,使用激光雷達(dá)點(diǎn)云提供的深度作為監(jiān)督。在BEVFormer部分,在SD map的polyline采樣固定數(shù)量的點(diǎn),編碼成sinusoidal embedding,與圖像特征進(jìn)行cross attention,應(yīng)該是跟SMERF方法一致。LSS和BEVFormer得到的BEV特征用channel attention模塊進(jìn)行融合。

Decoder

有兩個(gè)并行的decoder,分別是instance-wise detection decoder和segmentation decoder。instance-wise detection decoder負(fù)責(zé)輸出待檢測(cè)的目標(biāo)。segmentation decoder起輔助作用,加快收斂。

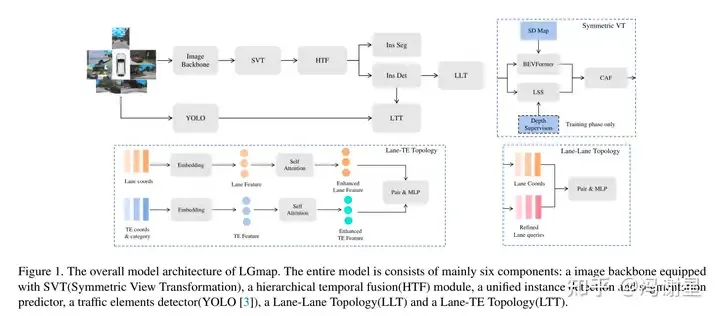

Temporal fusion

論文考慮時(shí)序信息,提升遠(yuǎn)距離建圖的準(zhǔn)確性。提出HTF,實(shí)際是將streaming和stacking結(jié)合的方式。所謂streaming是指RNN的范式,將信息通過memory進(jìn)行傳遞;而stacking就是直接將信息拼接。作者提出了streaming-streaming和streaming-stacking兩種方式供選擇。

Streaming和stacking組合的hierarchical temporal fusion模塊

Loss

總共考慮了4個(gè)loss。第一,跟隨MapTR,point2point loss和edge direction loss;第二,跟隨MapTRv2,segmentation loss和depth prediction loss;第三,BEV instance segmentation loss;第四,跟隨GeMap,geometric 3D loss。

Area

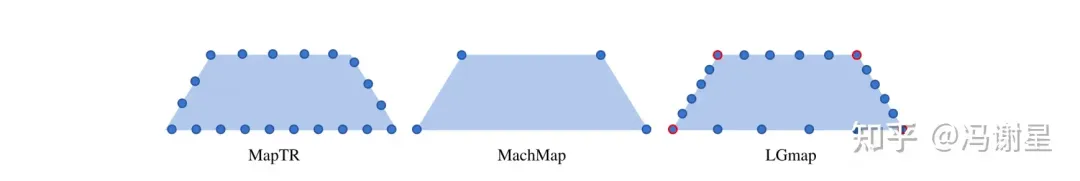

針對(duì)人行橫道,MapTR是是采用20個(gè)點(diǎn)均勻間隔采樣。本文則是受到Machmap的啟發(fā),首先用采樣4個(gè)頂點(diǎn),然后再用每條邊都為6個(gè)點(diǎn)的均勻采樣。這樣本文比MapTR的采樣點(diǎn)簡單很多,以20個(gè)點(diǎn)為例,MapTR有40種等效排列,而本文只有8中等效排列。這樣可以加速收斂速度。

MapTR, MachMap和本文LGmap的人行橫道建模方式對(duì)比

MapTR, MachMap和本文LGmap的人行橫道建模方式對(duì)比

Traffic elements

采用YOLOv8和YOLOv9,檢測(cè)交通元素,在OpenLaneV2,就包括紅綠燈和道路標(biāo)牌。

Lane-Lane topology

跟隨TopoMLP,將已經(jīng)輸出的centerline坐標(biāo)經(jīng)過MLP再變成embedding,與經(jīng)過訓(xùn)練的refined query結(jié)合,再經(jīng)過MLP,輸出車道線之間連接關(guān)系的二分類結(jié)果。

Lane-Traffic topology

本文的這部分是和檢測(cè)模型分離的。Lane-Traffic topology模型是用lane segments的和traffic elements的真值訓(xùn)的。lane segments和traffic elements過embedding層得到特征,再經(jīng)過self attention,得到加強(qiáng)特征,再過MLP進(jìn)行二分類。

Ablation Study

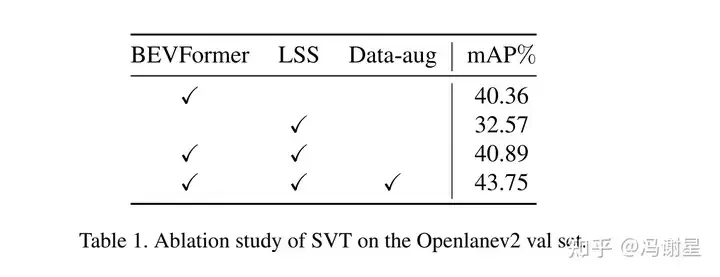

Encoder部分,增加LSS僅提高了0.5%,作用不大。BEVFormer是主力。

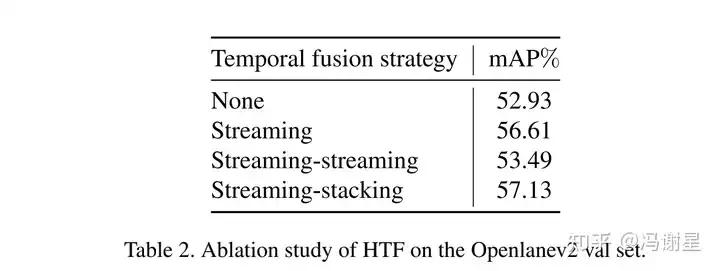

時(shí)序融合模塊,使用Streaming-Stacking模塊,比Streaming高0.5%。Streaming比baseline高3%,主力是Streaming。

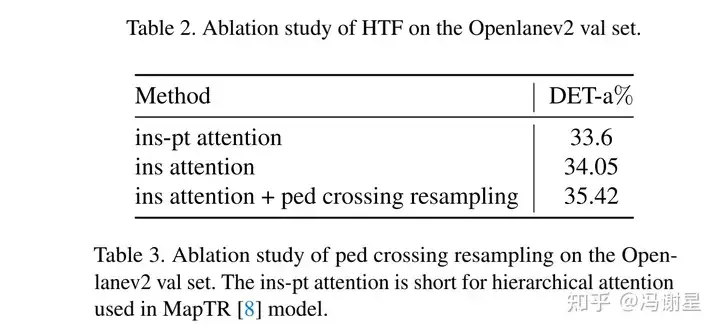

用新的人行橫道編碼方式,可有提高約1%。

#2 Leveraging SD Map to Assist the OpenLane Topology

本文設(shè)計(jì)了一種緊湊的transformer-based結(jié)構(gòu),用于SD map encoding and integration,充分利用SD map已經(jīng)包含的基礎(chǔ)道路拓?fù)浣Y(jié)構(gòu)。此外,提出一種動(dòng)態(tài)位置編碼(dynamic positional embedding)機(jī)制,提升decoding performance。

Model Architecture

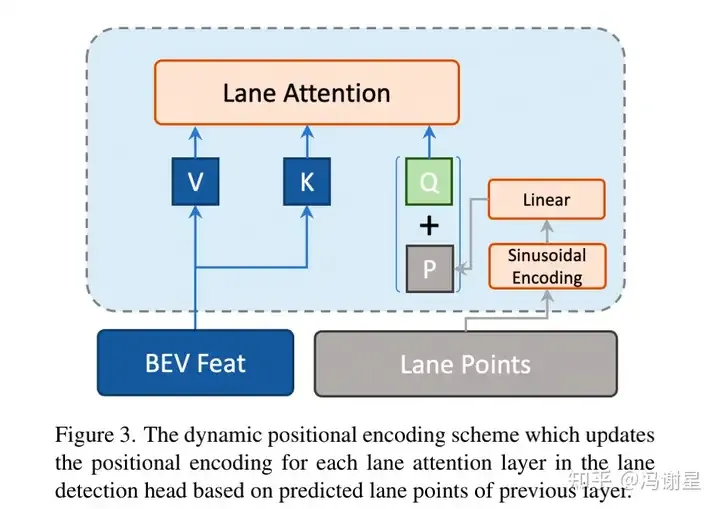

論文沒有給出總體框架圖。總體框架屬于常規(guī)的套路。

首先,經(jīng)過圖像backbone得到PV feature,再經(jīng)過BEVFormer得到BEV feature。其次,基于BEV feature,建立一個(gè)SD map encoder來提取SD map的特征。接下來,過lane decoder以及,得到lane的檢測(cè)結(jié)果。最后,接上 topology模型,topology模型是decoupled的。

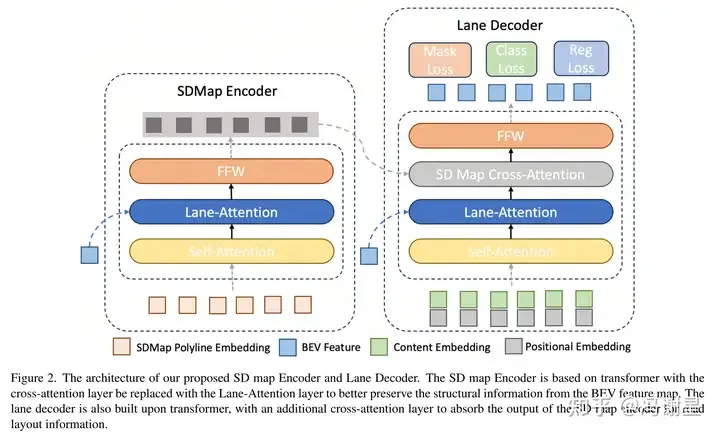

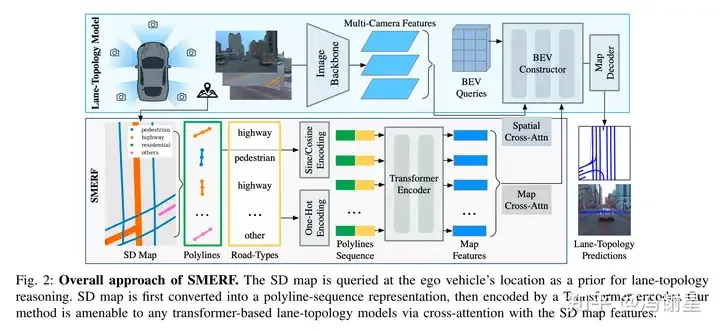

SD Map Encoder

SD map Encoder和Lane Decoder的示意圖

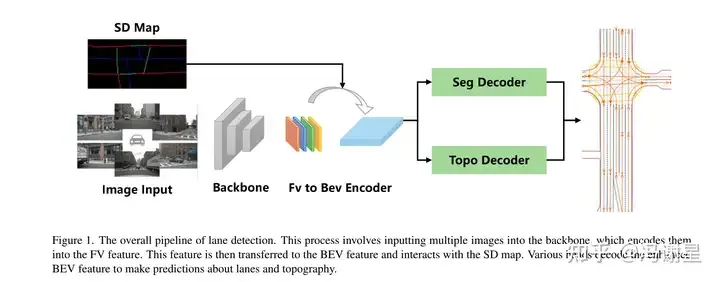

首先對(duì)SD map進(jìn)行編碼,方法跟LGmap基本上一致。針對(duì)SD map里面的M條polylines,每條polyline均勻取N個(gè)點(diǎn)。對(duì)這些點(diǎn)進(jìn)行sinusoidal embeddings:

其中p(,)表示polyline上采樣點(diǎn)坐標(biāo),j表示維度的索引, d表示編碼維度,T表示temperature scale。此外,一個(gè)one-hot向量 K用于編碼polyline類型。最后,所有的采樣點(diǎn)的positional embedding(就是上面公式的sinusoidal embeddings)和polyline的類別embedding拼接起來,得到N * d+K維度的SD map polyline編碼。先接一個(gè)linear layer,將維度轉(zhuǎn)為,再輸入transformer。

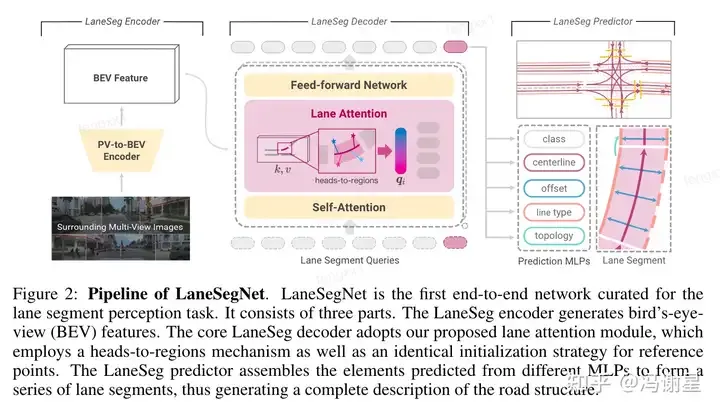

在SDMap Encoder里,先做一次self attention,再做一次cross attention,k, v是BEV features。這里選擇用LaneSegNet提出的Lane Attention操作。

Lane Decoder

Content embedding和positional embedding作為query輸入Lane Decoder,先進(jìn)行一個(gè)self attention,再接一個(gè)Lane Attention與BEV features進(jìn)行交互,再接一個(gè)cross attention跟SD map embedding進(jìn)行交互。

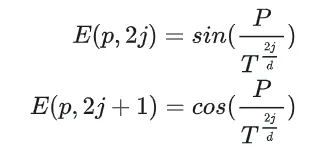

論文提出給Lane Attention動(dòng)態(tài)位置編碼。方法是在上一個(gè)decoder結(jié)束后,得到N個(gè)lane points坐標(biāo),將其進(jìn)行sinusoidal編碼,得到N * d維度的向量,再過linear layer變換成維的向量。作為位置編碼加到query里。

Lane Decoder中動(dòng)態(tài)位置編碼示意圖

Topology Prediction

與LGmap類似,論文也將topology prediction和detection任務(wù)分離了。論文說的原因是因?yàn)闃颖静黄胶猓琾ositive(associated elements)和negative(non-associated elements)極度不平衡。

將detection模型輸出的結(jié)果,輸入MLP,進(jìn)行二分類預(yù)測(cè)。在lane-lane topology中,考慮lane的起點(diǎn)和終點(diǎn)的距離。在lane-traffic topology,用traffic element的bbox和front view攝像機(jī)外參進(jìn)行編碼。

#3 UniHDMap: Unified Lane Elements Detection for Topology HD Map Construction

第三名是去年的冠軍團(tuán)隊(duì),也就是TopoMLP的作者團(tuán)隊(duì)。今年提出了一套u(yù)nified detection framework,檢測(cè)車道線,人行橫道和道路邊界,其中融入了SD map信息。和去年一樣,traffic elements還是用YOLOv8檢測(cè),topology prediction還是用MLP。

Diagram

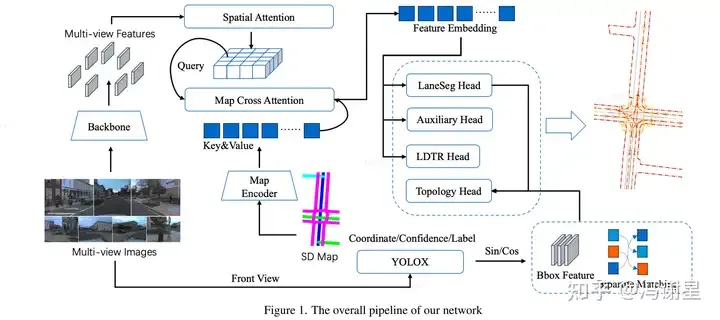

UniHDMap流程圖

BEV Feature Extraction

跟第二名的方案基本一樣,都是SMERF的特征提取框架,把SD map的信息融入。

SMERF算法流程圖

Lane and Area Detection

直接采用了LaneSegNet的detection部分。

LaneSegNet算法流程圖

Traffic Detection和Topology Prediction都跟去年的TopoMLP方法一樣。之后會(huì)專門寫一篇TopoMLP的解讀文章。

#6 MapVision: CVPR 2024 Autonomous Grand Challenge Mapless Driving Tech Report

論文引入了SD map encoder的pre-training,提高模型的幾何編碼能力。利用YOLOX來提高traffic element detection。另外,對(duì)area detection,引入LDTR和輔助任務(wù),提高精度。

Diagram

MapVision算法流程圖

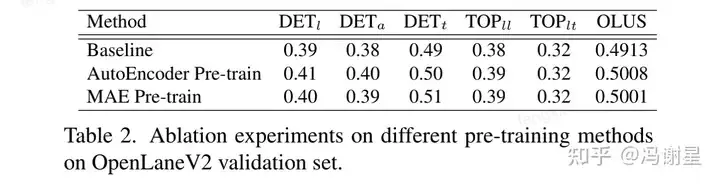

SD Map Encoding

Encoder的框架跟隨SMERF。為了增強(qiáng)SD Map Encoder幾何結(jié)構(gòu)的編碼能力,論文提出了對(duì)其進(jìn)行預(yù)訓(xùn)練。使用AutoEncoder進(jìn)行預(yù)訓(xùn)練,將feature sinusoidal embedding作為ground truth。在encoder后加一個(gè)輕量化的decoder,進(jìn)行預(yù)測(cè)。用L2 loss進(jìn)行監(jiān)督。漲點(diǎn)大概在2%左右。

Area Detection

跟隨MapTR得方式進(jìn)行檢測(cè)。但是,論文認(rèn)為MapTR采用keypoint的方式進(jìn)行編碼,降低了instance的整體性。因此,受到LDTR得啟發(fā),采用anchor-chain的編碼方式。

Traffic Detection和Topology Prediction跟前面的論文基本一致。

總結(jié)

CVPR 2024無圖智駕賽道榜單前幾名的模型框架基本一致。相比去年,也沒有顛覆性的創(chuàng)新,主要改進(jìn)在于以下幾點(diǎn):

- 引入了SD Map作為信息輸入,采用SMERF提出的框架將其融入到transformer encoding里;

- 引入時(shí)序信息,預(yù)測(cè)提高遠(yuǎn)處的建圖精度,提出采用streaming-stacking的方式;

- 對(duì)Area Detection的編碼方式,提出了一些改進(jìn),更好地適應(yīng)Area這個(gè)instance的特性;