自動(dòng)駕駛大模型論文調(diào)研與簡(jiǎn)述

本文經(jīng)自動(dòng)駕駛之心公眾號(hào)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請(qǐng)聯(lián)系出處。

最近關(guān)于大模型(LLMs, VLM)與自動(dòng)駕駛相關(guān)文獻(xiàn)調(diào)研與匯總:

適合用于什么任務(wù)?答:目前基本上場(chǎng)景理解、軌跡預(yù)測(cè)、行為決策、運(yùn)動(dòng)規(guī)劃、端到端控制都有在做。

大家都怎么做的?

- 對(duì)于規(guī)控任務(wù),LLM型基本是調(diào)用+Prompt設(shè)計(jì),集中在輸入和輸出設(shè)計(jì),如輸入有 1.2 DiLu這種拼memory的,輸出有1.1 LanguageMPC這種做cost function的,訓(xùn)練和微調(diào)的有1.3 Wayve的工作;有做開環(huán)的1.3,也有閉環(huán)的1.1 和1.2。目前仿真器和數(shù)據(jù)都未有統(tǒng)一的benchmark。

- 對(duì)于場(chǎng)景理解任務(wù),大多數(shù)都在構(gòu)建QA類型的數(shù)據(jù)集,常用數(shù)據(jù)集為nuScenes。

一、自動(dòng)駕駛決策/規(guī)劃任務(wù):

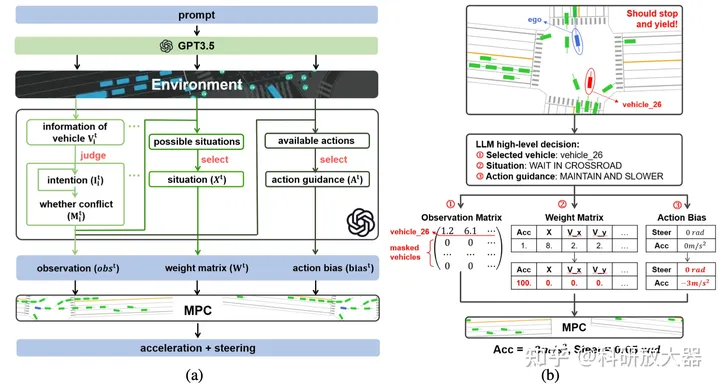

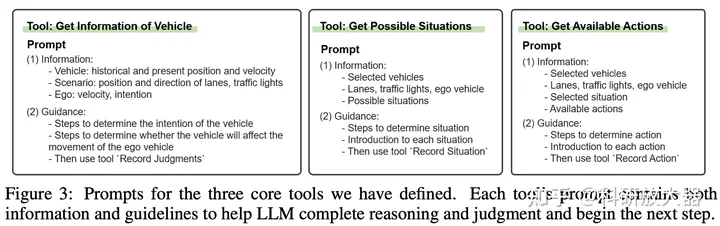

1. 1 LanguageMPC: Large Language Models As Decision Makers For Autonomous Driving, 10.4

動(dòng)機(jī):學(xué)習(xí)型決策系統(tǒng)缺乏 理解、泛化和可解釋性,LLM具備推理和泛化能力,如何作為決策器與下游控制器結(jié)合?Language-action對(duì)齊到了MPC的cost function。

方案:

LLM的任務(wù)1) 選擇關(guān)鍵交互車輛 2)評(píng)估當(dāng)前駕駛情況 3) 提供決策動(dòng)作引導(dǎo)。下游控制器采用了MPC controller,Language-action的輸出為 observation matrix, weight matrix, and action bias,前者對(duì)應(yīng)的是關(guān)鍵交互車輛,后兩者對(duì)應(yīng)MPC中Cost function的參數(shù)項(xiàng)。

對(duì)于上述3步所設(shè)計(jì)的prompts

對(duì)于上述3步所設(shè)計(jì)的prompts

實(shí)驗(yàn)環(huán)境:CARLA路口、環(huán)島等。調(diào)用GPT3.5,定義輸出action,輸入非視覺可理解為將原先vector輸入語言化。

1.2. DiLu: A Knowledge-Driven Approach to Autonomous Driving with Large Language Models, 9.28

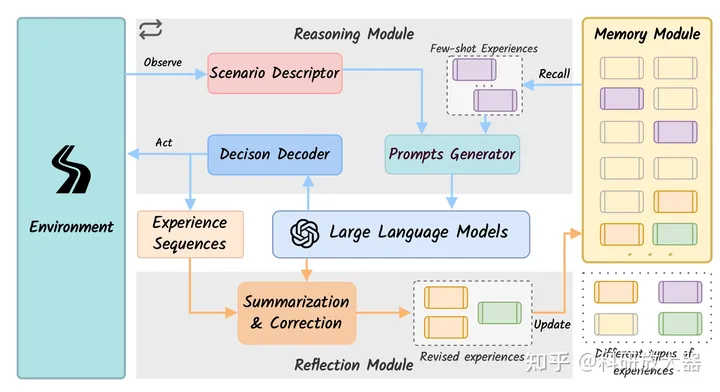

動(dòng)機(jī):用LLM增強(qiáng)agent的泛化和可解釋性。這篇文章的創(chuàng)新在于memory module的引入,是7月份Drive Like a Human的改進(jìn)版,值得一看。

框架:用GPT3.5作為推理輸出模塊,用GPT4作為reflection模塊。所有模塊非fine-tuning,而是輸入adaption

有意思的結(jié)論:LLM cannot directly perform the closed-loop driving tasks without any adaptation. 通過記憶模塊消融分析得到。

實(shí)驗(yàn)環(huán)境:HighwayEnv,閉環(huán);加速,保持,跟車,換道等高層行為,沒說decision decoder是什么,如何映射的高層行為到底層控制。對(duì)比基線為 RL。

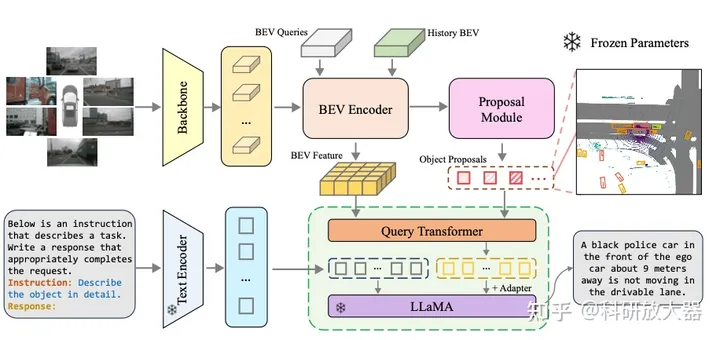

1.3 Driving with LLMs: Fusing Object-Level Vector Modality for Explainable Autonomous Driving,10.3 Wayve

動(dòng)機(jī):OOD的推理和可解釋能力;對(duì)于目標(biāo)級(jí)輸入構(gòu)建LLM的預(yù)訓(xùn)練和微調(diào)方法,開放駕駛QA數(shù)據(jù)和評(píng)估基線。還有一個(gè)相關(guān)blog: LINGO-1: Exploring Natural Language for Autonomous Driving

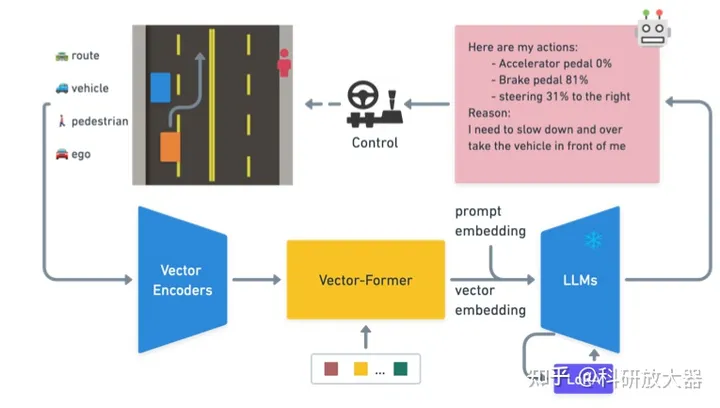

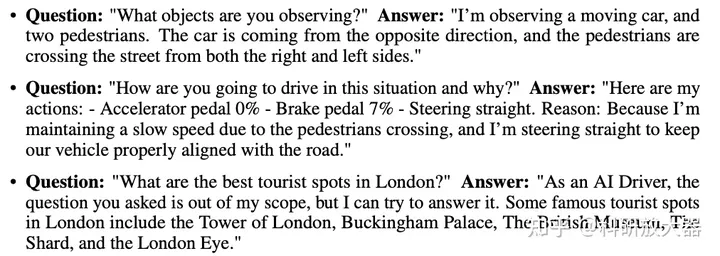

方法:action teacher:RL teacher;QA teacher:GPT teacher;

?

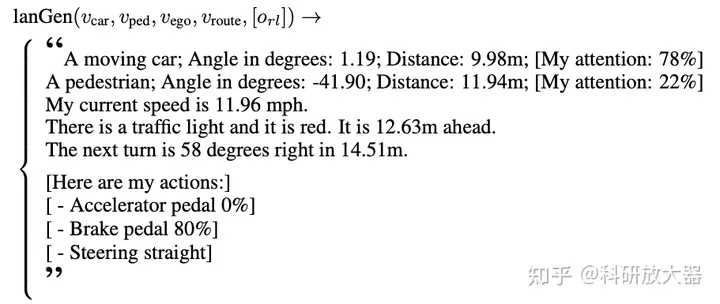

一個(gè)結(jié)構(gòu)化的語言生成器(lanGen):基于數(shù)值向量來產(chǎn)生prompt模版;使用RL產(chǎn)生專家動(dòng)作O_{rl},100k問答數(shù)據(jù)從仿真器收集 (包括表征學(xué)習(xí),推理任務(wù):action預(yù)測(cè),attention預(yù)測(cè))

?

駕駛問答數(shù)據(jù)標(biāo)注:使用ChatGPT來自動(dòng)產(chǎn)生問答數(shù)據(jù), 10k

?

訓(xùn)練過程:第一階段 訓(xùn)練vectorformer,輸入為高維的vector向量信息 第二階段:利用QA問答數(shù)據(jù)來finetuning LLaMA-7b

實(shí)驗(yàn):在1000個(gè)不同駕駛場(chǎng)景中評(píng)估,指標(biāo)為感知和預(yù)測(cè)精度;在開放世界場(chǎng)景中評(píng)估,通過ChatGPT來評(píng)估得分。要求20GB顯存來評(píng)估,40GB顯存來訓(xùn)練。

1.4 GPT-DRIVER: LEARNING TO DRIVE WITH GPT,10.2

動(dòng)機(jī):推理能力和泛化

方法:1. planner inputs and outputs as language tokens 2. a novel prompting-reasoning-finetuning strategy

輸入語言token化,使用的UniAD的感知和預(yù)測(cè)結(jié)構(gòu),輸出思維鏈與上一篇類似,LLM先輸出關(guān)鍵交互車、再判斷行為決策動(dòng)作,最后輸出軌跡。對(duì)chatGPT做了fine-tuning

實(shí)驗(yàn)環(huán)境:NuScenes,開環(huán),對(duì)比UniAD

1.5 Drive as You Speak: Enabling Human-Like Interaction with Large Language Models in Autonomous Vehicles,9.19

動(dòng)機(jī):LLM賦能

- Language Interaction

- Contextual Understanding and Reasoning

- Zero-Shot Planning

- Continuous Learning and Personalization

- Transparency and Trust

方案:更多探索人機(jī)協(xié)同,駕駛員給予指令,LLM ChatGPT 4獲取感知結(jié)果,輸出決策行為。沒有給實(shí)驗(yàn),只給了上圖的case。

1.6 Receive, Reason, and React: Drive as You Say with Large Language Models in Autonomous Vehicles, 10.12

同1.5,進(jìn)一步分析了ICL,CoT,Personalization方面的能力。

1.7 A Language Agent for Autonomous Driving, 11.17 (單位有Nvidia)

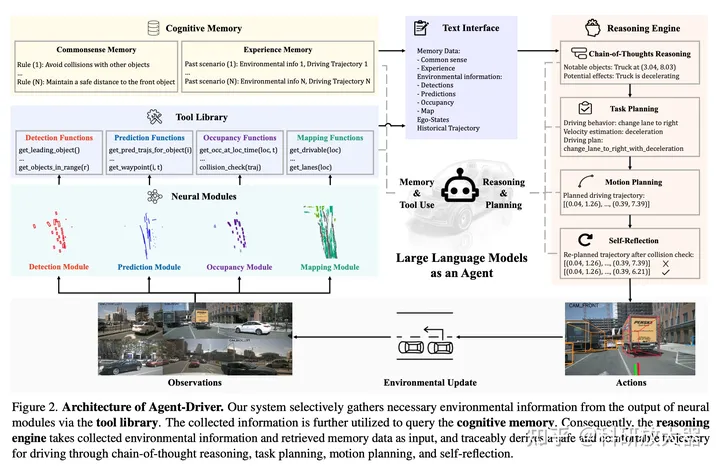

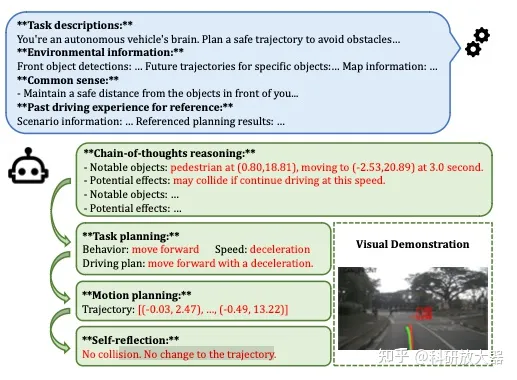

動(dòng)機(jī):用Agent框架重塑自動(dòng)駕駛系統(tǒng),Agent Driver,三個(gè)重要組件:tool library;cognitive memory;reasoning engine;

方法:輸入為sensory data;輸出為軌跡;

Tools:抽象不同網(wǎng)絡(luò)輸出并轉(zhuǎn)化為text文本,即LLM調(diào)用tools來收集文本形式的環(huán)境信息;tool庫(kù)是4類神經(jīng)網(wǎng)絡(luò)模型 檢測(cè)(產(chǎn)生檢測(cè)結(jié)果)、預(yù)測(cè)(產(chǎn)生預(yù)測(cè)結(jié)果)、占據(jù)柵格、地圖,但模型產(chǎn)生的信息過于冗余,LLM-based tools目的是為了從冗余的信息中提取到必要的環(huán)境信息。

Cognitive memory:基于環(huán)境信息query來搜索traffic rules (純文本形式;可以認(rèn)為是考駕照科目1的學(xué)習(xí)材料) 和 similar past experience(環(huán)境信息和decision);past experience記憶搜索形式:vector-space KNN + LLM-based fuzzy search

Reasoning:LLM-based CoT作為推理引擎,最終輸出軌跡,形式如GPT-Driver,自我反思部分基于碰撞檢測(cè)和優(yōu)化方法;如果碰撞檢測(cè)到危險(xiǎn),會(huì)利用優(yōu)化cost function形式將LLM 產(chǎn)生的軌跡進(jìn)行優(yōu)化;

實(shí)驗(yàn)還是在Nusenses數(shù)據(jù)集上的開環(huán)評(píng)測(cè),對(duì)標(biāo)的是UniAD和GPT-Driver,消融分析了ICL和fine-tuning的性能差異,結(jié)論是ICL是首選。

1.8 A Multi-Task Decision-Making GPT Model for Autonomous Driving at Unsignalized Intersections 6.30

不是大模型,trained PPO作為teacher,收集多任務(wù)教師數(shù)據(jù)用的 decision Transformer訓(xùn)多任務(wù)策略。沒太多可看的。

二、 軌跡預(yù)測(cè)

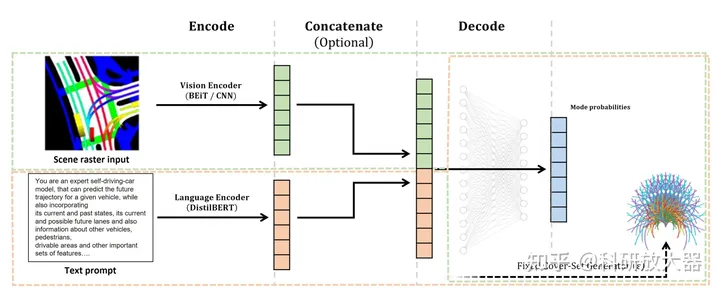

2.1 Can you text what is happening? Integrating pre-trained language encoders into trajectory prediction models for autonomous driving,9.13 Bosch

動(dòng)機(jī):可以將LLM看作foundation model,集成視覺特征和文本特征,進(jìn)行軌跡預(yù)測(cè)獲得最好效果

方案:由于GPT系列難以得到中間feature,對(duì)于文本使用的是DistilBert,對(duì)于BEV使用了BEiT作為encoder,

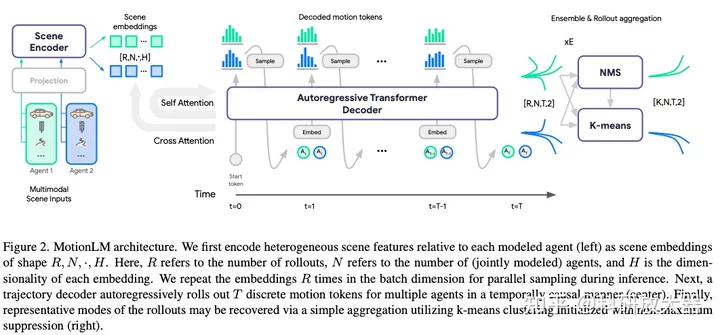

2.2 MotionLM: Multi-Agent Motion Forecasting as Language Modeling, ICCV, 2023, Waymo

動(dòng)機(jī):autoregressive language models作為多智能體軌跡預(yù)測(cè)模型,在waymo交互預(yù)測(cè)任務(wù)取得SoTA

方案:使用的是LLM類似的自回歸transformer decoder,但chatGPT本身沒有太大聯(lián)系。可以同時(shí)decoder多個(gè)智能體,不開源,

三、端到端控制任務(wù):

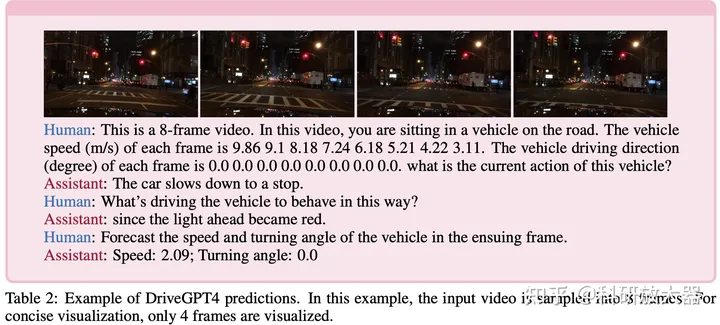

3.1 DRIVEGPT4: INTERPRETABLE END-TO-END AUTONOMOUS DRIVING VIA LARGE LANGUAGE MODEL,10.2

動(dòng)機(jī):可解釋性、泛化性。同時(shí)多模態(tài)大模型還可處理圖像和視頻數(shù)據(jù);可解釋性端到端模型,用黑盒解釋黑盒,具備了人機(jī)交互層面的可解釋性。

數(shù)據(jù)集生成:在BDDK的16k固定問答數(shù)據(jù)上,用chatGPT產(chǎn)生了新的12k問答數(shù)據(jù)

模型訓(xùn)練:使用Valley將video token轉(zhuǎn)化為語言token,LLM使用了LLaMA 2;預(yù)訓(xùn)練階段只訓(xùn)練video tokenizer;fine-tuning階段LLM和video tokenizer在29k數(shù)據(jù)上一起微調(diào),同時(shí)為了保障它的問答能力,還在80k的問答數(shù)據(jù)上一起微調(diào)

實(shí)驗(yàn)環(huán)境:開環(huán),視覺輸入,BDD-K,對(duì)比基線為ADAPT,metric:使用了ChatGPT打分。

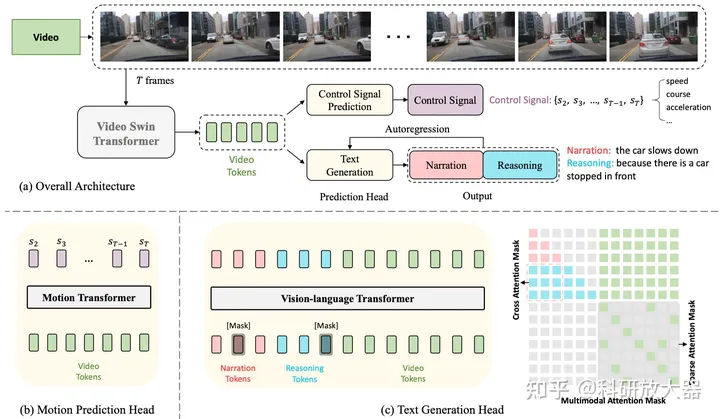

3.2 ADAPT: Action-aware Driving Caption Transformer,ICRA,2023,開源代碼,中文解讀

動(dòng)機(jī):端到端模型的可解釋性

方法:連續(xù)多幀圖像輸入,預(yù)訓(xùn)練的video swin transformer 得到video tokens,預(yù)測(cè)控制信號(hào)和文本輸出。

實(shí)驗(yàn)環(huán)境:開環(huán),BDD-K,具體見中文解讀。

四、多視角視覺輸入場(chǎng)景理解:

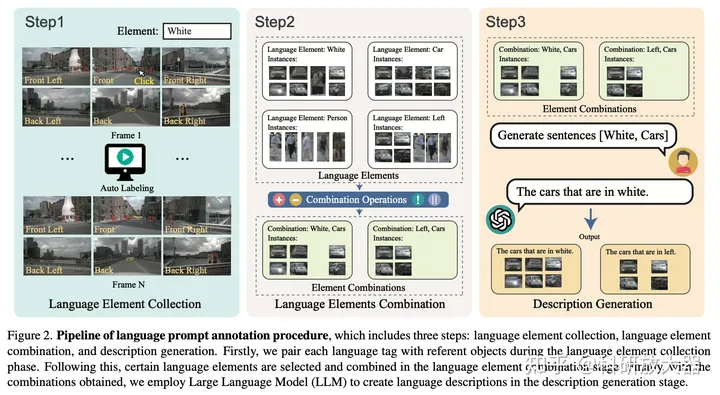

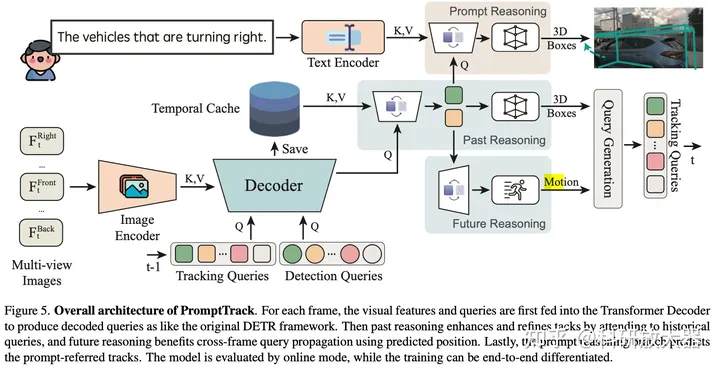

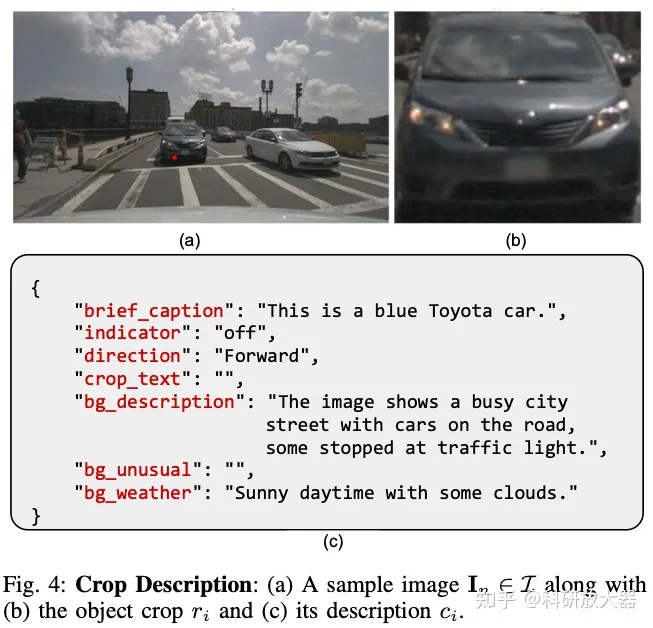

4.1 Language Prompt for Autonomous Driving,9.8

動(dòng)機(jī):缺少多視角輸入的language prompt-instance 數(shù)據(jù)

方案:第1步:3D目標(biāo)檢測(cè),目標(biāo)包括4類屬性 color,class,action,location, 手工標(biāo)注13k目標(biāo);第2步:屬性與或非操作的組合;第3步:讓GPT3.5產(chǎn)生描述的language prompt,35k. 基于nuScenes數(shù)據(jù)集。

基于此數(shù)據(jù)集,做了prompt輸入的多目標(biāo)跟蹤任務(wù)。整體效果為:利用視覺和language prompt,可以檢測(cè)和跟蹤多視角連續(xù)幀輸入的目標(biāo)。

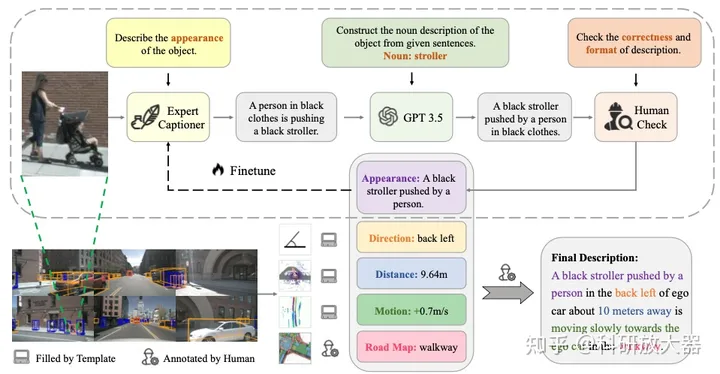

4.2 3D DENSE CAPTIONING BEYOND NOUNS: A MIDDLE-WARE FOR AUTONOMOUS DRIVING

動(dòng)機(jī):目前缺少銜接 感知和規(guī)劃的3D場(chǎng)景理解的LLM數(shù)據(jù)集,3D dense captioning

方案:3D目標(biāo)屬性:Appearance Direction Distance Motion Road Map

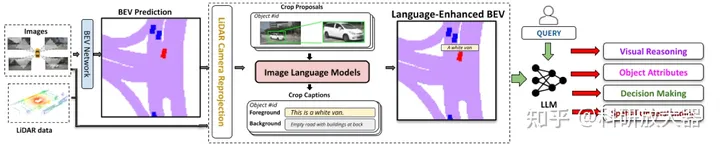

4.3 Talk2BEV: Language-enhanced Bird’s-eye View Maps for Autonomous Driving

與3.2類似,是對(duì)BEV input做了語言prompt.

4.4 DriveLM: Drive on Language, OpenDriveLab

LLM將用于感知、預(yù)測(cè)和規(guī)劃任務(wù),graph of thouht. 相比于3.2,多做了預(yù)測(cè)和規(guī)劃。在nuScenes上360k annotated QA pairs。目前只開源了demo樣例。

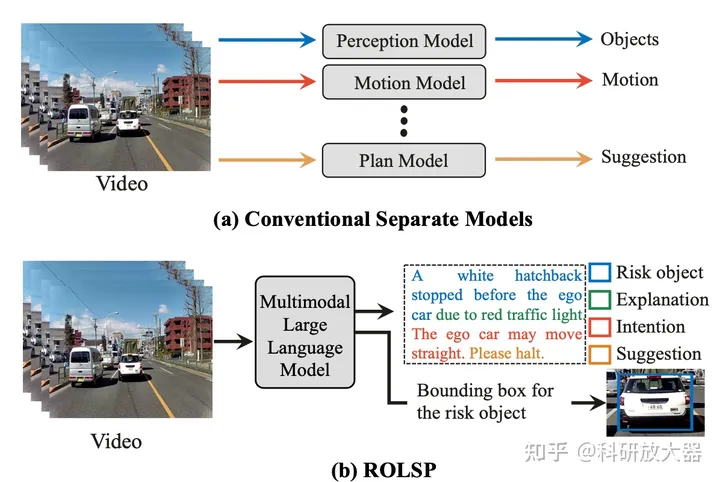

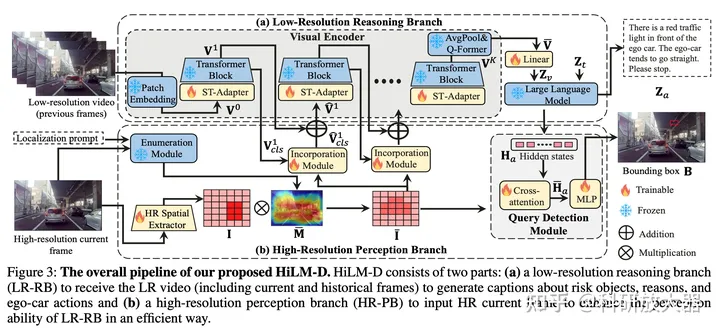

4.5 HiLM-D: Towards High-Resolution Understanding in Multimodal Large Language Models for Autonomous Driving,9.11

動(dòng)機(jī):對(duì)于非高清圖片,目前預(yù)訓(xùn)練的多模態(tài)大模型往往會(huì)漏掉小目標(biāo)、過分關(guān)注大目標(biāo)(由于預(yù)訓(xùn)練數(shù)據(jù)為低分辨率圖片)。本文感知關(guān)注的是關(guān)鍵風(fēng)險(xiǎn)目標(biāo),還輸出預(yù)測(cè)和主車決策建議,

動(dòng)機(jī)圖

方案:提出了用高清圖片分支輔助低分辨率分支,在23年CVPR的DRAMA數(shù)據(jù)集上進(jìn)行了實(shí)驗(yàn),包括關(guān)鍵風(fēng)險(xiǎn)目標(biāo)的檢測(cè)、預(yù)測(cè)目標(biāo)意圖和給出駕駛建議。

五、場(chǎng)景或數(shù)據(jù)生成

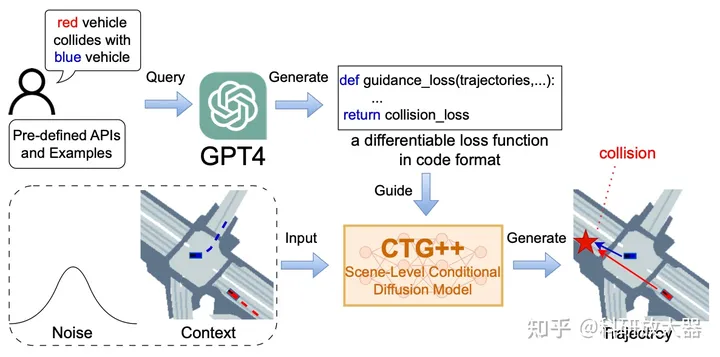

5.1 Language-Guided Traffic Simulation via Scene-Level Diffusion,Nvidia,CoRL, 2023

動(dòng)機(jī):基于語言表述生成openscenarios格式的場(chǎng)景

方案:利用GPT4產(chǎn)生引導(dǎo)loss,引導(dǎo)擴(kuò)散模型來產(chǎn)生指定場(chǎng)景

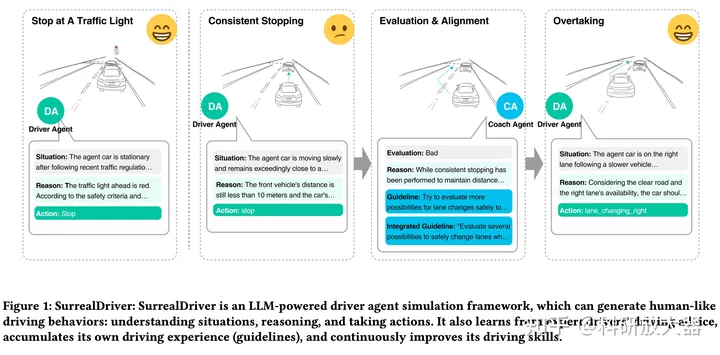

5.2 SurrealDriver: Designing Generative Driver Agent Simulation Framework in Urban Contexts based on Large Language Model,9.22

駕駛場(chǎng)景的可控生成,將會(huì)成為L(zhǎng)LM的潛力方向。

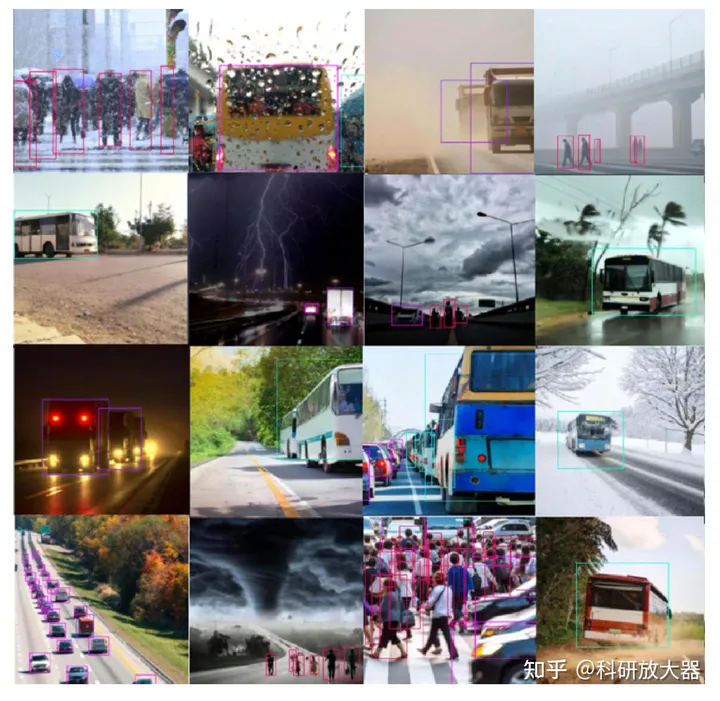

5.3 WEDGE: A multi-weather autonomous driving dataset built from generative vision-language models,2023, CVPR workshop

動(dòng)機(jī):緩解OOD問題,利用DALL-E生成增廣圖片數(shù)據(jù)