史上最快AI芯片「Sohu」,速度10倍于B200,哈佛輟學生打造

大模型時代,全球都缺算力,買鏟子的英偉達市值被炒上了天。

現在,終于有一家公司帶著自己的 AI 芯片來叫板了。

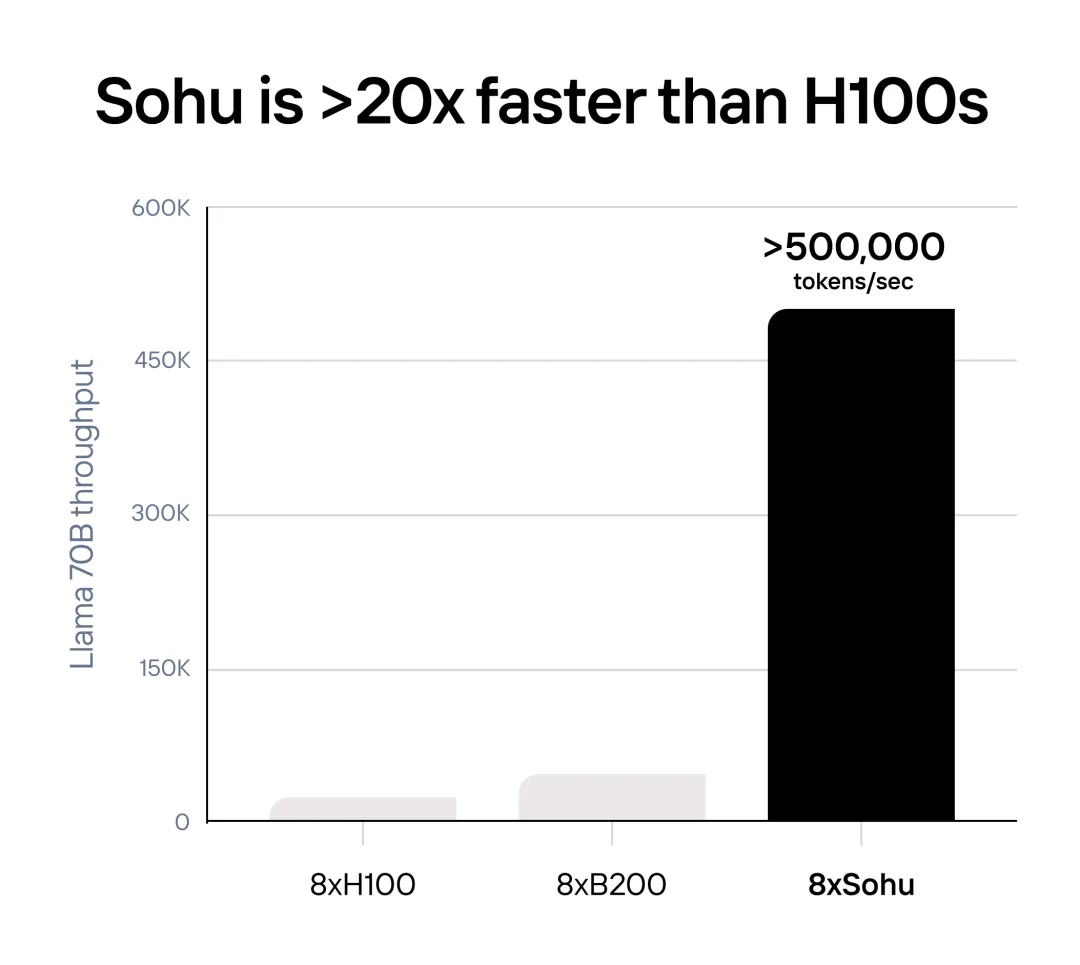

今天凌晨,科技圈迎來了一個重要新聞。美國芯片創業公司 Etched 推出了自己的第一塊 AI 芯片 Sohu,它運行大模型的速度比英偉達 H100 要快 20 倍,比今年 3 月才推出的頂配芯片 B200 也要快上超過 10 倍。

一臺 Sohu 的服務器運行 Llama 70B 每秒可輸出超過 50 萬個 token,比 H100 服務器(23,000 個 token / 秒)多 20 倍,比 B200 服務器(約 45,000 個 token / 秒)多 10 倍。

一臺 Sohu 的服務器運行 Llama 70B 每秒可輸出超過 50 萬個 token,比 H100 服務器(23,000 個 token / 秒)多 20 倍,比 B200 服務器(約 45,000 個 token / 秒)多 10 倍。

Sohu 是世界第一款專用于 Transformer 計算的芯片,歷時兩年打造。

作為一塊 ASIC(專用集成電路),Sohu 把對于 transformer 架構的優化硬化在芯片中,無法運行大多數「傳統」的 AI 模型:如為 Instagram 廣告提供支持的 DLRM、AlphaFold 2 等蛋白質折疊模型或 Stable Diffusion 2 等較舊的圖像生成模型。我們也無法運行 CNN、RNN 或 LSTM。

但另一方面,對于 transformer 來說,Sohu 就是有史以來最快的芯片,與其他產品之間是量級的區別。如今的每款主流 AI 產品如 ChatGPT、Claude、Gemini 和 Sora 都是由 transformer 驅動的。

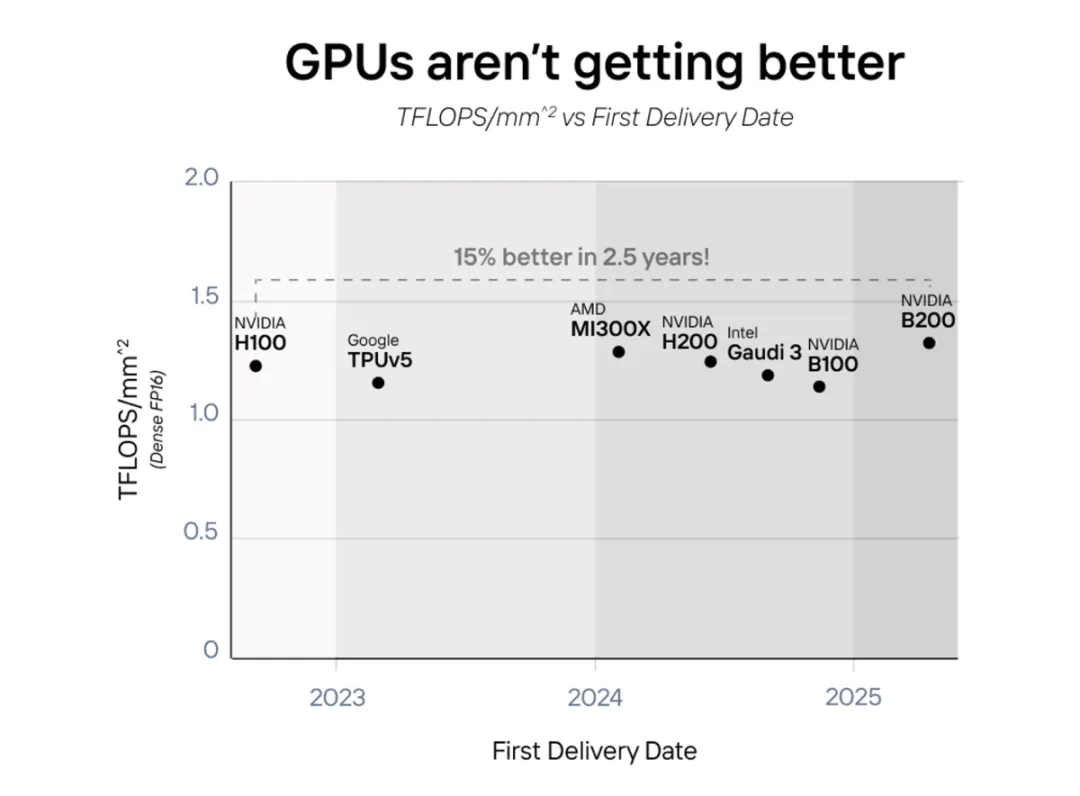

最近一段時間,由于摩爾定律放緩,GPU 性能的提升很大程度上需要依賴于增加芯片面積和功耗。不論是英偉達 B200、AMD MI300X 還是 Intel Gaudi 3,都不約而同的使用「二合一」的方式提升性能,功耗也翻倍了。

從 2022 年到 2025 年,AI 芯片的性能并沒有真正變得更好,而是變得更大了。

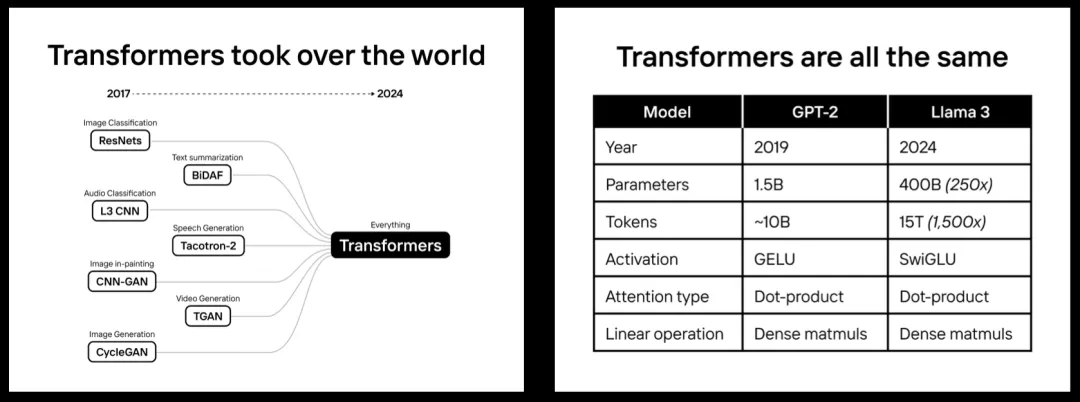

但如果大模型廣泛使用 Transformer 架構,追求專業化或許是提高性能的好方向。

作為一個新興領域,AI 模型的架構過去變化很大。但自 GPT-2 以來,最先進的模型幾乎都在使用 Transformer,從 OpenAI 的 GPT 系列、谷歌的 PaLM、Facebook 的 LLaMa,再到特斯拉 FSD 自動駕駛所需的模型。

Etched 給我們算了一筆賬:芯片項目的成本為 5000 萬至 1 億美元,需要數年時間才能投入生產。另一方面,當模型訓練成本超過 10 億美元、推理成本超過 100 億美元時,使用專用芯片是不可避免的。在這種產業規模下,1% 的改進就能撬動硬件架構的更新。

速度超 H100 20 倍,FLOPS 利用率超 90%

作為世界上首款 transformer ASIC(應用型專用集成電路)芯片,一臺集成了 8 塊 Sohu 的服務器可以匹敵 160 塊 H100 GPU。也即,Sohu 的運行速度是 H100 的 20 多倍。

具體來講,通過專門化,Sohu 具備了前所未有的性能。一臺集成 8 塊 Sohu 芯片的服務器每秒可以處理 50 萬的 Llama 7B tokens。

針對 Llama 3 70B 的 FP8 精度基準測試顯示:無稀疏性、8 倍模型并行、2048 輸入或 128 輸出長度。

此外,對于 Llama、Stable Diffusion 3,Sohu 僅支持 transformer 推理。Sohu 支持了當前谷歌、Meta、微軟、OpenAI、Anthropic 等各家的模型,未來還會適配模型調整。

由于 Sohu 僅能運行一種算法,因此可以刪除絕大多數控制流邏輯,從而允許擁有更多數學塊。也因此,Sohu 實現了 90% 以上的 FLOPS 利用率,而使用 TRT-LLM 的 GPU 約為 30%。

Sohu 為何能輸出更多 FLOPS?

英偉達 H200 支持 989 TFLOPS 的 FP16/BF16 計算能力,并且沒有稀疏性。這是當前最先進的芯片,而 2025 年推出的 GB200 將在計算能力上提升 25%,支持 1250 TFLOPS。

由于 GPU 的絕大部分區域都是可編程的,因此專注于 transformer 會容納更多的計算。這可以從第一性原理中證明:

構建單個 FP16/BF16/FP8 乘加電路需要 10000 個晶體管,這是所有矩陣數學的基石。H100 SXM 擁有 528 個張量核心,每個核心擁有 4× 8 × 16 FMA 電路。乘法告訴我們:H100 有 27 億個晶體管用于張量核心。

但是,H100 卻有 800 億個晶體管。這意味著 H100 GPU 上只有 3.3% 的晶體管用于矩陣乘法。這是英偉達和其他芯片廠商經過深思熟慮的設計決定。如果你想支持所有類型的模型(CNN、LSTM、SSM 等),那么沒有比這更好的了。

而通過僅運行 transformer,Etched 可以讓 Sohu 芯片輸出更多的 FLOPS,且需要降低精度或稀疏性。

內存帶寬也不是瓶頸

實際上,對于像 Llama 3 這樣的模型,情況并非如此。

我們以英偉達和 AMD 的標準基準為例:2048 個輸入 token 和 128 個輸出 token。大多數 AI 產品的 prompt 更長,比如最新的 Claude 聊天機器人在系統 prompt 中擁有 1000+tokens。

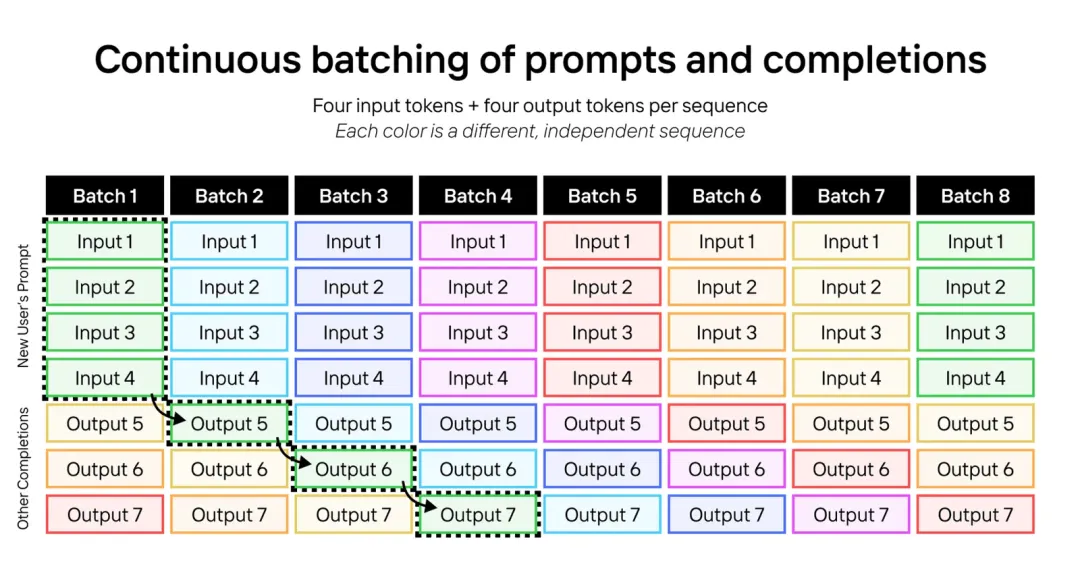

在 Sohu 上,推理是分 batch 運行的。每個 batch 都需要加載所有模型權重一次,并在 batch 的每個 token 中重復使用。通常來說,LLM 輸入是計算密集型的,而 LLM 輸出是內存密集型的。當我們將輸入和輸出 token 與連續 batch 結合時,工作負載變成了高度計算密集型。

以下為 LLM 連續 batching 處理的示例,這里運行具有四個輸入 token 和四個輸出 token 的序列。每種顏色代表不同的序列。

我們可以擴展相同的技巧,從而運行具有 2048 個輸入 token 和 128 個輸出 token 的 Llama 3 70B。每個 batch 中包含用于一個序列的 2048 個輸入 token,以及用于 127 個不同序列的 127 個輸出 token。

如果這樣做了,則每個 batch 需要大約 (2048 + 127)×70B 參數 × 每個參數 2 字節 = 304 TFLOP,而僅需要加載 70B 參數 × 每個參數 2 字節 = 140 GB 的模型權重和大約 127× 64 × 8 × 128 × (2048 + 127) × 2 × 2 = 72GB 的 KV 緩存權重。這比內存帶寬需要的計算量多得多:H200 需要 6.8 PFLOPS 的計算才能最大化其內存帶寬。這還是利用率為 100% 的情況,如果利用率僅為 30%,則需要 3 倍以上的內存。

Sohu 擁有了更多的計算能力且利用率非常高, 因此可以運行巨大的吞吐量,而不會出現內存帶寬瓶頸。

軟件如何工作

在 GPU 和 TPU 上,軟件是一場噩夢。處理任意 CUDA 和 PyTorch 代碼需要極其復雜的編譯器。第三方 AI 芯片(如 AMD、Intel、AWS 等)在軟件上總共花費了數十億美元,但收效甚微。

而 Sohu 只運行 transformer,因此只需要為 transformer 編寫軟件。

大多數運行開源或內部模型的公司都使用特定于 transformer 的推理庫,比如 TensorRT-LLM、vLLM 或 HuggingFace 的 TGI。

這些框架非常僵化,雖然你可以進行模型超參數調優,但實際上不支持更改底層模型代碼。但這沒關系,因為所有 transformer 模型都非常相似(甚至是文本 / 圖像 / 視頻模型),所以超參數調優就是你真正需要的。

雖然 95% 的 AI 公司是這樣,但一些最大的 AI 實驗室采用定制方式。他們有工程師團隊來手動調整 GPU 核心以實現更高的利用率,并進行逆向工程以將寄存器對每個張量核心的延遲將至最低。

Etched 讓我們不需要再進行逆向工程,他們的軟件(從驅動程序、內核到服務堆棧)都將是開源的。如果你想實現自定義 transformer 層,則內核向導可以自由地這樣做。

創業團隊:哈佛輟學生領銜

Etched 的 CEO Gavin Uberti 告訴記者:「如果未來 Transformer 不再是主流,那我們就會滅亡。但如果它繼續存在,我們就會成為有史以來最大的公司。」

打造 Sohu 芯片的 Etched 位于加州庫比蒂諾,公司成立僅兩年,目前團隊只有 35 人,創始人是一對哈佛輟學生 Gavin Uberti(前 OctoML 和前 Xnor.ai 員工)和 Chris Zhu,他們與 Robert Wachen 和前賽普拉斯半導體公司首席技術官 Mark Ross 一起,一直致力于打造專用于 AI 大模型的芯片。

在 Sohu 芯片發布的同時,Etched 也宣布已完成了 1.2 億美元的 A 輪融資,由 Primary Venture Partners 和 Positive Sum Ventures 共同領投。Etched 的總融資額已達到 1.2536 億美元,本輪融資的重要投資者包括 Peter Thiel、GitHub 首席執行官 Thomas Dohmke、Cruise 聯合創始人 Kyle Vogt 和 Quora 聯合創始人 Charlie Cheever。

不過對于占據超過 80% AI 芯片市場份額的英偉達來說,1.2 億美元只相當于它半天的收入。

「我們如此興奮的原因,選擇輟學的原因,以及我們召集團隊,投身芯片項目的原因在于 —— 這是最重要的工作,」Etched 運營主管 Robert Wachen 說道。「整個技術的未來將取決于算力基礎設施能否實現大規模。」

Uberti 聲稱到目前為止,已有匿名客戶預訂了「數千萬美元」的硬件,預計在今年三季度,Sohu 將推向市場。

未來真的如 Uberti 所說,只有在 Sohu 這樣的芯片上,視頻生成、音頻生成、具身智能等技術才能真正落地嗎?