GPT-4頂替大學生參加考試,94%作弊未被揭穿!AI作弊毫無破綻

AI大模型參加考試,已經通過圖靈測試!

調查顯示,94%的AI內容,完全不會被大學老師發現。

而且「AI同學」的成績,83.4%的情況下顯著高于人類學生。

看來,AI真的是要把人類的考試給攻陷了。

其實,早在GPT-4發布時,OpenAI就聲稱,它能在SAT的閱讀和數學考試中分別打敗93%和89%的人類。

雖然數字讓人震驚,但技術報告中并沒有披露這些數據是如何得到的,以及實驗的具體設置如何。這大大削弱了數據的可信度。

之前雖然也有很多關于AI參與考試作弊的研究,但它們大多是在實驗環境中得出數據,與真實情景還是有所差距。

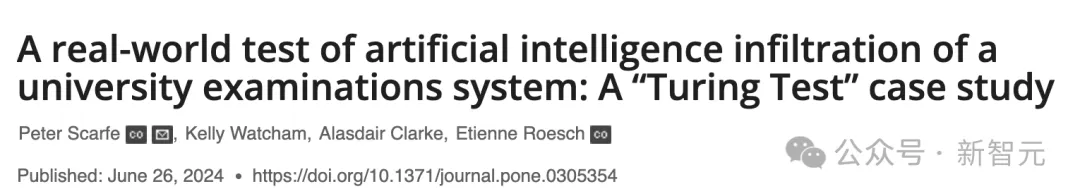

但最近英國的研究人員在現實的大學考試中為AI做的這次「圖靈測試」,已經將實驗過程和數據以論文的形式發布了出來。

https://journals.plos.org/plosone/article?id=10.1371/journal.pone.0305354

結果發現,雖然我們每天抱怨AI生成的文本「一眼假」,但實際上大學老師也很容易被它蒙混過去,有94%的AI生成內容——完全沒有被發現!

此外,AI內容的平均水平也顯著高于人類同學,差距大概是半個等級。在83.4%的情況下,AI的成績高于隨機選擇的學生。

這就讓人類真實的顫抖了……

這也就意味著,AI的「以假亂真」程度再次被證實,在能力上不僅可以替代掉打工人,還在認知任務上完全碾壓了大學生。

那么論文到底是如何描述這次「碾壓」的?我們先來看看具體過程。

「偽裝」過程

描述這種在真實世界中進行的「圖靈測試」,畫面感強到像是真人秀現場。

團隊選中了英國雷丁大學的心理學和臨床語言科學學院,但完全沒有告知考試評分員。除了參與批準研究的人和負責幫助AI偽裝成學生的行政人員,沒有人知道這項正在開展的研究。

在COVID之后,像很多英國大學一樣,雷丁大學也更多地轉向線上考試。學生在規定時間中完成題目或論文,而且是完全的開卷模式,參考課程材料、論文、書籍、互聯網材料都是被允許的。

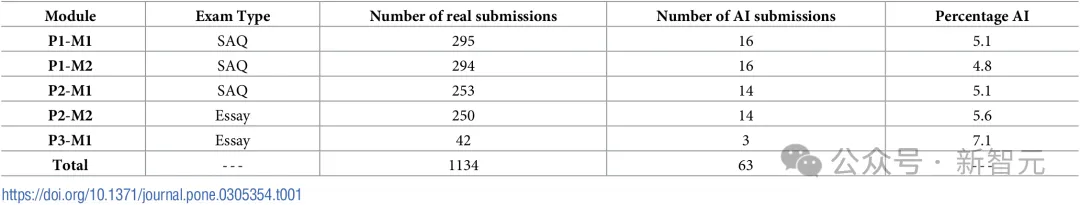

這項考試共有兩種題型,一是簡答題(SAQ),2.5小時內完成,從6個問題中任選4題回答,答案不超過200詞;二是論文題(Essay),從3~4個題目中任選其一,在8小時內完成一篇1500詞的論文。

每個考試模塊中都混入了約占總數5%的AI生成內容。這個比例不會造成額外的評分負擔,也讓兩位作者能夠在規定時間內確保提交的AI內容沒有出現自相似情況,否則會很容易被判定為抄襲。

實驗中的5個部分,P表示考試的學生年級,M表示考試內容模塊

作者使用標準化的提示詞讓GPT-4生成每種類型考試的答案。對于簡答題(SAQ),提示詞是:

包括對學術文獻的引用,但不需要單獨的參考文獻部分,請用160詞回答以下問題:XXX

對于論文題,提示詞是:

包括對學術文獻的引用,但不需要單獨的參考文獻部分,請寫一篇2000詞的文章回答以下問題:XXX

在與GPT-4打交道時,作者發現模型經常不遵循提示中關于字數的要求。簡答題總超字數,論文又寫不到規定長度,因此調整了提示詞中的字數。

為了保證AI的「真實性」,GPT-4生成的內容被100%原汁原味地搬運到試卷上,作者沒有添加過渡文字或用任何方式修改文本內容,最大的改動就是為論文添加必要格式,或者刪去模型徑自生成的免責聲明和參考文獻。

總而言之,原則是保證100%的AI書面答案,但要在其他地方「藏好尾巴」,防止評分人員看出破綻。

如何評分

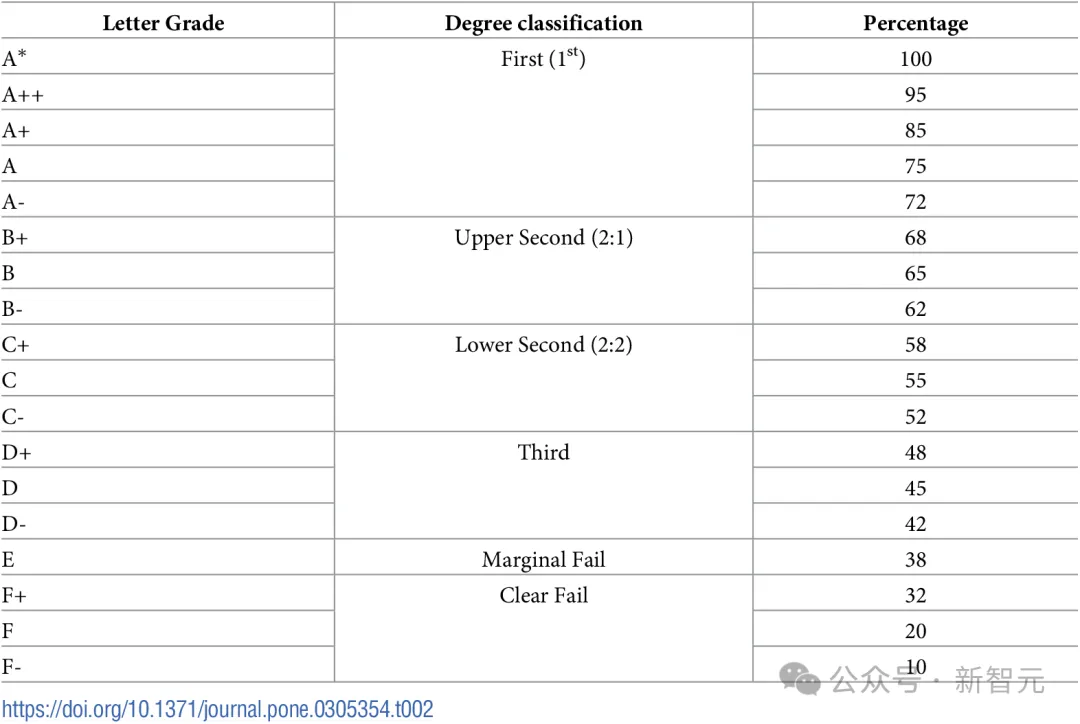

考試按照表2中的分級規則進行評分。雷丁大學評估考試分數的流程比較復雜,涉及多個步驟和評分角色。

首先,由一名評分員對提交內容進行打分,標準是看學生在多大程度上達到了評估目標。

之后,分數會呈遞給一位獨立審核員,他負責考量所有提交內容的整體水平,并隨機選取、閱讀一部分作業,同時也要過目那些第一名評分員標記為不及格或潛在學術不端的作業。

此時,審核員的角色不是對作業進行二次評分,而是審查評分的質量、一致性和適當性。

有些模塊需要多個評分員共同打分。在這部分工作開始前,評分團隊會進行一次「校準會議」,通過對少量作業進行評分以及比較、討論,評分員們需要對于如何應用評分標準達成一致。

此時,審核員依舊要發揮作用,對同一內容中不同評分員給分的一致性進行檢查。

這項研究進行于2023年夏季,當時ChatGPT已經發布,評分員們有什么檢測AI作弊的方法嗎?

當時,還沒有自動檢測工具,評分員們只能依靠自己的直覺和經驗,比如1)檢查答案是否「好得難以置信」,寫作風格、內容水平有沒有完全超出了對本科生能力的預期,2)答案的主要內容是否為課上未教授內容,3)引用的參考文獻與內容本身無關。

這些經驗聽起來相當靠譜,甚至是比較好地捕捉到了AI生成文本的特征。但結果發現,人類的直覺終究是靠不住的。

實驗結果

多少被發現了?

在這項研究中,只要評分員將作業標記為「值得關注」,可能存在某種形式的不良學術行為或學術不端,都不需要特別提到AI,就算是被檢測到了。

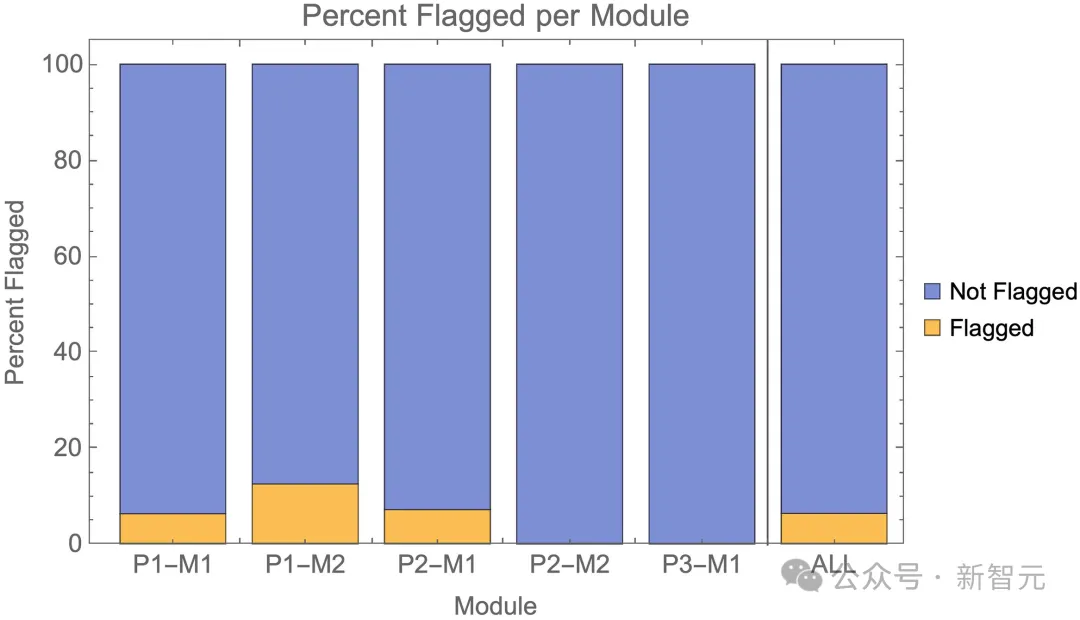

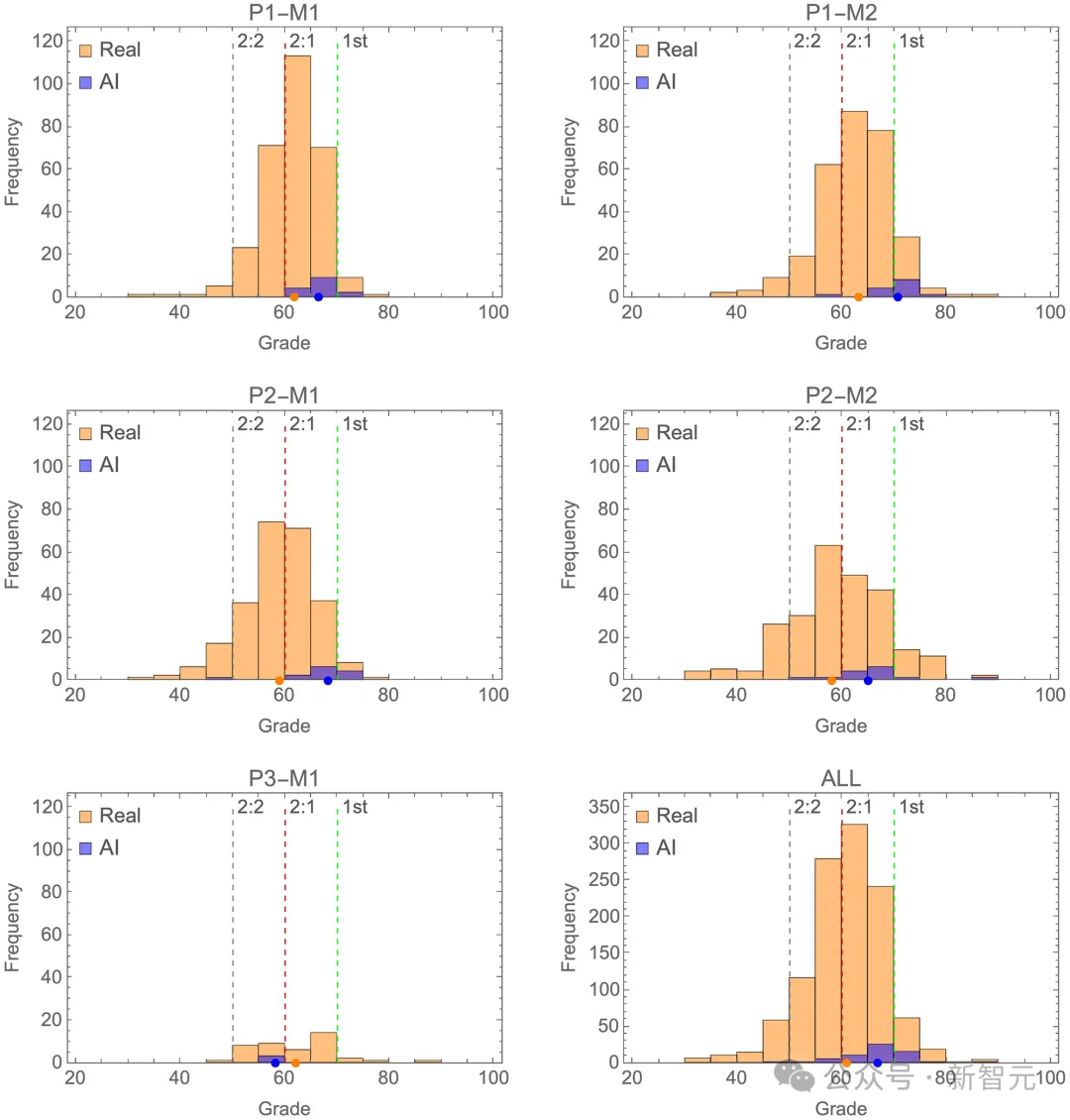

即使規則如此寬松,檢測成功的百分比依舊少得可憐。如圖1和表3所示,在P2-M2和P3-M1的兩個論文題目中,檢測準確率甚至為零。也就是說,作者分別混入的14篇和3篇AI文章完全沒有引起評分員的警覺。

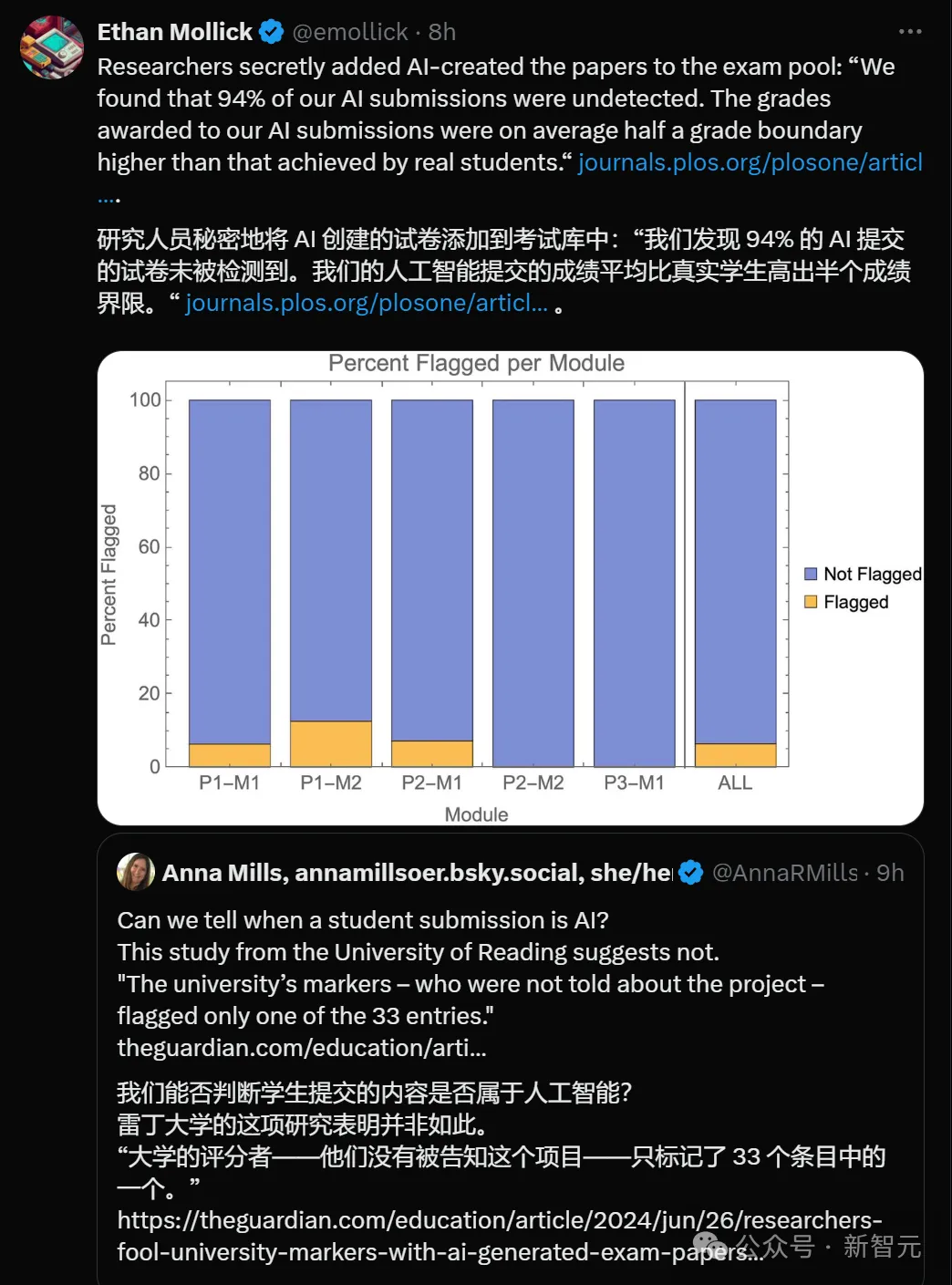

圖1:各模塊中以及總體中,被標記為AI的百分比

表3:AI答案的檢測統計數據

總體來看,AI提交的作業幾乎無法檢測,有94%的作業未被發現。

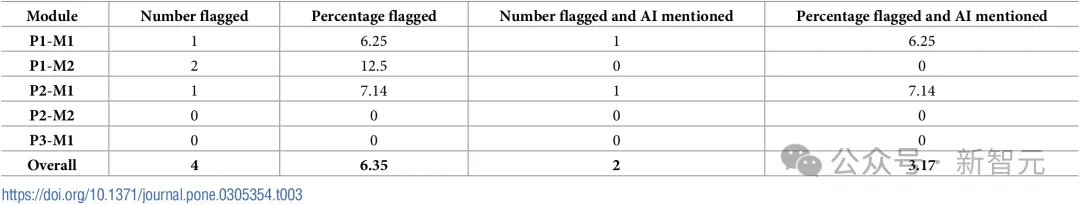

如果我們采用更嚴格的「檢測」標準,要求標記時必須特別提到AI,那么97%的AI提交作業未被發現。

圖2:各模塊和總體中,被標記為AI的百分比

成績如何?

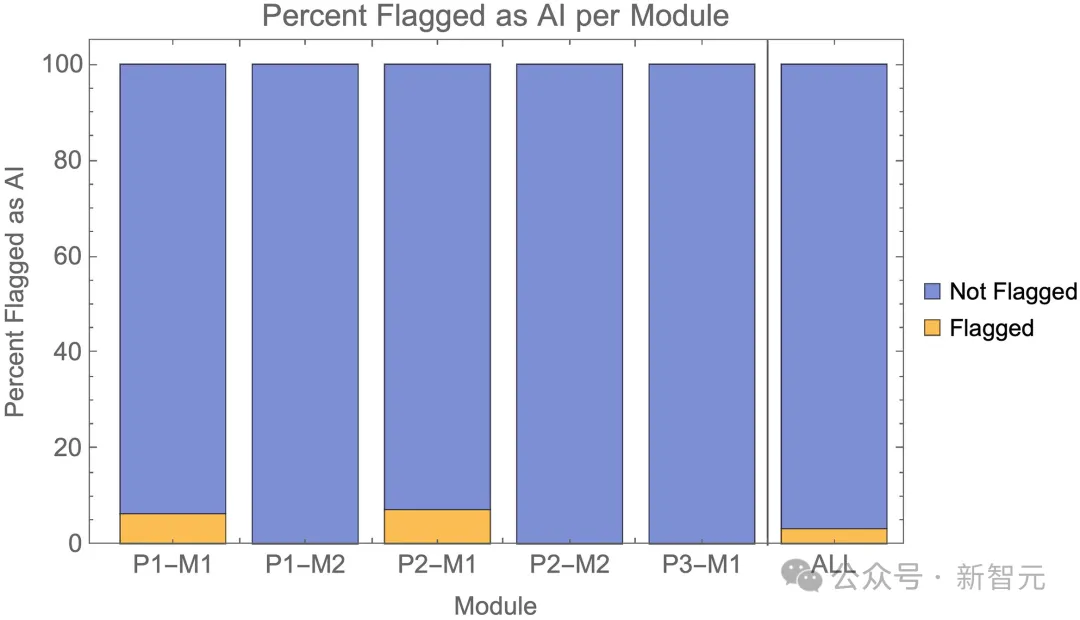

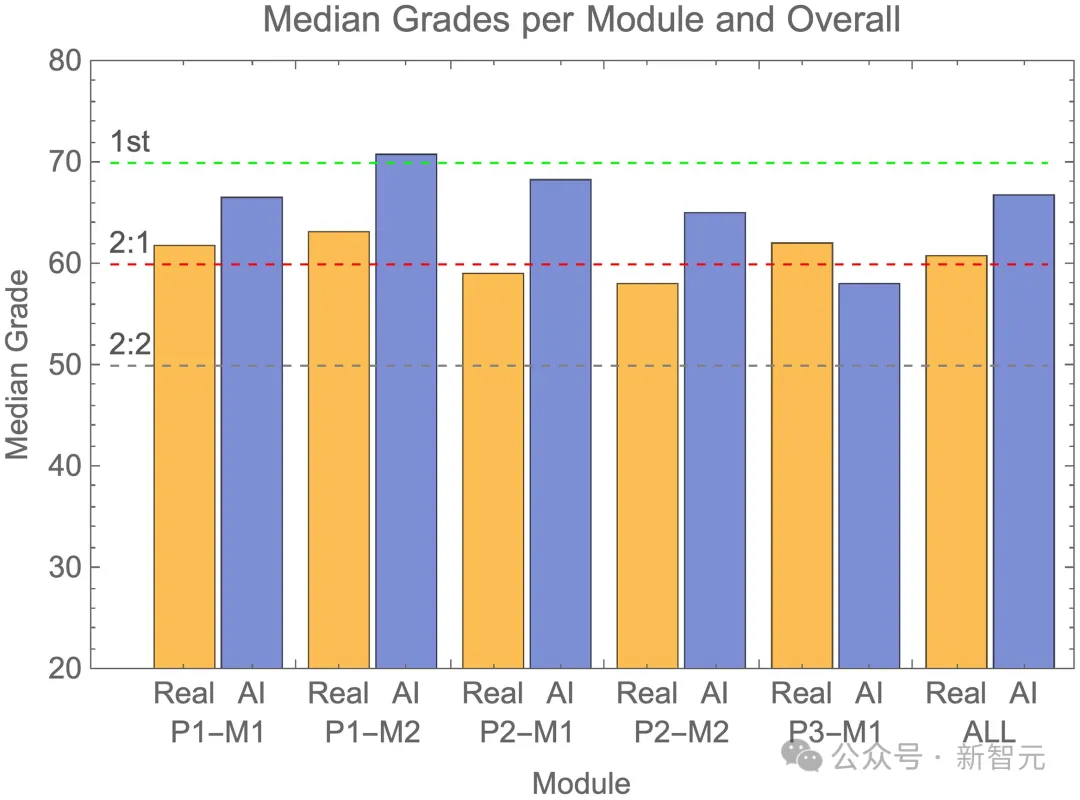

將被檢測出來的AI內容剔除后,作者比較了GPT-4和人類學生的分數分布情況。圖3中,橙色表示人類學生,藍色表示GPT-4。

可以看到,藍色部分相比橙色部分整體右移,說明AI的成績往往集中在真實成績分布的高端,中位數對應First或者Upper Second等級。

其中P3-M1模塊是一個例外,AI的成績集中在真實分數分布的低端。但考慮到這個模塊只混入了4篇AI內容,遠少于其他模塊,因此可能是數據過少造成的偏誤。

圖3:各模塊真實(橙色)和AI(藍色)的成績頻率直方圖,以及所有模塊的總成績頻率直方圖

單獨比較中位數則更能體現AI的優勢,如圖4所示,除了P3-M1模塊略有落后,GPT-4的得分中位數完全超過了人類學生。

圖4:各模塊真實(橙色)和AI(藍色)的成績中位數,以及所有模塊的總成績中位數

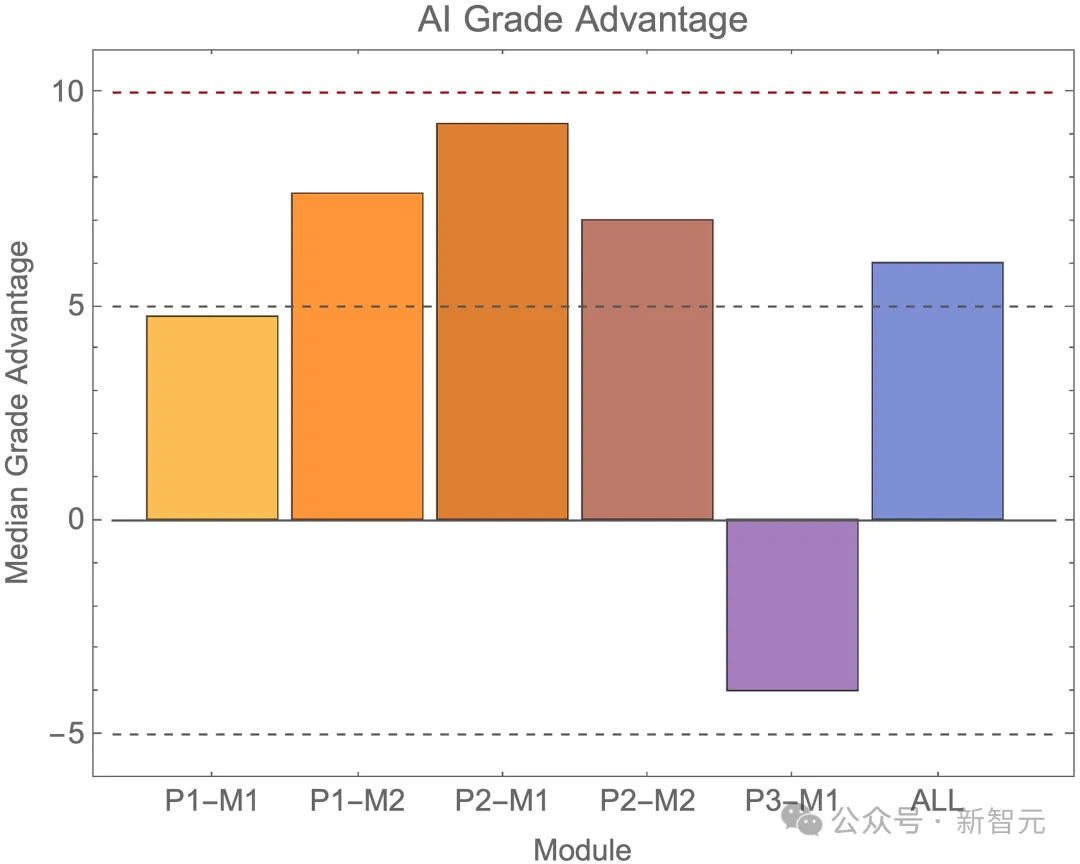

平均來看,AI提交作業的成績比真實學生高出半個等級以上,但在不同模塊中有所不同(見圖5)。

在P1-M2模塊,AI整體上獲得了1級成績,差距接近一個完整的等級。

圖5:各模塊和總體中,AI提交的成績相對于真實學生提交的成績的優勢

AI拿高分的概率有多大?

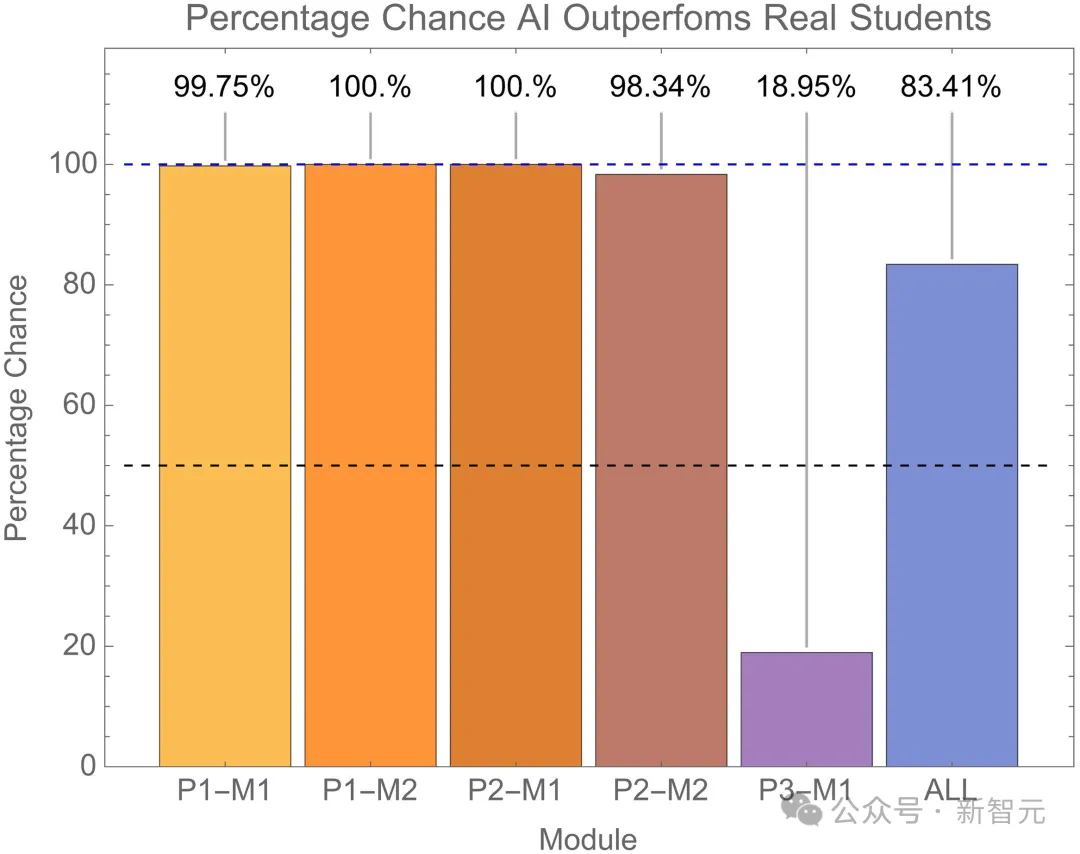

論文提出通過以下方法了解AI超越真實學生的可能性。對于每個模塊的nm個AI提交作業,計算出在同一模塊中,隨機抽取nm個真實學生提交作業被AI提交作業超越的可能性,這里的「超越」依舊用中位數衡量。

具體過程如下:(1)隨機選擇nm個真實學生提交作業,(2)計算這些作業的中位成績,(3)查看nm個AI提交作業的中位成績是否高于這些成績,(4)進行重復抽樣,即所有真實學生提交作業在每次抽樣中都保留在選擇池中,并進行了10萬次重抽樣過程。

如圖6所示,除P3-M1模塊外,幾乎所有模塊中,隨機選取的nm個真實學生提交作業被相同數量的AI作業超越的概率接近100%。例外的是P3-M1模塊,其中AI提交作業在19%的情況下優于真實學生。

總體來看,各模塊中隨機選取的nm個真實學生提交作業AI超越的概率為83.4%。

圖6:隨機選擇nm份真實學生的成績,中位數低于AI成績的概率

這一結果可以反映出,AI提交作業能非常穩定地獲得比真實學生更高的成績。從成績直方圖(圖3)可以明顯看出,AI提交作業的成績往往集中在真實學生成績分布的高端。

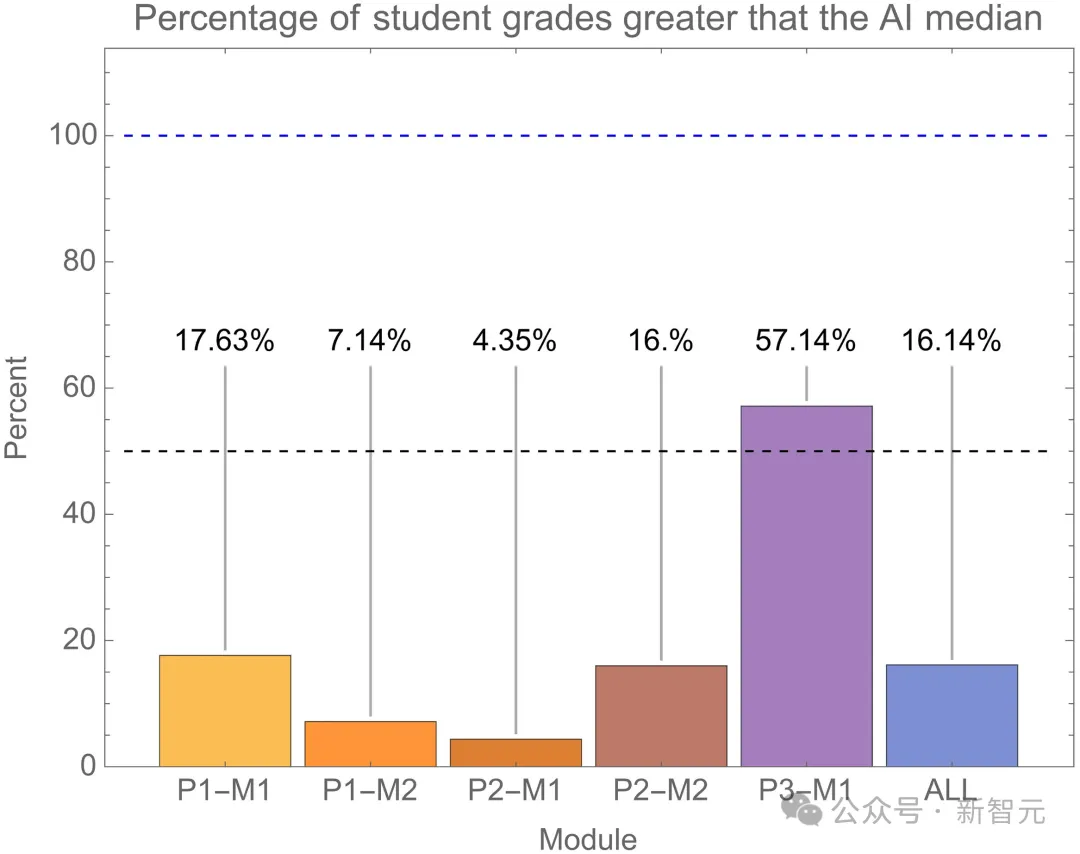

實際上,我們可以簡單地計算每個模塊(以及總體)中,有多少學生提交作業的成績超過了AI的中位數成績,如圖7所示。

正如預期的那樣,也與圖6中的重抽樣結果一致。總體來看,只有16%的學生提交作業成績超過了AI在同一模塊的中位數成績。

圖7:學生成績高于AI的成績中位數的百分比

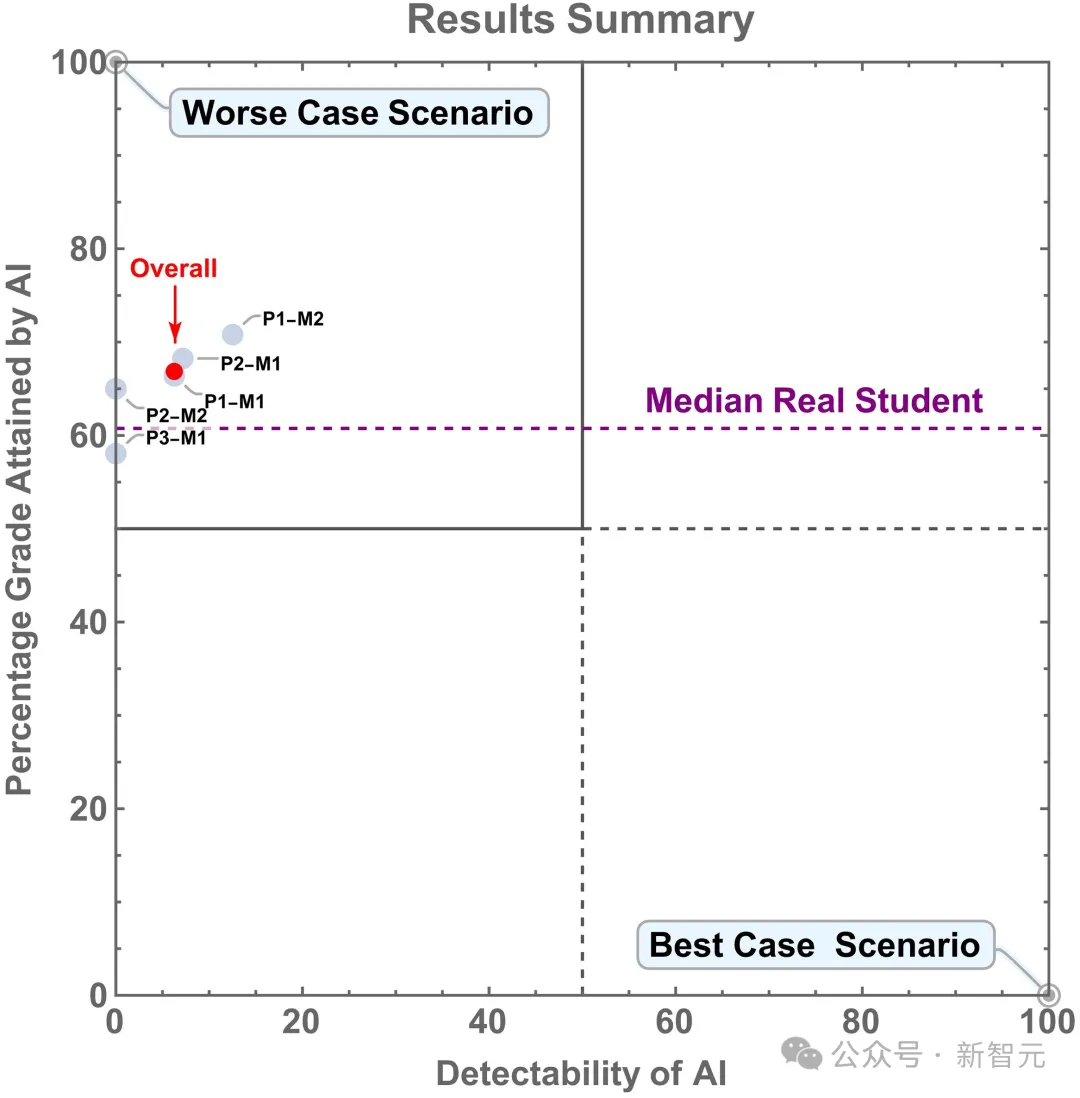

成績和可檢測性的可視化

通過在二維空間中繪制數據,就可以全面了解AI獲得的成績,及其可檢驗性。

在下圖中,x軸表示AI提交作業的可檢測性,y軸表示AI提交作業的中位成績。

研究者希望,數據可以位于某些特定區域。

其中,「最佳情況」是數據位于右下角,此時AI的可檢測性為100%,但成績為0%。

但從學術誠信的角度來看,另一種理想情況就是數據位于右上角。

這也就意味著——學生使用AI作弊,并且獲得了100%的成績,但我們能100%地檢測到他們作弊了。

不理想的情況,就是數據位于左下角了,此時我們無法檢測到AI的使用,但它的成績為0%。

因此,使用AI作弊的學生可能會發現,自己做作業能獲得更高的成績,從而不再作弊。

最糟糕的情況是數據位于左上角,此時我們根本無法檢測到AI的使用,但它卻獲得了100%的成績。

顯然,這是我們最不愿意看到的事。

圖8:AI的可探測性及其達到的等級匯總

結論與討論

在這次測試中,研究人員對GPT-4生成的文本內容沒有進行任何修改。但現實世界的更可能的情況是,學生會對生成內容進行潤色和調整,這會使學術不端行為更難被發現。

總體而言,這個結果是令人擔憂的。GPT-4的能力讓學生們可以在利用AI作弊的情況下很難被發現,而且有極高的概率能取得更好的成績。

GPT-4在模塊P3-M1的表現明顯落后,這有兩種可能的解釋,一是數據不足導致的偏誤,二是由于P3-M1的考試內容涉及更為抽象的邏輯推理,這也恰好是AI仍不擅長的領域。

從另一個角度來看,這也啟發我們思考,應該如何看待,甚至是改革大學教育的目標與內容。

去年Nature的一篇論文就發現,AI在完成大學課程作業時,已經體現出信息搜索、集成以及批判性分析的能力,這可以完美構成大學培養目標的一部分。

https://www.nature.com/articles/s41598-023-38964-3

在評論區,有推特網友質疑,這項研究怕不會也是AI進行的吧?

對此,作者鄭重承諾:研究內容絕對是人類進行的。