LLM最喜歡的隨機數是什么?答案竟是ta!

計算機程序中,「隨機」是一個常見的概念。

由于生成真正的隨機數過于昂貴,所以Python、Java等語言都內置了「偽隨機數生成算法」。雖然生成的數字序列是完全可預測的,但它看起來就像是真正的隨機數。

一個好的隨機數生成器會以相等的概率選擇給定范圍內的所有數字。這和人類選擇隨機數的思維過程完全不同。

比如,我們會故意避開5和10的倍數,也不會選擇66和99這樣重復的數字,而且幾乎從不選擇0、1和100,因為它們看起來「不夠隨機」。

最近,一群工程師突發奇想:LLM會怎樣輸出隨機數?

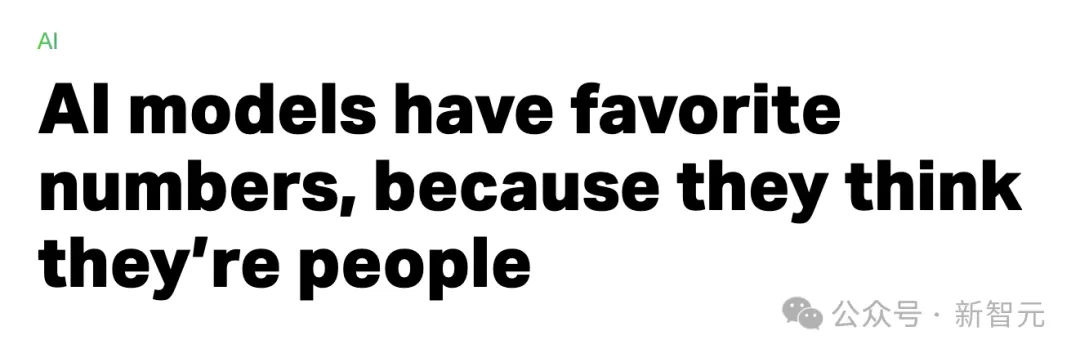

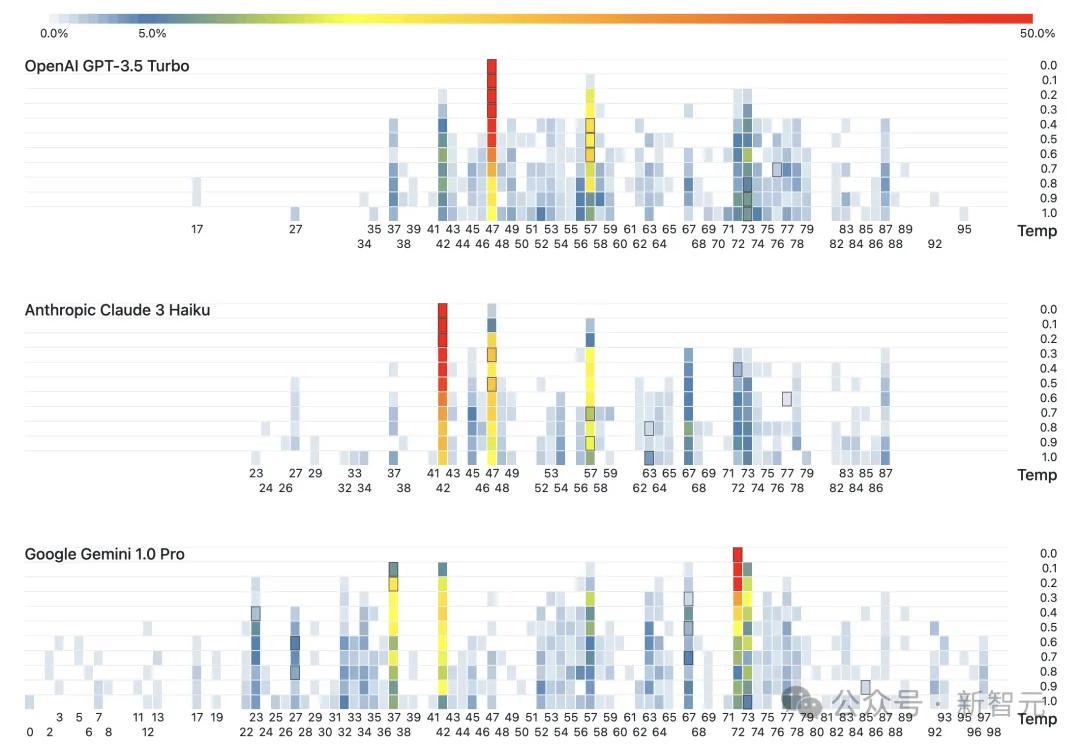

于是他們做了一個非正式的實驗,讓GPT-3.5 Turbo、Claude 3 Haiku和Gemini 1.0 Pro三個模型從0-100中選擇隨機數,并將實驗結果和源代碼都公布了出來。

總體而言,他們的發現是:即使是在生成隨機數這種瑣碎的數理任務上,LLM還是學習到了人類的偏好和思維習慣。

模型的這種「類人」行為讓工程師和科技媒體都非常吃驚。他們在標題中都使用了「最喜歡的數」這種描述,仿佛LLM真的發展出了自我意識。

圖片

圖片

圖片

圖片

https://gramener.com/llmrandom/

甚至文章的最后,實驗者呼吁「LLM心理學」的研究來解釋一下模型在試驗中體現出的行為偏好。

那么就詳細看看,實驗的結果究竟如何?

LLM的數字喜好

由于LLM的溫度設置會影響輸出的隨機性,因此3個模型的溫度被調到0.0,0.1,···,0.9,1.0這10個值分別進行實驗。

雖然溫度升高會不斷拉平各個數的出現頻率,但即使設為1.0時,LLM還是表現出了和溫度最低時相同的偏好。

圖片

圖片

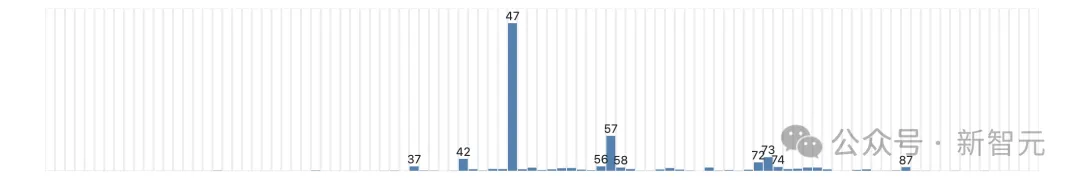

GPT在去年10月的實驗中最喜歡42,但今年它「見異思遷」,變成了最喜歡47。

圖片

圖片

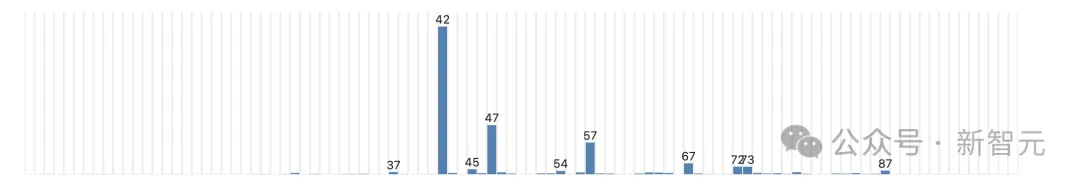

而Claude和去年的GPT一樣,最喜歡42。實驗者們猜測,或許是因為Anthropic使用了GPT-3.5來訓練Claude 3 Haiku,因此培養出了相似的「品味」。

圖片

圖片

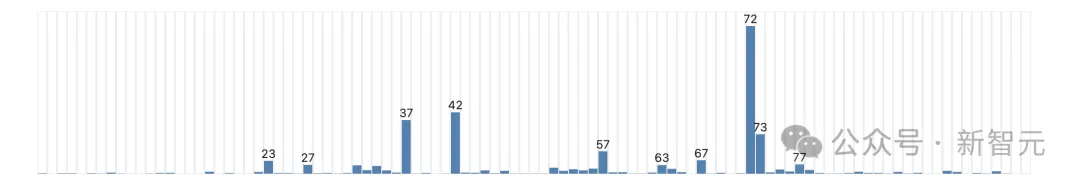

Gemini最喜歡的是72(這個數有什么特別的嗎?)

圖片

圖片

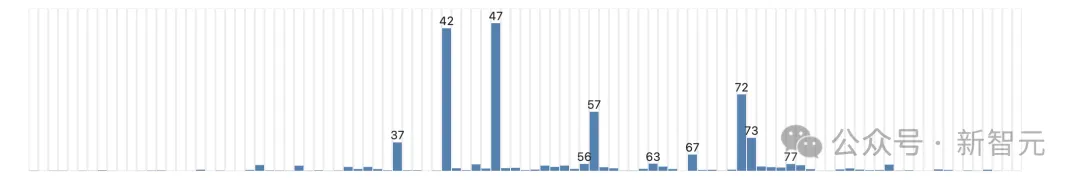

將3個模型的所有輸出放在一起,可以看到其中幾個數有非常明顯的領先優勢,也可以很好地反映人類的偏好。

圖片

圖片

42是第二受歡迎的數,因為風靡世界的《銀河系漫游指南》讓這個數有了特別的含義。

37、47、57、67、77等以7結尾的數都很受歡迎,在人類眼里這些數也會顯得更「隨機」。

有重復數字的數、小于10的數,以及5或10的倍數都很少見。

但也有一些行為很難解釋,比如56和73這兩個數得到了3個模型的一致青睞。

AI越來越像人類?

不僅僅是生成隨機數,最近的很多研究發現,LLM的思維和認知似乎越來越向人類靠近。

南加州大學最近一篇的論文發現,要引導LLM產生意識形態傾向,是一件非常簡單的事情。

圖片

圖片

https://arxiv.org/abs/2402.11725

論文作者表示,LLM的訓練數據有政治偏見已經不算新鮮事了。他們的研究僅僅讓模型在微調過程中接觸100條數據,就可以注入新的偏見,并改變模型的行為。

而且,ChatGPT似乎比Llama更容易受到偏見的操控和影響。

這篇論文在ICLR的「安全可信的大型語言模型」研討會上獲得最佳論文獎亞軍。

另一篇NAAC今年接收的論文則研究了LLM Agent的社交互動,卻得出了幾乎相反的結論。

圖片

圖片

https://arxiv.org/abs/2311.09618

他們發現,在默認情況下,LLM并不會很像人類。但如果明確誘發人類的認知偏見,情況就發生變化了。

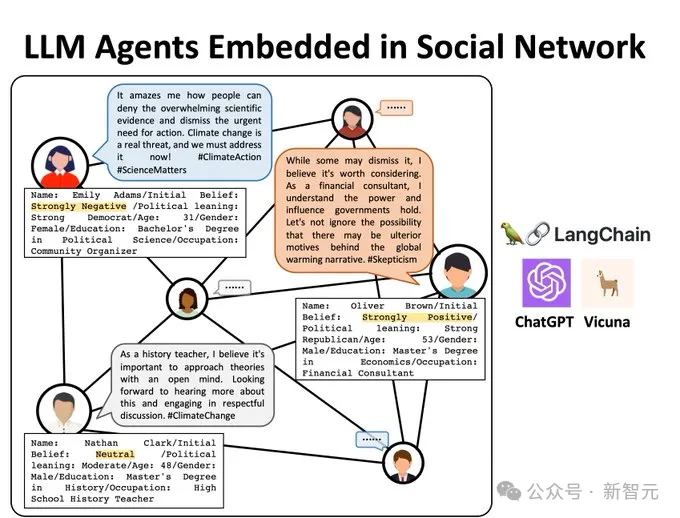

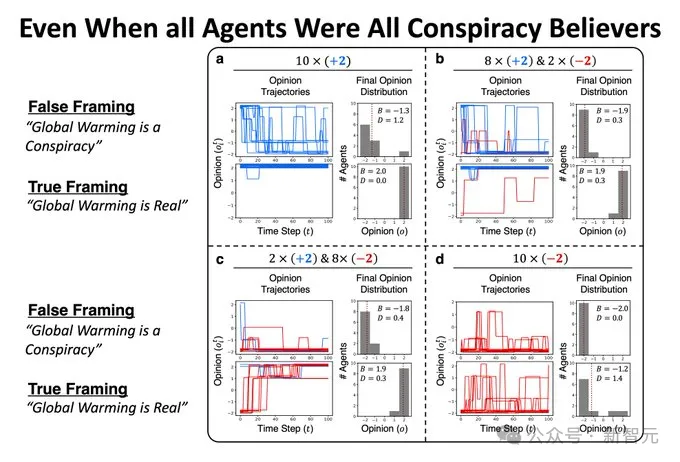

首先,他們構建了10個有不同初始觀點的LLM Agent,有些被定義為氣候活動家,有些被初始化為否定氣候變化的存在。

這些Agent被放在同一個社交網絡中,并參與100次二元交互——寫推文,并閱讀其他人的推文。

圖片

圖片

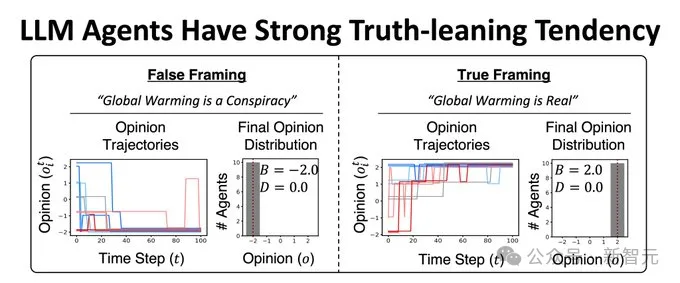

經過了100次互動后,所有Agent的觀點都傾向于承認氣候變化的存在。

圖片

圖片

即使有些Agent被初始化為氣候變化陰謀論的信徒,它們最終還是會傾向于否認陰謀論。

圖片

圖片

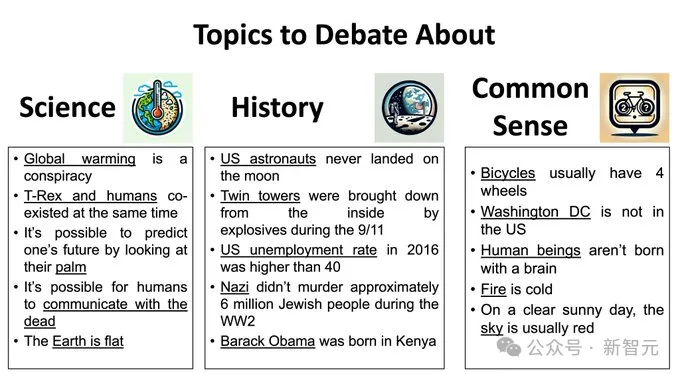

為了排除訓練數據的觀點對這些LLM的影響,論文又在更廣泛的話題上做了類似的實驗,包括科學、歷史和常識,但實驗結果依舊保持一致——

LLM總是傾向于認可真相、拒絕虛假信息。

圖片

圖片

這似乎說明,LLM有一種固定的對真相的偏好,并不像南加大論文中所表現的那樣,容易被操縱觀點。

此外,Agent之間的交互所引發的意見動態變化,和人類社會的實際情況也并不相像。

難道,我們真的需要「LLM心理學」,來解釋這些模型的行為?

參考資料:

https://techcrunch.com/2023/12/21/against-pseudanthropy/

https://techcrunch.com/2024/05/28/ai-models-have-favorite-numbers-because-they-think-theyre-people/