等不來OpenAI的Q*,華為諾亞探索LLM推理的秘密武器MindStar先來了

本論文作者來自華為蒙特利爾諾亞方舟實驗室的康計堃,李信擇,陳熙, Amirreza Kazemi,陳博興。

人工智能(AI)在過去十年里取得了長足進步,特別是在自然語言處理和計算機視覺領域。然而,如何提升 AI 的認知能力和推理能力,仍然是一個巨大的挑戰。

近期,一篇題為《MindStar: Enhancing Math Reasoning in Pre-trained LLMs at Inference Time》的論文提出了基于樹搜索的推理時間能力提升方法 MindStar [1],該方法在開源模型 Llama-13-B 與 Mistral-7B 上達到了近似閉源大模型 GPT-3.5 與 Grok-1 在數學問題上的推理能力。

- 論文標題:MindStar: Enhancing Math Reasoning in Pre-trained LLMs at Inference Time

- 論文地址:https://arxiv.org/abs/2405.16265v2

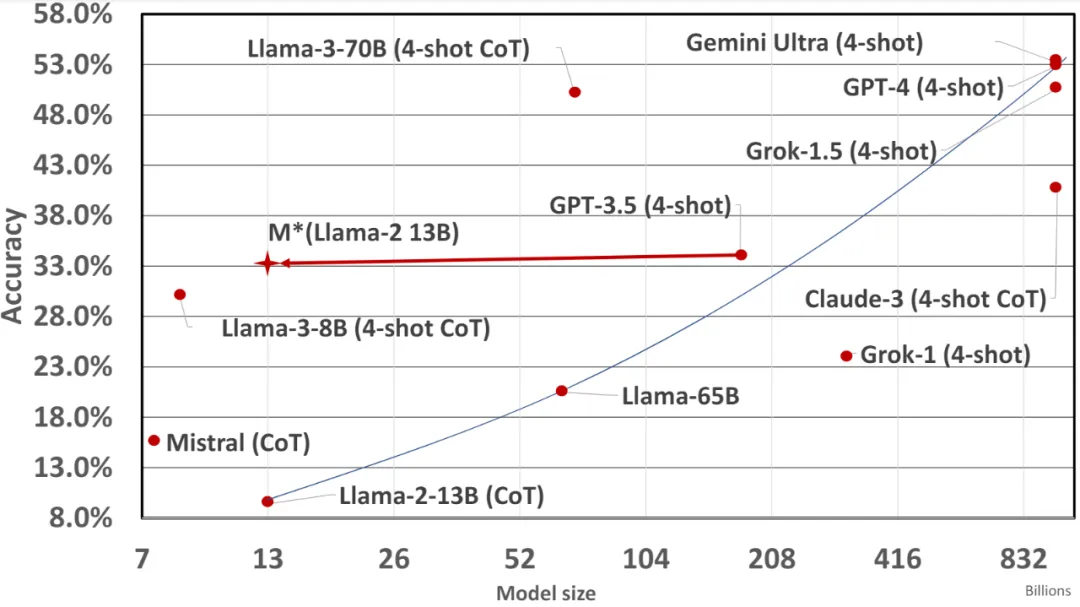

MindStar 在數學問題上的應用效果:

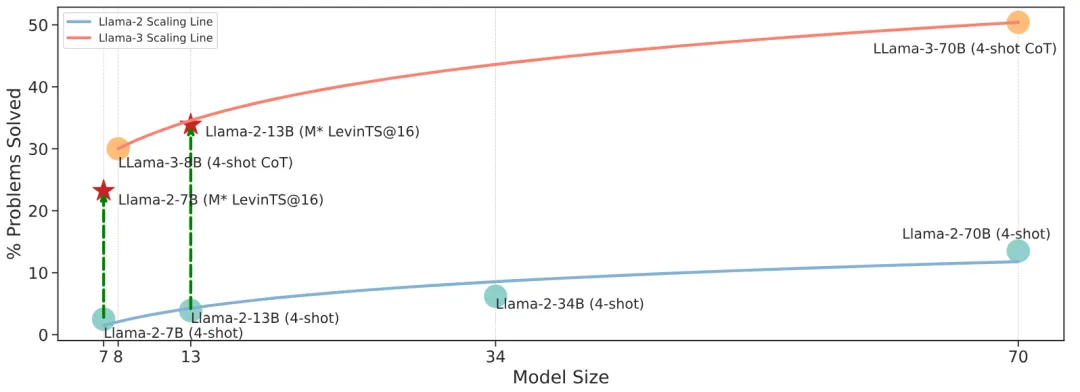

圖 1 :不同大型語言模型的數學準確率。LLaMA-2-13B 在數學性能上與 GPT-3.5 (4-shot) 類似,但節省了大約 200 倍的計算資源。

1. 引言

隨著模型規模的快速增長,基于 Transformer 的大型語言模型(LLMs)在指令遵循 [1,2]、編碼輔助 [3,4] 和創意寫作 [5] 等領域展示了令人印象深刻的成果。然而,解鎖 LLMs 解決復雜推理任務的能力仍然是一大挑戰。最近的一些研究 [6,7] 嘗試通過監督微調(Supervised Fine-Tuning, SFT)來解決,通過將新的推理數據樣本與原始數據集混合,使 LLMs 學習這些樣本的底層分布,并嘗試模仿所學邏輯來解決未見過的推理任務。盡管這種方法有性能提升,但它嚴重依賴于大量的訓練和額外的數據準備 [8,9]。

Llama-3 報告 [10] 強調了一個重要的觀察:當面對一個具有挑戰性的推理問題時,模型有時會生成正確的推理軌跡。這表明模型知道如何產生正確答案,但在選擇上存在困難。基于這一發現,我們提出了一個簡單的問題:我們能否通過幫助 LLMs 選擇正確的輸出來增強它們的推理能力?為探索這一點,我們進行了一項實驗,利用不同的獎勵模型進行 LLMs 輸出選擇。實驗結果表明,步驟級選擇顯著優于傳統的 CoT 方法。

2. MindStar 方法

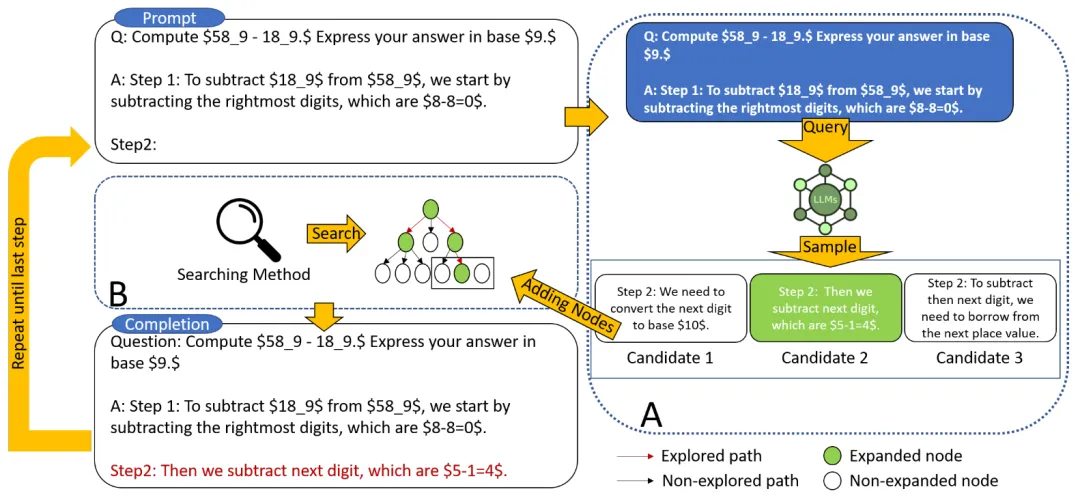

圖 2 MindStar 的算法架構圖

我們引入了一種新的推理搜索框架 ——MindStar(M*),通過將推理任務視為搜索問題,并利用過程監督的獎勵模型(Process-supervised Reward Model, PRM),M * 在推理樹空間中有效導航,識別近似最優路徑。結合束搜索(Beam Search, BS)和 Levin 樹搜索(Levin Tree Search, LevinTS)的思想,進一步增強了搜索效率,并保證在有限計算復雜度內找到最佳推理路徑。

2.1 過程監督獎勵模型

過程監督獎勵模型 (PRM) 的設計目的是評估大語言模型 (LLM) 生成的中間步驟,以幫助選擇正確的推理路徑。這種方法借鑒了其他應用中 PRM 的成功經驗。具體而言,PRM 以當前推理路徑 和潛在的下一步

和潛在的下一步 作為輸入,并返回獎勵值

作為輸入,并返回獎勵值 。

。

PRM 通過考慮整個當前推理軌跡來評估新步驟,鼓勵與整體路徑的一致性和忠實性。高獎勵值表明,新的步驟 )對于給定的推理路徑

)對于給定的推理路徑 可能是正確的,從而使擴展路徑值得進一步探索。相反,低獎勵值則表示新步驟可能不正確,這意味著遵循此路徑的解決方案也可能不正確。

可能是正確的,從而使擴展路徑值得進一步探索。相反,低獎勵值則表示新步驟可能不正確,這意味著遵循此路徑的解決方案也可能不正確。

M* 算法包含兩個主要步驟,迭代直到找到正確的解決方案:

1. 推理路徑擴展:在每次迭代中,基礎 LLM 生成當前推理路徑的下一步。

2. 評估和選擇:使用 PRM 評估生成的步驟,并根據這些評估選擇下一次迭代的推理路徑。

2.2 推理路徑擴展

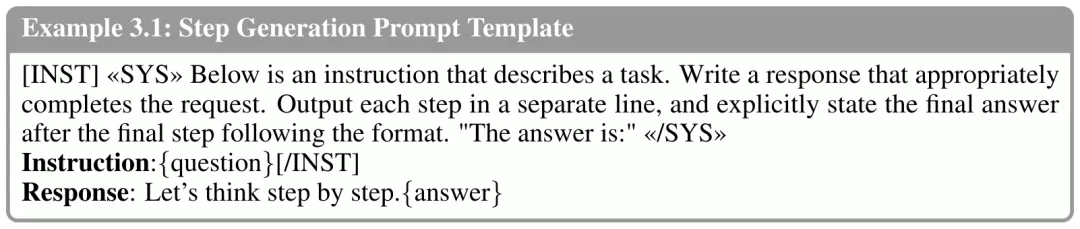

在選擇要擴展的推理路徑 后,我們設計了一個提示模板(Example 3.1),以從 LLM 中收集下一步。正如示例所示,LLM 將原始問題作為 {question},將當前推理路徑作為 {answer}。注意,在算法的第一次迭代中,所選擇的節點是僅包含問題的根節點,因此 {answer} 為空。對于推理路徑

后,我們設計了一個提示模板(Example 3.1),以從 LLM 中收集下一步。正如示例所示,LLM 將原始問題作為 {question},將當前推理路徑作為 {answer}。注意,在算法的第一次迭代中,所選擇的節點是僅包含問題的根節點,因此 {answer} 為空。對于推理路徑 ,LLM 生成 N 個中間步驟,并將它們作為當前節點的子節點附加。在算法的下一步中,將評估這些新生成的子節點,并選擇一個新的節點進行進一步擴展。我們還意識到,生成步驟的另一種方法是使用步驟標記對 LLM 進行微調。然而,這可能會降低 LLM 的推理能力,更重要的是,這與本文的重點 —— 在不修改權重的情況下增強 LLM 推理能力相悖。

,LLM 生成 N 個中間步驟,并將它們作為當前節點的子節點附加。在算法的下一步中,將評估這些新生成的子節點,并選擇一個新的節點進行進一步擴展。我們還意識到,生成步驟的另一種方法是使用步驟標記對 LLM 進行微調。然而,這可能會降低 LLM 的推理能力,更重要的是,這與本文的重點 —— 在不修改權重的情況下增強 LLM 推理能力相悖。

2.3 推理路徑選擇

在擴展推理樹后,我們使用預訓練的過程監督獎勵模型(PRM)來評估每個新生成的步驟。正如前面提到的,PRM 采用路徑和步驟 ,并返回相應的獎勵值。在評估之后,我們需要一種樹搜索算法來選擇下一個要擴展的節點。我們的框架不依賴于特定的搜索算法,在這項工作中,我們實例化了兩種最佳優先搜索方法,即 Beam Search 和 Levin Tree Search。

3. 結果與討論

在 GSM8K 和 MATH 數據集上的廣泛評估顯示,M * 顯著提升了開源模型(如 LLaMA-2)的推理能力,其表現可與更大規模的閉源模型(如 GPT-3.5 和 Grok-1)媲美,同時大幅減少了模型規模和計算成本。這些發現突顯了將計算資源從微調轉移到推理時間搜索的潛力,為未來高效推理增強技術的研究開辟了新途徑。

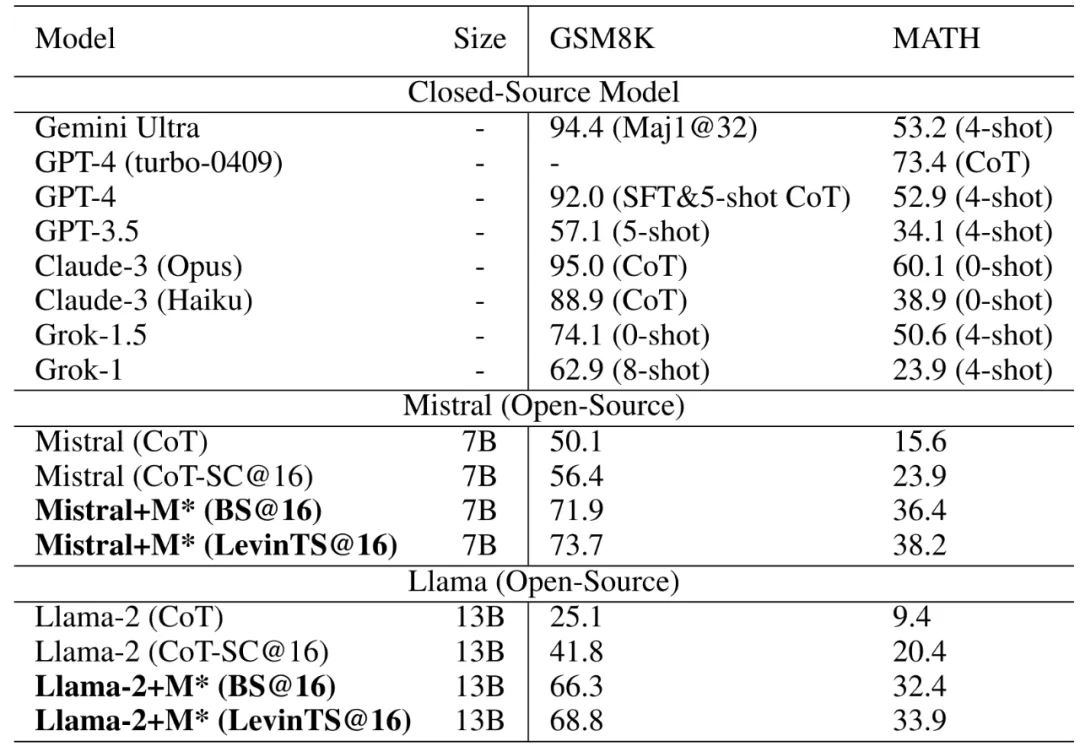

表 1 展示了各種方案在 GSM8K 和 MATH 推理基準上的對比結果。每個條目的數字表示問題解決的百分比。符號 SC@32 表示在 32 個候選結果中的自一致性,而 n-shot 表示少樣本例子的結果。CoT-SC@16 指的是在 16 個思維鏈(CoT)候選結果中的自一致性。BS@16 代表束搜索方法,即在每個步驟級別涉及 16 個候選結果,而 LevinTS@16 詳細說明了使用相同數量候選結果的 Levin 樹搜索方法。值得注意的是,MATH 數據集上 GPT-4 的最新結果為 GPT-4-turbo-0409,我們特別強調這一點,因為它代表了 GPT-4 家族中的最佳性能。

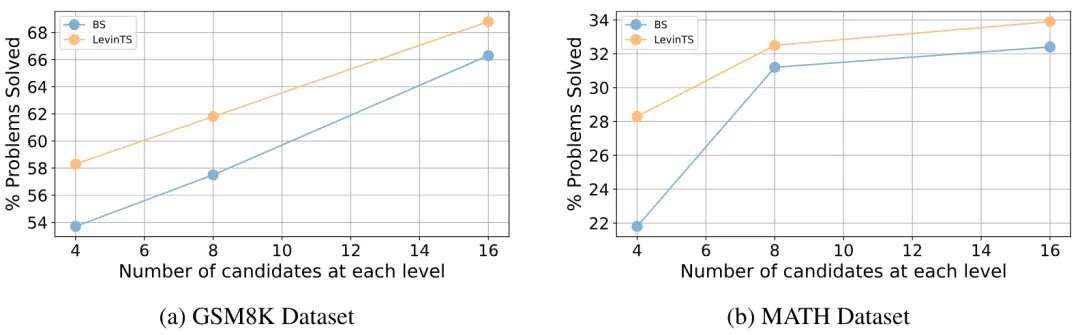

圖 3 我們研究了 M * 性能如何隨著步驟級別候選數量的變化而變化。我們選擇 Llama-2-13B 作為基礎模型,并分別選擇束搜索(BS)作為搜索算法。

圖 4 Llama-2 和 Llama-3 模型家族在 MATH 數據集上的尺度定律。所有結果均來自它們的原始資源。我們使用 Scipy 工具和對數函數來計算擬合曲線。

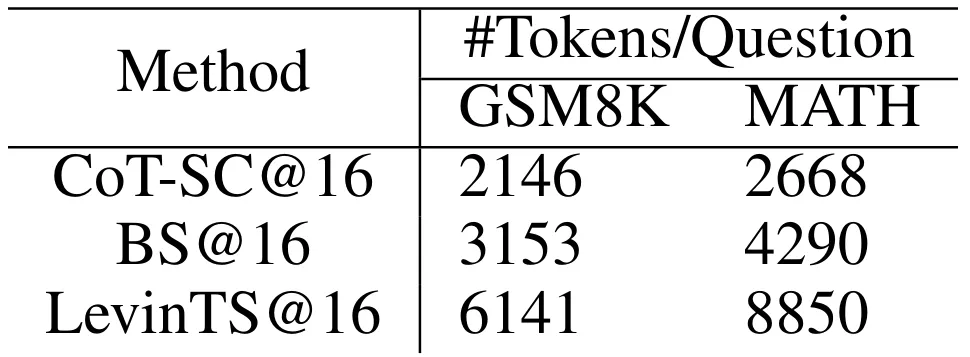

表 2 不同方法在回答問題時的平均 token 生產數量

4. 結論

本文介紹了 MindStar(M*),一種新穎的基于搜索的推理框架,用于增強預訓練大型語言模型的推理能力。通過將推理任務視為搜索問題并利用過程監督的獎勵模型,M* 在推理樹空間中有效導航,識別近似最優路徑。結合束搜索和 Levin 樹搜索的思想,進一步增強了搜索效率,并保證在有限計算復雜度內找到最佳推理路徑。廣泛的實驗結果表明,M* 顯著提升了開源模型的推理能力,其表現可與更大規模的閉源模型媲美,同時大幅減少了模型規模和計算成本。

這些研究成果表明,將計算資源從微調轉移到推理時間搜索具有巨大的潛力,為未來高效推理增強技術的研究開辟了新途徑。