長上下文能力只是吹牛?最強GPT-4o正確率僅55.8%,開源模型不如瞎蒙

大數字一向吸引眼球。

千億參數、萬卡集群,——還有各大廠商一直在卷的超長上下文。

從一開始的幾K幾十K,發展到了如今的百萬token級別。

Gemini的最新版本可以接收200萬個token作為上下文。

這大概相當于140萬個單詞、2小時視頻或者22小時的音頻。

但不知諸位平時用得著這么長的上下文嗎?畢竟100K已經相當于一部比較長的小說了。

更重要的是,LLM真的能在這個長度上進行推理嗎?

近日,有兩篇獨立研究分別表明:長上下文水分很大!LLM實際上并不能「理解」內容。

讀小說挑戰

首先是來自UMass、AI2和普林斯頓的研究人員,推出了一項針對性的測試。

圖片

圖片

論文地址:https://arxiv.org/pdf/2406.16264

代碼和示例數據:https://github.com/marzenakrp/nocha

當前傳統的長上下文測試手段一般被稱為「大海撈針」(needle-in-a-haystack):

圖片

圖片

將一個事實(針)嵌入到大量的上下文信息(干草堆)中,然后測試模型能否找到這根「針」,并回答與之相關的問題。

這種方式基本上衡量的是LLM的檢索能力,有些流于表面。

于是研究人員構建了NoCha(小說挑戰)數據集,讓模型根據所提供的上下文(書籍)驗證聲明的真假。

圖片

圖片

如下圖所示,由小說的粉絲根據書籍內容,提出關于同一事件或角色敘述的一對相反的聲明。

LLM看完小說后需要分別判斷兩個問題的真假(確保是根據理解做題,打擊在考場上瞎蒙的)。

圖片

圖片

對于一對問題的回答有四種情況,只有兩個問題全對時才能得一分。

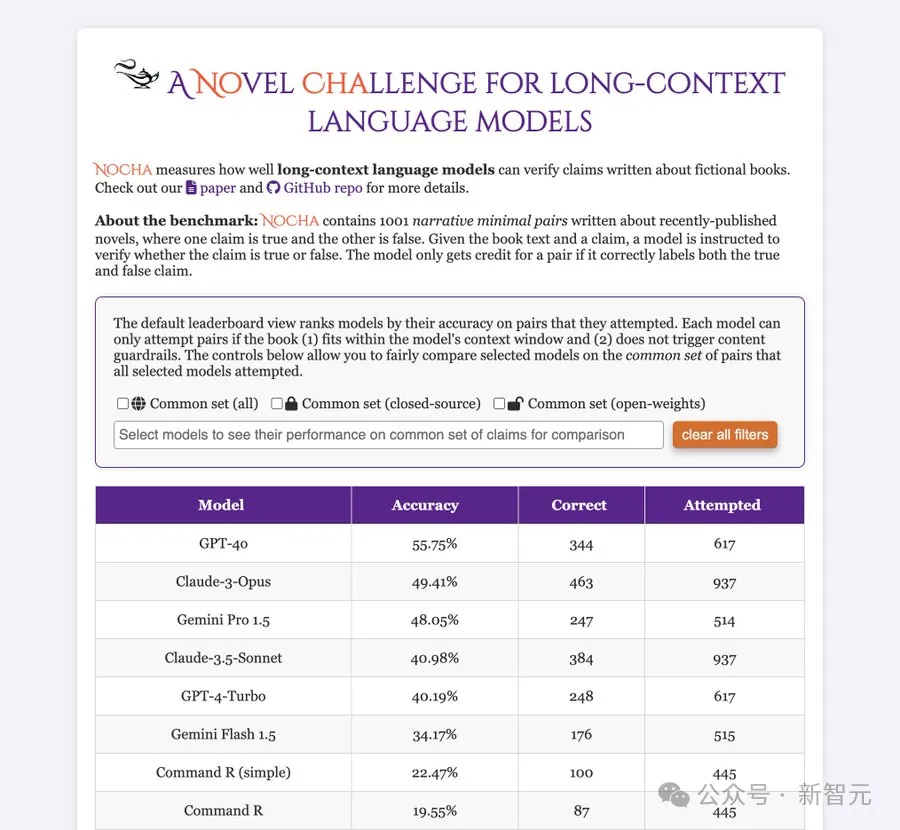

研究人員測試了目前最強的一些長上下文模型(包括閉源和開源),并將成績單貼在墻上,公開處刑:

圖片

圖片

首當其沖的是GPT-4o,雖然全班第一,但是55.75分。

而開源陣營的成績直接慘不忍睹,表現最好的Command R(simple)只有22.47%的準確率。

——要知道,這考試瞎蒙也能得25分(四選一)。

當然,這也說明人家不是瞎蒙的,確實動腦子了。

視覺上的長上下文

另一篇研究來自UCSB,考察的是視覺大模型(VLM)的長上下文能力。

圖片

圖片

論文地址:https://arxiv.org/pdf/2406.16851

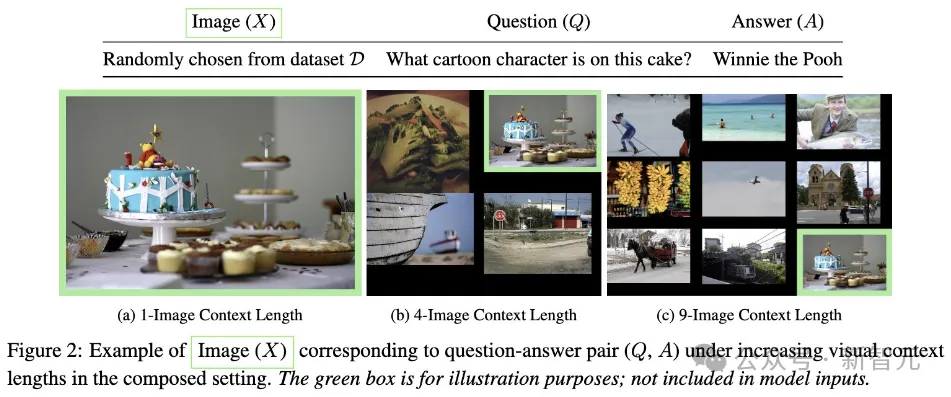

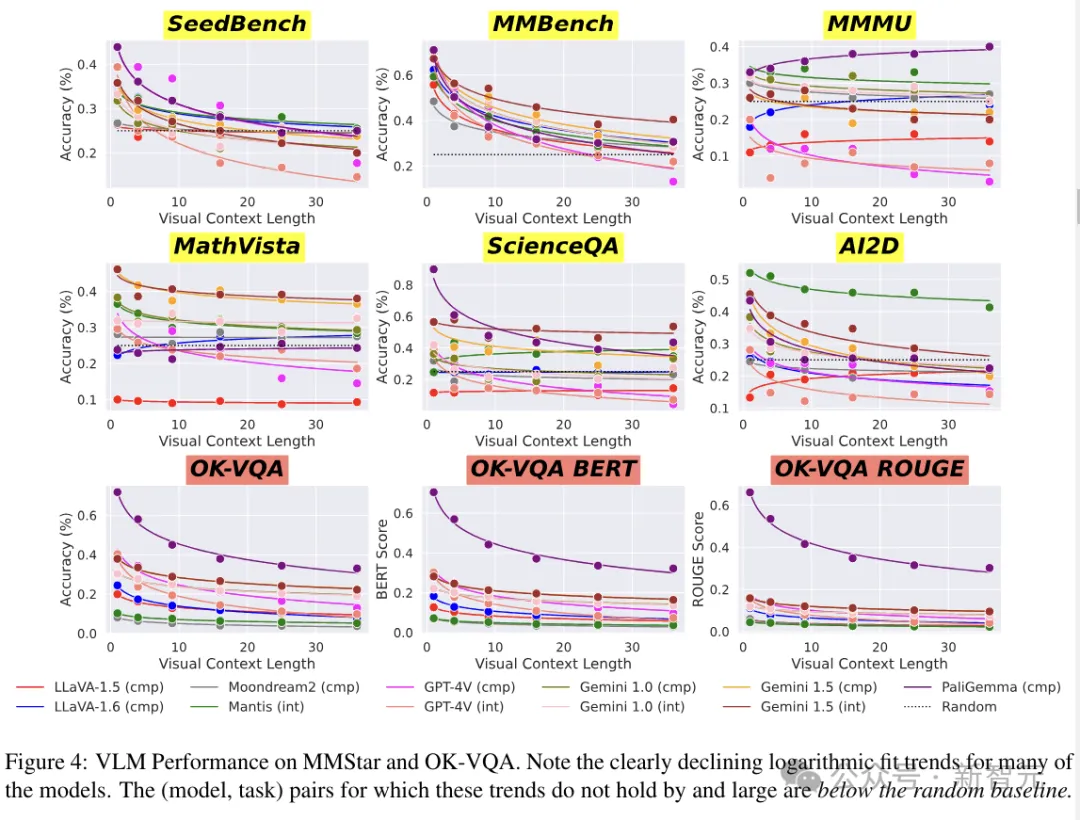

主要的實驗思路如下圖所示,研究人員通過不斷增加上下文長度(干擾圖片的數量),將現有的VQA基準和簡單圖像識別集 (MNIST) 擴展為測試長上下文「提取推理」的示例。

圖片

圖片

結果在簡單VQA任務上,VLM的性能呈現出驚人的指數衰減。

圖片

圖片

——LLM:原形畢露了家人們。

而與實際研究相對的,在今年早些時候,谷歌展示了幾個預先錄制的演示。

讓Gemini 1.5 Pro搜索阿波羅11號登月的電視直播記錄(約402頁),查找包含笑話的引語,以及在電視直播中找到與鉛筆素描相似的場景。

主持這次簡報會的谷歌DeepMind研究副總裁Oriol Vinyals表示,「Gemini 1.5 Pro可以在每一頁、每一個單詞上執行此類推理任務。」

一千零一夜

第一篇工作被作者命名為「One Thousand and One Pairs」(下面這盞燈應該也是這么來的)。

一千零一在這里有兩個含義,首先用于測試的材料基本都是小說,對于大模型來說,算是故事會了;

其次,作者真的花錢請人注釋了剛剛好1001個問題對。

為了保證模型無法依靠自己的知識來作弊,這1001個問題大部分來自于最近出版的虛構敘事類讀物。

數據收集

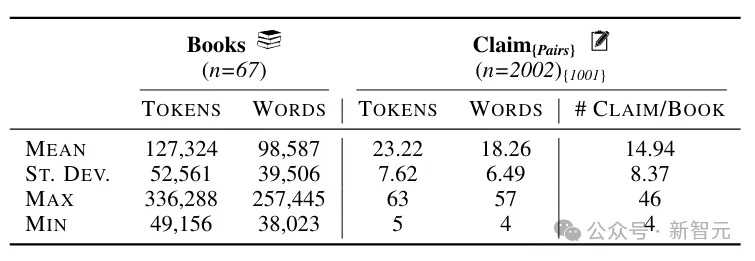

NoCha數據集包括63本新書(33本于2023年出版,30本于2024年出版)和四本經典小說,書籍的平均長度為127k個token(約98.5k個單詞)。

圖片

圖片

注釋者首先寫出關于書中事件或人物的真實陳述,然后針對同一對象創建相應的虛假陳述,同時還需要給出一個簡短的解釋,說明為什么這些說法是正確或錯誤的。

圖片

圖片

為了確保聲明的質量,作者聘請了讀過相同書籍的注釋者,來驗證五本書中的128個聲明,并最終對其中的124個達成了一致。

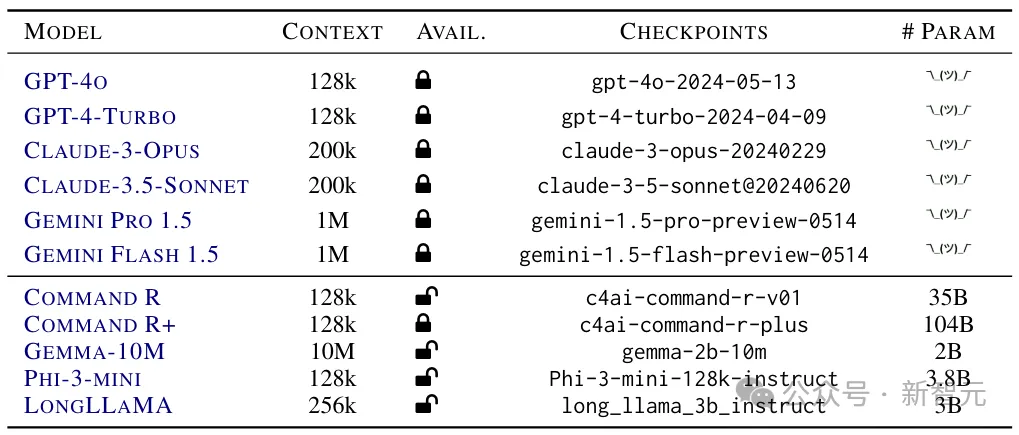

下面給出參加本次考試的考生信息(開源和閉源兩大陣營):

圖片

圖片

以及考試成績:

圖片

圖片

結果分析

如果按照小說類型劃分,所有六個閉源模型在歷史小說上的準確率為56.4%,當代小說為46.8%,推理小說為38.8%。

圖片

圖片

對于每個模型來說,都是歷史小說的準確度最高,當代小說次之,推理小說的準確度最低。

從這個結果來看,貌似LLM的推理更多依賴于自身參數中的知識。

接下來做個對比實驗:如果某個主張可以通過書中的一小部分內容來單獨驗證,那么提供本書的其余部分是否會影響其準確性?

圖片

圖片

上圖顯示了在四個短篇故事集上的模型性能,每兩行為一組,上面一行表示給出整本書(約129k token)時的準確率,下面表示只給出與聲明相關的部分(約21k token)。

Gemini對于添加上下文的表現相對穩健,而Claude-3-Opus的準確度直接下降了44.5%,Claude-3.5-Sonnet、GPT-4-Turbo和GPT-4o的表現也大幅下降。

作者表示,與句子層面的檢索任務相比,模型在驗證需要考慮整本書(或大部分)內容的問題時,顯得力不從心。

另外,書中的一些隱含信息對于人類讀者來說是明確的,但LLM卻無法理解。

大海撈針

另一項研究來自加州大學圣巴巴拉分校(UCSB),作者引入了 LoCoVQA,一種帶有干擾項的長上下文視覺問答 (VQA) 基準生成器。

LoCoVQA可以提供與問題相關的圖像序列,以及一組可配置的視覺干擾項,從而準確評估VLM如何在雜亂的上下文中僅提取與查詢相關的信息。

從原理上講,這也是一項「大海撈針」的任務。

另外,LoCoVQA的方法能夠以任意圖像理解數據集為基礎,創建長上下文圖像理解測試。

生成方法

通過LoCoVQA合成的樣本包含一個或多個與問答對(??、??)相對應的內容圖像??。

內容圖像可以從各種圖像理解基準中采樣,例如OK-VQA、MMStar 、MNIST等。

除了內容圖像之外,每個樣本還包括最多35個干擾圖像(來自相同或者不同的數據集)。

圖片

圖片

VLM的輸入樣本可以是多個交錯的圖像,也可以是上面這種排列為網格的合成圖像。

單圖像推理任務

OK-VQA(Outside Knowledge Visual Question Answering)是一個單圖像視覺問答數據集,包含5072個問題-答案-圖像三元組。它需要外部知識來超越圖像進行推理。

圖片

圖片

LoCoVQA生成分布內的長上下文OK-VQA樣本,確保內容圖像不會出現可能使評估復雜化的概念沖突。

實驗使用三個指標對樣本進行評分:精確匹配(如果模型的響應包含任何真實答案作為子字符串,則為滿分)、連續文本生成、和 ROUGE(候選人和推薦人之間)。

為了解決內容干擾沖突問題(視覺上下文中多個相似分布的圖像使QA對模糊),作者實現了一種基于LM的魯棒過濾方法。

對于每個視覺上下文圖像,提示GPT-4列出前五個實體,如果存在重疊,則認為該問題可能含糊不清。

多圖像推理任務

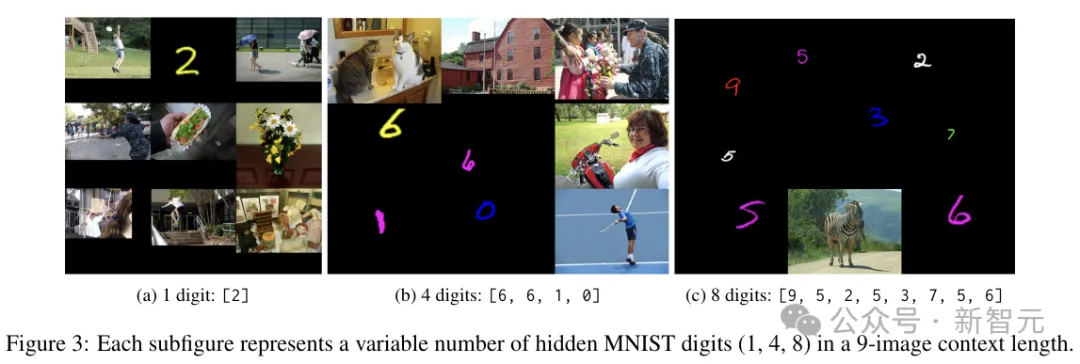

這里使用合成任務構建「序列VQA」數據集,將多個OCR示例作為交錯圖像輸入,要求VLM列出所有文本(OCR規范數據集采用MNIST)。

為了獲得所需的視覺上下文長度,研究人員從大約60K圖像的MNIST訓練集中采樣1到8個隨機顏色的數字,將它們的大小調整到其他上下文圖像最大高度的1/6到1/2之間。

剩余的干擾圖像是從5K個MS COCO的子集中隨機采樣的。VLM的任務是列出序列中存在的所有手寫數字。

圖片

圖片

通過改變序列中的位數,可以動態調整多圖像干擾OCR任務的難度級別。

圖片

圖片

上圖展示了9個圖像上下文中包含1、4 和8個數字的示例。僅當存儲的生成數字字符串與基本事實完全匹配時,輸出才被認為是正確的。

實驗

參賽的VLM如下圖所示:

圖片

圖片

研究人員在LoCoVQA生成的基準上,評估了以上九種視覺語言模型的性能。

圖片

圖片

上圖結果展示了單圖像LoCoVQA任務中,模型性能如何隨著視覺上下文長度的增加而變化。

圖片

圖片

上圖為每個任務的模型在上下文長度為1、9和25時的性能,比較了不同模型在各種任務上的相對優勢。

與其他模型相比,PaliGemma在OK-VQA上表現出色,而Mantis在AI2D上表現也很好。這些差異可能是由于訓練任務的變化造成的。

參考資料:https://techcrunch.com/2024/06/29/geminis-data-analyzing-abilities-arent-as-good-as-google-claims/