最強開源CodeLLM模型深夜來襲!320億參數,Qwen2.5-Coder新模型超越GPT-4o

一夜之間,AI編程模型的開源王座易主了!

Qwen2.5-Coder-32B正式發布,霸氣拿下多個主流基準測試SOTA,徹底登上全球最強開源編程模型寶座。

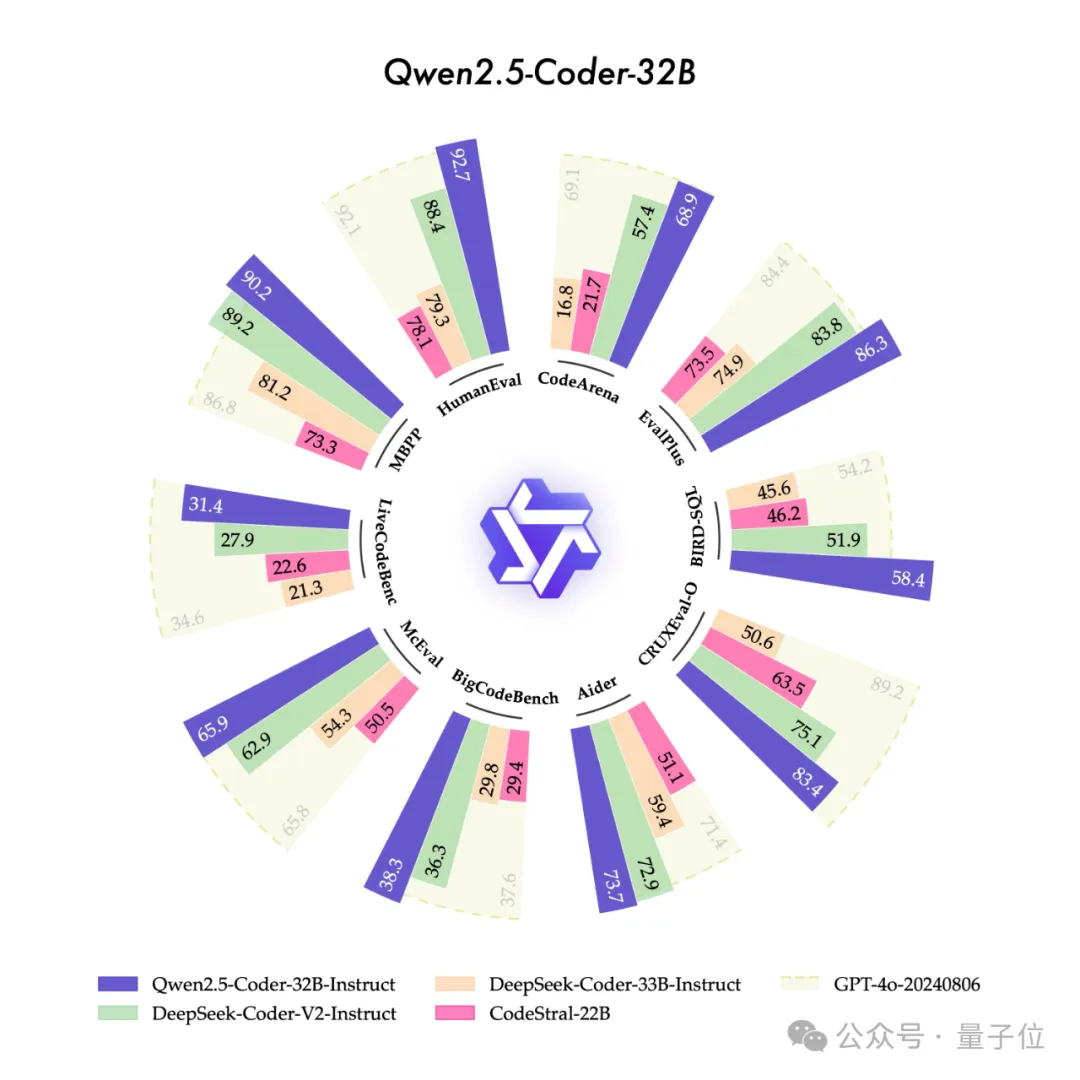

更重要的是,在代碼能力的12個主流基準上,Qwen2.5-Coder-32B與GPT-4o對決,斬獲9勝,一舉掀翻閉源編程模型的絕對統治。

不用一行代碼,只要輸入最直接、夠詳細的自然語言prompt,它就能給你整全套:

比如,做個簡單的模擬三體運動的HTML網頁吧!

生成個game of life的小游戲,也是手拿把掐:

哪怕是完全不懂編程的小白,也能輕松上手。比如我們體驗了一把用一句大白話生成計算器:

很快就搞定了,計算器可以直接使用。

還有更多好玩又實用的應用,比如不到20秒生成一個音樂播放器。

做簡歷也易如反掌:

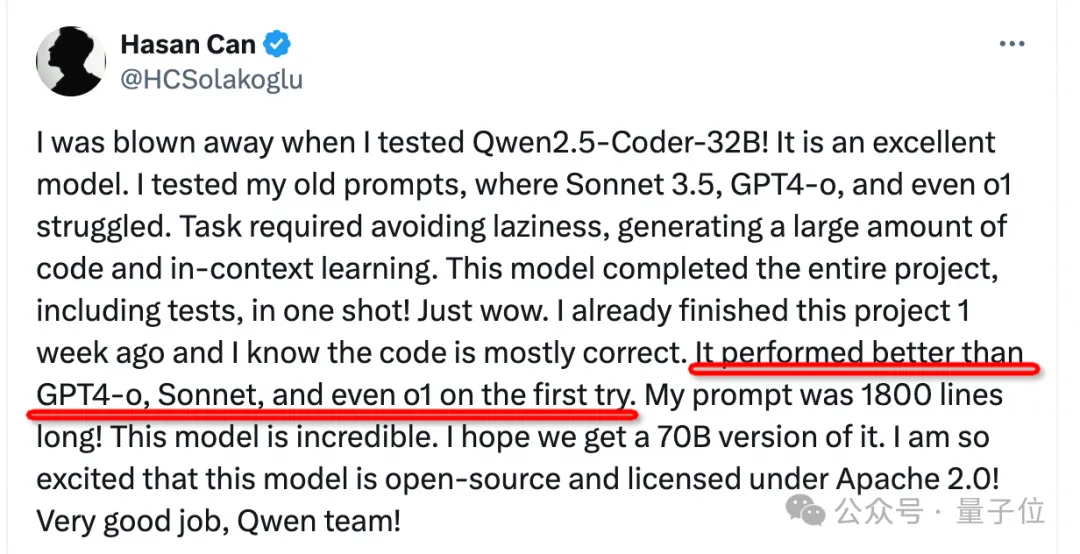

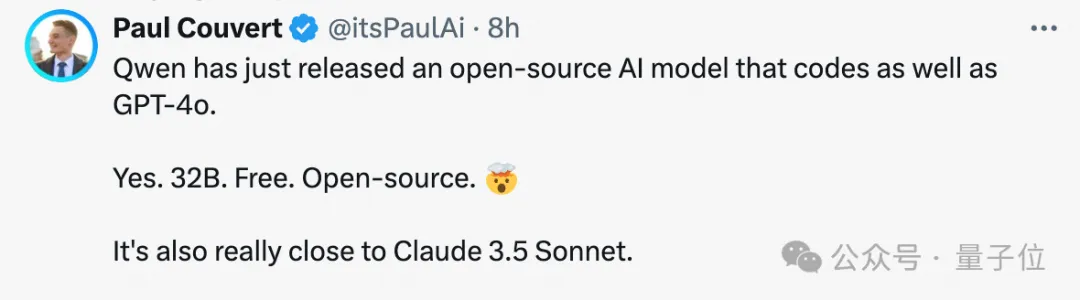

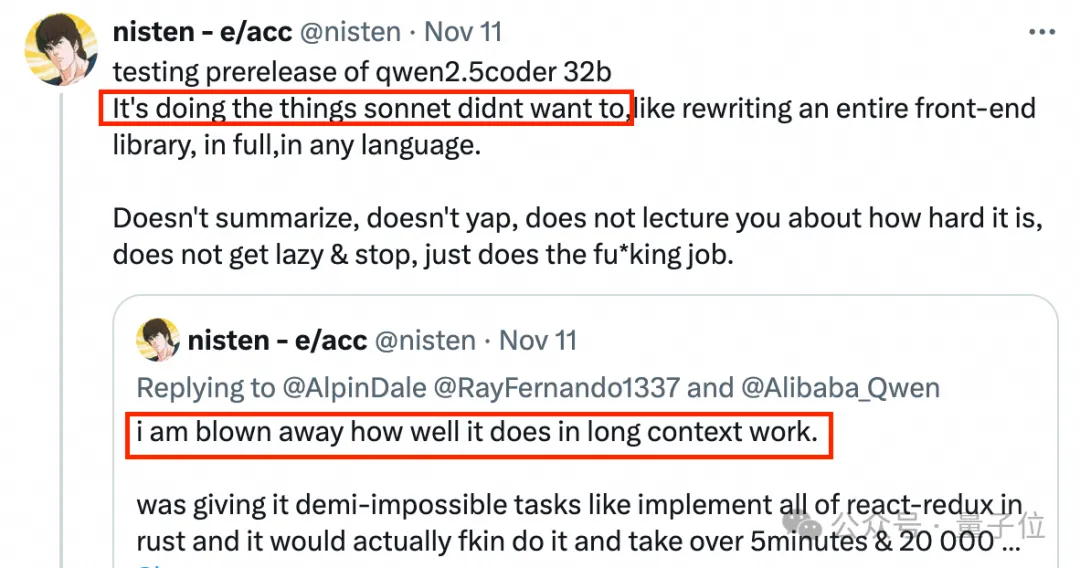

怪不得開發者們都說,太恐怖了,超越了4o,與Sonnet、o1都能掰手腕!

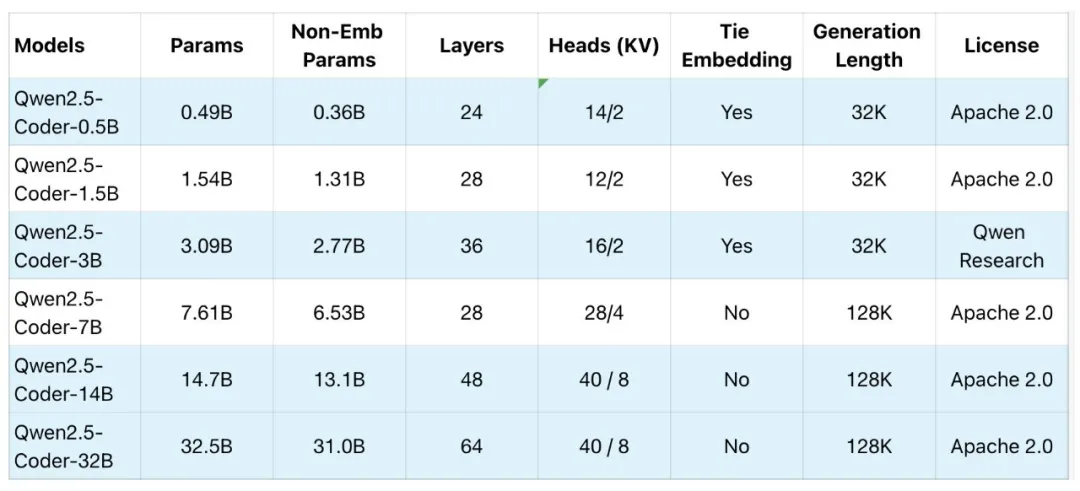

更讓人驚喜的是,這次Qwen2.5-Coder上新,共開源0.5B/1.5B/3B/7B/14B/32B共6個尺寸的全系列模型,每種尺寸都取得同規模下SOTA。

而且大部分版本都是采用非常寬松的Apache 2.0許可。

△藍色為此次新發布版本

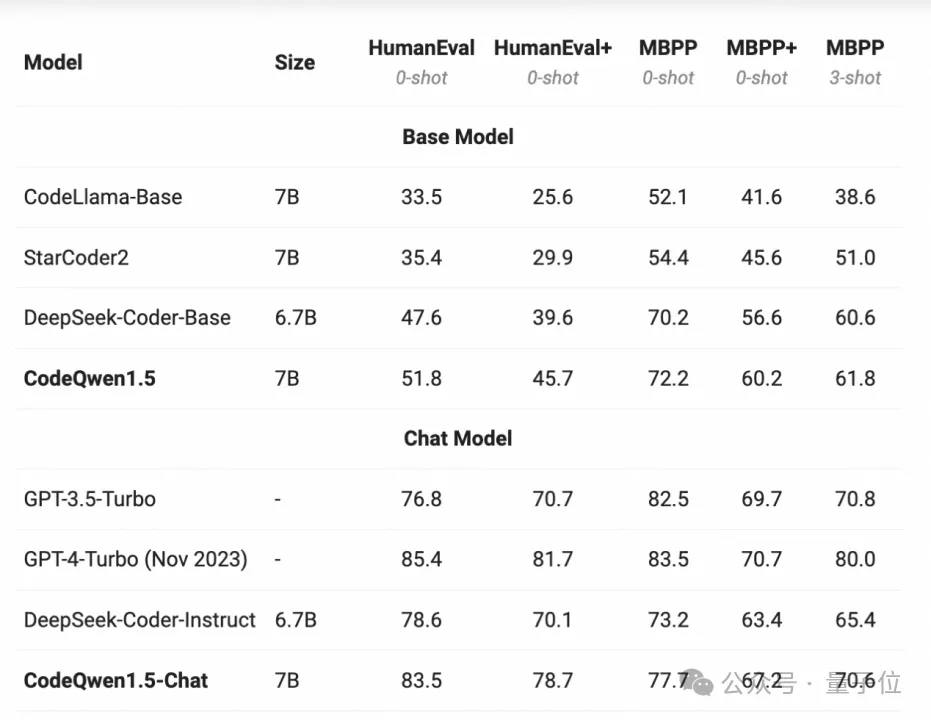

要知道,自從CodeQwen1.5推出以來,該系列模型就成為開發者社區最關注的開源編程模型之一。

9月發布的Qwen2.5-Coder-7B版本,更是一騎絕塵,不少人表示它足以替代GPT-4和Sonnet 3.5成為日常主力工具。

當時還預告了32B的發布,從此,網友一直催更。

這次,32B和更多尺寸的全系列Qwen2.5-Coder如約而至,這個看起來能用code生萬物的最強開源代碼模型,到底厲害在哪兒呢?

超越GPT-4o,人人都能用

首先,我們為什么關注編程模型?因為代碼能力對大模型的推理很重要,大模型對代碼的理解通常被認為是其邏輯能力的基礎來源之一。

代碼思維鏈(program-of-thought) 將復雜問題分解為可執行的代碼片段,并且利用代碼執行器逐步解決子問題,可以較大程度提升基于大型語言模型的推理能力。

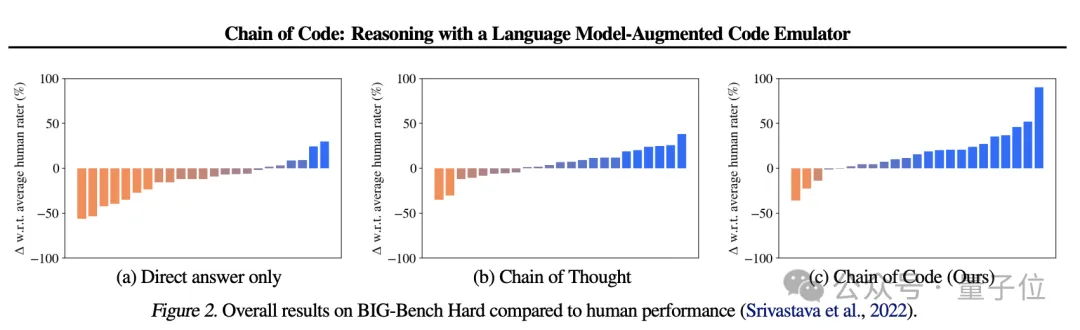

DeepMind斯坦福UC伯克利聯手發表的一項研究中提到,使用代碼鏈(Chain of Code),不僅可以提升模型基于代碼的推理能力,也給模型自然語言任務、數學計算方面帶來積極影響。

△https://arxiv.org/abs/2312.04474

Qwen2.5-Coder也采用了類似原理。它基于Qwen2.5基礎大模型進行初始化,使用源代碼、文本代碼混合數據、合成數據等5.5T tokens的數據持續訓練,實現了代碼生成、代碼推理、代碼修復等核心任務性能的顯著提升。

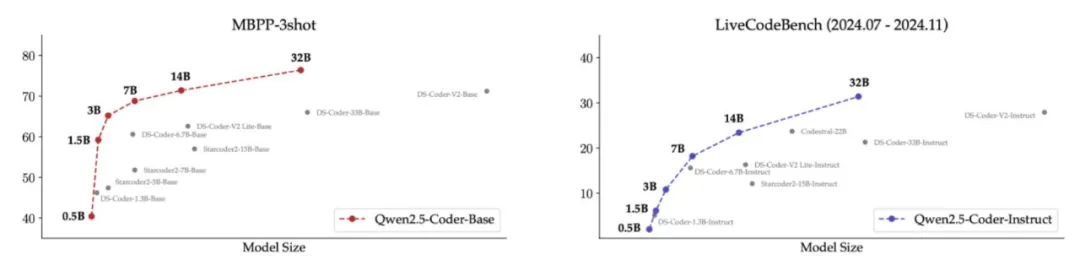

最新發布中,Qwen2.5-Coder全系列共開源6個尺寸模型,每個規模包含base和Instruct兩個版本。

Base模型為開發者可以自行微調的基座模型,Instruct模型是可以直接聊天的官方對齊模型。

團隊評估了不同尺寸Qwen2.5-Coder在所有數據集上的表現,不但均取得同等規模下最佳性能(無論開閉源),并且還驗證了Scaling Law依舊奏效。

其中,Qwen2.5-Coder-32B-Instruct是本次開源的旗艦模型。

在編程大模型主要關注的5個方面上,它都實現了對GPT-4o的超越:

- 代碼生成

- 代碼修復

- 代碼推理

- 多編程語言

- 人類偏好對齊

首先來看編程模型最核心的能力——代碼生成。

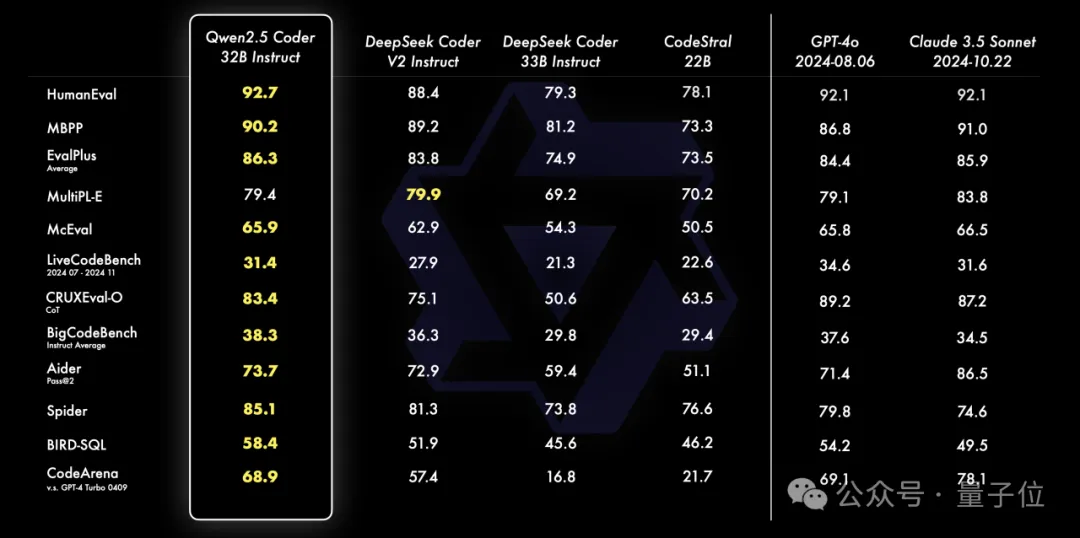

Qwen2.5-Coder-32B-Instruct在多個流行的代碼生成基準上都取得了開源SOTA。

而且在HumanEval、McEval、Spider、EvalPlus、BigCodeBench等基準上,都超越了閉源的GPT-4o和Claude 3.5 Sonnet。

其次,代碼修復方面,在主流基準Aider上,Qwen2.5-Coder-32B-Instruct略勝GPT-4o。

第三,代碼推理方面,在CRUXEval基準上,32B版本較7B版本有了明顯提升,甚至達到了和GPT-4o、Claude 3 Opus相當的水平。

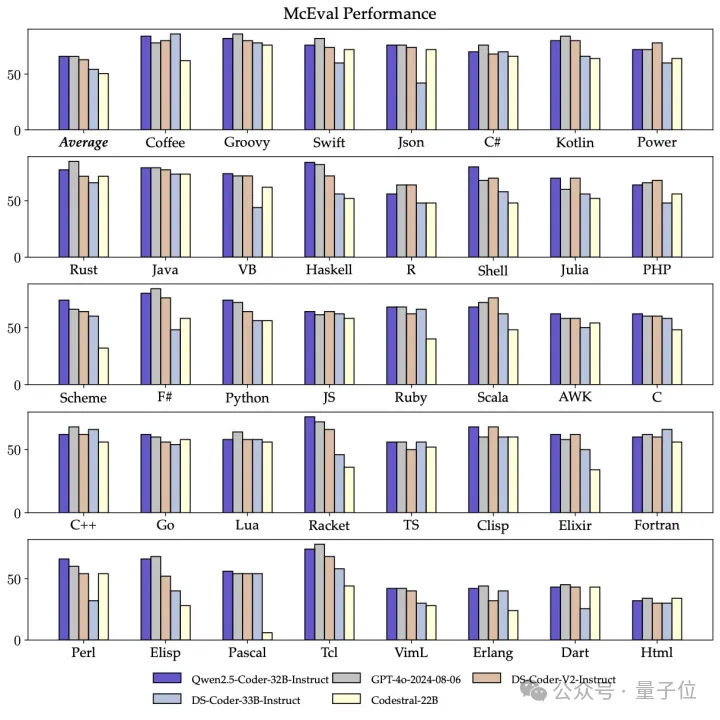

第四,在對多編程語言的掌握上,Qwen2.5-Coder支持92種編程語言。Qwen2.5-Coder-32B-Instruct在其中40多種語言上表現出色。

在Haskell、Racket等語言上表現格外突出,打敗4o等閉源模型同時取得了超高分數。

通過在預訓練階段進行獨特數據清洗和配比,它在McEval上取得65.9分,

在多編程語言的代碼修復基準MdEval上,同樣表現突出,取得75.2分,位列所有開源模型第一。

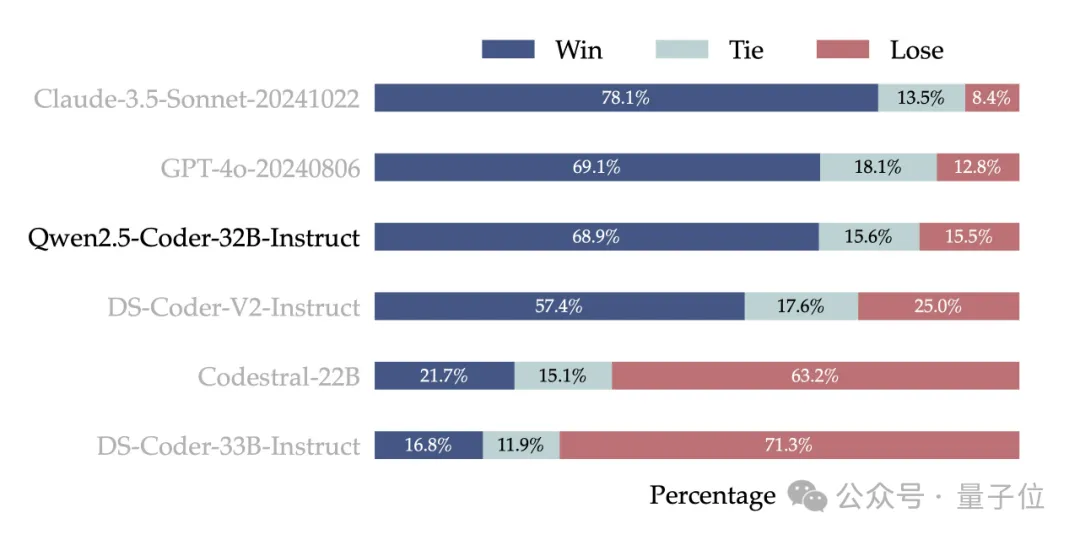

最后,為了檢驗Qwen2.5-Coder-32B-Instruct在人類偏好上的對齊表現。通義千問團隊還構建了一個來自內部標注的代碼偏好評估基準Code Arena,可以理解為編程大模型競技場。

這一部分,Qwen2.5-Coder-32B-Instruct和閉源模型正面PK,通過讓兩個模型在同樣問題下PK,計算最終勝負比,以此來評判模型表現。

實驗結果顯示,Claude 3.5 Sonnet戰績最好,Qwen2.5-Coder-32B-Instruct和GPT-4o水平相當,勝率為68.9%。

總的來看,Qwen2.5-Coder-32B-Instruct毫無疑問是開源最佳,并且真正拉平甚至部分超出了有最強代碼能力的閉源模型。

在實際應用上,通義千問團隊演示了基于Qwen2.5-Coder打造的智能代碼助手,并上線了一個Artifacts應用。

目前智能代碼助手領域主要以閉源模型為主,Qwen2.5-Coder為開發者提供了開源選擇。

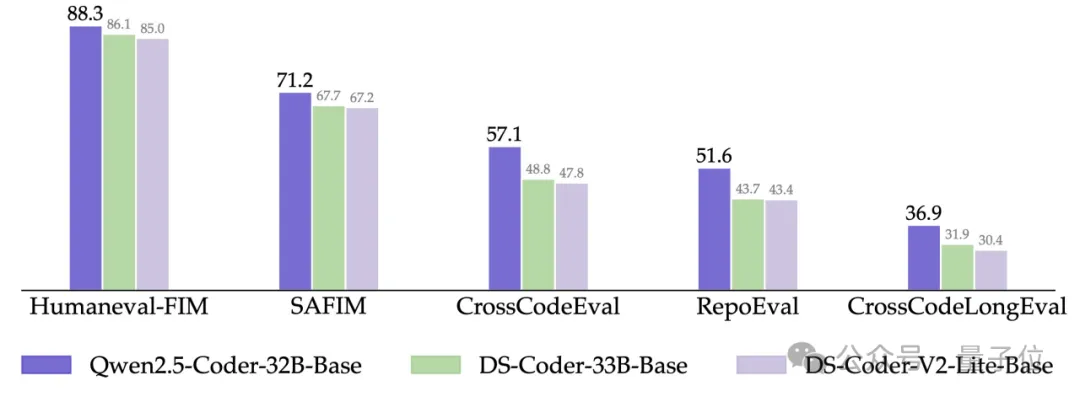

它在幾個可以評估模型輔助編程的基準上(CrossCodeEval、CrossCodeEval、CrossCodeLongEval、RepoEval、SAFIM)都取得了SOTA。

新的Qwen2.5-Coder,對編程小白也很友好,一句話就能開發小應用/游戲。

比如現場自動做一個2048小游戲,幾十秒搞定,立刻就能玩。

或者是生成一個圖文并茂的英語單詞卡頁面,速度都非常快。

被全球開發者追捧的中國開源模型

Qwen2.5-Coder-32B的快速推出可以說是眾望所歸。

就在前段時間,Reddit還有帖子提問,怎么32B版本還不來?

畢竟,不少人都基于9月開源的Qwen2.5-Coder-1.5B和7B版本,打造出了熱度頗高的應用。

比如Qwen Code Interpreter。這是一個類似于ChatGPT的代碼解釋器,可完全在本地/瀏覽器上運行,基于Qwen2.5-Coder-1.5B打造。

只用小模型還實現了非常好的效果,這立刻引發不少網友的關注,一個隨手推薦帖就有近千人點贊。

還有人基于Qwen2.5-Coder打造了專門用于rust語言的編程助手。

說Qwen2.5-Coder是最受歡迎的開源編程大模型絕不為過,事實上,每一代Qwen編程模型,都代表了開源的最高水平,PK的永遠是當時最厲害的閉源模型。

今年4月,CodeQwen1.5-7B發布,在基礎代碼生成能力上,它表現出超過更大尺寸模型的潛力,拉近了開源模型和GPT-4之間的編程能力差距。

之后在云棲大會上,Qwen2.5-Coder-1.5B/7B發布。作為Qwen2.5家族的一員,Qwen2.5-Coder-7B打敗了當時比它尺寸更大的DeepSeek-Coder-V2-Lite和Codestral-20B,成為最強基礎編程模型之一。

在此基礎上,Qwen2.5-Coder-32B的推出,將規模提升一個數量級達到百億參數,能力也進一步涌現,水平超越GPT-4o,逐漸逼近閉源模型王者Claude 3.5 Sonnet。

閉源模型山頭幾個月一換,而開源的Qwen卻從來沒有停下攀登的腳步,也進一步驗證,開源模型和閉源模型之間的差距正在縮短,開源模型完全有機會、有能力取代閉源模型,為全球廣大開發者用戶提供更加低門檻、開放的AI能力。

隨著AI應用趨勢不斷演進,越來越多領域和行業加入,對AI模型的性能、開發成本以及上手門檻都會提出更高要求。反之,易用的開源模型將成為推動這股趨勢的重要動力。

Qwen系列的爆火就是這種正向循環最好的證明之一。截至9月底,全球基于Qwen系列二次開發的衍生模型數量9月底突破7.43萬,超越Llama系列衍生模型的7.28萬。

通義千問Qwen已成為全球最大的生成式語言模型族群。

而背靠阿里——全球云計算和AI的第一梯隊玩家,一方面,深厚技術和資源支持為Qwen系列的持續開源、不斷升級提供更可靠保障,另一方面,阿里自身業務及發展上的需要也構成了Qwen繼續攀登高峰的內在閉環。

不過開源模型最大價值還是要回歸開發者。

AI的到來,讓天下沒有難開發的應用。

Qwen作為中國開源大模型領軍者,為全球開發者提供更豐富的選擇,也代表中國創新力量在全球大模型競技中登臺亮相,并且正在得到更多人的認可。

嗯…比如前段時間Mistral發布的端側模型沒有和Qwen2.5做對比,還被小小吐槽了下(doge)。

值得一提的是,據透露Qwen3已經在路上,預計在幾個月內和大家見面。可以期待一下~

關于Qwen2.5-Coder的更多信息,可直接通過下方鏈接了解。

GitHub地址:

https://github.com/QwenLM/Qwen2.5-Coder

技術報告:

https://arxiv.org/abs/2409.12186