賈揚清十年經典之作獲時間檢驗獎!ICML 2024十篇最佳論文開獎,爆火SD3、谷歌Genie在列

ICML 2024大獎新鮮出爐了!

剛剛,ICML開幕式正式召開,會上公布了10篇最佳論文獎,還有1篇十年前論文摘得時間檢驗獎。

最佳論文中,有幾篇AI圖像、視頻生成領域的爆火之作,包括SD3技術報告、CMU谷歌AI視頻模型VideoPoet、谷歌基礎世界模型Genie。

值得一提的是,AI大牛賈揚清等人在2013年10月發(fā)表的論文DeCAF,獲得了時間檢驗獎。

剛剛,他發(fā)文表示,深感榮幸獲此殊榮。

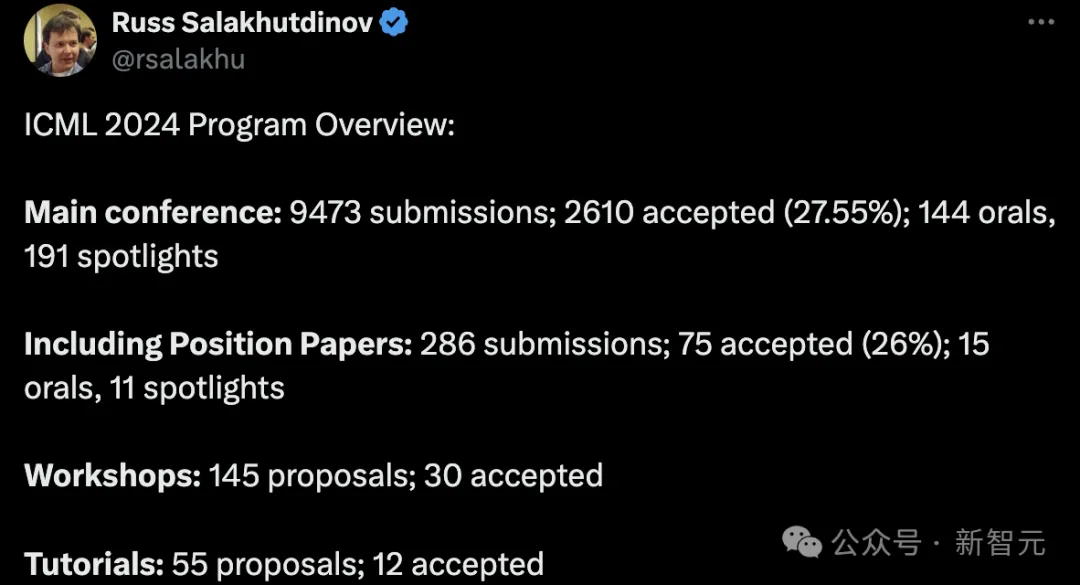

CMU教授、Meta GenAI副總Russ Salakhutdinov對ICML 2024整體錄用結果做了一個總結:

這屆頂會一共收到了9473篇論文,其中2610篇被錄用,錄用率為27.55%。144篇是Oral,還有191篇是Spotlight。

今年全新引入的Position論文,提交有286篇,75篇被接收(26%)。15篇是Oral,11篇是Spotlight。

另外,Workshop中有145個提案,30個被接收。Tutorial有55個提案,12個被接收。

今年,是ICML 2024第41屆年會(每年一屆),于7月21日-27日在奧地利維也納舉辦。

8675人紛紛前來現場參會,臺下虛無坐席。

ICML 2024頂會速覽

頒獎前,組委會首先介紹了下,今年大會的整體情況:

· 9個EXPO Talk Panel

· 12個Tutorial

· 6個特邀演講

· 2,610篇論文(主會議)

· 30個研討會

· 12345位作者和演講者

· 39%參與者是學生

· 10個線下社交活動

· 3個affinity event

· 52名志愿者

· 97位高級區(qū)域主席(SAC),492位區(qū)域主席(AC),7473名審稿人

· 9406名注冊參會者(其中8,675人現場參會)

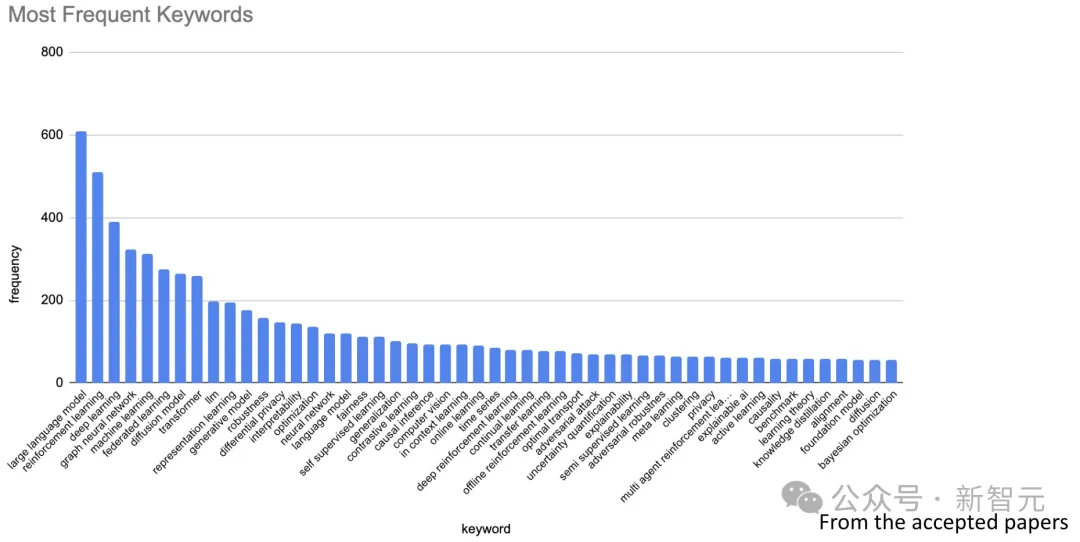

根據被錄用的論文,ICML匯總了出現的高頻詞,也正是這一年的熱點詞:

大模型出現頻率最高,超過了600+次。

其次是強化學習、深度學習、圖神經網絡、機器學習、聯(lián)邦學習、擴散模型、Transformer、LLM、表示學習、生成模型等等。

從注冊國家/地區(qū)來看,美國高達2463人,中國以1100+人位列第二。

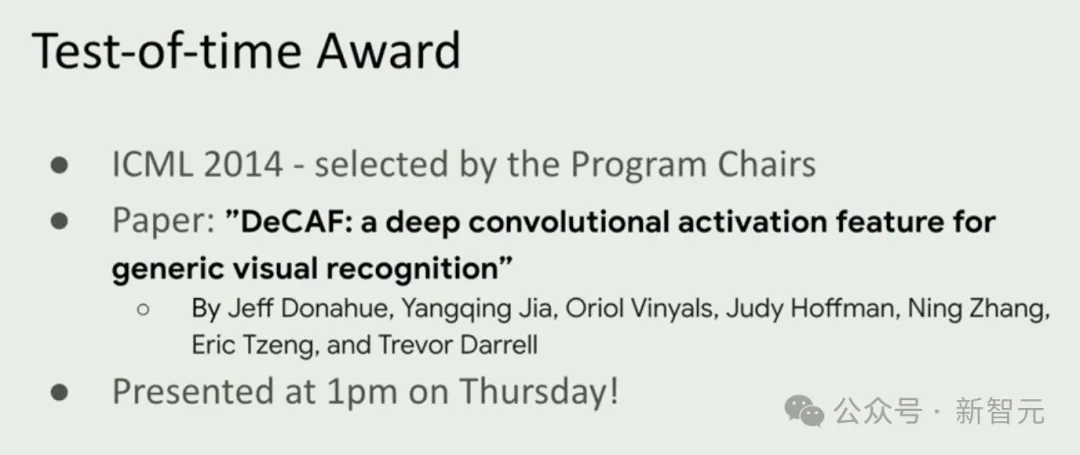

時間檢驗獎

通常來說,時間檢驗獎頒給10年以上的產生重要持久影響的學術論文。

這篇論文還是Caffe之父賈楊清就讀于UC伯克利,在谷歌實習期間和團隊合作完成的經典之作。

他曾在采訪中表示,2013年在谷歌實習時喝了太多咖啡,由此起名DeCAF,為的是督促自己把咖啡戒了。

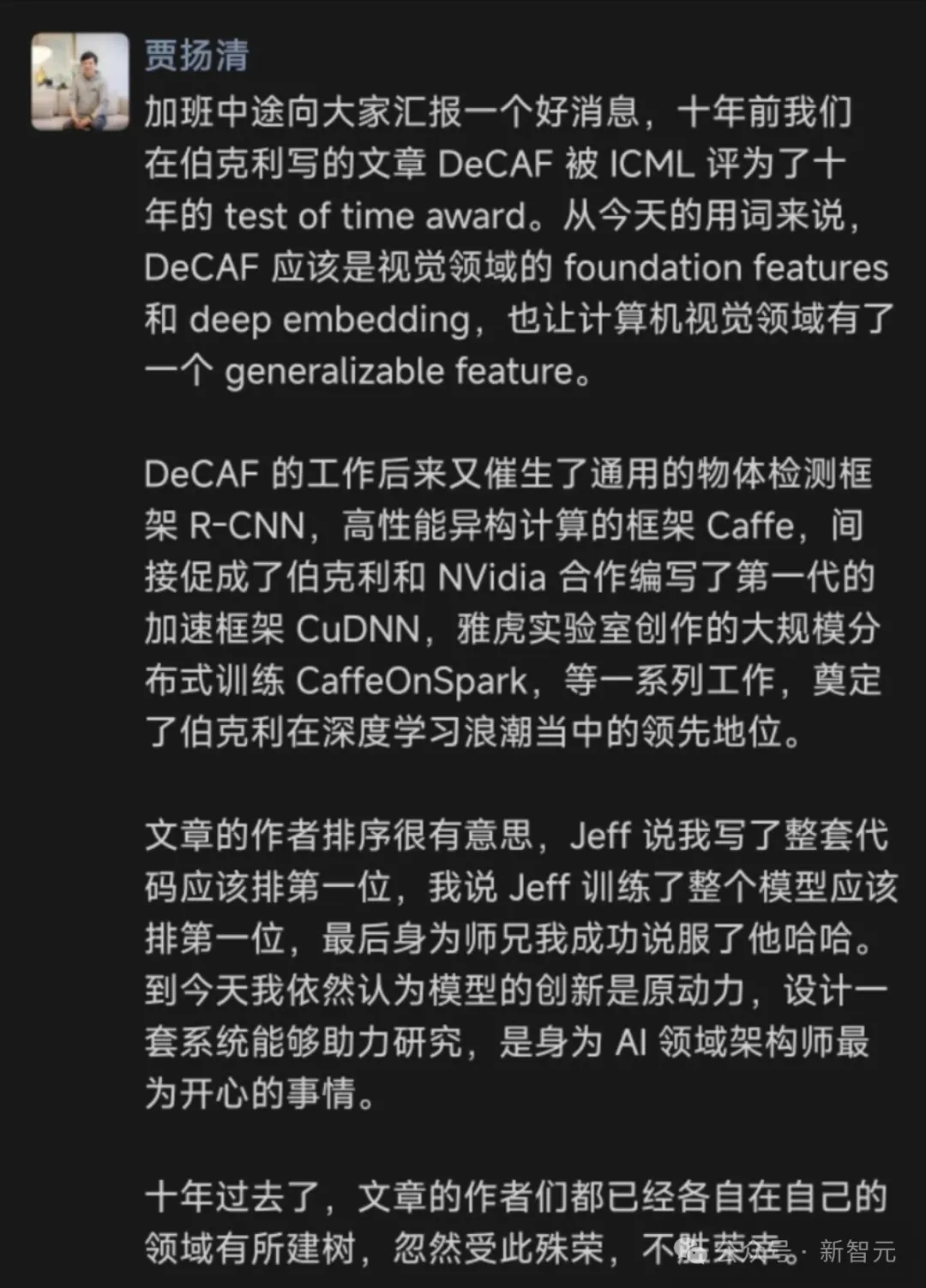

加班途中,他發(fā)文稱,「DeCAF應該是視覺領域的foundation features和deepembedding,也讓計算機視覺領域有了一個generalizable feature..」

DeCAF研究的影響在于,催生了通用物體檢測框架R-CNN,高性能異構計算的框架Caffe,間接促成了伯克利和英偉達合作編寫了第一代的加速框架CuDNN,雅虎實驗室創(chuàng)作的大規(guī)模分布式訓練CaffeOnSpark等一系列工作,奠定了伯克利在深度學習浪潮當中的領先地位。

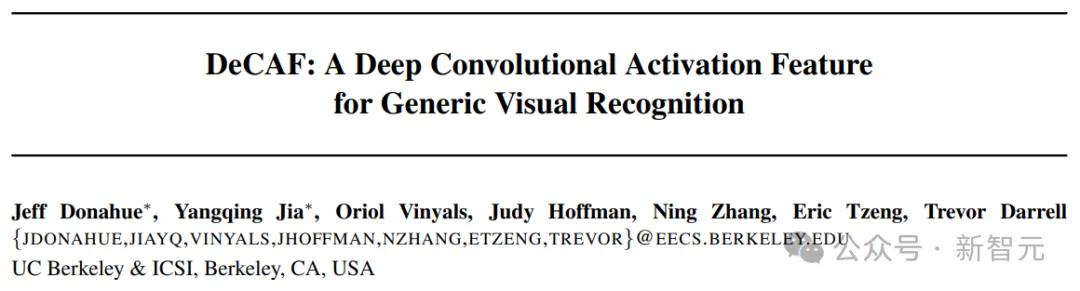

題目:DeCAF: A Deep Convolutional Activation Feature for Generic Visual Recognition

作者:Jeff Donahue,Yangqing Jia,Oriol Vinyals,Judy Hoffman,Ning Zhang,Eric Tzeng,Trevor Darrell

機構:加利福尼亞大學伯克利分校

論文地址:https://arxiv.org/abs/1310.1531

為了用一個更好的概率框架來表達人的行為,團隊親自寫了第一個框架——DeCAF。

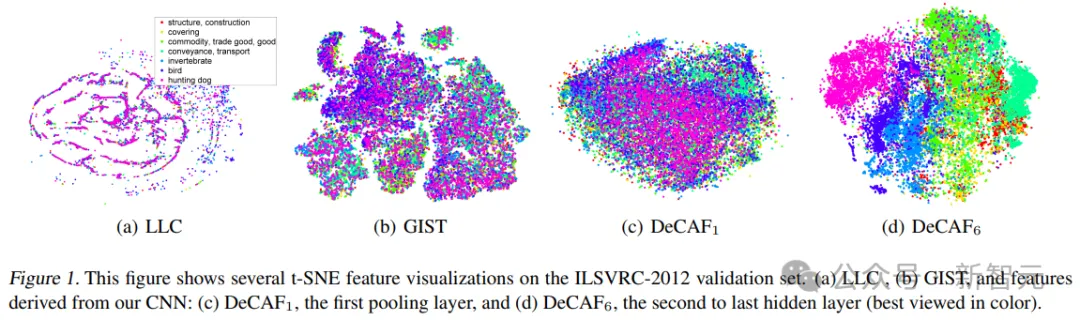

在這項工作中,作者評估了從一個在大量固定物體識別任務上以全監(jiān)督方式訓練的深度卷積網絡中提取的特征,能否在新的通用任務上重新得到利用。

這些通用任務與最初的訓練任務可能存在顯著差異,且可能缺乏足夠的標注數據,或完全沒有標注數據,因此無法使用常規(guī)方法訓練或微調深度網絡來適應新任務。

此外,作者還可視化了深度卷積特征在場景識別、領域適應和細粒度識別等任務中的語義聚類,并通過比較依賴于網絡不同層次來定義固定特征的效果,提出了在幾個重要的視覺挑戰(zhàn)上取得的新SOTA。

最后,作者發(fā)布了這些深度卷積激活特征的開源實現——DeCA,以及所有相關的網絡參數。從而幫助視覺作者能夠在各種視覺概念學習范式中進行深度表征的實驗。

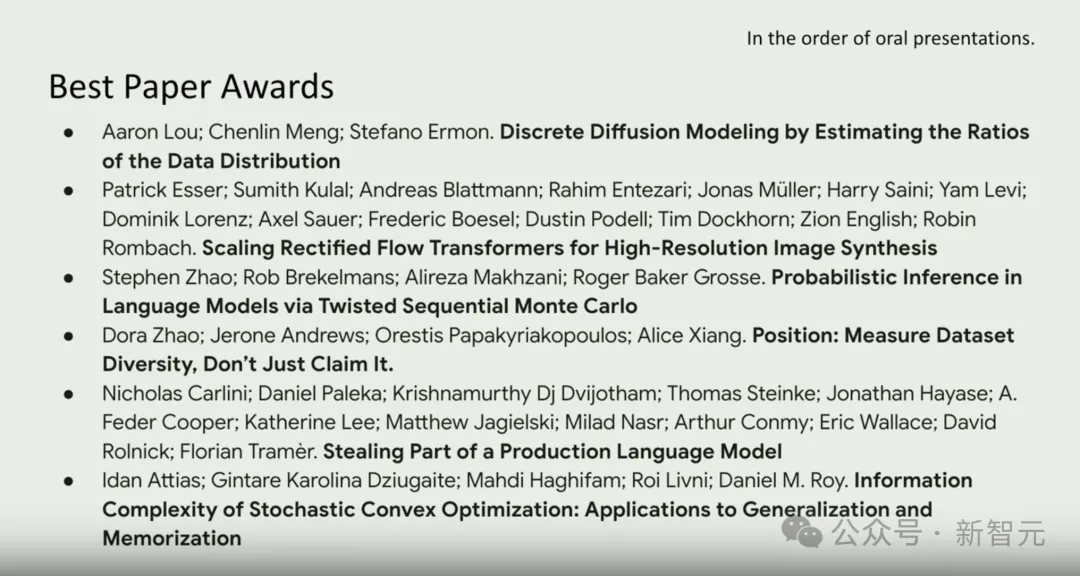

十篇最佳論文

今年,一共有十篇最佳論文。

以上排名皆以oral展示為序

論文一:Discrete Diffusion Modeling by Estimating the Ratios of the Data Distribution

作者:Aaron Lou,Chenlin Meng,Stefano Ermon

機構:斯坦福大學,Pika Labs

論文地址:https://arxiv.org/abs/2310.16834

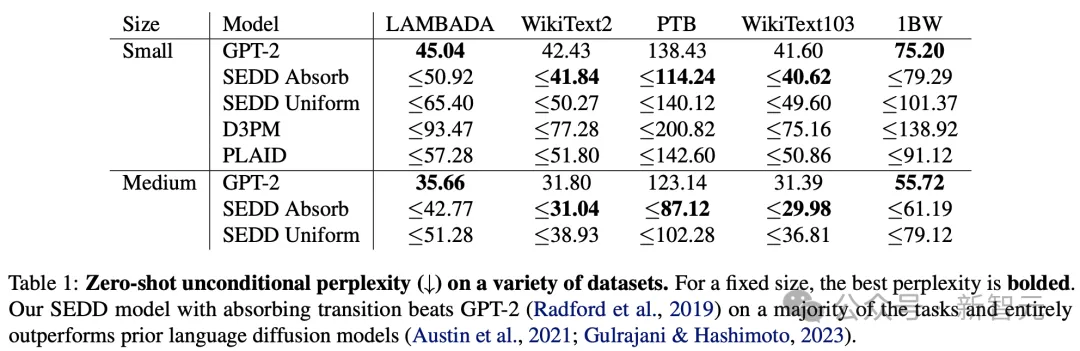

這項研究提出了一個全新的機器學習模型SEDD(Score Entropy Discrete Diffusion),主要針對離散數據生成任務。

當前,擴散模型在許多生成建模任務中,展現出突破性的性能,但在自然語言等離散數據領域卻表現不佳。

論文中,作者提出了得分熵(score entropy)的概念,來彌補這種差距。

這是一種新穎的損失函數,自然地將得分匹配擴展到離散空間,無縫集成以構建離散擴散模型,并顯著提升性能。

實驗評估過程中,SEDD比現有語言擴散模型表現更好(困惑度降低25-75%)。

而且,它還在某些方面超過了GPT-2等自回歸模型。

總而言之,SEDD的優(yōu)勢在于:

- 無需使用溫度scaling等技術就能生成高質量文本(生成困惑度比未退火的GPT-2好約6-8倍)

- 可以在計算資源和輸出質量之間進行靈活權衡(使用32倍更少的網絡評估次數達到相似的性能)

- 支持可控的文本填充,提供更多靈活性。(匹配核(matching nucleus)采樣質量,同時支持除從左到右提示之外的其他策略)。

論文二:Scaling Rectified Flow Transformers for High-Resolution Image Synthesis

作者:Patrick Esser,Sumith Kulal,Andreas Blattmann,Rahim Entezari,Jonas Müller,Harry Saini,Yam Levi,Dominik Lorenz,Axel Sauer,Frederic Boesel,Dustin Podell,Tim Dockhorn,Zion English,Kyle Lacey,Alex Goodwin,Yannik Marek,Robin Rombach

機構:Stability AI

論文地址:https://arxiv.org/abs/2403.03206

正如開頭所述,這篇論文是爆火出圈的Stable Diffusion 3的技術報告。

與Sora類似,SD3采用了改進版的Diffusion模型和一個基于DiT的文生圖全新架構。

具體而言,作者利用了三種不同的文本編碼器——兩個CLIP模型和一個T5——來處理文本信息,同時使用了一個更為先進的自編碼模型來處理圖像信息。

全新提出的多模態(tài)擴散Transformer(MMDiT)架構,采用了分別針對圖像和語言表示的獨立權重集,與SD3的早期版本相比,顯著提升了對文本的理解和文字的拼寫能力。

評估結果顯示,無論是在遵循提示的準確性、文本的清晰呈現還是圖像的視覺美感方面,SD3都達到或超過了當前文生圖生成技術的最高水平。

論文三:Probabilistic Inference in Language Models via Twisted Sequential Monte Carlo

作者:Stephen Zhao,Rob Brekelmans,Alireza Makhzani,Roger Grosse

機構:多倫多大學,Vector Institute

論文地址:https://arxiv.org/abs/2404.17546

這項研究主要關注的是,大模型中采樣和推理問題。

LLM許多能力和安全技術,比如RLHF、自動化紅隊測試、提示工程和填充等,皆可以被視為:

給定獎勵或潛在函數,在其定義的未歸一化目標分布中進行采樣。這一分布是針對完整序列定義的。

論文中,作者提出利用序列蒙特卡洛(SMC)方法,來解決這些采樣概率問題。

對此,作者提出了扭曲函數(twist functions)來估計每個時間步的潛在未來值,進而優(yōu)化采樣過程。

此外,他們還提出了使用新型雙向SMC邊界(bounds),以評估LLM推理技術準確性的方法。

最終結果顯示,扭曲SMC在以下方法中展現出強大效力:從預訓練模型中采樣不良輸出、生成帶有不同情感的評論,以及執(zhí)行填充任務。

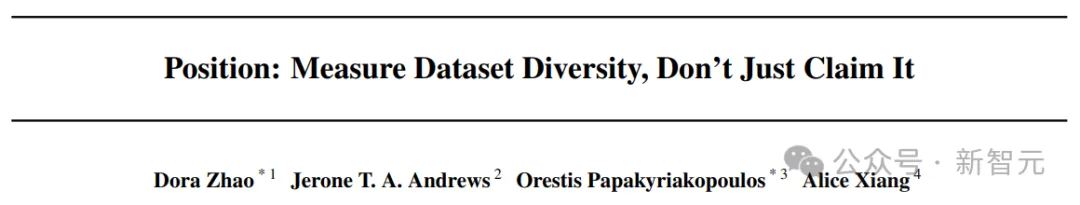

論文四:Position: Measure Dataset Diversity,Don't Just Claim It

作者:Dora Zhao,Jerone T.A. Andrews,Orestis Papakyriakopoulos,Alice Xiang

機構:斯坦福大學,慕尼黑工業(yè)大學,Sony AI

論文地址:https://arxiv.org/abs/2407.08188

當前,許多數據集都為自己貼上多樣性的標簽,但實際上卻包含著抽象且富有爭議的社會概念。

在這項工作中,作者通過分析135個圖像和文本數據集中的「多樣性」,來探討這一問題。

如下圖所示,作者借鑒社會科學理論中測量理論,作為需要考慮的因素,并為概念化、操作化和評估數據集中的多樣性提供建議。

這項研究最終目的是,呼吁在機器學習研究中,特別是在數據集構建過程中,希望AI學者對帶有價值判斷的屬性數據,采取更加細致和精確的處理方法。

論文五:Stealing Part of a Production Language Model

作者:Nicholas Carlini,Daniel Paleka,Krishnamurthy Dj Dvijotham,Thomas Steinke,Jonathan Hayase,A. Feder Cooper,Katherine Lee,Matthew Jagielski,Milad Nasr,Arthur Conmy,Itay Yona,Eric Wallace,David Rolnick,Florian Tramèr

機構:蘇黎世聯(lián)邦理工學院,華盛頓大學,麥吉爾大學,Google DeepMind,OpenAI

論文地址:https://arxiv.org/abs/2403.06634

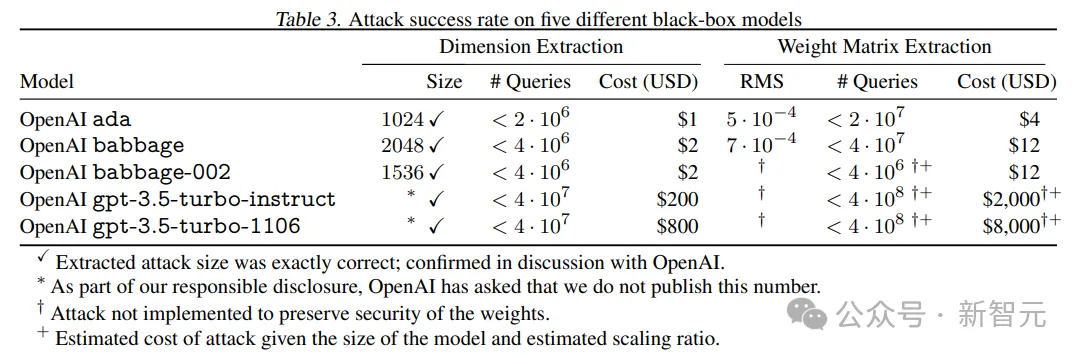

在這項工作中,作者提出了首個能夠從黑盒語言模型(如OpenAI的ChatGPT或Google的PaLM-2)中提取精確且復雜信息的模型竊取攻擊。

具體來說,這種攻擊能夠通過常規(guī)的API訪問,重建Transformer模型的嵌入投影層(在對稱性條件下)。

并且,只需不到20美元,便可提取OpenAI的Ada和Babbage語言模型的整個投影矩陣。從而首次證實了這兩個黑盒模型分別具有1024和2048的隱藏維度。

此外,作者還還原了gpt-3.5-turbo模型的確切隱藏維度大小。而這次,整個投影矩陣的提取成本,也不過是2000美元。

最后,作者提出了潛在的防御和緩解措施,并討論了對未來工作影響。

論文六:Information Complexity of Stochastic Convex Optimization: Applications to Generalization and Memorization

作者:Idan Attias,Gintare Karolina Dziugaite,Mahdi Haghifam,Roi Livni,Daniel M. Roy

機構:本·古里安大學,東北大學,特拉維夫大學,多倫多大學,Vector Institute,Google DeepMind

論文地址:https://arxiv.org/abs/2402.09327

在這項工作中,作者研究了在隨機凸優(yōu)化問題(SCO)背景下記憶化和學習之間的相互作用。

首先,通過學習算法揭示與訓練數據點相關信息來定義記憶化。然后,使用條件互信息(Conditional Mutual Information,CMI)框架來進行量化。從而,實現了對學習算法的準確性與其CMI之間權衡的精確描述。

結果顯示,在L^2 Lipschitz有界設置和強凸性條件下,每個超額誤差為ε的學習者的CMI分別在Ω(1/ε^2)和Ω(1/ε)處有下界。

更進一步,作者通過設計一個能準確識別特定SCO問題中大部分訓練樣本的對抗者,證明了記憶化在SCO學習問題中的重要作用。

最后,作者列舉了幾項重要意義,例如基于CMI的泛化界限的限制以及SCO問題中樣本不可壓縮性。

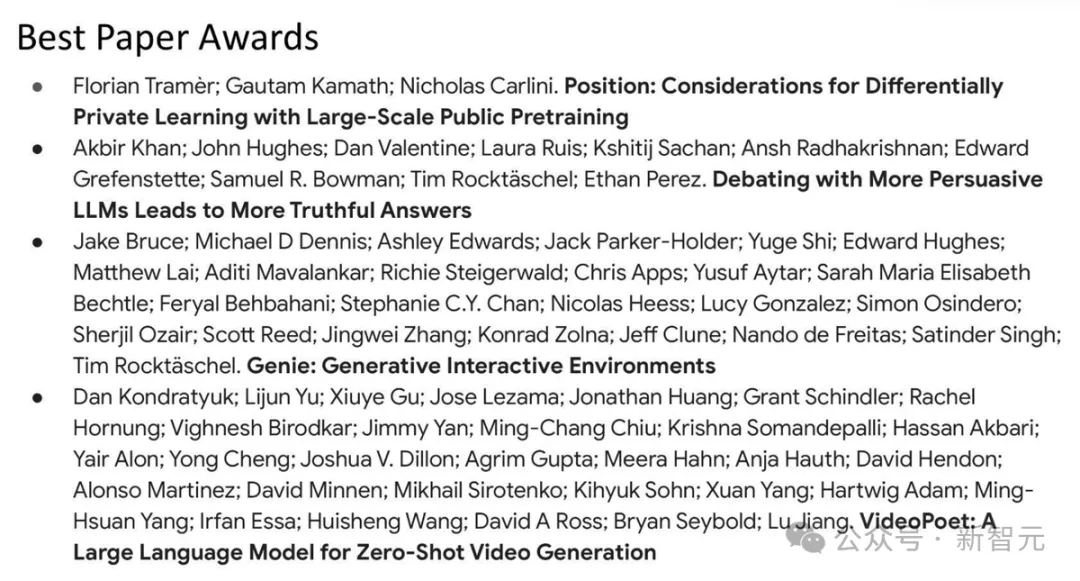

論文七:Position: Considerations for Differentially Private Learning with Large-Scale Public Pretraining

作者:Florian Tramèr,Gautam Kamath,Nicholas Carlini

機構:蘇黎世聯(lián)邦理工學院,滑鐵盧大學,Vector Institute,Google DeepMind

論文地址:https://arxiv.org/abs/2212.06470

通過利用在大型公共數據集上預訓練的非私有模型的遷移學習能力,可以顯著提升差分隱私機器學習的性能。

在這項工作中,作者質疑了使用大型網絡抓取數據集是否符合差分隱私保護。并警告稱,將這些在網絡數據上預訓練的模型稱為「private」可能會帶來諸多危害,比如削弱公眾對差分隱私這一概念的信任。

除了使用公共數據的隱私考慮之外,作者還進一步質疑了這種方法的實用性。

對于那些大到終端用戶無法在自己設備上運行的模型,預訓練的影響尤為明顯。因為這將需要將私有數據外包給計算能力更強的第三方,因此部署此類模型會對隱私造成凈損失。

最后,作者討論了隨著公共預訓練變得越來越流行和強大,隱私學習領域的潛在發(fā)展路徑。

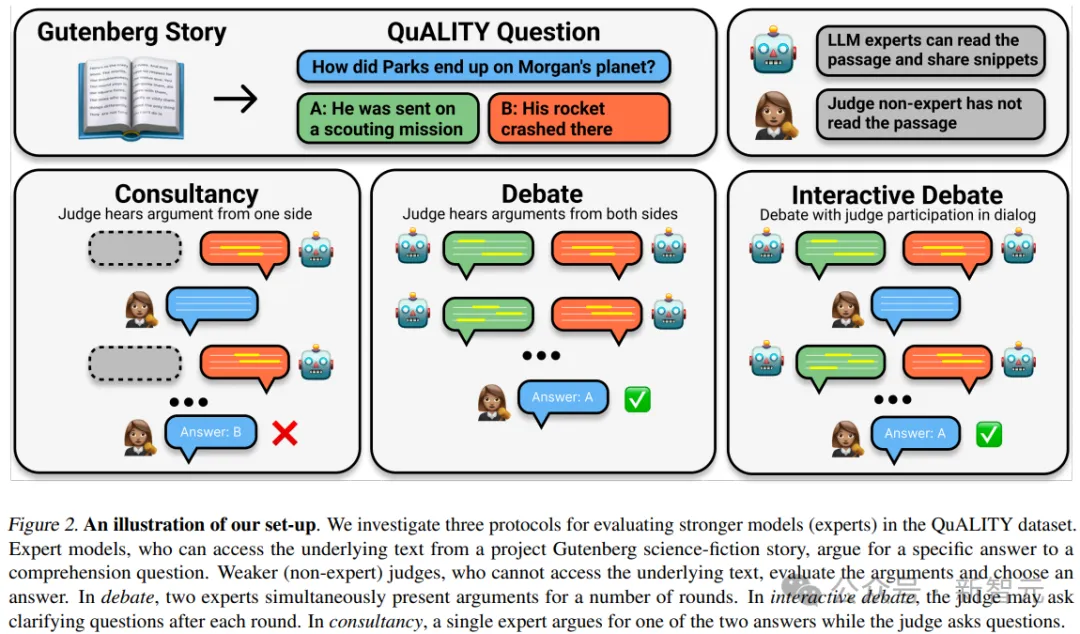

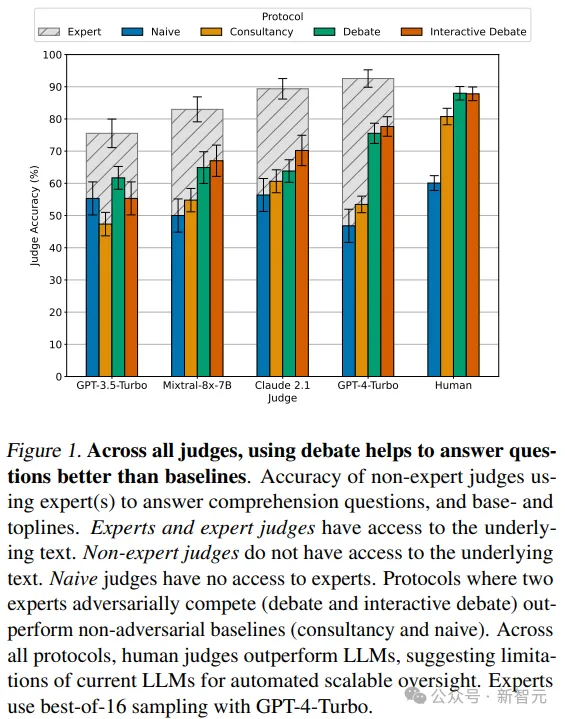

論文八:Debating with More Persuasive LLMs Leads to More Truthful Answers

作者:Akbir Khan, John Hughes, Dan Valentine, Laura Ruis, Kshitij Sachan, Ansh Radhakrishnan, Edward Grefenstette, Samuel R. Bowman, Tim Rockt?schel, Ethan Perez

機構:倫敦大學學院,Speechmatics,MATS,Anthropic,FAR AI

論文地址:https://arxiv.org/abs/2402.06782

目前常用的LLM對齊方法,嚴重依賴于人工標注的數據。

然而,隨著模型變得越來越復雜,它們將超越人類的專業(yè)知識,人工評估的角色將演變?yōu)榉菍<冶O(jiān)督專家。

基于此,作者提出了一個疑問:較弱的模型能否評估較強模型的正確性?

根據設定,較強的模型(專家)具備回答問題的必要信息,而較弱的模型(非專家)缺乏這些信息。

而評估的方法則是辯論,即兩個LLM專家各自為不同的答案辯護,而非專家選擇答案。

結果顯示,辯論始終可以幫助非專家模型和人類更好地回答問題,分別達到了76%和88%的準確率(基線分別為48%和60%)。

此外,通過無監(jiān)督方式優(yōu)化專家辯手的說服力提高了非專家在辯論中識別真相的能力。

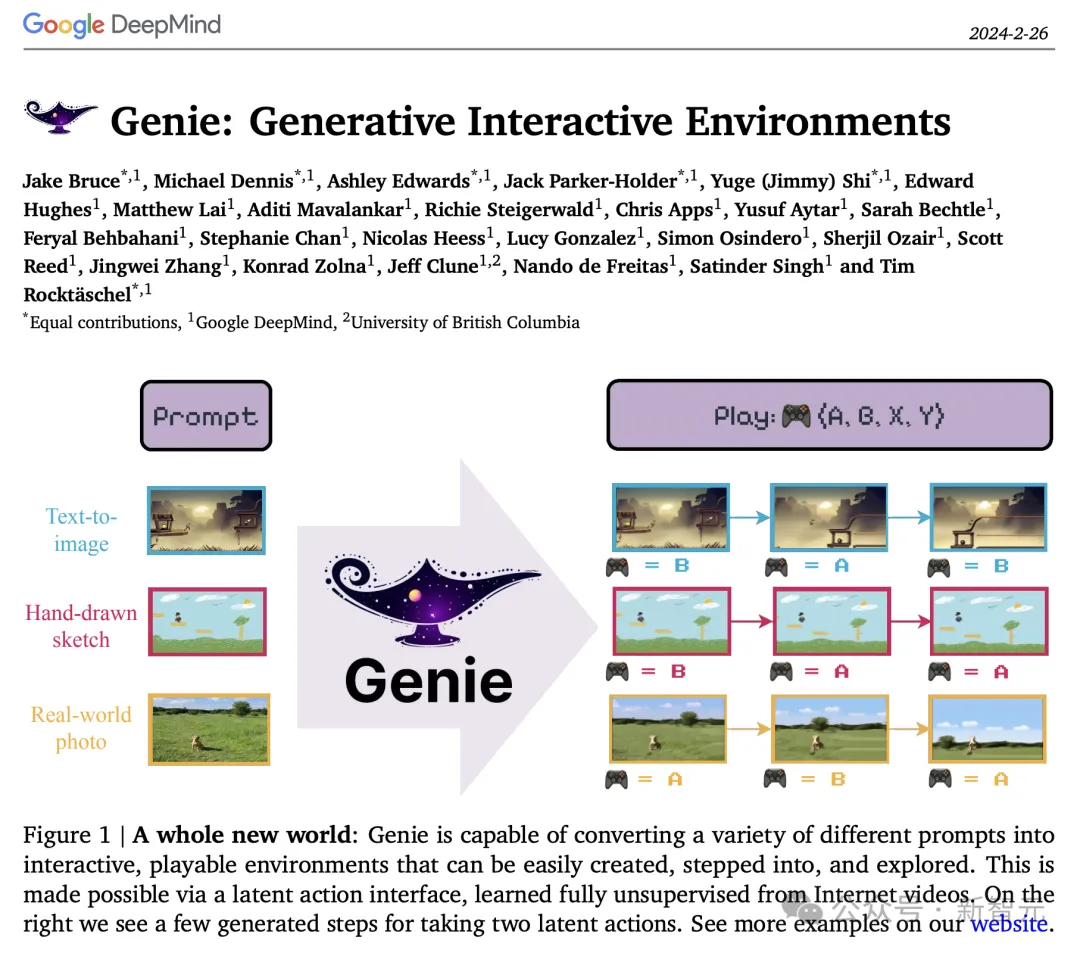

論文九:Genie: Generative Interactive Environments

作者:Jake Bruce,Michael Dennis,Ashley Edwards,Jack Parker-Holder,Yuge Shi,Edward Hughes,Matthew Lai,Aditi Mavalankar,Richie Steigerwald,Chris Apps,Yusuf Aytar,Sarah Bechtle,Feryal Behbahani,Stephanie Chan,Nicolas Heess,Lucy Gonzalez,Simon Osindero,Sherjil Ozair,Scott Reed,Jingwei Zhang,Konrad Zolna,Jeff Clune,Nando de Freitas,Satinder Singh,Tim Rockt?schel

機構:哥倫比亞大學、Google DeepMind

論文地址:https://arxiv.org/pdf/2402.15391

谷歌DeepMind團隊發(fā)布的基礎世界模型——Genie「精靈」。

從一個圖像,一張照片,一個草圖中,它就能生成一個無窮無盡的世界。

Genie的瘋狂之處在于,學習了20萬小時的未標注互聯(lián)網視頻,無需監(jiān)督即可訓練。

無需任何動作標注,便可以確定誰是主角,并讓用戶能夠在生成的世界中對其控制。

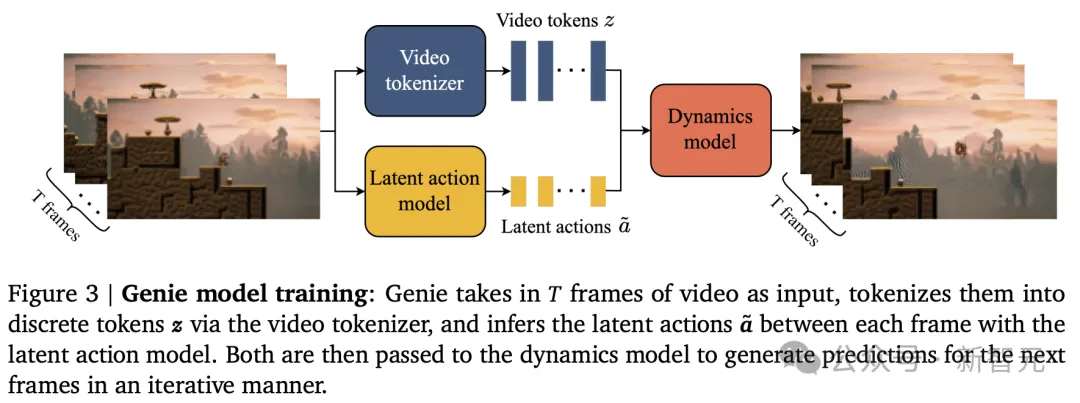

具體來說,它是通過潛動作(latent action)模型、視頻分詞器,以及自回歸動態(tài)模型三大核心組件來實現的。

由此產生的學習潛動作空間,不僅使用戶交互成為可能,而且還有助于訓練智能體模仿看不見的視頻中的行為。

總而言之,Genie為培養(yǎng)未來的通才智能體開辟了嶄新的途徑,重塑了交互式生成環(huán)境的格局。

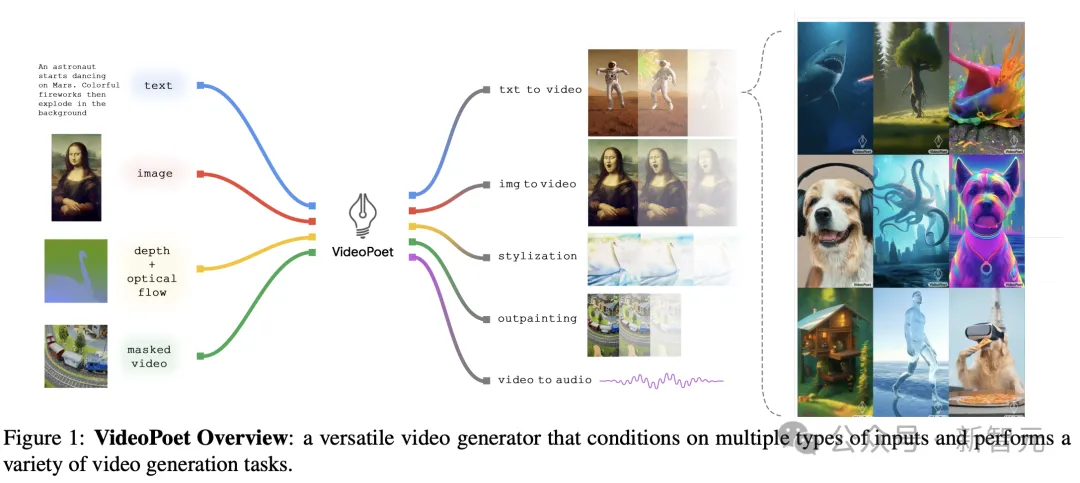

論文十:VideoPoet: A Large Language Model for Zero-Shot Video Generation

作者:Dan Kondratyuk,Lijun Yu,Xiuye Gu,José Lezama,Jonathan Huang,Grant Schindler,Rachel Hornung,Vighnesh Birodkar,Jimmy Yan,Ming-Chang Chiu,Krishna Somandepalli,Hassan Akbari,Yair Alon,Yong Cheng,Josh Dillon,Agrim Gupta,Meera Hahn,Anja Hauth,David Hendon,Alonso Martinez,David Minnen,Mikhail Sirotenko,Kihyuk Sohn,Xuan Yang,Hartwig Adam,Ming-Hsuan Yang,Irfan Essa,Huisheng Wang,David A. Ross,Bryan Seybold,Lu Jiang

機構:卡內基梅隆大學、Google

論文地址:https://arxiv.org/pdf/2312.14125

在Sora發(fā)布之前,谷歌和CMU團隊在23年12月,在技術路線上推出了與Sora相似的視頻生成技術——VideoPoet。

VideoPoet一次能夠生成10秒超長,且連貫大動作視頻,而且無需特定數據便可生成視頻。

具體來說,VideoPoet主要包含以下幾個組件:

- 預訓練的MAGVIT V2視頻tokenizer和SoundStream音頻tokenizer,能將不同長度的圖像、視頻和音頻剪輯轉換成統(tǒng)一詞匯表中的離散代碼序列。這些代碼與文本型語言模型兼容,便于與文本等其他模態(tài)進行結合。

- 自回歸語言模型可在視頻、圖像、音頻和文本之間進行跨模態(tài)學習,并以自回歸方式預測序列中下一個視頻或音頻token。

- 在大語言模型訓練框架中引入了多種多模態(tài)生成學習目標,包括文本到視頻、文本到圖像、圖像到視頻、視頻幀延續(xù)、視頻修復/擴展、視頻風格化和視頻到音頻等。此外,這些任務可以相互結合,實現額外的零樣本功能(例如,文本到音頻)。

與領先模型不同的是,VideoPoet并非基于擴散模型,而是多模態(tài)大模型,便可擁有T2V、V2A等能力。

總之,VideoPoet具備了三大優(yōu)勢:生成更長的視頻、實現更精準的控制、強大的運鏡手法。

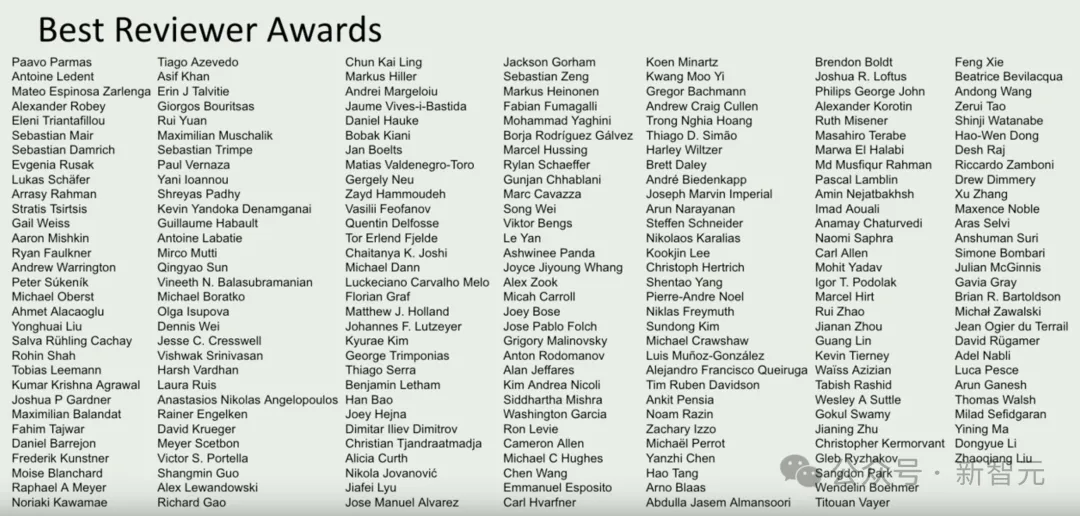

最佳審稿人獎

最好,ICML 2024大會上,還公布了最佳審稿人獎。