ECCV 2024|是真看到了,還是以為自己看到了?多模態大模型對文本預訓練知識的過度依賴該解決了

本文第一作者皮仁杰是香港科技大學三年級博士生,師從張潼教授和周曉方教授。此前獲得香港大學計算機工程學士學位。研究興趣為多模態大語言模型,以數據為中心的人工智能,以及自動化機器學習。

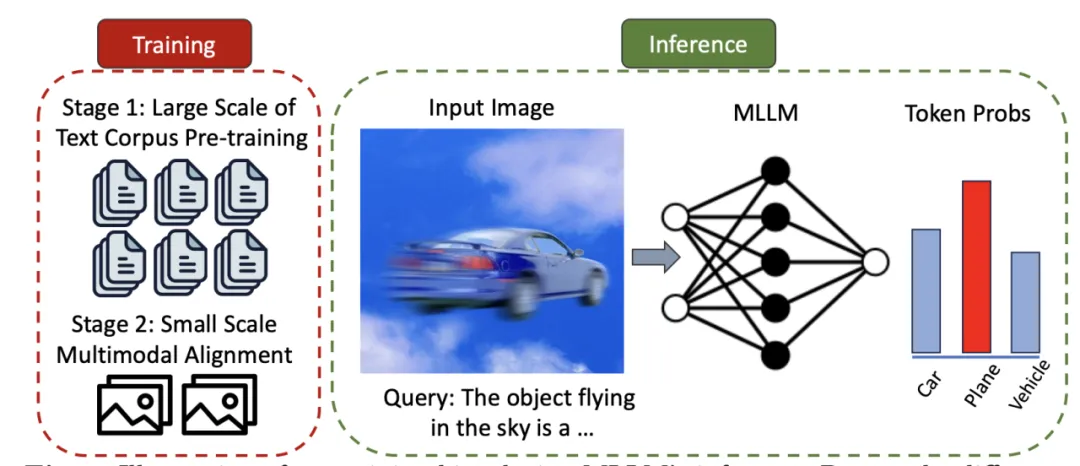

隨著大型語言模型(LLMs)的進步,多模態大型語言模型(MLLMs)迅速發展。它們使用預訓練的視覺編碼器處理圖像,并將圖像與文本信息一同作為 Token 嵌入輸入至 LLMs,從而擴展了模型處理圖像輸入的對話能力。這種能力的提升為自動駕駛和醫療助手等多種潛在應用領域帶來了可能性。

盡管 MLLMs 具有出色的圖文理解能力,但它們仍然會出現錯誤或幻覺,生成與輸入圖像不相符的相應,例如回答不存在的對象或錯誤識別屬性等。我們認為多模態大模型在不同訓練階段的數據量和訓練時間的不平衡是產生這類偏見的主要原因之一。多模態大模型的語言模塊往往使用了海量的文本數據進行預訓練,而模態對齊階段則使用更小的數據規模和更短的訓練時間。

為了解決上述問題,我們提出了一種偏好對齊方法 --Bootstrapped Preference Optimization(BPO),能在緩解多模態大模型的幻覺現象的同時提升模型的視覺理解能力。

- 論文標題:Strengthening Multimodal Large Language Model with Bootstrapped Preference Optimization

- 論文鏈接:https://arxiv.org/pdf/2403.08730

- 代碼鏈接:https://github.com/pipilurj/bootstrapped-preference-optimization-BPO-

具體來講,我們設計了兩種方法去自動構建偏好學習的負樣本,使得多模態模型對與訓練的過度依賴暴露出來。之后,我們用原本的數據標注當作正樣本,對多模態模型進行偏好微調。總的來說,我們的主要貢獻有:

1. 我們提出了一種新的視角,將多模態對齊問題轉化為偏好學習任務,其中預訓練偏見和視覺理解能力被視為舊的和新的偏好;

2. 我們介紹了一種自動化構建大規模偏好數據集的方法。通過該方法能構造出大量帶有預訓練偏見信息的負面樣本;

3. 在大量實驗上證明了我們的方法能有效地提升多模態大模型對于圖像的認知能力,訓練后的模型在多個基準測試中性能得到提升。

可擴展的偏好數據集構建

對于偏好數據集的正面樣本,已經有許多為監督微調而設計的現成數據集,例如通過 LlaVA 和 MiniGPT4 生成的高質量標注問答數據、ShareGPTV 利用強大的 GPT4-V 作為工具為圖像生成高質量標題。我們將這些已標注完成的公開數據集作為偏好數據集中的正面響應,在保證高質量數據對的同時避免了昂貴的人工標注。

為了能收集到能反映預訓練偏見的負面響應數據,我們提出了兩種方法。

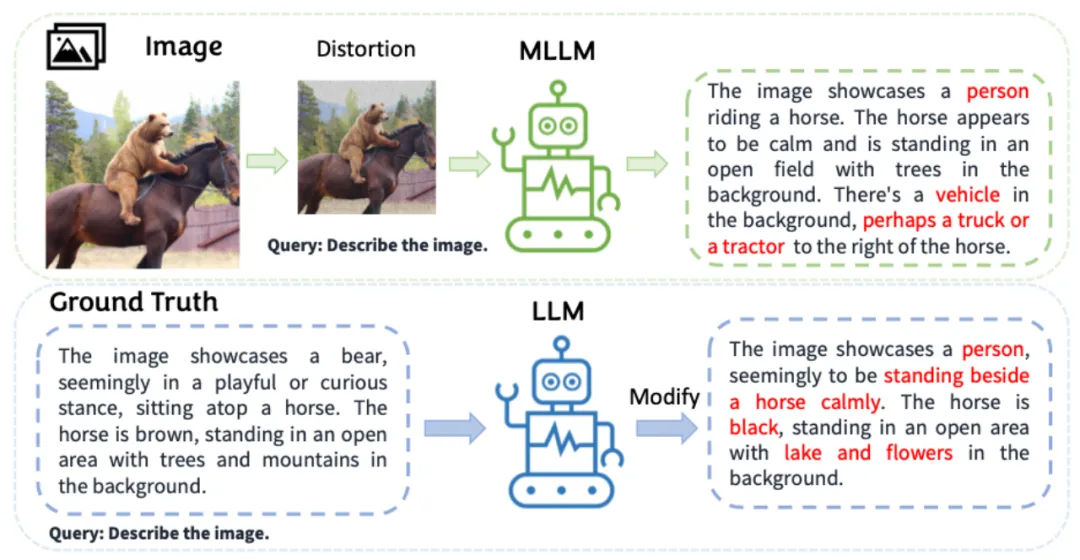

a. 弱化圖像提示:我們給偏好數據集中的圖片數據加上噪聲,以此破壞圖像特征,使多模態大模型在回答時更傾向原始的預訓練分布,由此產生的錯誤響應會包含 LLM 模塊的固有偏見。從圖中可以看到,我們通過像圖片中加入不同程度的噪聲,正確答案出現的概率就越小,帶有預訓練偏見的答案出現的概率也就越大。

b. 錯誤注入:我們要求多模態大模型對應的大語言模型直接改寫響應,要求模型生成與答案相近但不完全一樣的錯誤回答。

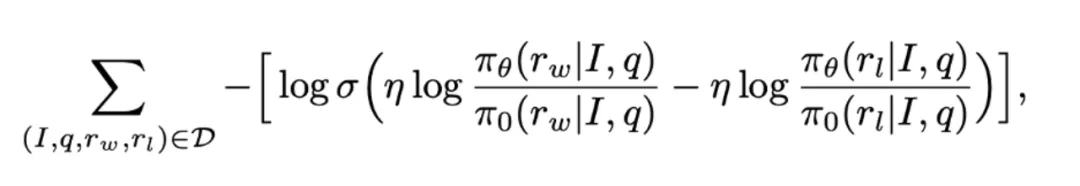

接下來,我們采用直接偏好優化(DPO)對多模態模型進行優化:

實驗評估

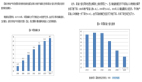

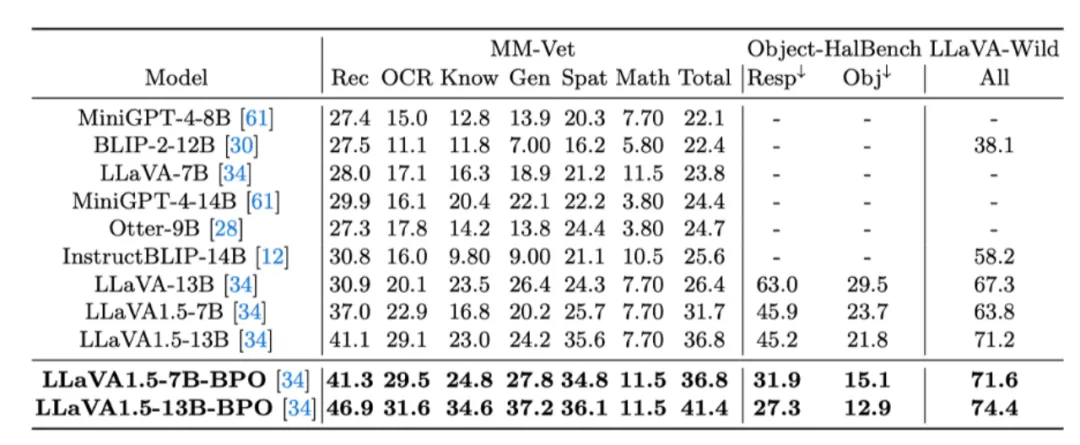

我們采用經過 BPO 微調過后的 LLaVA 模型(LLaVA-7B-BPO 和 LLaVA-13B-BPO)在 MM-Vet,LLaVA-Wild 和 Object HalBench 上測試。MM-Vet 和 LlaVA-Bench 是專門用來衡量模型綜合能力的榜單,Object HalBench 則是評估多模態大模型的視覺可信度。

實驗結果表明,經過 BPO 微調后的模型在三個基準測試榜單的所有任務中均取得領先。在大多數任務上,LLaVA-7B-BPO 的表現甚至超過了未曾微調的 LLaVa1.5-13B 模型。

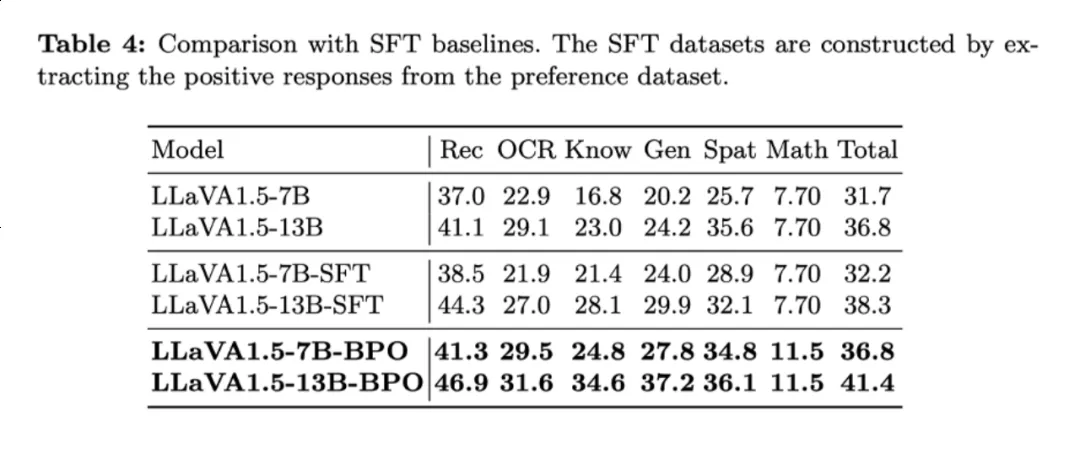

我們還將 BPO 與監督微調訓練(SFT)進行對比。我們通過直接使用數據集中的正樣本作為監督數據對模型進行微調。實驗表明經過 BPO 微調過的多模態大模型在不同類別的子任務下的表現均優于 SFT 微調。

在定性結果上,我們對比了 BPO 微調前后多模態大模型的表現。我們發現經過 BPO 微調后的模型能生成更忠誠于圖像輸入的答案,并且包含更少錯誤信息。

在定性結果上,我們對比了 BPO 微調前后多模態大模型的表現。我們發現經過 BPO 微調后的模型能生成更忠誠于圖像輸入的答案,并且包含更少錯誤信息。

更多研究細節,可參考原論文。