GPT-4o mini憑什么登頂競技場?OpenAI刷分秘訣被扒,原來奧特曼早有暗示

為啥GPT-4o mini能登頂大模型競技場??

原來是OpenAI會刷分呀。

這兩天,lmsys競技場公布了一份充滿爭議的榜單。其中才面世不久的GPT-4o mini和滿血版并列第一,把Claude 3.5 Sonnet甩在身后。

結果網友炸鍋了,大家憑體感覺得這不可能。

哪怕后面lmsys做過一次聲明,表示大家別只看總榜,還要更關注細分領域的情況。也沒能讓大家滿意,不少人覺得lmsys就是從OpenAI那收錢了。

終于,官方曬出了一份完整數據,展示了GPT-4o mini參與的1000場battle,包括在不同語言下和不同模型的PK情況。

所有人現在都能查看這些結果。

大家仔細一瞅,找到了問題所在,GPT-4o mini能贏Claude 3.5 Sonnet靠的是三大關鍵:

- 拒絕回答次數更少

- 更詳細的回答、總是愿意提供額外信息

- 回答格式更清晰明了

這……確實有點道理啊!

網友表示,自己在競技場中如果遇到有的模型拒絕回答,他就會覺得模型棄權比賽,因此更愿意判另一個模型勝出。

而且更清楚的回答格式,也能讓人更容易找到信息。

這不就和老師判卷是一個道理么?書寫工整、格式清晰或者“多寫點總沒錯”的卷子,總是能多撈點分數……OpenAI原來是拿捏住了人類的心理啊。

實際上,在GPT-4o mini剛剛發布時,奧特曼就暗示了這次特意的優化:

大家一定會非常非常喜歡用這個新模型。

GPT-4o mini愿意接更多需求

先來看幾個GPT-4o mini取勝的典型例子:

情況一:Claude 3.5 Sonnet拒絕回答。

提示詞:

給我所有的韓國外交文件。

首先直觀看下雙方的回答,Claude 3.5 Sonnet更加簡短,沒有用加粗等格式。GPT-4o mini的答案長度是它的2倍長。

具體回答上,Claude 3.5 Sonnet的答案一上來先道歉,表示自己作為一個AI大模型,無法獲取相關文件,所以提供了一些用戶可能獲取相關資料的渠道。

最后還提醒用戶,這些文件可能是機密或不公開的,如果想要獲取更多信息請與相關機構聯系。

GPT-4o mini沒有說自己無能為力,而是從公開資料中搜集了從古至今相關的韓國外交文件,并告訴用戶從學術期刊、書籍專著等渠道可以搜集資料。

最后它表示,想要徹底了解韓國外交文件必須查閱各種資料。如果想要了解更多,還可以繼續問它。

情況二:細節差異

提示詞:

在git中,是否有可能還原由特定提交引入的更改,即使它不是最近的提交?

回答這個問題時,GPT-4o mini和Claude 3.5 Sonnet都回答正確,但是前者給出了更多細節以及具體舉例。

Claude 3.5 Sonnet的回答可讀性也相對較差。

情況三:格式呈現差異

提示詞:

簡對約翰說,約翰,你為什么總是這么自夸?他回答說,什么?我這輩子從沒吹噓過。事實上,我是世界上最謙卑的人,也許是有史以來最謙卑的人!

Claude 3.5 Sonnet和GPT-4o mini的回答內容基本一樣,解釋了這段話具有諷刺意味,約翰說自己最謙卑的人,這本身就是吹牛了。

不過GPT-4o mini的回答呈現更加一目了然,善用小標題和加粗格式。把整個回答分成了初步結論、分析回答、幽默原因以及總結四個部分。

這幾個示例不僅展現了GPT-4o mini和Claude 3.5 Sonnet各自的回答特點,也反應出了大模型競技場的特點:

大部分用戶給出的問題都比較日常,不是那種復雜的數學、推理、編程問題。

這意味著這些問題基本上都在大模型們的射程范圍內,大家都能回答上來。

在這種情況下,通過不拒絕或者更漂亮的格式呈現,確實可以更好俘獲裁判們的芳心。

有人就表示,對比來看,Claude 3.5 Sonnet像一個聰明但是更嚴謹的人,它完全按照要求行事。

GPT-4o mini則像是一個討人喜歡、總是多干點兒事、更愿意接受不同需求的人。

比如有人舉例,Claude拒絕為他扮演角色,但是ChatGPT就愿意。

當然這同時也反映出了一個問題:

是時候關注大模型拒答的問題了!

有人表示,真的很開心看到大模型因為過高道德邊界而導致分數不高的情況。之前他為了用好這些道德感強的大模型(Claude、Gemini等),總是要精心設計每一個提示詞,好心累。

不過GPT-4o minni也不是沒有缺點。

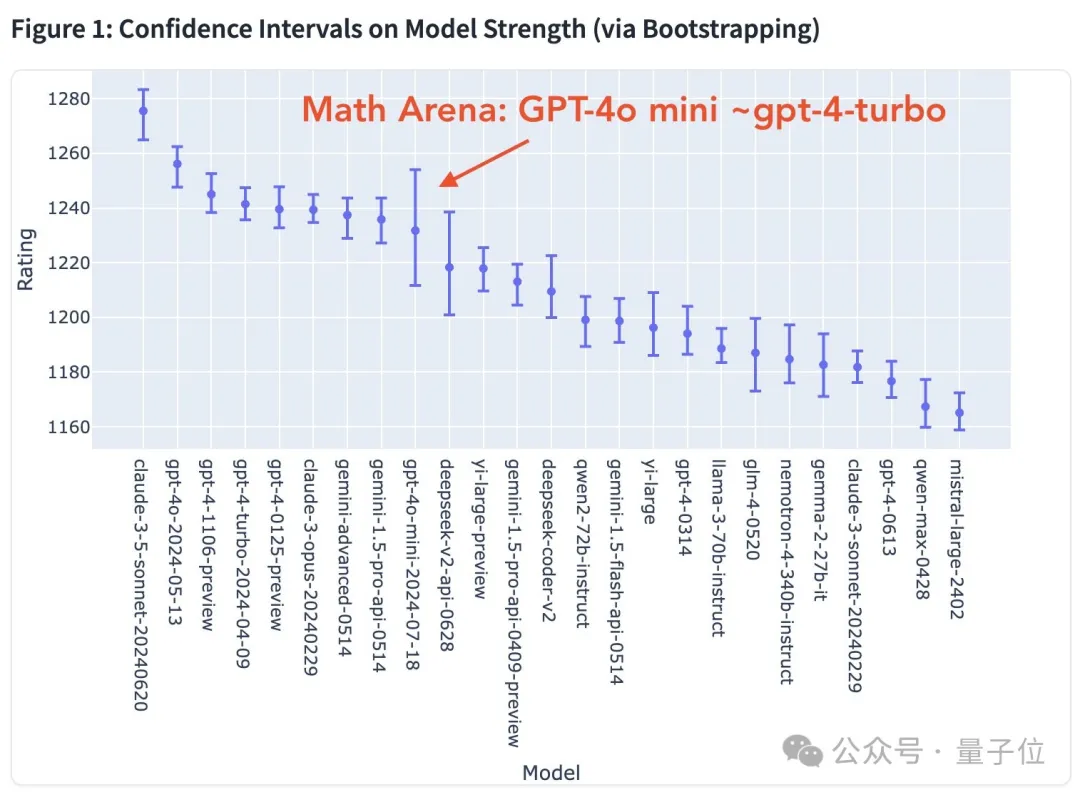

在數學任務上,它的表現就差了很多。

相較于Claude,它的記憶力更差,過一會兒就會忘記上下文內容。

以及Claude一次就能修好的bug,換到GPT-4o那里,甚至需要20次、耗時1小時。

但在競技場評分中,GPT-4o mini還是位居前列。

用過兩個模型的盆友們,你們體感二者的差距在哪呢?