買不到GPU,馬斯克自曝AI巨獸Dojo!自研超算挑戰英偉達,約等于8千塊H100

為了訓出最強Grok 3,xAI耗時19天,打造了由10萬塊H100組成的世界最大超算集群。

而在訓練FSD、擎天柱機器人方面,馬斯克同樣不惜重金,投入了大量的計算資源。

超算Dojo,是特斯拉AI的基石,專為訓練FSD神經網絡而打造。

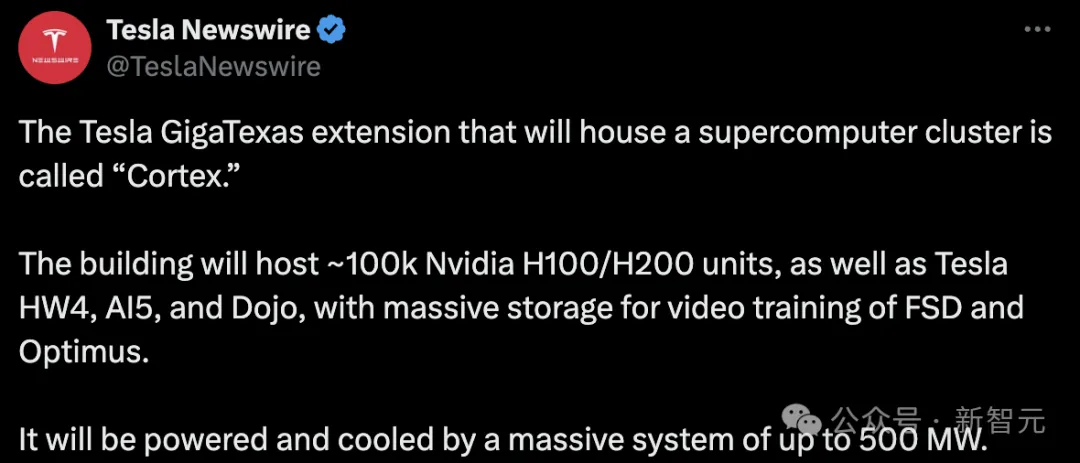

就在今天,他在德州超級工廠(Cortex)參觀了特斯拉的超級計算機集群。

馬斯克稱,「這將是一個擁有約10萬個H100/H200 GPU,并配備大規模存儲的系統,用于全自動駕駛(FSD)和Optimus機器人的視頻訓練」。

不僅如此,除了英偉達GPU,這個超算集群中還配備了特斯拉HW4、AI5、Dojo系統。

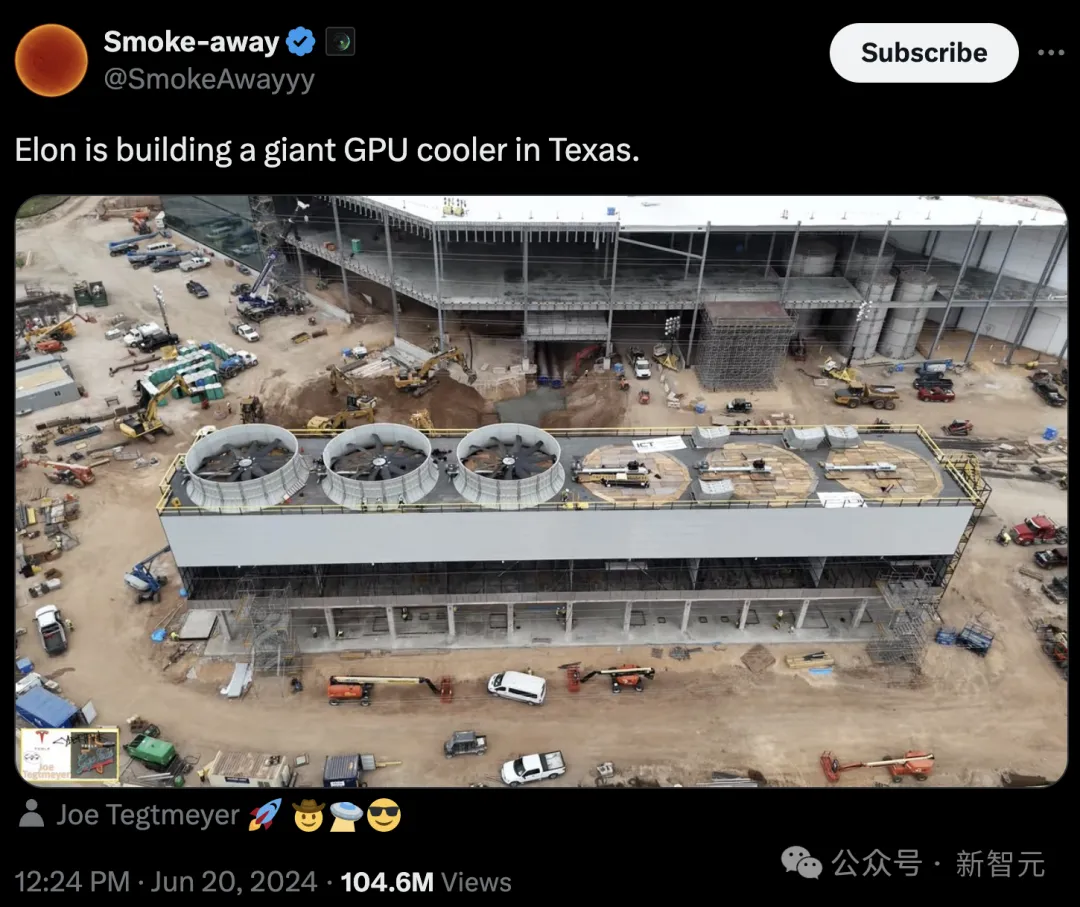

它們將由一個高達500兆瓦的大型系統提供電力和冷卻。

2021年特斯拉AI Day上,馬斯克首次對外宣布Dojo。

如今三年過去了,Dojo建得怎樣了?

8000塊H100等價算力,加倍下注

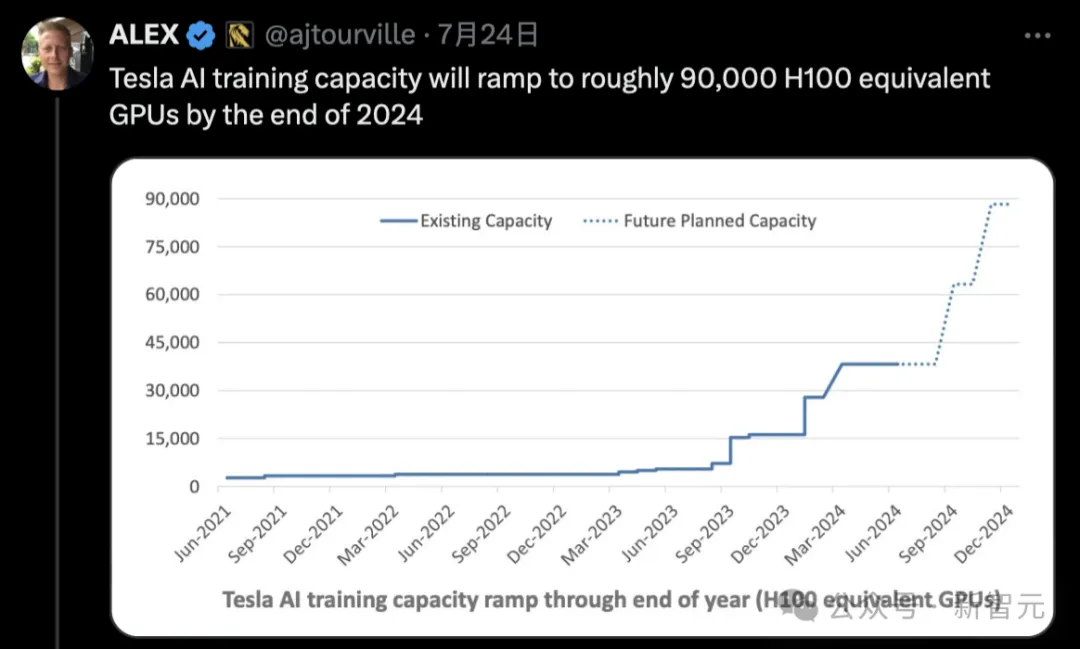

半個月前,網友稱2024年年底,特斯拉擁有AI訓練算力,等價于9萬塊H100的性能。

馬斯克對此做了一些補充:

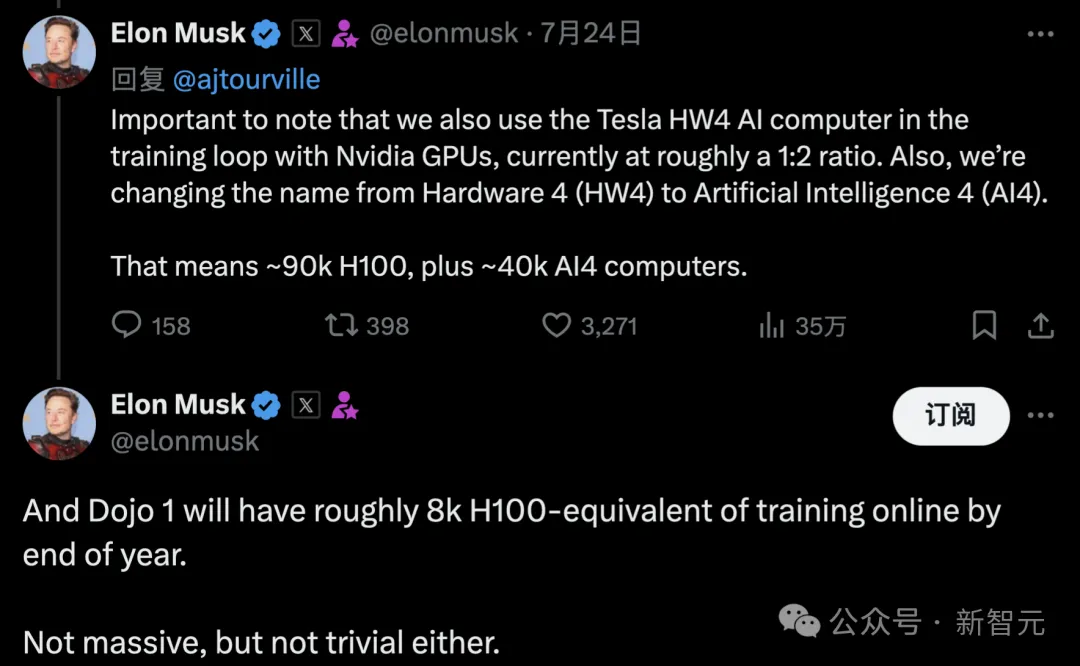

我們在AI訓練系統中不僅使用英偉達的GPU,還使用自己的AI計算機——Tesla HW4 AI(更名為AI4),比例大約為1:2。

這意味著相當于有大約9萬個H100,加上大約4萬個AI4計算機。

他還提到,到今年年底,Dojo 1將擁有大約8000個相當于H100算力。這個規模不算龐大,但也不算小。

Dojo D1超算集群

其實在去年6月,馬斯克曾透露Dojo已經在線并運行了幾個月的有用任務。

這已經暗示著,Dojo已經投入到一些任務的訓練中。

最近,在特斯拉財報會議上,馬斯克表示特斯拉準備在10月推出自動駕駛出租車,AI團隊將「加倍投入」Dojo。

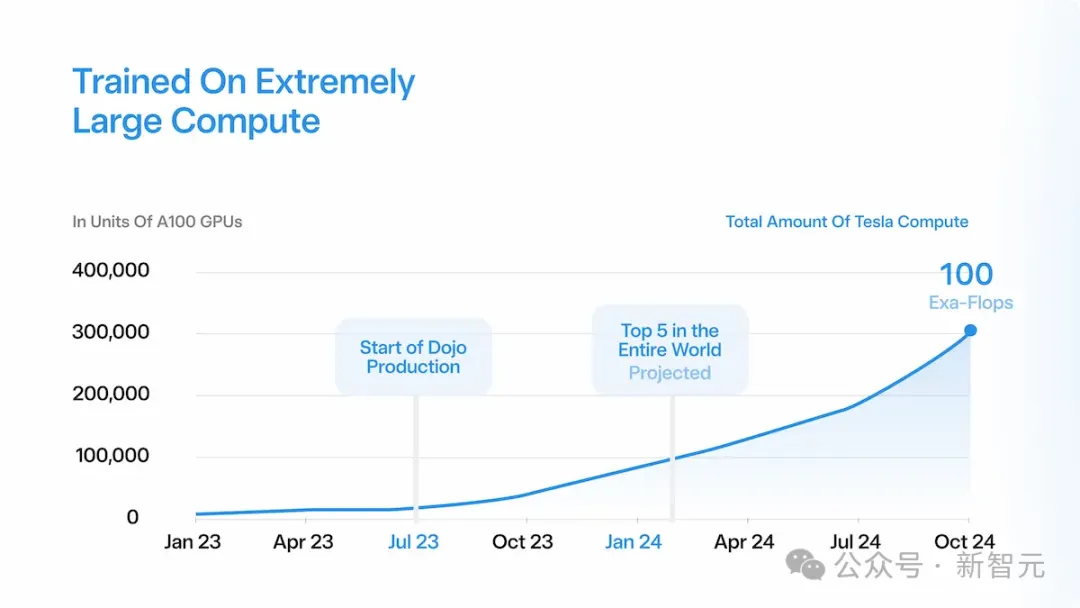

預計Dojo的總計算能力,將在2024年10月達到100 exaflops。

假設一個D1芯片可以實現362 teraflops,要達到100 exaflops,特斯拉將需要超過27.6萬個D1芯片,或者超過32萬英偉達A100 GPU。

500億晶體管,D1已投產

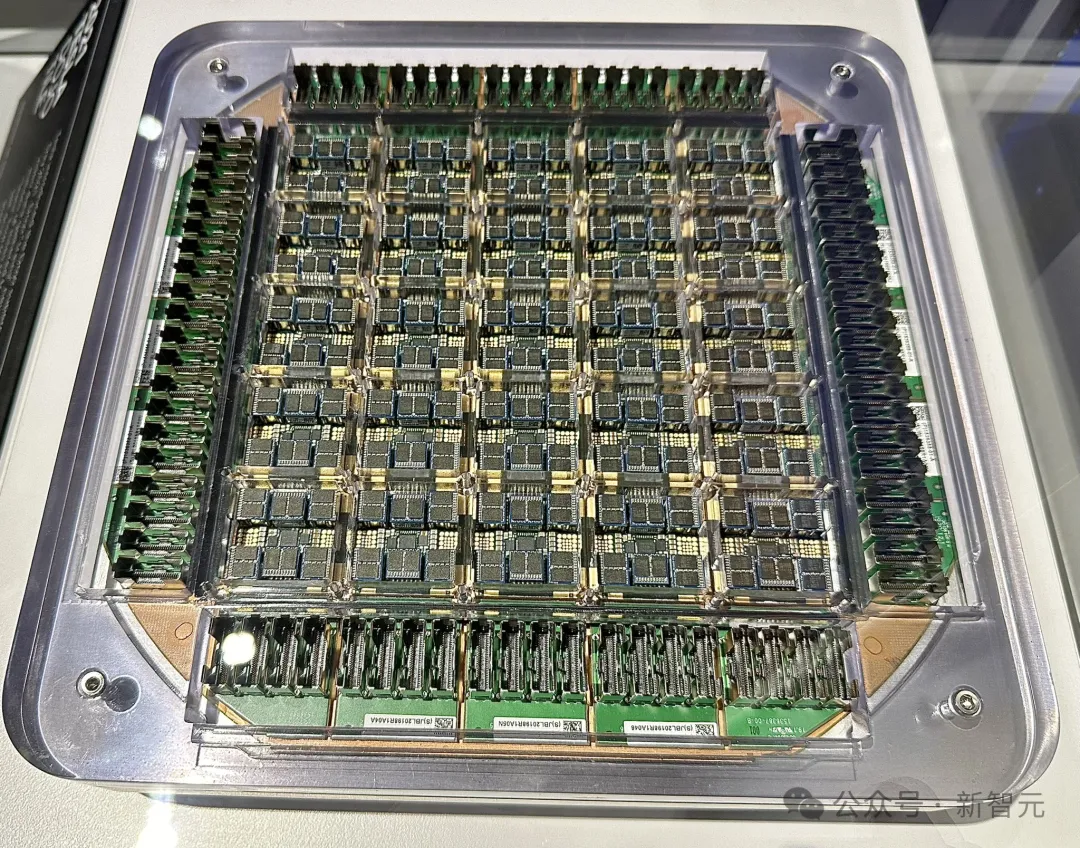

2021年特斯拉AI Day上,D1芯片初次亮相,擁有500億晶體管,只有巴掌大小。

它具備了強大和高效的性能,能夠快速處理各種復雜的任務。

今年5月,D1芯片開始投產,采用臺積電7nm工藝節點。

Autopilot前硬件高級總監Ganesh Venkataramanan曾表示,「D1可以同時進行計算和數據傳輸,采用定制ISA指令集架構,并針對機器學習工作負載進行了充分優化」。

這是一臺純粹的機器學習的芯片。

盡管如此,D1仍沒有英偉達A100強大,后者同樣采用了臺積電7nm工藝制造。

D1在645平方毫米的芯片上放置了500億個晶體管,而A100包含540億個晶體管,芯片尺寸為826平方毫米,性能領先于D1。

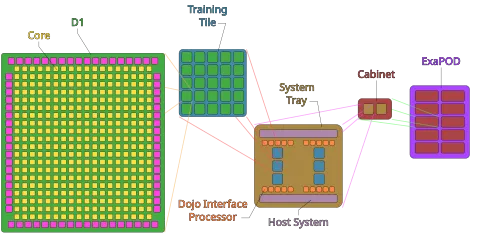

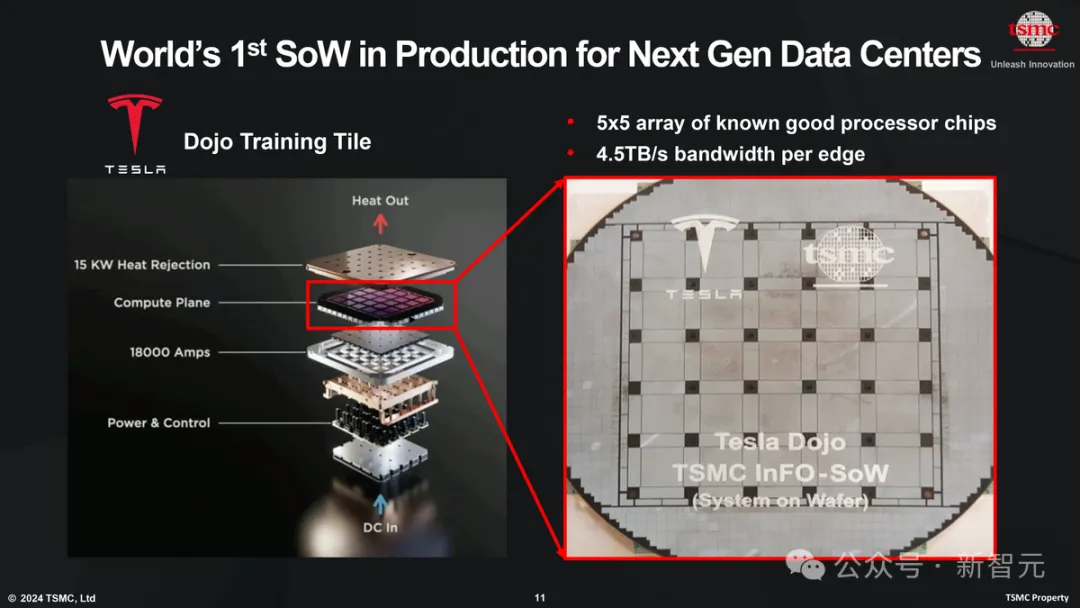

為了獲得更高的帶寬和算力,特斯拉AI團隊將25個D1芯片融合到一個tile中,將其作為一個統一的計算機系統運作。

每個tile擁有9 petaflops的算力,以及每秒36 TB的帶寬,并包含電力源、冷卻和數據傳輸硬件。

我們可以將單個tile視為,由25臺小型計算機組成的一臺自給自足的計算機。

通過使用晶圓級互連技術InFO_SoW(Integrated Fan-Out,System-on-Wafer),在同一塊晶圓上的25塊D1芯片可以實現高性能連接,像單個處理器一樣工作。

6個這樣的tile構成一個機架(rack),兩個機架構成一個機柜(cabinet)。

十個機柜構成一個ExaPOD。

在2022年AI Day中,特斯拉表示,Dojo將通過部署多個ExaPOD進行擴展。所有這些加在一起構成了超級計算機。

晶圓級處理器(wafer-scale processor),比如特斯拉的Dojo和Cerebras的晶圓級引擎WSE,比多處理器(multi-processor)的性能效率要高得多。

前者的主要優點包括內核之間的高帶寬和低延遲通信、較低的電網阻抗以及更高的能源效率。

目前,只有特斯拉和Cerebras擁有晶圓上系統設計。

然而,將25個芯片放在一起對電壓挑戰和冷卻系統也是不小的挑戰。

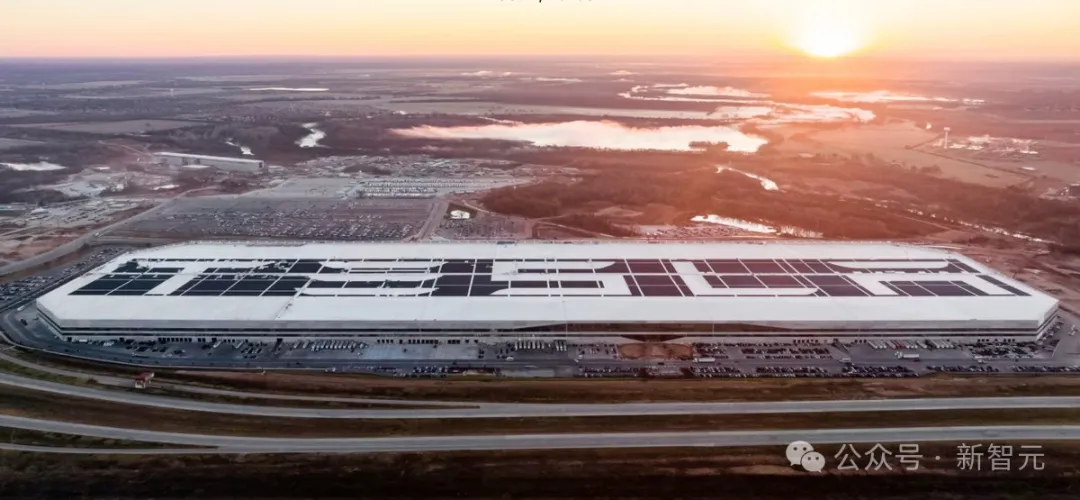

網友拍到特斯拉在德州建設巨型冷卻系統

晶圓級芯片的固有挑戰還在于,必須使用片上內存(on-chip memory),這不夠靈活,可能無法滿足所有類型的應用。

Tom's Hardware預測, 下一代使用的技術可能是CoW_SoW(Chip-on-Wafer),在tile上進行3D堆疊并集成HBM4內存。

此外,特斯拉還在研發下一代D2芯片,為了破解信息流難題。

與連接單個芯片不同,D2將整個Dojo tile放在了單個硅晶圓上。

到2027年,臺積電預計將提供更復雜的晶圓級系統,計算能力預計將提升超過40倍。

自D1發布以來,特斯拉既沒有公開已訂購、預期接收的D1芯片訂單情況,也沒有公開Dojo超算的具體部署時間表。

不過在今年6月份的時候,馬斯克曾表示,在未來18個月,一半部署特斯拉AI硬件,一半是英偉達/其他硬件。

其他硬件,也可能是AMD。

為什么需要Dojo

自動駕駛耗算力

在我們的印象中,特斯拉的主業僅限于生產電動汽車,再附帶一些太陽能電池板和儲能系統的業務。

但馬斯克對特斯拉的期望遠遠不止于此。

大多數自動駕駛系統,比如谷歌母公司Alphabet旗下的Waymo,仍舊依靠傳統的感知器作為輸入,比如雷達、激光雷達和攝像頭等。

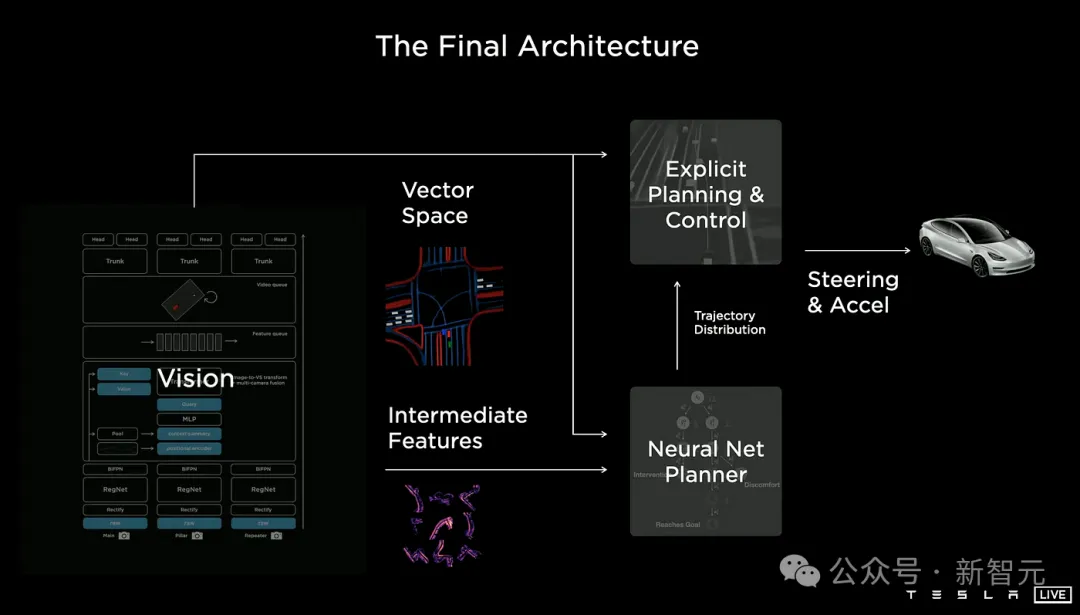

但特斯拉采取的是「全視覺」路徑,他們僅依靠攝像頭捕捉視覺數據,輔以高清地圖進行定位,再使用神經網絡處理數據以進行自動駕駛的快速決策。

直觀來看,顯然前者是一種更簡單快捷的路徑,事實也的確如此。

Waymo已經實現了L4級自動駕駛的商業化,即SAE所定義的,在一定條件下下無需人工干預即可自行駕駛的系統。但特斯拉的FSD(Full Self-Driving)神經網絡仍無法脫離人類操作。

Andrej Karpathy曾在特斯拉擔任AI負責人,他表示,實現FSD基本是在「從頭開始構建一種人造動物」。

我們可以將其理解為人類視覺皮層和大腦功能的數字復制。FSD不僅需要連續收集和處理視覺數據,識別、分類車輛周圍的物體,還需要有與人類相當的決策速度。

由此可見,馬斯克想要的絕不只是能盈利的自動駕駛系統而已。他的目標,是打造一種新智能。

但幸運的是,他幾乎不太需要擔心數據不夠的問題。目前大約有180萬人為FSD支付了8000美元的訂閱費(之前可達1.5萬美元),這意味著特斯拉能收集到數百萬英里的駕駛視頻用于訓練。

而算力方面,Dojo超算就是FSD的訓練場。它的中文名字可以翻譯為「道場」,是對武術練習空間的致敬。

英偉達不給力

英偉達GPU有多搶手?看看各大科技巨頭的CEO有多想跟老黃套近乎就知道了。

即便財大氣粗如馬斯克,也會在7月的財報電話會上承認,自己對特斯拉可能沒法用上足夠的英偉達GPU感到「非常擔憂」。

「我們看到的是,對英偉達硬件的需求如此之高,以至于通常很難獲得GPU。」

目前,特斯拉似乎依舊使用英偉達的硬件為Dojo提供算力,但馬斯克似乎不想把雞蛋都放在一個籃子里。

尤其是考慮到,英偉達芯片的溢價如此之高,而且性能還不能讓馬斯克完全滿意。

在硬件與軟件協同這方面,特斯拉與蘋果的觀點類似,即應該實現兩者的高度協同,尤其是FSD這種高度專門化的系統,更應該擺脫高度標準化的GPU,使用定制硬件。

這個愿景的核心,是特斯拉專有的D1芯片,于2021年發布,今年5月開始由臺積電量產。

此外,特斯拉還在研發下一代D2芯片,希望將整個Dojo塊放在單個硅片上,解決信息流瓶頸。

在第二季度財報中,馬斯克指出,他看到了「通過Dojo與英偉達競爭的另一條途徑」。

Dojo能成功嗎

即便自信如馬斯克,在談到Dojo時,也會支支吾吾地表示,特斯拉可能不會成功。

從長遠來看,開發自己的超算硬件可以為AI部門開拓新的商業模式。

馬斯克曾表示,Dojo的第一個版本將為特斯拉的視覺數據標注和訓練量身定制,這對FSD和訓練特斯拉的人形機器人Optimus來說非常有用。

而未來版本將更適合通用的AI訓練,但這不可避免地要踏入英偉達的護城河——軟件。

幾乎所有的AI軟件都是為了與英偉達GPU配合使用,使用Dojo就意味著要重寫整個AI生態系統,包括CUDA和PyTorch。

這意味著,Dojo幾乎只有一條出路——出租算力,建立類似于AWS和Azure一樣的云計算平臺。

摩根士丹利在去年9月的報告中預測,Dojo可以通過robotaxi和軟件服務等形式釋放新的收入來源,為特斯拉的市值增加5000億美元。

簡言之,從目前馬斯克對硬件的謹慎配比來看,Dojo并非「孤注一擲」而更像是一種雙重保險。但一旦成功,也可以釋放巨大紅利。