作者 | 沈旸

出品 | 51CTO技術棧(微信號:blog51cto)

對于技術泡沫,大家可能最熟悉的就是Gartner的技術成熟度曲線圖。過去幾年確實出現了許多備受關注的技術,例如云計算、大數據、區塊鏈和元宇宙。新技術讓人激動,但很多企業在跟進這些技術時往往猶豫不決,擔心不下注未來會被淘汰,也擔心投入巨大但方向錯誤。

例如,前幾年Facebook押注元宇宙,甚至將公司名稱改為Meta,但元宇宙的技術成熟度和市場發展并未達到預期。幸好,Meta公司在大模型時代及時調整方向,特別是在開源大模型上為社區做出了巨大貢獻。那么,這次大模型的技術發展周期是怎樣的,會出現短期見頂的情況嗎?

圖片

圖片

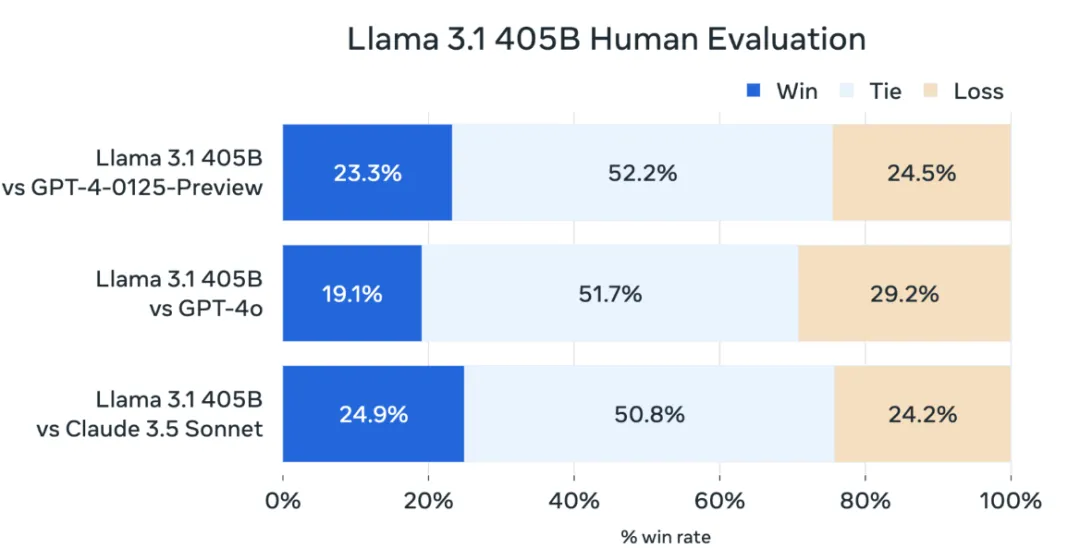

Meta于7月23日發布了Llama 3.1 405B開源人工智能模型,這是Meta迄今為止最強大的模型,也是目前全球最強大的開源大模型。在某些方面,超大杯Llama 3.1 405B超過了GPT-4 0125,與GPT-4o和Claude 3.5互有勝負。例如,它在NIH/Multi-Needle基準測試中的得分為98.1,在ZeroScrolls/Quality基準測試中的得分為95.2,在處理長文本方面表現出色,在Human-Eval基準測試中也略占上風。

圖片

圖片

從最終效果來看,大力仍能出奇跡,Scaling Law依然有效。在Llama3.1的大模型中,70B和8B大小參數的模型也比之前的版本有了非常大的性能提升,這兩個規模的開源模型非常適合企業部署。

從2022年底OpenAI推出大模型后,從一開始的聊天應用,到后來的RAG,Agent,多模態,視頻處理等,AI的應用落地實踐其實是越來越成熟,開源的大模型也被廣泛應用在企業的各種業務場景中。

但是由于所有的大模型都幾乎用同一套標準的接口,使得大模型很難像傳統軟件那樣打造專屬的生態圈,從而建立競爭護城河。用戶從一個大模型切換到另外一個大模型,幾乎不需要什么成本,每個月都會有更新更好用成本更低的大模型出來。這也使得市場和投資界對大模型的商業價值持懷疑態度,認為其發展可能類似于幾年前的各種技術概念泡沫。

圖片

圖片

Llama 3.1 405 模型是在一個包含了16384 塊Nvidia H100 80GB GPU 集群上訓練了整整54天,其中出現了417 次意外中斷。如果按照每小時每張卡3美金的H100租賃成本,加上CPU、內存、磁盤、網絡等硬件資源每小時預計5美金的成本來算,這次訓練就需要1億美金的硬件成本。再加上數據購買、人工訓練、維護和調優的費用,一次大模型的訓練成本可能超過2億美金。而目前SpaceX發射一次星艦火箭的成本也不到一億美金,這已經是當前商業航天里運力最強的火箭。

圖片

圖片

目前,人類正以極大的熱情投入AI領域,受益于AI的火熱,英偉達的股價在兩年內上漲了10倍以上,市值超過3萬億美元。每個月都有企業宣布推出新的大模型,消耗了幾個小目標,不斷地刷新榜單。這不禁讓大家聯想到20世紀60年代美蘇爭霸時期的太空競賽。

1957年,蘇聯成功發射世界上第一顆人造衛星——斯普尼克一號。1958年,蘇聯宇航員尤里·加加林成為第一個進入太空的人,乘坐東方1號(Vostok 1)繞地球飛行。這一事件引發了美國的極大震驚和反應,美國總統艾森豪威爾簽署了《國家航空航天法》,成立了美國國家航空航天局(NASA),以應對蘇聯在太空競賽中的領先地位。

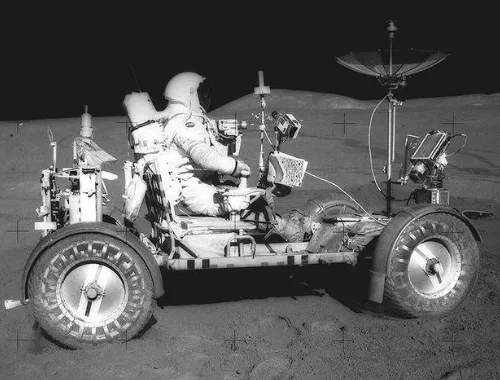

在1969年,美國成功實現了載人登月計劃。阿波羅11號任務中,尼爾·阿姆斯特朗(Neil Armstrong)和巴茲·奧爾德林(Buzz Aldrin)成為首批登上月球的人類。阿波羅計劃共進行了17次任務,其中6次成功登月,最后一次是1972年的阿波羅17號。阿波羅計劃的實際支出略高于預算,大約為257億美元。按現值計算,其花費相當于2000億美元,但它實現了人類歷史上的重大突破。太空競賽的角逐中,除了航天技術以外,還推動了計算機技術、材料科學和通信技術的進步,我們今天非常多的技術都孵化于當年的太空探索。

圖片

圖片

很多人可能會很好奇,既然登月計劃那么成功,人類為什么沒有繼續轉向火星和更遠的太空呢?首先,技術上的挑戰遠超預期。火星距離地球遙遠得多,火星到地球的距離約為月亮到地球距離的586倍;長達數月甚至數年的航行時間,以及在陌生星球上生活所需的復雜生命支持系統,都給科學家們帶來了前所未有的難題。其次,高昂的成本也是一個無法忽視的因素,預計火星任務的預算將至少比阿波羅計劃高10倍以上。現實是資源有限,必須優先處理地球上的諸多問題,地球上即使是生存條件最惡劣的地方也比月球和火星更宜居。

盡管當時的各國政府和科學家們對太空探索都充滿熱情,但下一個目標跨度太大、成本太高,讓單純的刷榜行為失去了動力。阿波羅登月這一事件被認為是太空競賽的巔峰,之后美蘇的競爭反而轉向了地球軌道空間站和無人深空探測等方向。

圖片

圖片

目前,大模型的訓練可能也會遇到類似的瓶頸,那就是下一個目標的成本可能高不可攀。目前最強的開源大模型已經達到了4000億參數,但仍未實現通用人工智能。假設下一步量變引起質變的規模是十萬億參數,訓練更大的模型往往需要更多的參數,其整體訓練量和成本的增加遠超過參數增長倍數。訓練十萬億規模參數的大模型,可能需要幾十萬張H100的顯卡的集群這樣一次訓練的成本可能達到100億美元。從過去的太空競賽來看,100億美元單個項目可能是目前人類社會能承受的極限。畢竟,下一個量級的百萬億參數大模型,其對應訓練總成本很可能超過1萬億美元,這幾乎是無法實現的。

如果100億美金砸下去了,10萬億規模參數的大模型還是沒法實現AGI,那么基于Transformer架構的大模型是不是短期就到頭了?不過這個結果很可能會啟發人們去探索Transformer之外的架構體系,例如量子計算,類腦芯片等。

10萬億規模參數的大模型,會是Transformer架構的登月時刻么?