Nature曝驚人內(nèi)幕:論文被天價賣出喂AI!出版商狂賺上億,作者0收入

全球數(shù)據(jù)告急,怎么辦?

論文來湊!

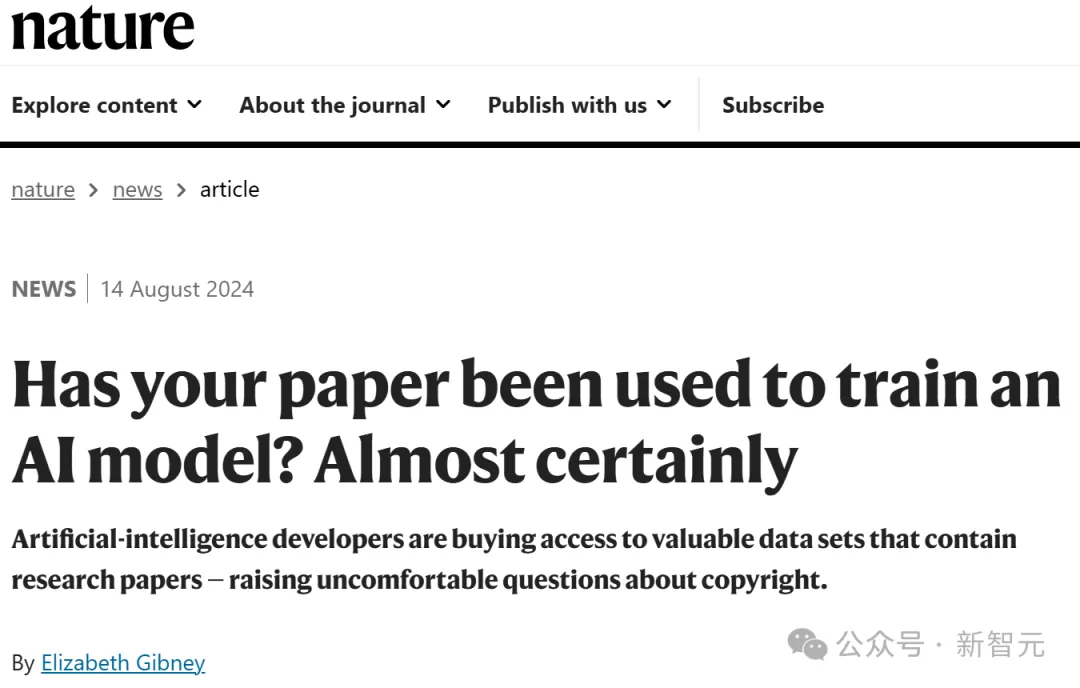

最近,Nature的一篇文章向我們揭露了這樣一個事實:連科研論文,都被薅去訓(xùn)AI了……

據(jù)悉,很多學(xué)術(shù)出版商,已經(jīng)向科技公司授權(quán)訪問自家的論文,用來訓(xùn)練AI模型。

一篇論文從醞釀idea到成稿,包含了多少作者日日夜夜的心血,如今很可能在不知情的情況下,就成為訓(xùn)AI的數(shù)據(jù)。

這合理嗎?

更可氣的是,自己的論文還被出版商拿來牟利了。

根據(jù)Nature報告,上個月英國的學(xué)術(shù)出版商Taylor & Francis已經(jīng)和微軟簽署了一項價值1000萬美元的協(xié)議,允許微軟獲取它的數(shù)據(jù),來改進AI系統(tǒng)。

而6月的一次投資者更新顯示,美國出版商Wiley允許某家公司使用其內(nèi)容訓(xùn)模型后,直接一舉豪賺2300萬美元!

但這個錢,跟廣大論文的作者是半毛錢關(guān)系都沒有的。

而且,華盛頓大學(xué)AI研究員Lucy Lu Wang還表示,即使不在可開放獲取的存儲庫內(nèi),任何可在線閱讀的內(nèi)容,都很可能已經(jīng)被輸入LLM中。

更可怕的是,如果一篇論文已經(jīng)被用作模型的訓(xùn)練數(shù)據(jù),在模型訓(xùn)練完成后,它是無法刪除的。

如果現(xiàn)在,你的論文還尚未被用于訓(xùn)練AI,那也不用擔(dān)心——它應(yīng)該很快就會了!

數(shù)據(jù)集如黃金,各大公司紛紛出價

我們都知道,LLM需要在海量數(shù)據(jù)上進行訓(xùn)練的,而這些數(shù)據(jù)通常是從互聯(lián)網(wǎng)上抓取的。

正是從這些訓(xùn)練數(shù)據(jù)中數(shù)十億的token中,LLM推導(dǎo)出模式,從而生成文本、圖像、代碼。

而學(xué)術(shù)論文篇幅又長,信息密度又高,顯然就是能喂給LLM的最有價值的數(shù)據(jù)之一。

而且,在大量科學(xué)信息上訓(xùn)練LLM,也能讓它們在科學(xué)主題上的推理能力大大提高。

Wang已經(jīng)共同創(chuàng)建了基于8110萬篇學(xué)術(shù)論文的數(shù)據(jù)集S2ORC。起初,S2ORC數(shù)據(jù)集是為了文本挖掘而開發(fā)的,但后來,它被用于訓(xùn)練LLM。

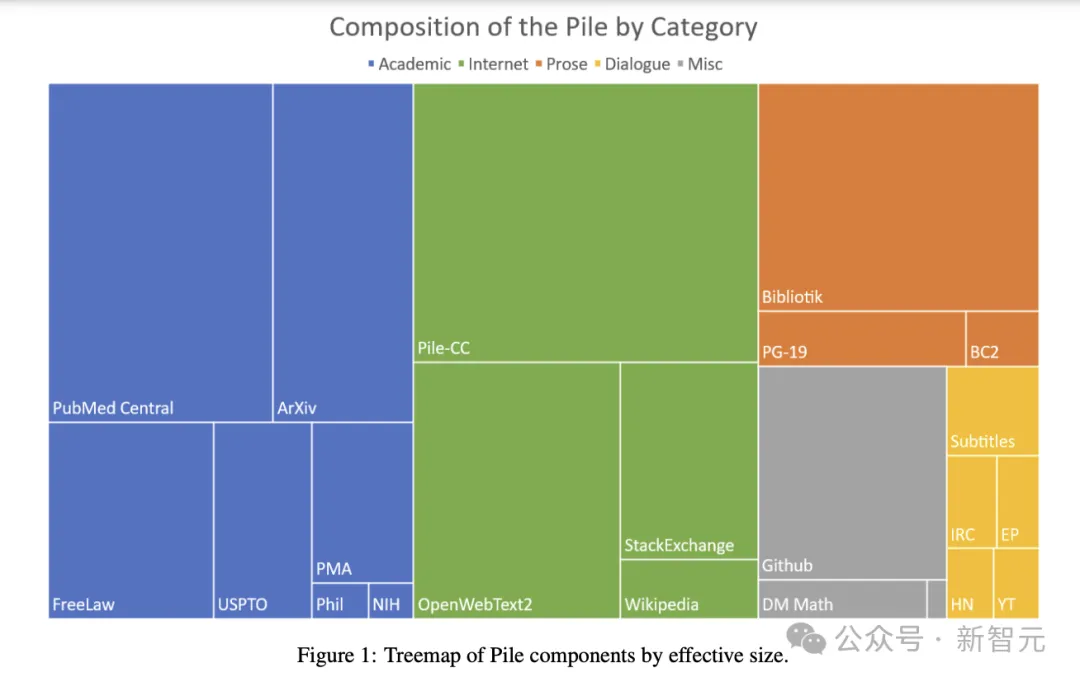

2020年非營利組織Eleuther AI構(gòu)建的Pile,是NLP研究中應(yīng)用最廣泛的大型開源數(shù)據(jù)集之一,總量達到800GB。其中就包含了大量學(xué)術(shù)來源的文本,arXiv論文比例為8.96%,此外還涵蓋了PubMed、FreeLaw、NIH等其他學(xué)術(shù)網(wǎng)站。

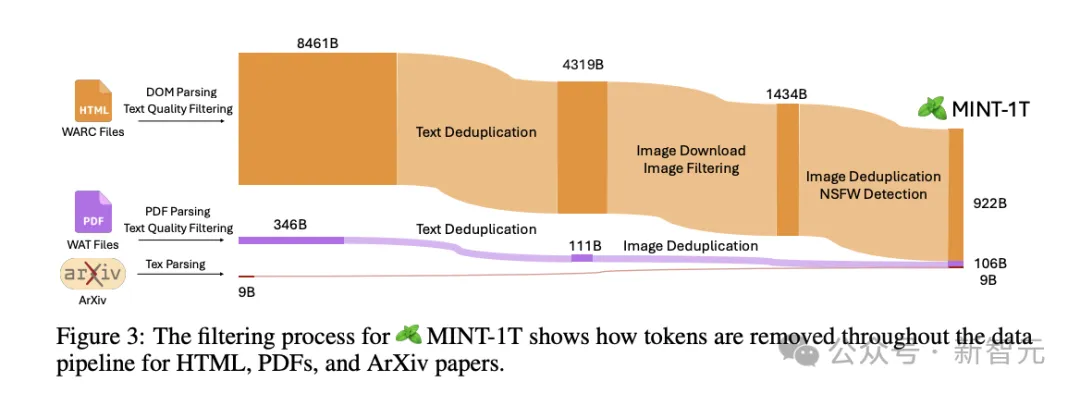

前段時間開源的1T token數(shù)據(jù)集MINT也挖掘到了arXiv這個寶藏,共提取到了87萬篇文檔、9B token。

從下面這張數(shù)據(jù)處理流程圖中,我們就能發(fā)現(xiàn)論文數(shù)據(jù)的質(zhì)量有多高——幾乎不需要太多的過濾和去重,使用率極高。

而現(xiàn)在,為了應(yīng)對版權(quán)爭議,各大模型公司也開始真金白銀地出價,購買高質(zhì)量數(shù)據(jù)集了。

今年,「金融時報」已經(jīng)把自己的內(nèi)容以相當(dāng)可觀的價格,賣給了OpenAI;Reddit也和谷歌達成了類似的協(xié)議。

而以后,這樣的交易也少不了。

證明論文曾被LLM使用,難度極高

有些AI開發(fā)者會開放自己的數(shù)據(jù)集,但很多開發(fā)AI模型的公司,會對大部分訓(xùn)練數(shù)據(jù)保密。

Mozilla基金會的AI訓(xùn)練數(shù)據(jù)分析員Stefan Baack表示,對于這些公司的訓(xùn)練數(shù)據(jù),誰都不知道有什么。

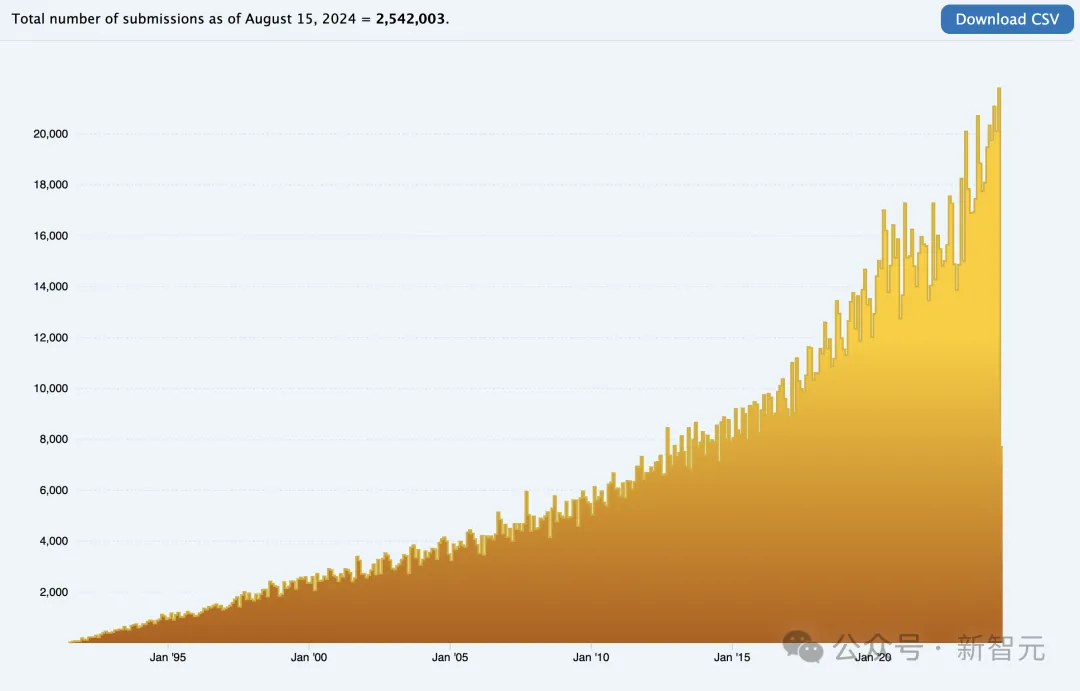

而最受業(yè)內(nèi)人士歡迎的數(shù)據(jù)來源,無疑就是開源存儲庫arXiv和學(xué)術(shù)數(shù)據(jù)庫PubMed的摘要了。

目前,arXiv已經(jīng)托管了超過250萬篇論文的全文,PubMed包含的引用數(shù)量更是驚人,超過3700萬。

雖然PubMed等網(wǎng)站的一些論文全文有付費墻,但論文摘要是免費瀏覽的,這部分可能早就被大科技公司抓取干凈了。

所以,有沒有技術(shù)方法,能識別自己的論文是否被使用了呢?

目前來說,還很難。

倫敦帝國理工學(xué)院的計算機科學(xué)家Yves-Alexandre de Montjoye介紹道:要證明LLM使用了某篇確定的論文,是很困難的。

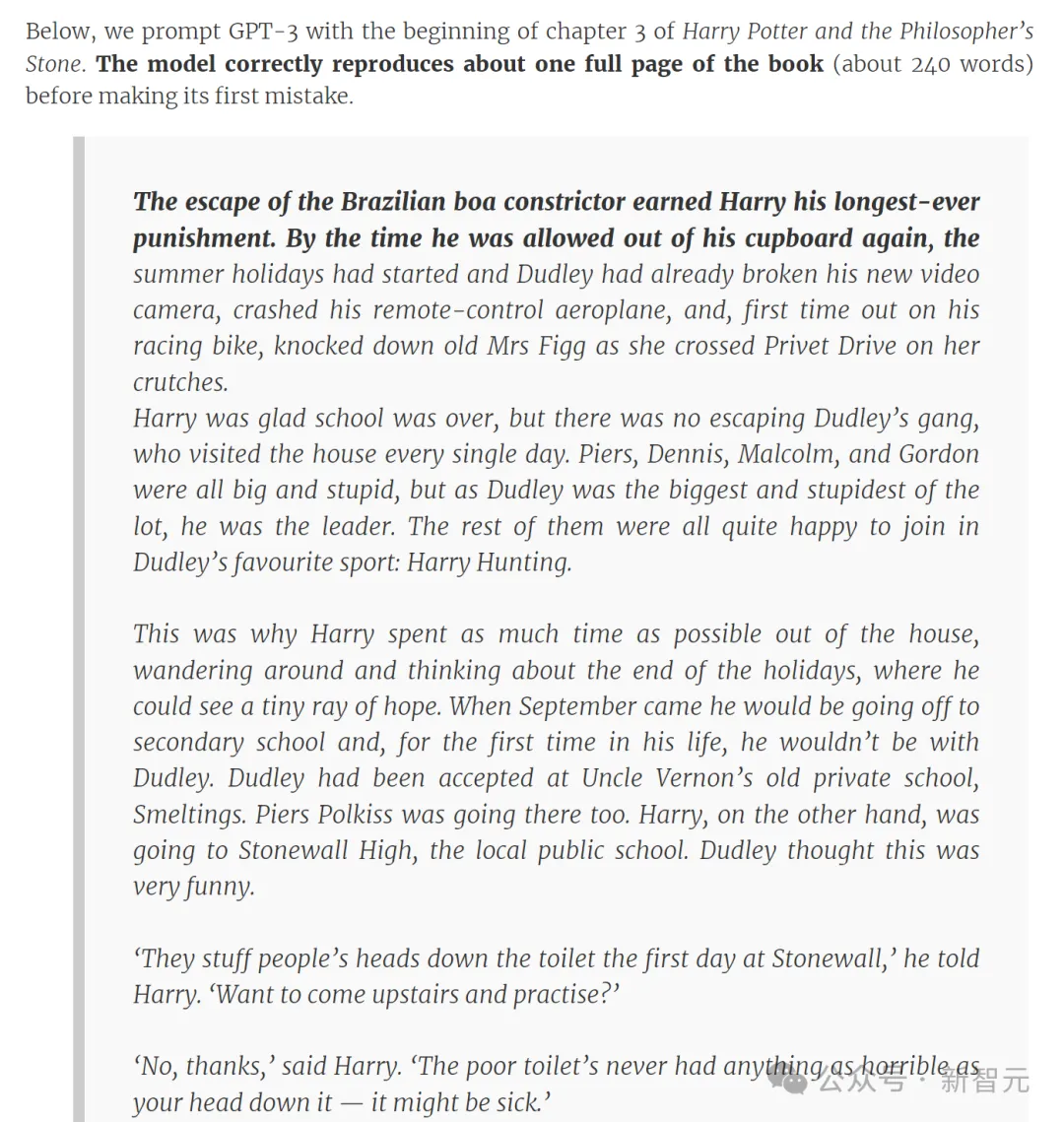

有一個辦法,是使用論文文本中非常罕見的句子來提示模型,看看它的輸出是否就是原文中的下一個詞。

有學(xué)者曾以「哈利·波特與魔法石」第三章的開頭提示GPT-3,模型很快正確地吐出了大約一整頁書中的內(nèi)容

如果是的話,那就沒跑了——論文就在模型的訓(xùn)練集中。

如果不是呢?這也未必是有效證據(jù),能證明論文未被使用。

因為開發(fā)者可以對LLM進行編碼,讓它們過濾響應(yīng),從而不和訓(xùn)練數(shù)據(jù)過于匹配。

可能的情況是,我們費了老大勁,依然無法明確地證明。

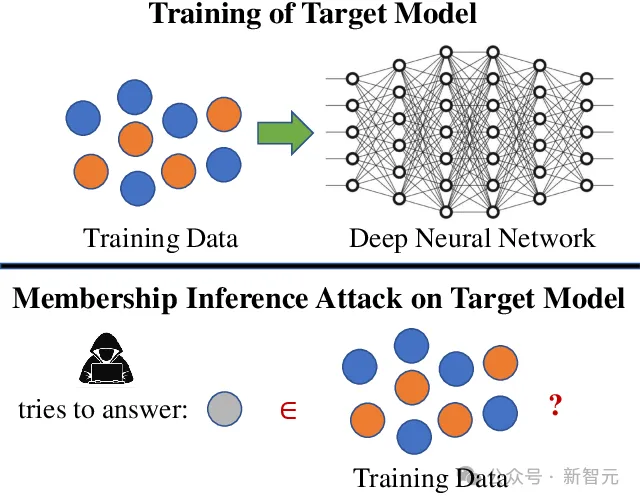

另一種方法,就是「成員推理攻擊」。

這種方法的原理,就是當(dāng)模型看到以前見過的東西時,會對輸出更有信心,

論文地址:https://arxiv.org/abs/2112.03570

為此,De Montjoye的團隊專門開發(fā)了一種「版權(quán)陷阱」。

論文地址:https://arxiv.org/abs/2402.09363

為了設(shè)置陷阱,團隊會生成看似合理卻無意義的句子,并將其隱藏在作品中,比如白色背景上的白色文本或網(wǎng)頁上顯示為零寬度的字段。

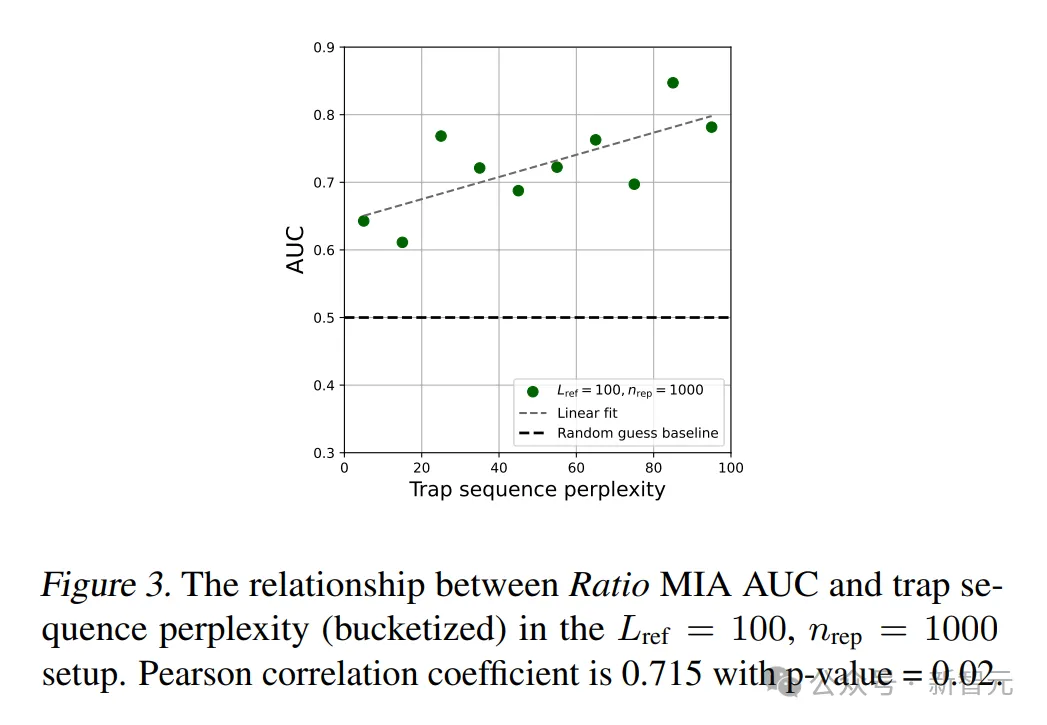

如果模型對未使用的控制句的困惑度,比對隱藏在文本中的控制句的困惑度更高,這就可以作為陷阱曾被看到的統(tǒng)計證據(jù)。

版權(quán)爭議

然而,即使能證明LLM是在某篇論文上訓(xùn)練的,又能怎么辦呢?

這里,就存在一個由來已久的爭議。

在出版商看來,如果開發(fā)者在訓(xùn)練中使用了受版權(quán)保護的文本,且沒有獲得許可,那鐵定就是侵權(quán)。

但另一方卻可以這樣反駁:大模型并沒有抄襲啊,所以何來侵權(quán)之說?

的確,LLM并沒有復(fù)制任何東西,它只是從訓(xùn)練數(shù)據(jù)中獲取信息,拆解這些內(nèi)容,然后利用它們學(xué)習(xí)生成新的文本。

當(dāng)然,這類訴訟已經(jīng)有先例了,比如「紐約時報」對OpenAI那場石破天驚的起訴。

其中更加復(fù)雜的問題,是如何劃清商用和學(xué)術(shù)研究用途。

根據(jù)目前arXiv網(wǎng)站上的使用條款,如果是個人或研究用途,抓取、存儲、使用所有的電子預(yù)印本論文和網(wǎng)站元數(shù)據(jù)都是合規(guī)且被支持的。

然而,arXiv對商業(yè)方面的使用是嚴令禁止的。

那么問題來了,如果某個商業(yè)公司使用了學(xué)術(shù)機構(gòu)發(fā)布的開源數(shù)據(jù)集訓(xùn)練自己的商業(yè)模型,且數(shù)據(jù)來源含有arXiv或類似學(xué)術(shù)出版機構(gòu),這怎么算?

此外,出版商在用戶的訂閱條款中往往也沒有明確規(guī)定,能否將論文用作模型的訓(xùn)練數(shù)據(jù)。

比如,一個付費購買Wiley論文庫閱讀全文資格的用戶,是否被允許將這些文本拷貝下來喂給模型?

現(xiàn)在的問題是,有人想讓自己的作品納入LLM的訓(xùn)練數(shù)據(jù)中,有人不想。

有人已經(jīng)做出來一個[haveibeentrained」的同名網(wǎng)站,用來檢測自己的內(nèi)容是否被用于訓(xùn)練AI模型

比如Mozilla基金會的Baack就表示,非常樂于看到自己的作品讓LLM變得更準(zhǔn)確,「我并不介意有一個以我的風(fēng)格寫作的聊天機器人」。

但是,他只能代表自己,依然有其他很多藝術(shù)家和作家,會受到LLM的威脅。

如果提交論文后,這篇論文的出版商決定出售對版權(quán)作品的訪問權(quán)限,那個別的論文作者是根本沒有權(quán)力干涉的。

整個圈子也是魚龍混雜,公開發(fā)表的文章既沒有既定的方法來分配來源,也無法確定文本是否已被使用。

包括de Montjoye在內(nèi)的一些研究者對此感到沮喪。

「我們需要LLM,但我們?nèi)匀幌M泄娇裳裕壳拔覀冞€沒有發(fā)明出理想的公平是什么樣子。」

多模態(tài)數(shù)據(jù)不夠,arXiv來湊

事實上,龐大的arXiv論文庫中,可以利用的不止文本數(shù)據(jù)。

ACL 2024接收了一篇來自北大和港大學(xué)者的論文,他們嘗試利用這些論文中的圖文構(gòu)建高質(zhì)量多模態(tài)數(shù)據(jù)集,取得了非常不錯的效果。

項目主頁:https://mm-arxiv.github.io/

前段時間,紐約大學(xué)謝賽寧教授和Yann LeCun等人發(fā)布的Cambrian模型也用到了這個數(shù)據(jù)集。

之所以要用arXiv論文中的圖片,主要還是由于科學(xué)領(lǐng)域訓(xùn)練數(shù)據(jù)集的稀缺。

GPT-4V等視覺語言模型雖然在自然場景的圖像中有出色的表現(xiàn),但在解釋抽象圖片方面,比如幾何形狀和科學(xué)圖表,依舊能力有限,也無法理解學(xué)術(shù)圖片中細微的語義差別。

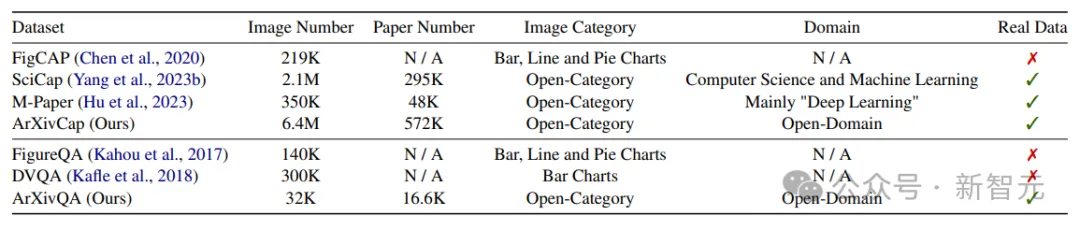

這篇論文構(gòu)建的多模態(tài)arXiv數(shù)據(jù)集總共用到了各個STEM領(lǐng)域的57.2萬篇論文,超過arXiv論文總數(shù)(2.5M)的五分之一,包含兩部分:問答數(shù)據(jù)集ArXivQA和圖片標(biāo)注數(shù)據(jù)集ArXivCap。

依托arXiv大量且多樣的論文收錄,與之前的科學(xué)圖片數(shù)據(jù)集相比,ArXivCap的數(shù)據(jù)量是第二名SciCap的3倍,ArXivQA也是唯一涵蓋廣泛領(lǐng)域內(nèi)真實論文的問答數(shù)據(jù)集。

通過使用這些領(lǐng)域特定數(shù)據(jù)進行訓(xùn)練,VLM的的數(shù)學(xué)推理能力有了顯著增強,在多模態(tài)數(shù)學(xué)推理基準(zhǔn)上實現(xiàn)了10.4%的準(zhǔn)確率提升。

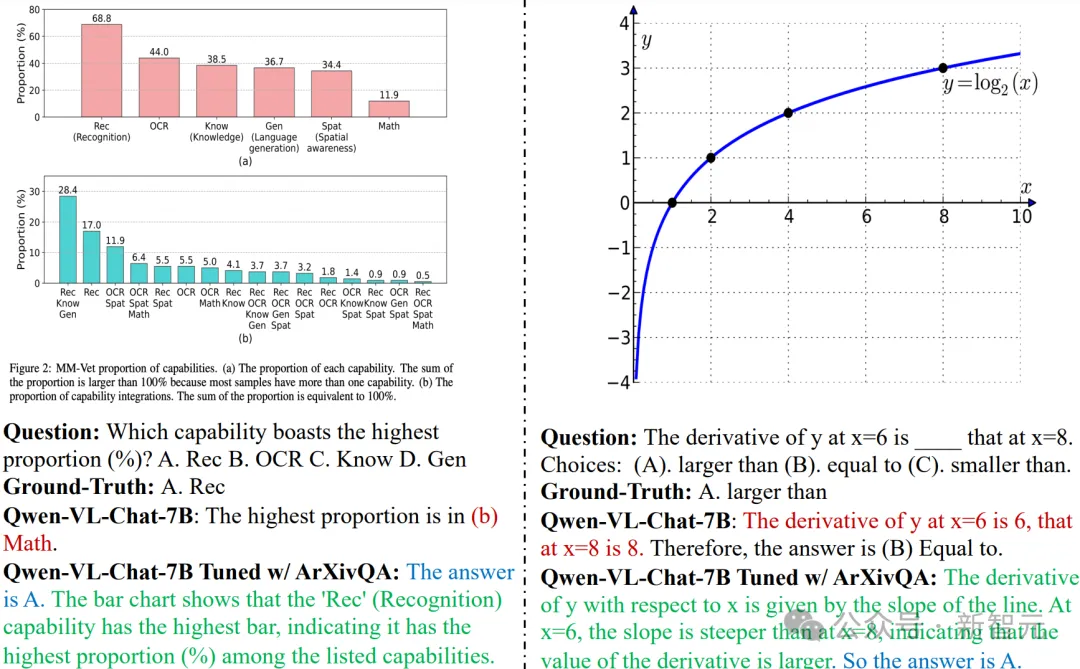

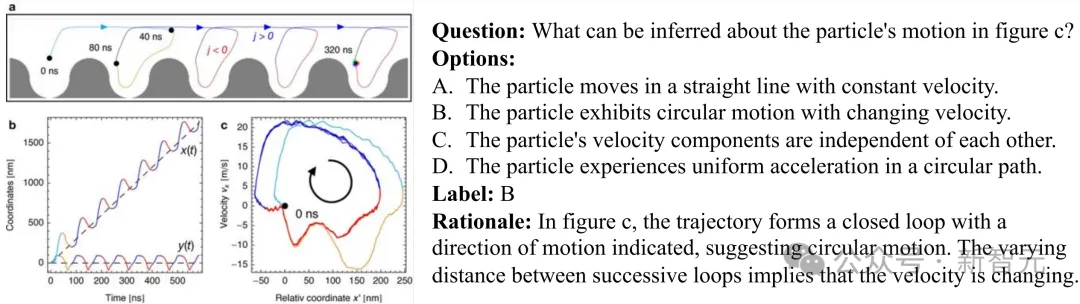

比如,在ArXivQA上訓(xùn)練過的Qwen 7B模型能夠正確理解條形圖并回答相關(guān)問題(左圖),數(shù)學(xué)能力也有所提高(右圖)。不僅答案正確,給出的推理過程也更加完整充分。

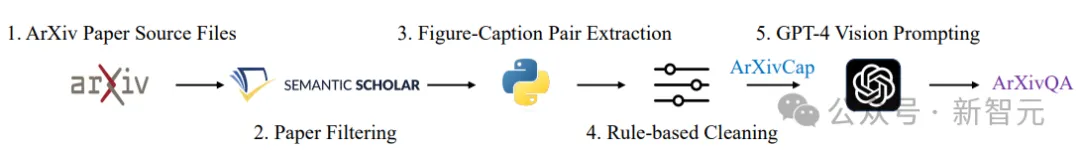

數(shù)據(jù)集構(gòu)建

數(shù)據(jù)集的構(gòu)建流水線如下圖所示。由于arXiv是預(yù)印本平臺,所以需要先通過發(fā)表記錄篩選出被期刊或會議接收的論文,以保證數(shù)據(jù)質(zhì)量。

提取論文中的圖片-文字對并進行基于規(guī)則的清理后,組成ArXivCap;ArXivQA則由GPT-4V生成,但使用了精心設(shè)計過的prompt模板。

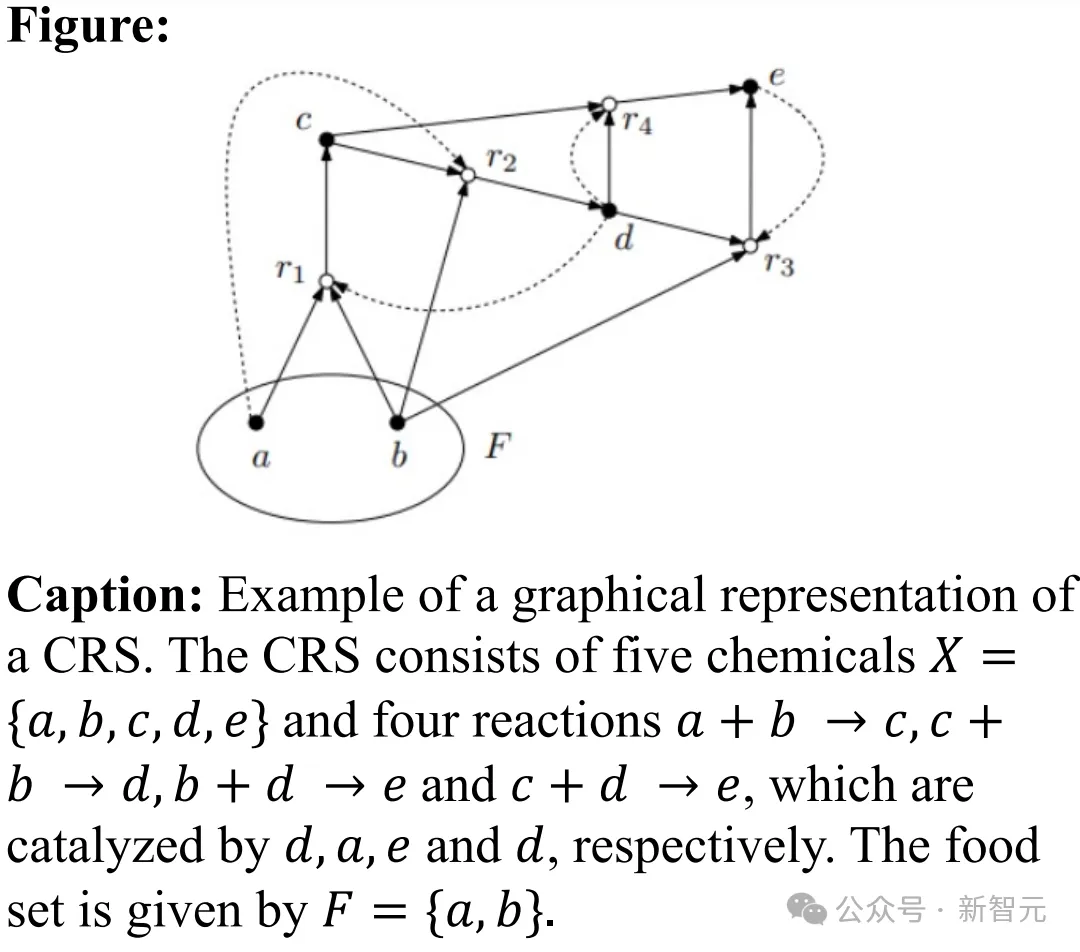

ArXivCap中的一個單圖標(biāo)注對:

2019年論文「Semigroup models for biochemical reaction networks」

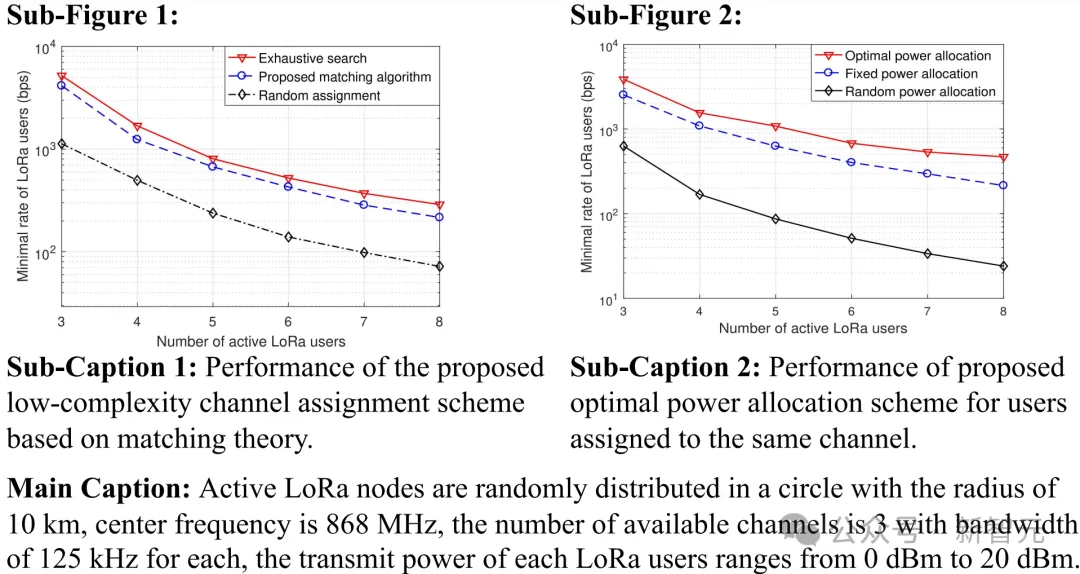

ArXivCap數(shù)據(jù)集中的一個多圖標(biāo)注對:

2018年論文「Low-Power Wide-Area Networks for Sustainable IoT」

ArXivQA數(shù)據(jù)集示例:

2020年論文「Skyrmion ratchet propagation: Utilizing the skyrmion Hall effect in AC racetrack storage devices」

評估

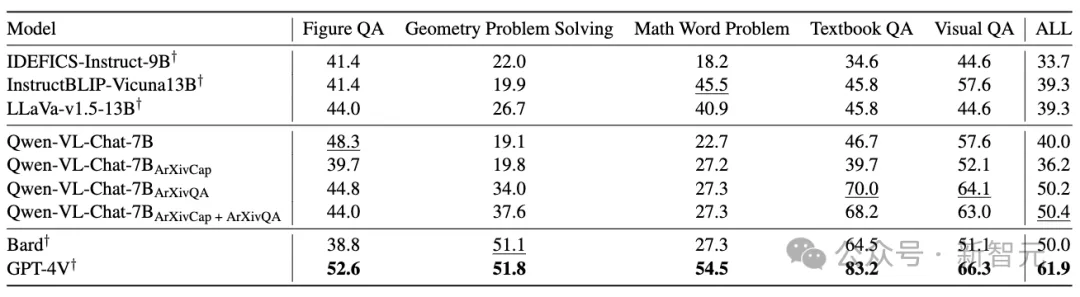

根據(jù)在MathVista數(shù)據(jù)集上的結(jié)果,ArXivCap和ArXivQA共同提升了Qwen-VL-Chat的整體性能,超越了Bard的表現(xiàn)。

最佳結(jié)果以粗體顯示,次佳結(jié)果以下劃線標(biāo)記

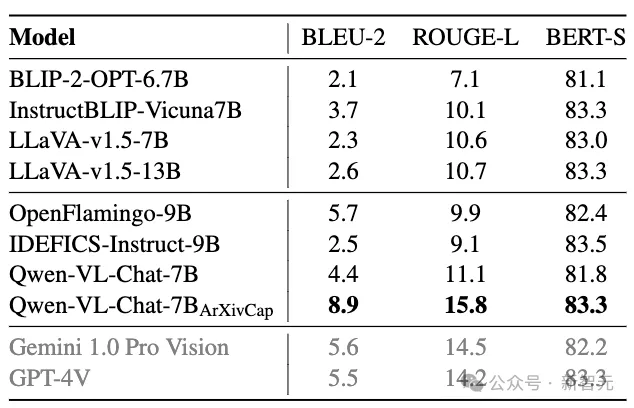

在為單張圖片生成圖注的任務(wù)中,提升效果更加顯著,經(jīng)過ArXivCap訓(xùn)練的Qwen 7B模型可以匹配甚至超過GPT-4V。

灰色結(jié)果由數(shù)據(jù)集中500個樣本的測試得到

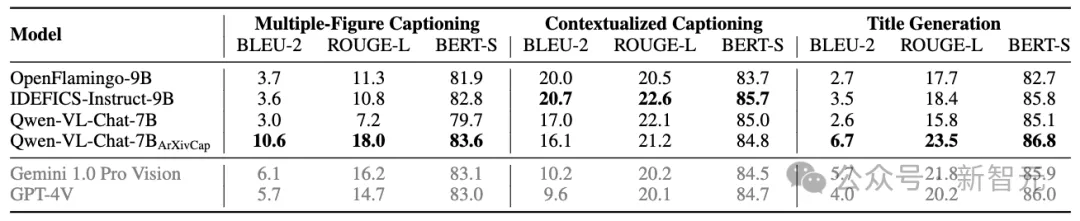

論文提出了三個新定義任務(wù):多圖的圖注生成、上下文中的圖注生成以及標(biāo)題生成。經(jīng)過ArXivCap訓(xùn)練的Qwen 8B的所有分數(shù)都超過了GPT-4V,且多數(shù)情況下是最佳結(jié)果。

最佳結(jié)果以粗體顯示

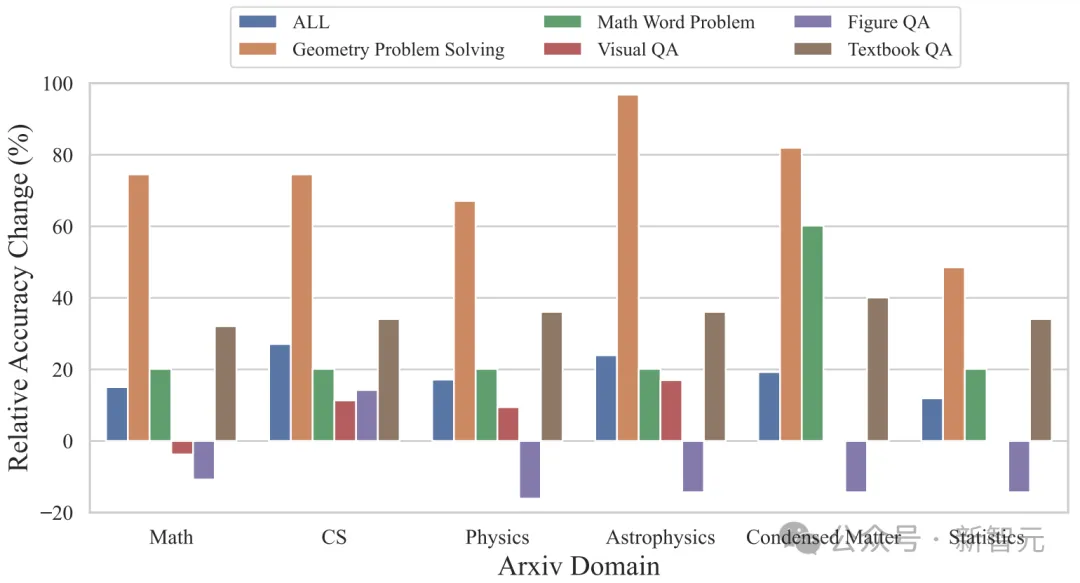

按照研究領(lǐng)域劃分,ArXivQA數(shù)據(jù)集上的訓(xùn)練在天體物理、凝聚態(tài)物理、數(shù)學(xué)、計算機科學(xué)這些領(lǐng)域都能帶來相當(dāng)顯著的提升,超過60%,準(zhǔn)確率變化比例超過60%。

人工評估

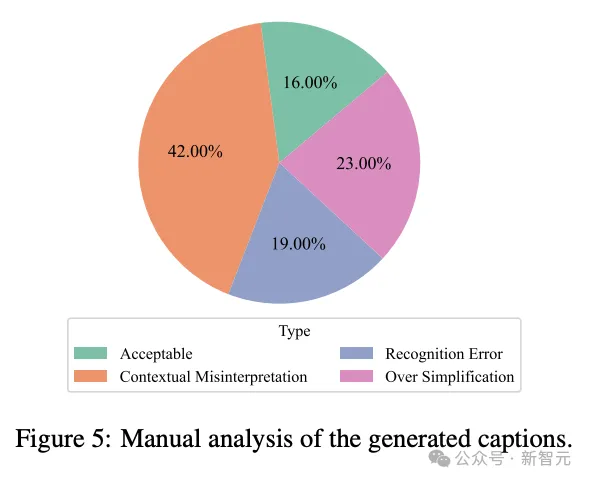

前面所述的文本生成質(zhì)量和準(zhǔn)確率都是基于算法的自動評估,研究團隊還對單圖的圖注生成任務(wù)進行了人工評估,但只專注于計算機科學(xué)領(lǐng)域的論文。

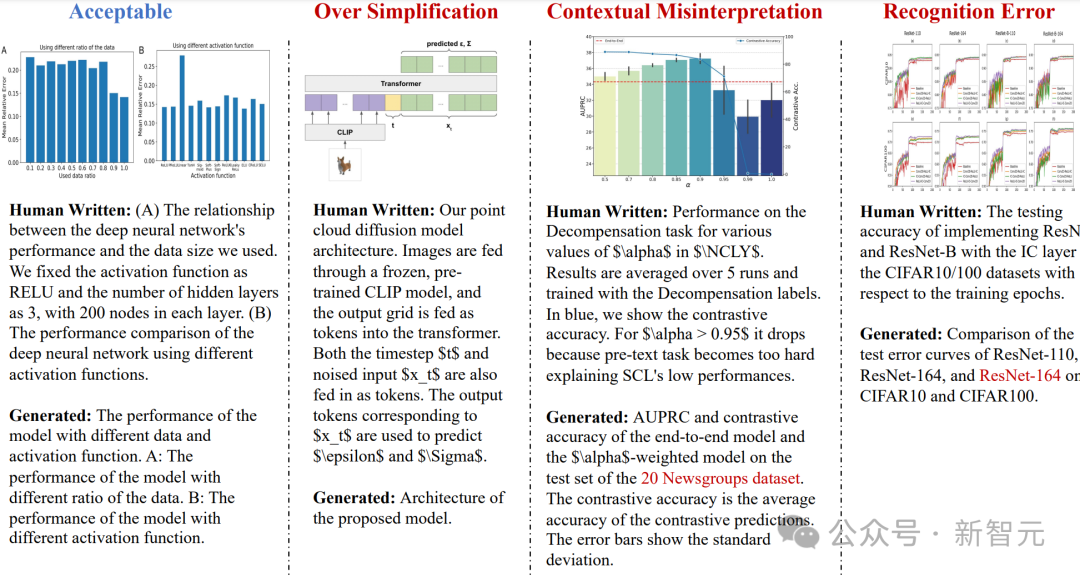

與前面的基準(zhǔn)測試結(jié)果相比,人工評估的結(jié)果并不理想,100個案例中只有16%被認為是「可接受的」,「上下文誤讀」的問題相對嚴重,也有一定比例的「過度簡化」和「識別錯誤」。