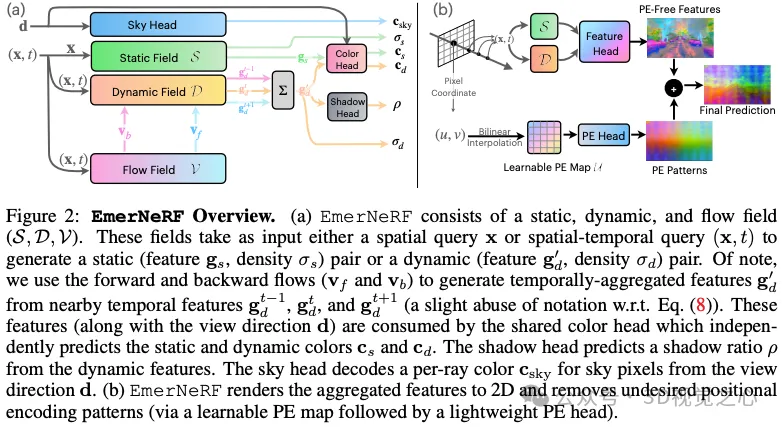

入行自動駕駛數據閉環,今年必讀的十三篇最前沿論文

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

近幾年,自動駕駛技術的發展日新月異。從ECCV 2020的NeRF問世再到SIGGRAPH 2023的3DGS,三維重建走上了快速發展的道路!再到自動駕駛端到端技術的問世,與之相關的仿真閉環開始頻繁出現在大眾視野中,新興的三維重建技術由此在自動駕駛領域也逐漸煥發新機。2023年8月特斯拉發布FSD V12;2024年4月商湯絕影發布面向量產的端到端自動駕駛解決方法UniAD;2024年7月理想夏季發布會宣稱端到端正式上車,快系統4D One Model、慢系統VLM,并首次提出『重建+生成』的世界模型測試方案。

可以說,端到端+仿真閉環是當下自動駕駛發展的主流路線。但是仿真閉環提了很多年,到底什么是仿真閉環?仿真閉環的核心又是什么?三維重建又在閉環中起到什么樣的作用?業內也一直在討論,百花齊放。無論如何,閉環的目的是明確的,降低實車測試的成本和風險、有效提高模型的開發效率進而優化系統性能、測試各種corner case并優化整個端到端算法。

今天就和大家盤一盤自動駕駛中新興的三維重建技術相關算法。

MARS: An Instance-aware, Modular and Realistic Simulator for Autonomous Driving(CICAI 2023)

- 論文鏈接:https://arxiv.org/abs/2307.15058v1

- 代碼鏈接:https://github.com/OPEN-AIR-SUN/mars

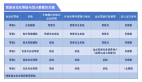

清華AIR提出的首個開源自動駕駛NeRF仿真工具!如今自動駕駛汽車在普通情況下可以平穩行駛,人們普遍認為,逼真的傳感器仿真將在通過仿真解決剩余的corner case方面發揮關鍵作用。為此,我們提出了一種基于神經輻射場(NeRFs)的自動駕駛仿真器。與現有的工作相比,我們有三個顯著的特點:

- Instance-aware:前景目標和背景,單獨建模,因此可以保證可控性

- Modular:模塊化設計,便于集成各種SOTA的算法進來

- Realistic:由于模塊化的設計,不同模塊可以靈活選擇比較好的算法實現,因此效果SOTA。

UniSim: A Neural Closed-Loop Sensor Simulator(CVPR 2023)

- 論文鏈接:https://arxiv.org/abs/2308.01898v1

- 項目主頁:https://waabi.ai/unisim/

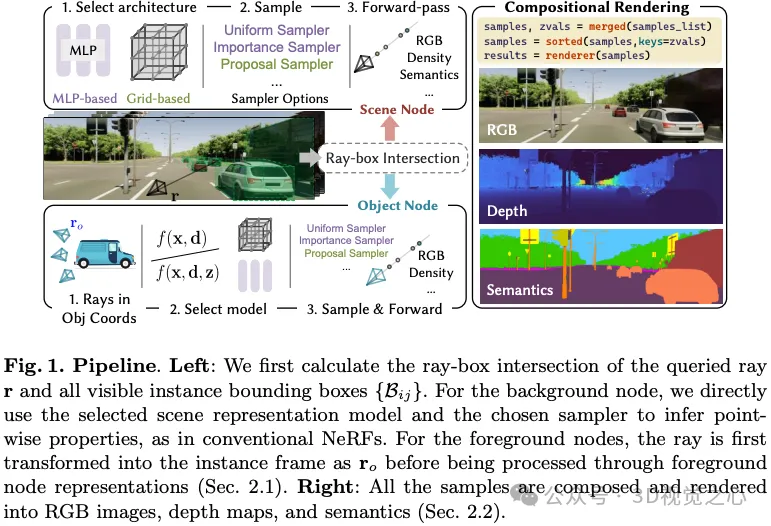

Waabi和多倫多大學在CVPR 2023上的工作:嚴格測試自動駕駛系統對于實現安全的自動駕駛汽車(SDV)至關重要。它要求人們生成超出世界上安全收集范圍的安全關鍵場景,因為許多場景很少發生在公共道路上。為了準確評估性能,我們需要在閉環中測試這些場景中的SDV,其中SDV和其他參與者在每個時間步相互作用。以前記錄的駕駛日志為構建這些新場景提供了豐富的資源,但對于閉環評估,我們需要根據新的場景配置和SDV的決定修改傳感器數據,因為可能會添加或刪除參與者,現有參與者和SDV之間的軌跡將與原始軌跡不同。本文介紹了UniSim,這是一種神經傳感器模擬器,它將配備傳感器的車輛捕獲的單個記錄日志轉換為現實的閉環多傳感器模擬。UniSim構建神經特征網格來重建場景中的靜態背景和動態參與者,并將它們組合在一起,以在新視角仿真LiDAR和相機數據,添加或刪除參與者以及新的位置。為了更好地處理外推視圖,我們為動態目標引入了可學習的先驗,并利用卷積網絡來完成看不見的區域。我們的實驗表明,UniSim可以在下游任務中模擬具有較小域間隙的真實傳感器數據。通過UniSim,我們演示了在安全關鍵場景下對自主系統的閉環評估,就像在現實世界中一樣。UniSim的主要貢獻如下:

- 高度逼真(high realism): 可以準確地模擬真實世界(圖片和LiDAR), 減小鴻溝(domain gap )

- 閉環測試(closed-loop simulation): 可以生成罕見的危險場景測試無人車, 并允許無人車和環境自由交互

- 可擴展 (scalable): 可以很容易的擴展到更多的場景, 只需要采集一次數據, 就能重建并仿真測

- 知乎解讀:https://zhuanlan.zhihu.com/p/636695025

- 一作直播:https://www.bilibili.com/video/BV1nj41197TZ

EmerNeRF: Emergent Spatial-Temporal Scene Decomposition via Self-Supervision

- 論文鏈接:https://arxiv.org/abs/2311.02077v1

- 代碼鏈接:https://github.com/NVlabs/EmerNeRF

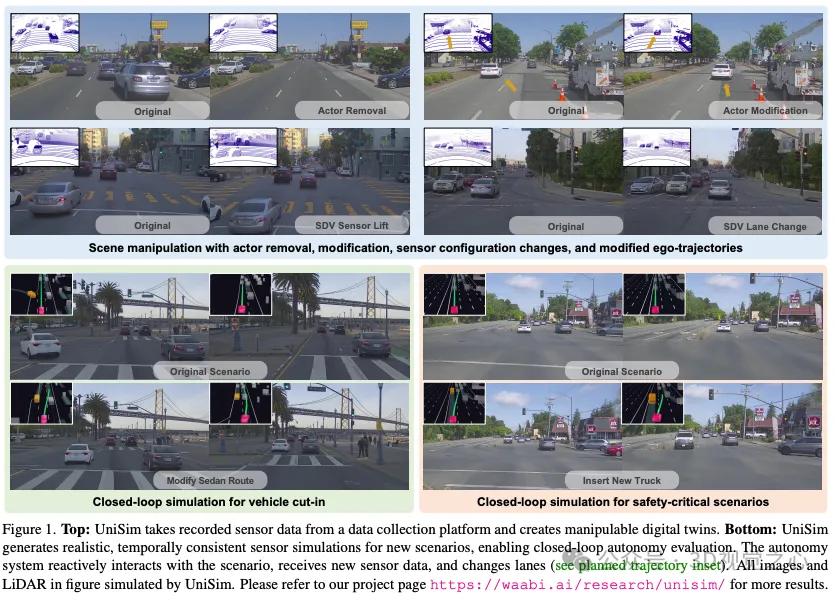

加利福尼亞大學的工作:本文提出了EmerNeRF,這是一種簡單而強大的學習動態駕駛場景時空表示的方法。EmerNeRF以神經場為基礎,通過自舉同時捕獲場景幾何、外觀、運動和語義。EmerNeRF依賴于兩個核心組件:首先,它將場景劃分為靜態和動態場。這種分解純粹源于自監督,使我們的模型能夠從一般的、野外的數據源中學習。其次,EmerNeRF將動態場中的感應流場參數化,并使用該流場進一步聚合多幀特征,從而提高了動態目標的渲染精度。耦合這三個場(靜態、動態和流)使EmerNeRF能夠自給自足地表示高度動態的場景,而無需依賴GT標注或預先訓練的模型進行動態目標分割或光流估計。我們的方法在傳感器仿真中實現了最先進的性能,在重建靜態(+2.93 PSNR)和動態(+3.70 PSNR)場景時明顯優于以前的方法。此外,為了支持EmerNeRF的語義泛化,我們將2D視覺基礎模型特征提升到4D時空中,并解決了現代變形金剛中的普遍位置偏差問題,顯著提高了3D感知性能(例如,職業預測精度平均相對提高了37.50%)。最后,我們構建了一個多樣化且具有挑戰性的120序列數據集,用于在極端和高度動態的環境下對神經場進行基準測試。總結來說,本文的主要貢獻如下:

- EmerNeRF是一種新穎的4D神經場景表示框架,在具有挑戰性的自動駕駛場景中表現出色。EmerNeRF通過自監督執行靜態動態分解和場景流估計;

- 一種簡化的方法,可以解決ViT中位置嵌入圖案的不良影響,該方法可立即應用于其他任務;

- 我們引入NOTR數據集來評估各種條件下的神經場,并促進該領域的未來發展;

- EmerNeRF在場景重建、新視角合成和場景流估計方面實現了最先進的性能。

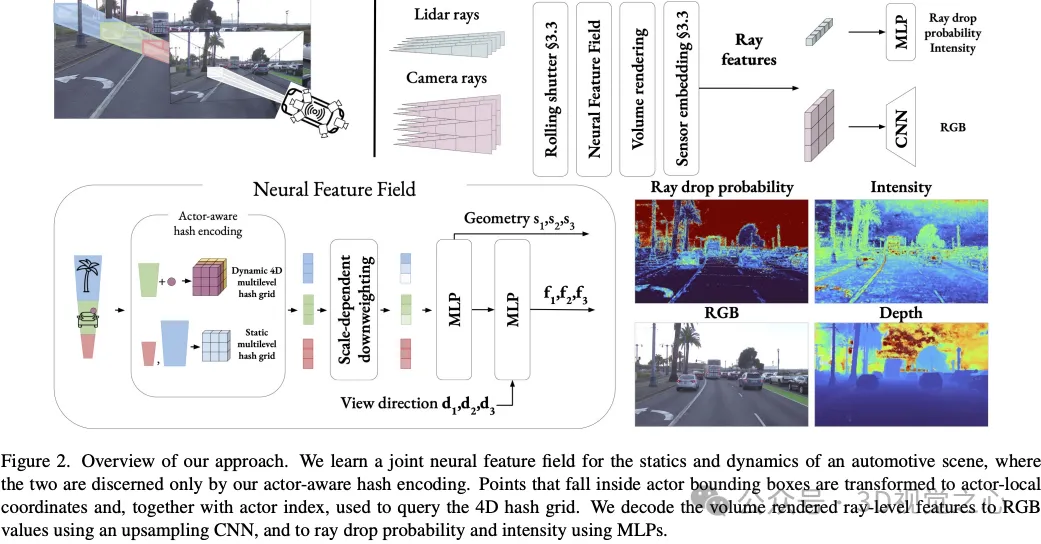

NeuRAD: Neural Rendering for Autonomous Driving

- 論文鏈接:https://arxiv.org/abs/2311.15260v3

- 代碼鏈接:https://github.com/georghess/neurad-studio

Zenseact的工作:神經輻射場(NeRF)在自動駕駛(AD)領域越來越受歡迎。最近的方法表明,NeRF具有閉環仿真的潛力,能夠測試AD系統,并作為一種先進的訓練數據增強技術。然而,現有的方法通常需要較長的訓練時間、密集的語義監督或缺乏可推廣性。這反過來又阻止了NeRFs大規模應用于AD。本文提出了NeuRAD,這是一種針對動態AD數據量身定制的魯棒新型視圖合成方法。我們的方法具有簡單的網絡設計,對相機和激光雷達進行了廣泛的傳感器建模,包括滾動快門、光束發散和光線下降,適用于開箱即用的多個數據集。我們在五個流行的AD數據集上驗證了它的性能,全面實現了最先進的性能。

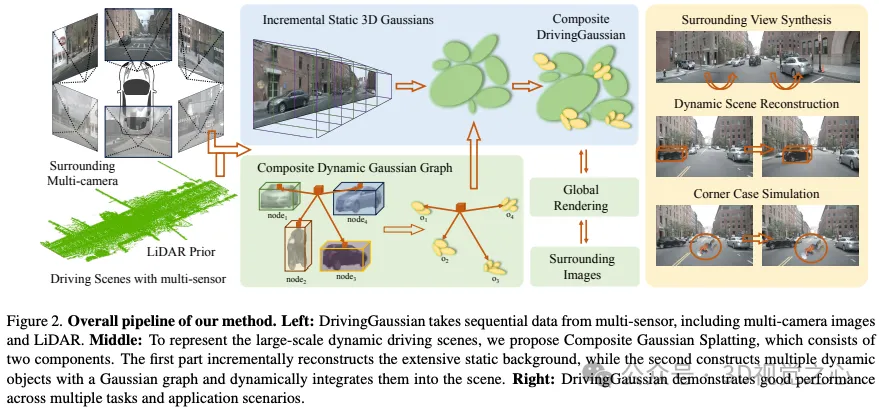

DrivingGaussian: Composite Gaussian Splatting for Surrounding Dynamic Autonomous Driving Scenes

- 論文鏈接:https://arxiv.org/abs/2312.07920v3

- 項目主頁:https://pkuvdig.github.io/DrivingGaussian/

北大&谷歌的工作:本文提出了DrivingGaussian模型,這是一個用于環視動態自動駕駛場景的高效和有效的框架。對于具有運動目標的復雜場景,DrivingGaussian首先使用增量靜態3D高斯對整個場景的靜態背景進行順序和漸進的建模。然后利用復合動態高斯圖來處理多個運動目標,分別重建每個目標并恢復它們在場景中的準確位置和遮擋關系。我們進一步使用激光雷達先驗進行 Gaussian Splatting,以重建具有更多細節的場景并保持全景一致性。DrivingGaussian在動態驅動場景重建方面優于現有方法,能夠實現高保真度和多相機一致性的逼真環繞視圖合成。總結來說,本文的主要貢獻如下:

- 據我們所知,DrivingGaussian是基于復合Gaussian Splatting的大規模動態駕駛場景的第一個表示和建模框架;

- 引入了兩個新模塊,包括增量靜態3D高斯圖和復合動態高斯圖。前者逐步重建靜態背景,而后者用高斯圖對多個動態目標進行建模。在激光雷達先驗的輔助下,所提出的方法有助于在大規模駕駛場景中恢復完整的幾何形狀;

- 綜合實驗表明,Driving Gaussian在挑戰自動駕駛基準測試方面優于以前的方法,并能夠為各種下游任務進行角情況仿真;

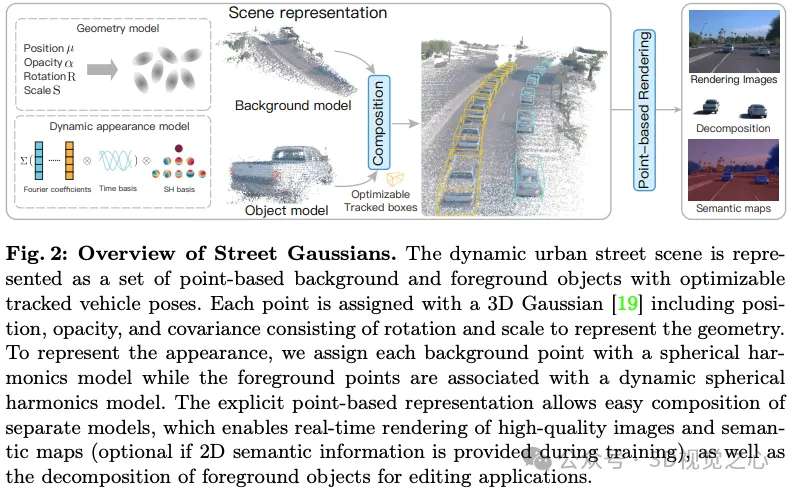

Street Gaussians: Modeling Dynamic Urban Scenes with Gaussian Splatting(ECCV 2024)

- 論文鏈接:https://arxiv.org/abs/2401.01339v2

- 代碼鏈接:https://github.com/zju3dv/street_gaussians

浙大&理想在ECCV 2024上的工作:本文旨在解決自動駕駛場景中動態城市街道的建模問題。最近的方法通過將跟蹤的車輛姿態結合到車輛動畫中來擴展NeRF,實現了動態城市街道場景的照片級逼真視圖合成。然而,它們的訓練速度和渲染速度都很慢。為此本文引入了Street Gaussians,這是一種新的顯式場景表示,可以解決這些限制。具體來說,動態城市場景被表示為一組配備語義邏輯和3D高斯的點云,每個點云都與前景車輛或背景相關聯。為了仿真前景目標車輛的動力學,每個目標點云都使用可優化的跟蹤姿態進行優化,并使用4D球諧模型進行動態外觀優化。顯式表示允許輕松組合目標車輛和背景,這反過來又允許在半小時的訓練內以135 FPS(1066×1600分辨率)進行場景編輯操作和渲染。該方法在多個具有挑戰性的基準上進行了評估,包括KITTI和Waymo Open數據集。實驗表明在所有數據集上,所提出的方法始終優于最先進的方法。

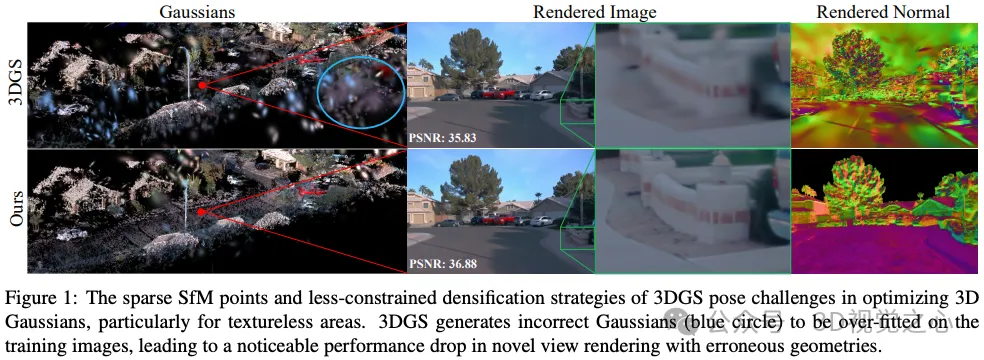

GaussianPro: 3D Gaussian Splatting with Progressive Propagation

- 論文鏈接:https://arxiv.org/abs/2402.14650v1

- 代碼鏈接:https://github.com/kcheng1021/GaussianPro

中科大&港大的工作:3DGS的出現最近在神經渲染領域帶來了一場革命,促進了實時速度的高質量渲染。然而,3DGS在很大程度上依賴于運動結構(SfM)技術產生的初始化點云。當處理不可避免地包含無紋理曲面的大規模場景時,SfM技術總是無法在這些曲面上產生足夠的點,也無法為3DGS提供良好的初始化。因此,3DGS存在優化困難和渲染質量低的問題。在這篇論文中,受經典多視圖立體(MVS)技術的啟發,我們提出了GaussianPro,這是一種應用漸進傳播策略來指導3D Gaussian致密化的新方法。與3DGS中使用的簡單分割和克隆策略相比,我們的方法利用場景現有重建幾何的先驗和補丁匹配技術來生成具有精確位置和方向的新高斯分布。在大規模和小規模場景上的實驗驗證了我們方法的有效性,我們的方法在Waymo數據集上顯著超過了3DGS,在PSNR方面提高了1.15dB。

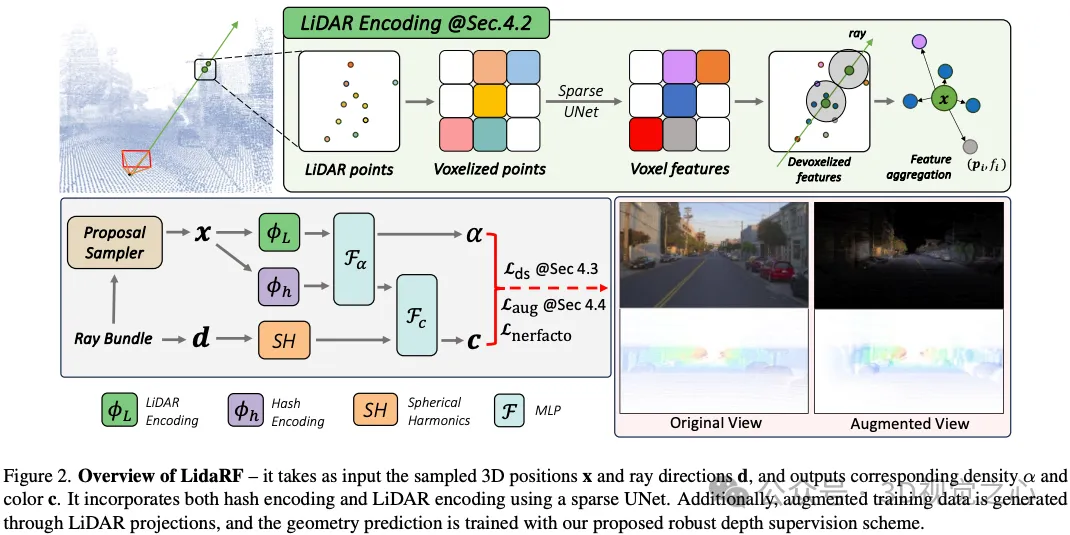

LidaRF: Delving into Lidar for Neural Radiance Field on Street Scenes

- 論文鏈接:https://arxiv.org/abs/2405.00900v2

加州大學歐文分校的工作:真實仿真在自動駕駛等應用中起著至關重要的作用,神經輻射場(NeRF)的進步可以通過自動創建數字3D資產來實現更好的可擴展性。然而,由于共線相機的大運動和高速下的稀疏樣本,街道場景的重建質量會受到影響。另一方面,實際使用通常要求從偏離輸入的相機視圖進行渲染,以準確模擬車道變換等行為。在這篇論文中,我們提出了幾個見解,可以更好地利用激光雷達數據來提高街道場景的NeRF質量。首先,我們的框架從激光雷達中學習幾何場景表示,將其與隱式基于網格的表示融合用于輻射解碼,然后提供顯式點云提供的更強幾何信息。其次提出了一種魯棒的遮擋感知深度監督方案,該方案允許通過累積來利用密集的激光雷達點。第三本文從激光雷達點生成增強訓練視圖,以進一步改進。我們的見解轉化為在真實駕駛場景下大大改進的新視圖合成。

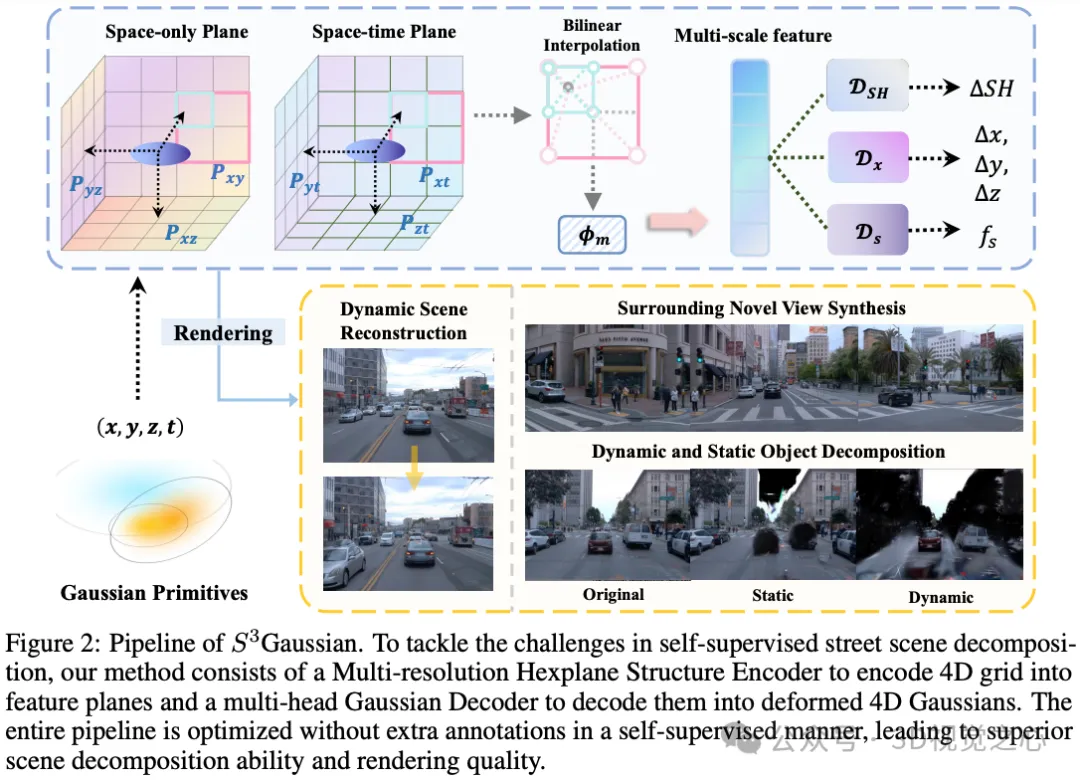

Gaussian: Self-Supervised Street Gaussians for Autonomous Driving

- 論文鏈接:https://arxiv.org/abs/2405.20323v1

UC Berkeley&北大&清華的工作:街道場景的真實感3D重建是開發自動駕駛仿真的關鍵技術。盡管神經輻射場(NeRF)在駕駛場景中的效率很高,但3DGS因其更快的速度和更明確的表示而成為一個有前景的方向。然而,大多數現有的街道3DGS方法需要跟蹤的3D車輛邊界框來分解靜態和動態元素以進行有效的重建,這限制了它們在自由場景中的應用。為了在沒有標注的情況下實現高效的3D場景重建,我們提出了一種自監督街道高斯(S3Gaussian)方法,用于從4D一致性中分解動態和靜態元素。我們用3D高斯分布來表示每個場景,以保持其明確性,并進一步用時空場網絡來壓縮4D動力學模型。我們在具有挑戰性的Waymo Open數據集上進行了廣泛的實驗,以評估我們方法的有效性。我們的S3Gaussian展示了分解靜態和動態場景的能力,并在不使用3D標注的情況下實現了最佳性能。

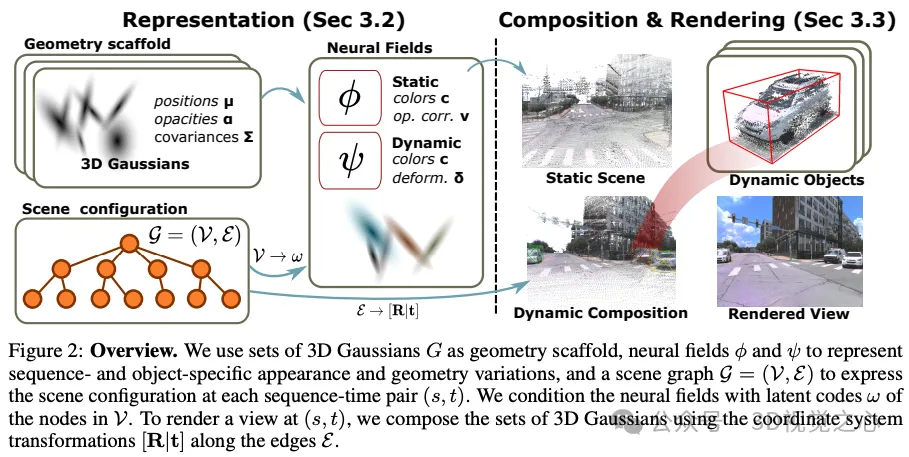

Dynamic 3D Gaussian Fields for Urban Areas

- 論文鏈接:https://arxiv.org/abs/2406.03175v1

- 代碼鏈接:https://github.com/tobiasfshr/map4d(待開源)

ETH和Meta的工作:本文提出了一種高效的神經3D場景表示方法,用于大規模動態城市地區的新視圖合成(NVS)。由于其有限的視覺質量和非交互式渲染速度,現有工作品不太適合混合現實或閉環仿真等應用。最近,基于光柵化的方法以令人印象深刻的速度實現了高質量的NVS。然而,這些方法僅限于小規模、均勻的數據,即它們無法處理由于天氣、季節和光照引起的嚴重外觀和幾何變化,也無法擴展到具有數千張圖像的更大、動態的區域。我們提出了4DGF,這是一種神經場景表示,可擴展到大規模動態城市區域,處理異構輸入數據,并大大提高了渲染速度。我們使用3D高斯作為高效的幾何支架,同時依賴神經場作為緊湊靈活的外觀模型。我們通過全局尺度的場景圖集成場景動力學,同時通過變形在局部層面建模關節運動。這種分解方法實現了適用于現實世界應用的靈活場景合成。在實驗中,我們繞過了最先進的技術,PSNR超過3dB,渲染速度超過200倍。

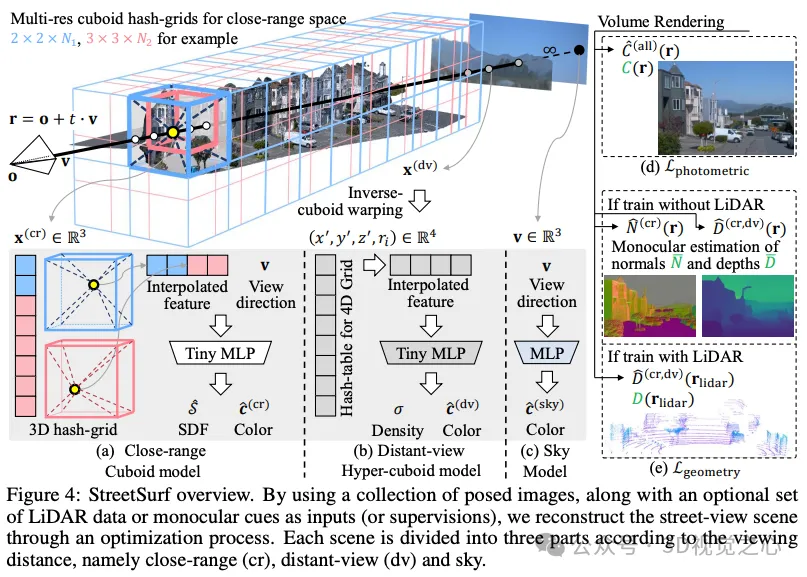

StreetSurf: Extending Multi-view Implicit Surface Reconstruction to Street Views

- 論文鏈接:https://arxiv.org/abs/2306.04988v1

- 代碼鏈接:https://github.com/pjlab-ADG/neuralsim

上海AI Lab和商湯的工作:本文提出了一種新的多視圖隱式表面重建技術,稱為StreetSurf,該技術很容易應用于廣泛使用的自動駕駛數據集中的街景圖像,如Waymo感知序列,而不一定需要LiDAR數據。隨著神經渲染研究的迅速發展,將其整合到街景中開始引起人們的興趣。現有的街景方法要么主要關注新視圖合成,很少探索場景幾何,要么在研究重建時嚴重依賴密集的LiDAR數據。他們都沒有研究多視圖隱式表面重建,特別是在沒有激光雷達數據的情況下。我們的方法擴展了現有的以目標為中心的神經表面重建技術,以解決由非以目標為核心、長而窄的相機軌跡捕獲的無約束街景所帶來的獨特挑戰。我們將無約束空間劃分為近距離、遠景和天空三個部分,具有對齊的長方體邊界,并采用長方體/超長方體哈希網格以及路面初始化方案,以實現更精細和更復雜的表示。為了進一步解決無紋理區域和視角不足引起的幾何誤差,我們采用了使用通用單目模型估計的幾何先驗。再加上我們實施了高效細粒度的多級光線行進策略,我們使用單個RTX3090 GPU對每個街道視圖序列進行訓練,僅需一到兩個小時的時間,即可在幾何和外觀方面實現最先進的重建質量。此外,我們證明了重建的隱式曲面在各種下游任務中具有豐富的潛力,包括光線追蹤和激光雷達模擬。

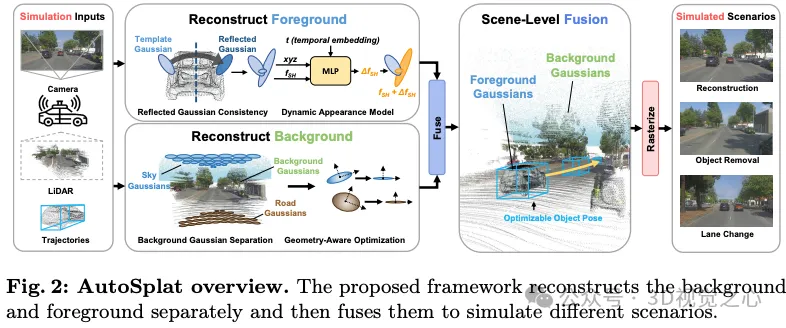

AutoSplat: Constrained Gaussian Splatting for Autonomous Driving Scene Reconstruction

- 論文鏈接:https://arxiv.org/abs/2407.02598v2

多倫多大學和華為諾亞的工作:逼真的場景重建和視圖合成對于通過仿真安全關鍵場景來推進自動駕駛系統至關重要。3DGS在實時渲染和靜態場景重建方面表現出色,但由于復雜的背景、動態對象和稀疏視圖,在建模駕駛場景方面遇到了困難。我們提出了AutoPlat,這是一個采用Gaussian Splatting實現自動駕駛場景高度逼真重建的框架。通過對表示道路和天空區域的高斯分布圖施加幾何約束,我們的方法能夠對包括車道變換在內的具有挑戰性的場景進行多視圖一致的模擬。利用3D模板,我們引入了反射高斯一致性約束來監督前景對象的可見面和不可見面。此外,為了模擬前景對象的動態外觀,我們估計了每個前景高斯的殘差球面諧波。在Pandaset和KITTI上進行的大量實驗表明,AutoPlat在各種駕駛場景中的場景重建和新穎視圖合成方面優于最先進的方法。

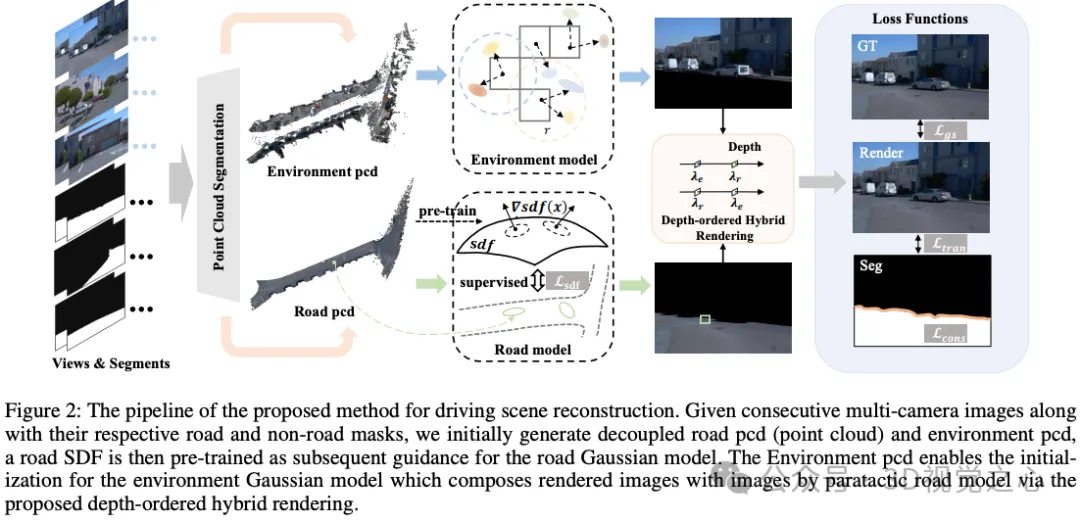

DHGS: Decoupled Hybrid Gaussian Splatting for Driving Scene

- 論文鏈接:https://arxiv.org/abs/2407.16600v3

長安汽車的工作:現有的GS方法在實現駕駛場景中令人滿意的新視圖合成方面往往不足,主要是由于缺乏巧妙的設計和所涉及元素的幾何約束。本文介紹了一種新的神經渲染方法,稱為解耦混合GS(DHGS),旨在提高靜態駕駛場景新型視圖合成的渲染質量。這項工作的新穎之處在于,針對道路和非道路層的解耦和混合像素級混合器,沒有針對整個場景的傳統統一差分渲染邏輯,同時通過提出的深度有序混合渲染策略仍然保持一致和連續的疊加。此外,對由符號距離場(SDF)組成的隱式道路表示進行訓練,以監控具有微妙幾何屬性的路面。伴隨著輔助傳輸損耗和一致性損耗的使用,最終保留了具有不可察覺邊界和高保真度的新圖像。在Waymo數據集上進行的大量實驗證明,DHGS的性能優于最先進的方法。