邁向『閉環』| PlanAgent:基于MLLM的自動駕駛閉環規劃新SOTA!

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

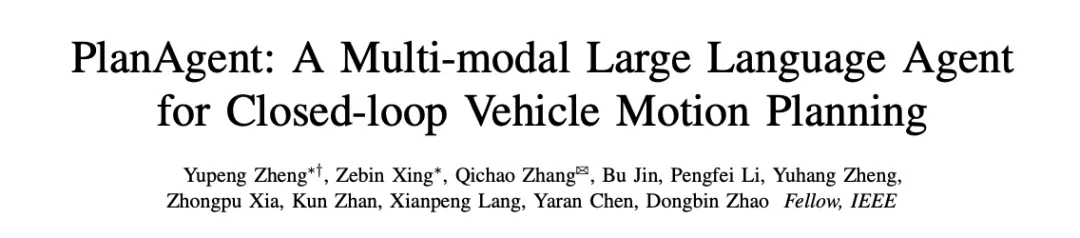

中科院自動化所深度強化學習團隊聯合理想汽車等提出了一種新的基于多模態大語言模型MLLM的自動駕駛閉環規劃框架—PlanAgent。該方法以場景的鳥瞰圖和基于圖的文本提示為輸入,利用多模態大語言模型的多模態理解和常識推理能力,進行從場景理解到橫向和縱向運動指令生成的層次化推理,并進一步產生規劃器所需的指令。在大規模且具有挑戰性的nuPlan基準上對該方法進行了測試,實驗表明PlanAgent在常規場景和長尾場景上都取得了最好(SOTA)性能。與常規大語言模型(LLM)方法相比,PlanAgent所需的場景描述詞符(token)量僅為1/3左右。

論文信息

- 論文題目:PlanAgent: A Multi-modal Large Language Agent for Closed loop Vehicle Motion Planning

- 論文發表單位:中科院自動化所,理想汽車,清華大學,北京航空航天大學

- 論文地址:https://arxiv.org/abs/2406.01587

1 引言

作為自動駕駛的核心模塊之一,運動規劃的目標是產生一條安全舒適的最優軌跡。基于規則的算法,如PDM[1]算法,在處理常見場景時表現良好,但往往難以應對需要更復雜駕駛操作的長尾場景[2]。基于學習的算法[2,3]常常會在長尾情況下過擬合,導致其在nuPlan中的性能并不如基于規則的方法PDM。

最近,大語言模型的發展為自動駕駛規劃開辟了新的可能性。最新的一些研究嘗試利用大語言模型強大的推理能力增強自動駕駛算法的規劃和控制能力。然而,它們遇到了一些問題:(1)實驗環境未能基于真實閉環場景(2)使用過量的坐標數字表示地圖細節或運動狀態,大大增加了所需的詞符(token)數量;(3)由大語言模型直接生成軌跡點難以確保安全。為應對上述挑戰,本文提出了PlanAgent方法。

2 方法

基于MLLM的閉環規劃智能體PlanAgent框架如圖1所示,本文設計了三個模塊來解決自動駕駛中的復雜問題:

- 場景信息提取模塊(Environment Transformation module):為了實現高效的場景信息表示,設計了一個環境信息提取模塊,能夠提取具有車道信息的多模態輸入。

- 推理模塊(Reasoning module):為了實現場景理解和常識推理,設計了一個推理模塊,該模塊利用多模態大語言模型MLLM生成合理且安全的規劃器代碼。

- 反思模塊(Reflection module):為了保障安全規劃,設計了一個反思機制,能夠通過仿真對規劃器進行驗證,過濾掉不合理的MLLM提案。

圖1 PlanAgent的整體框架,包含場景信息提取/推理/反思模塊

2.1 環境信息提取模塊

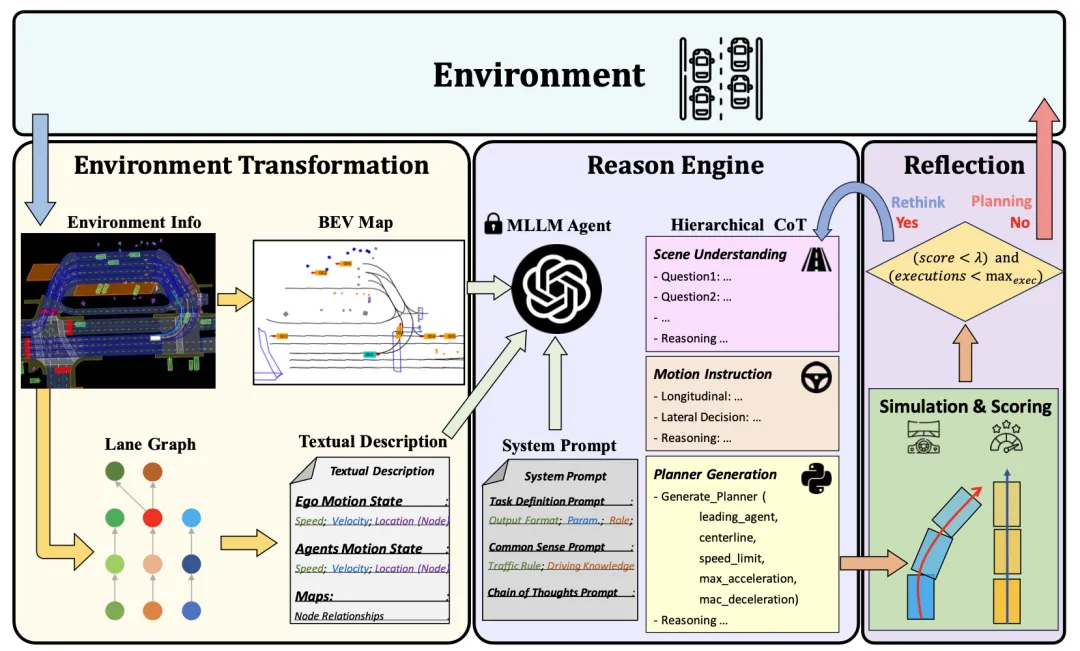

大語言模型中的提示詞(prompt)對其生成輸出的質量有著至關重要的影響。為了提高MLLM的生成質量,場景信息提取模塊能夠提取場景上下文信息,并將其轉換為鳥瞰圖(BEV)圖像和文本提示,使之與MLLM的輸入保持一致。首先,本文將場景信息轉化成鳥瞰圖(BEV)圖像,以增強MLLM對全局場景的理解能力。同時,需要對道路信息進行圖表征,如圖 2所示,在此基礎上提取關鍵車輛的運動信息,使MLLM能夠重點關注與自身位置最相關的區域。

圖2 基于圖表征的文本提示描述

2.2 推理模塊

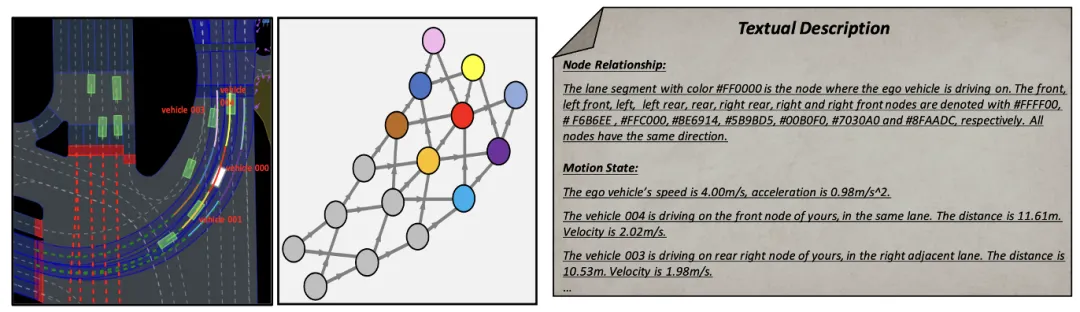

如何將大語言模型的推理能力引入到自動駕駛規劃過程中,實現具有常識推理能力的規劃系統是一個關鍵問題。本文設計的方法能夠以包含當前場景信息的用戶消息和預定義的系統消息為輸入,經過分層思維鏈多輪推理,生成智能駕駛員模型(IDM)的規劃器代碼。由此,PlanAgent能夠通過上下文學習將MLLM強大的推理能力嵌入到自動駕駛規劃任務中。

其中,用戶消息包括BEV編碼和基于圖表征提取出來的周圍車輛運動信息。系統消息包括任務的定義、常識知識以及思維鏈步驟,如圖 3所示。

圖3 系統提示模版

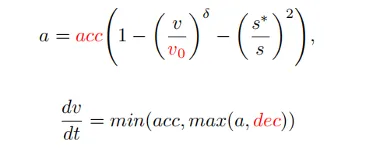

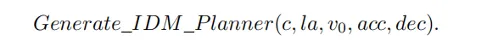

在得到prompt信息后,MLLM會對當前場景從三個層次進行推理:場景理解、運動指令和代碼生成,最終生成規劃器的代碼。在PlanAgent中,會生成跟車、中心線、速度限制、最大加速度和最大減速度參數代碼,再由IDM生成某一場景下的瞬時加速度,最終由此生成軌跡。

2.3 反思模塊

通過以上兩個模塊強化了MLLM對場景的理解和推理能力。然而,MLLM的幻覺仍然對自動駕駛的安全構成了挑戰。受到人類“三思而后行”決策的啟發,本文在算法設計中加入了反思機制。對MLLM生成的規劃器進行仿真模擬,并通過碰撞可能性、行駛距離、舒適度等指標評估該規劃器的駕駛分數。當得分低于某個閾值τ時,表明MLLM生成的規劃器欠妥,MLLM將被請求重新生成規劃器。

3 實驗與結果

本文在大規模真實場景的閉環規劃平臺nuPlan[4]進行閉環規劃實驗,以評估PlanAgent的性能,實驗結果如下。

3.1 主要實驗

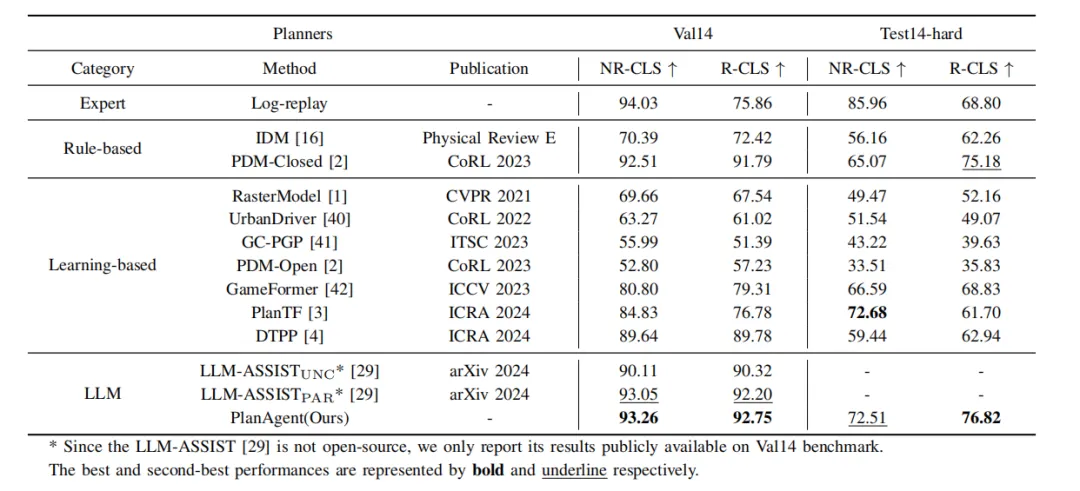

表1 PlanAgent與其他算法在nuPlan的val14和test-hard基準上的比較

如表 1所示,本文將所提出的PlanAgent和三類最前沿的算法進行比較,并在nuPlan的兩個基準val14和test-hard上進行測試。PlanAgent與其他方法相比表現出了有競爭力和可泛化的結果。

- 有競爭力的結果:在常見場景val14基準上,PlanAgent優于其他基于規則、基于學習和基于大語言模型的方法,在NR-CLS和R-CLS中都取得了最好的評分。

- 可泛化的結果:以PDM-Closed[1]為代表的規則類方法和以planTF[2]為代表的學習類方法都不能同時在val14和test-hard上表現良好。與這兩類方法相比PlanAgent能夠在克服長尾場景的同時,保證常見場景中的性能。

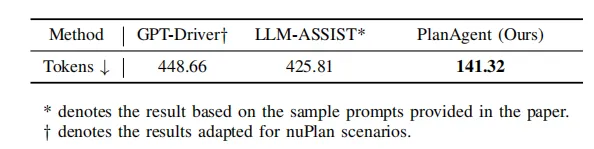

表2 不同方法描述場景所用token比較

同時,PlanAgent相比于其他基于大模型的方法所用的token數量更少,如表 2,大概只需要GPT-Driver[5]或LLM-ASSIST[6]的1/3。這表明PlanAgent能夠用較少的token更有效地對場景進行描述。這對于閉源大語言模型的使用尤為重要。

3.2 消融實驗

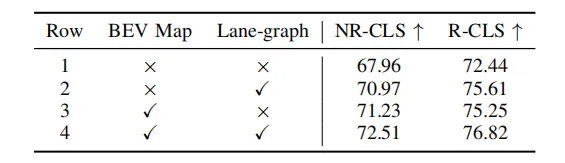

表3 場景提取模塊中不同部分的消融實驗

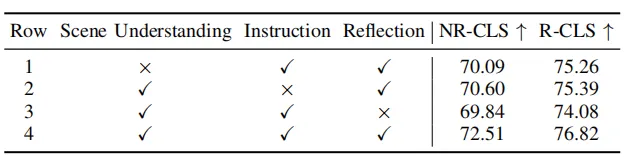

表4 分層思維鏈中不同部分的消融實驗

如表3和表4,本文對場景信息提取模塊和推理模塊中不同部分進行了消融實驗,實驗證明了各個模塊的有效性和必要性。通過BEV圖像和圖表征兩種形式可以增強MLLM對場景的理解能力,通過分層思維鏈能增強MLLM對場景的推理能力。

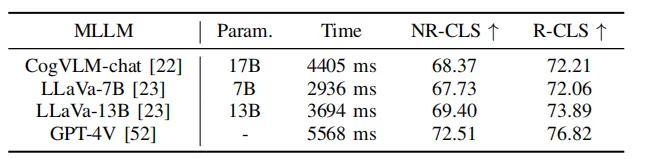

表5 PlanAgent在不同語言模型上的實驗

同時,如表 5所示,本文使用了一些開源大語言模型進行測試。實驗結果表明,在Test-hard的NR-CLS基準上,PlanAgent使用不同的大語言模型分別能夠比PDM-Closed的駕駛分數高出4.1%、5.1%和6.7%。這證明了PlanAgent與各種多模態大語言模型的兼容性。

3.3 可視化分析

環島通行場景

PDM選擇外側車道作為centerline,車輛靠外側車道行駛,在車輛匯入時卡住。PlanAgent判斷有車輛匯入,輸出合理的左換道指令,并生成橫向動作選擇環島內側車道為centerline,車輛靠內側車道行駛。

路口停止線停車場景

PDM選擇了紅綠燈類為跟車類。PlanAgent輸出合理指令,選擇停止線為跟車類。

4 結論

本文提出了一種新的基于MLLM的自動駕駛閉環規劃框架,稱為PlanAgent。該方法引入了一個場景信息提取模塊,用于提取BEV圖像,并基于道路的圖表征提取周圍車輛的運動信息。同時提出了一個具有層次結構的推理模塊,用于指導MLLM理解場景信息、生成運動指令,最終生成規劃器代碼。此外,PlanAgent還模仿人類決策進行反思,當軌跡評分低于閾值時進行重規劃,以加強決策的安全性。基于多模態大模型的自動駕駛閉環規劃智能體PlanAgent在nuPlan基準上取得了閉環規劃SOTA性能。