谷歌推世界首個AI游戲引擎,2000億游戲產業恐顛覆!0代碼生成游戲,老黃預言成真

世界上第一個完全由神經模型驅動的游戲引擎,剛剛誕生了!

「黑神話:悟空」的熱度正旺,AI又在游戲中創造了全新的里程碑。

史上首次,AI能在沒有游戲引擎的情況下,為玩家生成實時游戲了。

從此,我們開始進入一個炸裂的新時代:游戲不僅能被AI玩,還能由AI來創造和驅動。

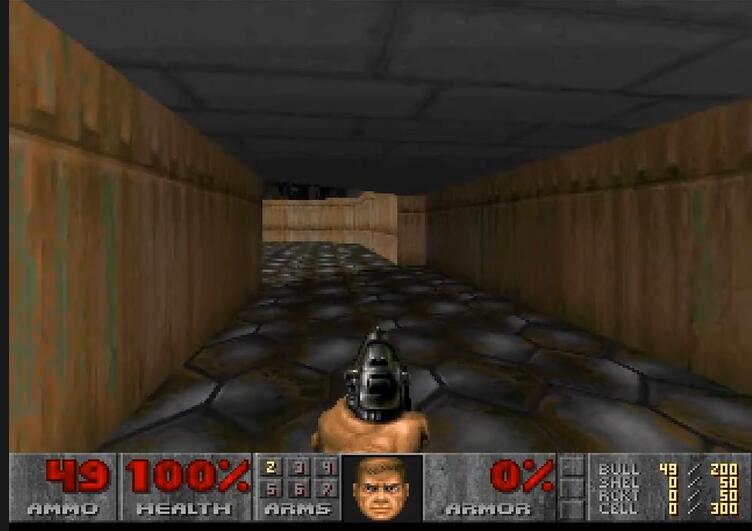

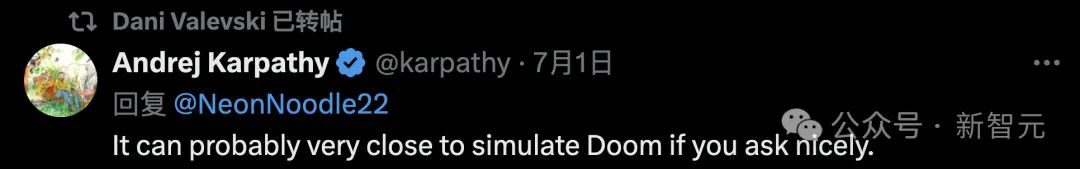

谷歌的GameNGen,可以在單個TPU上,讓AI以每秒20幀的速度,生成實時可玩的游戲。每一幀,都是由擴散模型預測的。

幾年后,AI實時生成3A游戲大作的愿望還會遠嗎?

從此,開發者不必再手動編程游戲邏輯,開發時間和成本都會顯著降低。

價值2000億美元的全球游戲產業,可能會被徹底顛覆!

谷歌研究者表示,GameNGen是第一個完全由神經模型驅動的游戲引擎,能夠在復雜環境中,實現高質量的長軌跡實時交互。

論文地址:https://arxiv.org/abs/2408.14837

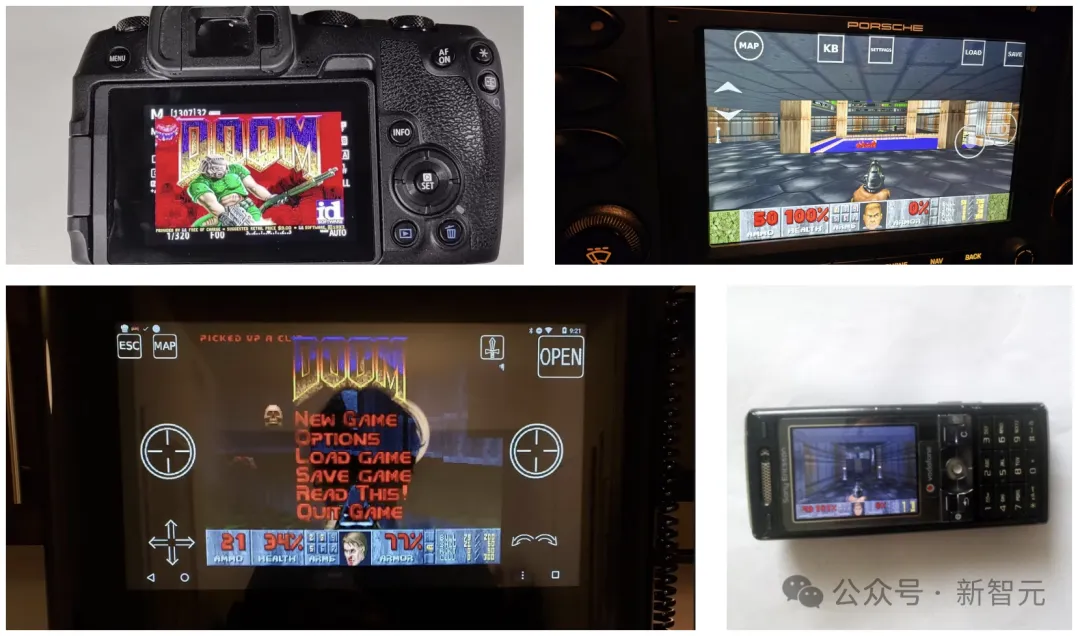

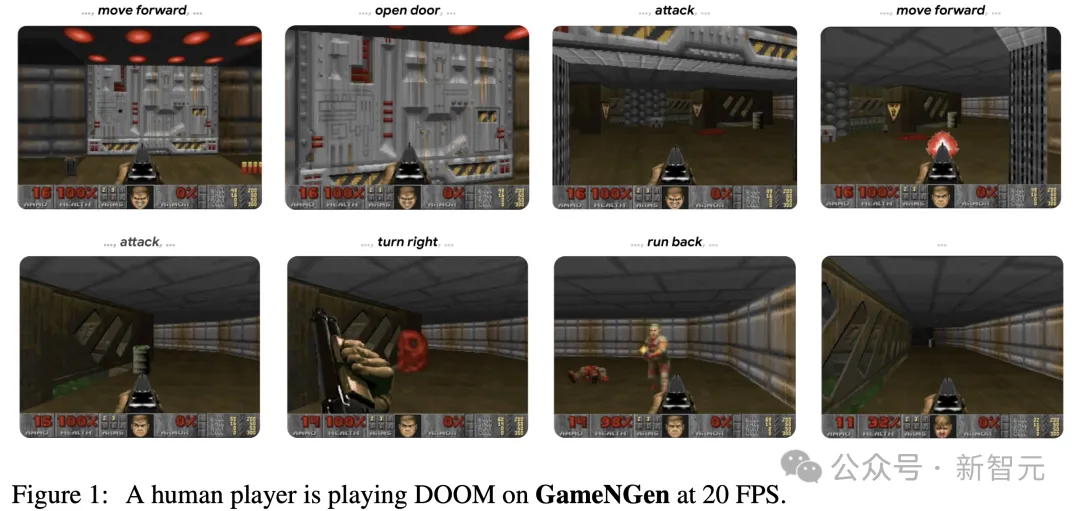

不僅速度是實時的,它的優秀畫質,也是讓開發者顫抖的地步。

模擬「毀滅戰士」時,它下一幀預測的峰值信噪比(PSNR)達到了29.4,已經可以和有損JPEG壓縮相媲美。

在神經網絡上實時運行時,視覺質量已經達到了與原始游戲相當。

模擬片段和游戲片段如此相似,讓不少人類被試都分不清,眼前的究竟是游戲還是模擬?

網友感慨:這不是游戲,這是人生模擬器。

小島秀夫的另一個預言,成真了。

3A電視劇是不是也來了?想象下,按照自己的喜好生成一版《權游》。

想象下,1000年后或一百萬年后,這項技術是什么樣?我們是模擬的概率,已經無限接近于1了。

從此,游戲開發不再需要游戲引擎?

AI首次完全模擬具有高質量圖形和復雜交互的復雜視頻游戲,就做到了這個地步,實在是太令人驚嘆了。

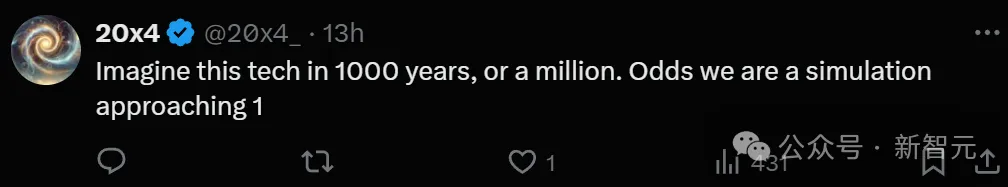

作為最受歡迎、最具傳奇色彩的第一人稱射擊游戲,自1993年發布以來,「毀滅戰士」一直是個技術標桿。

它被移植到一系列超乎想象的平臺上,包括微波爐、數碼相機、洗衣機、保時捷等等。

而這次,GameNGen把這些早期改編一舉超越了。

從前,傳統的游戲引擎依賴的是精心編碼的軟件,來管理游戲狀態和渲染視覺效果。

而GameNGen,只用AI驅動的生成擴散模型,就能自動模擬整個游戲環境了。

從視頻中可以看出,神經網絡復現游戲標志性視覺效果的能力簡直是一絕,AI實時生成復雜交互環境的潛力非常驚人

「毀滅戰士」一直以復雜的3D環境和快節奏的動作聞名,現在,所有這些都不需要游戲引擎的常用組件了!

AI引擎的意義,不僅僅是減少游戲的開發時間和成本。

這種技術,可以使游戲創作徹底民主化,無論是小型工作室,還是個人創作者,都能創造出從前難以想象的復雜互動體驗。

此外,AI游戲引擎,還給全新的游戲類型打開了大門。

無論是環境、敘事,還是游戲機制,都可以根據玩家的行為動態來發展。

從此,游戲格局可能會被整個重塑,行業會從熱門游戲為中心的模式,轉向更多樣化的生態系統。

順便一提,「DOOM」的大小只有12MB。

大佬們「瘋了」

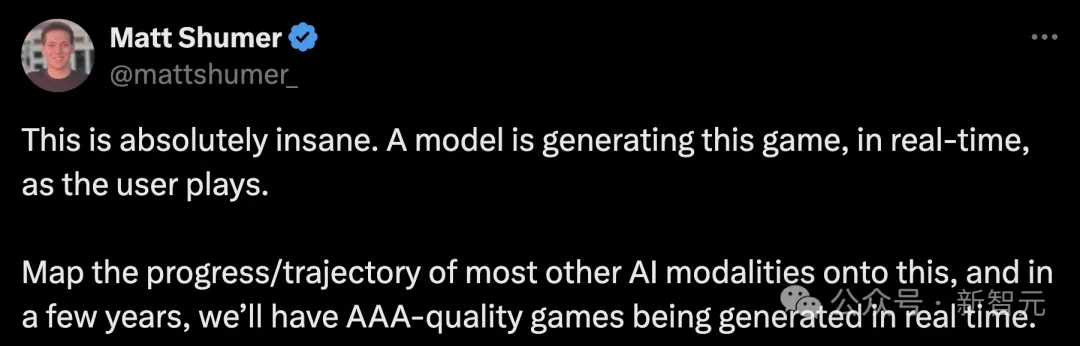

AI初創HyperWrite的CEO Matt Schumer表示,這簡直太瘋狂了!用戶玩游戲時,一個模型正在實時生成游戲。

如果將大多數AI模型的進展/軌跡映射到這上面,那么在幾年內,我們將會得到3A級生成游戲。

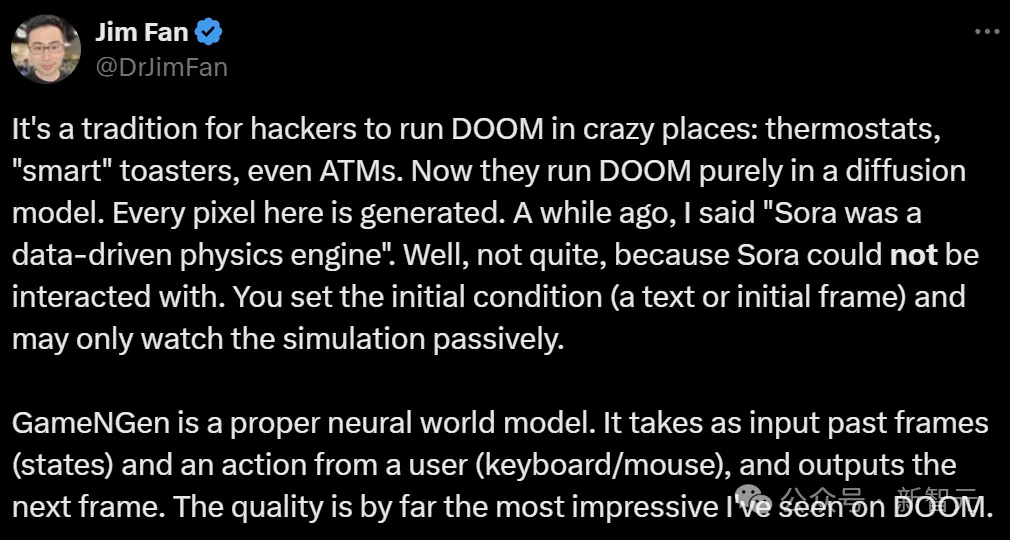

英偉達高級科學家Jim Fan感慨道,被黑客們在各種地方瘋狂運行的DOOM,竟然在純粹的擴散模型中實現了,每個像素都是生成的。

連Sora跟它比起來,都黯然失色。我們只能設定初始條件(一個文本或初始幀),然后只能被動觀看模擬過程。

因為Sora無法進行交互,因此還不算是一個「數據驅動的物理引擎」。

而GameNGen是一個真正的神經世界模型。它將過去的幀(狀態)和用戶的一個動作(鍵盤/鼠標)作為輸入,并輸出下一幀。這種質量,是他見過的最令人印象深刻的DOOM。

隨后,他深度探討了一些GameNGen中存在的限制。

比如在單個游戲上過擬合到了極致;無法想象新的場景,無法合成新的游戲或交互機制;數據集的瓶頸,導致了方法無法推廣;無法實現用提示詞創造可玩世界,或用世界模型訓練更好的具身AI,等等。

一個真正有用的神經世界模型,應該是什么樣子?

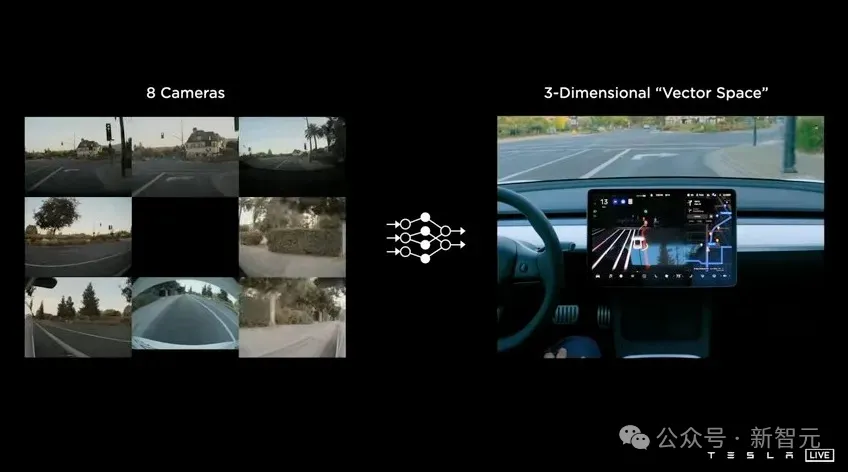

馬斯克的回答是:「特斯拉可以用真實世界的視頻做類似的事情」。

的確,數據是難點。

Autopilot團隊可能擁有數萬億的數據對(攝像頭視頻,方向盤動作)。

有了如此豐富的真實世界數據,完全有可能訓練一個涵蓋各種極端情況的通用駕駛模擬器,并使用它來部署和驗證新的完全自動駕駛(FSD)版本,而不需要實體車輛。

最后Jim Fan總結道:不管怎么說,GameNGen仍是一個非常出色的概念驗證——至少我們現在知道,9億幀是將高分辨率DOOM壓縮到神經網絡中的上限。

網友們感慨:擴散網絡學習物理引擎和游戲規則的方式,太瘋狂了。

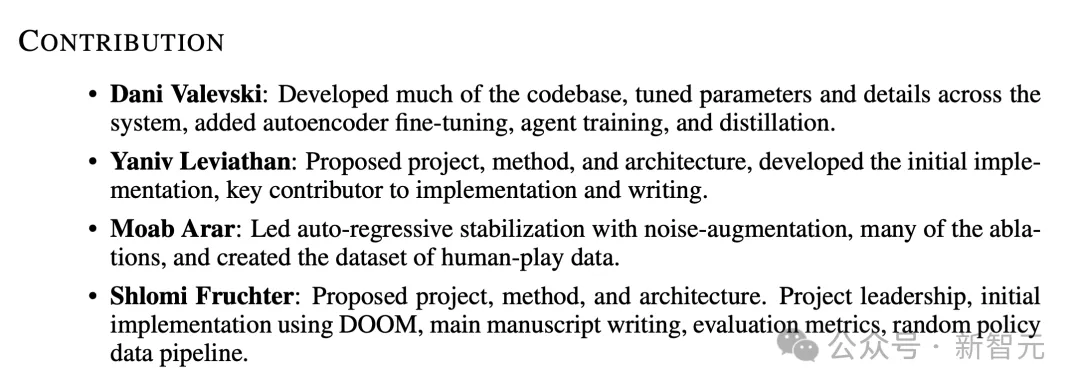

核心作者:個人里程碑

谷歌DeepMind核心貢獻者,項目負責人Shlomi Fruchter,在社交媒體上,介紹了自己開發GameNGen的過程。

他表示,「GameNGen是自己開發路上的里程碑」。

從最初手寫GPU渲染代碼(顯式),到現在訓練能在GPU上運行的神經網絡(隱式),甚至包含了游戲邏輯,讓我有一種實現了完整「閉環」的感覺。

Fruchter進行的第一個大型編碼項目之一是3D引擎(如下圖所示)。早在2002年,GPU仍只能用于渲染圖形。

還記得,第一款圖形處理器GeForce 256是在1999年發行。

渲染3D圖形恰好需要大量的矩陣運算,這恰恰是GPU所擅長的。

然后谷歌研究人員編寫高級著色器語言代碼,計算自定義渲染邏輯并構建新的視覺效果,同時還能保持高幀率。

GameNGen的誕生,是源于一個好奇心:

「我們能否在當前的處理器上,運行一個隱式神經網絡,來進行實時互動游戲」。

對于Fruchter以及團隊成員來說,最終答案是一個令人興奮的發現。

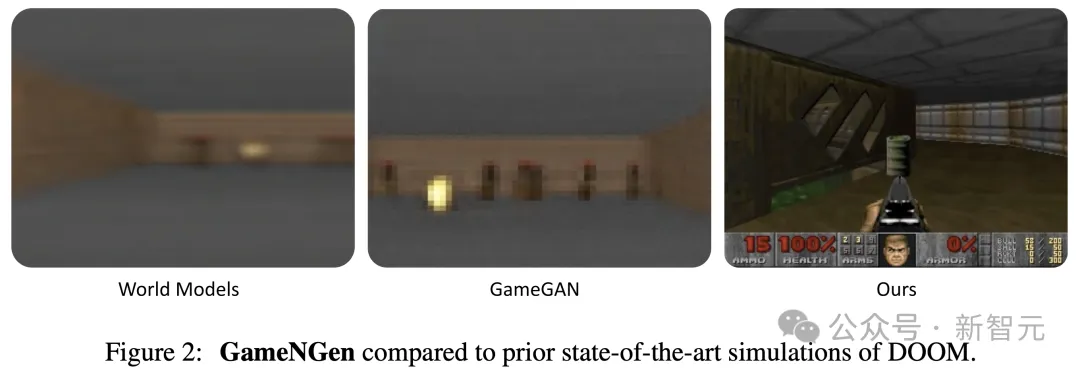

AI大牛Karpathy曾說過,100%純軟件2.0計算機,只有一個神經網絡,完全沒有傳統軟件。

設備輸入(音頻、視頻、觸摸等)直接到神經網絡中,其輸出直接作為音頻/視頻在揚聲器/屏幕上顯示,就是這樣。

有網友便問道,那就是它不能運行DOOM了?

對此,Karpathy表示,如果能夠很好提出請求,它可能可以非常接近地模擬DOOM。

而現在,Fruchter更加肯定,它可以運行DOOM了。

另一位谷歌作者Dani Valevski也轉發了此帖,對此愿景表示極度認可。

GameNGen或許標志著游戲引擎全新范式的開啟,想象一下,和自動生成的圖像或視頻一樣,游戲也是自動生成的。

雖然關鍵問題依舊存在,比如如何訓練、如何最大程度利用人類輸入,以及怎樣利用神經游戲引擎創建全新的游戲。但作者表示,這種全新范式的可能性讓人興奮。

而且,GameNGen的名字也暗藏彩蛋,可以讀出來試一試——和Game Engine有相似的發音。

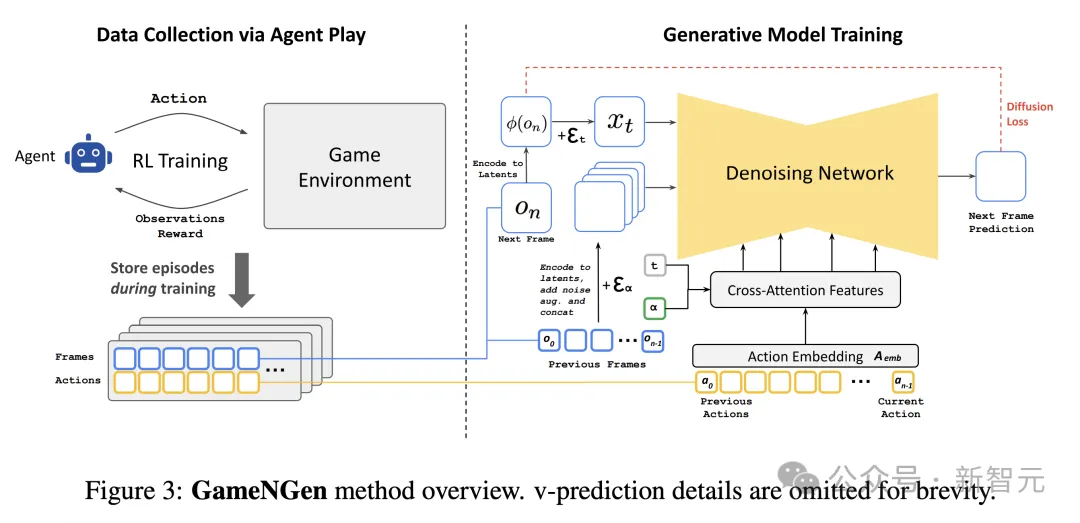

Agent采集軌跡,SD預測生成

在手動制作計算機游戲的時代,工作流程包括(1)收集用戶輸入(2)更新游戲狀態,以及(3)將更新后的狀態渲染為屏幕像素,計算量取決于幀率。

盡管極客工程師們手中的Doom可以在ipod、相機,甚至微波爐、跑步機等各種硬件上運行,但其原理依舊是原樣模擬模擬手動編寫的游戲軟件。

看起來截然不同的游戲引擎,也遵循著相同的底層邏輯——工程師們手動編程,指定游戲狀態的更新規則和渲染邏輯。

如果和擴散模型的實時視頻生成放在一起,乍一看好像沒什么區別。然而,正如Jim Fan指出的交互式世界模擬不僅僅是非常快速的視頻生成。

其一,生成過程需要以用戶的輸入動作流為條件,這打破了現有擴散模型架構的一些假設。

其二,模型需要自回歸生成幀,這往往會導致采樣發散、模型不穩定等問題。

Agent數據收集

由于無法直接對游戲數據進行大規模采樣,因此首先教會一個agent玩游戲,在各種場景中生成類似于人類且足夠多樣化的訓練數據。

agent模型使用深度強化學習方法進行PPO訓練,以簡單的CNN作為特征網絡,共生成900M幀的??_a?g?e?n?t數據集,包括agent的動作以及對環境的觀察,用于后續的訓練 、推理和微調。

訓練生成模型

GameNGen使用的Stable Diffusion 1.4是文生圖擴散模型,其中最重要的架構修改就是,讓以文本為條件的模型適應數據集中的動作數據a_{<n}和對先前幀的觀察結果o_{<n}。

具體來說,首先訓練一個嵌入模塊A_e?m?b,將agent的每個動作(例如特定的按鍵)轉換為單個token,并將交叉注意力中的文本替換為編碼后的動作序列。

為了能接受o_{<n}作為條件,同樣使用自動編碼器?將其編碼到潛在空間中(即x_t),同時在潛在的通道維度上與噪聲隱變量ε_α拼接在一起。

實驗中也嘗試過用交叉注意力處理o_{<n}輸入,但并沒有明顯改進。

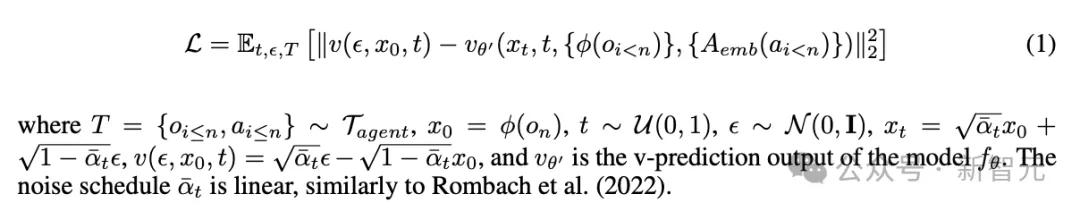

相比原來的Stable Diffusion,GameNGen對優化方法也做了改進,使用velocity parameterization方法最小化擴散損失。

GameNGen方法概述(省略v-prediction細節)

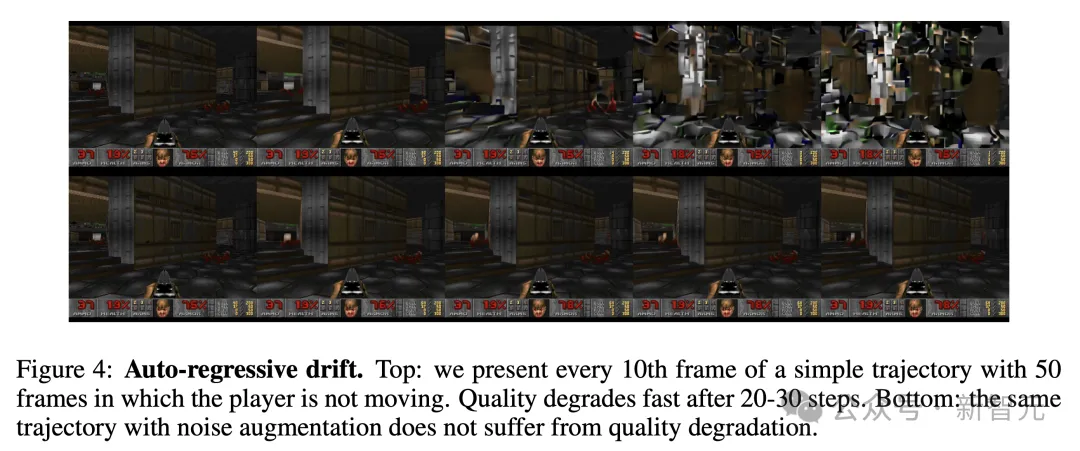

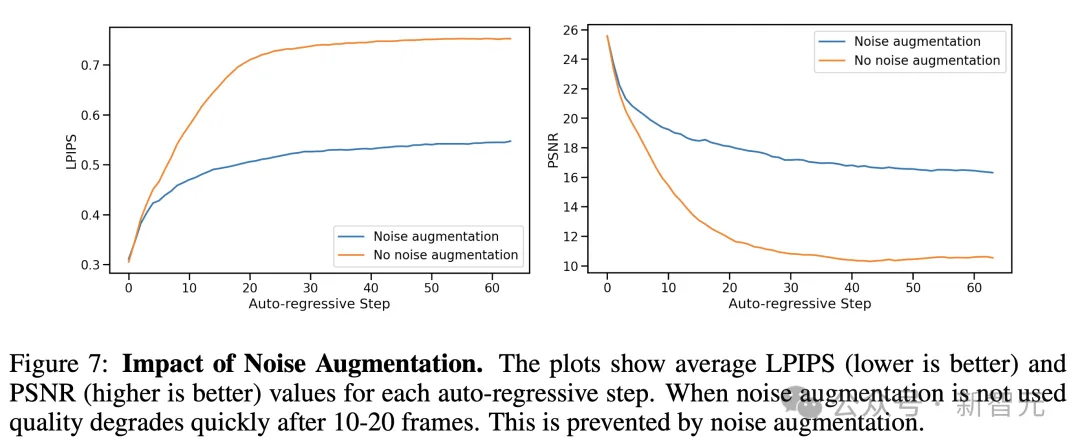

噪聲增強減輕自回歸漂移

從原Stable Diffusion的教師強制訓練轉換為游戲引擎中的自回歸采樣,會不可避免地導致錯誤累積和樣本質量快速下降。

為了避免這個問題,訓練生成模型時會在編碼過的上下文幀中添加不同數量的高斯噪聲,同時將噪聲水平作為模型的輸入,從而讓降噪網絡可以糾正先前幀中采樣的信息。

這些操作對于隨著時間推移時保證幀質量至關重要。在推理過程中,也可以控制添加的噪聲水平以最大限度地提高生成質量。

自回歸漂移:上圖中, 20-30個步驟后,生成質量會快速下降;而下圖中,具有噪聲增強的相同軌跡不會出現質量下降

推理

模型在推理時使用DDIM采樣方法。之所以能達到20FPS的實時生成效率,與GameNGen推理期極高的采樣效率直接相關。

通常,生成擴散模型(例如Stable Diffusion)無法只用單個去噪步驟產生高質量結果,而是需要數十個采樣步驟。

但令人驚訝的是,GameNGen只需4個DDIM采樣步驟就能穩健地模擬 DOOM,而且相比使用20個或更多采樣步驟時,質量并沒有明顯下降。

作者推測,這可能源于多個因素的共同作用,包括可采樣的圖像空間受限,以及通過先前幀信息施加了較強的條件限制。

僅使用4個降噪步驟讓U-Net的推理成本降低至40ms,加上自動編碼器,總推理成本為50ms,相當于每秒生成20幀圖像。

實驗還發現,模型蒸餾后進行單步采樣能夠進一步提高幀率,達到50FPS,但會以犧牲模擬質量為代價,因此最后還是選用了20FPS的采樣方案。

AI游戲生成太逼真,60%片段玩家沒認出

模擬質量

總的來說,就圖像質量而言,GameNGen在長時間軌跡上預測,達到了與原始游戲相當的模擬質量。

對于短時間軌跡,人評估者在模擬片段和真實游戲畫面中,進行區分時,比隨機猜測略強一些。

這意味著什么?

AI生成的游戲畫面,太過逼真沉浸,讓人類玩家有時根本無法辨別。

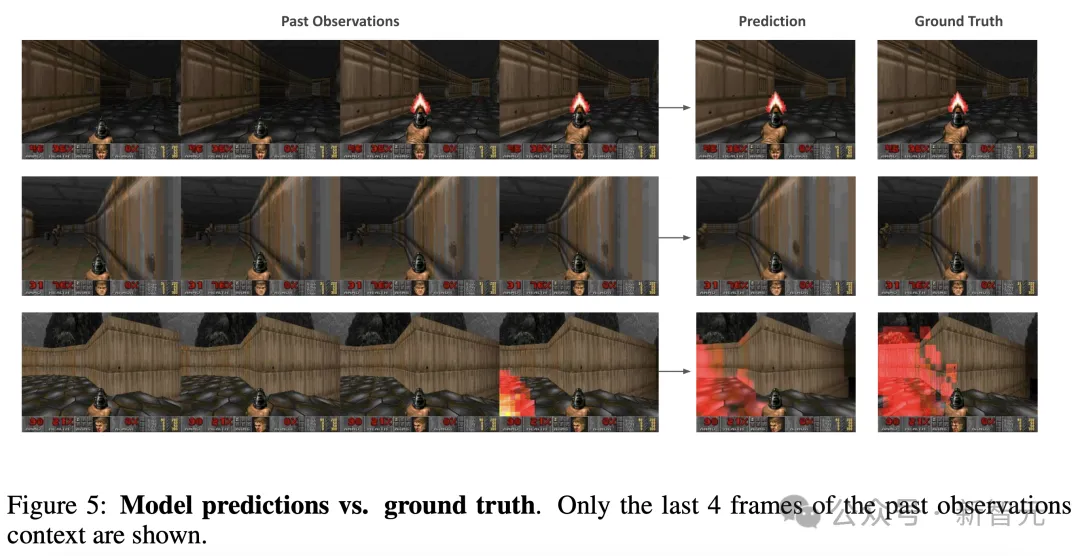

圖像質量

這里,評估中采用了LPIPS和PSNR作為評估指標。這是在強制教學設置下進行測量,即基于真實過去觀察預測單個幀。

對5個不同關卡中,隨機抽取的2048個軌跡進行評估時,GameNGen達到了29.43的PSNR和0.249的LPIPS。

下圖5展示了,模型預測和相應的真實樣本示例。

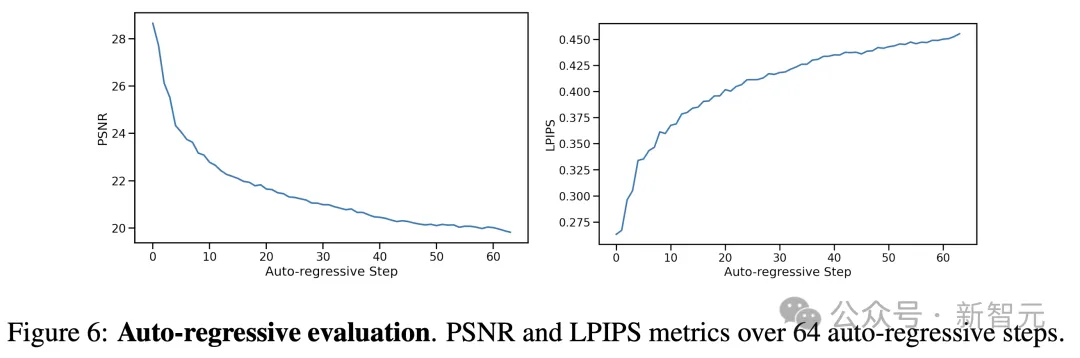

視頻質量

針對視頻質量,研究人員使用了自回歸設置,即模型基于自己的過去預測來生成后續幀。

不過,預測和真實軌跡在幾步后會發生偏離,主要是由于幀間移動速度的微小差異累積。

如下圖6所示,隨著時間推移,每幀的PSNR值下降,LPIPS值上升。

預測軌跡在內容和圖像質量方面,仍與實際游戲相似,但逐幀指標在捕捉這一點上,能力有限。

因此,研究團隊測量了在512個隨機保留軌跡上,計算的FVD(用于測量預測和真實軌跡分布之間的距離)。

這里,分別對16幀(0.8秒)和32幀(1.6秒)兩種模擬長度,進行了測試。

最終,得到的FVD分別是114.02,以及186.23。

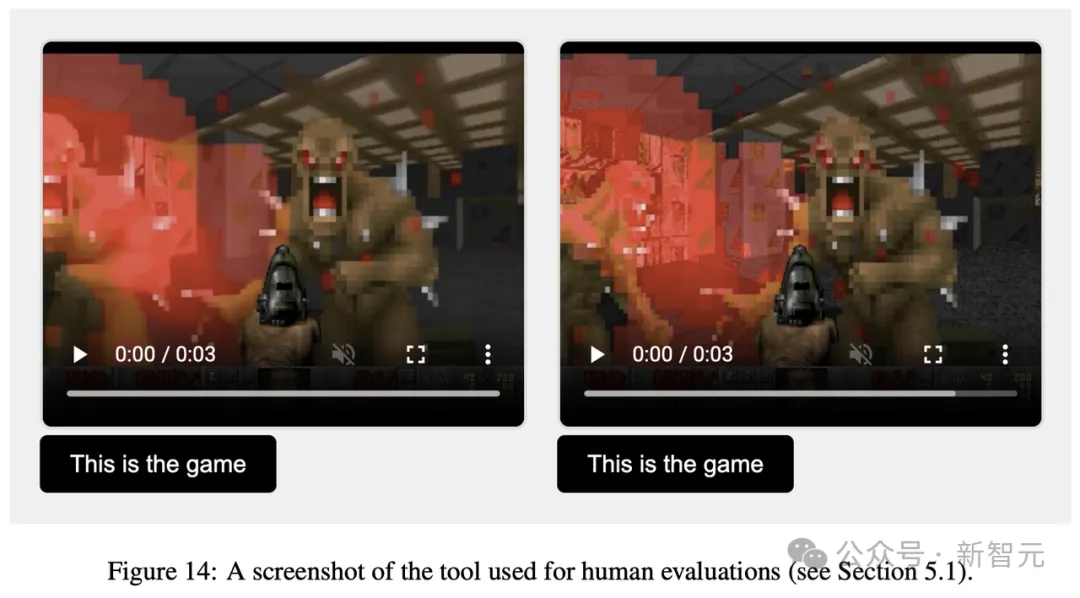

人工評估

為了得到更真實的評估,研究者向10名人類評分者,提供了130個隨機短片段(長度為1.6秒和3.2秒)。

并且,將GameNGen模擬的游戲和真實游戲并排對比,如下所示。

評估者的任務,便是識別其中,哪一個是真實游戲。

結果發現,針對1.6秒生成游戲的片段,在58%情況下,他們認為GameNGen生成游戲是真實的。

而對于3.2秒片段,這一比率更高,達到了60%。

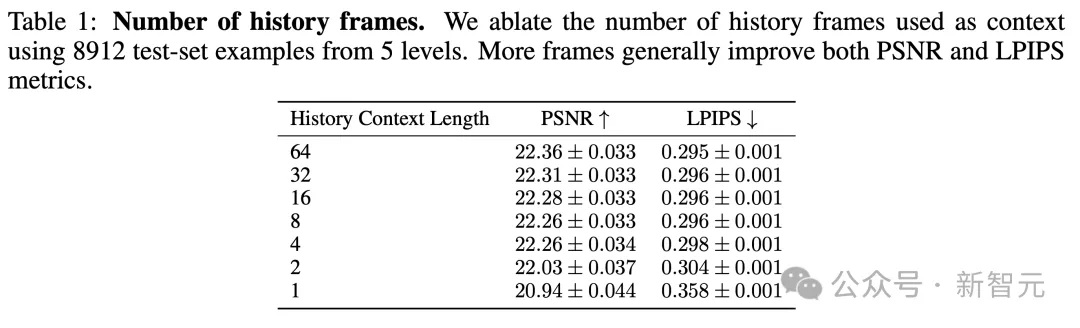

消融實驗

接下來,研究者評估了架構中,不同組件的重要性,從評估數據集中采樣軌跡,并計算地面真值與預測幀之間的LPIPS和PSNR指標。

上下文

通過訓練N∈{1, 2, 4, 8, 16, 32, 64}模型,測試上下文中過去觀察數量N的影響。(標準模型使用了N=64)。

這影響了歷史幀和動作的數量。

保持解碼器凍結情況下,訓練模型200,000步,并在5個關卡的測試集軌跡上進行評估。

結果如下表1所示,如預期一樣,研究者觀察到GameNGen生成質量,隨著上下文增加,而提升。

更有趣的是,在1幀和2幀之間,這一改進非常大,但往后開始很快接近了閾值線,改進質量逐漸放緩。

即便用上了最大上下文(64幀),GameNGen模型也僅能訪問,略超過3秒的歷史信息。

另一個發現是,大部分游戲狀態可能會持續更長時間。

表1結果很好地說明了,未來可能需要改變模型架構,來支持更長的上下文。同時,探索更好的方法,采用過去幀作為條件。

噪聲增強

為了消除噪聲增強的影響,研究人員還訓練了一個沒有添加噪聲的模型。

通過對比評估,經過噪聲增強的標準模型和沒有添加噪聲的模型(在200k訓練步驟后),以自回歸方式計算預測幀與真實幀之間的PSNR和LPIPS指標。

如下圖7所示,呈現了每個自回歸步驟的平均指標值,總共達64幀。

這些評估是在隨機保留的512條軌跡上進行的。

結果顯示,沒有噪聲增強時,與真實值的LPIPS距離,比起研究標準噪聲增強模型增加得更快,而PSNR下降,表明模擬與真實值的偏離。

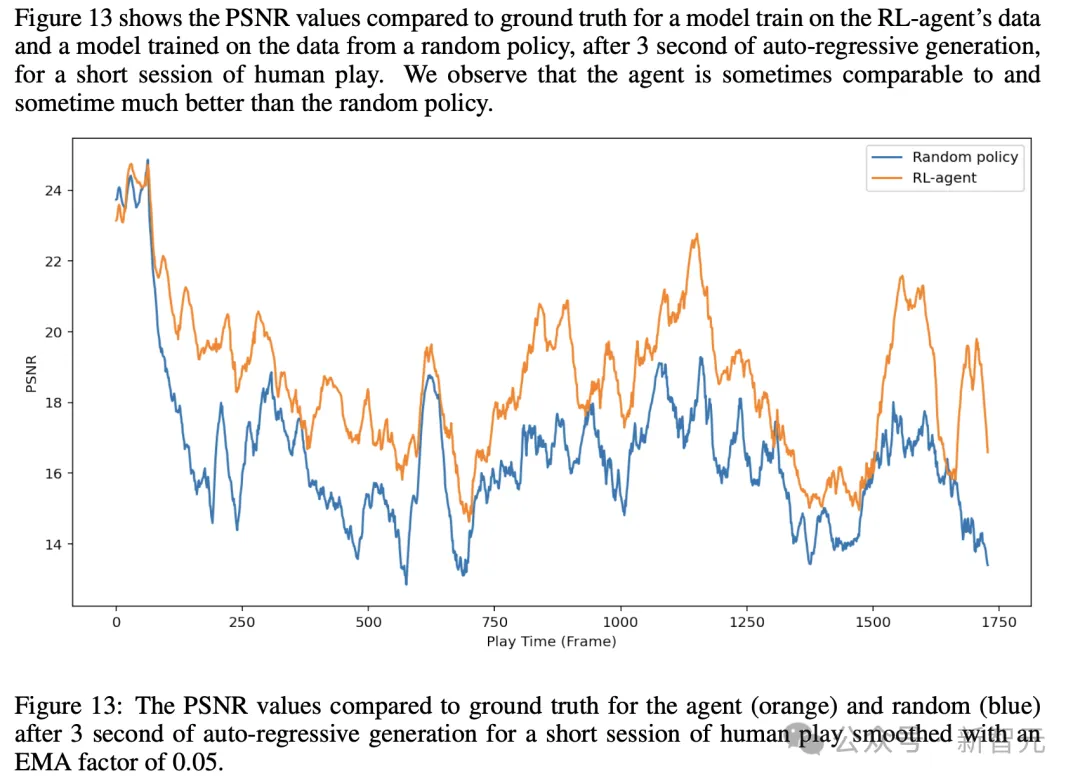

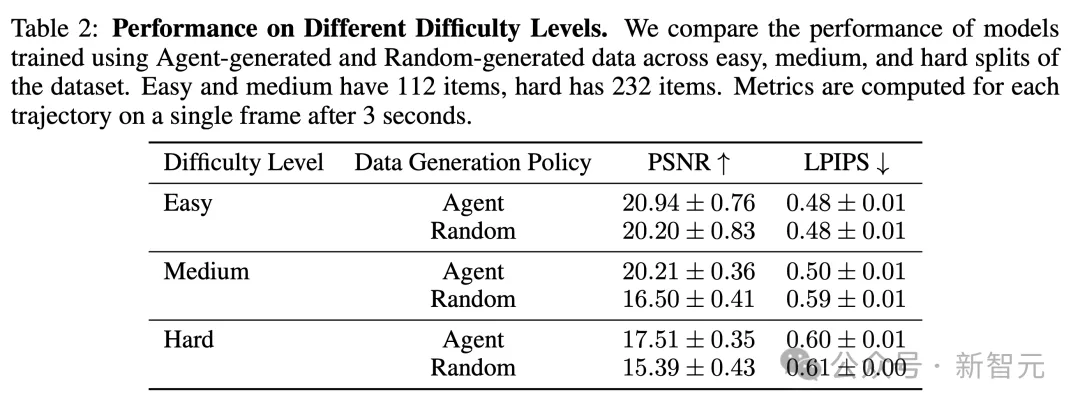

智能體

最后,研究人員將智能體生成的數據訓練,與使用隨機策略生成的數據訓練,進行了比較。

這里,通過訓練兩個模型,以及解碼器,每個模型訓練700k步。

它們在一個由5個關卡組成的2048條人類游戲軌跡的數據集上,進行評估。

而且,研究人員比較了在64幀真實歷史上下文條件下,生成的第一幀,以及經過3秒自回歸生成后的幀。

總得來說,研究觀察到,在隨機軌跡上訓練模型效果出乎意料地好,但受限于隨機策略的探索能力。

而在比較單幀生成時,智能體僅略勝一籌,達到25.06 PNSR,而隨機策略為24.42。

而在比較3秒情況下,差異增加到19.02 Vs 16.84。

在手動操作模型時,他們還觀察到,某些區域對兩者都非常容易,某些區域對兩者都非常困難,而在某些區域智能體表現更好。

因此,作者根據其在游戲中與起始位置的距離,將456個示例手動分為三個級別:簡單、中等和困難。

如下表2所示,結果觀察到,在簡單和困難集合中,智能體僅略優于隨機,而在中等集合中,智能體的優勢如預期般更大。

0代碼生成游戲,老黃預言成真

今天,視頻游戲,是由人類編程的。

GameNGen的誕生,開啟了實時互動視頻游戲的全新范式。

在這一范式中,游戲是神經模型的「權重」,而非代碼行。

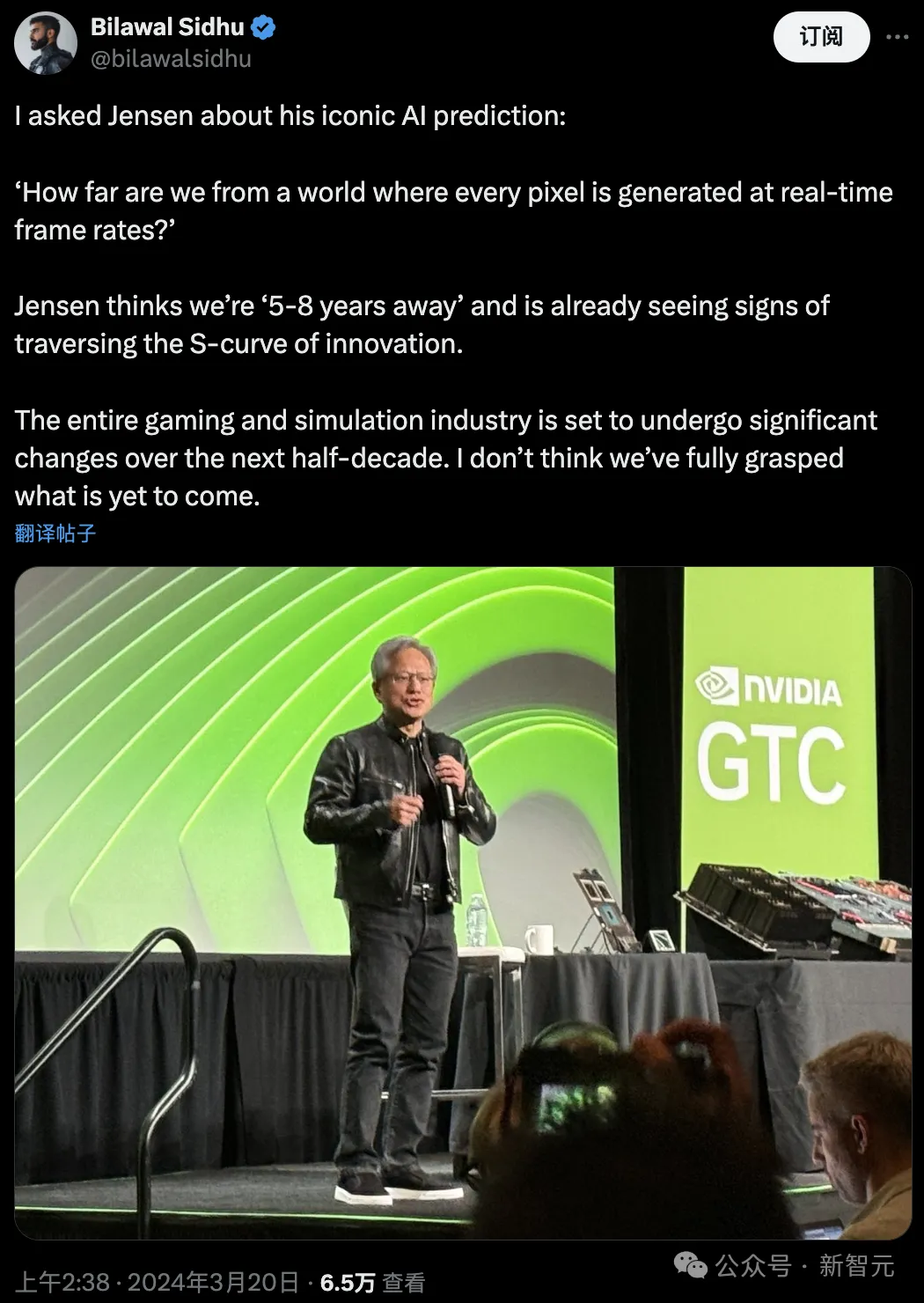

如今看來,老黃的預言近在眼前。

每個像素很快都將會是生成的,并非是渲染的。

在今年GTC大會的記者會上,Bilawal Sidhu就老黃的話,提出了一個后續問題:「我們距每個像素都是以實時幀速率生成的世界還有多遠」?

老黃表示,我們還需要5-8年的時間,并且現已看到了跨越創新S曲線的跡象。

它表明,當前存在一種架構和模型權重,可以讓神經網絡能夠在現有GPU上,有效交互運行復雜游戲DOOM。

不過,GameNGen仍有許多重要的問題存在,這也是谷歌開發者接下來繼續攻克的問題。

Shlomi Fruchter帶領團隊開辟了游戲制作的另一片天地,并希望這個范式能為前路指明方向。

在這種新范式下,能夠直接拉低視頻游戲的開發成本,并讓更多人得到訪問。

僅需一句話,或者是一個示例圖像,未來可任何一個開發者,皆可以對游戲進行開發和編輯。

另外,為現有游戲創建/修改行為,可能在短期就能實現了。

比如,我們可以將一組幀,轉化為一個全新可玩的關卡,或者僅基于示例圖像創建一個新角色,無需編寫代碼。

新范式的好處,或許還能保持足夠優秀的幀率,和極少的內存占用。

正如論文作者所述,他們希望這小小一步的嘗試,能夠對人們游戲體驗,甚至更廣泛地對日常交互軟件系統的互動,帶來有極大價值的改善。

從游戲到自動駕駛汽車,令人興奮的可能性

更令人興奮的是,GameNGen的潛在應用,遠遠超出了游戲領域!

無論是虛擬現實、自動駕駛汽車還是智能城市行業,都可能因此而變革。

因為在這些行業中,實時模擬對于培訓、測試和運營管理都至關重要。

比如在自動駕駛汽車中,需要能夠模擬無數的駕駛場景,以安全地在復雜的環境中行駛。

而GameNGen這類AI驅動引擎,恰恰可以通過高保真度和實時處理來執行這項任務。

在VR和AR領域,AI引擎可以創建完全沉浸式的交互式世界,還能實時適應用戶輸入。

這種交互式模擬產生的巨大吸引力,可能會徹底改變教育、醫療保健和遠程工作等行業!

當然,GameNGen也存在一些挑戰。

雖然它可以以交互速度運行《毀滅戰士》,但圖形密集程度更高的游戲,可能會需要更大的算力。

另外,它是針對特定游戲量身定制的,因此要開發能運行多個游戲的通用AI游戲引擎,挑戰仍然艱巨。

但現在,我們儼然已至未來的風口浪尖,從此,我們最喜歡的游戲不是從代碼行中誕生,而是從機器的無限創造力中誕生。

從此,人類創造力和機器智能之間的界限會越來越模糊。

通過GameNGen,谷歌研究人員讓我們對未來有了令人興奮的一瞥——

在這個世界中,阻礙我們虛擬體驗的唯一限制,就是AI的想象力。