港科技&大疆:基于自適應交互模態探索的預測與決策

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

- 論文鏈接:https://arxiv.org/pdf/2408.13742

- 代碼鏈接:https://github.com/HKUST-Aerial-Robotics/MIND

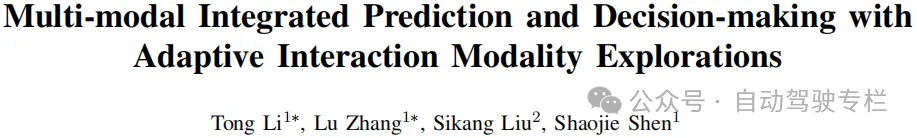

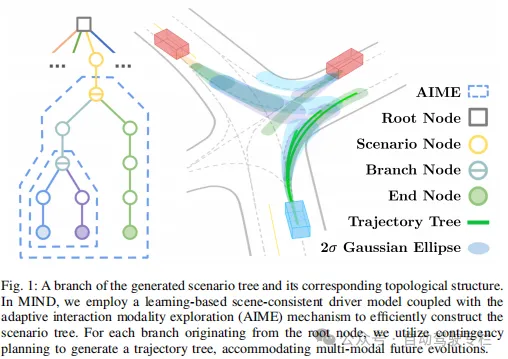

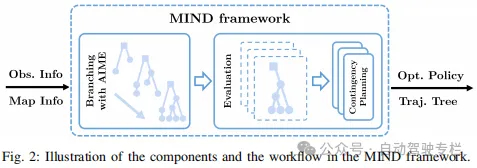

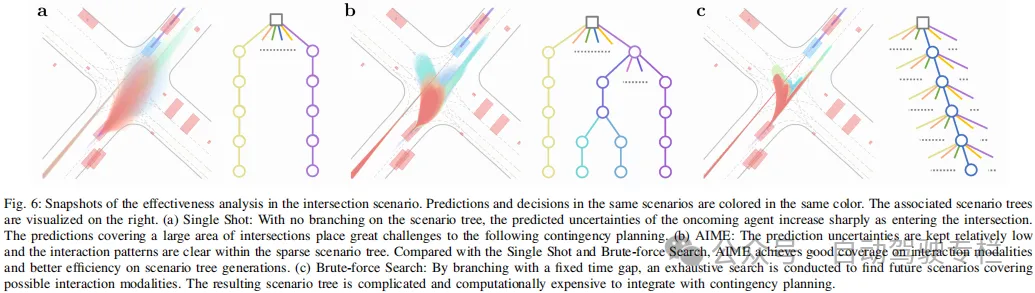

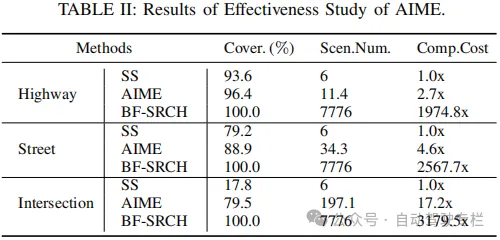

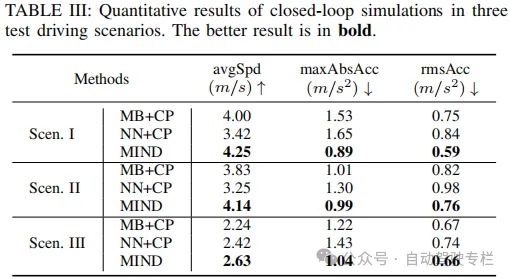

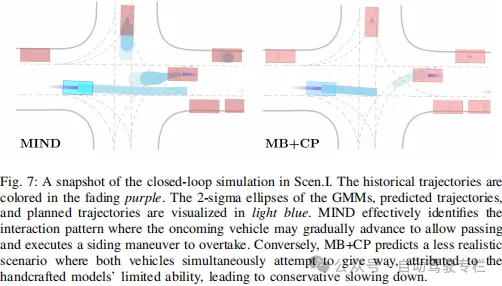

本文介紹了基于自適應交互模態探索的多模態集成的預測與決策。由于多模態交互的復雜性,在擁堵且動態的環境中導航給自動駕駛系統帶來了重大挑戰,其中各種交通參與者和自動駕駛車輛的行為是復雜的,并且是隱式耦合的。本文提出了一種新的框架,即多模態集成的預測與決策(MIND),其通過高效地生成涵蓋多種不同交互模態的聯合預測和決策來解決這些挑戰。具體而言,MIND利用基于學習的場景預測來獲得具有社會一致性交互模態的集成預測和決策,并且利用模態感知動態分支機制來生成場景樹,該場景樹高效地捕獲不同交互模態的演變,其在規劃范圍內交互不確定性的變化較小。交互不確定性下的應急規劃無縫地利用場景樹來獲得明確且考慮多模態演變的行為。基于現實世界駕駛數據集的閉環仿真中的綜合實驗結果表明,本文方法在各種駕駛環境下的性能優于其它強大的基線。

主要貢獻

本文的貢獻總結如下:

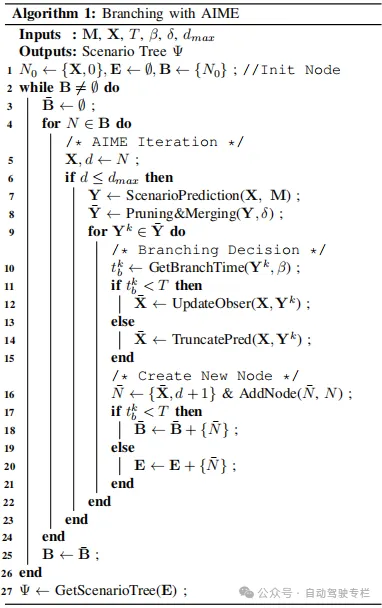

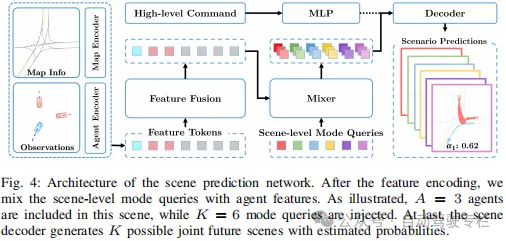

1)本文設計了一種場景預測網絡,并且將其與具有動態分支機制的樹搜索技術相結合,從而獲得覆蓋范圍更廣的場景樹,用于探索世界的演變;

2)對于場景樹中的多種潛在未來變化,本文利用應急規劃來自然地生成針對從根開始的每個分支的最優軌跡樹,從而確定最佳決策;

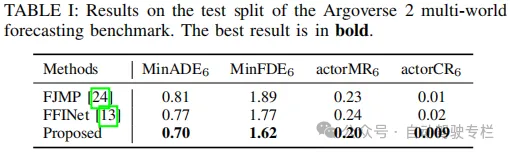

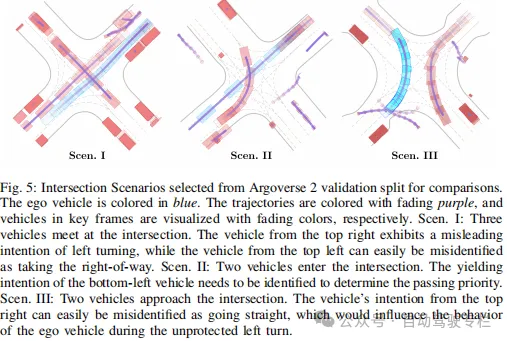

3)本文通過各種實驗評估MIND,結果表明,在不同的駕駛場景中優于其它基線,展現了其在復雜情況下的有效性。

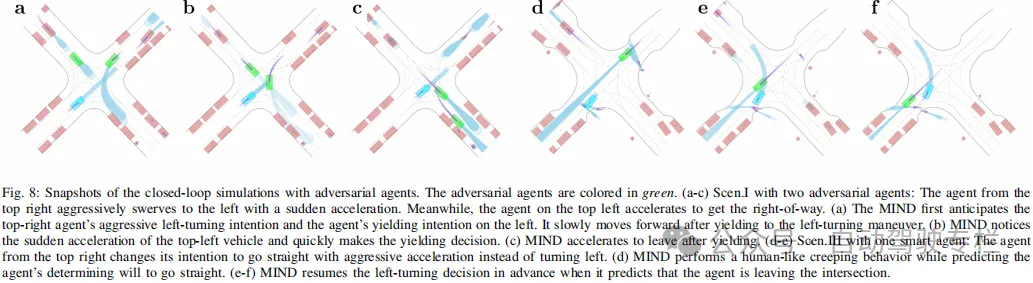

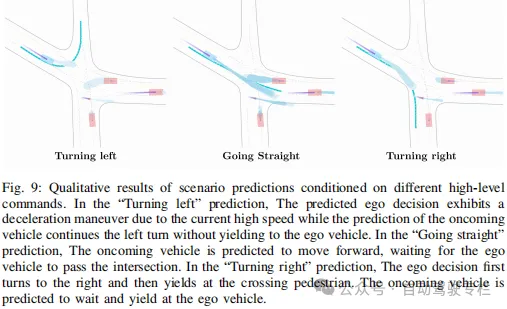

論文圖片和表格

總結

本文引入了MIND框架,其作為動態交互環境中實現自動駕駛同時預測與決策的綜合方法。該框架系統性地結合了場景預測網絡、自適應交互模態探索機制和應急規劃,以在處理多模態未來演變的同時,在復雜交互場景中生成合理的行為。與最新技術的廣泛定量比較以及定性實驗證明了本文方法的優越性。展望未來,本文旨在將所提出的框架擴展到現實世界應用中。