開源!上海AI Lab視頻生成大模型書生·筑夢 2.0來了

近日,上海人工智能實驗室推出新一代視頻生成大模型 “書生?筑夢 2.0”(Vchitect 2.0)。根據官方介紹,書生?筑夢 2.0 是集文生視頻、圖生視頻、插幀超分、訓練系統一體化的視頻生成大模型。

- 主頁:https://vchitect.intern-ai.org.cn/

- Github: https://github.com/Vchitect/Vchitect-2.0

本文將詳細介紹筑夢 2.0 背后的核心亮點與技術細節。

核心亮點

1、 支持更長的視頻生成:

目前來看,筑夢 2.0 支持 5s-20s 長視頻生成,超過其他開源模型的生成時長。

同時支持高達 720x480 分辨率的生成。該模型還能夠處理多種視頻格式,包括橫屏、豎屏、4:3、9:16 和 16:9 等比例,極大地擴展了其應用場景。

2. 新一代視頻增強算法 VEnhancer

與其他開源模型不同,筑夢 2.0 同步開源了用于視頻增強的生成式模型 ——VEnhancer,集成了插幀、超分辨率和修復功能。該增強算法可在 2K 分辨率、24fps 的情況下生成更加清晰、流暢的視頻,解決了視頻抖動等常見問題,顯著提升了視頻的穩定性。

此外,該算法還可用于增強其他生成模型的視頻表現,GitHub 中展示了它對快手可靈生成視頻的顯著改進,對于追求高質量內容輸出的創作者來說,VEnhancer 無疑是一個重要的工具。

3. 全球首個支持長視頻生成評測的框架

該在原有的 VBench 評測框架基礎上,優化并升級了對長視頻生成的評測能力,目前已包含 Gen-3、可靈、OpenSora 等主流模型。這使開發者和用戶能夠更系統地評估模型性能,尤其是在長視頻生成方面。書生?筑夢 2.0 在開源 2B 模型中表現卓越,性能甚至可以媲美開源最優的 5B 模型。

筑夢 2.0 技術解析

1、模型架構

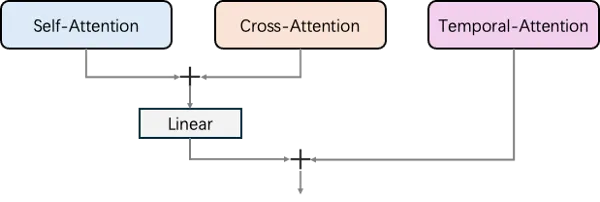

根據開源代碼分析,書生?筑夢 2.0 采用了時下熱門的擴散式 Transformer(Diffusion Transformer)網絡模型。不同于 CogVideoX 的全注意力機制,筑夢 2.0 通過并行結構的 Transformer 模塊處理視頻的空間和時間信息,包括自注意力(self-attention)、交叉注意力(cross-attention)和時間注意力(temporal-attention)。

具體來說,自注意力模塊負責每一幀之間的 token 交互,交叉注意力則使用所有幀的 token 作為查詢,文本 token 作為鍵和值,而時間注意力則在不同幀的相同位置之間執行 token 的注意力操作。最終,模型通過線性層融合自注意力和交叉注意力的輸出,再與時間注意力的結果相加,從而實現高效的視頻生成任務處理。

2、訓練框架

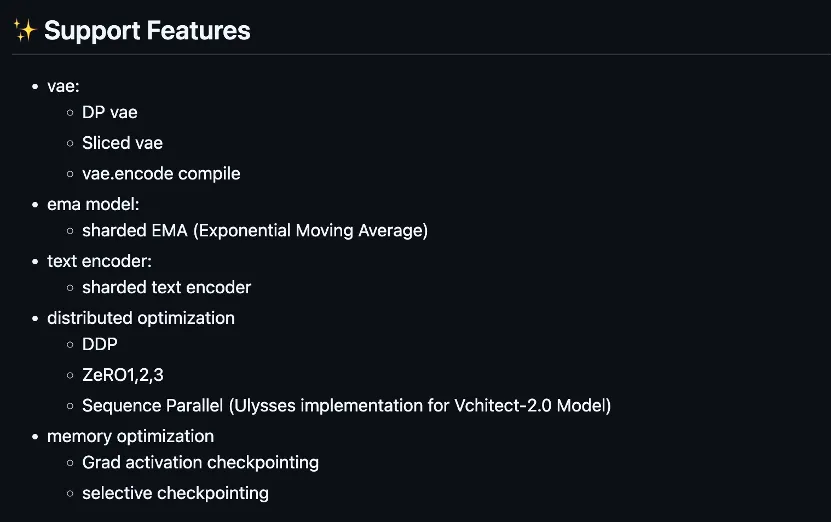

此外,書生?筑夢 2.0 同時開源了他們的訓練和推理框架 LiteGen。從改框架的優化介紹上看,該框架針對性地提供了 diffusion 任務所需的各項優化。

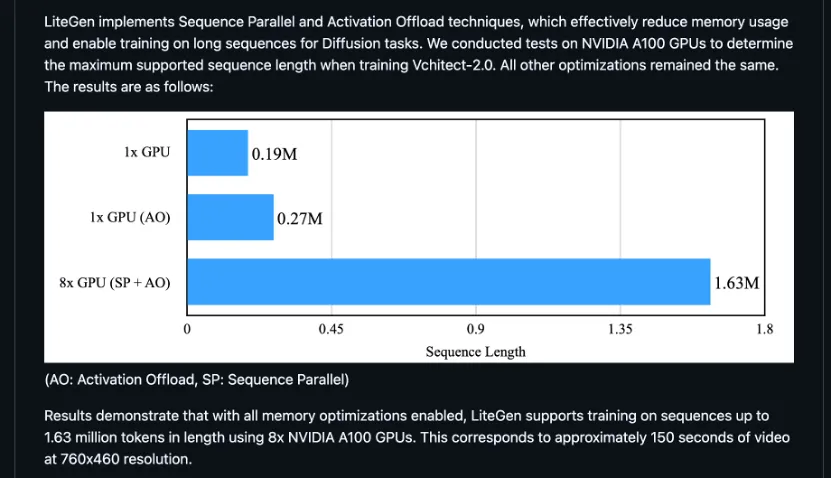

對于如何進一步優化顯存以支持更大序列長度的訓練這一方面,他們的開源代碼采用了 Activation Offload 與 Sequence Parallel 技術進行優化。在實現上,他們的 Activation Offload 在計算時將暫未使用的中間激活 offload 到 CPU 內存上,需要時再拷貝到顯存中,這樣可以讓 GPU 顯存中盡量只留有當前計算所必須的激活,減少了顯存峰值使用量。從開源代碼的分析開看,他們采用了通信計算重疊的方式實現 Activation Offload,這將有助于降低設備間拷貝通信對整體性能的影響。

據其開源代碼的說明描述,在 A100 GPU 上,采用 Activation Offload 讓筑夢 2.0 的 2B 模型單卡序列長度提升了 42%;進一步應用 Sequence Parallel 拓展至 8 卡,最大序列長度提升 8.6 倍,可以滿足分鐘級視頻生成訓練的計算需求。

從其代碼實現上來看,他們的框架設計得較為輕量,使用接口簡潔,可以在改動比較小的情況下集成框架內的各項優化,在易用性上具有不錯的優勢。

團隊介紹

上海人工智能實驗室的書生·筑夢團隊由來自上海人工智能實驗室和新加坡南洋理工大學S-Lab的成員組成,專注于視頻生成技術的前沿研究與應用開發。他們致力于通過創新的算法和架構優化,提升視頻生成模型的質量和效率。近期,他們的工作包括VBench、VideoBooth 、FreeU、FreeInit、Latte 、VEnhancer等,這些項目在視頻生成、插幀、超分辨率處理以及生成質量評估等多個關鍵領域都取得了顯著進展。