開源視頻生成天花板?最強攪局者Mochi 1免費直出電影級特效

AI視頻生成賽道最強攪局者,來了!

何謂攪局?下面這些是模型直出的效果,開源免費送給你!

這也讓一些網友直呼:「賽博菩薩」!

雖然很想把標題寫成「劍指Sora」,但可惜這個標題小編我用過了~

而驀然回首,那驚世駭俗的Sora也已經是很久之前的事情了。

今天,我們已經可以通過親自與開源模型交互,來體驗當初的震撼。

先來個高仿版世界名畫:

是不是直接夢回當年?

這算是小編目前體驗過的最強開源文生視頻模型了。

開放權重:https://huggingface.co/genmo/mochi-1-preview

源代碼:https://github.com/genmoai/models

這個「賽博菩薩」名叫Mochi 1,來自Genmo,模型的研究預覽版已經在hugging face開源(或通過磁力鏈接下載),Apache 2.0許可證,可免費用于個人和商業用途。

作為Genmo家最新的開源視頻生成模型,Mochi 1在運動質量方面表現出色,并且具有極強的提示依從性。

除了開放權重之外,Genmo還在官網提供了免費試用Mochi 1的平臺:https://www.genmo.ai/play,完全免費,只不過限制每6小時生成2個視頻。

開玩!

神奇的魔法世界:

海上戰爭:

星際穿越:

月下美人:

開測

這些都是來自discover頁面的作品,有可能是網友做的,效果包不包真咱不知道,所以小編只好下場一試:

A Chinese female college student with fair skin, slim figure, and wearing a school uniform stood next to the bookshelf in the library, smiling and looking at the camera attentively. High resolution 4k.

直出的效果小編是比較滿意的,這里的動圖質量有限,而且截圖工具過來有點偏色,還是推薦大家親自體驗,會有驚喜。

在上面的基礎上加一點細節:

A Chinese female college student with fair skin, slender figure, and wearing a school uniform is standing next to the bookshelf in the library. She has shoulder-length black short hair, a high nose bridge, and a pointed chin. She is smiling and looking at the camera attentively. High resolution 4k.

雖然但是......還行吧,可能小編的提示詞功力還需修煉。

下面這張的效果最令小編驚喜,盡管有些瑕疵,但基本能上官圖了吧。

A young woman wearing a white shirt and navy blue dress on the beach at sunset. She was holding high heels in her hands and walking barefoot on the beach, her long silver hair fluttering in the sea breeze. The waves gently lap on the shore, creating a fresh and elegant atmosphere. 4K ultra-high definition, delicate and realistic style.

來看一下刻板印象(doge):

In the summer, a cute Japanese high school student is on campus. She was wearing a school uniform, a short skirt, white stockings and black leather shoes. She was carrying a black schoolbag, with her hands behind her back, smiling at the camera, with the University of Tokyo building behind her.

當然肯定也有翻車的時候:

A cute girl walks on campus in summer. She was wearing her school uniform, short skirt, black stockings and boots, and was carrying a black school bag. She walks confidently and casually

翻車了嗎?微翻,翻的不多,也就40%

目前Genmo只發布了生成480p視頻的基礎版本,而更高級的Mochi 1 HD將于今年晚些時候推出。

另外模型的相關API也已經發布,開發者可以將其無縫集成到自己的應用程序中。

本地跑?

hugging face上的模型權重大小為40多G,根據官方的說法,需要4個H100才能運行。

——不過別擔心,既然敢開源,那么總有大神幫你解決問題:

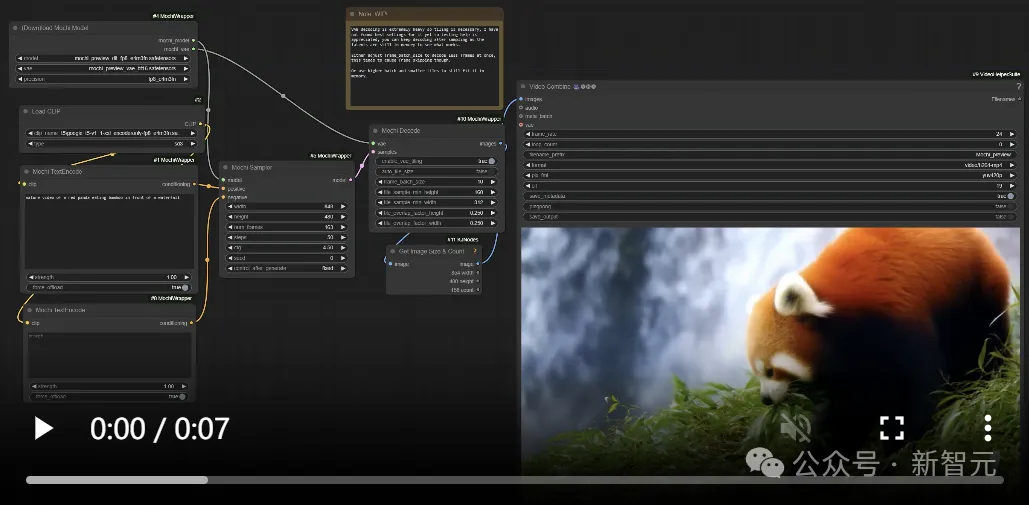

地址:https://github.com/kijai/ComfyUI-MochiWrapper

Mochi 1已經進入ComfyUI了,可以使用flash attention、pytorch attention(sdpa)或sage attention進行加速。

根據設置的幀數,可以把生成過程限制在20GB內存以下,作者還嘗試了CogVideoX -diffusers來挑戰更高的幀數,目前做到了97幀。

Mochi 1模型架構

Genmo表示自己要搞一個「人工智能的右腦」,而Mochi 1就是構建可以想象任何東西的世界模擬器的第一步。

Mochi 1是基于新型的非對稱擴散Transformer(Asymmetric Diffusion Transformer,AsymmDiT) 架構構建的擴散模型。

參數量為100億,是有史以來開源的最大視頻生成模型。

Mochi 1是完全從頭開始訓練的,同時提供了簡單、可以自由修改的架構。

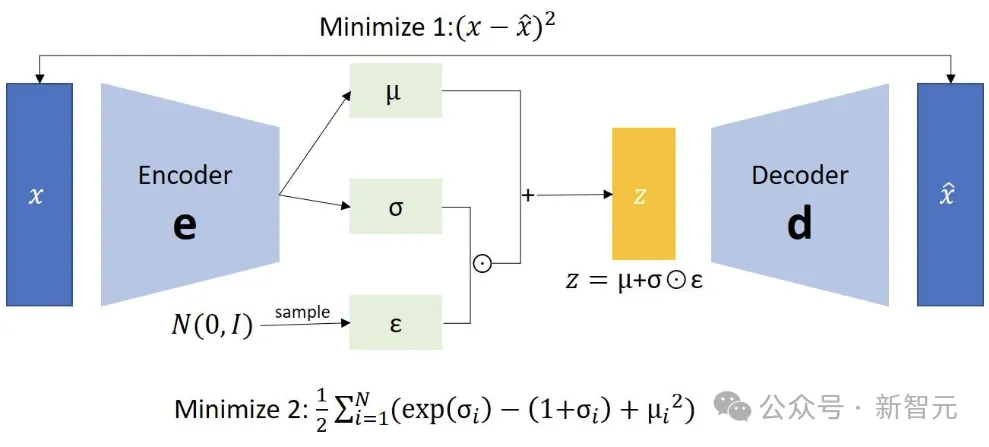

計算效率對于模型的發展至關重要。與Mochi一起開源的還有它的VAE編碼器。

VAE將視頻壓縮了128倍(包括空間壓縮和時間壓縮),轉化到12通道的潛在空間。

AsymmDiT通過簡化文本處理,并將神經網絡能力集中在視覺推理上,有效地處理用戶提示和壓縮的視頻token。

AsymmDiT通過多模態自我注意共同關注文本和視覺token,并為每種模態學習單獨的MLP層,這類似于Stable Diffusion 3,所不同的是,這里的視覺流通過更大的隱藏維度(擁有幾乎是文本流的 4 倍的參數)。

為了統一自我注意的模態,研究人員使用非方形QKV和輸出投影層。這種非對稱設計降低了推理內存要求。

許多現代擴散模型使用多個預訓練語言模型來表示用戶提示。相比之下,Mochi 1只使用單個T5-XXL對提示進行編碼。

Mochi 1的上下文窗口高達44,520個視頻token,并具有完整的3D attention。

為了定位每個token,研究人員將可學習的旋轉位置嵌入(RoPE)擴展到3維,網絡端到端學習空間軸和時間軸的混合頻率。

其他的設計包括SwiGLU前饋層、用于增強穩定性的query-key normalization,以及用于控制內部激活的sandwich normalization。

詳細的技術論文將在不久之后發布。

評估

當前的視頻生成模型與現實之間存在巨大差距。運動質量和提示遵循是視頻生成模型中仍然缺少的兩個最關鍵的功能。

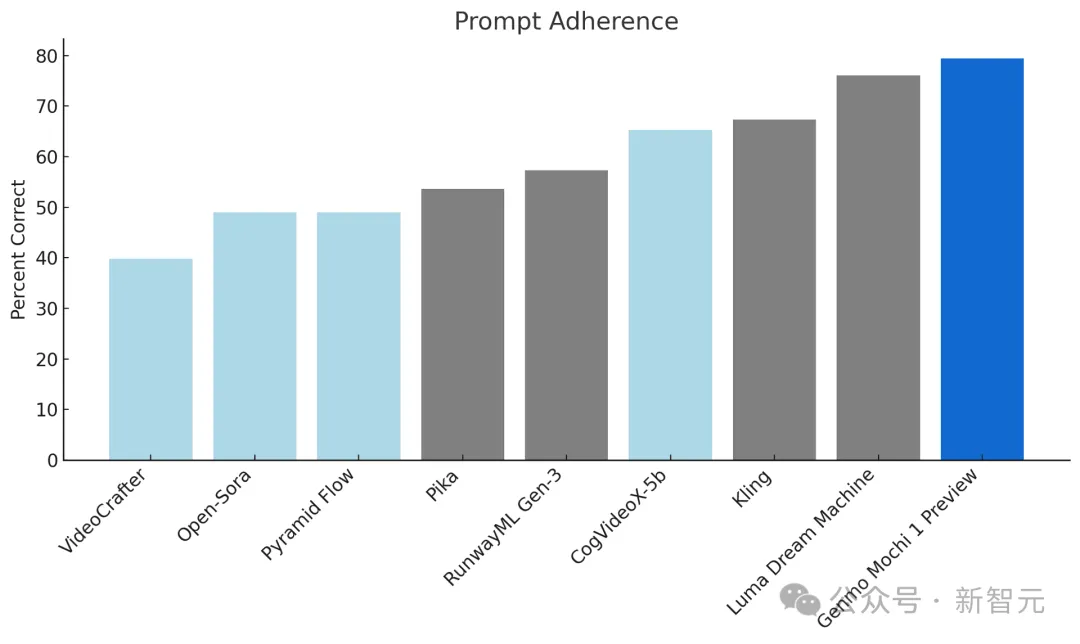

Mochi 1為開源視頻生成設定了新的標準,對比領先的封閉模型也表現出很強的競爭力:

提示依從性

提示依從性衡量生成的視頻遵循提供的文本說明的準確性,從而確保對用戶意圖的高度保真度。模型應該允許用戶對字符、設置和操作進行詳細控制。

研究人員使用視覺語言模型作為裁判,遵循OpenAI DALL-E 3協議,使用自動指標對提示依從性進行基準測試。這里使用 Gemini-1.5-Pro-002評估生成的視頻。

Elo Score

運動質量評估運動平滑度和空間真實感,確保生成的視頻流暢且具有視覺吸引力。

Mochi 1 以每秒30幀的速度生成流暢的視頻,持續時間長達5.4秒,具有高度的時間連貫性和逼真的運動動態。

Mochi模擬流體動力學、毛皮和頭發等物理特性,以及一致、流暢的人類動作,不存在恐怖谷問題。

評分者根據運動而不是幀級美學(標準包括運動的趣味性、物理合理性和流動性)來進行打分。Elo分數是按照LMSYS Chatbot Arena協議計算的。

局限性

Mochi 1目前仍處于不斷發展的狀態,存在一些已知的限制。

比如初始版本只能生成480p的視頻,比如在某些極端運動的邊緣情況下,可能會出現輕微的扭曲。

由于Mochi 1針對照片級真實感樣式進行了優化,因此在動畫內容中表現不佳。

此外,模型實施了強大的安全審核協議,以確保所有視頻都保持安全并符合道德準則。

應用

Mochi 1的開源在各個領域開辟了新的可能性:

研發:推進視頻生成領域并探索新方法。

產品開發:在娛樂、廣告、教育等領域構建創新應用程序。

創意表達:使藝術家和創作者能夠通過AI生成的視頻將他們的愿景變為現實。

機器人:生成合成數據,用于在機器人、自動駕駛汽車和虛擬環境中訓練AI模型。

What's next?

Genmo近日宣布已經成功籌集了2840萬美元的A輪融資,該輪融資由Rick Yang、NEA領投,The House Fund、Gold House Ventures、WndrCo、Eastlink Capital Partners和Essence VC,以及天使投資人Abhay Parasnis(Typespace 首席執行官)、Amjad Masad(Replit 首席執行官)、Sabrina Hahn、Bonita Stewart和Michele Catasta等參投。

Genmo團隊包括DDPM(去噪擴散概率模型)、DreamFusion和Emu Video等項目的核心成員,由領先的技術專家提供咨詢,包括 Ion Stoica(Databricks和Anyscale的執行主席兼聯合創始人)、Pieter Abbeel(Covariant的聯合創始人、OpenAI的早期團隊成員)和 Joey Gonzalez(語言模型系統的先驅、Turi的聯合創始人)。

Genmo表示將在今年年底之前,發布Mochi 1的完整版,其中包括 Mochi 1 HD。

Mochi 1 HD將支持720p視頻生成,具有更高的保真度和更流暢的運動,可解決復雜場景中的翹曲等邊緣情況。

除此之外,團隊還在開發圖像到視頻功能,并專注于提高模型的可控性和可操控性,以便用戶能夠更精確地控制自己的輸出。

展望未來,高分辨率、長視頻生成將觸手可及。