NeurIPS 2024評審結(jié)果公布!AI大佬曬出成績單,又是被吐槽最嚴重的一屆?

NeurIPS 2024評審結(jié)果已經(jīng)公布了!

收到郵件的小伙伴們,就像在開盲盒一樣,紛紛在社交媒體上曬出了自己的成績單。

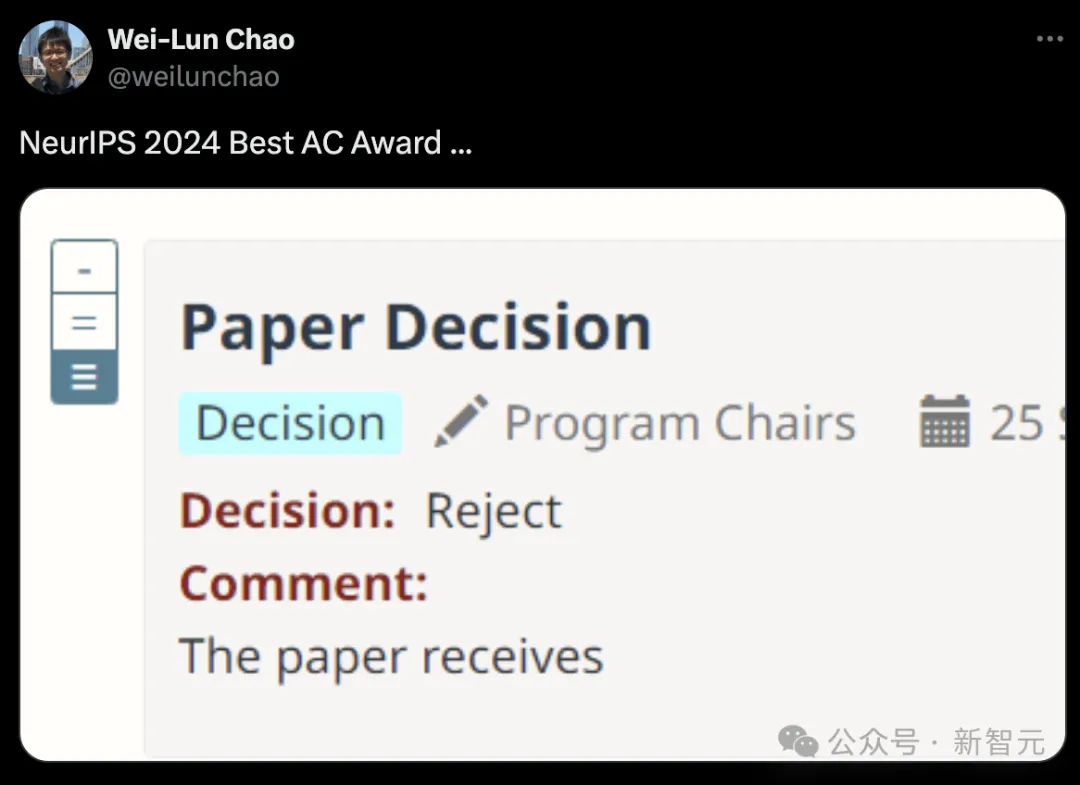

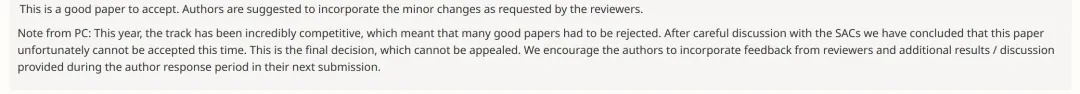

俄亥俄州立大學(xué)助理教授曬圖,明明評審員給的評價是「論文接收」,卻沒想到最終決定是「拒收」。

應(yīng)該給這位審稿人頒發(fā)一個NeurIPS 2024最佳AC獎

順便提一句,今年是NeurIPS第38屆年會,將于12月9日-15日在加拿大溫哥華舉辦。

AI大佬曬出成績單

一些網(wǎng)友們早已曬出了自己的錄用結(jié)果,好像一件大事。

來自洛桑聯(lián)邦理工學(xué)院(EPFL)的博士Maksym Andriushchenko稱,自己有3篇論文被NeurIPS 2024接收。

它們分別是:

論文一:Why Do We Need Weight Decay in Modern Deep Learning?

論文地址:https://arxiv.org/pdf/2310.04415

權(quán)重衰減(weight decay),比如在AdamW中傳統(tǒng)上被視為一種正則化的方法,但效果非常微妙,即使在過度參數(shù)化的情況下也是如此。

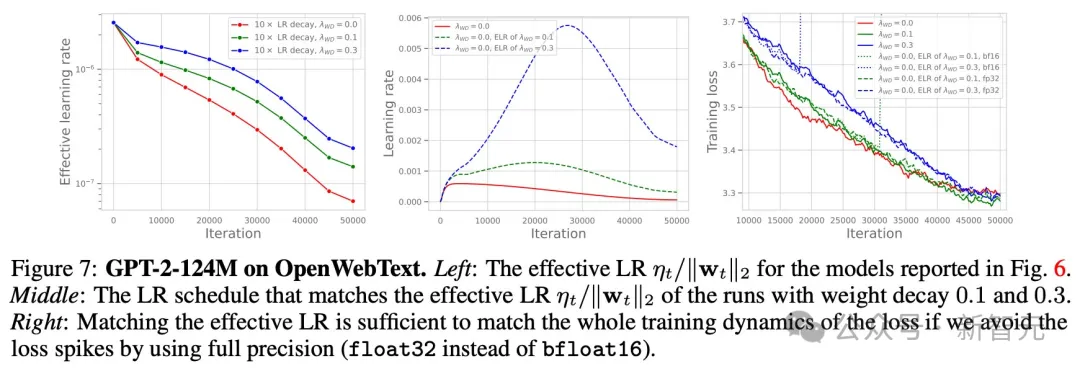

而對大模型而言,權(quán)重衰減則扮演者完全不同的角色。與最初一版arXiv論文相比,研究人員對其進行了很多更新。

Andriushchenko表示,自己非常喜歡這項新實驗,并且匹配了AdamW有效學(xué)習(xí)率,得到了完全相同的損失曲線,而沒有使用權(quán)重衰減。

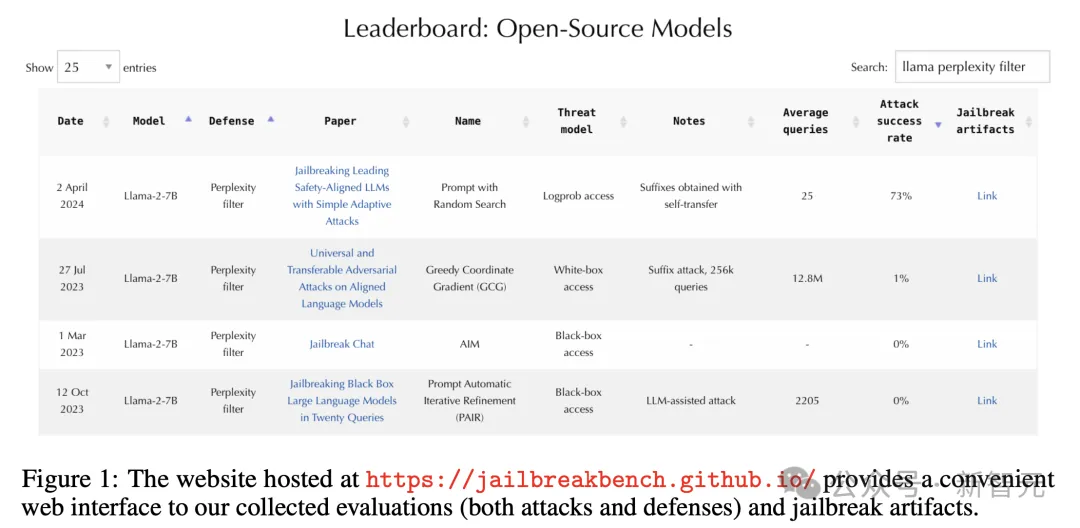

論文二:JailbreakBench(Datasets and Benchmarks Track)

論文地址:https://arxiv.org/pdf/2404.01318

JailbreakBench是全新評估大模型越獄能力的基準(zhǔn)。上個月,該數(shù)據(jù)集在HuggingFace上,被下載了2500次。

而且,多家媒體還使用了這個越獄神器,Gemini 1.5技術(shù)報告中也將其用于模型穩(wěn)健性的評估。

論文三:Improving Alignment and Robustness with Circuit Breakers

論文地址:https://arxiv.org/pdf/2406.04313

這篇論文發(fā)布之初,已經(jīng)掀起了不少的討論。

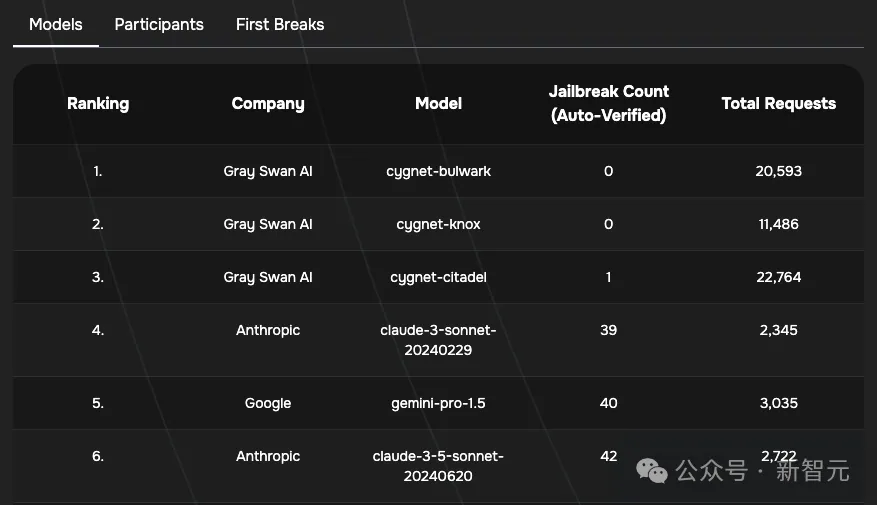

其中最重要的一點是,它有助于訓(xùn)練Cygnet模型,其在越獄競技場上表現(xiàn)出驚人的性能,而這正是對防御是否有用的測試。

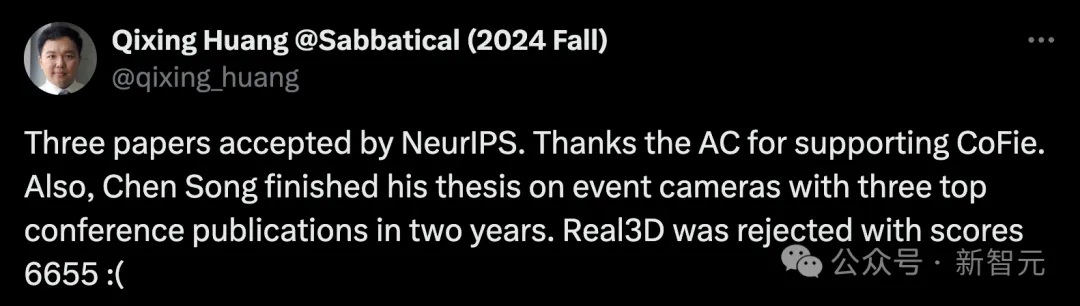

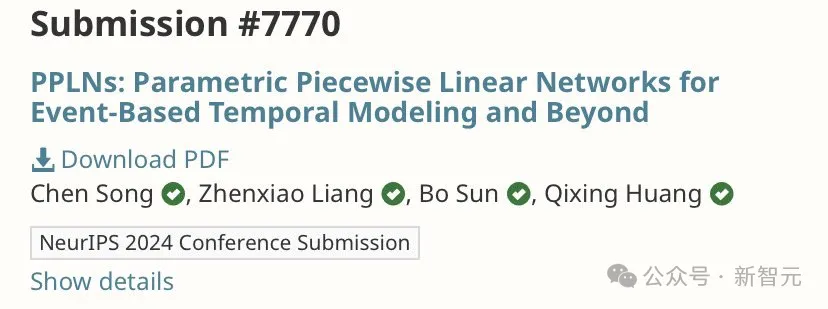

來自UT Austin的副教授Qixing Huang也有三篇論文被NeurIPS錄用。

它們分別是:

局部幾何感知神經(jīng)曲面表示法CoFie。

以及另外兩篇,一個是參數(shù)化分段線性網(wǎng)絡(luò)PPLN,另一個是關(guān)于時空聯(lián)合建模的運動生成。

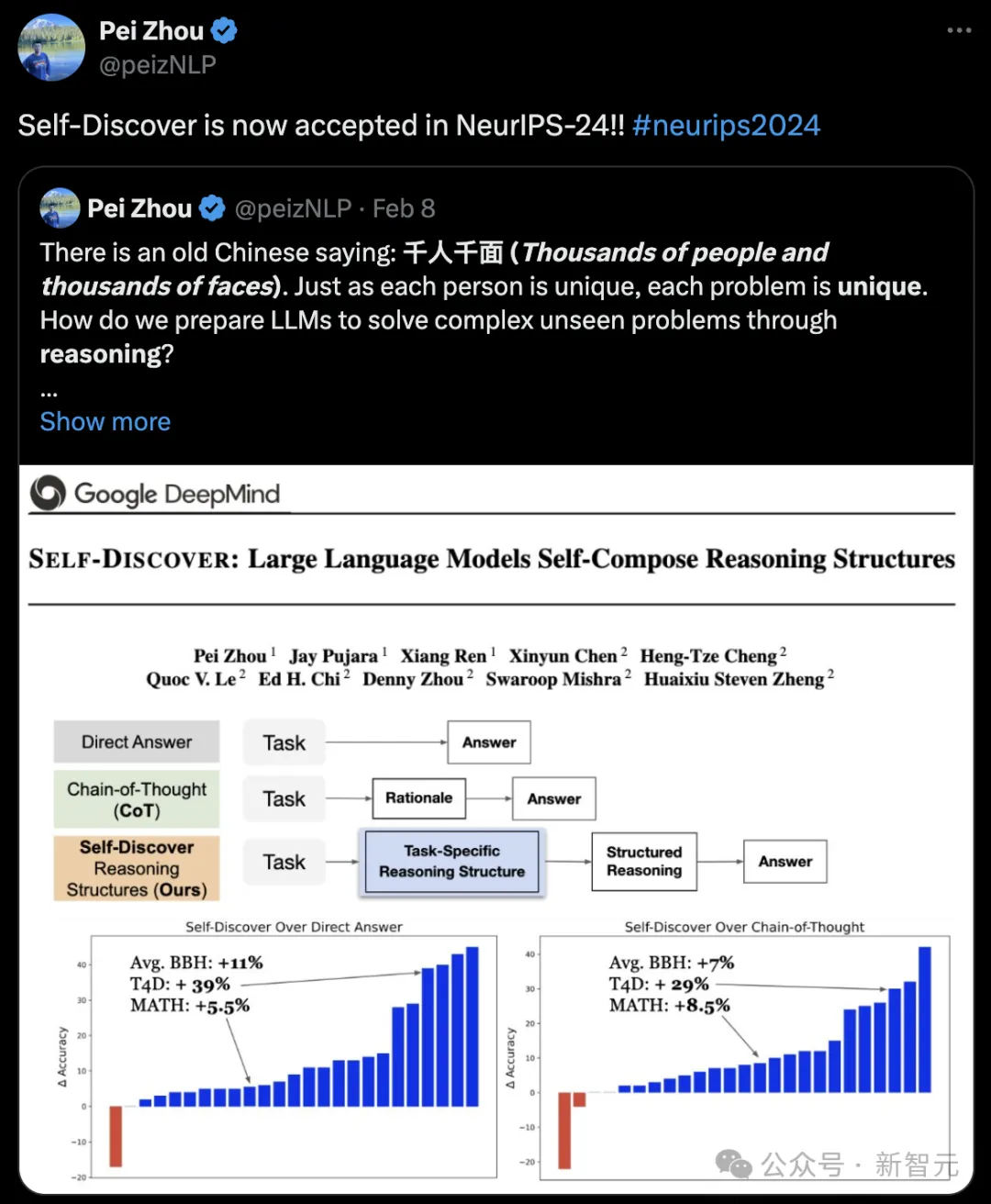

谷歌DeepMind團隊Self-Discover算法被NeurIPS 2024錄用。

中國有句古話:千人千面。正如每個人都是獨一無二的,每個問題也是獨一無二的。如何讓LLM通過推理解決復(fù)雜的看不見的問題?

Self-Discover最新論文證明了,模型可以從一般問題解決技術(shù)的集合中,組成特定用于任務(wù)的推理策略。

最新算法在GPT-4和PaLm 2-L上的性能比CoT高32%,而推理計算量比Self-Consistency少10-40倍。

論文地址:https://arxiv.org/pdf/2402.03620

又是被吐槽的一屆

不論是哪個頂會,吐槽是必不可少的。

這不,網(wǎng)友們對NeurIPS 2024審稿結(jié)果,吵成一鍋了。

紐約大學(xué)工學(xué)院的助理教授稱,一篇在NeurIPS提交中得分相當(dāng)高的論文被拒絕。原因竟是:「模擬器是用C++編寫的,而人們不懂C++」。

他表示,論文被拒的現(xiàn)象太正常了,但是對這個被拒理由,實在是令人震驚。

還有一位大佬表示,團隊的兩篇關(guān)于數(shù)據(jù)集追蹤的NeurIPS論文被拒了,盡管評審結(jié)果有積極的反饋。

這顯然是,組委會試圖人為地標(biāo)尺較低的錄取率。

「根據(jù)錄取率而不是成績來排擠研究,這一點其實我不太確定」。

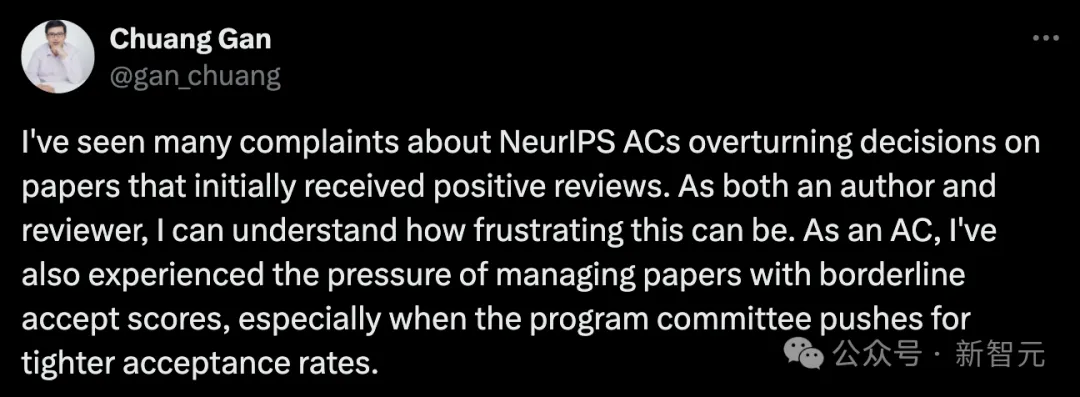

無獨有偶,UMass Amherst的教員也表達出了這種擔(dān)憂:

我看到很多人抱怨 NeurIPS的AC,推翻了最初收到積極評審論文的決定。

作為一名作者和評審員,我能理解這種做法有多令人沮喪。作為一名區(qū)域主席,我也經(jīng)歷過管理那些勉強達到錄用分數(shù)的論文的壓力,特別是當(dāng)項目委員會要求更嚴格的錄用率時。

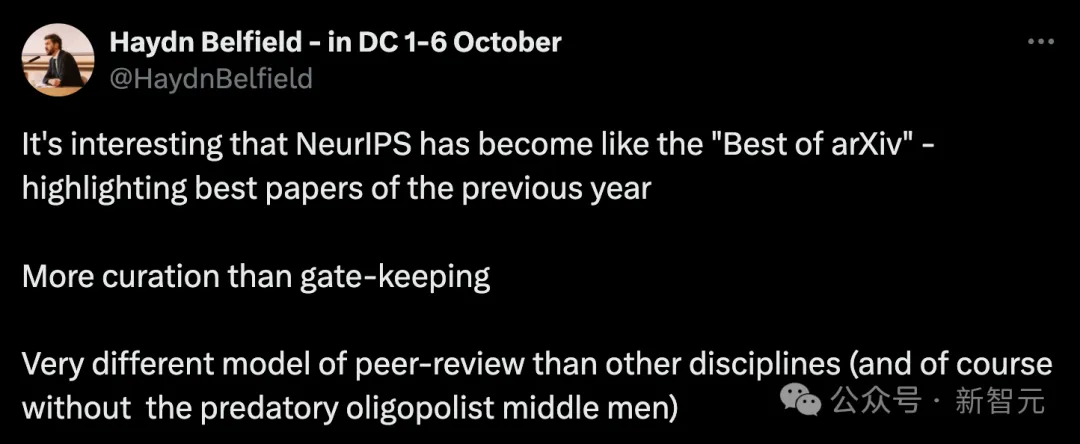

有趣的是,NeurIPS已經(jīng)變得像「arXiv精選」——突出展示前一年的最佳論文。

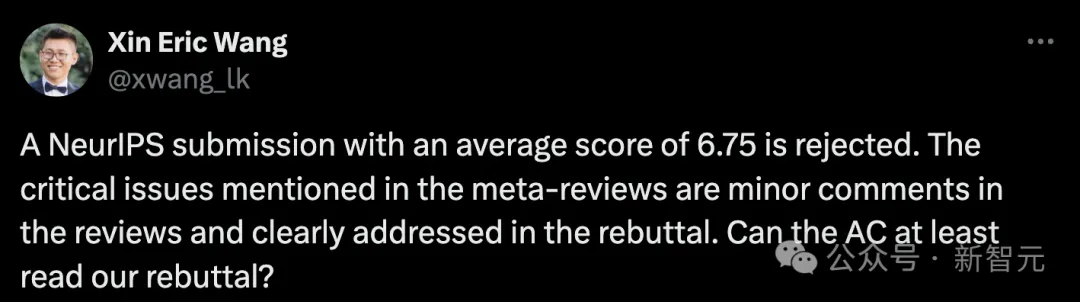

一位UCSC教授Xin Eric Wang表示,一篇平均得分為6.75的NeurIPS投稿被拒絕了。

他表示,這是自己收到第二荒謬的元評審,最荒謬的那次,是因為結(jié)果中沒有加「%」就否決了論文。

無論論文質(zhì)量如何,似乎總會有無數(shù)理由可以否決一篇論文。

元評審中提到的關(guān)鍵問題,在原始評審中只是小問題,而且他們團隊已經(jīng)在回復(fù)中明確解決。Xin Eric Wang懷疑AC是否真正閱讀了他們的回復(fù):

(1) AC提出了一個重大問題,這是基于一個得分為8分的評審者的小建議,引用了「大部分數(shù)據(jù)」,但實際數(shù)字小于10%(如回復(fù)中所述)。

(2) AC指出缺少統(tǒng)計數(shù)據(jù),這些數(shù)據(jù)評審者從未提及,而且在論文正文中已經(jīng)清楚地呈現(xiàn)。

LLM參與評審

而且AI火了之后,大模型也被用來論文評審。

這次,NeurIPS 2024也不例外。

Reddit網(wǎng)友評論道,自己用一個月的時間審核6篇論文,當(dāng)看到自己得到的是LLM的評價,真的很受傷。

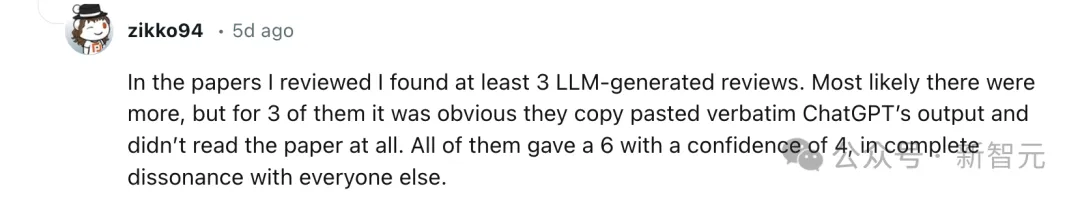

還有人指出,在自己審閱的論文中,至少發(fā)現(xiàn)了3篇由大模型生成的評審意見,很可能還有更多,其中3篇明顯是直接復(fù)制粘貼了ChatGPT輸出,完全沒有閱讀論文。

這些評審都給了6分,Confidence為4,與其他所有人的評價完全不一致。

更有網(wǎng)友評價道,「論文評論的質(zhì)量很低」。

一個評審者混淆了我們方法的基線,另一個評審者混淆了基線的派生(正如我們的工作所批評的那樣)和我們方法的派生。我懷疑一些評論是由LLM產(chǎn)生的。