利用公開知識定向提升大模型,騰訊優圖&上交大提出新方法,性能達SOTA

告別傳統指令微調,大模型特定任務性能提升有新方法了。

一種新型開源增強知識框架,可以從公開數據中自動提取相關知識,針對性提升任務性能。

與基線和SOTA方法對比,本文方法在各項任務上均取得了更好的性能。

該方法由上海交通大學和騰訊優圖實驗室共同提出。

研究背景

近年來,LLMs 在眾多任務和領域取得了顯著發展,但為了在實際業務場景發揮模型的專業能力,通常需要在領域特定或任務特定的數據上進行指令微調。傳統的指令微調往往需要大量的有標注數據和計算資源,對于實際業務場景這是很難獲得的。

另一方面,開源社區提供了大量的微調模型和指令數據集。這些開源知識的存在使得在特定任務上LLM在特定領域上的適配和應用成為了可能。但是,使用開源的各類SFT模型以及任務相關的數據集時,仍有以下關鍵問題需要解決:

- 少量有標注樣本場景下,直接對模型微調或進行in-context-learning的效果往往不能滿足需求,如何利用這些少量的樣本和海量的外部知識(開源世界的模型,數據)對目前已有的知識進行補充,提升模型的任務能力和泛化性能?

- 開源社區中有大量微調且對齊的模型和指令數據集,可作為提升 LLMs 特定任務專業能力的良好起點,如何在可能存在知識沖突的情況下,合理融合這些外部知識?現有工作往往聚焦于對已有模型組合方法的設計,無法最大化利用多個模型的知識儲備。

- 在開源模型的評價上,現有工作僅僅從單一角度(如測試集上嚴格答案匹配的準確率)進行性能評估,而忽視了這可能帶來的偏差。同時在開源數據的評價上,現有方案通常從通用數據的質量、復雜度等評估角度出發,沒有結合任務導向性來實現數據精選。

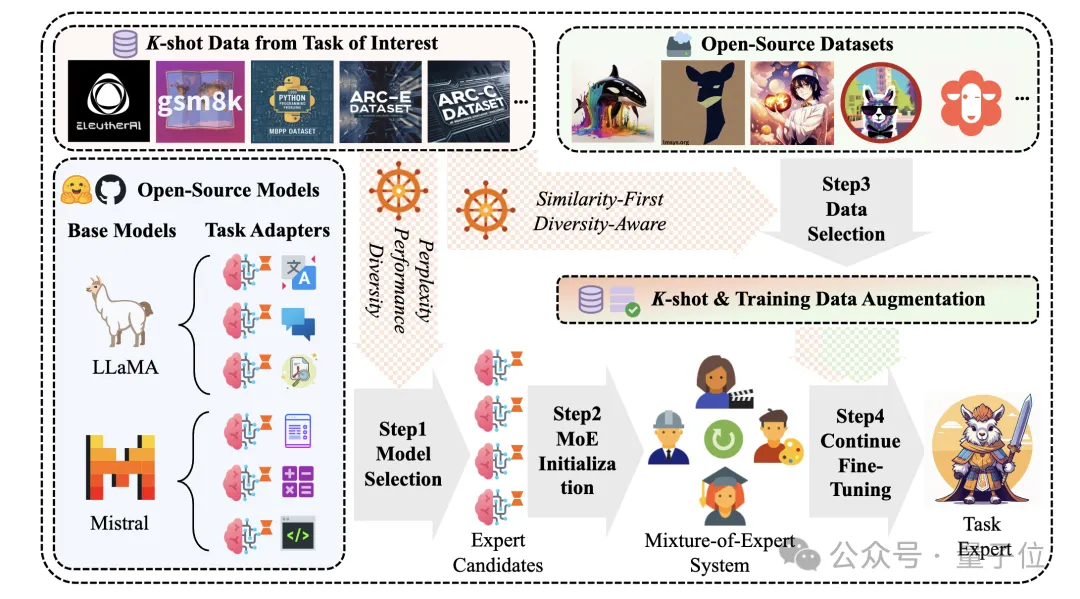

針對以上關鍵問題,研究團隊提出了一種切合業務實際的全新實驗設置:K-shot有標簽真實業務數據下的開源知識增強框架。在這樣的框架下,充分利用K-shot樣本來實現LLM的定向任務增強。

具體地,團隊設計了一套可輕松尺度拓展的LLM知識增強管線,并且充分發揮少量的K-shot樣本在開源模型、開源數據篩選上的指導作用。在方案設計上,主要面臨了以下挑戰:

挑戰1: 對于給定的感興趣任務,如何充分利用有限的 K-shot 數據,以高效地確定具有最大潛力的模型。

挑戰2: 如何從開源數據集中識別與 K-shot 任務相關性最強的一批指令數據,以便為 LLMs 注入、補充缺失的領域知識,同時避免過擬合現象。

挑戰3: 當多個 LLMs 均在任務上表現出有效性時,如何構建一個自適應的模型融合系統,以更好地利用這些模型之間互補的知識,從而提高它們在 K-shot 任務中的協同性能并展現出比單模型更優的效果。

本文貢獻

本研究提出了一種結合公開可用模型和數據集,針對特定任務提升大型語言模型性能的方法全流程。主要貢獻包括:

- 提出了一種高效篩選具有最大潛力的模型的方法,綜合推理困惑度,模型表現和模型間知識豐富度進行模型篩選,在有限的 K-shot 數據條件下,能夠充分發揮已有模型的性能。

- 設計了一種從開源數據集中提取與感興趣任務或領域相關知識的方法,通過相似性-多樣性的數據篩選策略,為 LLMs 提供補充信息,降低過擬合的風險。

- 通過混合專家模型結構構建了一種自適應的模型融合系統,能夠在多個潛在有效的 LLMs 之間實現知識互補和協同優化,從而在感興趣任務上取得更好的性能。

前提儲備:

LoRA Bank Construction:從 Huggingface 選擇 38 個具有代表性且廣泛使用的指令數據集,對每個數據集進行預處理和 LoRA 微調來構建 LoRA Bank。LoRA Bank的引入為特定任務提供了可選擇的預訓練模型集合,并保證了實驗的可重復性以及對比的公平性。

核心方法:

1、K-shot Guided Expert Model Selection:提出一種專家模型選擇方法,綜合考慮模型的推理困惑度、在K-shot數據上的性能表現以及模型多樣性來篩選最有潛力的模型組。

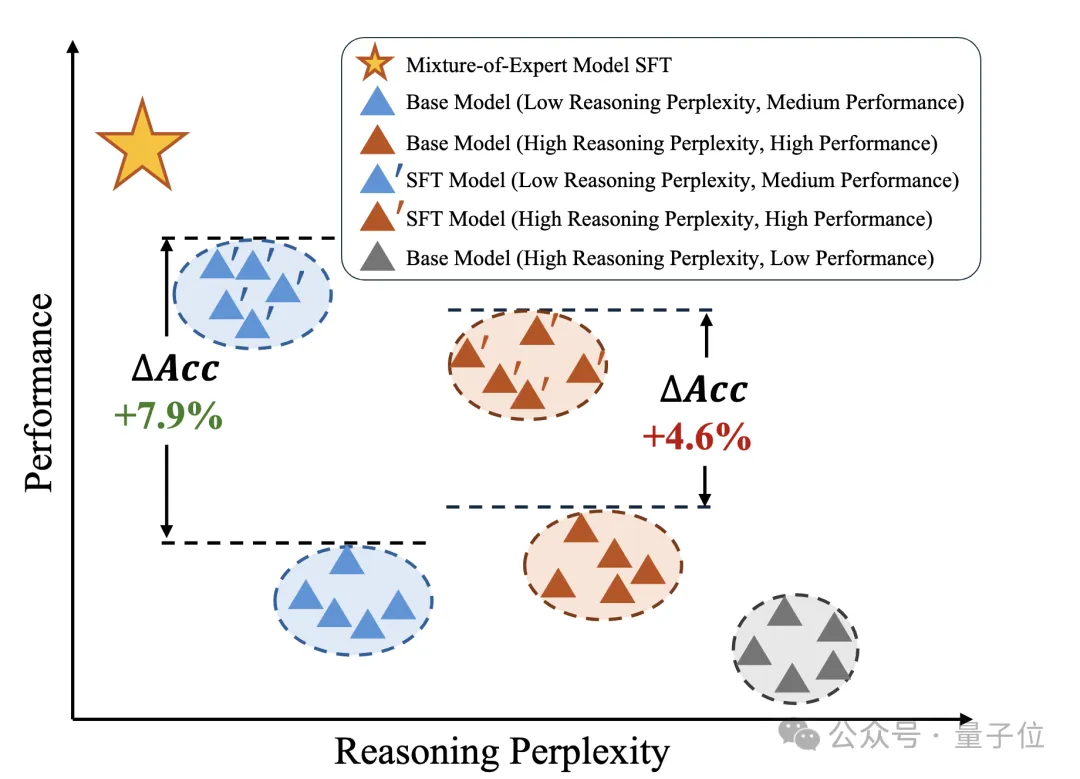

團隊發現,僅僅從推理結果的性能評估(通常用后處理+Exact Match等手段來計算)不能很好地預測得到模型在特定任務上的表現。這是因為模型輸出的答案可能無法被完全后處理解析,導致模型被低估。

團隊發現通過答案的推理困惑度可以判斷模型對某一個領域的理解能力,因此綜合考慮了這兩種手段。

如下圖,部分直接推理指標高的模型在微調后表現可能低于原先推理指標低的模型,但推理困惑度低的模型的微調后的性能會比原先困惑度高的模型更強。

此外,還對模型組的組多樣性進行了評估,即不同模型的知識的差異性要盡量大,這對于混合專家系統的訓練效果有較大提升。

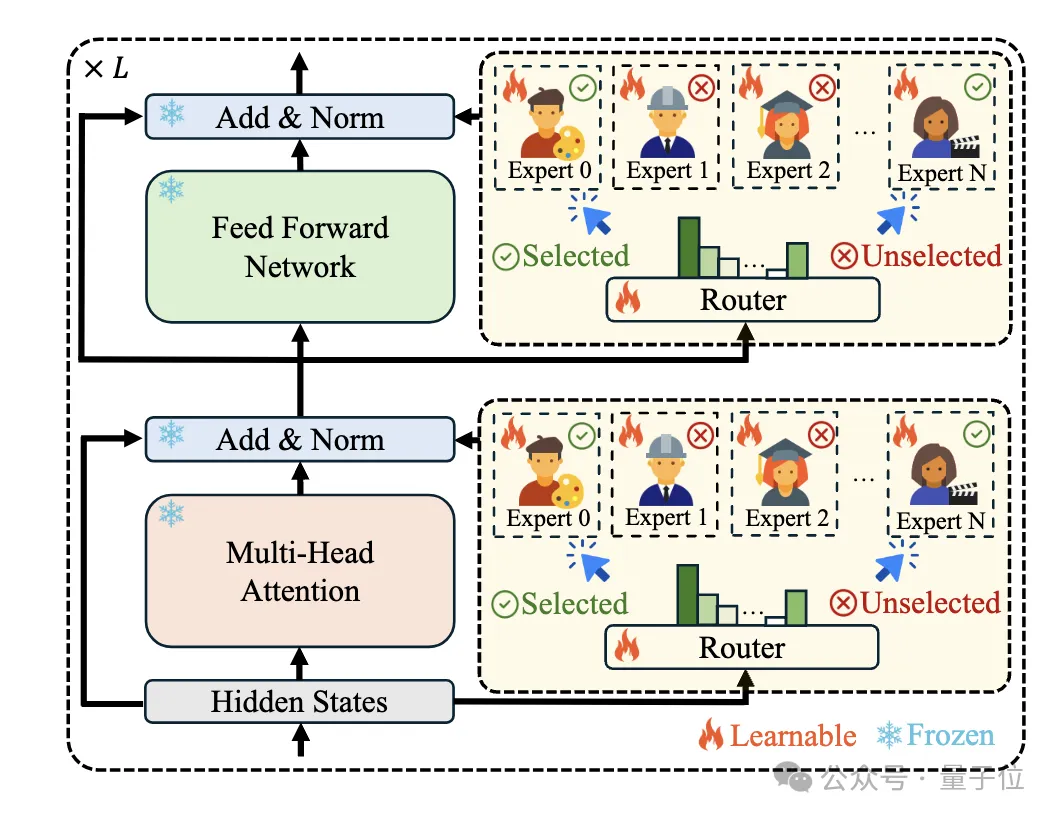

2、Mixture-of-Experts Initialization:使用混合專家模型結構來利用合理利用 LoRA Bank,用模型篩選步驟中得到的模型做MoE模型的初始化,并訓練Router使模型能夠自動將不同的 token 分配給合適的專家,從而促進不同專家之間的協同合作。

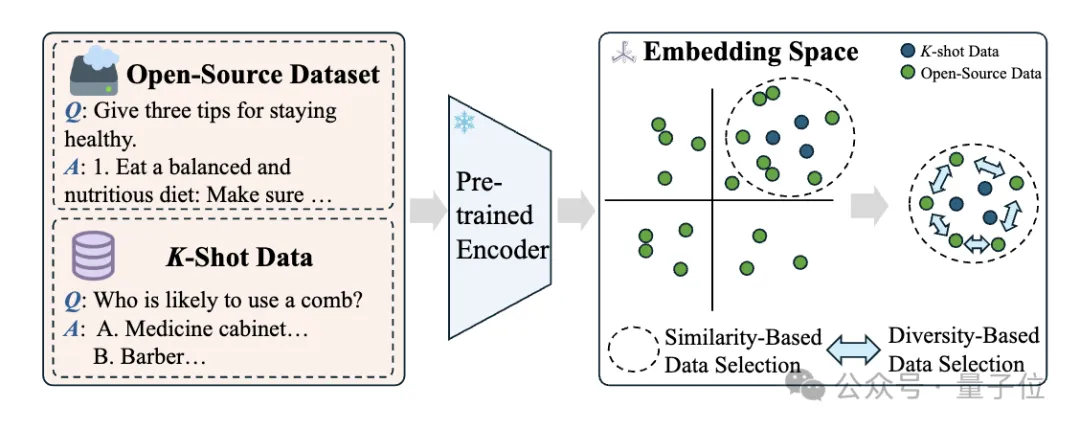

3、K-shot Guided Sim-Div Data Selection:提出一種相似性優先和多樣性感知的數據選擇策略,通過對原始指令文本進行embedding計算,計算開源數據和K-shot數據相似度,選擇與K-shot數據最相似的數據子集,并通過語義層面上的相似度去重來去除重復度過高的數據,保證數據的多樣性。

數據相似度-多樣性的平衡是篩選過程中著重考慮的點,相似的數據能保證和當前任務的強相關性,多樣性的引入能保持數據整體的豐富度和信息充分性,防止模型過擬合的情況的出現。

4、Mixture-of-Experts Fine-Tuning:結合增強數據集和K-shot數據集來優化 MoE 系統的Router權重和專家權重,使用交叉熵損失來監督語言建模的輸出。

實驗設置

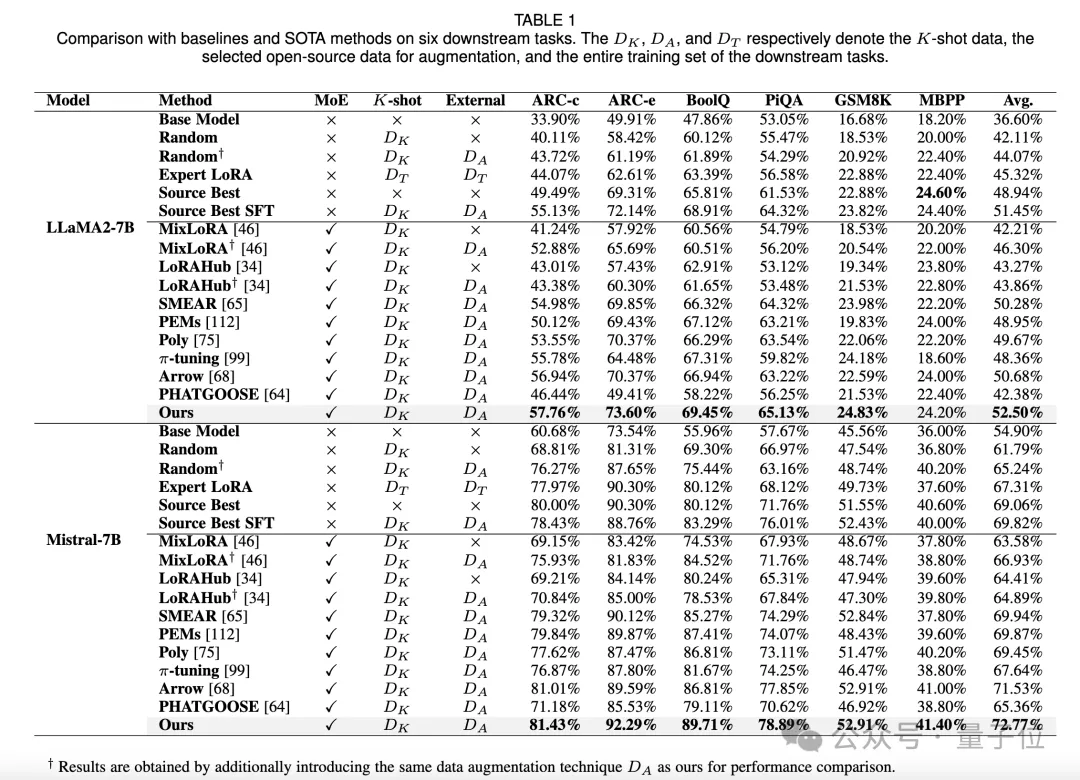

數據集:使用六個開源數據集(ARC-Challenge、ARC-Easy、PiQA、BoolQ、MBPP 和 GSM8K)作為評估集,從每個數據集的官方訓練集中隨機采樣K條有標注的指令-響應對作為 K–shot數據。

基線:與五種基線方法(基礎模型、隨機選擇模型、基于整個訓練集微調的模型、在測試集上表現最佳的專家模型、對最佳專家進行微調的模型)以及其他 SOTA 方法進行比較。

實驗結果與分析

1、與基線和 SOTA 方法對比,本文方法在各項任務上均取得了更好的性能。

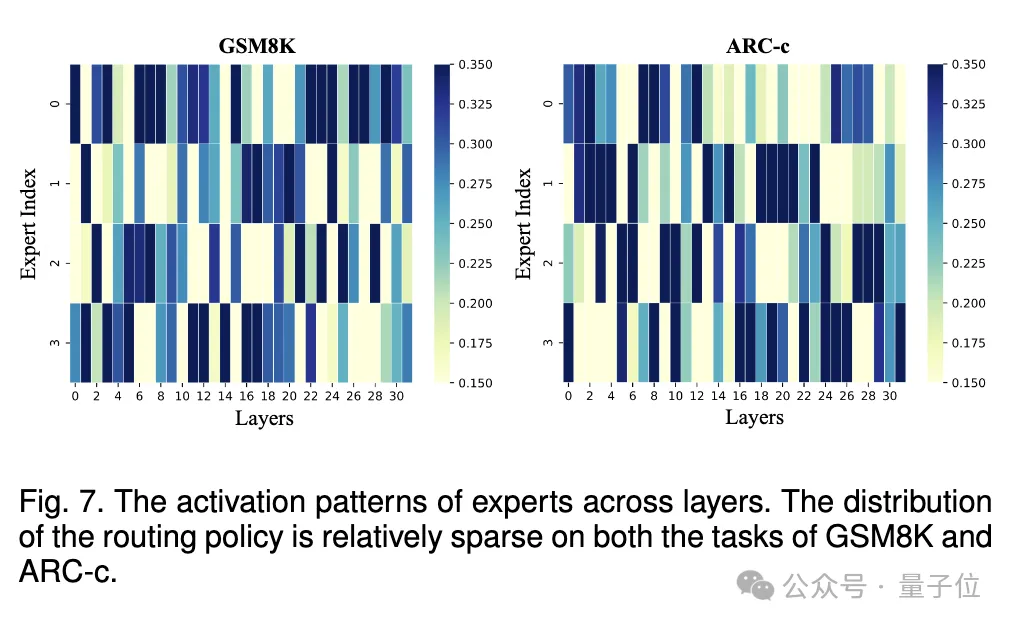

2、通過可視化專家的激活模式,發現 MoE 系統沒有等效地坍縮為單個模型,每個專家都對整體有貢獻。

3、在模型選擇的消融研究中,綜合考慮評測性能、推理困惑度和模型多樣性來選擇有潛力的模型優于單一依賴 K - shot 性能或推理困惑度的方法,且推理困惑度比普通困惑度在模型選擇中更有效。

4、在數據選擇的消融研究中,基于相似性優先和多樣性感知的數據選擇策略進一步提高了 MoE 系統的性能,同時發現增加數據量時性能先上升后下降,多樣性在平衡分布和緩解過擬合方面起著重要作用,不同的相似性采樣技術對性能也有影響。

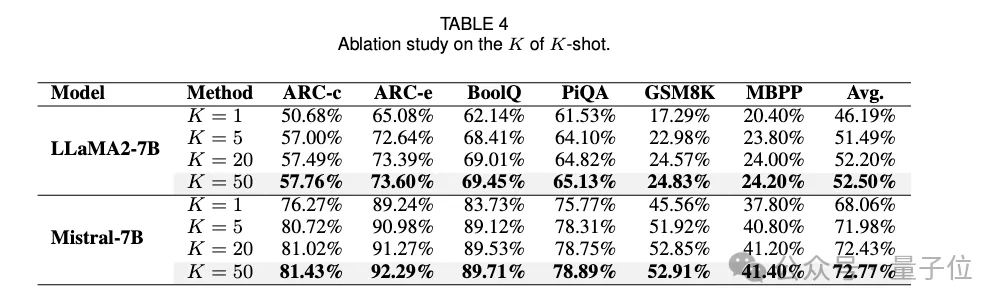

5、在對 K、N 和 k 的消融研究中,發現增加僅僅需要K=5,即5條有標注樣本在感興趣任務上的就可以取得不錯的效果。

專家候選者之間的差異對于維持任務導向的 MoE 系統至關重要。此外MoE 系統訓練所需的數據量應根據任務進行優化,更困難的任務需要更多高質量訓練數據。總的訓練數據的數量不能太多,隨著k的增加,模型性能會出現先上升后下降的趨勢,證明和任務數據相似度較高的外部數據的引入才能對模型性能有所提升。

從LoRA Bank中選出的專家數量N不需要很多,證明和模型高相關性的適配器的引入才能增強模型的任務能力。

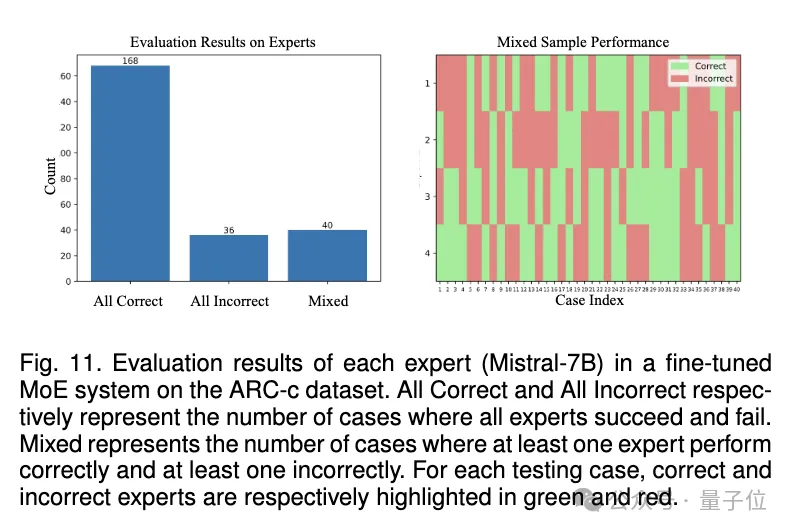

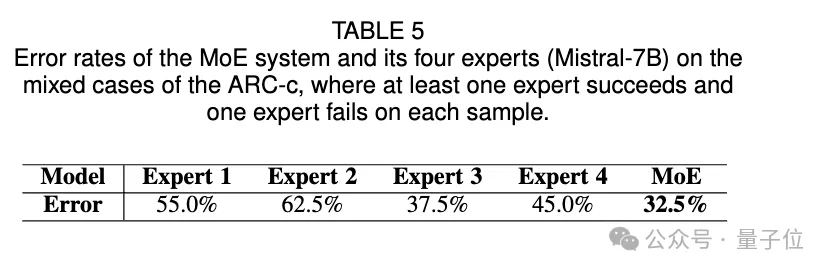

6、對MoE組合的有效性分析:將數據劃分為All-correct,All-incorrect,Mixed三類數據,其中Mixed代表至少有一個專家做對且至少有一個專家做錯(不同專家出現分歧)的樣本,通過MoE的方式,不同專家的融合能超過最優的專家的效果,證明MoE組合方案的有效性。

討論

本方法不依賴數據集和模型的元信息,這是本方法的一大優勢。實際場景下,數據和模型的源信息可能會存在描述不詳細、難以確定相關數據點等問題。開源模型的訓練數據/訓練細節很難具體獲得。

該方法具有多任務適用性和易用性,大多數開源 LLMs 是 LLaMA 和 Mistral 家族的變體,可通過 Huggingface 獲取大量模型,但不同 PEFT 方法之間計算模型間相似性可能不兼容。

結論

本文提出的方法通過 K - shot 數據在模型選擇和數據擴增中發揮重要作用,優于現有方法,并通過消融研究驗證了選擇方法的有效性,展示了一種挖掘開放知識進行定制技能整合的高效流程。