Bengio精簡了傳統RNN,性能可與Transformer媲美

深度學習三巨頭之一的Yoshua Bengio,剛剛發布了一篇有趣的新論文——

RNN就是所需的全部嗎?

Were RNNs All We Needed?

不僅論文的名字有意思,其結論更是精彩。

研究表明,精簡十幾年前的RNN們,性能上可以與最近序列模型(如Transformer等)相媲美!

具體而言,Bengio等人重新審視了諸如LSTM(1997)和GRU(2014)這些傳統的RNN,認為這些模型的缺點是由于需要時間反向傳播 (BPTT) 而導致速度較慢。

所以他們直接大刀闊斧地移除了LSTM和GRU中的隱藏狀態依賴,讓它們不再需要BPTT,從而可以高效地并行訓練。

而精簡改良版的RNN們,名字分別叫做minLSTM和minGRU。

它們和傳統RNN相比,不僅訓練時所需的參數量大幅減少,并且完全可并行化。

嗯,是頗有一種大道至簡的感覺了。

那么Bengio等人具體又是如何實現的?我們繼續往下看。

精簡版RNN

Transformer和它的變體們可以說是近幾年大熱的架構,但與此同時缺點也是較為明顯,那便是在處理長序列時的計算復雜度問題。

具體來說,Transformer模型在序列長度上的計算復雜度是二次方的,這使得它在處理長序列時資源的消耗就比較高。

因此就需要能夠在訓練時有效地處理長序列,同時在推理時保持高效性能的替代方案——簡化版的RNN。

這個過程的關鍵便是隱藏狀態依賴,讓它們不再需要BPTT,讓效率直接飆升。

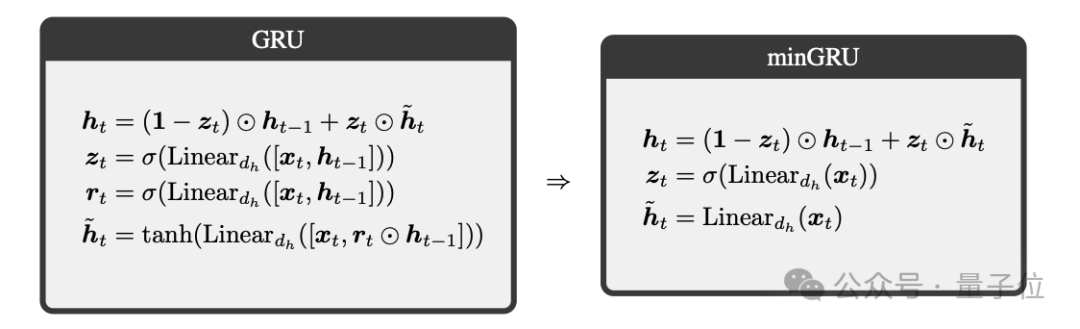

minGRU

首先我們來看下Bengio團隊對GRU的處理,即minGRU,總共分為2步。

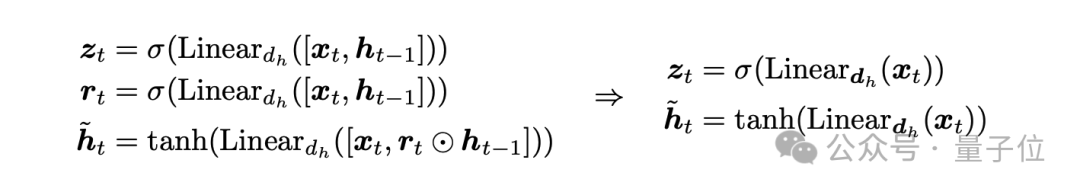

第一步,去除之前隱藏狀態的依賴。

在傳統的GRU模型中,更新門zt和候選隱藏狀態h~t的計算依賴于前一時刻的隱藏狀態 ht-1。這導致模型在訓練時無法實現并行處理,因為每個時間步的計算都依賴于前一個時間步的結果。

為了解決這個問題,minGRU對GRU進行了修改,使更新門和候選隱藏狀態的計算僅依賴于當前時刻的輸入xt,而不依賴于ht-1:

通過這種方式,minGRU的每一時刻的計算可以獨立于其他時刻并行執行。

第二步,去除候選狀態的范圍限制。

在第一步中,候選隱藏狀態h~t仍然使用雙曲正切函數(tanh)來限制其值的范圍在 [?1,1][?1,1] 之間。雖然這有助于模型的穩定性,但它并不是并行化所必需的。

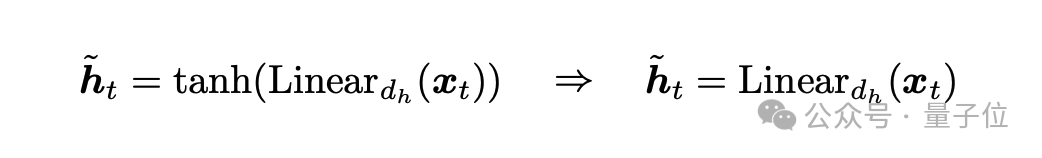

minGRU進一步簡化模型,去除了對h~t的范圍限制,將其替換為一個無需激活函數的線性變換:

這樣,候選隱藏狀態的計算變得更加簡單,并且沒有任何范圍限制。

在這種結構下,minGRU不僅減少了模型參數,而且可以利用并行掃描算法在訓練時實現并行化,從而顯著提高了處理長序列的速度。

此外,minGRU的輸出尺度在時間上是獨立的,這有助于優化過程中的數值穩定性。整體變化如下:

minLSTM

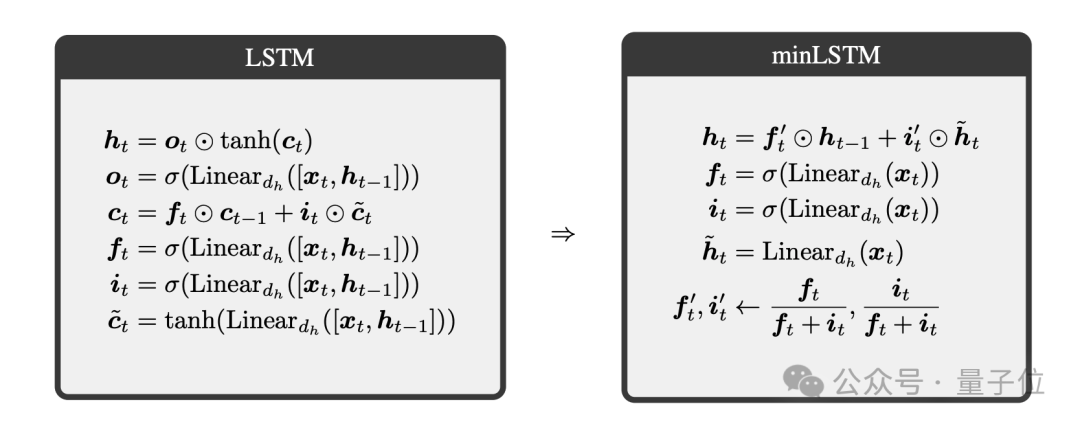

接下來,我們再來看下Bengio團隊對LSTM的處理,即minLSTM,共分為三步。

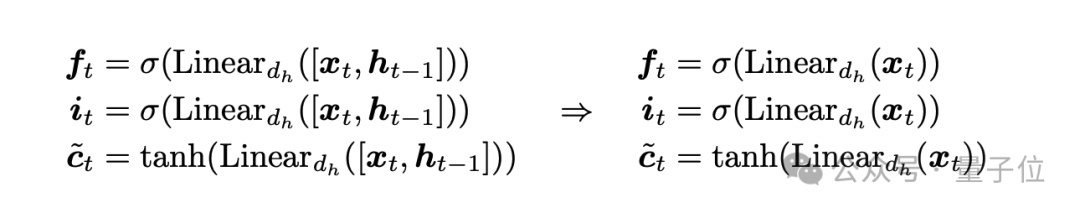

第一步,去除之前隱藏狀態的依賴。

在傳統的LSTM模型中,遺忘門ft、輸入門it和候選細胞狀態c~t的計算依賴于前一時刻的隱藏狀態ht-1。

這導致模型在訓練時無法實現并行處理,因為每個時間步的計算都依賴于前一個時間步的結果。

為了解決這個問題,minLSTM對LSTM進行了修改,使遺忘門、輸入門和候選細胞狀態的計算僅依賴于當前時刻的輸入xt,而不依賴于ht-1:

通過這種方式,minLSTM的每一時刻的計算可以獨立于其他時刻并行執行。

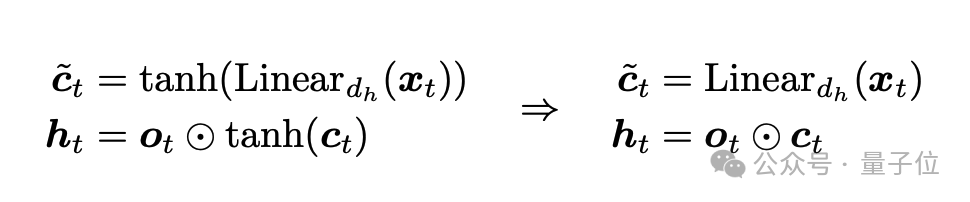

第二步,去除候選狀態的范圍限制。

在第一步中,候選細胞狀態c~t仍然使用雙曲正切函數(tanh)來限制其值的范圍在 [?1,1][?1,1] 之間。雖然這有助于模型的穩定性,但它并不是并行化所必需的。

minLSTM進一步簡化模型,去除了對c~t的范圍限制,將其替換為一個無需激活函數的線性變換:

這樣,候選細胞狀態的計算變得更加簡單,并且沒有任何范圍限制。

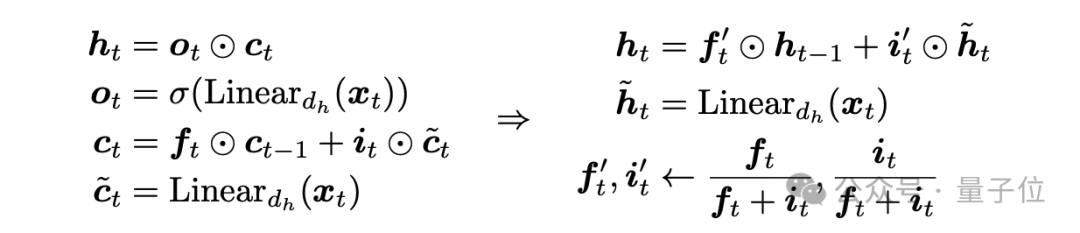

第三步,確保輸出在時間上是獨立的。

在許多序列建模設置中(例如文本生成),優化目標/輸出在時間上是獨立的。

為了確保LSTM的輸出在時間上是獨立的,minLSTM對遺忘門和輸入門進行了歸一化,確保它們的和為1,并且細胞狀態的尺度在時間上是獨立的:

通過這種方式,minLSTM確保了其輸出在時間上是獨立的,這有助于優化過程中的數值穩定性。

minLSTM的最終形式為:

Were RNNs All We Needed?

在精簡了RNN們之后,Bengio團隊也展示了實驗結果。

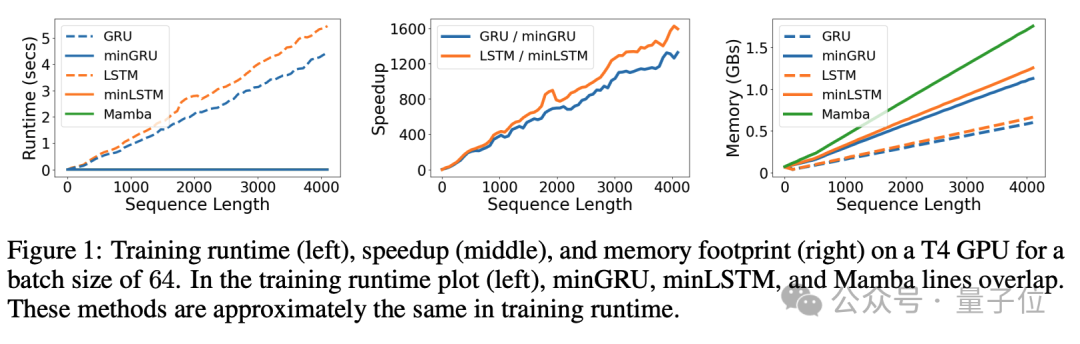

例如下圖顯示了minGRU、minLSTM和Mamba模型在訓練效率方面的比較,具體包括訓練運行時間、加速比和內存占用。

這些指標是在T4 GPU上,以64的批次大小進行測量的:

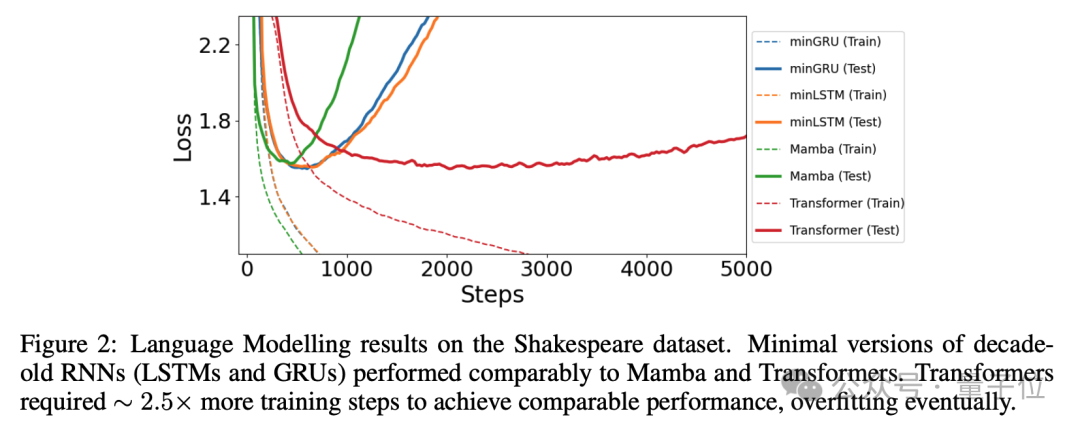

以及在下圖中,還展示了在Shakespeare語言建模任務中,不同模型的學習曲線。

這個任務使用字符級生成對抗訓練,目的是評估模型在文本生成任務中的表現,簡化RNN模型在處理語言建模任務時具有較好的有效性和高效率(特別是在需要快速訓練和部署的應用場景中):

總而言之,Bengio團隊認為,經過簡化的RNN可能仍然是處理長序列任務的理想選擇,尤其是在資源有限的場景下,因此也提出了問題 “Were RNNs All We Needed?”

華人一作

在這項研究中,作者除了Bengio之外,還有一點值得關注,那便是一作是一位華人,Leo Feng。

從公開的個人網站來看,Leo Feng師從Bengio,目前是蒙特利爾大學的博士生,目前正在Borealis AI進行研究實習。

Leo Feng的研究范圍包括元學習和高效模型的設計,其本科畢業于牛津大學。

那么你覺得精簡版RNN這項研究如何?歡迎在評論區留言討論。

論文地址:https://arxiv.org/abs/2410.01201