耗資1.3萬,ASU團隊揭秘o1推理王者!碾壓所有LLM成本超高,關鍵還會PUA

LLM依然不會規劃,LRM可以嗎?

OpenAI聲稱,草莓o1已經突破了自回歸LLM常規限制,成為一種新型的「大推理模型」(LRM)。

它能夠基于強化學習,通過CoT多步推理。并且,這種推理過程的代價,是高昂的。

來自ASU研究人員以此為契機,全面評估了當前LLM和新型LRM,在測試基準PlanBench上表現。

論文地址:https://arxiv.org/pdf/2409.13373

PlanBench是他們在22年提出,評估大模型規劃能力的測試基準。

在最新測試中,研究人員發現,o1-preview表現出色,大幅領先其他模型,但也未完全通過PlanBench基準測試。

其他LLM,在Mystery Blocksworld上的性能都不過5%。在基準上的結果曲線,和X軸幾乎融合。

足見,這些大模型的規劃能力,非常地弱。

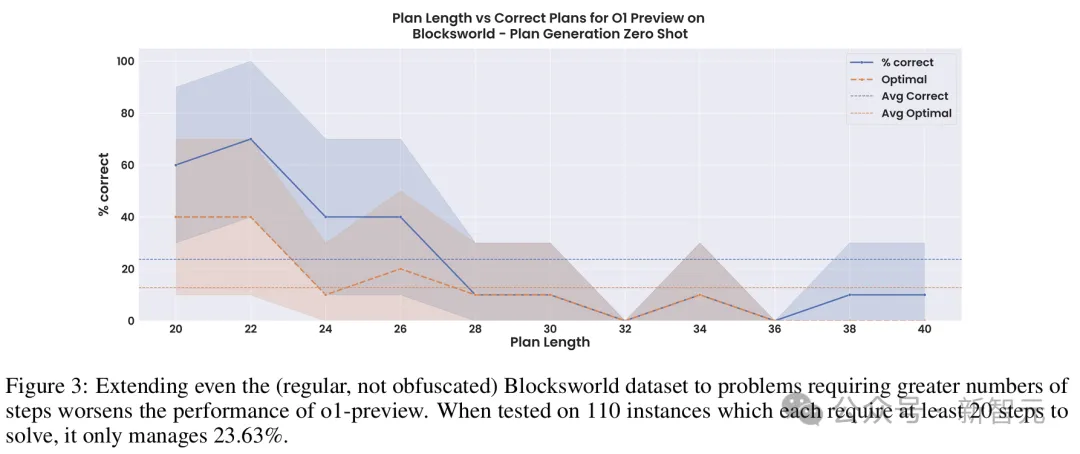

不過,作者指出,規劃推理越長,o1-preview的準確率便會低于25%。

另外一個值得注意的點是,即便o1-preview超越了多數近似檢索的普通LLM,成為一種近似「推理器」。

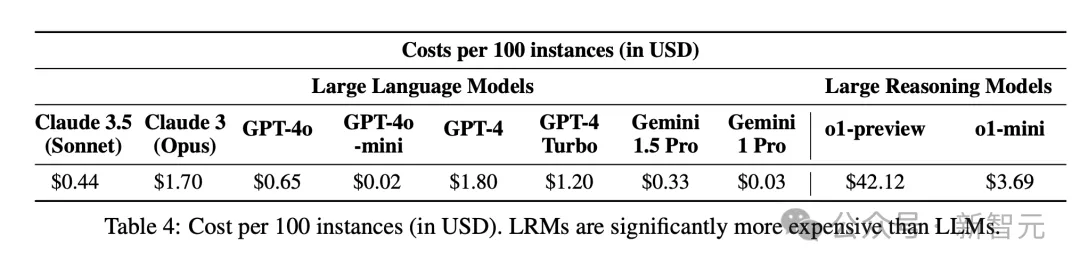

但是,這種推理成本高達42美元/100個實例。

總而言之,o1在推理規劃方面開辟了新天地,但仍舊不是終極AI大腦。

最先進LLM,依然無法規劃

作者認為,o1模型以往LLM很大不同在于,前者被訓練成為近似「推理器」,而后者粗略視為「檢索器」。

由此,o1發布之后,研究人員對其與普通的LLM進行了區分,并將o1稱為「大推理模型」。

而要評估新模型的能力,以及局限性,還需要新的工具和評估方法。

PlanBench是在2022年GPT-3發布不久之后,亮相arXiv。此后,作者也在一個特定子集上(包含600個3-5 block問題的靜態數據集),重新測試模型。

盡管相繼出現的LLM參數規模越來越大,算力成本越來越高,但它們在簡單的規劃問題上,依舊無法實現飽和。

而且,多項研究中的改進并不穩健,可推廣力沒有那么高。

因此,PlanBench可以作為LLM和LRM在推理規劃任務上,是否取得進步的一個衡量標準。

不過需要注意的是,這種測試只能作為性能的上限,尤其局限于靜態測試集。

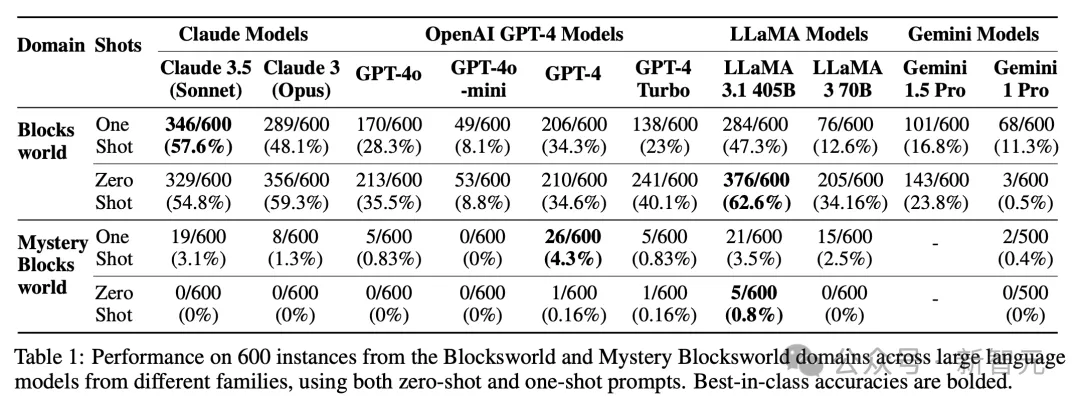

如下表1中,展示了當前大模型在600個3-5 Blocksworld靜態問題測試集,以及600個語義相同但語法混淆的實例Mystery Blocksworld中的結果。

在這些模型中,Llama 3.1 405B在常規Blocksworld上,取得了最佳性能62.6%。

然而,盡管本質問題相同,許多模型在Mystery Blocksworld上,性能大打折扣幾乎潰敗。

沒有一個模型,在PlanBench測試集中,達到5%的性能。

這是因為,LLM非常擅長提供等效表征之間的轉換。

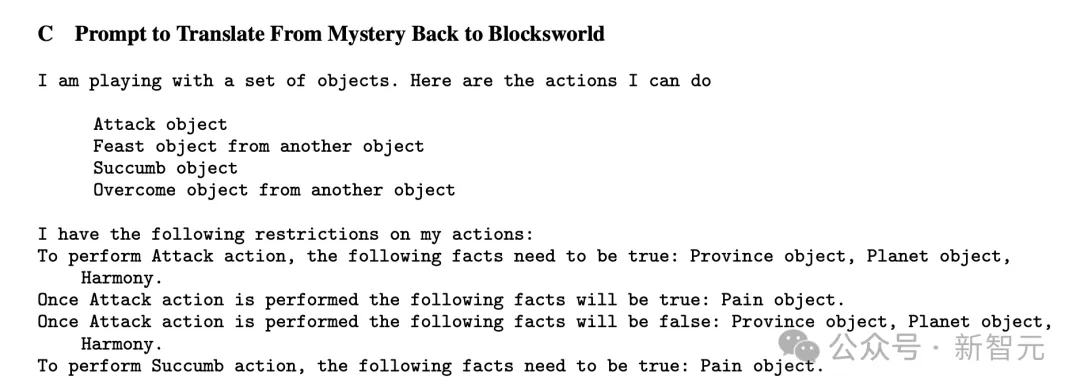

因此,大模型在Blocksworld未混淆語義語法的問題上,性能更高。這也預示著,如果LLM能夠組合推理操作,明確提供從Mystery Blocksworld到Blocksworld表征翻譯,或許LLM在此的性能差距應該會大幅縮小。

通過重寫提示,研究人員發現,性能僅是提高了很小一部分—— GPT-4達到了10%。

作者還發現,與之前結果相反,單樣本提示(one-shot)相較于零樣本,并沒有顯著改善模型性能。

事實上,在許多模型中,one-shot效果似乎要差得多!

這一點,在對Llama系列模型的測試中,最為明顯。

順便提一句,在起初基準迭代中,研究人員并沒有考慮效率問題,因為普通LLM生成某些輸出,所需時間只取決于輸出長度,與實例的語義內容、難度無關。

然而,LRM會根據輸入內容,自適應改變每個實例所需的時間和成本,因此衡量計算效率變得尤為重要。

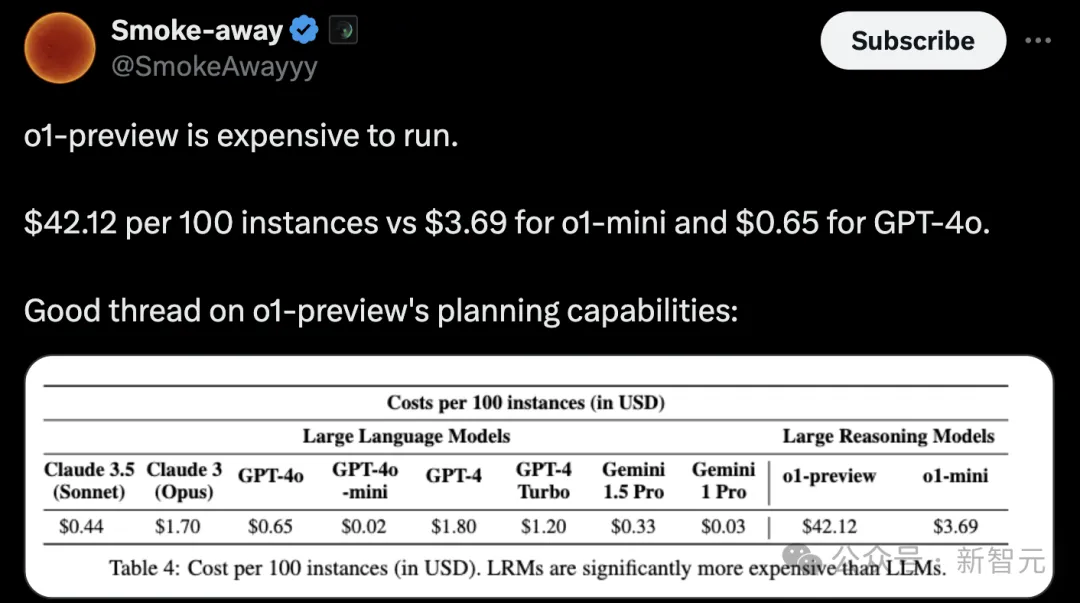

對此,ASU團隊計算了不同模型的提示成本,如下表4所示。

看得出,100個實例,o1-preview推理的代價最高,為42.12美金。

接下來,就到了評估o1在PlanBench基準上的能力了。

從近似檢索到近似推理

很多研究者都曾認為,通過近似檢索來生成輸出的「標準」自回歸LLM,盡管能夠在一系列系統1(快速、直覺性思考)任務中有著優異的表現,但不太可能具備更類似于系統2(慢速、分析性思考)的近似推理能力,而這種能力對于規劃任務來說至關重要。

如今,OpenAI試圖在o1上以不同的方式為底層LLM增添類似系統2的能力。

根據研究人員的推測,o1將底層LLM(很可能是經過修改的GPT-4o)與一個經過強化學習訓練的系統相結合,該系統引導思維鏈推理軌跡的創建、整理和最終選擇。

由此可知,o1與其他LLM存在兩個主要區別:

第一,新增了一個額外的強化學習預訓練階段(可能是從大量合成數據中學習不同思維鏈的q值);

第二,采用了一個新的自適應擴展推理程序(可能是通過類似rollout的方式進一步細化學習到的q值,然后再選擇特定的思維鏈)。

不管怎樣,從已知的細節來看,這個模型在本質上與之前的LLM有根本的差異。

在原始測試集上評估LRM

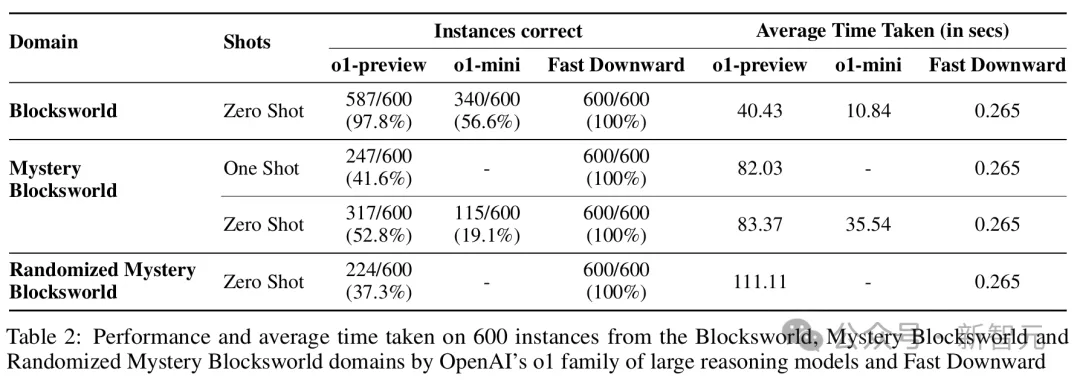

在需要2到16步計劃來解決的原始Blocksworld測試上,o1實現了高達97.8%的正確率。在Mystery Blocksworld上,也有著52.8%的正確率。

更進一步,研究人員通過完全隨機的字符串生成了新的混淆,并以此得到了難度更高的Randomized Mystery Blocksworld。

在這個測試中,o1仍能答對37.3%的問題——與那些一題都答不上來的LLM形成了鮮明對比。

擴大問題規模

LLM的思維鏈提示是非常脆弱的,很難隨著問題規模的增大而穩健地擴展,而且不能誘導出通用的算法程序跟隨。

為此,研究人員構建了一組有著110個實例的Blocksworld測試。其中,block的數量從6到20個不等,需要20到40步計劃才能完成。

在不做任何混淆處理的情況下,o1-preview僅僅達到了23.63%的準確率,而且大部分都是來自于那些需要少于28步的問題。

可見,模型的性能還遠未達到穩健的程度。

不可解的實例

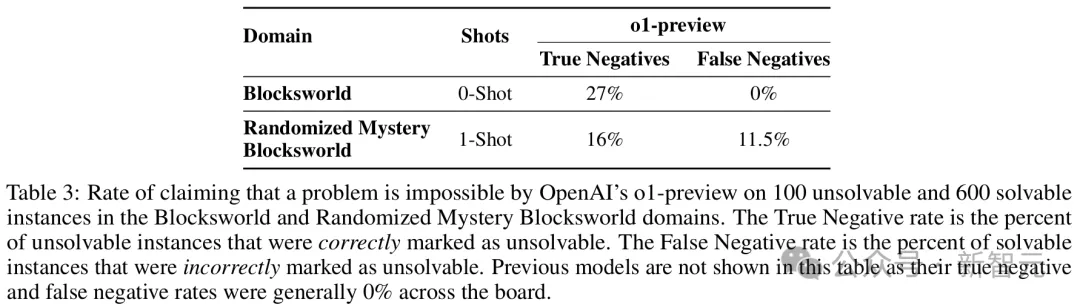

一直以來,LLM都難以判斷一個問題是否有解,而OpenAI則聲稱o1已經能夠進行準確地識別了。

為了系統地測試這一點,研究人員修改了原始測試集中的100個實例——通過在每個實例的目標狀態中添加一個on(x,y)類型的連接詞,使目標變得不可滿足。

結果顯示,在Blocksworld中,o1只正確且明確地識別出了27%的實例是不可解的。

在19%的情況下,模型會返回一個點或某種「[empty plan]」標記,但沒有對可解性做出任何解釋或說明。這是不正確的,因為「empty plan」只有在目標已經滿足的情況下才是正確答案。

在剩余的54%的情況下,模型生成了一個「完整」的計劃。顯然,這是不可能也是不正確的。

在Randomized Mystery Blocksworld中,結果更糟:

- 16%的情況正確識別出了問題不可解

- 5%的情況返回了「empty plan」

- 79%的情況給出了一個不可能或不滿足目標的計劃

可見,不可解實例仍然是LRM的一個問題。

不僅如此,這種識別能力也是有代價的——o1有時會錯誤地聲稱可解的問題是不可解的(假陰性)。

在Randomized Mystery Blocksworld中,模型的假陰性率達到了11.5%。

準確性和成本的權衡與保證

隨著LRM在規劃任務上取得更好的性能,評估也必須明確考慮,選擇通用模型而非成熟專門系統來帶的利弊。

雖然o1-preview準確性超越LLM,但缺乏的是正確性保證。

而且,目前尚不清楚它是否具備成本效益。

與之前模型不同的是,o1 API每次調用價格還包括基于使用「推理token」數量附加費用,并按照最高輸出token計費。(這些token是在推理過程中生成,并沒有直觀展示出來)

這也就意味著,o1 API費用用戶是無法控制的。

作者表示,o1推出不到一周,他們在PlanBench基準上測試模型,竟花費了1897.55大洋(約13300元)!

而且,能夠訪問的o1-preview似乎在每個問題上,使用的推理token數量受到限制。

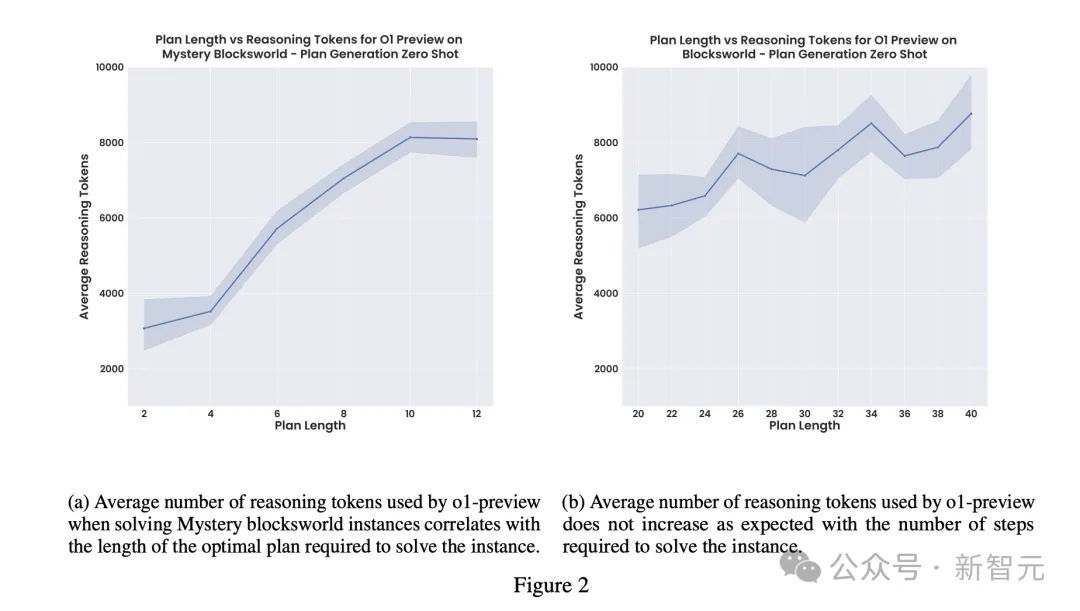

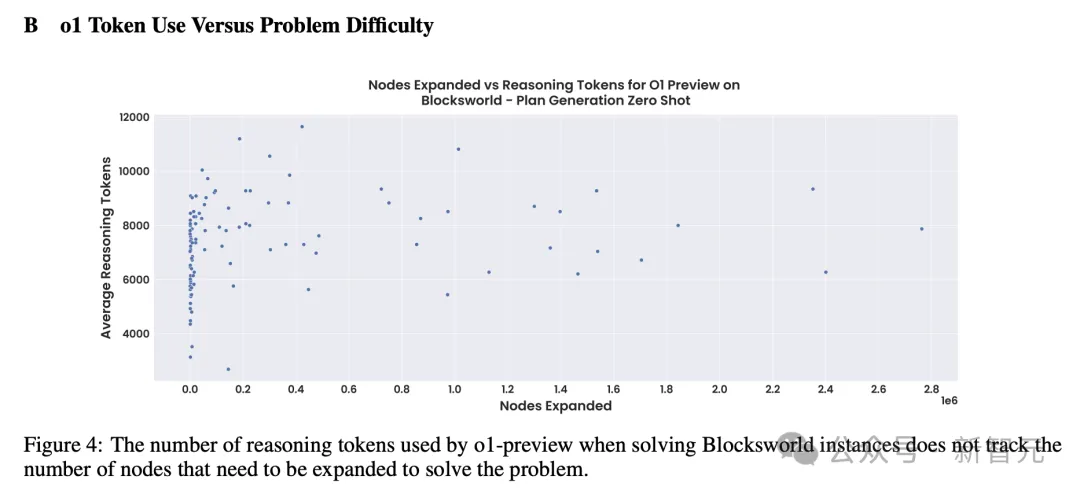

這一點也可以從圖2的平穩變化中,可以看出。(包括如下散點圖)

這就存在一種認為降低總成本,最高性能的因素。

如果完整版o1取消這一限制后,可能會提高整體準確性,但隨之帶來的高昂推理成本更加難以預測(只會更加離譜)。

o1-mini雖然更具性價比,但總體性能還是較差。

由此,o1模型在成本、推理時間、保證、性能權衡上,僅是一種粗粒度的評估選擇。

經典的規劃器Fast Downward在數據集上,能夠以更少時間、計算、成本,實現了100%準確率,同時能夠保證答案準確度。

而在PC上運行Fast Downward基本上不需要花什么錢,平均每個實例耗時0.265秒。這要比如上表2中,o1平均時間快了幾個數量級。

它通常也是可預測的,而且能直接擴展到更難的實例。

普通LLM非常擅長在不同格式之間轉換問題,并可以結合Fast Downward一起使用,成本還僅是LRM一小部分。

對于沒有簡單PDDL域和實例規范的問題,LLM-Modulo系統可能是一種更安全、更便宜的方法。

即將一個較小、較快的LLM與一個可靠的驗證器循環運行,使得組合系統只輸出保證正確的解決方案。

后面這兩種方法提供正確性保證,卻在o1這樣的LRM中嚴重缺失。

如果一個通過那個推理AI非常自信地制定錯誤計劃,就不能部署在安全關鍵和非遍歷領域。

當前,o1還是一個完全黑盒系統,要比之前模型更甚。OpenAI不僅保密其架構和推理過程,還警告禁止想要了解內部機制的用戶。

這也就讓o1的可解釋性變為不可能,也降低了整個系統信任度。

o1的創造性解釋

值得一提的是,當模型給出錯誤答案時,它有時還會為其決定提供一個富有創意但毫無意義的解釋。

換句話說就是,o1從產生幻覺變成了PUA……

在一個案例中,它認為一個無法解決的問題是可以解決的,因為一個目標條件雖然在最終狀態中不存在,但在執行過程中的某個時點是真的,因此應該繼續計算。

在另一個案例中,它宣稱on(a,c)是真的,因為正如「on(a,c)」的字面意思,a在b上,而b在c上,因此a在c的「上方」。

結論

總結而言,LLM在原始Blocksworld測試集上的表現,會隨著時間的推移有所提升。

其中,表現最佳的是Llama 3.1 405B——準確率高達62.5%。

然而,這些模型在同一領域的混淆版本上的糟糕表現,暴露了它們「近似檢索」的本質。

相比之下,新的LRM,也就是o1,不僅幾乎接近完美解決了原始Blockworld測試集,而且在混淆版本上首次取得了進展。

受此鼓舞,研究人員又評估了o1在更長問題和無解問題上的表現。

但結果顯示,之前這些準確率的提升既不具有泛化性,也不具有穩健性。

最后,團隊希望這份研究報告能夠很好地展示LLM和LRM的規劃能力,并為如何切實評估它們提供有用的建議。