給機器人裝上「蟲腦」?非Transformer液態神經網絡終于來了!MIT CSAIL負責人創業成果

在大模型時代,谷歌 2017 年開創性論文《Attention Is All You Need》中提出的 Transformer 已經成為主流架構。

然而,剛剛一家由 MIT 計算機科學與人工智能實驗室 (CSAIL) 前研究人員共同創立的初創公司 Liquid AI 卻走出了不一樣的路線。

Liquid AI 表示他們的目標是「探索構建超越生成式預訓練 Transformer (GPT) 基礎模型的方法」。

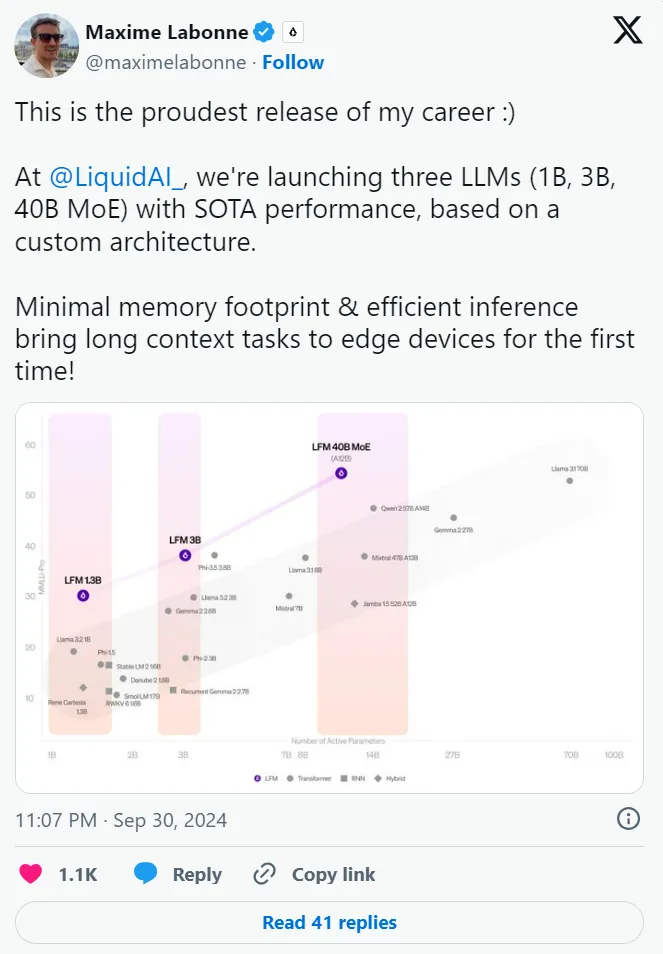

為了實現這一目標,Liquid AI 推出了其首批多模態 AI 模型:Liquid Foundation Models(LFM)。這是基于第一原理構建的新一代生成式 AI 模型,其 1B、3B 和 40B LFM 在各個規模上均能實現 SOTA 性能,同時保持更小的內存占用和更高效的推理。

Liquid AI 后訓練主管 Maxime Labonne 在 X 上表示,LFM 是他職業生涯中最自豪的版本 ,LFM 的核心優勢在于它們能夠勝過基于 Transformer 的模型,同時占用更少的內存。

有人表示,LFM 是 Transformer 的終結者。

還有網友盛贊 LFM 是游戲規則的改變者。

更有網友認為「可能是時候放棄 Transformers 了,這種新架構看起來很有前途。」

Liquid AI 發布三款模型

LFM 系列擁有三種不同的尺寸和變體:

- 密集型 LFM 1.3B(最小),非常適合資源高度受限的環境。

- 密集型 LFM 3B,適合在邊緣部署優化。

- LFM 40.3B MoE 模型(最大,類似于 Mistral 的專家混合模型),專為處理更復雜的任務而設計。

SOTA 性能

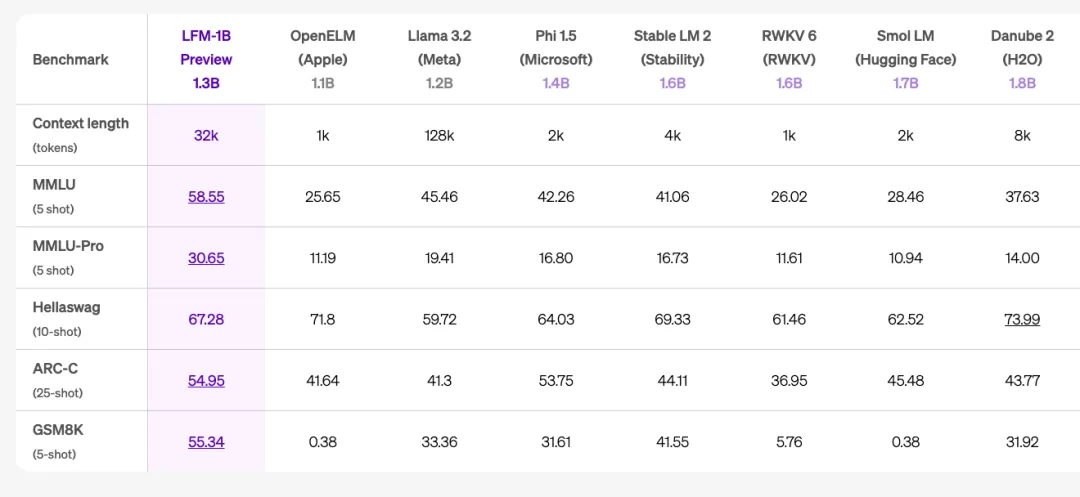

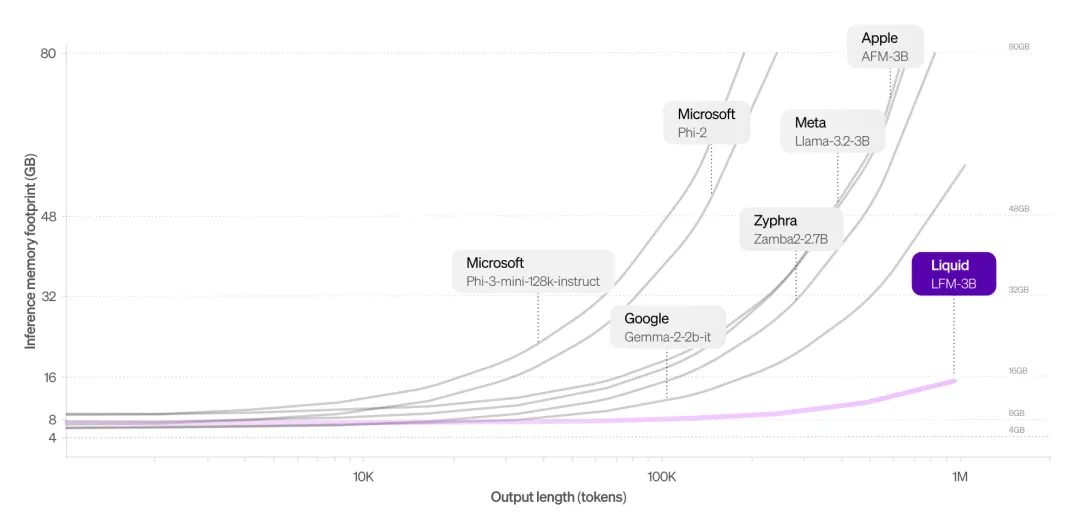

LFM-1B 與同等規模模型的比較。LFM-1B 在各項基準測試中均取得最高分,成為該規模下最先進的模型。這是非 GPT 架構首次顯著優于基于 Transformer 的模型。舉例來說,LFM 1.3B 在第三方基準測試中優于 Meta 的 Llama 3.2-1.2B 和微軟的 Phi-1.5。

LFM-3B 實現了令人難以置信的性能,在與 3B transformer 模型、混合模型和 RNN 模型的比較中名列第一。在多個基準測試中也與 Phi-3.5-mini 相當,同時規模小了 18.4%。可以看出 LFM-3B 是移動和其他邊緣文本應用的理想選擇。

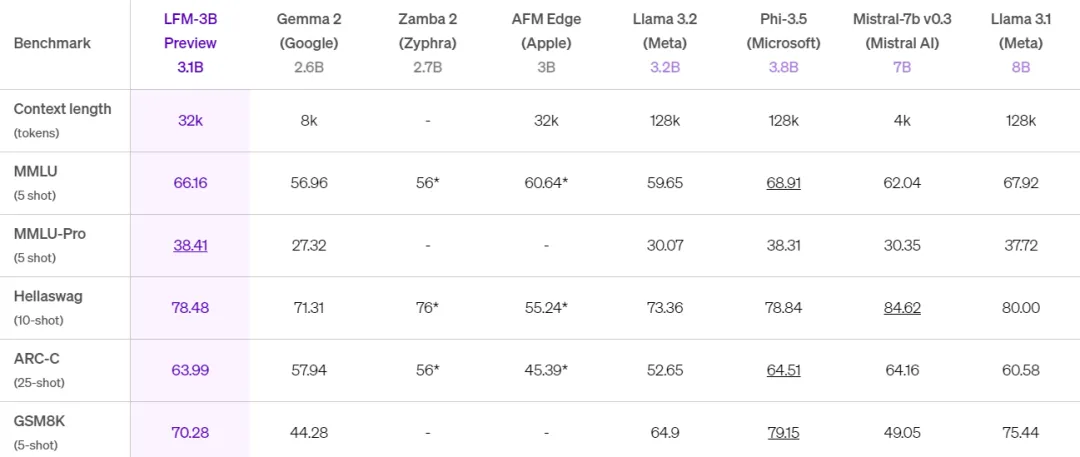

LFM-40B 在模型大小和輸出質量之間實現了新的平衡。它在運行時可以激活 12B 參數,其性能媲美更大的模型,而 MoE 架構可實現更高的吞吐量,并可在更具成本效益的硬件上進行部署。

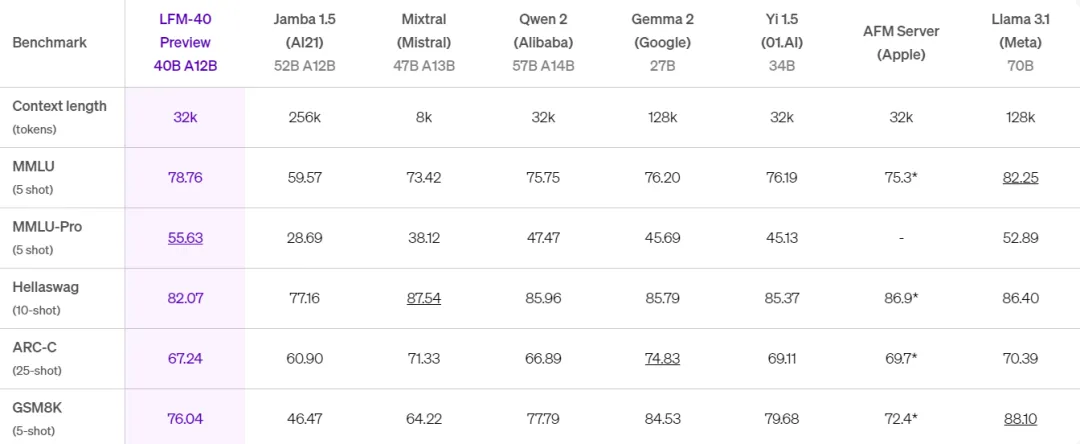

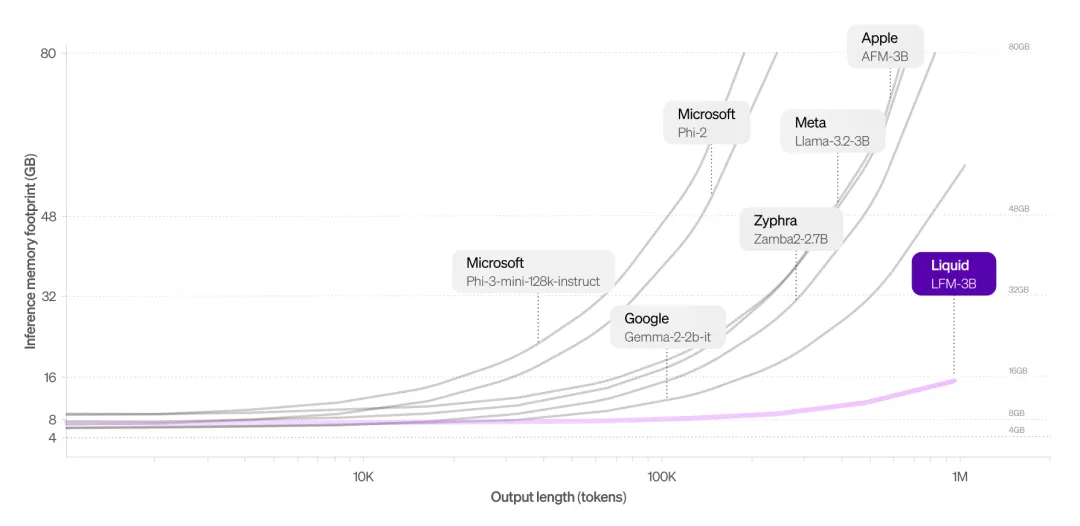

內存高效

與 Transformer 架構相比,LFM 占用的內存更少。對于長輸入尤其如此,因為基于 Transformer 的 LLM 中的 KV 緩存會隨著序列長度線性增長。通過高效壓縮輸入,LFM 可以在相同硬件上處理更長的序列。與其他 3B 類模型相比,LFM 占用的內存最少。舉例來說,LFM-3B 僅需要 16 GB 內存,而 Meta 的 Llama-3.2-3B 則需要超過 48 GB 內存。

LFM 真正利用了上下文長度

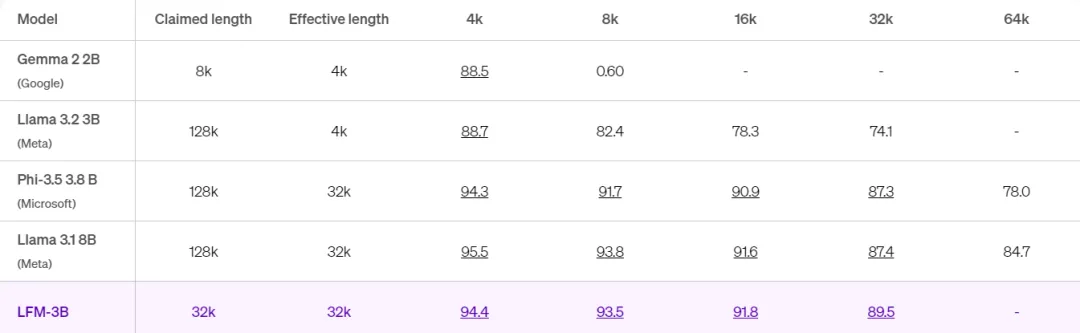

下表比較了幾種模型在不同上下文長度下的表現。

這種高效的上下文窗口首次在邊緣設備上實現了長上下文任務。對于開發者來說,它解鎖了新的應用,包括文檔分析和摘要、與上下文感知聊天機器人進行更有意義的交互,以及改進的檢索增強生成 (RAG) 性能。

這些模型不僅在原始性能基準方面具有競爭力,而且在運營效率方面也具有競爭力,使其成為各種用例的理想選擇,從金融服務、生物技術和消費電子產品領域的企業級應用程序到邊緣設備的部署。

用戶可以通過 Lambda Chat 或 Perplexity AI 等訪問。

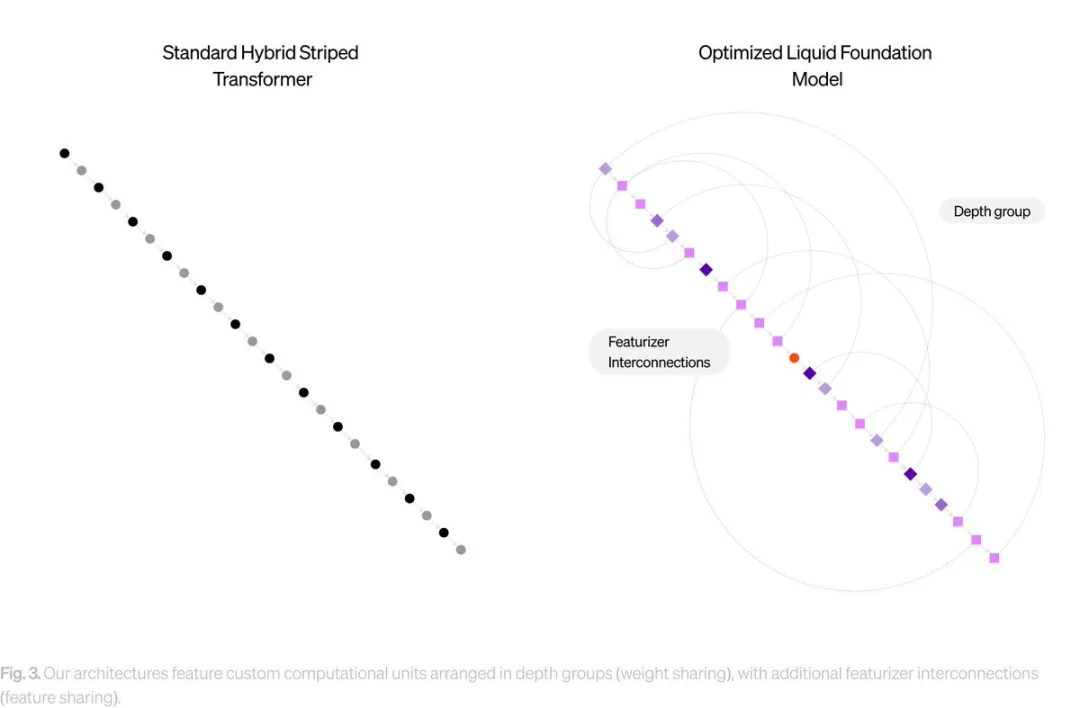

Liquid 如何超越生成式預訓練 Transformer (GPT)

Liquid 使用了一種混合的計算單元,這些計算單元深深植根于動態系統理論、信號處理和數值線性代數的理論中。結果就是開發出了通用的人工智能模型,這些模型能夠用來模擬任何類型的序列數據,包括視頻、音頻、文本、時間序列和信號,以此來訓練其新的 LFM。

早在去年,Liquid AI 就使用了一種名為 LNN(Liquid Neural Networks)的方法,與需要數千個神經元來執行復雜任務的傳統深度學習模型不同,LNN 表明,更少的神經元(結合創新的數學公式)可以實現相同的結果。

Liquid AI 的新模型保留了這種適應性的核心優勢,允許在推理過程中進行實時調整, 而不會帶來傳統模型相關的計算開銷。可以高效處理多達 100 萬個 token,同時將內存使用量降至最低。

例如,在推理內存占用方面,LFM-3B 模型的表現優于 Google 的 Gemma-2、Microsoft 的 Phi-3 和 Meta 的 Llama-3.2 等流行模型,尤其是在 token 長度擴展的情況下。

雖然其他模型在處理長上下文時內存使用量會急劇增加,但 LFM-3B 占用的空間卻小得多,因此非常適合需要大量順序數據處理的應用程序,例如文檔分析或聊天機器人。

Liquid AI 已將其基礎模型構建為跨多種數據模態(包括音頻、視頻和文本)的通用模型。

憑借這種多模態能力,Liquid 旨在解決從金融服務到生物技術和消費電子產品等各種行業特定挑戰。

Liquid AI 正在為多家硬件制造商的產品優化其模型,包括 NVIDIA、AMD、Apple、Qualcomm 和 Cerebras。

Liquid AI 正在邀請早期用戶和開發者測試他們的新模型并提供反饋。雖然目前模型還不完美,但公司計劃利用這些反饋來改進產品。他們將于 2024 年 10 月 23 日在麻省理工學院舉行正式發布會。

為了保持透明度和推動科學進步,公司計劃在發布會前發表一系列技術博客文章。他們還鼓勵用戶進行紅隊測試,探索模型的極限,以幫助改進未來版本。

Liquid AI 推出的 LFM 結合了高性能和高效的內存使用,為傳統的基于 Transformer 的模型提供了一個有力的替代選擇。這使得 Liquid AI 有望成為基礎模型領域的重要玩家。

Liquid AI :從一條小蟲子開始

這家公開與 OpenAI 和其他大語言模型公司競爭的創業公司,由 MIT 計算機科學和人工智能實驗室 CSAIL 孵化,成立于 2023 年 3 月。

2023 年 12 月,公司拿到種子輪融資 3750 萬美元,估值達到 3 個億。

投資人包括 GitHub 聯合創始人 Tom Preston Werner、Shopify 聯合創始人 Tobias Lütke 、 Red Hat 聯合創始人 Bob Young,等。

MIT CSAIL 主任 Daniela Rus 是公司創始人之一,這位著名的機器人學家和計算機科學家也是該實驗室的首位女性主管。

除了 Daniela Rus,Liquid AI 另三位聯合創始人都曾是 MIT CSAIL 博士后研究人員。

聯合創始人兼 CEO Ramin Hasani 在 MIT CSAIL 從事博士后研究之前,曾是美國最大的基金管理公司之一先鋒集團( Vanguard )的首席人工智能科學家。

聯合創始人兼 CTO Mathias Lechner 早在維也納工業大學讀書時,就和 Hasani 一起研究過線蟲的神經結構。

聯合創始人兼首席科學官 Alexander Amini 曾是 Daniela Rus 的博士生。

四位創始人(從左到右)CEO Ramin Hasani,Daniela Rus,首席科學官 Alexander Amini 和 CTO Mathias Lechner

2017 年,Daniela Rus 將 Hasani 和 Lechner 「挖到 」MIT CSAIL,Rus 和她的博士生 Amini 也加入到液態神經網絡的研究中。

Daniela Rus 指出,生成式 AI 在安全、可解釋性以及算力等方面存在明顯局限性,很難被用于解決機器人問題,特別是移動機器人。

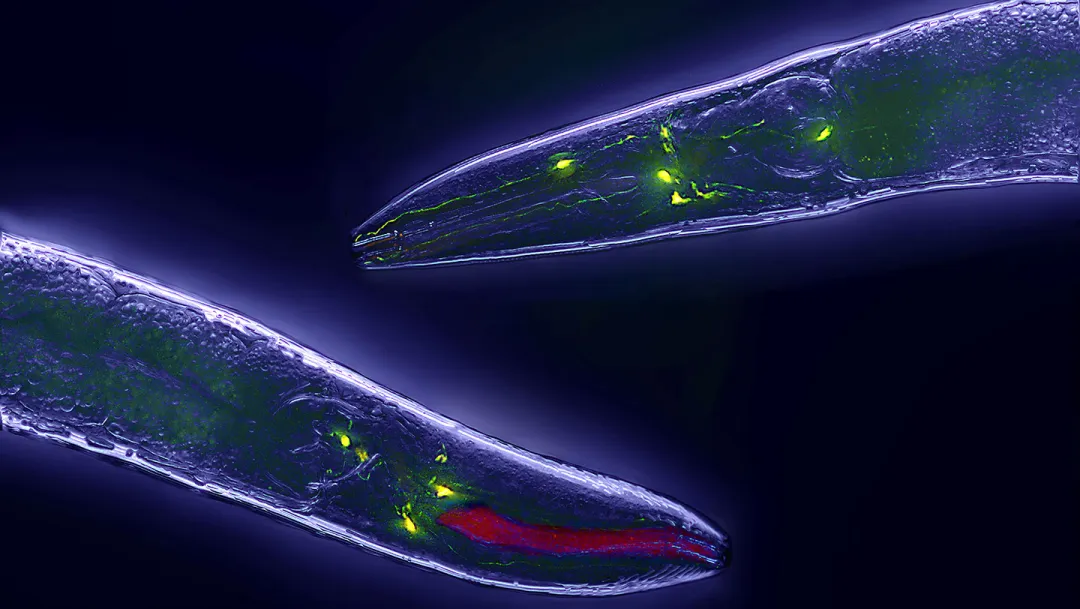

受科研界的「常客」秀麗隱桿線蟲的神經結構啟發,Daniela Rus 和她的實驗室博士后人員研發出一種新型的靈活神經網絡,也被成為液態神經網絡。

秀麗隱桿線蟲也是唯一完成連接組(connectome)測定的生物體(截至 2019 年)。雖然大腦簡單,但在學習和適應環境方面也比當下任何人工智能系統都要好得多。

秀麗隱桿線蟲體長僅 1 毫米、只有 302 個神經元、96 塊肌肉,但卻具備感知、逃逸、覓食、交配等復雜智能行為。

它是最簡單的生命智能體,也是通過生物神經機理模擬實現通用人工智能的最小載體。

近幾年來,科研人員也在利用線蟲神經的研究成果進行計算機生物仿真。通過研究線蟲大腦如何工作,Daniela Rus 等人設計出一種「液態時間常數網絡」( Liquid Time-constant Networks):

一個連續時間模型,由多個簡單的動態系統組成,這些系統通過非線性門相互調節。

如果說,標準的神經網絡猶如一層層間隔均勻的水壩,每層水壩上安裝了許多閥門(權重),計算的洪流每流經一層水壩,都要透過這些閥門,匯總后再奔向下一層。

那么,液態神經網絡不需要水壩,因為,每個神經元都由微分方程 (ODE)控制。

這種網絡的特點是時間常數可變,輸出通過求解微分方程得到。研究表明,它在穩定性、表達能力和時間序列預測方面都優于傳統模型。

后來,Daniela Rus 等人又提出一種近似方法,可以用閉式解來高效地模擬神經元和突觸之間的相互作用( Closed-form continuous-time neural networks ),不僅大大提高了模型的計算速度,也顯示出更好的可擴展性,在時間序列建模方面表現出色,優于許多先進的循環神經網絡模型。

Liquid AI 團隊成員曾聲稱,該架構適合分析任何隨時間波動的現象,包括視頻處理、自動駕駛、大腦和心臟監測、金融交易(股票報價)和天氣預報等。

除了像液體一樣的靈活性,與動輒數十億參數規模的生成 AI 模型相比,液態神經網絡的另一個特點是規模小得多。

例如,可在資源高度受限環境中部署的 LFM 1.3B,參數僅 1.3B(與 GPT-2 最大版本 1.5B 相近),同時保持了更小的內存占用和更高效的推理,可以在各種機器人硬件平臺上運行。

另外,由于尺寸小、架構簡單,液態神經網絡也有可解釋性方面的優勢。

不過,全新架構將如何與 OpenAI 等競爭對手的主流模型相抗衡還有待觀察。

Hasani 曾表示,目前 Liquid AI 沒有計劃為消費者開發像 ChatGPT 這樣的應用程序。公司首先關注希望為金融和醫學研究建模的企業客戶。