小紅書搜索:生成式檢索的探索與實踐

一、研究團隊

目前團隊有四名成員,主要研究方向包括大模型評測推理及生成式檢索,目前在進行技術(shù)攻關(guān)以實現(xiàn)大模型在搜索系統(tǒng)各環(huán)節(jié)的落地應(yīng)用。

二、檢索范式

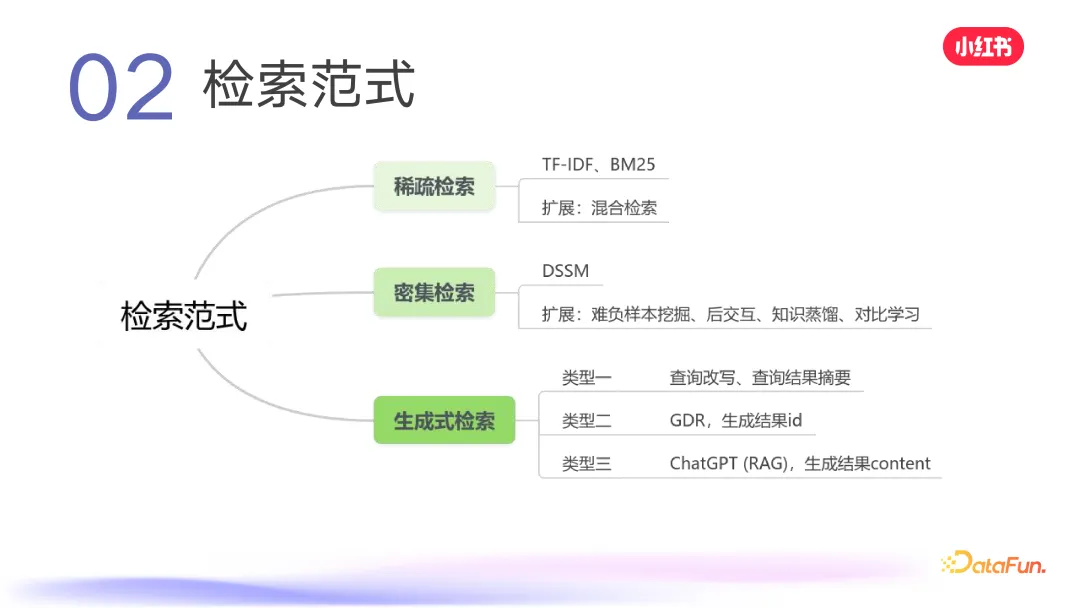

目前常見的檢索范式包括:

- 稀疏檢索,如 TF-IDF、BM25,以及一些擴展的混合檢索;

- 密集檢索,常見模型有 DSSM,還有一些變體,如難負樣本挖掘、后交互、知識蒸餾,以及 loss 上的一些工作(對比學(xué)習(xí))。

- 生成式檢索,常見的有三種,一種是對現(xiàn)有檢索系統(tǒng)各個模塊進行優(yōu)化,比如在 QP 環(huán)節(jié)對查詢進行改寫,對最終結(jié)果進行摘要,這在商品搜索、小紅書、抖音、快手等平臺都能看到,即 one box 查完后上文的摘要;第二種是今天要介紹的主題 GDR,根據(jù) query 直接生成筆記 ID 或文檔 ID,要求對檢索系統(tǒng)的召回環(huán)節(jié)進行較大改動;第三種是理想態(tài),如 ChatGPT,直接生成結(jié)果的 context。從使用角度看,對于某一類問題,用戶可能希望有直接生成的結(jié)果,但對于像小紅書、抖音、快手等內(nèi)容平臺,用戶不僅希望看到搜索結(jié)果的摘要,還希望看到其他用戶在平臺上關(guān)于查詢內(nèi)容的分享,所以這幾種檢索類型都有必要。

三、GDR:記憶機制的雙刃劍效應(yīng)

接下來介紹我們發(fā)表在 EACL 2024 Oral 的一個工作:

主要探索生成式檢索的關(guān)鍵問題——記憶機制。文章中分析了記憶機制的幾個問題,并與密集檢索進行了重要差異對比。針對生成式檢索的問題,提出了一些解決方案。

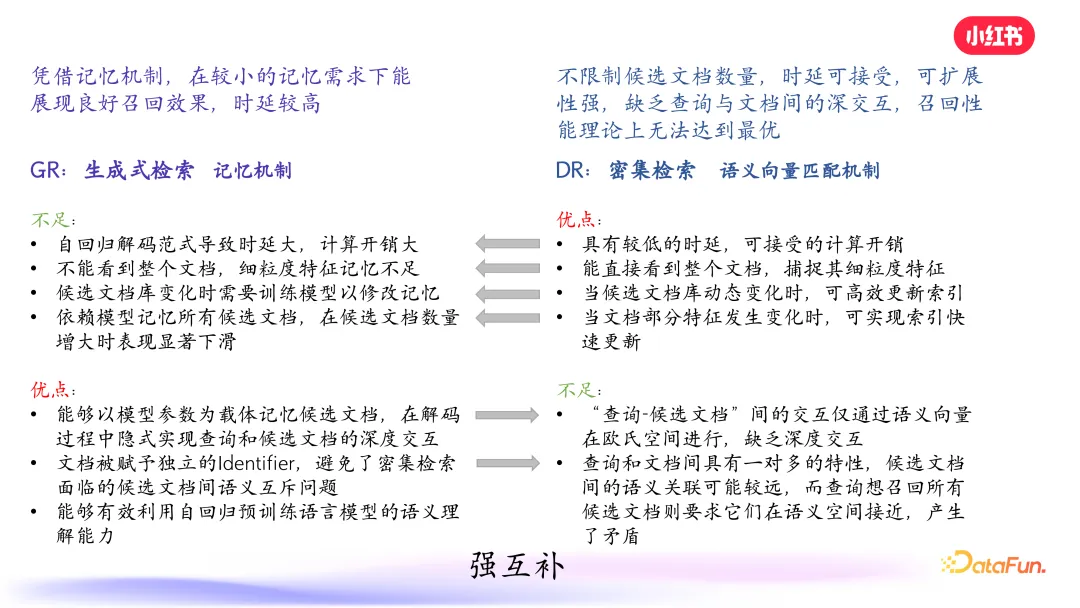

簡要回顧密集檢索,其本質(zhì)是利用語義向量匹配機制,在各個業(yè)務(wù)場景廣泛應(yīng)用。其優(yōu)點是具有較低的時延、可接受的在線計算開銷,并且比較靈活,當(dāng)文檔庫發(fā)生動態(tài)更新時,可以快速高效地更新索引。采用雙塔模型,無論是 query 側(cè)還是筆記側(cè),都可以輸入豐富的信息,有助于模型捕捉細粒度特征。上圖中可以看到,雙塔一側(cè)是 query 的語義向量編碼,另一側(cè)是 doc 的語義向量編碼,在向量空間做距離計算,進行優(yōu)化。

其不足之處是雙塔模型無法進行深度交互,都是得到向量后,語義向量在歐氏空間進行計算。我們知道深交互有助于特征交叉,提升模型性能。但在檢索環(huán)節(jié),由于對計算時間和開銷的要求,一般不會進行深度交互。另外一個缺點是,查詢和文檔之間具有一對多的特性,候選文檔的語義關(guān)聯(lián)可能較遠,而查詢想召回的所有候選文檔則要求它們在語義空間接近,產(chǎn)生了矛盾。

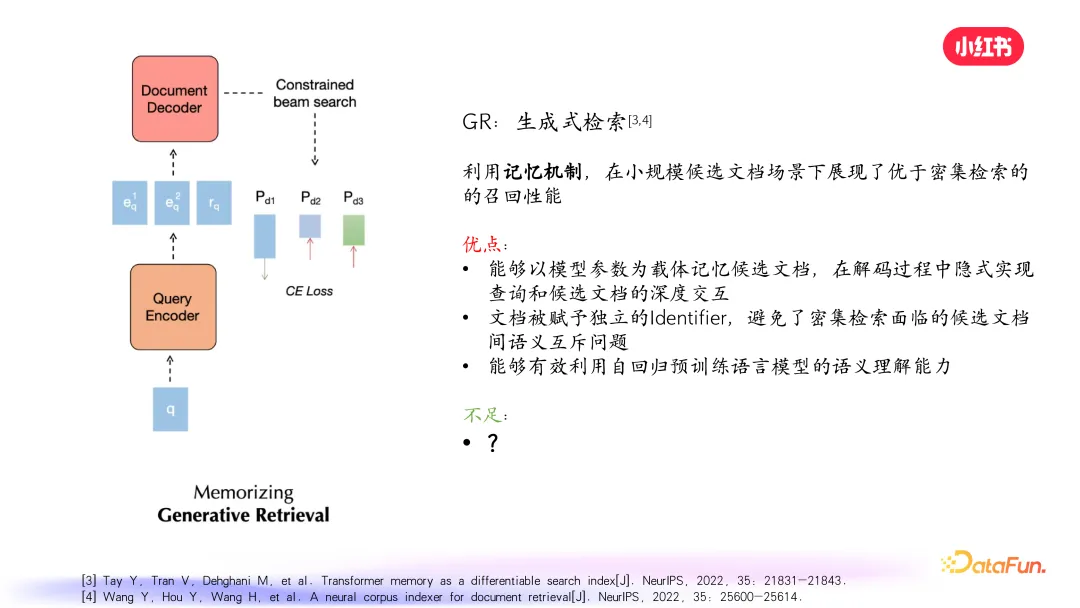

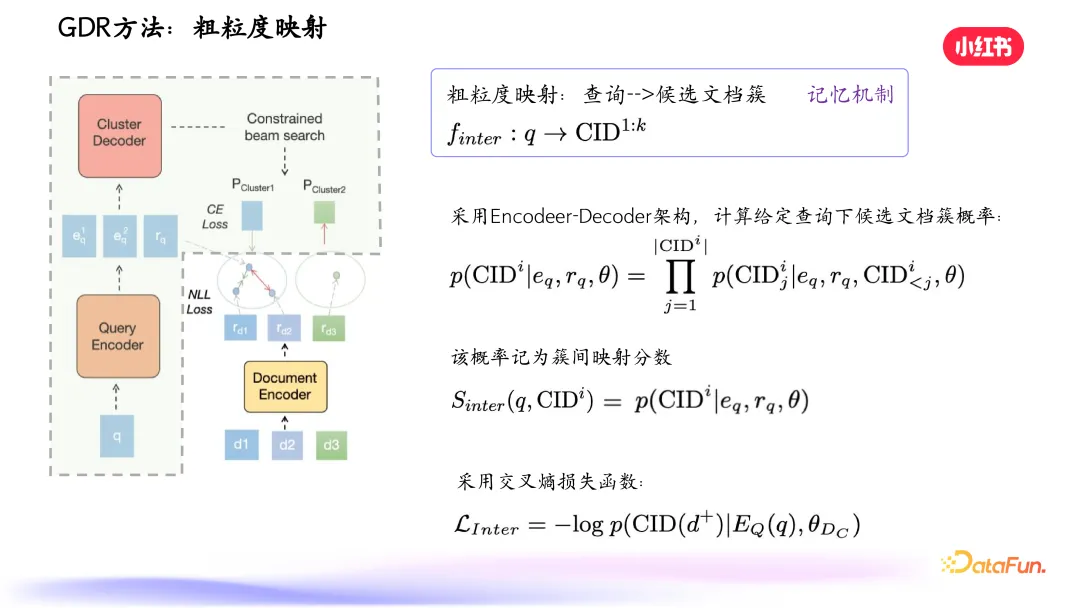

再來看一下生成式檢索。給定一個 query,生成式檢索的編碼端首先得到一個向量,然后將這個向量給到文檔解碼器,用 Beam Search 解碼策略逐步得到每篇筆記的 ID。這意味著筆記需要通過 ID 進行表示,可以是單值或一串序列的值。預(yù)測過程是給 query 直接生成筆記 ID,而不是先得到 query 的向量,在歐氏空間和筆記向量進行計算找到最相似的向量。其本質(zhì)是利用記憶機制,因為 query 進去后,筆記沒有拿出向量,所以要求模型根據(jù) query 記住相關(guān)筆記的 ID 序列。

在較小規(guī)模的候選文檔場景下,生成式檢索展現(xiàn)出了優(yōu)于密集檢索的召回性能。具體優(yōu)點包括:模型以參數(shù)作為記憶載體,記住所有候選文檔,在解碼過程中隱式實現(xiàn)了候選文檔和查詢的深度交互,這是密集檢索的主要缺點;另外,文檔被賦予了獨立的 ID,避免了密集檢索存在的 one to many 情況;如果將 query 的編碼器換成大語言模型,能有效利用預(yù)訓(xùn)練語言模型的語義理解能力。

但生成式檢索也存在不足,接下來從三個方面來詳細介紹。

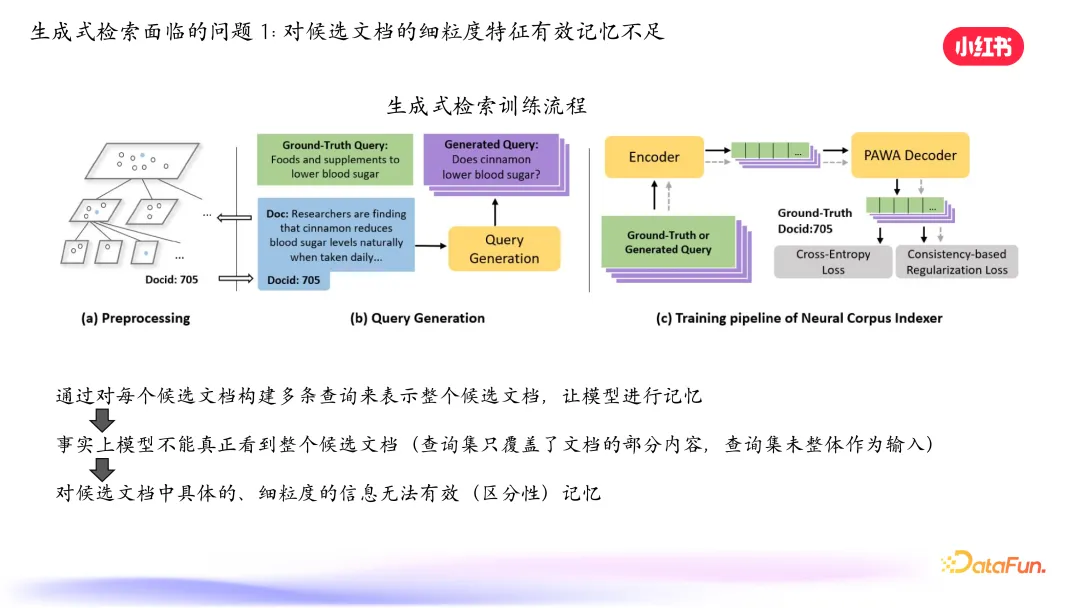

首先,對候選文檔的細粒度特征有效記憶不足。生成式檢索的訓(xùn)練流程是先對文檔進行表示,通過聚類得到層級樹狀圖,每篇筆記通過一條 path 表示。然后對 query 進行處理,為每篇筆記生成一堆 query 來表示筆記,將真實 query 和生成 query 集合作為輸入,生成對應(yīng)的筆記 ID。但目前構(gòu)建 query 的方式不能很好地充分拿到所有筆記信息和進行從細粒度到 high level的表示學(xué)習(xí),導(dǎo)致候選文檔不能很好地記住細粒度特征。

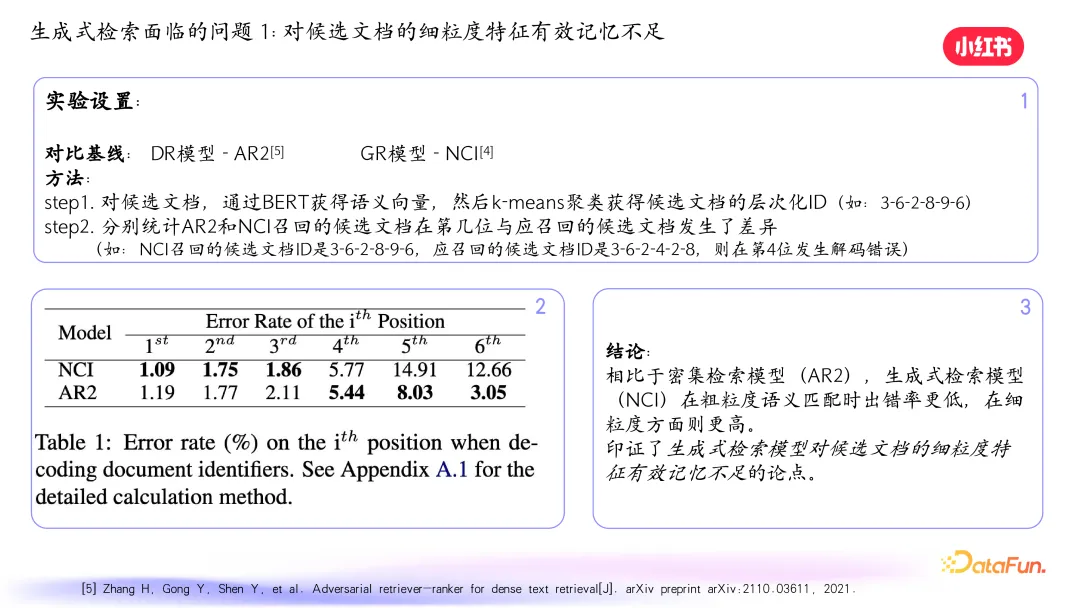

我們做了一個實驗,對比基線是常見的密集檢索模型和生成式模型 NCI。對文檔獲取語義向量后聚類,得到層次化 ID,分別用 AR2 和 NCI 模型召回筆記,在測試集上統(tǒng)計錯誤率。發(fā)現(xiàn)生成式檢索模型在前面幾位錯誤率較低,但越往后錯誤率升得特別快,驗證了對細粒度特征有效記憶不足的問題。

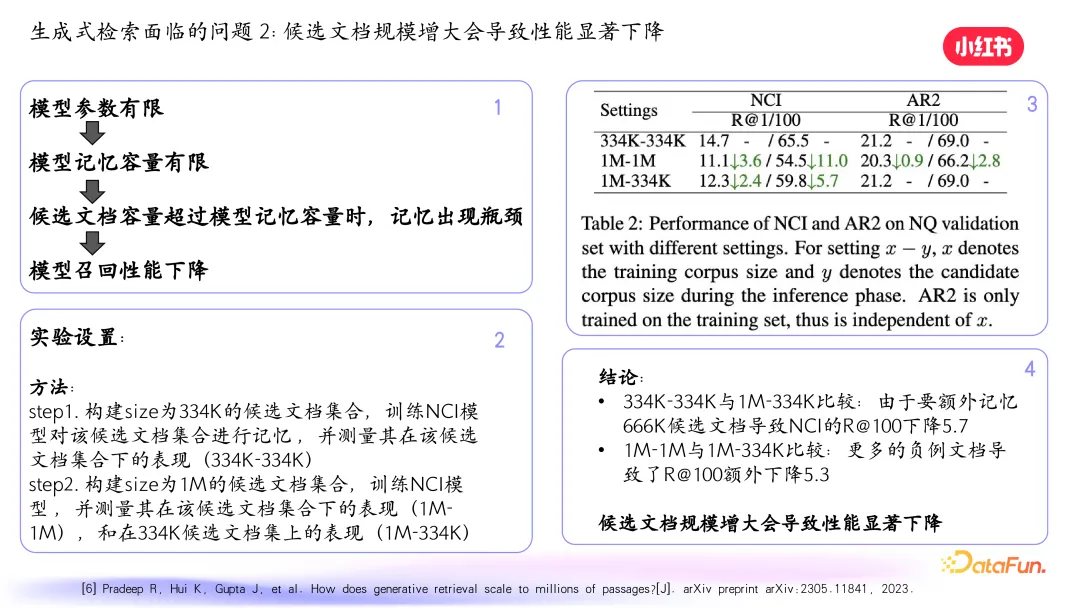

其次,當(dāng)候選文檔規(guī)模增大時,性能會顯著下降。原因是模型參數(shù)有限,記憶容量有限,當(dāng)候選文檔容量超過模型記憶容量時,記憶出現(xiàn)瓶頸,性能下降明顯。我們做了一個實踐,構(gòu)建不同規(guī)模的候選文檔集合訓(xùn)練 NCI 模型,測試在不同候選文檔下的表現(xiàn),發(fā)現(xiàn)候選文檔增多時,生成式模型的召回率下降明顯。

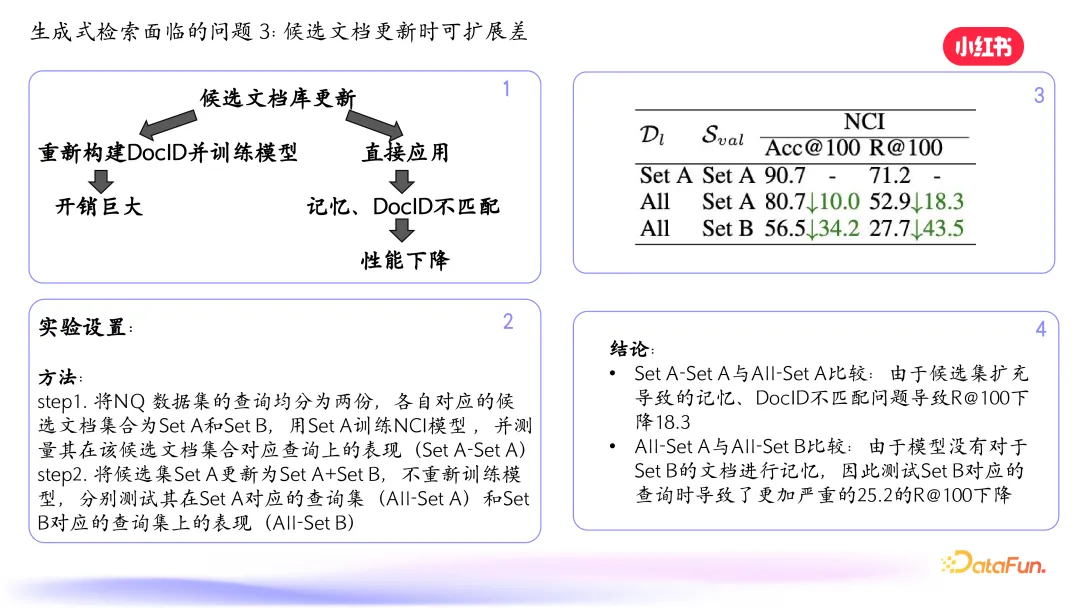

第三,候選文檔更新時可擴展性差。對于密集檢索,新文檔加入后可以快速更新向量加入索引。但對于生成式檢索,文檔變了需要生成新的 query 加入模型訓(xùn)練,容易出現(xiàn)災(zāi)難性遺忘問題。如果不訓(xùn)練直接應(yīng)用,可能會出現(xiàn)預(yù)測不準(zhǔn)確的問題。我們做了一個驗證實驗,將數(shù)據(jù)集均分為兩份,先用一份子集訓(xùn)練 NCI 模型,然后更新候選集不重新訓(xùn)練模型,測試在不同查詢集上的表現(xiàn),發(fā)現(xiàn)候選集擴充后召回率下降。

總結(jié)一下生成式檢索和密集檢索的優(yōu)缺點。生成式檢索的本質(zhì)是記憶機制,是序列化生成筆記 ID,自回歸解碼范式導(dǎo)致時間和計算開銷大,當(dāng)候選文檔多時代碼層數(shù)變多,對細粒度特征記憶不足,候選文檔庫變化時需要重新訓(xùn)練模型。但優(yōu)點是在解碼過程中實現(xiàn)了查詢和候選文檔的深交互,文檔有獨立 ID 且能利用大模型的理解能力。密集檢索本質(zhì)是向量匹配機制,優(yōu)點是較低的時延、可接受的計算開銷,能捕捉細粒度特征,文檔庫動態(tài)變化時可高效更新索引。但缺乏深交互,存在一對多的問題。

經(jīng)過分析得出結(jié)論,兩者可以很好地互相補充。

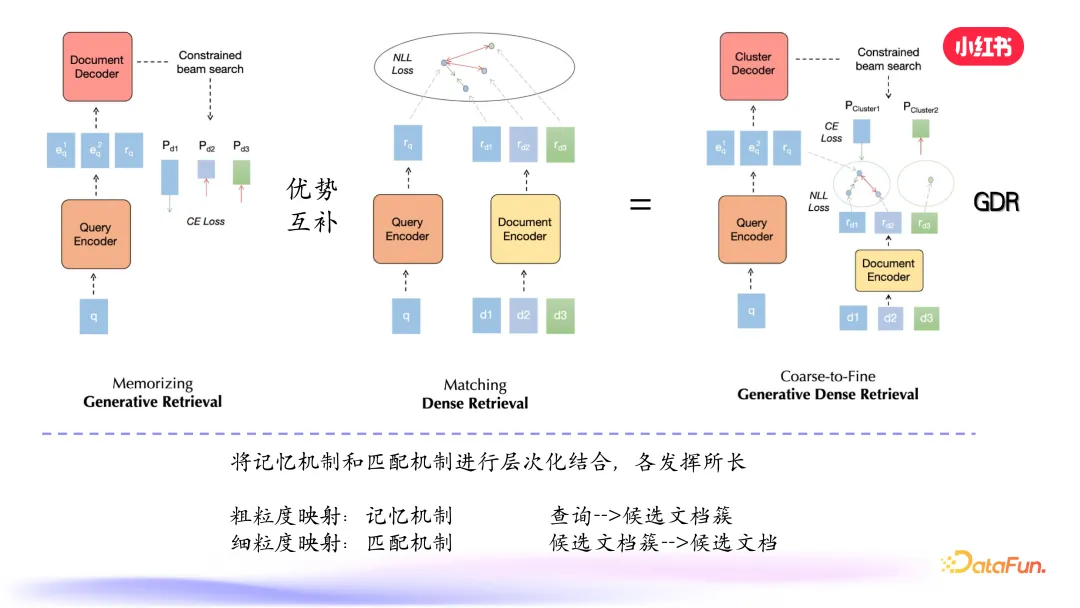

我們可以利用生成式檢索的記憶能力記住 high level 的語義類 ID,到細粒度的地方用密集檢索做匹配。具體而言,記憶機制主要用來記憶候選文檔簇,一旦選到簇這個粒度之后,就會使用匹配機制,在更少的候選文檔集合-簇里面做細粒度的匹配。

給定 query,編碼器先編碼出向量,進入解碼階段,首先對筆記進行向量表示和聚類,解碼層級樹的前面部分 high level 的 ID,得到候選文檔簇的概率。在粗粒度生成后,在相關(guān)的葉子節(jié)點內(nèi)進行細粒度的匹配,使用損失函數(shù)得到綜合分數(shù)得到最終結(jié)果。

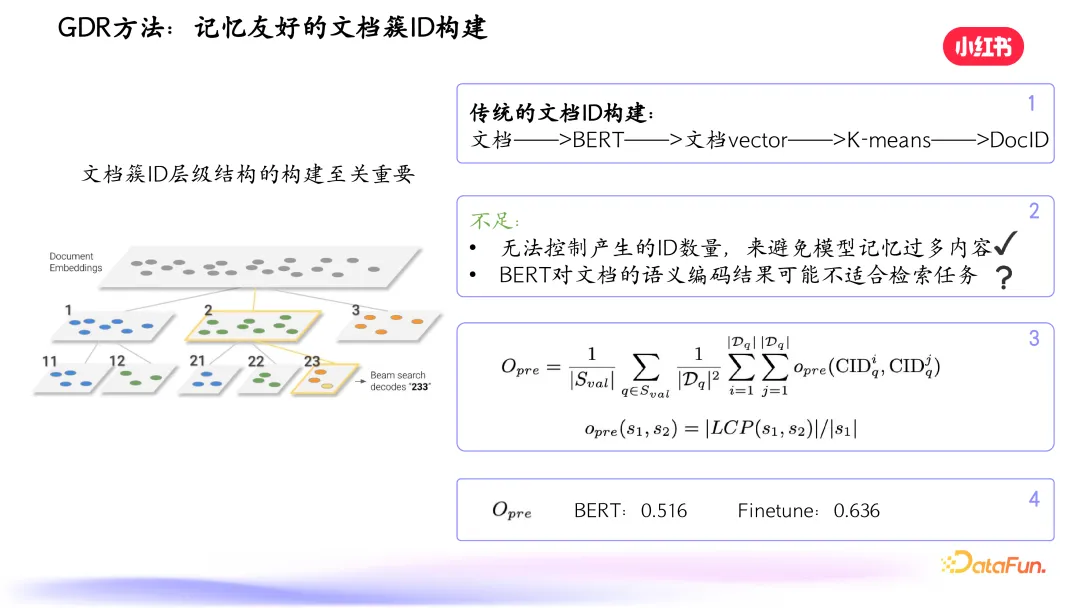

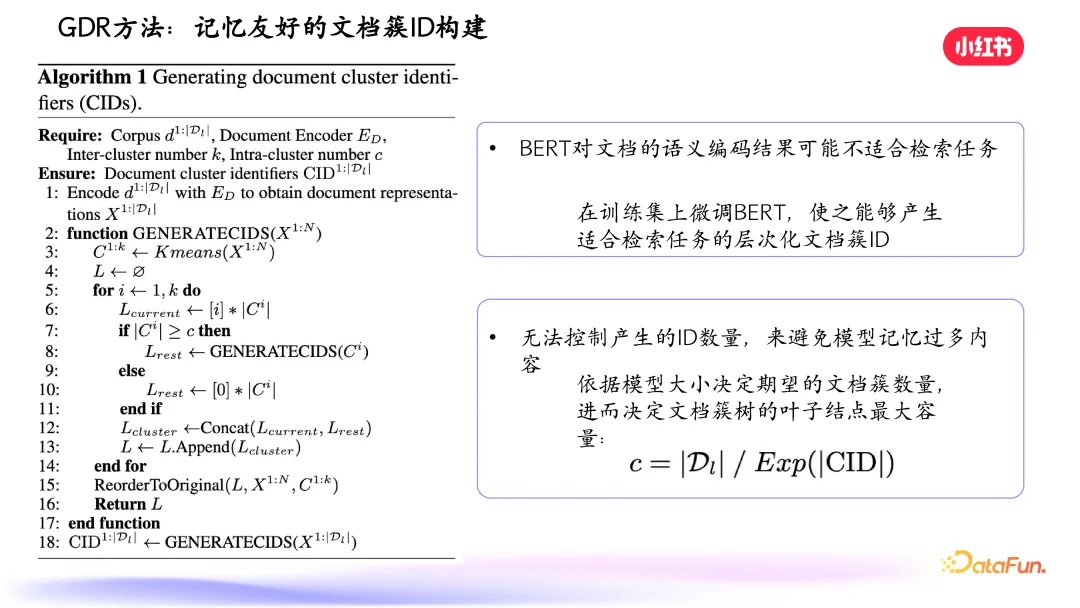

文檔簇 ID 層級結(jié)構(gòu)的構(gòu)建至關(guān)重要。傳統(tǒng)檢索表示到 doc ID 維度會有問題,一是文檔數(shù)量增加時模型參數(shù)量也要增加,否則召回性能下降;二是目前文檔表示不一定有助于構(gòu)建層級文檔簇 ID。我們做了分析,如上圖中的公式,先用 Bert 對文檔進行向量表示得到一個樹,再以我們的方式,用雙塔模型進行密集檢索訓(xùn)練,用文檔的 encoder 生成向量,構(gòu)建一個樹,這樣得到兩個樹。在兩個樹里,分別對正確文檔的 ID 計算出最大公共子序列,最前面的最大公共子序列應(yīng)盡量一致,越一致,模型記憶的負荷越小。因此我們希望構(gòu)建易于記憶的文檔簇,減少模型記憶負荷。

我們還設(shè)計了約束,根據(jù)模型大小控制文檔簇數(shù)量,每個葉子節(jié)點包含一定數(shù)量的文檔,留下部分通過細粒度匹配機制去匹配。

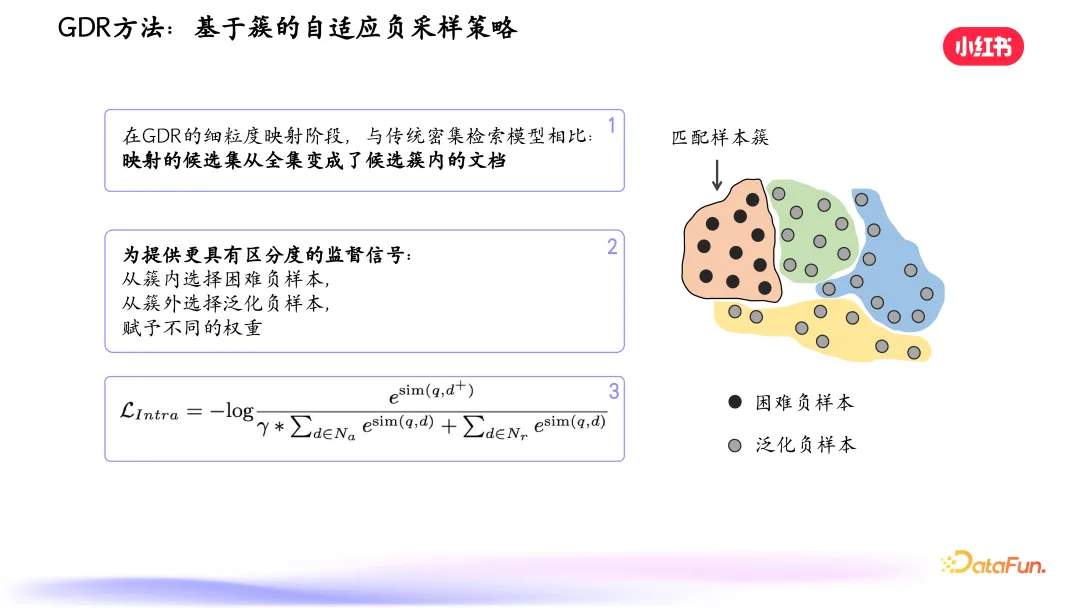

另外一個特別的設(shè)計是基于簇的自適應(yīng)負采樣策略,在細粒度匹配階段挑選正負樣例,讓匹配機制更有針對性。

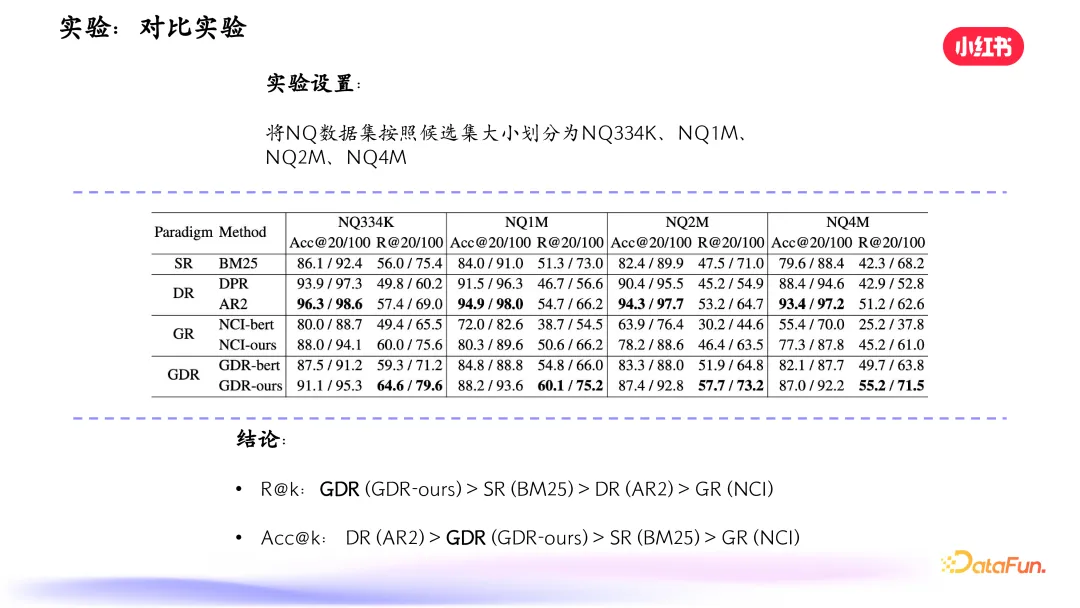

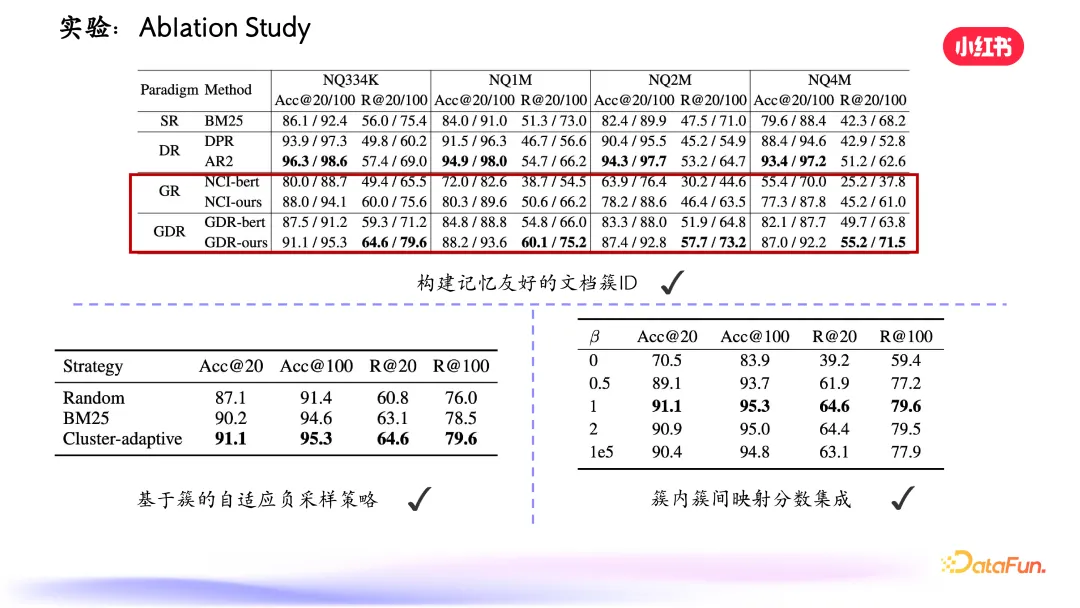

實驗結(jié)果表明,我們提出的 GDR(生成式密集檢索)在召回指標(biāo)方面是最優(yōu)的,準(zhǔn)確性方面 DR 是最好的,GDR 次之。

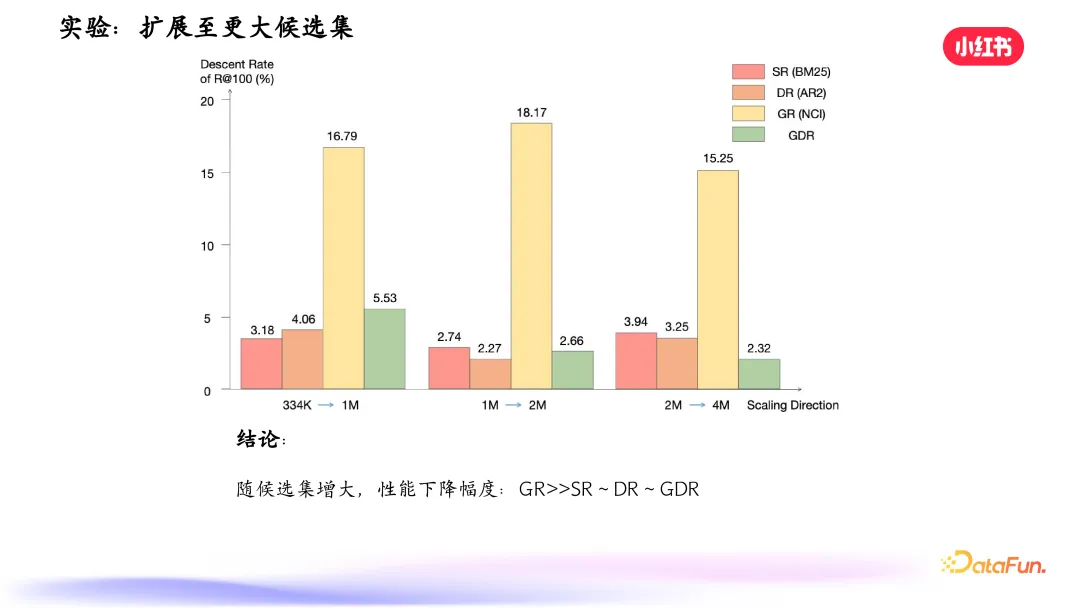

擴展至更大候選集,傳統(tǒng)生成式檢索方法效果下降明顯,其他三種方式下降不明顯。

關(guān)于文檔更新,可以看到,相比于傳統(tǒng)方式,GDR 效果下降的幅度很小。檢索效率方面,包括時延、吞吐量,相比 BM25、AR2 有顯著提升,這也是需要繼續(xù)優(yōu)化的一個方向。

我們還做了消融實驗,驗證了構(gòu)建記憶友好的文檔簇 ID 和自適應(yīng)負采樣策略的有效性,以及超參數(shù)的泛化性。

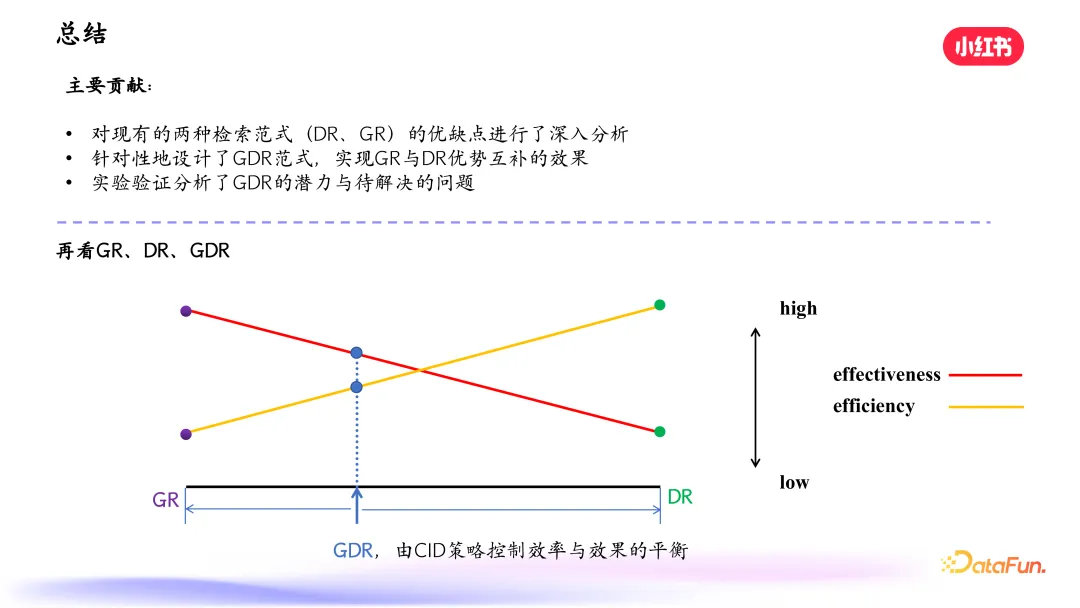

最后總結(jié)一下該工作的主要貢獻。首先我們對現(xiàn)有的兩種檢索范式,即 DR 和 GR 進行了深入分析,然后針對性地設(shè)計了新的 GDR 范式,實現(xiàn)了 GR 和 DR 的優(yōu)勢互補,為生成式檢索落地提供了有力支持。我們通過實驗分析了 GDR 的潛力和問題,并指出可能的解決方向。

上圖下半部分顯示了 GR、DR 和 GDR 在效率和效果上的表現(xiàn),可以看到,GR 的效率較低,但其召回效果是非常優(yōu)秀的;DR 的效率很高,但效果較弱;而我們的 GDR 的方式,則在效率和效果上進行了平衡。

四、GDR:應(yīng)用場景

接下來介紹一些 GDR 落地的場景。

1. 在線流式筆記召回

通常在召回階段可以默認觸發(fā) DR 密集檢索的過程,與此同時并行地調(diào)用 GDR 和 LLM 檢索,從而在利用 GDR 和 LLM 精準(zhǔn)的召回效果的同時,避免其高時延的問題。

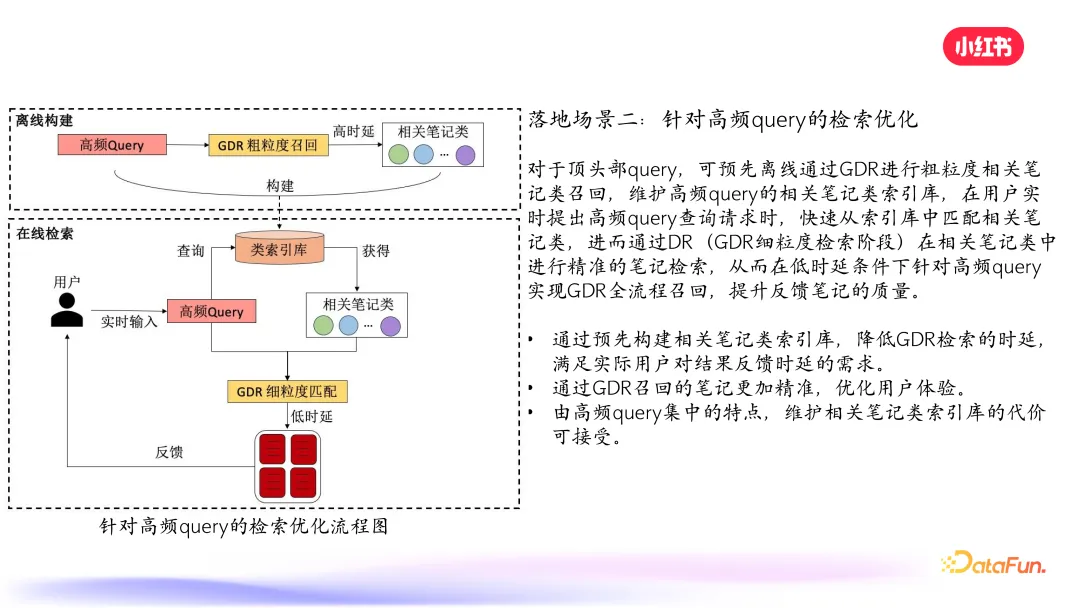

2. 針對高頻 query 的檢索優(yōu)化

對于 query,可以預(yù)先離線通過 GDR 進行粗粒度相關(guān)筆記類召回,維護高頻 query 的相關(guān)筆記類索引庫,之后再遇到該 query,即可快速匹配,進而通過 DR 在相關(guān)筆記類中進行精準(zhǔn)的筆記檢索。這樣不僅可以降低時延,還能提升召回準(zhǔn)確度。

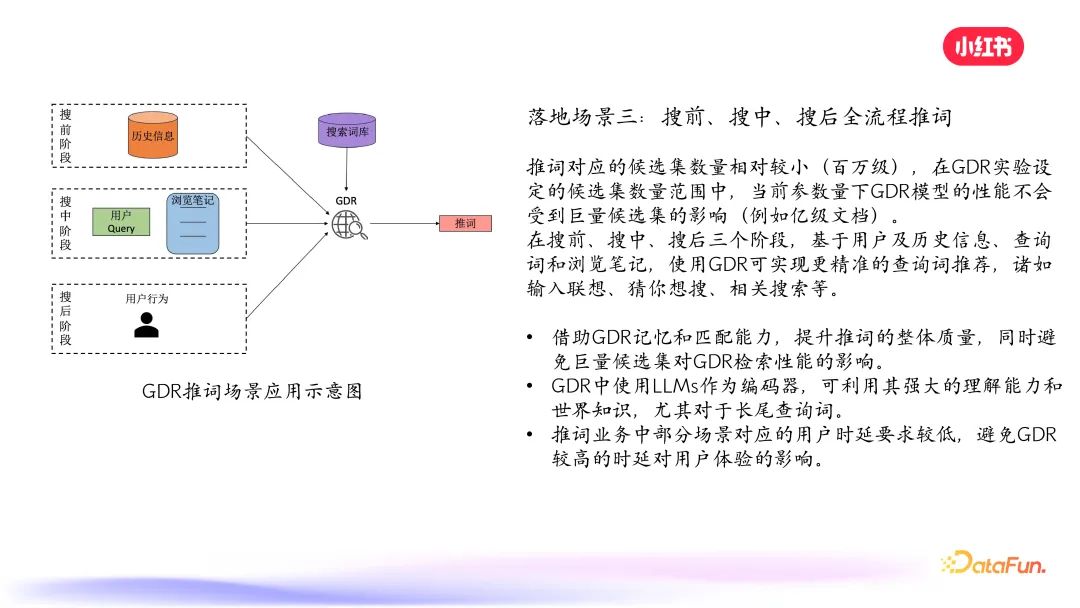

3. 搜前、搜中、搜后全流程推詞

推詞對應(yīng)的候選集數(shù)量相對較小(百萬級),在 GDR 實驗設(shè)定的候選集數(shù)量范圍中,當(dāng)前參數(shù)量下 GDR 模型的性能不會受到巨量候選集的影響(小紅書筆記庫在億級以上),其能力能夠充分發(fā)揮。另外,也可以對 query 編碼端使用 LLM,利用其強大的理解能力和世界知識,優(yōu)化查詢,尤其是長尾查詢。

4. 未來落地場景一:GDR+LLM

未來的落地場景之一是將 LLM 應(yīng)用在 GDR 中。不僅可以提升對 query 的理解能力,同時提升檢索性能。

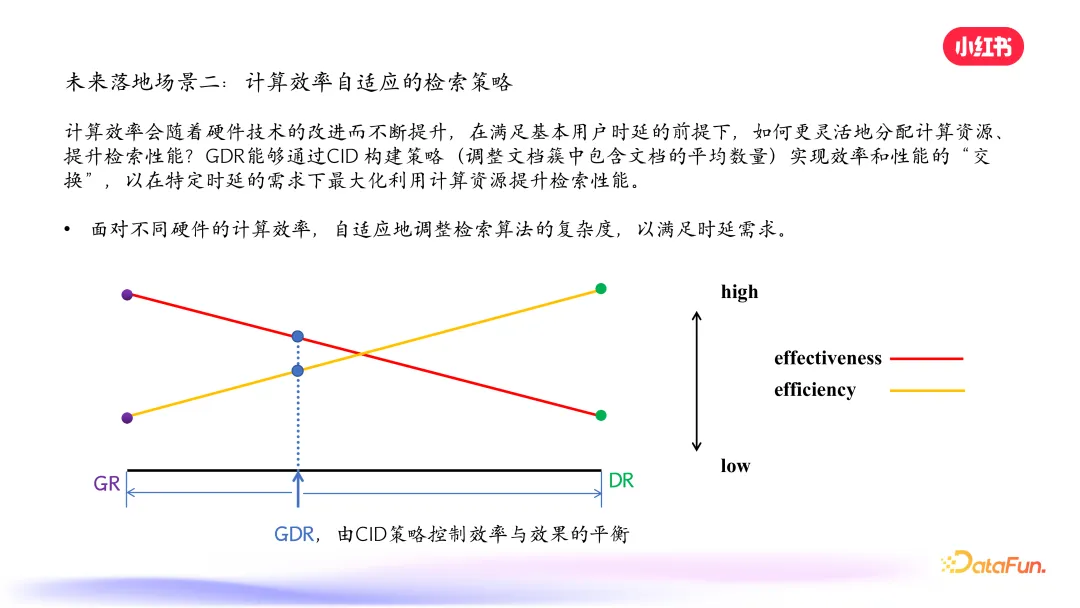

5. 未來落地場景二:計算效率自適應(yīng)的檢索策略

計算效率會隨著硬件技術(shù)的改進而不斷提升,在滿足基本用戶時延的前提下,實現(xiàn)更靈活的資源分配,提升檢索性能。

以上就是本次分享的內(nèi)容,謝謝大家。

五、問答環(huán)節(jié)

Q1:如何解決層次聚類,即層次化 ID 不穩(wěn)定導(dǎo)致 GR 模型需要重新訓(xùn)練的問題?

A1:GDR 可以避免這個問題,在細粒度階段使用匹配機制,文檔變化可放到相近葉子節(jié)點,不需要重新訓(xùn)練記憶模塊。

Q2:生成式檢索對于新文檔加入之后的處理流程是怎么樣?如何應(yīng)對 ID 快速增量更新的問題?

A2:一部分新文檔可直接加入葉子節(jié)點,長周期內(nèi)新文檔足夠多時可對記憶模塊進行周級或月級更新,避免頻繁更新記憶模塊。

Q3:從現(xiàn)在只從文本信息中獲得 ID,是否會導(dǎo)致傳統(tǒng)模型中協(xié)同信息的缺失?

A3:會缺失,可以在解碼文檔 ID 階段加入用戶行為,讓模型有一定概率選擇真實筆記 ID 和探索別的,loss 上也可引入歷史行為特征。

Q4:從 1 到 6 的錯誤率不是應(yīng)該累計增加嗎?為啥第六個的錯誤率會降低?

A4:對于 AR2 這種向量檢索,訓(xùn)練過程沒有學(xué)習(xí)更高維向量的匹配,只算最后一個錯誤率低是因為其與細粒度筆記向量匹配更好,中間幾層沒有學(xué)習(xí)。

Q5:GR 里去記憶 ID 不就拋棄了大模型的優(yōu)勢嗎?

A5:沒有拋棄,query 的編碼用大模型對長尾 query 理解能力更強,可減少對每篇筆記生成大量 query 的需求,能用到大模型的能力。

Q6:層次數(shù)設(shè)置是幾層?每層多少個簇?一個文檔可能屬于多個簇嘛?

A6:模型大小決定簇的數(shù)量,超參設(shè)置每一層最多生成 10 個簇。目前一個文檔屬于一個簇,但在框架下允許一個文檔屬于多個簇,類似密集檢索中一個文檔有多個向量表示。

Q7:論文中講的這些東西在現(xiàn)實的生產(chǎn)環(huán)境中有沒有落地?

A7:已經(jīng)在推動落地,在召回環(huán)節(jié)作為另一個通道,尤其是推詞階段更適合落地。

Q8:真實場景下如何應(yīng)對一個更新周期內(nèi)里從零開始突然爆發(fā)式增長的某一類筆記?

A8:可以馬上啟動整個筆記的訓(xùn)練,或?qū)@一類筆記再做細致聚類,產(chǎn)生更多層級的表示。在框架下也可靈活更新 DR,對突然增長的一類筆記進行針對性學(xué)習(xí)。