Evaluation is All You Need!首個開源多模態大模型通用評測器LLaVA-Critic

作者介紹:本文作者來自于字節跳動和馬里蘭大學。其中第一作者為馬里蘭大學博士生熊天翼,主要研究領域為計算機視覺,多模態基礎大模型;通訊作者為 Chunyuan Li (https://chunyuan.li/)。

本文作者也包括馬里蘭大學博士生王璽堯,字節跳動研究員 Dong Guo、Qinghao Ye、Haoqi Fan、Quanquan Gu, 馬里蘭大學教授 Heng Huang。

引言:Evaluation is All You Need

隨著對現有互聯網數據的預訓練逐漸成熟,研究的探索空間正由預訓練轉向后期訓練(Post-training),OpenAI o1 的發布正彰顯了這一點。

而 Post-training 的核心在于評測(Evaluation)。可靠的 AI 評測不僅能在復雜任務的評測中提供可擴展的解決方案,減少人工勞動,還能在強化學習中生成有效的獎勵信號并指導推理過程。

例如,一個 AI 評測器可以遵循用戶設計的評分標準,在視覺對話任務中為不同模型的回復(model response)提供 1 到 10 的評分。除了評分外,它還會提供相應的給分理由,確保模型性能評測的透明性和一致性。

來自字節跳動和馬里蘭大學的研究團隊發布了首個用于多任務評測的開源多模態大模型 LLaVA-Critic,旨在啟發社區開發通用大模型評測器(generalist evaluator)。

- 論文標題:LLaVA-Critic: Learning to Evaluate Multimodal Models

- 論文鏈接:https://arxiv.org/abs/2410.02712

- 項目主頁:https://llava-vl.github.io/blog/2024-10-03-llava-critic/

- 數據與模型開源:https://huggingface.co/collections/lmms-lab/llava-critic-66fe3ef8c6e586d8435b4af8

首先,該團隊構建了一個涵蓋了多樣化評測場景和評分標準的評測指令遵循數據集(critic instruction-following dataset);之后,在這一數據集上訓練 LLaVA-Critic,使之學會對模型回復給出合理評分(judgement)和打分依據(reason);更進一步,在多模態評測(LMM-as-a-Judge)和偏好學習(preference learning)兩個場景中驗證了 LLaVA-Critic 的有效性。

評測指令遵循數據集

該團隊首先構建了一個高質量的評測指令遵循數據集,旨在涵蓋多個復雜的評測場景,根據對應的評測提示給出相應的打分和評分理由。

論文中將使用 AI 模型(如 GPT)作為評測器的開放式多模態評測任務分為兩類:

1. 單點評分(pointwise-scoring):根據評測提示,對單個模型回復進行打分。

2. 成對排序(pairwise-ranking):對于兩個(一對)模型回復,給出二者之間的偏序關系或宣布平局。

LLaVA-Critic-113k 主要包含單點評分和成對排序兩種評測設定。在兩種評測中,LLaVA-Critic 均需要根據給定的圖片、問題、模型回復以及評測提示中給定的評分要求,對模型回復打分并給出理由。

針對單點評分,該團隊從 8 個多模態數據集中收集了輸入指令(圖片 - 問題),使用 13 個 LMM 生成模型回復,并匯集了 7 個常用開放式評測基準中的評測提示,由此整理得到評測樣本。針對于每一條評測樣本,再詢問 GPT-4o 進行評測,得到判斷得分與理由。

針對成對排序,該團隊收集了三個偏好數據集中的模型回復,這些數據中已經包含了人類或 GPT-4V 的偏好排序結果。之后,將每一對模型回復和已知的偏序關系輸入給 GPT-4o,獲取其對偏序關系的解釋。

在此基礎上,他們設計了 30 個包含不同格式與評分標準的評測提示模板,將【圖片 - 問題輸入,兩個模型回復,偏序關系,解釋】打包成涵蓋多種評測場景的評測指令遵循數據。

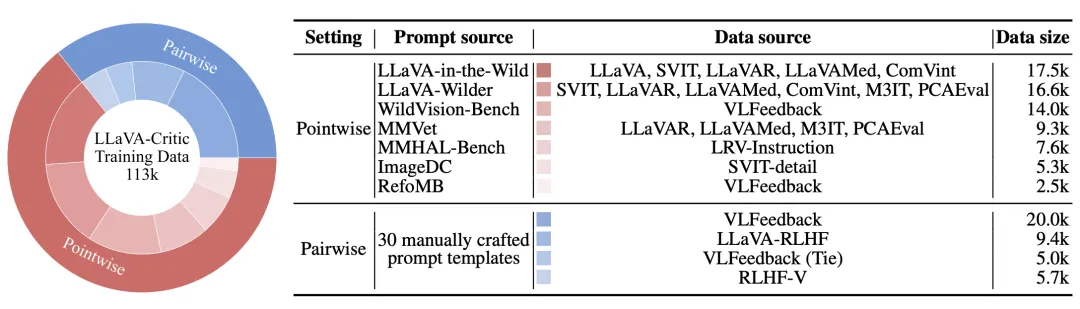

由此,LLaVA-Critic-113k 數據集得以構建,共計包含 46k 張圖片和 113k 個評測數據樣本。下圖展示了具體的數據統計:

LLaVA-Critic-113k 數據集的數據統計。該團隊收集了廣泛的輸入指令與模型回復,涵蓋了多個評測任務和領域。需要注意的是,以上全部數據來源于開源的指令遵循訓練數據,與實際的評測基準(evaluation benchmark)沒有重合。

LLaVA-Critic

首個具有通用評測能力的開源多模態大模型

為了使模型具備通用的評測能力,該團隊對一個已經具備強大指令遵循能力的預訓練多模態大模型進行指令微調。這一點非常關鍵,因為模型自身能高質量處理復雜視覺任務是其具備評測能力的基礎;而評測能力則在此之上,作為附加的判別能力得到進一步開發。

在訓練中,LLaVA-Critic 會接受一個評測提示(evaluation prompt),包含多模態指令輸入、模型回復及可選的參考回復。它會根據評測提示中的評分標準,預測定量分數或成對排序,并給出詳細的理由。

該團隊對評測結果(分數或偏序關系)和理由同時應用交叉熵損失進行訓練。實驗中,他們從 LLaVA-OneVision (OV) 7B/72B 預訓練模型開始,使用 LLaVA-Critic-113k 數據集進行 1 輪微調,得到 LLaVA-Critic 模型。

場景一:多模態大模型作為評測器(LMM-as-a-Judge)

該團隊首先對 LLaVA-Critic 模型在多個多模態評測任務中與 GPT-4o 以及人類的打分一致性進行了驗證。

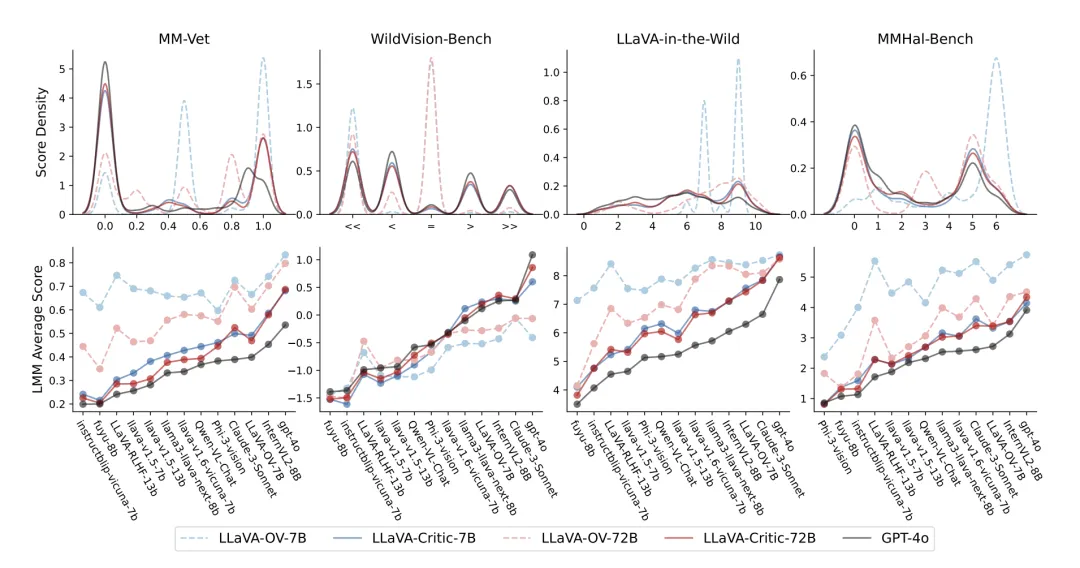

在評分的整體分布和對回復模型 (response model) 的排序層面上,LLaVA-Critic 均展現了與 GPT-4o 的一致性

如上圖所示,在單點評分的評估任務中,LLaVA-Critic 大幅超越其基礎模型 LLaVA-OneVision—— 在多個開放式問答評估基準上,其評分一致性和模型排序與 GPT-4o 高度吻合。

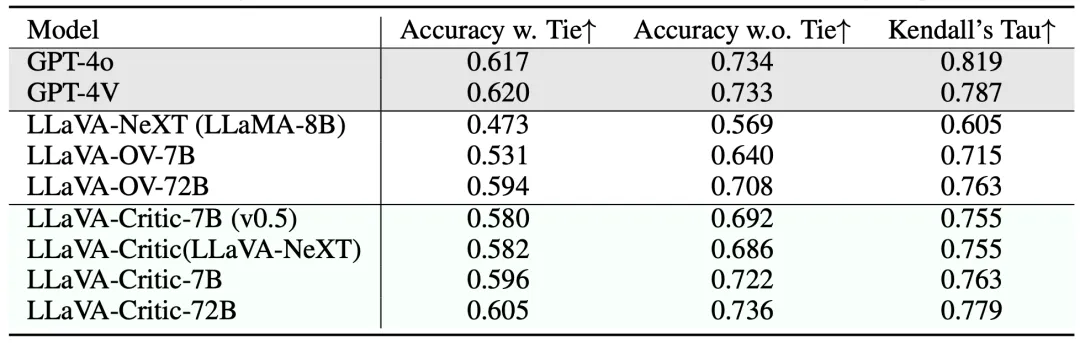

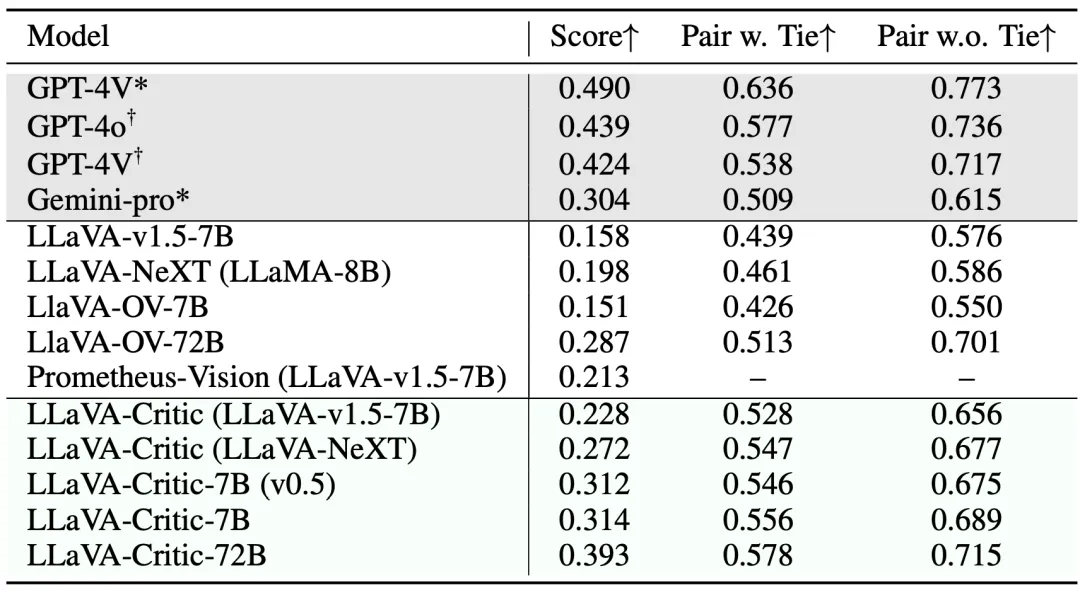

上表比較了不同評測器在成對排序方面與人類偏好的一致性。LLaVA-Critic-72B 在評測準確率(不包含平局)方面達到了 73.6%,已經超越了 GPT-4V/4o;在其余兩個指標中也與商用的 GPT 模型差異很小。

盡管 LLaVA-Critic-7B 的模型參數大幅減少,但其在包含與不包含平局的評測準確率上仍分別達到了 59.6% 和 72.2%。這為在資源受限的環境中部署 LLaVA-Critic 提供了可行的解決方案。

上表展示了 LLaVA-Critic 在 MLLM-as-a-Judge 基準測試中的表現,該測試包括了訓練數據中未見過的更廣泛評測場景。面對全新的評測任務,LLaVA-Critic 也顯著縮小了開源模型與 GPT-4o/4V 在評測準確性上的差距,充分展現其泛化性與通用性。

在上述實驗結果中,72B 模型的表現優于 7B 模型,Critic-7B 的表現也優于使用弱化版本評測數據訓練的 Critic-7B(v0.5)—— 這進一步強調了模型擴展(model scaling)和數據擴展(data scaling)在構建通用評測器中的重要性。

在這個成對排序示例中,LLaVA-Critic 能夠準確識別輸入圖像的內容(手寫數字 「7」),并基于回復間的差異做出判斷,給出了和人類評估者一致的排序,并提供了清晰的理由說明。后者(評分理由)對于構建可靠人工智能至關重要,它使 LLaVA-Critic 的評測過程更透明,評測結果更可信。

場景二:偏好學習(Preference Learning)

LLaVA-Critic 的評測能力也可用于比較成對模型回復的好壞,從而作為獎勵信號應用于 RLHF 和 DPO 等強化學習算法。實驗中,該團隊將 LLaVA-Critic 用于迭代直接偏好優化( iterative DPO)算法,具體方式如下:

給定一個預訓練 LMM 和一組圖片 - 問題輸入,首先讓 LMM 對每一個圖片 - 問題輸入隨機生成 K=5 個候選回復,由此構建出 Kx (K-1)=20 個成對回復。

接著,使用 LLaVA-Critic 對這 20 個回復對進行成對排序,選出最好和最壞的回復,形成成對的反饋數據集。

之后,使用這一數據集對于預訓練 LMM 進行直接偏好優化(DPO)訓練。

在此基礎上,漸進式迭代這一過程共計 M 輪,每次使用最新訓練的模型生成候選回復,最終得到與 LLaVA-Critic 反饋對齊的模型。

該團隊采用 LLaVA-OneVision 作為初始 LMM,進行 3 輪 iterative DPO 訓練,最終將訓練后的模型命名為 LLaVA-OneVision-Chat。隨后,他們在多個開放式問答評測基準上測試了最終模型的表現,以比較 LLaVA-Critic 和其他獎勵模型的效果。

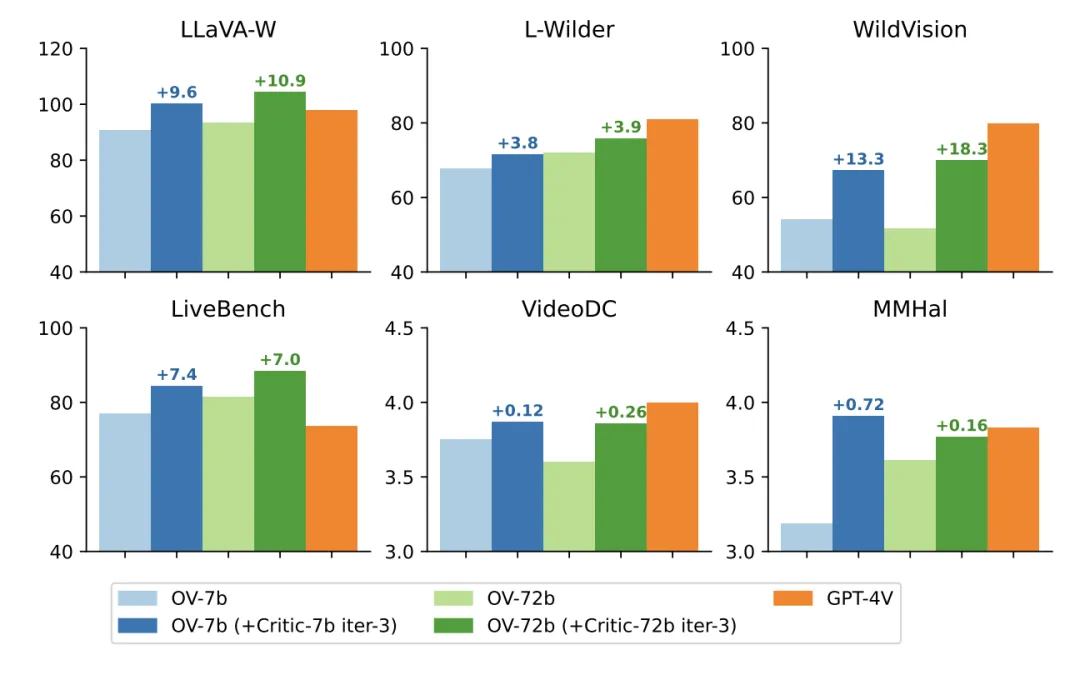

如上表所示,無論是在 7B 還是 72B 基礎模型上,LLaVA-Critic(AI 反饋)均超越了 LLaVA-RLHF (人類反饋),顯著提升了基礎模型在 6 個多模態開放式問答評測基準上的表現。

下方的柱狀圖進一步直觀展示了 LLaVA-Critic 的反饋對 LLaVA-OneVision 模型在視覺問答性能上的提升效果。可見,LLaVA-Critic 作為一種提供有效獎勵信號的可擴展方案,不僅減少了對昂貴人工反饋的依賴,還通過 AI 生成的反饋進一步優化了模型的偏好對齊效果。

結論

LLaVA-Critic 是首個通用的開源多模態大模型評測器,能夠在多個開放式多模態場景中評測模型表現。為實現這一目標,研究團隊精心構建了一個高質量的評測指令遵循數據集,涵蓋多樣化的評測任務與標準。

實驗中展示了 LLaVA-Critic 在兩個關鍵領域的有效性:

1. 作為通用的評測器,LLaVA-Critic 能夠為需要評測的模型回復提供單點評分和成對排序,這些評分和排序與人類和 GPT-4o 的偏好高度一致,為自動評測多模態大模型的開放式回復提供了一個可行的開源替代方案。

2. 在偏好學習方面,LLaVA-Critic 提供的偏好信號能有效提升多模態大模型的視覺對話能力,甚至超越了基于人類反饋的 LLaVA-RLHF 獎勵模型。

這項工作在利用開源多模態大模型自身的評價能力方面,邁出了重要的一步。我們期待更多的研究可以由此出發,通過探究更具可擴展性的,超越人類的對齊反饋機制,進一步推動多模態大模型的發展。