一塊顯卡理解一部電影,最新超長(zhǎng)視頻理解大模型出爐!“大海撈針”準(zhǔn)確率近95%,代碼已開源

僅需1塊80G顯卡,大模型理解小時(shí)級(jí)超長(zhǎng)視頻。

智源研究院聯(lián)合上海交通大學(xué)、中國(guó)人民大學(xué)、北京大學(xué)和北京郵電大學(xué)等多所高校帶來最新成果超長(zhǎng)視頻理解大模型Video-XL。

它借助語(yǔ)言模型(LLM)的原生能力對(duì)長(zhǎng)視覺序列進(jìn)行壓縮,不僅保留了短視頻理解的能力,而且在長(zhǎng)視頻理解上展現(xiàn)了出色的泛化能力。

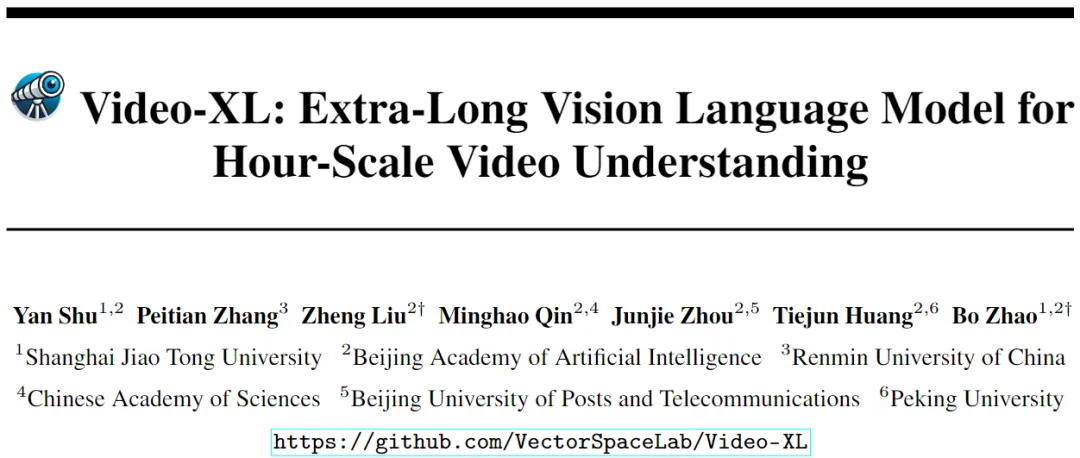

相較于同等參數(shù)規(guī)模的模型,Video-XL在多個(gè)主流長(zhǎng)視頻理解基準(zhǔn)評(píng)測(cè)的多項(xiàng)任務(wù)中排名第一。

而且在效率與性能之間實(shí)現(xiàn)了良好的平衡,僅需一塊80G顯存的顯卡即可處理2048幀輸入(對(duì)小時(shí)級(jí)長(zhǎng)度視頻采樣),并在視頻“海中撈針”任務(wù)中取得了接近95%的準(zhǔn)確率。

△圖一:不同長(zhǎng)視頻模型在單塊80G顯卡上支持的最大幀數(shù)及在Video-MME上的表現(xiàn)

要知道,長(zhǎng)視頻理解是多模態(tài)大模型的核心能力之一,也是邁向通用人工智能(AGI)的關(guān)鍵一步。

然而,現(xiàn)有的多模態(tài)大模型在處理10分鐘以上的超長(zhǎng)視頻時(shí),仍然面臨性能差和效率低的雙重挑戰(zhàn)。

Video-XL正是為此而來,模型代碼均已開源。

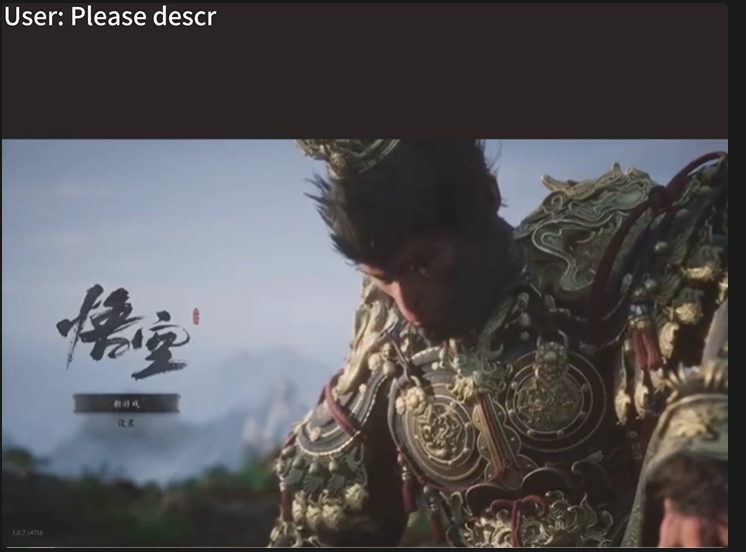

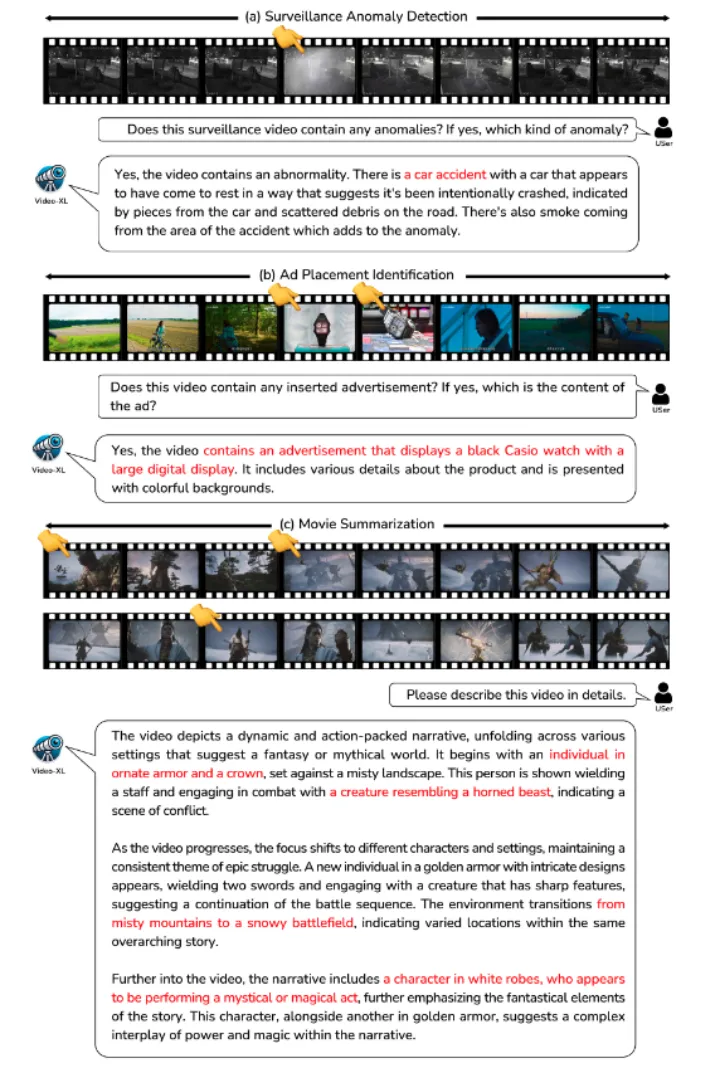

僅需幾秒鐘,VideoXL便可以準(zhǔn)確檢索長(zhǎng)視頻中植入的廣告內(nèi)容(https://github.com/VectorSpaceLab/Video-XL/tree/main/examples),也可以像人類一樣準(zhǔn)確理解電影中發(fā)生的主要事件。本視頻僅用于學(xué)術(shù)研究,如有問題,請(qǐng)隨時(shí)聯(lián)系。

未來,它有望在電影摘要、視頻異常檢測(cè)、廣告植入檢測(cè)等應(yīng)用場(chǎng)景中展現(xiàn)出廣泛的應(yīng)用價(jià)值,成為得力的長(zhǎng)視頻理解助手。

超長(zhǎng)視頻理解難平衡性能和效率

使用MLLM進(jìn)行長(zhǎng)視頻理解具有極大的研究和應(yīng)用前景。然而,當(dāng)前的視頻理解模型往往只能處理較短的視頻,無法處理十分鐘以上的視頻。

盡管最近研究社區(qū)出現(xiàn)了一些長(zhǎng)視頻理解模型,但這些工作主要存在以下問題:

壓縮視覺token帶來的信息損失:為了使語(yǔ)言模型的固定窗口長(zhǎng)度適應(yīng)長(zhǎng)視頻帶來的大量視覺token,眾多方法嘗試設(shè)計(jì)機(jī)制對(duì)視覺token進(jìn)行壓縮,例如LLaMA-VID主要降低token的數(shù)量,而MovieChat, MALMM則設(shè)計(jì)memory模塊對(duì)幀信息進(jìn)行壓縮。然而,壓縮視覺信息不可避免帶來信息的損失和性能降低。

性能和效率的不平衡:相關(guān)工作LongVA嘗試finetune語(yǔ)言模型擴(kuò)大其上下文窗口,并成功將短視頻理解能力泛化到了長(zhǎng)視頻上。LongVila優(yōu)化了長(zhǎng)視頻訓(xùn)練的開銷,提出了高效訓(xùn)練長(zhǎng)視頻訓(xùn)練的范式。然而,這些工作并未考慮推理時(shí)視頻幀數(shù)增加帶來的計(jì)算開銷。

建立統(tǒng)一視覺編碼機(jī)制

模型結(jié)構(gòu)

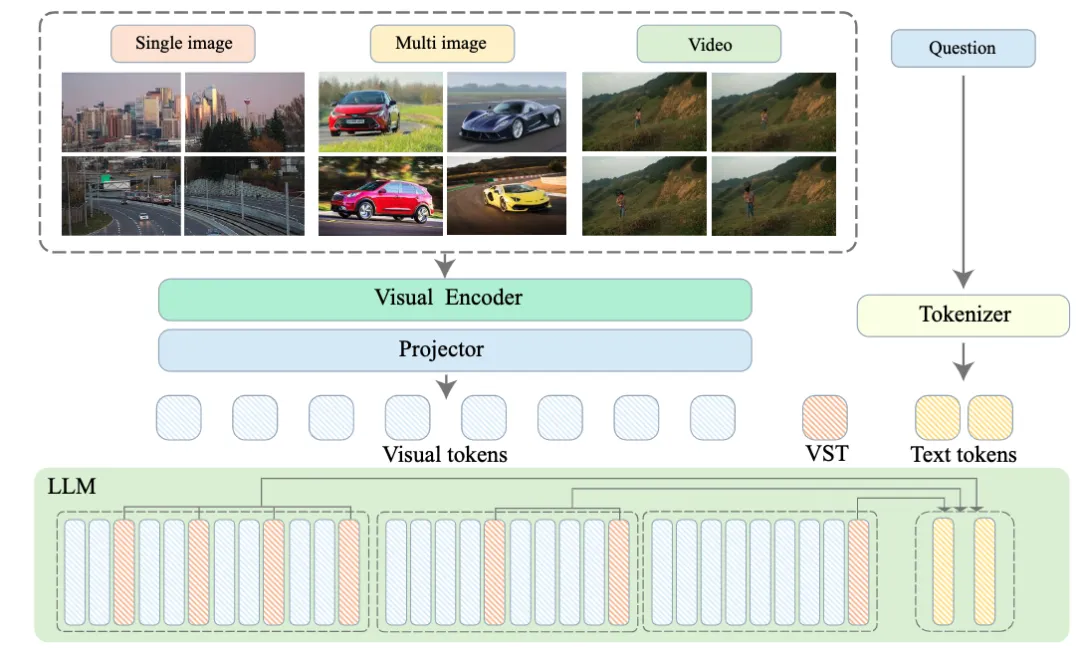

△圖二:Video-XL模型結(jié)構(gòu)圖

如圖二所示,Video-XL的整體模型結(jié)構(gòu)和主流的MLLMs結(jié)構(gòu)相似,由視覺編碼器(CLIP), 視覺-語(yǔ)言映射器(2-layer MLP)以及語(yǔ)言模型(Qwen-7B)構(gòu)成。

特別之處在于,為了處理各種格式的多模態(tài)數(shù)據(jù)(單圖,多圖和視頻),Video-XL建立了一個(gè)統(tǒng)一的視覺編碼機(jī)制。

針對(duì)多圖和視頻數(shù)據(jù),將每幀分別輸入CLIP;針對(duì)單圖,將其劃分為多個(gè)圖像塊,并將圖像塊輸入CLIP進(jìn)行編碼。因此,一個(gè)N幀的視頻或者一個(gè)N圖像塊的圖片都將統(tǒng)一標(biāo)記成 N × M 視覺tokens。

視覺上下文隱空間壓縮

相比于以往長(zhǎng)視頻模型直接對(duì)視覺token壓縮,Video-XL嘗試?yán)谜Z(yǔ)言模型對(duì)上下文的建模能力對(duì)長(zhǎng)視覺序列進(jìn)行無損壓縮。對(duì)于視覺語(yǔ)言連接器輸出的視覺信號(hào)序列:

其中n為視覺token的數(shù)量。Video-XL的目標(biāo)在于將X壓縮成更為緊湊的視覺表示C (|C| < |X|)。在下文中將詳細(xì)介紹視覺上下文隱空間壓縮的原理。

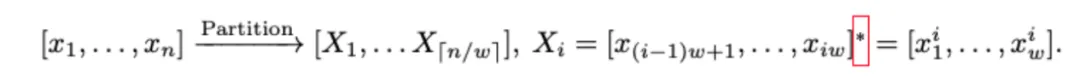

受到Activation Beacon的啟發(fā),Video-XL引入了一種新的特殊標(biāo)記,稱為視覺摘要標(biāo)記(VST),記為。基于此可以將視覺信號(hào)的隱層特征壓縮到VST在LLM中的激活表示中(每層的Key和Value值)。具體而言,首先將視覺信號(hào)序列X分成大小為w的窗口(默認(rèn)每個(gè)窗口長(zhǎng)度為1440):

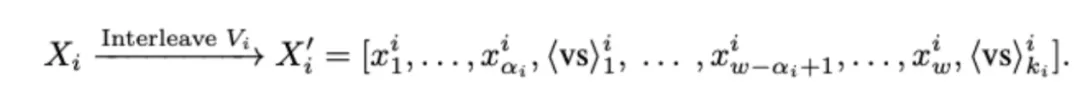

接著,對(duì)每個(gè)窗口首先確定壓縮比,并插入一組VST標(biāo)記,以交替的方式在視覺標(biāo)記序列中插入。在該過程中,視覺token表示的變化可以由以下公式表達(dá):

LLM將逐個(gè)處理每個(gè)窗口進(jìn)行編碼,并使用額外的投影矩陣在每層自注意力模塊中處理VST的隱藏值。編碼完成后,普通視覺標(biāo)記的激活值被丟棄,而VST的激活值被保留并累積,作為處理后續(xù)窗口時(shí)的視覺信號(hào)代理。

模型訓(xùn)練方式

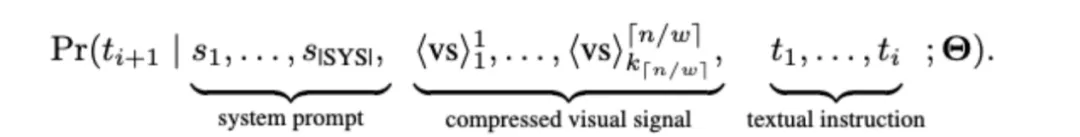

Video-XL通過優(yōu)化在壓縮視覺信號(hào)下的生成質(zhì)量來進(jìn)行訓(xùn)練。下一個(gè)Token的預(yù)測(cè)通過以下公式進(jìn)行計(jì)算:

其中,θ代表模型所有優(yōu)化的參數(shù),包含語(yǔ)言模型,視覺編碼器、視覺語(yǔ)言連接器、VST的投影矩陣,以及VST的token embedding。模型通過最小化標(biāo)準(zhǔn)的自回歸損失進(jìn)行訓(xùn)練,訓(xùn)練過程中不計(jì)算VST標(biāo)記的損失(其標(biāo)簽設(shè)為-100),因?yàn)樗鼈儍H用于壓縮。同時(shí),為了靈活支持不同的壓縮粒度,訓(xùn)練時(shí)每個(gè)窗口的壓縮比會(huì)從{2,4,8,12,16}中隨機(jī)抽取。在推理時(shí),可以根據(jù)具體的效率需求選擇一個(gè)壓縮比并應(yīng)用于所有窗口。

其中,θ代表模型所有優(yōu)化的參數(shù),包含語(yǔ)言模型,視覺編碼器、視覺語(yǔ)言連接器、VST的投影矩陣,以及VST的token embedding。模型通過最小化標(biāo)準(zhǔn)的自回歸損失進(jìn)行訓(xùn)練,訓(xùn)練過程中不計(jì)算VST標(biāo)記的損失(其標(biāo)簽設(shè)為-100),因?yàn)樗鼈儍H用于壓縮。同時(shí),為了靈活支持不同的壓縮粒度,訓(xùn)練時(shí)每個(gè)窗口的壓縮比會(huì)從{2,4,8,12,16}中隨機(jī)抽取。在推理時(shí),可以根據(jù)具體的效率需求選擇一個(gè)壓縮比并應(yīng)用于所有窗口。

模型訓(xùn)練數(shù)據(jù)

在預(yù)訓(xùn)練階段,Video-XL使用Laion-2M數(shù)據(jù)集優(yōu)化視覺語(yǔ)言連接器。在微調(diào)階段,Video-XL充分利用了MLLM在各種多模態(tài)數(shù)據(jù)集上的能力。對(duì)于單圖像數(shù)據(jù),使用了Bunny 695k和Sharegpt-4o的57k張圖片。對(duì)于多圖像數(shù)據(jù),使用了從MMDU提取的5k個(gè)數(shù)據(jù)。對(duì)于視頻數(shù)據(jù),收集了不同時(shí)長(zhǎng)的視頻樣本,包括來自NExT-QA的32k樣本,Sharegpt-4o的2k視頻樣本,CinePile的10k樣本以及11k個(gè)帶有GPT-4V視頻字幕注釋的私有數(shù)據(jù)。

為了增強(qiáng)長(zhǎng)視頻理解能力并釋放視覺壓縮機(jī)制的潛力,本工作開發(fā)了一個(gè)自動(dòng)化的長(zhǎng)視頻數(shù)據(jù)生產(chǎn)流程,并創(chuàng)建了一個(gè)高質(zhì)量數(shù)據(jù)集——視覺線索順序數(shù)據(jù)(VICO)。該流程首先從CinePile數(shù)據(jù)或YouTube等視頻平臺(tái)獲取長(zhǎng)視頻,涵蓋電影、紀(jì)錄片、游戲、體育等開放領(lǐng)域的內(nèi)容。每個(gè)長(zhǎng)視頻被分割成14秒的片段。對(duì)于每個(gè)片段,本工作使用VILA-1.5 40B模型生成詳細(xì)描述。這些描述包括動(dòng)作序列和關(guān)鍵事件,基于這些字幕,本工作利用ChatGPT將線索按時(shí)間順序排列。VICO數(shù)據(jù)集通過要求模型檢索關(guān)鍵幀并檢測(cè)時(shí)間變化,提升其長(zhǎng)視頻理解能力。

單項(xiàng)任務(wù)超越GPT-4o

(一)評(píng)測(cè)基準(zhǔn)

Video-XL選用多個(gè)主流視頻理解評(píng)測(cè)基準(zhǔn),對(duì)于長(zhǎng)視頻理解任務(wù),評(píng)測(cè)了VNBench, LongVideoBench, MLVU和Video-MME;對(duì)于短視頻理解任務(wù),評(píng)測(cè)了MVBench和Next-QA。

(二)評(píng)測(cè)結(jié)果

1、長(zhǎng)視頻理解:

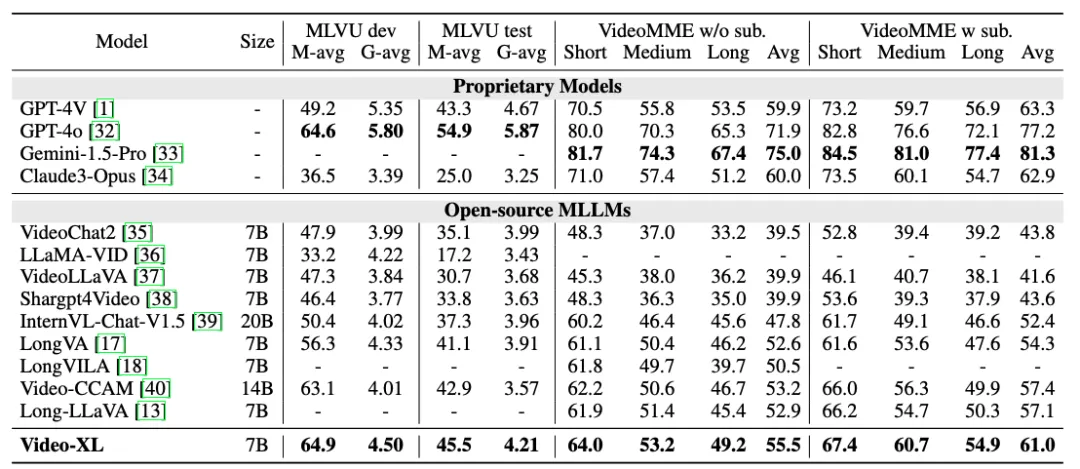

△表一 Video-XL在MLVU和VideoMME的性能

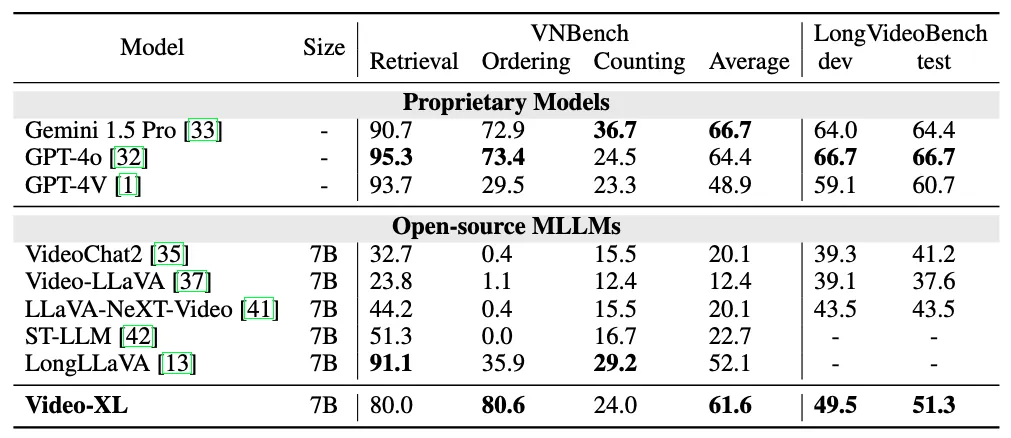

△表二 Video-XL在VNBench和LongVideoBench上的性能

如表一,表二所示Video-XL在多個(gè)主流的長(zhǎng)視頻評(píng)測(cè)基準(zhǔn)上展現(xiàn)了卓越性能。其中在VNBench上準(zhǔn)確率超過了目前最好的長(zhǎng)視頻模型大約10%。

在MLVU的驗(yàn)證集上,僅僅具有7B參數(shù)的Video-XL甚至在單項(xiàng)選擇任務(wù)上超越了GPT-4o模型。而在Video-MME和LongVideoBench等數(shù)據(jù)集上,Video-XL也在同等量級(jí)規(guī)模的長(zhǎng)視頻理解模型中排名第一。

2、超長(zhǎng)視頻理解:

Video-XL通過進(jìn)行了視頻“大海撈針”測(cè)試來評(píng)估其處理超長(zhǎng)上下文的能力。LLaVA-NexT-Video和LongLLaVA都采用了簡(jiǎn)單的位置信息外推算法,但在輸入更多上下文時(shí),仍然難以理解關(guān)鍵信息。

雖然LongVA通過微調(diào)LLM來處理更長(zhǎng)的輸入,但高昂的計(jì)算成本限制了其在單塊80G GPU上處理約400幀的能力。相比之下,Video-XL在相同硬件條件下,以16倍壓縮比和2048幀輸入,達(dá)到了近95%的準(zhǔn)確率。這表明,Video-XL在準(zhǔn)確性和計(jì)算效率之間實(shí)現(xiàn)了最佳平衡。

3、短視頻理解:

盡管Video-XL的設(shè)計(jì)主要面向長(zhǎng)視頻,但它保留了短視頻理解的能力。在MVBench和Next-QA任務(wù)評(píng)測(cè)中,Video-XL取得了和目前SOTA模型相當(dāng)?shù)男Ч?/p>

(三)消融實(shí)驗(yàn)

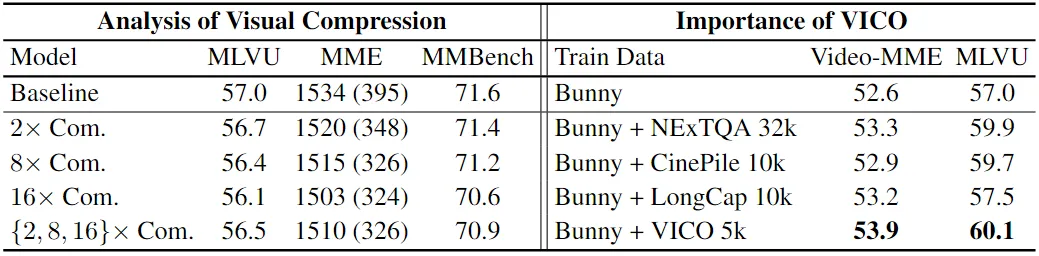

△表三 Video-XL的消融實(shí)驗(yàn)

Video-XL對(duì)所提出的視覺壓縮機(jī)制和VICO數(shù)據(jù)集進(jìn)行了消融實(shí)驗(yàn),如表三所示

1、視覺壓縮的有效性:

Video-XL使用Bunny 695k數(shù)據(jù)集訓(xùn)練了兩個(gè)模型:一個(gè)不使用壓縮,另一個(gè)使用隨機(jī)壓縮比(從{2, 8, 16}中選取)。對(duì)于壓縮模型,在視頻基準(zhǔn)MLVU和圖像基準(zhǔn)MME、MMBench上測(cè)試時(shí)應(yīng)用了不同的壓縮比。值得注意的是,即使使用16的壓縮比,壓縮模型在仍表現(xiàn)出較好的效果,接近甚至超越了基線模型。

2、VICO數(shù)據(jù)集的有效性:

Video-XL使用不同數(shù)據(jù)集訓(xùn)練了四個(gè)模型:(a) 僅使用Bunny 695k;(b) Bunny 695k結(jié)合NeXTQA 32k;(c) Bunny 695k結(jié)合CinePile 10k;(d) Bunny 695k結(jié)合長(zhǎng)視頻字幕5k;(e) Bunny 695k結(jié)合VICO 5k。值得注意的是,即使僅使用5k的VICO數(shù)據(jù),Video-XL也超過了使用NeXTQA 32k訓(xùn)練的模型。此外,主要事件/動(dòng)作排序任務(wù)比字幕生成任務(wù)帶來了更顯著的提升,因?yàn)樗偈鼓P蛷拈L(zhǎng)序列中提取關(guān)鍵片段并進(jìn)行理解。

(四)可視化結(jié)果

△圖三 Video-XL 在長(zhǎng)視頻理解任務(wù)上的可視化結(jié)果

目前。Video-XL的模型代碼均已開源,以促進(jìn)全球多模態(tài)視頻理解研究社區(qū)的合作和技術(shù)共享。

論文鏈接:https://arxiv.org/abs/2409.14485

模型鏈接:https://huggingface.co/sy1998/Video_XL

項(xiàng)目鏈接:https://github.com/VectorSpaceLab/Video-XL