強化學習訓練一兩個小時,100%自主完成任務:機器人ChatGPT時刻真來了?

最近,AI 的進步有目共睹,現在這些進步已經開始傳遞到機器人領域。強大的 AI 技術也能幫助機器人更好地理解其所處的物理世界并采取更合理的行動。

近日,UC 伯克利 BAIR 實驗室的 Sergey Levine 研究團隊提出了一個強化學習框架 HIL-SERL,可直接在現實世界中訓練通用的基于視覺的機器人操作策略。HIL-SERL 的表現堪稱前所未有的卓越,僅需 1-2.5 小時的訓練就能在所有任務上實現 100% 的成功率。要知道,基線方法的平均成功率還不到50%。就算有外部干擾,機器人也能取得很好的表現。

論文一作 Jianlan Luo 的推文,他目前正在 UC 伯克利 BAIR 實驗室從事博士后研究

團隊導師 Sergey Levine 也發了推文宣傳這項研究,他是一位非常著名的 AI 和機器人研究科學家,曾是 2021 年發表相關論文最多的研究者.

空口無憑,眼見為實,那就先讓機器人來煎個蛋吧。

在主板上安裝一塊固態硬盤?機器人也能與人類搭配,輕松完成。

插入 USB,問題也不大,看起來比人執行這個操作還流暢,畢竟很多人插 USB 都要對準兩三次才能成功。

這么好的效果,不禁讓人懷疑,這不會是遠程操控吧?Nonono!這些任務都是機器人獨立完成的,這次人類的角色也不是站在身后發號施令,而是在它旁邊搗亂。

對于沒有獨立思考能力的機器人來說,任務執行起來那是相當死板。一旦目標物體換了一個位置,它們就會迷失方向。但對于采取 HIL-SERL 框架的機器人,就算你強行奪走它手中這根 USB 線,它依然能自動定位,重新完成任務。

機器人如何變得如此厲害?下面我們就來看看 UC 伯克利的這項研究。

- 論文標題:Precise and Dexterous Robotic Manipulation via Human-in-the-Loop Reinforcement Learning

- 論文地址:https://hil-serl.github.io/static/hil-serl-paper.pdf

- 項目地址:https://hil-serl.github.io/

簡而言之,他們設計了一個有人類參與的強化學習框架。在此之前,基于強化學習的技術已經為機器人領域帶來了一些技術突破,使機器人已經能夠熟練地處理一些簡單任務。但是,真實世界環境非常動態多變,而且非常復雜,如果能開發出某種基于視覺的通用方法,必定有助于機器人掌握更加復雜的技能。

這正是該團隊做出貢獻的地方,他們開發的基于視覺的強化學習系統可以讓機器人掌握大量不同的機器人技能。

他們將該系統命名為 Human-in-the-Loop Sample-Efficient Robotic Reinforcement Learning,即有人類參與的樣本高效型機器人強化學習,簡稱 HIL-SERL。

為了解決優化穩定性問題,他們采用了預訓練的視覺主干網絡來實現策略學習。

為了處理樣本復雜性問題,他們利用了基于 RLPD 的樣本高效型離策略強化學習算法,該算法還結合了人工演示和校正。

此外,為了確保策略訓練期間的安全性,他們還納入了一個精心設計的低級控制器。

在訓練時,該系統會向人類操作員詢問潛在的校正,然后以離策略的方式使用這些校正來更新策略。他們發現,這種有人類參與的校正程序可讓策略從錯誤中學習并提高性能,尤其是對于這項研究中考慮的一些難以從頭開始學習的任務。

如圖 1 所示,該系統可解決的任務紛繁多樣,包括動態翻轉平底鍋中的物體、從積木塔中抽出一塊積木、在兩個機器臂之間遞交物體以及使用一個或兩個機械臂組裝復雜的設備,例如計算機主板、宜家置物架、汽車儀表板或正時皮帶。

這些任務復雜而精細,有著動態且高維的動作空間。之前一些研究者甚至認為無法通過強化學習來學習其中一些技能,但 BAIR 這個團隊的研究證否了這個說法。

研究和實驗表明,他們的系統能在相當短的時間(1-2.5 小時)內在所有這些任務上都實現幾近完美的成功率。

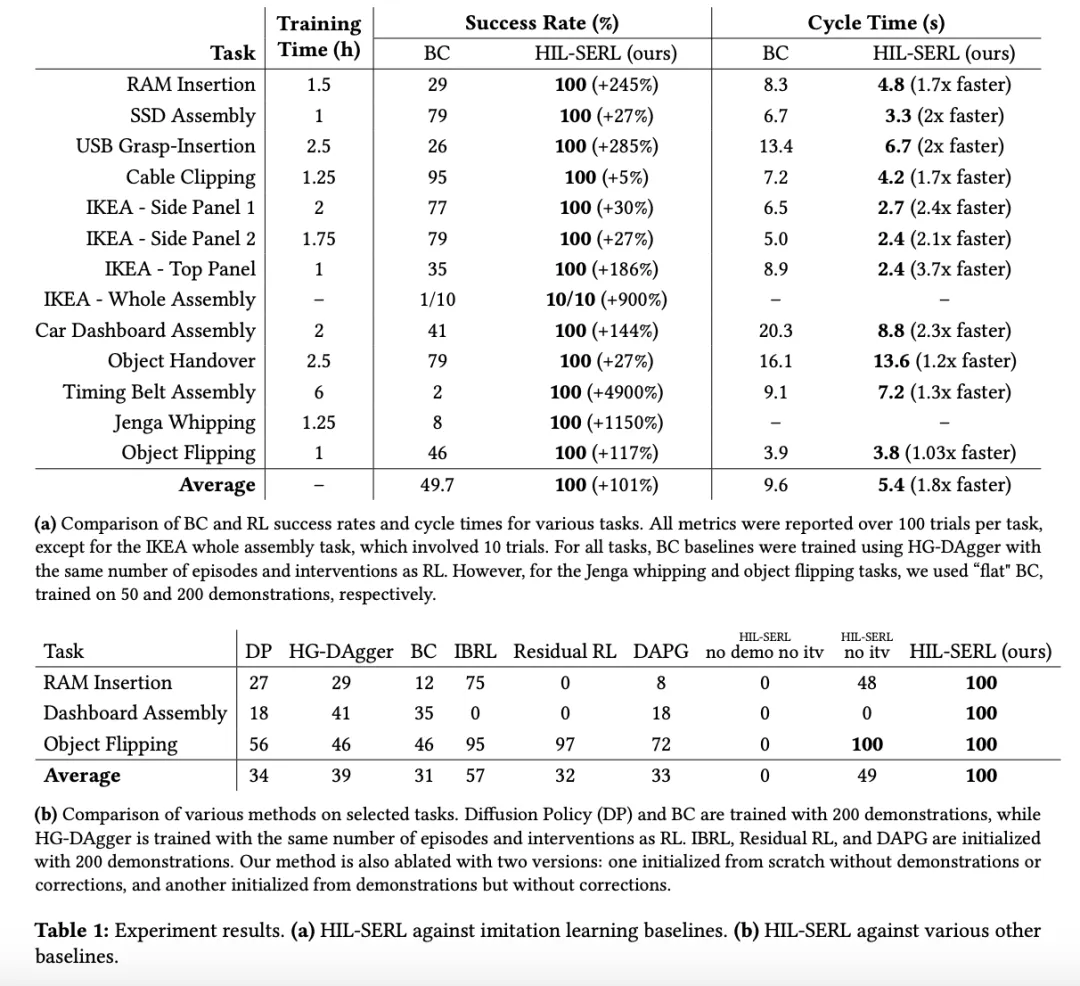

使用同樣數量的人類數據(演示和校正的數量)時,他們訓練的策略遠勝過模仿學習方法 —— 成功率平均超過 101%,周期時間平均快 1.8 倍。

這是個具有重大意義的結果,因為其表明強化學習確實可以直接在現實世界中,使用實際可行的訓練時間學會大量不同的基于視覺的復雜操作策略。而之前的強化學習方法無法做到這一點。此外,強化學習還能達到超越人類的水平,遠遠勝過模仿學習和人工設計的控制器。

下面展示了一個超越人類水平的有趣示例:用一根鞭子將一塊積木抽打出去,同時保證積木塔整體穩定。很顯然,這個任務對大多數人來說都非常困難,但這臺機器人通過強化學習掌握了這一技能。

有人類參與的強化學習系統

系統概況

HIL-SERL 系統由三個主要組件組成:actor 過程、learner 過程和位于 learner 過程中的重放緩存。它們都能以分布式的方式運行,如圖 2 所示。

actor 過程與環境交互的方式是在機器人上執行當前策略,并將數據發送回重放緩存。

環境采用了模塊化設計,允許靈活配置各種設備,包括支持多個攝像頭、集成 SpaceMouse 等用于遠程操作的輸入設備。

為了評估任務是否成功,也需要一個獎勵函數,而該獎勵函數是使用人類演示離線訓練的。

在 actor 過程中,人類可使用 SpaceMouse 從強化學習策略接管機器人的控制權,從而干預機器人的行動。

該團隊采用了兩種重放緩存,一種是為了存儲離線的人類演示(演示緩存),另一種則是為了存儲在策略數據(RL 緩存)。

learner 過程會從演示緩存和 RL 緩存平等地采樣數據,使用 RLPD 優化策略,并定期將更新后的策略發送到 actor 進程。

詳細的系統設計選擇這里不再贅述,請訪問原論文。

有人類參與的強化學習

此前,強化學習理論 (Jin et al., 2018; 2020; Azar et al., 2012; Kearns and Singh, 1998) 已經證明了智能體能學會的難度和它要處理的信息量密切相關。具體來說,狀態 / 動作空間的大小、任務的難度,這些變量不斷累加,會導致智能體在找到最優策略時所需的樣本成倍增加。最終在超過某個閾值時,所需要的樣本量過多,智能體實在學不動了,擺爛了,在現實世界中訓練 RL 策略也變得不切實際。

為了解決用強化學習訓練真實機器人策略的難題,該團隊研究后發現,人類反饋很好用 —— 可以引導學習過程,實現更高效的策略探索。具體來說,就是在訓練期間監督機器人,并在有必要時進行干預,糾正其動作。如上圖 2 所示。

在該系統的設計中,干預數據會被同時存儲在演示緩存和 RL 緩存中,但僅有 RL 緩存帶有策略轉移(即干預前后的狀態和動作)。事實證明,這種方法可以提升策略的訓練效率。

這種干預在以下情況下至關重要:

- 策略導致機器人處于不可恢復或不良狀態時;

- 當機器人陷入局部最優狀態時 —— 如果沒有人工幫助,就可能需要大量時間才能克服。

在訓練過程的開始階段,人類會更頻繁地干預以提供正確動作,隨著策略的改進,頻率會逐漸降低。根據該團隊的經驗,相比于讓機器人自行探索,當人類操作員給出具體的糾正措施時,策略改進速度會更快。

研究團隊放出了任務訓練過程的完整錄像

更具體的訓練過程請訪問原論文。

實驗結果

研究團隊選擇了七個任務來測試 HIL-SERL。這些任務對應著一系列挑戰,比如操縱動態物體(在平底鍋中翻煎蛋)、精確操作(插 USB 線)、動態和精確操作相結合(在主板移動時插入組件)、操縱柔性物體(組裝正時皮帶)、包含多個子任務的多階段任務(組裝宜家書架)。

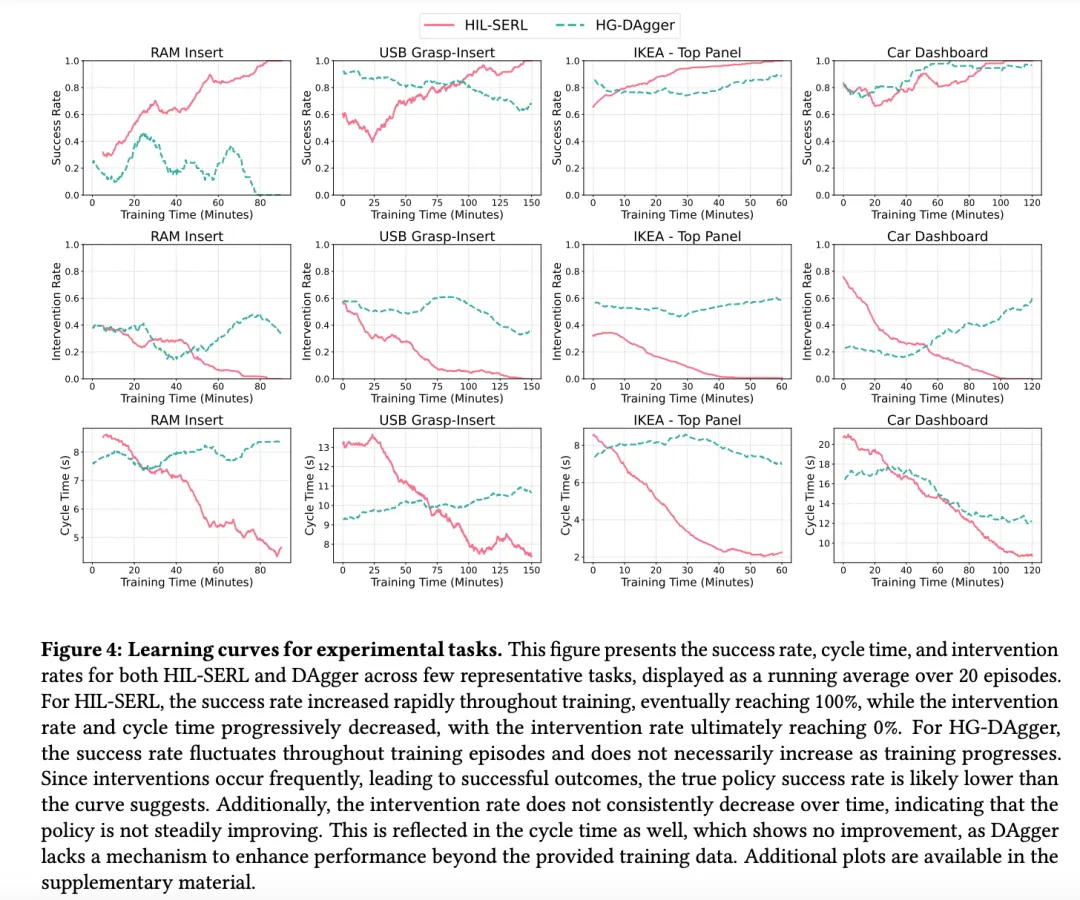

如上表所示,在幾乎所有任務上,HIL-SERL 在 1 到 2.5 小時的真實世界訓練里達到了 100% 的成功率。這比基線方法 HG-DAgger 的平均成功率 49.7% 有了顯著提高。對于抽積木、插入 RAM 條等,這種更復雜的任務,HIL-SERL 的優勢就更為明顯了。

上圖中顯示了采用 HIL-SERL 方法的機械臂在執行任務時被人工干預的次數。為了便于統計,研究團隊計算了每次干預的時步數與單次嘗試中的總時步數之比(干預率),并統計了 20 次實驗的動態平均值。從圖表中不難看出,干預率隨著訓練逐漸降低。這表明 HIL-SERL 策略會不斷優化,越來越不需要人類操心了。

同時,人工干預的總時長也大幅度減少。策略不成熟時,機械臂犯錯,需要花較長時間糾正,隨著 HIL-SERL 不斷完善,較短的干預就足以減少錯誤。相比之下,HG-DAgger 需要更頻繁的干預,亦不會因為策略逐漸完善減少犯錯的次數。

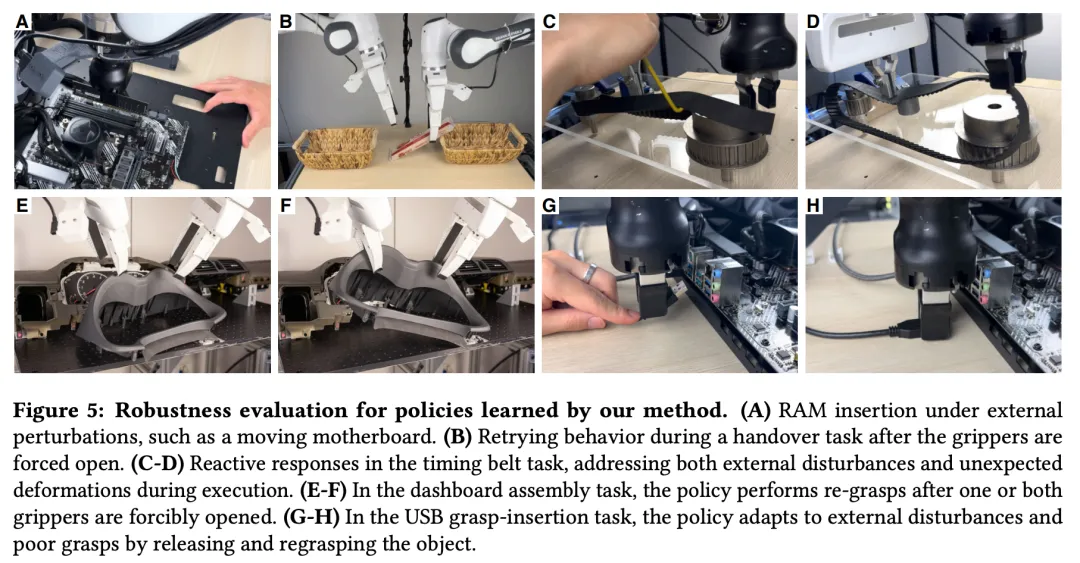

上圖展示了 HIL-SERL 的零樣本魯棒性。這證明新提出的策略能夠讓機器人靈活地適應即時變化,有效地處理外部干擾。

比如有人故意地松開了齒輪上的皮帶,受 HIL-SERL 指導的兩個機械臂,一個把皮帶放回了原位,另一個配合著把滑輪恢復到了適當的位置。

在兩個機械臂對接時,研究人員有意讓其中一個機械臂「失誤」,放開了手中的物體。在 HIL-SERL 的加持下,兩個機械臂自主分工合作,又恢復了搬運物體的平衡。