強化學習大牛Sergey Levine新作:三個大模型教會機器人認路

?內置大模型的機器人,在不看地圖的情況下,學會了按照語言指令到達目的地,這項成果來自強化學習大牛 Sergey Levine 的新作。

給定一個目的地,在沒有導航軌跡的情況下順利到達,有多難?

對于方向感不好的人類來說,這個任務也是很有挑戰性。但在最近的一項研究中,幾位學者只用三個預訓練模型就把機器人「教會了」。

我們都知道,機器人學習的核心挑戰之一是使機器人能夠按照人類的高級指令執行各種各樣的任務。這就要求機器人能夠理解人類的指令,并配備大量不同的動作,以便在現實世界中執行這些指令。

對于導航中的指令遵循任務來說,此前的工作主要集中在從帶有文本指令注釋的軌跡中學習。這樣可能可以實現對文本指令的理解,但數據注釋的成本問題阻礙了這種技術的廣泛使用。另一方面,最近的工作表明,自監督訓練的目標條件策略可以學習到穩健的導航。這些方法基于大型的、無標記的數據集,通過事后重新標記來訓練基于視覺的控制器。這些方法具有可擴展性、通用性和穩健性,但通常需要使用基于位置或圖像的笨重的目標規范機制。

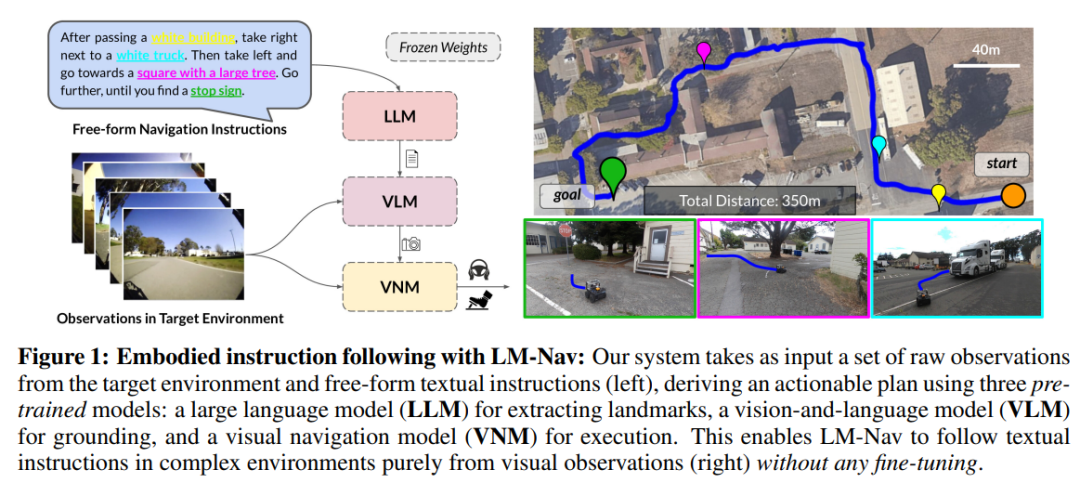

在一篇最新的論文中,UC 伯克利、谷歌等機構的研究者旨在結合這兩種方法的優勢,使機器人導航的自監督系統能夠適用于沒有任何用戶注釋的導航數據,利用預訓練模型的能力來執行自然語言指令。研究者使用這些模型來構建一個「界面」,用來向機器人傳達任務。這個系統借助于預訓練的語言和視覺 - 語言模型的概括能力,使機器人系統能夠接受復雜的高級指令。

?

- 論文鏈接:https://arxiv.org/pdf/2207.04429.pdf

- 代碼鏈接:https://github.com/blazejosinski/lm_nav

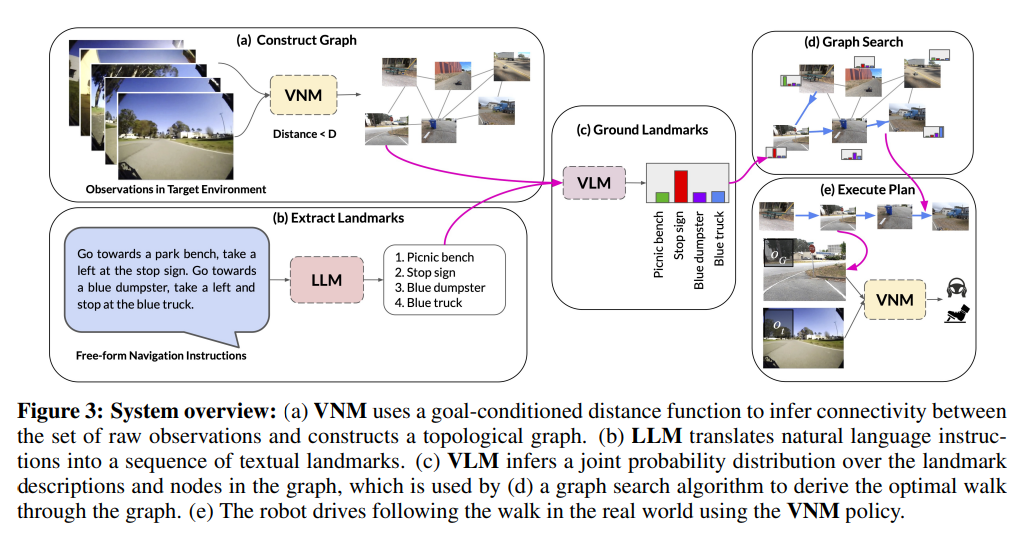

研究者觀察到,可以利用在視覺和語言數據集的大型語料庫上訓練的現成預訓練模型(這些語料庫廣泛可用,并顯示出零樣本泛化能力)來創建界面,以實現具體的指令跟蹤。為了實現這一點,研究者結合了視覺和語言的 robot-agnostic 預訓練模型以及預訓練導航模型的優點。具體而言,他們使用視覺導航模型(VNM:ViNG)來將機器人的視覺結果創建為環境的拓撲「心理地圖」。給定自由形式的文本指令,使用預訓練的大型語言模型(LLM:GPT-3)將指令解碼為一系列文本形式的特征點。然后,使用視覺語言模型(VLM:CLIP)通過推斷特征點和節點的聯合似然概率來在拓撲圖中建立這些文本特征點。之后使用一種新的搜索算法來最大化概率目標函數,并找到機器人的指令路徑,然后由 VNM 執行。 研究的主要貢獻在于大規模模型下的導航方法(LM Nav),一個具體的指令跟蹤系統。它結合了三個大型的獨立預訓練模型——一個利用視覺觀察和物理動作(VNM)的自監督機器人控制模型,一個將圖像置于文本中但沒有具體實施環境(VLM)的視覺語言模型,以及一個大型語言模型,該模型可以解析和翻譯文本,但沒有視覺基礎或體現感(LLM),以便在復雜的真實環境中實現長視野指令跟蹤。研究者首次將預訓練的視覺和語言模型與目標條件控制器相結合的想法實例化,以在目標環境中不進行任何微調的情況下得出可操作的指令路徑。值得注意的是,這三個模型都是在大規模數據集上訓練的,具有自監督的目標函數,并且在沒有微調的情況下現成使用 - 訓練 LM Nav 不需要對機器人導航數據進行人工注釋。

?實驗表明,LM Nav 能夠在 100 米的復雜郊區導航過程中,在新環境中成功地遵循自然語言指令,同時使用細粒度命令消除路徑歧義。

?LM-Nav 模型概覽

那么,研究者是如何利用預訓練好的圖像和語言模型,為視覺導航模型提供文本界面的?

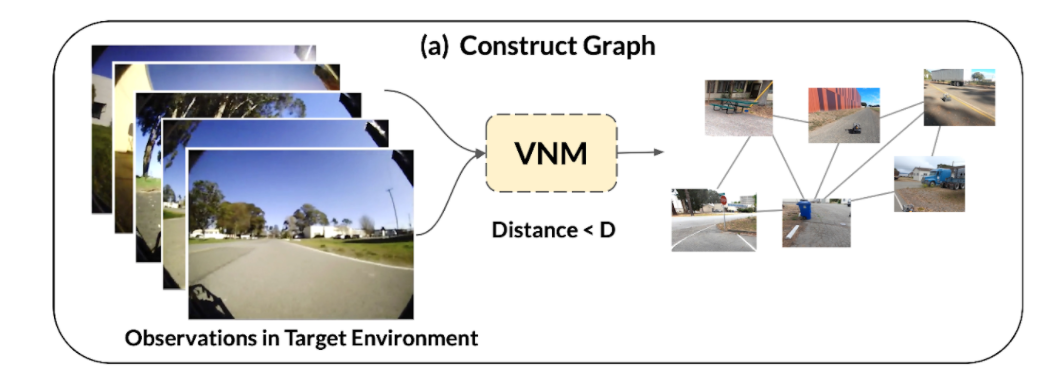

?1、 給定目標環境中的一組觀測值,使用目標條件距離函數,也就是視覺導航模型(VNM)的一部分,推斷它們之間的連通性,并構建環境中連通性的拓撲圖。

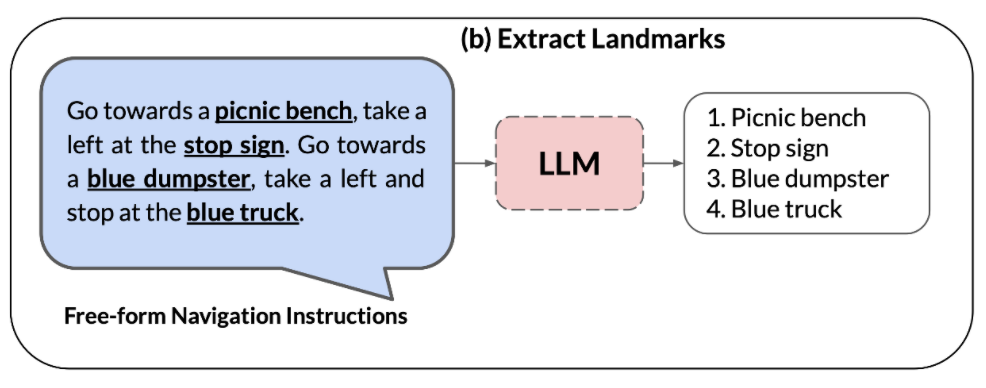

?2、大型語言模型(LLM)用于將自然語言指令解析為一連串的特征點,這些特征點可以作為導航的中間子目標。

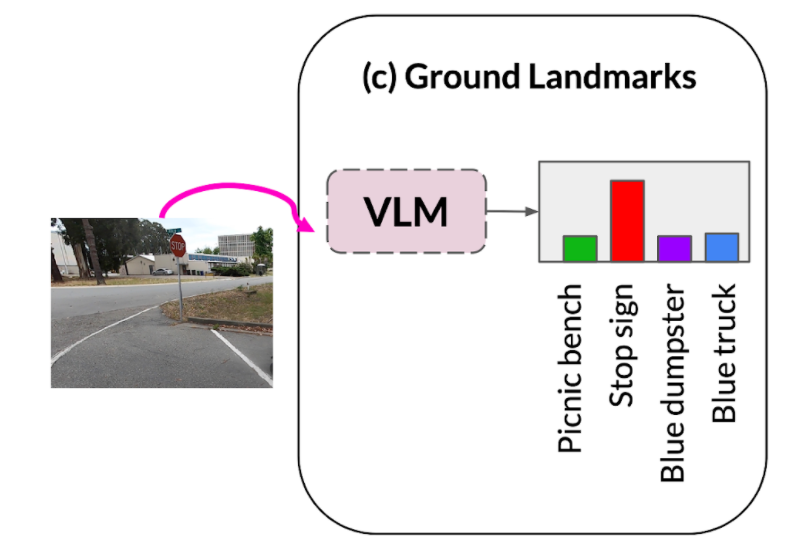

?3、視覺 - 語言模型(VLM)被用來在特征點短語上的基礎上建立視覺觀察結果。視覺 - 語言模型推斷出一個關于特征點描述和圖像的聯合概率分布(形成上述圖形中的節點)。

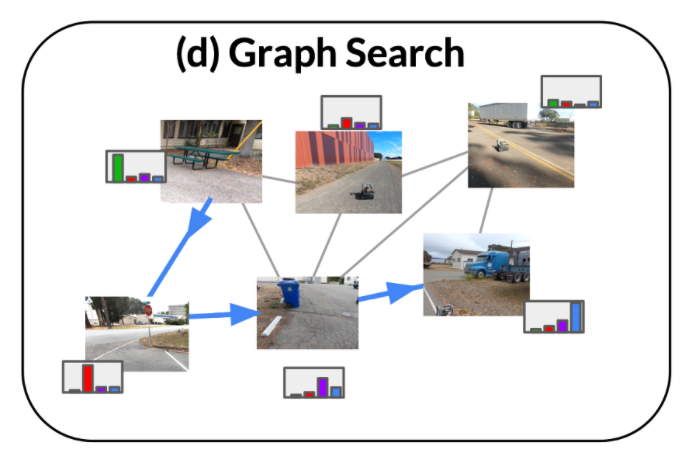

?4、利用 VLM 的概率分布和 VNM 推斷的圖連接性,采用一種新穎的搜索算法,在環境中檢索出一個最優指令路徑,該指令路徑(i)滿足原始指令,(ii)是圖中能實現目標的最短的路徑。

?

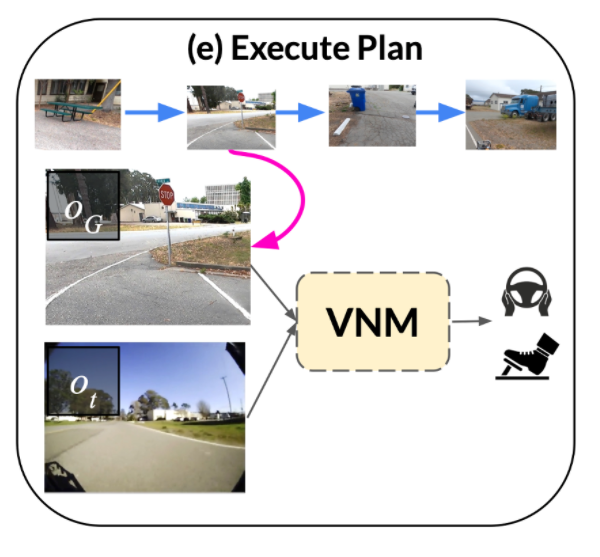

5、 然后,該指令路徑由目標條件策略執行,該策略是 VNM 的一部分。?

實驗結果

定性評估?

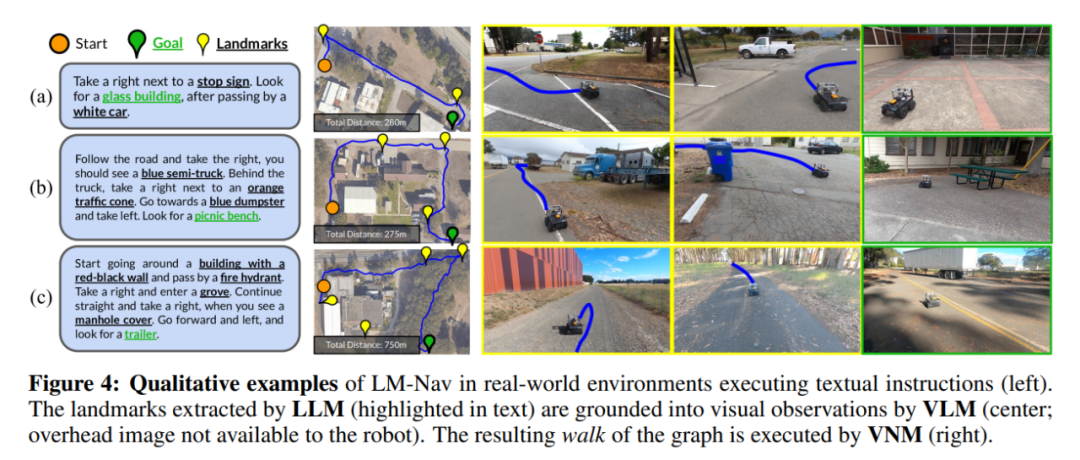

圖 4 展示了機器人所走路徑的一些實例(注意,機器人無法獲得頭頂上的圖像和特征點的空間定位,所顯示的只是視覺效果)。

?在圖 4(a) 中,LM-Nav 能夠成功地從其先前的穿越中定位出簡單的特征點,并找到一條通往目標的短路徑。雖然環境中存在多個停車特征點,但公式 3 中的目標函數使機器人在上下文中選擇正確的停車特征點,從而使整體行進距離最小。

圖 4(b) 強調了 LM-Nav 解析有多個特征點的指定路線的能力—盡管在無視指令路徑的情況下,直接到達最后的特征點是最短路線,但機器人仍然能找到了一條以正確順序訪問所有特征點的路徑。

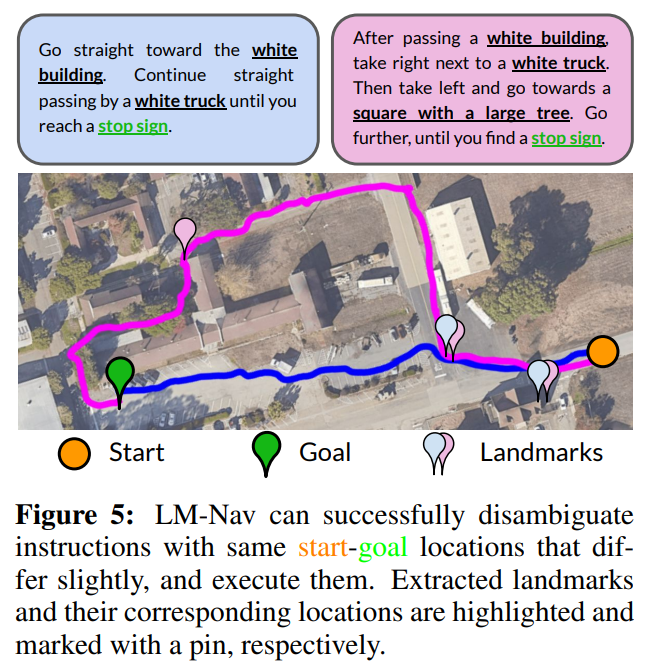

?使用指令來消除歧義。由于 LM Nav 的目標是遵循指令,而不僅僅是達到最終目標,不同的指令可能導致不同的遍歷。圖 5 展示了修改指令可以消除目標的多條路徑歧義的示例。對于較短的 prompt(藍色),LM Nav 首選更直接的路徑。在指定更細粒度的路線(洋紅色)時,LM Nav 采用通過不同特征點集的備用路徑。

?缺少特征點的情況。雖然 LM-Nav 能夠有效地解析指令中的特征點,在圖上對它們進行定位,并找到通往目標的路徑,但這個流程依賴于這樣的假設:特征點(i)存在于真實環境中,以及(ii)可以被 VLM 識別。圖 4(c) 顯示了這樣一種情況:可執行的路徑未能訪問其中一個特征點—一個消防栓—于是采取了一條繞過建筑物頂部而不是底部的路徑。這種失敗案例是由于 VLM 無法從機器人的觀察中發現消防栓。

在獨立評估的 VLM 在檢索特征點方面的功效時,研究者發現,盡管它是此類任務的最佳 off-the-shelf 模型,但 CLIP 無法檢索少量的 「硬 」特征點,包括消防栓和水泥攪拌器。但是在許多實際情況下,機器人仍然能夠成功地找到一條訪問其余特征點的路徑。

定量評估?

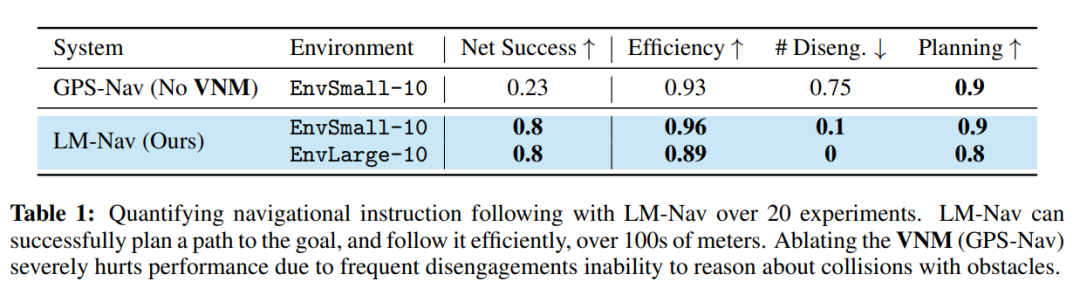

表 1 總結了該系統在 20 條指令中的量化表現。在 85% 的實驗中,LM-Nav 能夠始終遵循指令,沒有發生碰撞或脫離(平均每 6.4 公里的行進有一次干預)。與無導航模型的 baseline 相比,LM-Nav 在執行高效、無碰撞的目標路徑方面一直表現得更好。在所有不成功的實驗中,失敗可歸因于規劃階段的能力不足——搜索算法無法直觀地定位圖中的某些「硬」特征點—導致指令的不完整執行。對這些失敗模式的調查表明,系統中最關鍵的部分是 VLM 檢測不熟悉的特征點的能力,例如消防栓,以及在具有挑戰性的照明條件下的場景,例如曝光不足的圖像。

?