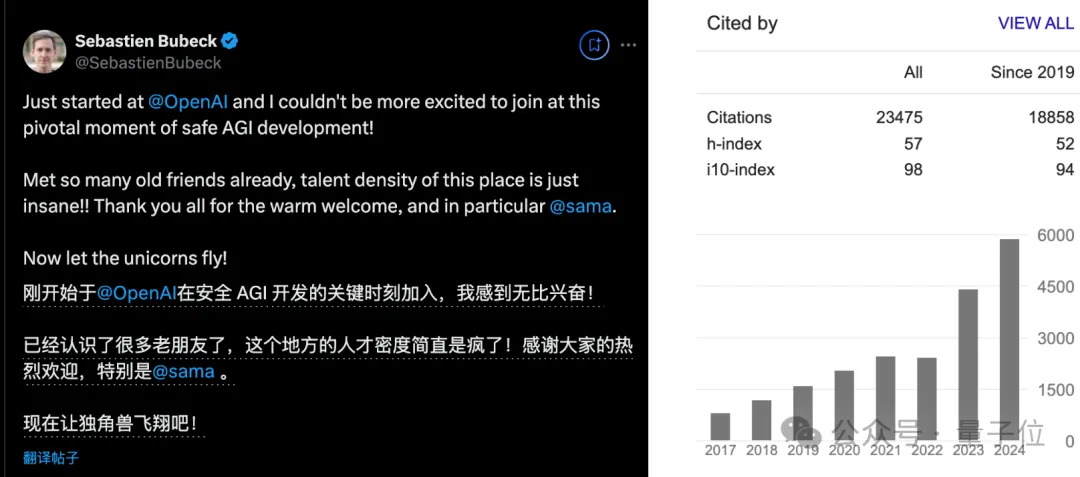

微軟萬(wàn)引理論大佬跳槽OpenAI!入職第一天:瘋了,這里的人才密度簡(jiǎn)直瘋了

傳聞證實(shí),微軟機(jī)器學(xué)習(xí)理論萬(wàn)引大佬,官宣跳槽加入OpenAI。

入職第一天,他便發(fā)出如此感慨:

這個(gè)地方的人才密度,簡(jiǎn)直是瘋了!

話一說(shuō)出去就得到印證,他口中的人才們都來(lái)評(píng)論區(qū)排隊(duì)歡迎了。

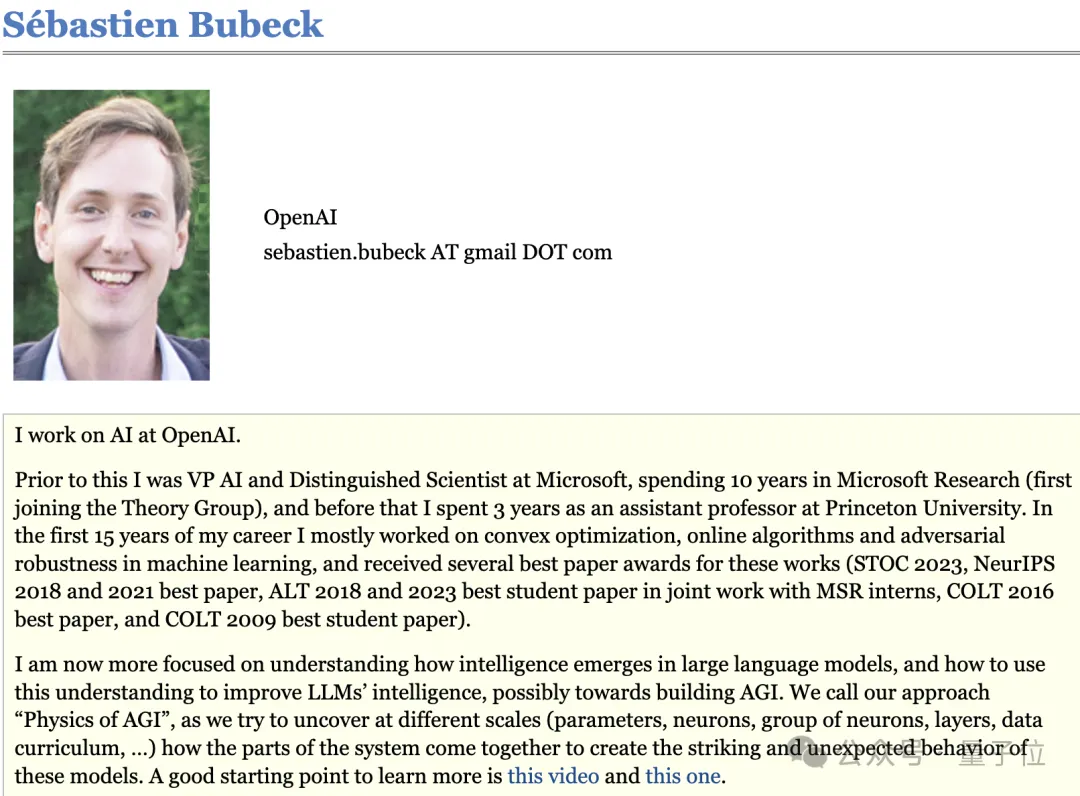

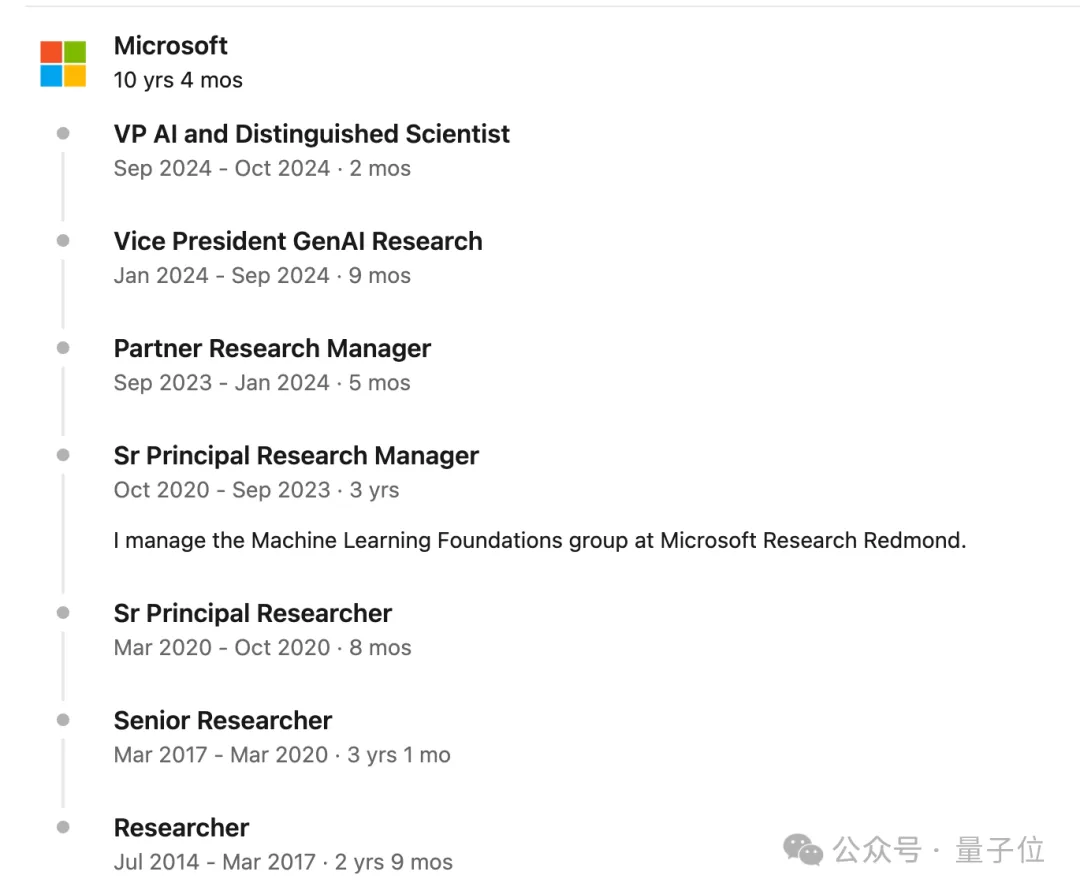

他是Sebastien Bubeck,微軟前AI副總裁和杰出科學(xué)家,在微軟工作10年。

2021年,他曾用一篇理論研究展示擴(kuò)大AI模型規(guī)模的重要性,幫助說(shuō)服微軟CEO納德拉在AI基礎(chǔ)設(shè)施上增加數(shù)十億美元的投資。

他的職業(yè)生涯前15年都投入在計(jì)算機(jī)理論和機(jī)器學(xué)習(xí)理論,研究的是凸優(yōu)化、在線學(xué)習(xí)和對(duì)抗穩(wěn)健性這些問(wèn)題,直到——

微軟作為OpenAI合作伙伴,派他參與了未安全對(duì)齊版GPT-4早期測(cè)試,期間他來(lái)了一場(chǎng)戲劇性的轉(zhuǎn)型。

全面轉(zhuǎn)向AGI研究。

在當(dāng)時(shí)外界還只接觸過(guò)GPT-3.5的背景下,看起來(lái)就像“理論學(xué)者轉(zhuǎn)型研究科幻了”,而他本人是這么解釋的:

現(xiàn)在我更關(guān)注大型語(yǔ)言模型中智能是如何形成,如何利用這種理解提高模型性能,并可能邁向構(gòu)建AGI。

我們的方法稱作“AGI的物理學(xué)”(Physics of AGI)。

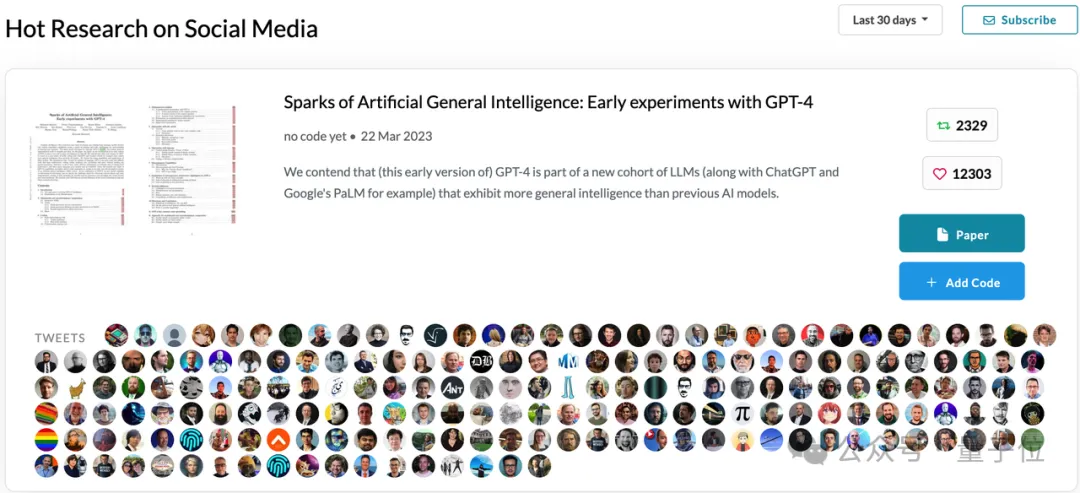

之后他便帶領(lǐng)微軟團(tuán)隊(duì)發(fā)布一篇154頁(yè)的GPT-4實(shí)驗(yàn)報(bào)告《AGI的火花》,一時(shí)引起全業(yè)界轟動(dòng),成為人們對(duì)AI過(guò)高期待的重要推手。

后來(lái)他承認(rèn)過(guò)當(dāng)時(shí)的實(shí)驗(yàn)方法并不算嚴(yán)格,但并不后悔,并堅(jiān)持“沒(méi)有證據(jù)否定GPT-4已經(jīng)具有一定推理能力”。

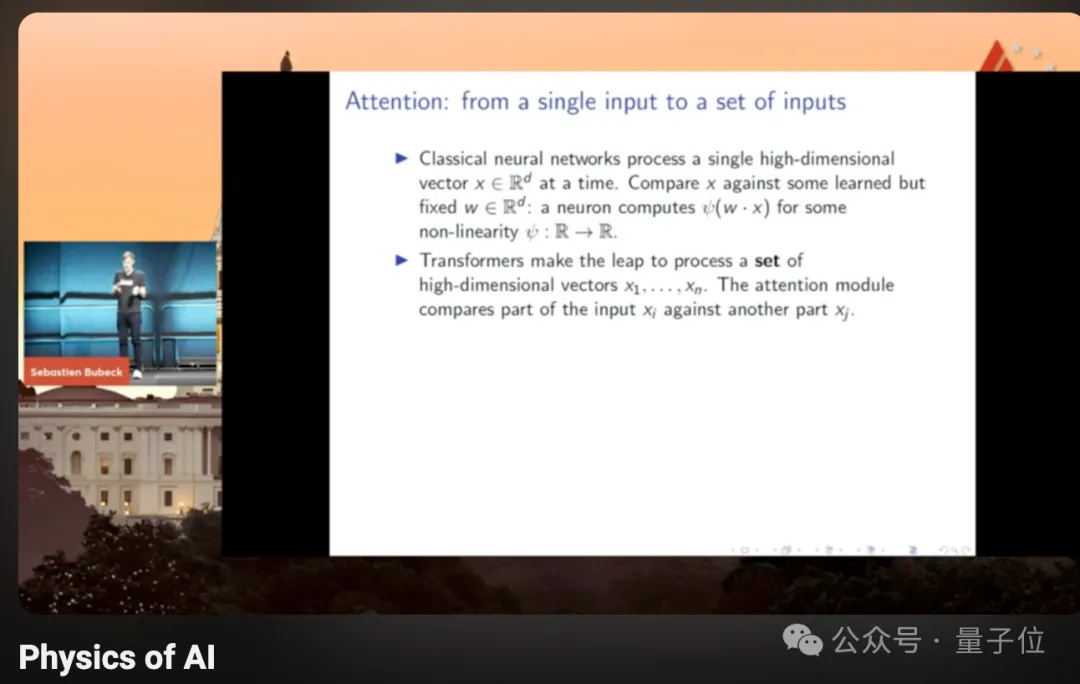

在轉(zhuǎn)型期間的一次演講中,他分享了自己對(duì)“Transformer到底有什么特別之處”的思考,指出很多人容易忽略的一點(diǎn):Transformer不是序列模型。

與RNN等模型關(guān)鍵區(qū)別在于Transformer一次處理一個(gè)集合,而不是序列中的單個(gè)輸入。

集合是一種強(qiáng)大的抽象層次,讓模型能看到元素之間的關(guān)系,從“絕對(duì)機(jī)器”變成相對(duì)機(jī)器。

這次他加入OpenAI的時(shí)機(jī)非常微妙,本人強(qiáng)調(diào)是在“開(kāi)發(fā)安全AGI的關(guān)鍵時(shí)刻加入”。

微軟發(fā)言人的聲明中也提到,“Sebastien已決定離開(kāi)微軟,以進(jìn)一步開(kāi)發(fā)AGI”。

同時(shí),現(xiàn)在也是OpenAI和微軟聯(lián)盟漸漸破裂的時(shí)刻,奧特曼和OpenAI首席財(cái)務(wù)官近期對(duì)員工抱怨,微軟行動(dòng)速度不夠快,沒(méi)有提供足夠的服務(wù)器。

兩家開(kāi)始相互視對(duì)方為備胎,OpenAI找了甲骨文做額外的云計(jì)算供應(yīng)商,微軟也開(kāi)始在旗下產(chǎn)品中接入谷歌和Anthropic模型。

不得不說(shuō),很耐人尋味。

一篇論文影響微軟對(duì)AI的數(shù)十億美元投入

Sebastien Bubeck,2010博士畢業(yè)于法國(guó)里爾第一大學(xué)數(shù)學(xué)專業(yè)。

在普林斯頓大學(xué)做三年助理教授后,于2014年加入微軟,從普通研究員一路做到VP。

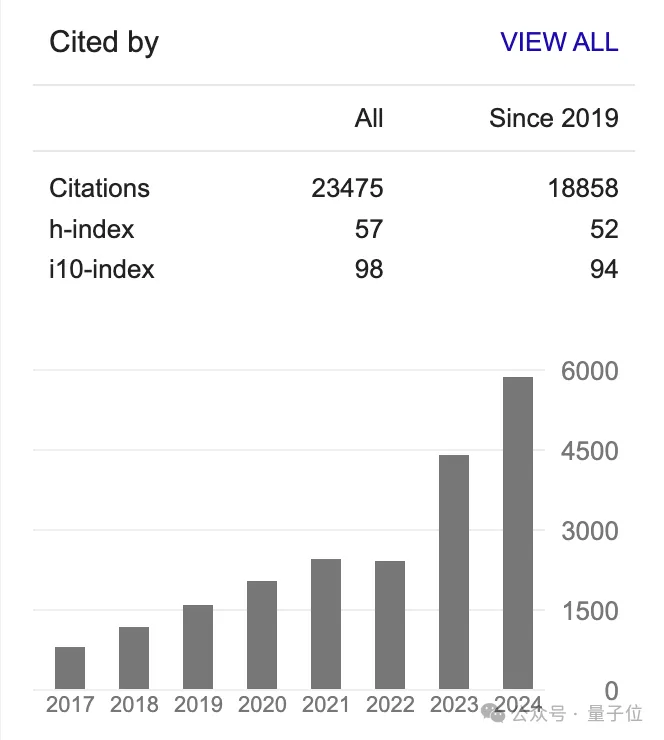

在2023年轉(zhuǎn)型AGI研究之前,就憑理論研究收獲上萬(wàn)被引,現(xiàn)在總被引數(shù)來(lái)到23475。

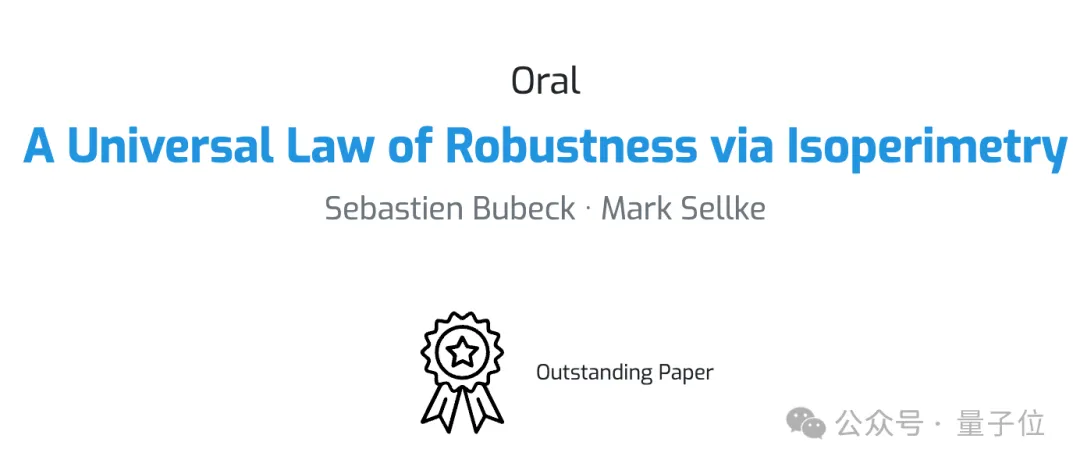

2021年他與斯坦福博士生Mark Sellke合著論文《A Universal Law of Robustness via Isoperimetry》,不僅入選NeurIPS2021杰出論文,也對(duì)微軟和整個(gè)人工智能業(yè)界產(chǎn)生影響。

這篇論文解釋了為什么實(shí)踐中訓(xùn)練模型需要的參數(shù)比理論建議的要多得多,幫助說(shuō)服微軟CEO納德拉和微軟研究院院長(zhǎng)Peter Lee等,在AI基礎(chǔ)設(shè)施上增加數(shù)十億美元的投資。

隨后這些對(duì)數(shù)據(jù)中心和先進(jìn)GPU的投資為OpenAI提供了訓(xùn)練和部署大模型的支柱。

Peter Lee后來(lái)表示“這是整個(gè)人工智能之旅中非常重要的時(shí)刻,不僅對(duì)于微軟,而是對(duì)于所有大型科技公司”。

在轉(zhuǎn)型研究AGI后,他在研究中解釋了自己的新方向:AGI的物理學(xué)。

他認(rèn)為Transformer和自然界一樣都是復(fù)雜系統(tǒng),需要用物理的方法去研究。

物理學(xué)的核心在于將一個(gè)系統(tǒng)進(jìn)行分解,辨認(rèn)出產(chǎn)生所觀察到的行為的真正關(guān)鍵要素。

第一步從通過(guò)可控的實(shí)驗(yàn),研究小規(guī)模“玩具模型”開(kāi)始。

隨后他就在微軟開(kāi)啟了Phi系列小模型研究,控制訓(xùn)練數(shù)據(jù)中只有教科書(shū)級(jí)別的高質(zhì)量數(shù)據(jù)和合成數(shù)據(jù),并發(fā)表論文《Textbook is all you need》。

到現(xiàn)在Phi系列小模型已迭代到phi-3.5版本,在本地大模型推理工具ollma上,開(kāi)源模型中受歡迎程度排第5。

One More Thing

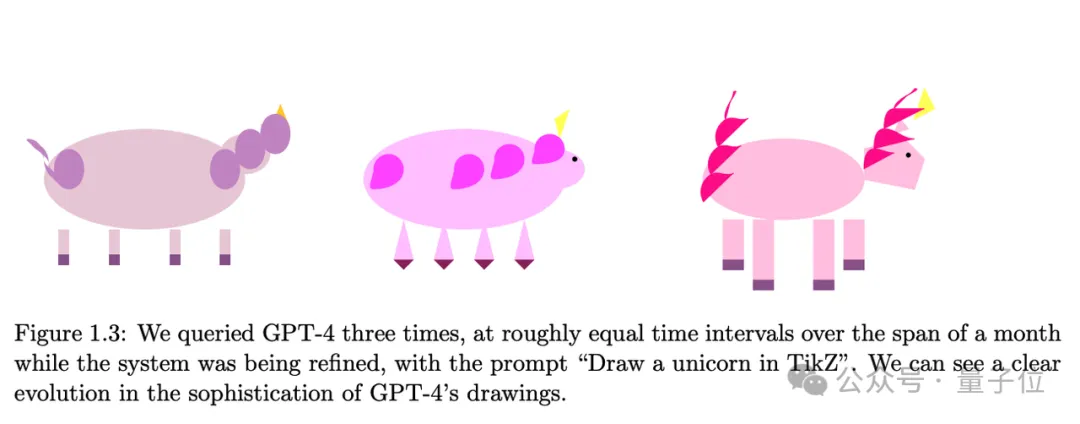

Bubeck在《AGI的火花》論文中,展示了滿血版GPT-4通過(guò)代碼畫(huà)獨(dú)角獸的能力,隨訓(xùn)練進(jìn)度增長(zhǎng)飛快。

他認(rèn)為未來(lái)這是考驗(yàn)大模型智力的一個(gè)有趣的檢驗(yàn)標(biāo)準(zhǔn),也成了這個(gè)meme的代言人。

但或許出乎他意料的是,今天的主流模型不僅能勝任畫(huà)圖,甚至能組團(tuán)玩你畫(huà)我猜了。