基于PyTorch的大語言模型微調指南:Torchtune完整教程與代碼示例

近年來,大型語言模型(Large Language Models, LLMs)在自然語言處理(Natural Language Processing, NLP)領域取得了顯著進展。這些模型通過在大規模文本數據上進行預訓練,能夠習得語言的基本特征和語義,從而在各種NLP任務上取得了突破性的表現。為了將預訓練的LLM應用于特定領域或任務,通常需要在領域特定的數據集上對模型進行微調(Fine-tuning)。隨著LLM規模和復雜性的不斷增長,微調過程面臨著諸多挑戰,如計算資源的限制、訓練效率的瓶頸等。

Torchtune是由PyTorch團隊開發的一個專門用于LLM微調的庫。它旨在簡化LLM的微調流程,提供了一系列高級API和預置的最佳實踐,使得研究人員和開發者能夠更加便捷地對LLM進行調試、訓練和部署。Torchtune基于PyTorch生態系統構建,充分利用了PyTorch的靈活性和可擴展性,同時針對LLM微調的特點進行了優化和改進。

Torchtune的核心設計原則

Torchtune的設計遵循以下四個核心原則:

- 簡單性和可擴展性:Torchtune采用原生PyTorch的設計風格,提供模塊化的組件和接口。這使得用戶能夠根據自己的需求,輕松地對現有功能進行修改和擴展,構建定制化的微調流程。同時,Torchtune也提供了一系列開箱即用的工具和模塊,降低了用戶的使用門檻。

- 正確性:LLM微調對訓練數據和算法實現的正確性有著較高的要求。Torchtune中的各個組件和模塊都經過了嚴格的單元測試和驗證,確保了其輸出結果的可靠性。Torchtune還提供了一系列調試和分析工具,幫助用戶快速定位和解決訓練過程中遇到的問題。

- 穩定性:Torchtune構建在PyTorch的穩定版本之上,并針對LLM微調場景進行了充分的測試和優化。用戶可以在各種硬件環境下穩定地運行Torchtune,不必擔心兼容性和穩定性問題。

- 可訪問性:Torchtune的一個重要目標是讓更多的用戶能夠參與到LLM的開發和應用中來。因此,Torchtune提供了詳細的文檔和教程,以及常見問題的解決方案。Torchtune還提供了一系列預訓練模型和數據集,降低了用戶的入門成本。

Torchtune的主要特性

Torchtune提供了以下主要特性,以支持LLM的微調任務:

- 模塊化的PyTorch實現:Torchtune實現了當前主流的LLM架構,如Transformer、GPT、BERT等。用戶可以直接使用這些模塊,也可以基于它們構建自己的模型。

- 數據集和評測工具的集成:Torchtune與Hugging Face的Datasets庫和EleutherAI的Eval Harness無縫集成,提供了豐富的數據集資源和標準化的評測方案。用戶可以方便地訪問和使用這些資源,也可以將自己的數據集和評測方案集成到Torchtune中。

- 高效的分布式訓練:Torchtune支持多種并行訓練方式,如數據并行、模型并行、流水線并行等。特別地,Torchtune針對LLM微調實現了Fully Sharded Data Parallel v2 (FSDP2),可以顯著地加速大規模模型的訓練速度,并減少顯存占用。

- 基于配置文件的任務管理:Torchtune使用YAML格式的配置文件來管理微調任務的參數和流程。用戶可以通過修改配置文件,靈活地控制訓練過程,而無需修改代碼。Torchtune還提供了一系列預置的配置文件和腳本,進一步簡化了任務的管理和執行。

Torchtune是一個專為LLM微調設計的PyTorch庫,其目標是讓LLM的開發和應用變得更加簡單、高效、可靠。Torchtune提供了模塊化的組件、高級的API、豐富的數據資源、先進的并行訓練技術,以及基于配置文件的任務管理方式。Torchtune在提高LLM微調效率的同時,也大大降低了用戶的使用門檻,使更多的研究人員和開發者能夠參與到LLM的開發和應用中來。

在接下來的內容中,我們將介紹Torchtune中的一些關鍵概念,并通過實例展示如何使用Torchtune進行LLM微調。我們也會探討一些高階的主題,如LoRA和QLoRA等參數高效的微調方法。

Torchtune中的關鍵概念

Torchtune引入了兩個關鍵概念:配置(Config)和方案(Recipe)。這兩個概念抽象了LLM微調任務的參數和流程,使得用戶能夠以更加靈活和高效的方式管理微調任務。

配置(Config)

在Torchtune中,配置以YAML文件的形式存在。每個配置文件定義了一個完整的微調任務,包括:

- 數據集的路徑和格式

- 模型的架構和參數

- 優化器的類型和超參數

- 訓練的批大小、學習率、迭代次數等

- 評測和日志的設置

通過使用配置文件,用戶可以將微調任務的參數與代碼實現解耦。這樣,用戶可以通過修改配置文件來快速地試驗不同的設置,而無需修改代碼。同時,配置文件也提高了任務的可重復性和可移植性。

下面是一個簡單的配置文件示例:

dataset:

path: /path/to/dataset

format: json

fields:

- name: text

type: string

- name: label

type: int

model:

type: transformer

params:

num_layers: 12

hidden_size: 768

num_attention_heads: 12

optimizer:

type: AdamW

params:

lr: 0.001

weight_decay: 0.01

train:

batch_size: 32

num_epochs: 10

log_interval: 100

evaluate:

batch_size: 64

metric:

- accuracy

- f1方案(Recipe)

方案是Torchtune提供的一系列預置的微調流程。每個方案都針對特定的場景和任務,提供了一套優化的實現和最佳實踐。用戶可以直接使用這些方案,也可以基于它們進行定制和擴展。

Torchtune內置了多個常用的方案,如:

- lora_finetune_single_device:單設備上使用LoRA進行微調

- lora_finetune_distributed:多設備分布式環境下使用LoRA進行微調

- qlora_finetune:使用QLoRA進行參數高效微調

- distill_finetune:使用知識蒸餾技術進行微調

每個方案都定義了一個完整的微調流程,包括數據處理、模型初始化、優化器選擇、訓練循環、評測和日志等。方案通過組合Torchtune提供的各種模塊和工具,實現了端到端的自動化微調。

下面是一個使用lora_finetune_single_device方案進行微調的示例:

tune run lora_finetune_single_device \

--config configs/llama2/7B_lora_single_device.yaml \

--train.batch_size 128 \

--optimizer.params.lr 0.0001在這個例子中,我們使用lora_finetune_single_device方案在單個設備上對LLaMA-2-7B模型進行微調。我們指定了配置文件的路徑,并通過命令行參數覆蓋了原始配置中的train.batch_size和optimizer.params.lr參數。

Torchtune的配置和方案機制提供了一種靈活、高效、可復用的方式來管理LLM微調任務。通過使用配置文件和預置方案,用戶可以快速啟動微調任務,并以極低的成本試驗不同的優化策略。

小結

Torchtune中的配置和方案是管理LLM微調任務的兩個關鍵抽象。配置以YAML文件的形式存在,定義了微調任務的各種參數;方案則提供了一系列預置的、經過優化的端到端微調流程。通過靈活地組合配置和方案,用戶可以以極低的成本開展LLM微調的實驗和優化。

在接下來的內容中,我們將通過一個完整的實例,展示如何使用Torchtune進行LLM微調。我們也會介紹一些高階的微調技術,如LoRA和QLoRA。

使用Torchtune微調LLM

在這一節中,我們將通過一個完整的實例,展示如何使用Torchtune微調LLM。我們會使用Torchtune提供的lora_finetune_single_device方案,在單個GPU設備上對LLaMA-2-7B模型進行微調。

準備工作

在開始之前,請確保你已經正確安裝了Torchtune,并且可以訪問Hugging Face Hub。Hugging Face Hub中托管了許多常用的預訓練語言模型,如LLaMA、GPT、BERT等。你需要先注冊一個Hugging Face賬號,并獲取訪問Tokens。

下載預訓練模型

首先,我們需要下載一個預訓練的語言模型。在這個例子中,我們使用Meta發布的LLaMA-2-7B模型,這是一個在Hugging Face Hub上的開源模型。我們可以使用以下命令下載這個模型:

tune download meta-llama/Llama-2-7b-hf \

--output-dir /tmp/Llama-2-7b-hf \

--hf-token <ACCESS TOKEN>這個命令會將LLaMA-2-7B模型下載到/tmp/Llama-2-7b-hf目錄下,其中<ACCESS TOKEN>需要替換為你自己的Hugging Face訪問Token。除了模型的參數,這個命令還會下載對應的Tokenizer和一些其他的文件,如模型卡片、使用許可等。

選擇微調方案

Torchtune提供了多個預置的微調方案,適用于不同的場景和任務。你可以通過以下命令查看所有可用的方案:

tune ls在這個例子中,我們選擇lora_finetune_single_device方案。這個方案使用LoRA(Low-Rank Adaptation)技術在單個GPU設備上對LLM進行微調。LoRA通過引入低秩的適配器參數,在不改變原始模型參數的情況下,實現對模型的微調。這種方法可以顯著減少微調過程中的內存消耗和計算開銷,使得在單個GPU上微調大型LLM成為可能。

配置微調任務

每個微調方案都有一個對應的配置文件,定義了微調任務的各種參數。lora_finetune_single_device方案的默認配置文件路徑為llama2/7B_lora_single_device.yaml。我們可以直接使用這個配置文件,也可以在此基礎上進行修改。

Torchtune支持兩種方式來修改配置文件:

- 通過命令行參數覆蓋配置文件中的參數:

tune run lora_finetune_single_device \

--config llama2/7B_lora_single_device.yaml \

train.batch_size=128 \

train.num_epochs=5- 將配置文件復制到本地,然后直接修改配置文件:

tune cp llama2/7B_lora_single_device.yaml custom_config.yaml修改custom_config.yaml文件,然后運行:

tune run lora_finetune_single_device \

--config custom_config.yaml通過靈活地使用這兩種方式,我們可以方便地控制微調任務的各種參數,如數據集、批大小、學習率、訓練輪數等。

啟動微調任務

配置文件準備好之后,我們就可以啟動微調任務了。使用以下命令啟動lora_finetune_single_device方案:

tune run lora_finetune_single_device \

--config llama2/7B_lora_single_device.yamlTorchtune會自動加載預訓練模型、Tokenizer、數據集等,并開始微調過程。在微調過程中,Torchtune會實時記錄訓練損失、評測指標、GPU使用情況等信息,方便用戶監控訓練進度和調試模型。

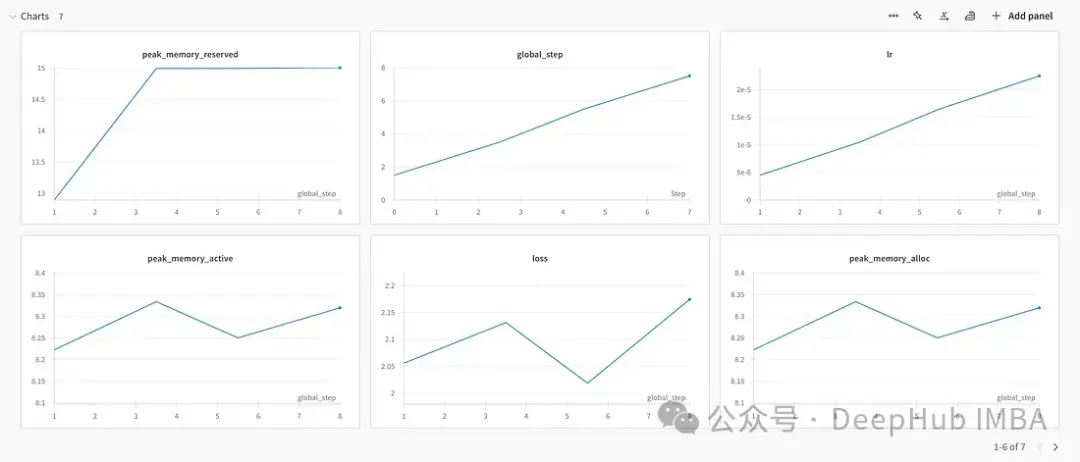

結果展示

下面是我用W&B做的示例結果,這張圖時訓練的表現

下面是內存的占用

保存和使用微調后的模型

微調完成后,我們可以使用以下命令將微調后的模型導出到指定路徑:

tune export lora_finetune_single_device \

--output_dir /path/to/output導出的模型可以直接用于下游任務的推理和服務。我們也可以將導出的模型上傳到Hugging Face Hub,方便其他用戶使用。

小結

在這一節中,我們通過一個完整的實例,展示了如何使用Torchtune微調LLM。我們使用了lora_finetune_single_device方案在單個GPU上對LLaMA-2-7B模型進行了微調。整個過程包括:

- 準備工作:安裝Torchtune,注冊Hugging Face賬號。

- 下載預訓練模型:從Hugging Face Hub下載LLaMA-2-7B模型。

- 選擇微調方案:選擇lora_finetune_single_device方案。

- 配置微調任務:修改lora_finetune_single_device方案的默認配置文件。

- 啟動微調任務:使用tune run命令啟動微調任務。

- 保存和使用微調后的模型:使用tune export命令導出微調后的模型。

可以看到,Torchtune大大簡化了LLM微調的流程,使得用戶可以通過簡單的命令行操作完成端到端的微調任務。同時,Torchtune提供了豐富的日志和可視化工具,方便用戶監控和調試訓練過程。

在接下來的內容中,我們將詳細介紹兩種參數高效的微調方法:LoRA和QLoRA。我們也會討論如何使用Torchtune實現這兩種方法。

參數高效的微調方法:LoRA和QLoRA

在前面的內容中,我們介紹了如何使用Torchtune微調LLM。然而,隨著LLM規模的不斷增長,傳統的微調方法面臨著越來越大的挑戰。以LLaMA-2-7B為例,這個模型有70億個參數,即使在現代的GPU設備上,也難以支持對所有參數的微調。因此,我們需要探索一些參數高效的微調方法,在保證微調效果的同時,降低計算和存儲開銷。

LoRA:低秩適配

LoRA(Low-Rank Adaptation)是一種參數高效的微調方法,由微軟研究院在2021年提出。LoRA的核心思想是在預訓練模型的基礎上,引入一組低秩的適配器參數。在微調過程中,我們只更新這些適配器參數,而保持預訓練模型的參數不變。這樣,我們就可以在不增加模型規模的情況下,實現對模型的微調。

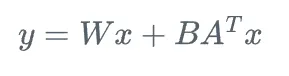

具體來說,對于預訓練模型中的每個線性層,LoRA引入兩個低秩矩陣A和B,將原始的線性變換y = Wx修改為:

其中

而r是一個遠小于d的超參數,稱為LoRA秩。在微調過程中,我們只訓練和更新矩陣A和B,而保持W不變。由于r遠小于d,因此LoRA引入的額外參數數量也遠小于原始模型的參數數量。

下面是一個使用Torchtune實現LoRA微調的示例代碼:

import torch

from torchtune.models.llama2 import llama2_7b, lora_llama2_7b

from torchtune.modules.peft.peft_utils import get_adapter_params, set_trainable_params

# 加載預訓練的LLaMA-2-7B模型

base_model = llama2_7b(weights="/path/to/llama2_7b_weights", tokenizer="/path/to/llama2_tokenizer")

# 在LLaMA-2-7B模型上應用LoRA

lora_model = lora_llama2_7b(

lora_attn_modules=['q_proj', 'v_proj'],

lora_rank=8,

lora_alpha=16

)

# 將預訓練權重加載到LoRA模型中

lora_model.load_state_dict(base_model.state_dict(), strict=False)

# 設置只有LoRA參數可訓練

lora_params = get_adapter_params(lora_model)

set_trainable_params(lora_model, lora_params)

# 使用torchtune的LoRA微調方案進行訓練

tune_command = """

tune run --nnodes 1 --nproc_per_node 2 lora_finetune_distributed --config llama2/7B_lora \

lora_attn_modules=['q_proj', 'k_proj', 'v_proj', 'output_proj'] \

lora_rank=32 lora_alpha=64 output_dir=./lora_experiment_1

"""在這個例子中,我們首先加載了預訓練的LLaMA-2-7B模型,然后在其上應用了LoRA。我們在attention層的query和value投影矩陣上引入了LoRA適配器,適配器的秩為8。接著,我們使用load_state_dict函數將預訓練權重加載到LoRA模型中,并通過set_trainable_params函數設置只有LoRA參數是可訓練的。最后,我們使用torchtune的lora_finetune_distributed方案在多個GPU上對LoRA模型進行微調。

通過引入LoRA,我們可以將微調過程中需要訓練和更新的參數數量減少到原來的1%左右,大大降低了微調的計算和存儲開銷。同時,研究表明,LoRA微調的效果與全參數微調相當,在某些任務上甚至略有提升。

QLoRA:量化LoRA

QLoRA(Quantized Low-Rank Adaptation)是LoRA的一個擴展,由華盛頓大學與英偉達合作提出。QLoRA在LoRA的基礎上,對預訓練模型的權重進行量化,進一步減少了模型的存儲開銷。

具體來說,QLoRA使用4-bit NF4(4-bit Normalized Fixed-Point)格式對預訓練模型的權重進行量化。NF4格式使用一個比特表示符號,三個比特表示尾數,動態范圍為[-8, 7]。量化后的權重只需要原來的1/8的存儲空間,但在實際使用時,需要將其解量化為全精度(FP16或FP32)格式。

下面是一個使用Torchtune實現QLoRA微調的示例代碼:

import torch

from torchtune.models.llama2 import qlora_llama2_7b

from torchtune.trainers import LoRAFinetuneTrainer

# 初始化QLoRA LLaMA-2-7B模型

qlora_model = qlora_llama2_7b(lora_attn_modules=["q_proj", "v_proj"])

# 準備QLoRA微調的Trainer

trainer = LoRAFinetuneTrainer(

model=qlora_model,

dataset_path="path_to_dataset",

output_dir="output_dir",

batch_size=2,

max_steps=1000,

logging_steps=100

)

# 開始微調

trainer.train()

# 保存微調后的模型

trainer.save_model("path_to_saved_model")這個例子與前面的LoRA微調非常類似,主要的區別在于:

- 我們使用qlora_llama2_7b函數初始化了一個QLoRA LLaMA-2-7B模型,該模型的權重是4-bit量化的。

- 我們使用LoRAFinetuneTrainer準備了一個專門用于QLoRA微調的Trainer,設置了數據集路徑、輸出路徑、批大小等參數。

- 在微調過程中,QLoRA模型的權重始終保持量化狀態,只有LoRA適配器的參數被更新。這進一步減少了微調過程中的內存消耗。

- 微調完成后,我們使用save_model函數將微調后的模型保存到指定路徑。保存的模型中包含了量化的預訓練權重和LoRA適配器參數。在實際使用時,我們需要將量化的權重解量化為全精度格式。

通過結合LoRA和量化,QLoRA可以將微調過程中的內存消耗降低到原來的1/8左右,使得在消費級GPU上微調十億規模的LLM成為可能。同時,研究表明,QLoRA微調的效果與LoRA微調相當,在某些任務上甚至略有提升。

總結

本文介紹了如何使用PyTorch的Torchtune庫進行大型語言模型(LLM)的微調。Torchtune提供了一套簡單、靈活、高效的工具和框架,使得研究人員和開發者能夠輕松地對LLM進行調試、訓練和部署。文章詳細介紹了Torchtune的設計原則、核心概念和主要特性,并通過一個完整的實例演示了如何使用Torchtune微調LLaMA-2-7B模型。此外,文章還介紹了兩種參數高效的微調方法:LoRA和QLoRA。這兩種方法通過引入低秩適配器和量化技術,大大減少了微調過程中的計算和存儲開銷,為LLM的應用開辟了新的可能性。