智能體首次達到Kaggle Grandmaster水平,華為用結構化推理補齊思維鏈短板

前些時日,AI 大模型開始掌握操作計算機的能力,但整體而言,它們與物理世界互動的能力仍處于早期階段。

為了提高 LLM 在復雜的現(xiàn)實世界中的表現(xiàn),研究者們提出了各種提示策略來提升大模型的推理和規(guī)劃能力,比如思維鏈、思維樹和思維圖譜。這些進步與工具集成一起,推動著通用 AI 智能體的發(fā)展,讓它們現(xiàn)在已經(jīng)能夠用 LLM 輸出的決策策略來解決序列決策問題(不過依然還相對簡單)。

在現(xiàn)實世界中,一個難題的解決方案往往都不是孤立存在的,而需要系統(tǒng)性的方法。這就促使人們開始研究如何讓 LLM 通過順序或并行模塊處理智能體任務,從而動態(tài)地、分步驟地解決問題。

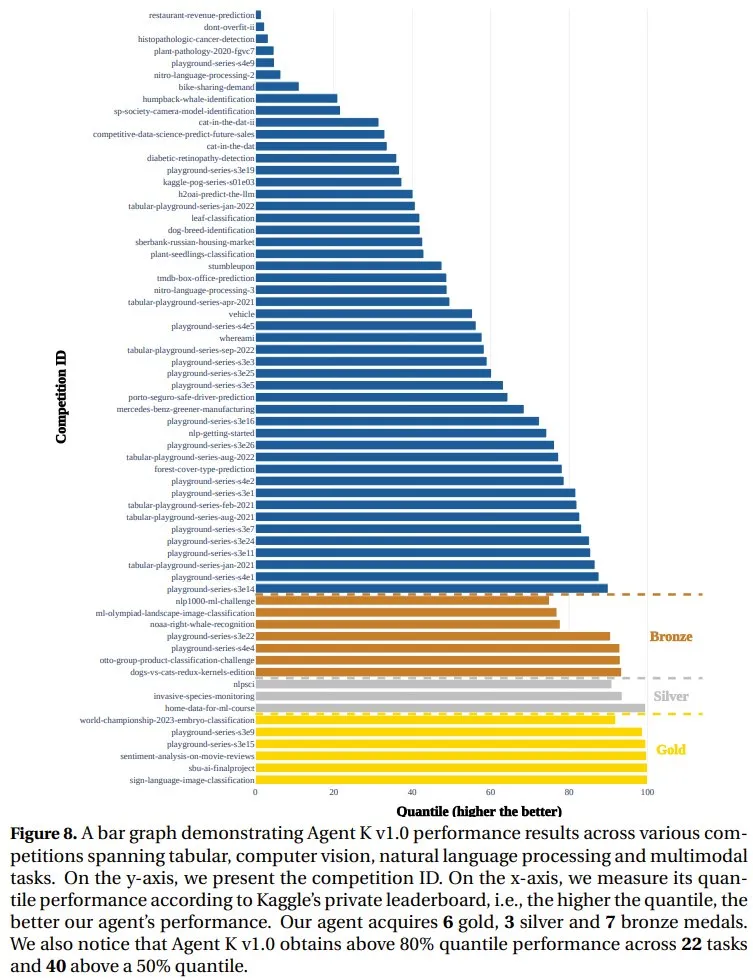

近日,華為諾亞方舟實驗室、倫敦大學學院(UCL)和達姆施塔特工業(yè)大學的一個研究團隊在這個研究方向上做出了自己的貢獻。他們采用第一性原理方法,將數(shù)據(jù)的分析、處理和預測(即數(shù)據(jù)科學)作為 LLM 與現(xiàn)實世界環(huán)境和外部系統(tǒng)交互的核心和可遷移技能,得到了一種利用 LLM 解決系統(tǒng)數(shù)據(jù)科學任務復雜性的新方法。然后他們基于此開發(fā)了智能體 Agent K v1.0,并讓其參加了多模態(tài) Kaggle 競賽。最終 Agent K v1.0 獲得了相當于 6 金 3 銀 7 銅的成績,成為首個達到 Kaggle Grandmaster level 1 的 AI 智能體。

- 論文標題:Large Language Models Orchestrating Structured Reasoning Achieve Kaggle Grandmaster Level

- 論文地址:https://arxiv.org/pdf/2411.03562

研究動機

這項研究有三個研究動機。

第一,數(shù)據(jù)科學的目的是從結構化和非結構化數(shù)據(jù)中提取見解和知識,從而解決各種復雜問題。這需要系統(tǒng)級的方法,需要自動化和優(yōu)化來適應具體的任務目標。

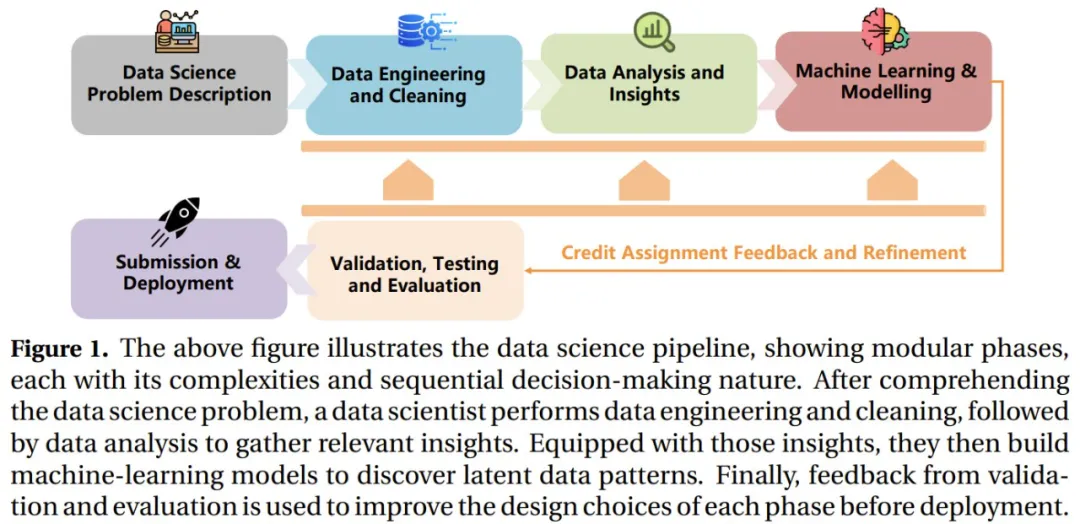

舉個例子,在 Kaggle 數(shù)據(jù)科學競賽中(如圖 1 所示),數(shù)據(jù)科學家需要遵循一個結構化的工作流程:收集、清理、預處理和標準化數(shù)據(jù),創(chuàng)建數(shù)據(jù)加載器以實現(xiàn)高效管理,生成關鍵評估指標,以及開發(fā)自定義模型。然后,這些見解和預測可以為決策和優(yōu)化提供信息。因此,為了解決這些工作流程,需要數(shù)據(jù)科學智能體將任務分解為子問題并與各種子系統(tǒng)交互以實現(xiàn)指定目標。

第二,數(shù)據(jù)能讓 LLM 感知和理解外部環(huán)境(物理和虛擬皆可)。LLM 智能體可通過收集、清理和分析這些數(shù)據(jù)來獲得有意義的見解并做出明智的決策。數(shù)據(jù)和動作之間的這種基本聯(lián)系可將計算推理與有形的現(xiàn)實世界后果聯(lián)系起來。

第三,數(shù)據(jù)科學對企業(yè)而言至關重要。數(shù)據(jù)科學可將原始數(shù)據(jù)轉換成可行動的見解,并由此提升效率和競爭力,進而推動創(chuàng)新。因此,據(jù) Grand View Research 預計,到 2031 年,全球對數(shù)據(jù)科學的投資將達到約 7400 億美元。數(shù)據(jù)科學智能體可通過生成代碼來自動執(zhí)行數(shù)據(jù)清理、建模和預測等任務,從而擴大這種影響,使組織能夠擴展其數(shù)據(jù)驅動的決策,以最大化回報和利潤。

結構化推理造就強大數(shù)據(jù)科學智能體

華為諾亞方舟實驗室首先確定了 LLM 智能體面臨的兩大難題,即自動化和優(yōu)化。這些難題源自數(shù)據(jù)科學工作流程的復雜性和多面性。

為此,該團隊提出了一種利用 LLM 解決系統(tǒng)數(shù)據(jù)科學任務復雜性的新方法。

具體來說,他們提出了一種靈活的「學習到推理」范式,從而無需反向傳播和微調就能實現(xiàn)學習和適應。

該團隊假設 LLM 具有固有的基于案例的推理能力,這讓它們可使用過去的正例或負例經(jīng)驗,并將其泛化到新任務。通過優(yōu)化這些經(jīng)驗,學習和適應可以自然地發(fā)生。

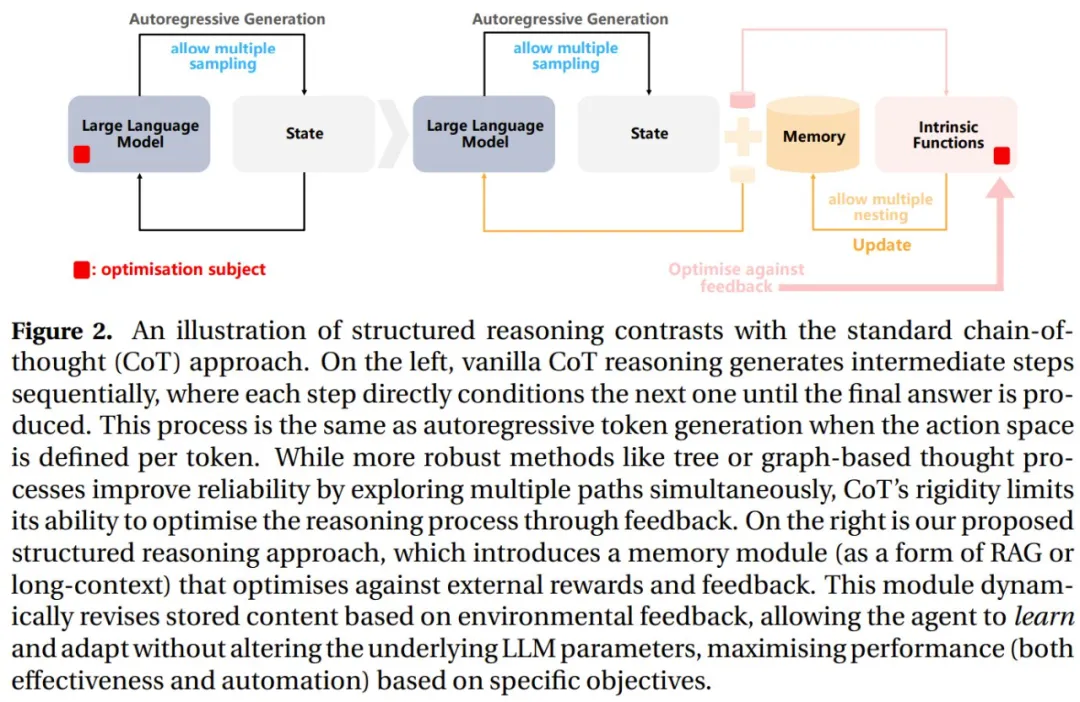

為了將這一觀察利用起來,該團隊提出了結構化推理(structured reasoning),其中集成了一個記憶模塊,從而可以動態(tài)地利用過去的成功和失敗經(jīng)驗來實現(xiàn)更據(jù)適應性的學習。這能克服思維鏈等方法的局限性。如圖 2 所示。

左側是基本思維鏈推理,其按順序生成中間步驟,其中每個步驟都是下一步驟的直接條件,直到得到最終答案。

右側是新提出的結構化推理方法,它引入了一個記憶模塊(作為 RAG 或長上下文的一種形式),可以根據(jù)外部獎勵和反饋進行優(yōu)化。該模塊可根據(jù)環(huán)境反饋動態(tài)地修改存儲的內容,讓智能體可在不改變底層 LLM 參數(shù)的情況下學習和適應,進而根據(jù)具體目標最大限度地提高性能(有效性和自動化)。

有了結構化推理之后,LLM 智能體可在內部重構自身,通過靈活和內在的(智能體內部的)自我反思功能實現(xiàn)主動推理,并在采取外部行動之前主動適應。

他們將這個智能體稱為 Agent K v1.0,這是他們的結構化推理框架 Pangu-Agent 的一個擴展,但它也是專門為應對數(shù)據(jù)科學挑戰(zhàn)設計的。

該團隊為 Agent K v1.0 引入了新的內部函數(shù)類別,以便在自動解決數(shù)據(jù)科學任務之前自動設置它們。他們還引入了另一組可與外部工具(如超參數(shù)優(yōu)化算法、集成方法、計算機視覺和自然語言處理庫)協(xié)作的內部函數(shù),從而可以最佳方式構建解答。

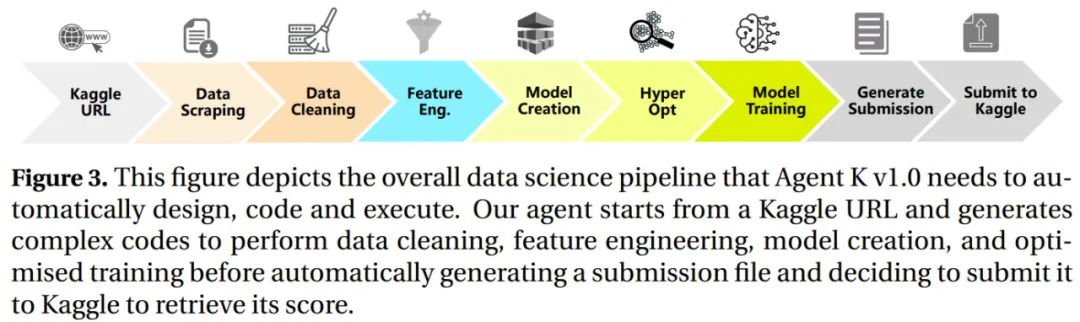

下圖展示了 Agent K v1.0 實現(xiàn)自動設計、編程和執(zhí)行所需的整體數(shù)據(jù)科學工作流程:首先從一個 Kaggle URL 開始,再生成執(zhí)行代碼清理、特征工程、模型創(chuàng)建和優(yōu)化訓練的復雜代碼,之后再自動生成一個提交文件,并將其提交給 Kaggle 以獲得分數(shù)。

第一階段(自動化):設置數(shù)據(jù)科學任務

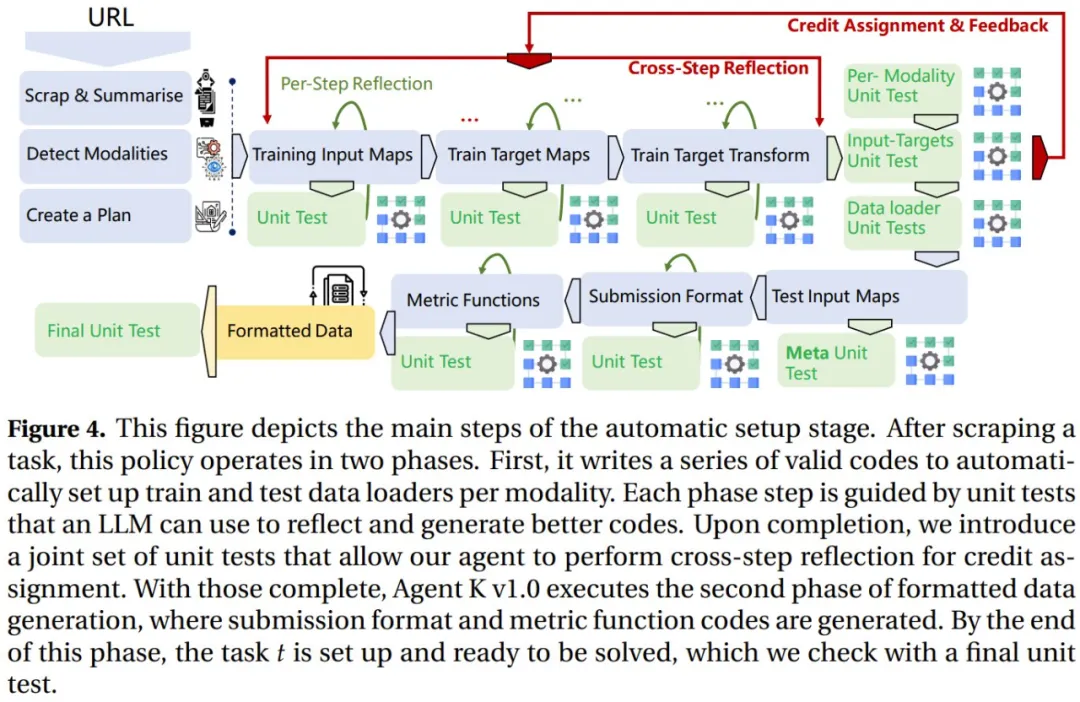

由于數(shù)據(jù)科學任務的數(shù)據(jù)類型和格式繁多,因此設置階段并不輕松。圖 4 展示了這個自動設置階段的主要步驟。

在抓取到任務后,該策略又分為兩個階段:

- 首先,編寫一系列有效代碼,以自動設置每個模態(tài)的訓練和測試數(shù)據(jù)加載器。每個階段步驟都由單元測試引導,LLM 可以使用這些單元測試來反思和生成更好的代碼。之后,引入了一組聯(lián)合單元測試,讓智能體執(zhí)行跨步驟反思以進行 credit 分配。

- 完成這些后,Agent K v1.0 執(zhí)行格式化數(shù)據(jù)生成的第二階段,其中會生成提交格式和度量函數(shù)代碼。到這個階段結束時,任務 t 已被設置好,可以解決了 —— 這里還會用一個最終單元測試來檢查。

第二階段(優(yōu)化):解決數(shù)據(jù)科學任務

數(shù)據(jù)科學工作流程的這一部分通常涉及許多步驟,包括生成腳本以預處理輸入、創(chuàng)建各種模型或優(yōu)化超參數(shù)。

由于可以進行多次嘗試,并且每個解決方案都是復合工作流程的結果,因此要實現(xiàn)非常有競爭力的性能,需要能夠推斷每個解決方案組件的優(yōu)勢和劣勢,并決定修改哪個部分或下一步嘗試什么。

在這里,該通過智能體的外部動作將這些決定留給了智能體,并使用針對數(shù)據(jù)驅動的預測設計量身定制的幾種工具為其提供支持。

第三階段(泛化):多任務和主動任務選擇

有效的智能體應該有能力解決不同領域的多種任務。該團隊還為 Agent K v1.0 配備了跨領域的任務求解能力,其做法是將之前的設置泛化到多任務設置。并且,他們注意到了多任務解決方案的不可行性,于是還提出了一種在線持續(xù)學習擴展。

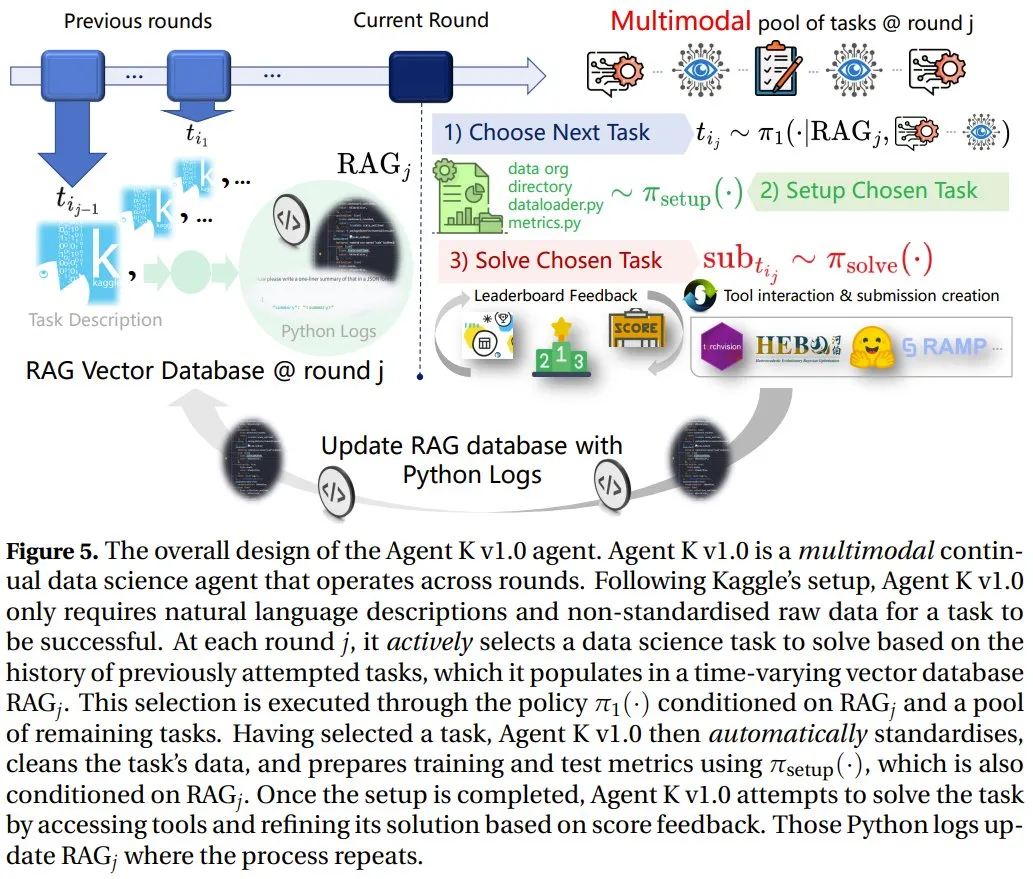

下圖展示了 Agent K v1.0 智能體的總體設計。

按照 Kaggle 的設置,Agent K v1.0 只需要自然語言描述和非標準化原始數(shù)據(jù)即可成功完成任務。在每一輪 j 中,它會根據(jù)之前嘗試過的任務的歷史記錄主動選擇要解決的數(shù)據(jù)科學任務,并將其填充到隨時間變化的向量數(shù)據(jù)庫 RAG_j 中。這種選擇是策略 π_1 (?) 基于 RAG_j 和一個剩余任務池執(zhí)行的。

選擇了任務之后,Agent K v1.0 會使用 π_setup (?) 自動執(zhí)行標準化、清理任務數(shù)據(jù)、 準備訓練和測試指標等操作。這個過程同樣基于 RAG_j。

設置完成后,Agent K v1.0 就會嘗試解決任務,這個過程會訪問工具并根據(jù)分數(shù)反饋進行改進。這些 Python 日志會對 RAG_j 進行更新,并重復此過程。

競爭性數(shù)據(jù)科學基準

當前的數(shù)據(jù)科學智能體缺乏競爭性基準測試,這限制了它們在專業(yè)領域的表現(xiàn)。為此,該團隊也做出了自己的貢獻:基于 Kaggle 競賽構建了一個多樣化且競爭性的數(shù)據(jù)科學基準,而 Kaggle 提供了 27K 個多樣化數(shù)據(jù)集、110 萬個筆記本、超過 7.7K 個預訓練機器學習模型和大約 27K 場比賽。

該基準支持在一個透明的排行榜上與人類參與者進行直接比較并涵蓋計算機視覺、自然語言處理、時間序列和表格數(shù)據(jù)等多種任務,支持多種模態(tài)。

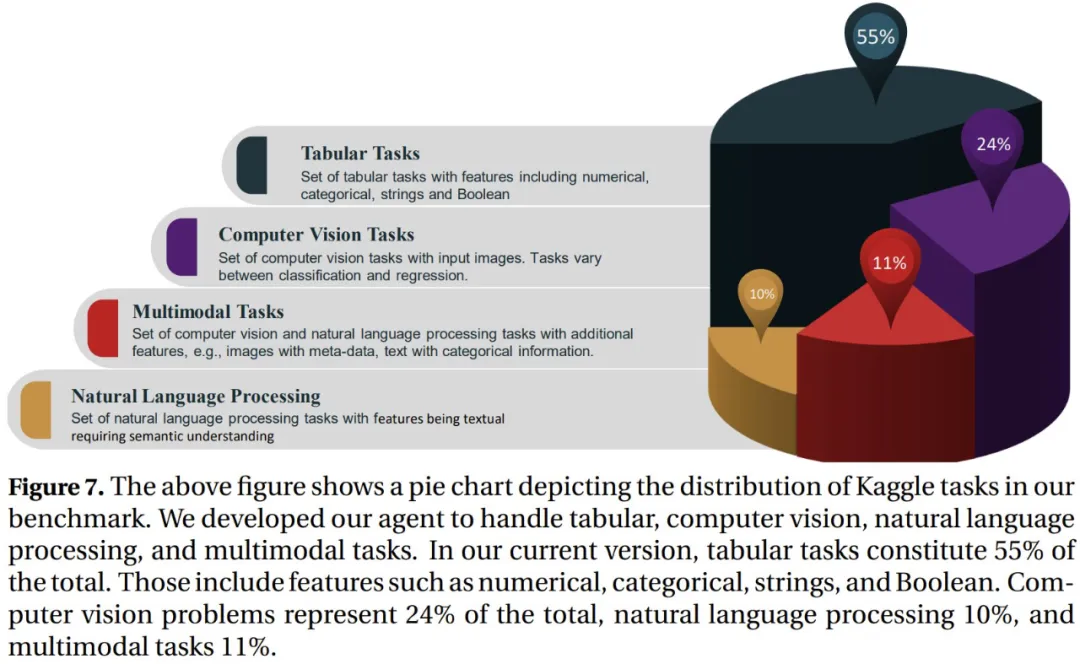

下圖展示了該基準中 Kaggle 任務的分布情況。目前,其中 55% 是表格任務,包括數(shù)值、類別、字符串和布爾值表。另外計算機視覺站 24%,自然語言處理占 10%、多模態(tài)任務占 11%。

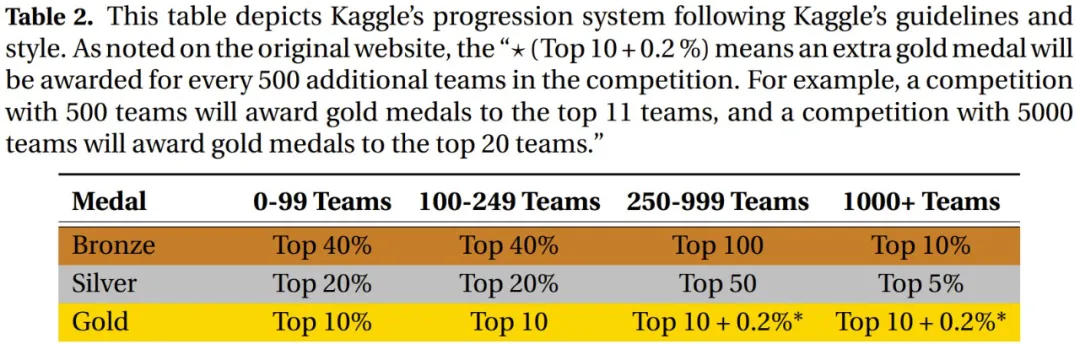

下表則是基于 Kaggle 的指南和風格構建的 Kaggle 進展系統(tǒng)。? (Top 10 + 0.2 %) 是指競賽每增加 500 個參賽隊伍,就會額外給出一枚金牌。舉個例子,如果一個競賽有 500 個參賽隊伍,則會給 11 團隊授予金牌。而如果競賽隊伍有 5000 個,則金牌數(shù)會達到 20。

實驗和結果

Agent K 表現(xiàn)如何?終究還需看實驗結果。該團隊嚴格測試了 Agent K v1.0(基礎模型使用了 Qwen-2.5 72B)實現(xiàn)完全自動化的能力以及性能。

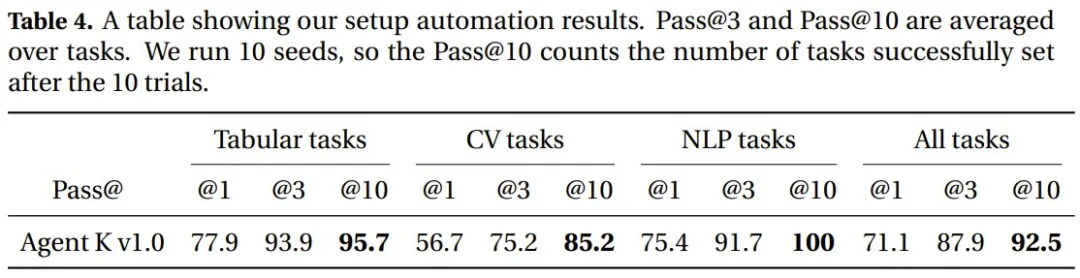

在自動化方面,他們評估了新系統(tǒng)能否有效地直接根據(jù) Kaggle URL 設置任務。結果,在跨多個領域自動執(zhí)行任務方面,該系統(tǒng)實現(xiàn)了 92.5% 的準確度,展示了其完全自動化地實現(xiàn)復雜設置的能力。

在性能方面,在多模態(tài)挑戰(zhàn)賽中,該團隊的方法實現(xiàn)了相當于 6 金 3 銀 7 銅的成績(共 65 場競賽),成為了首個達到 Kaggle Grandmaster level 1 水平的方法。下圖展示了 Agent K v1.0 在各個任務上的性能表現(xiàn)。

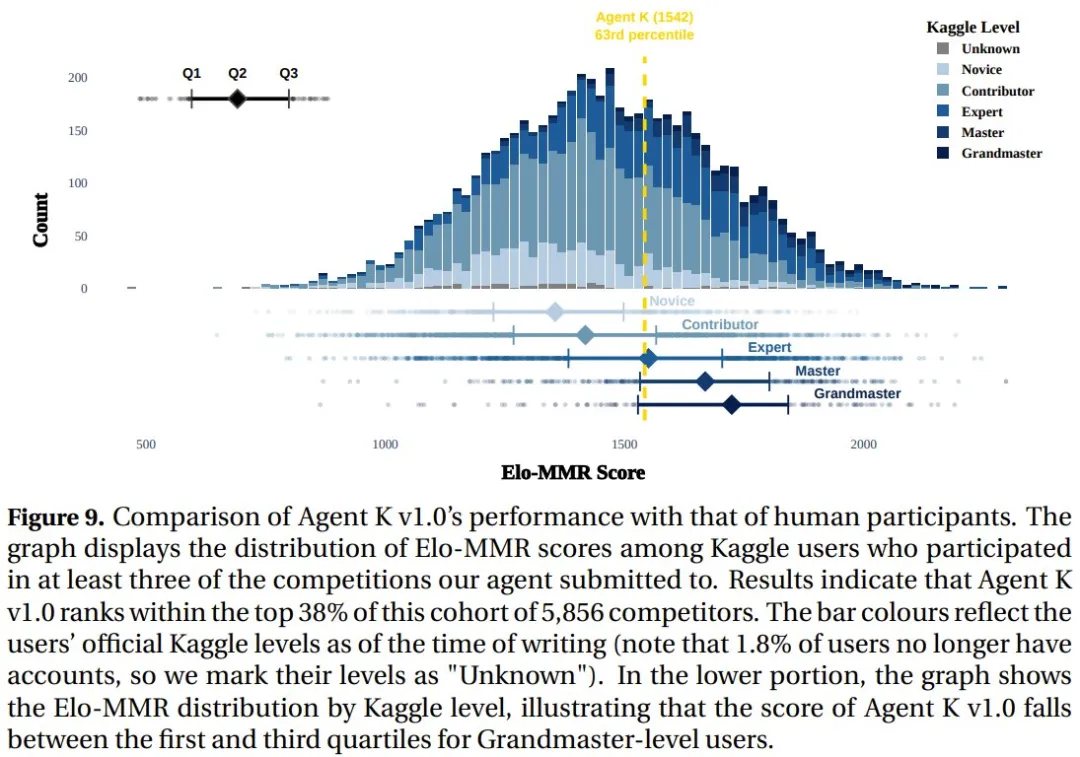

此外,他們還測量了 Agent K v1.0 與人類參與者的 Elo-MMR 評分。結果表明,在由 5856 名參賽者組成的競賽池中,Agent K v1.0 排名前 38%。

實驗詳情和更多實驗結果以及相關討論請訪問原論文。