多智能體架構Insight-V來了!突破長鏈視覺推理瓶頸

本文的主要作者來自南洋理工大學 S-Lab、騰訊公司和清華大學智能視覺實驗室。本文的共同第一作者為南洋理工大學博士生董宇昊和清華大學自動化系博士生劉祖炎,主要研究方向為多模態模型。本文的通訊作者為南洋理工大學助理教授劉子緯和騰訊高級研究員饒永銘。

大語言模型(LLMs)通過更多的推理展現出了更強的能力和可靠性,從思維鏈提示發展到了 OpenAI-o1 這樣具有較強推理能力的模型。盡管人們為改進語言模型的推理做出了種種努力,但在多模態視覺語言任務中,高質量的長鏈推理數據以及優化的訓練流程仍未得到充分的探索。

為了解決上述問題,來自南洋理工大學、騰訊、清華大學的研究者們提出一種能夠進行長鏈視覺推理的多模態模型 Insight-V。Insight-V 提供了 1)針對復雜的多模態任務,可擴展地生成冗長且可靠的推理數據;2)建立有效的訓練流程,以增強多模態語言模型的推理能力。

Insight-V 的核心創新點包括:1)一個用于生成長鏈、高質量推理數據的可擴展的數據生成流程;2)一個將視覺推理任務分解為推理和總結的多智能體系統;3)一個用于增強視覺推理能力的兩階段訓練流程。這些設計賦予了 Insight-V 較強的視覺推理能力。

- 論文:https://arxiv.org/abs/2411.14432

- 代碼:https://github.com/dongyh20/Insight-V

- 模型:https://huggingface.co/THUdyh/Insight-V-Reason

1. 介紹

現有的研究通過長鏈推理來提升語言模型(LLMs)的推理能力,已經取得了顯著進展,這在很大程度上得益于結構化、高質量數據的可獲取性以及成熟的訓練流程。相比之下,多模態語言模型(MLLMs)進行長鏈視覺推理仍然是一項重大挑戰,主要原因是缺乏大規模、高質量的數據集以及高效有效的訓練策略。與純文本數據相比,視覺推理數據不僅收集成本更高,而且由于缺乏有效的數據生成流程,還需要大量人力來進行詳細標注和驗證。此外,當前的多模態語言模型無法有效利用視覺線索進行精確的視覺推理,需要一種有效的訓練程序,使多模態語言模型在保持清晰視覺感知的同時能夠進行詳細推理。

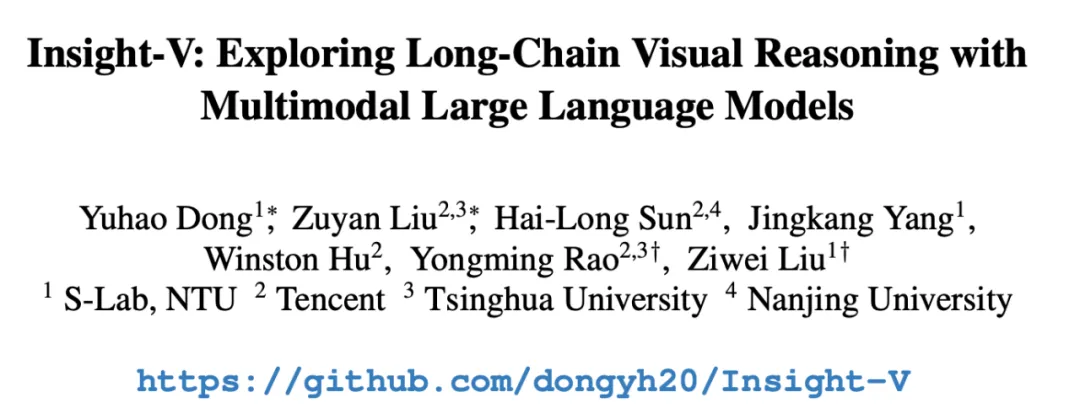

圖 1:Insight-V 方法展示。

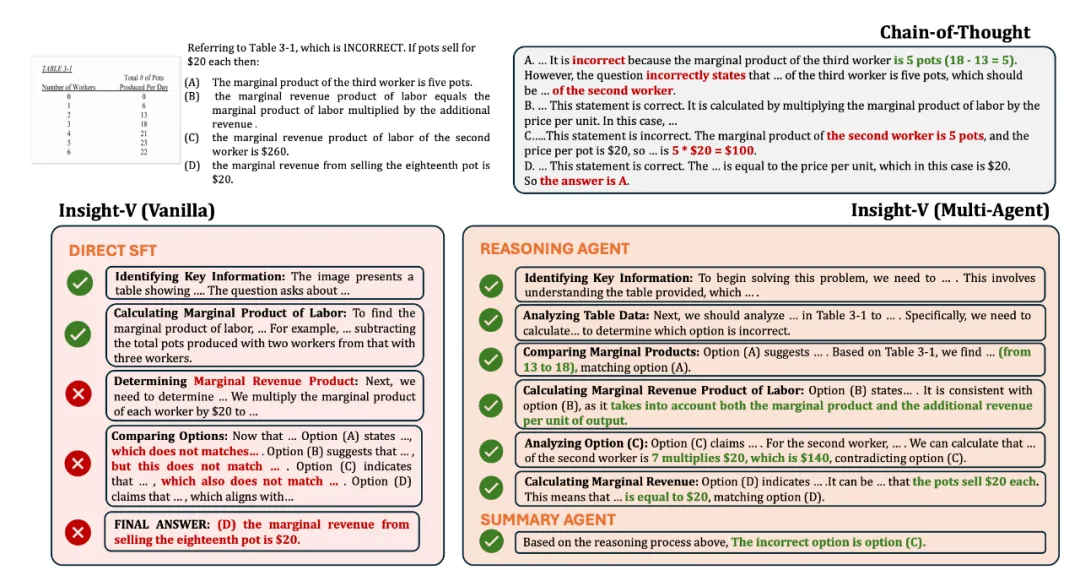

為了解決以上挑戰,本文提出了一個視覺推理的多模態系統 Insight-V,能夠實現結構化的長鏈視覺推理。如圖 1 所示,Insight-V 由兩個智能體組成,一個專門負責推理,另一個負責總結,這使得它在各類視覺推理基準測試中的性能有了顯著提升。

Insight-V 的主要貢獻包括:

- 一個用于生成長鏈、高質量推理數據的可擴展的數據生成流程。通過利用已有的模型構建數據生成流程,從而提供豐富的,可擴展的視覺推理訓練數據。

- 一個將視覺推理任務分解為推理和總結的多智能體系統。通過將視覺任務分解為推理和總結,并利用不同的模型來分別解決不同的任務,來提升視覺推理能力。

- 一個用于增強視覺推理能力的兩階段訓練流程,從而使 Insight-V 能夠在視覺推理評測集上取得優異的性能。

我們提供了 Insight-V 的模型權重,在視覺推理任務上表現出色,在 7B 規模下取得了綜合最好的結果,在部分數據集超過最先進的綜合模型和商業模型,為多模態視覺推理的發展提供了一個值得探索的方向。

2. 方法概覽

結構化推理數據構建

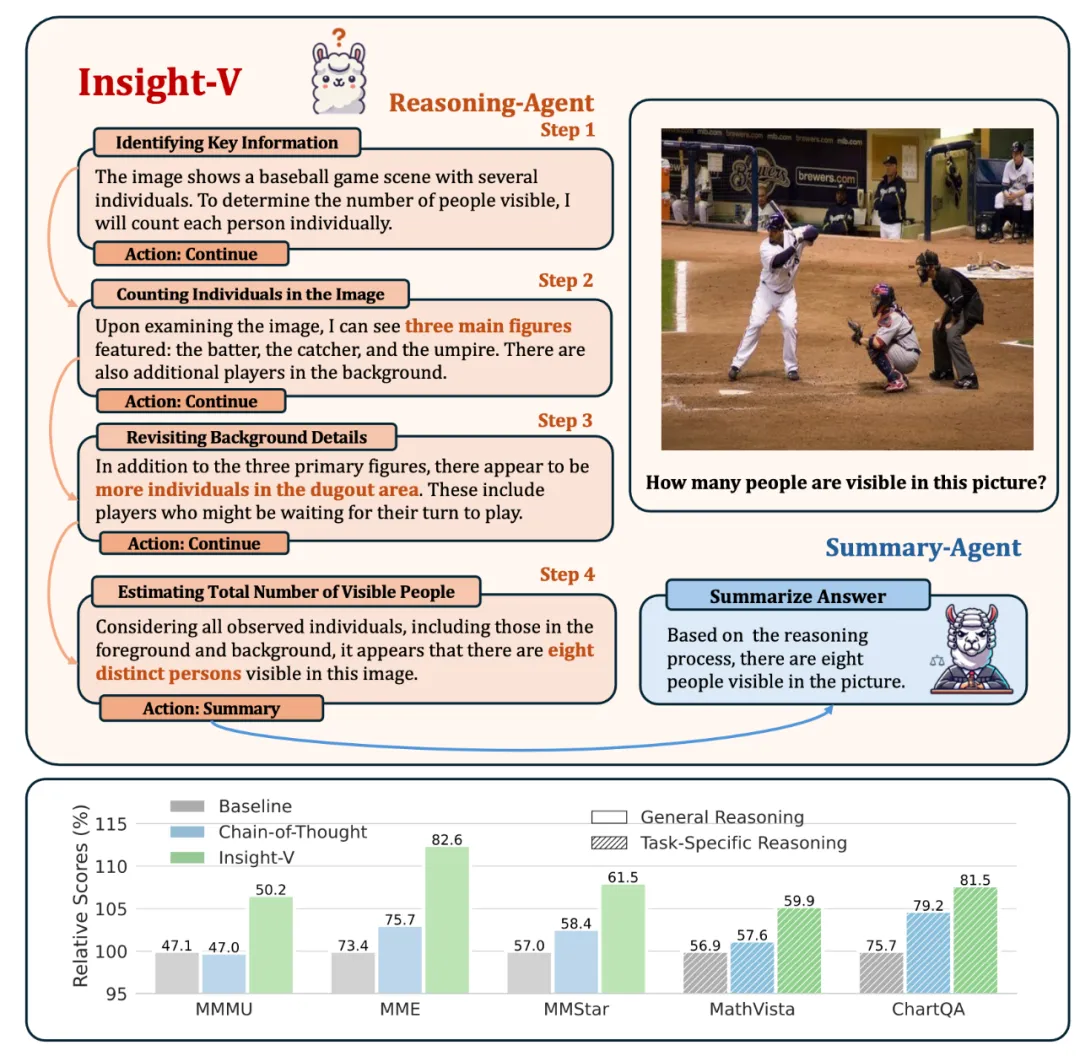

圖 2:結構化數據構建。

現有的研究已經探索了將推理能力融入多模態大型語言模型(MLLMs)中。然而,訓練 MLLMs 具備強大的推理技能仍然是一個相當大的挑戰,尤其是由于數據方面的限制。為了解決這一問題,我們介紹了提出的數據生成流程,該流程旨在通過漸進式生成過程和多粒度評估來生成高質量的長鏈推理數據。如圖 2 所示,這種可擴展的方法使我們能夠生成高質量的數據,從而有效地提升模型的推理能力。

漸進式長鏈推理數據生成。我們通過調用能力強大的多模態綜合模型,來收集單步推理結果。在每一步推理結束之后,模型根據歷史的推理結果來生成針對下一輪推理的動作,如果動作為‘繼續推理’,下一步模型繼續執行單步推理;如果動作為‘總結’,下一步模型根據歷史推理內容總結得出答案。

多粒度評估。我們通過兩個步驟來對生成的推理數據進行評估。首先,我們直接使用真實答案來對推理數據進行過濾,過濾掉最終答案錯誤的數據。之后,我們使用一個推理步驟打分模型,來針對推理數據的質量進行打分,將推理數據分為不同質量的子集,以供最后訓練數據集的構建。

模型設計

推理模型。我們提出了一種專門的推理智能體,其旨在針對輸入查詢生成一個詳細的、逐步推進的推理過程。我們通過為每個問題選取得分最高的推理路徑來構建推理數據集。在基于該數據集進行訓練之后,模型轉變為一個具有更強推理能力的推理智能體,使其能夠生成更詳細、結構化的推理過程。

總結模型。我們開發了一種對推理路徑中的不準確之處具有較強適應性的總結模型,該模型可根據需要有選擇性地納入或忽略某些元素。這種方法在最大程度發揮推理模型效能的同時,將引入誤導性信息的風險降至最低。我們利用所收集的數據集來完成總結任務,該數據集由兩類數據組成:具有最優推理過程的數據和具有有缺陷推理過程的數據。此外,為了保留原有的多模態能力,我們用標準問答數據對數據集進行補充,以維持總結智能體在直接問答方面的性能。

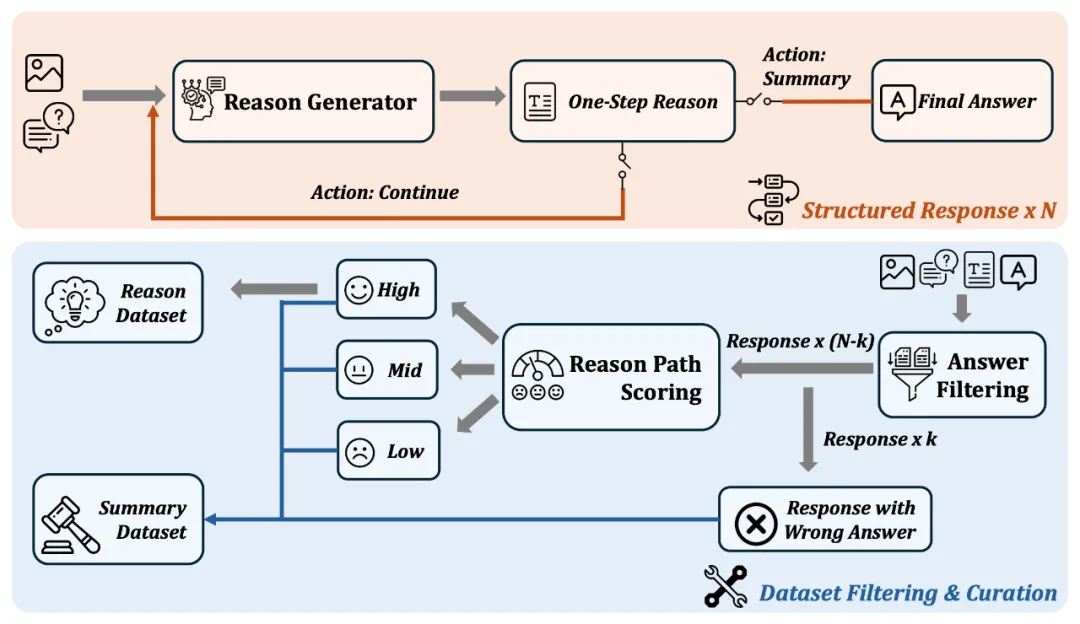

圖 3:訓練流程。

訓練策略

Insight-V 的訓練策略簡單直接。我們從一個已經訓練好的多模態模型出發,利用這個模型的權重來初始化 Insight-V 當中的兩個模型。

第一階段,我們進行多智能體系統的監督微調。對于推理模型,我們利用精心整理的推理數據集來培養逐步推理的能力。對于總結模型,我們按照上文所述構建了一個數據集,并從用于基礎模型的數據集中抽取了大約一百萬對通用的圖文組合,以保留其原有的視覺感知能力。

在第二階段,我們利用強化學習算法來進一步提升模型的推理能力。我們使用迭代式直接偏好優化(Iterative DPO)。通過進行多輪直接偏好優化(DPO)訓練和抽樣,這種方法能使該模型在訓練期間更好地模擬在線環境,從而進一步提升其性能。

3. 實驗結果

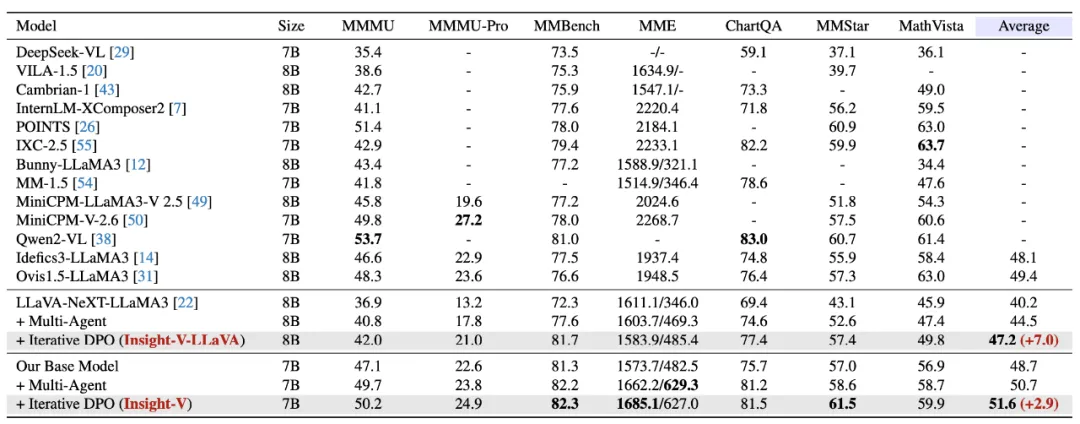

視覺推理

我們在 7 個基準測試上開展了評估實驗,涵蓋了通用推理和特定任務推理評估。當應用于 LLaVA-NeXT 和我們的基線模型時,Insight-V 展現出了顯著的有效性和通用性,大幅超越了其他最先進的大型語言模型(MLLMs)。在 MMStar 數據集中,Oryx 取得 61.5% 的平均準確率。在 MME 數據集上取得了 2312 的總分,并且在 MME 的感知和認知子任務上都取得了先進的結果。針對 7 個數據集的平均結果,Insight-V 表現出色,超越了一系列先進的模型。

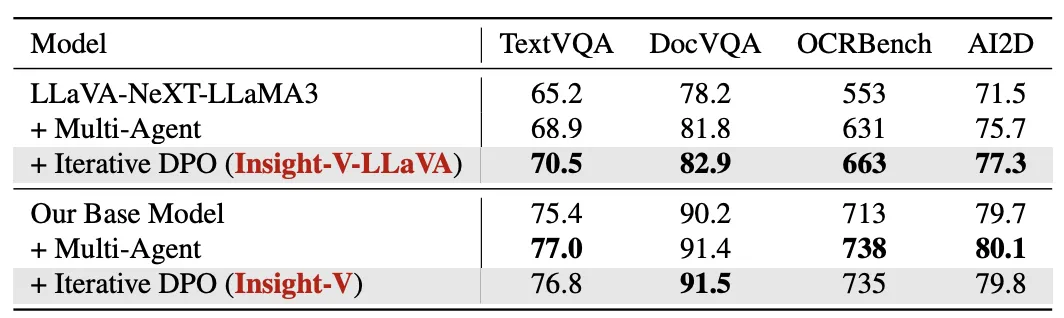

基礎視覺感知

為了更進一步測試 Insight-V 的通用性,我們在一些側重評估模型基礎視覺感知能力的數據集上進行了測試。結果表明,InsightV 在不影響一般視覺感知能力的情況下提升了推理能力,甚至在對感知能力要求更高的基準測試上也實現了性能提升。當 Insight-V 與 LLaVA-NeXT 模型結合時,在 TextVQA,DocVQA,OCRBench,AI2D 等測試集上都有顯著的性能提升,當與我們構建的更強的基礎模型結合時,在這些 benchmark 上也表現出了更好的結果。

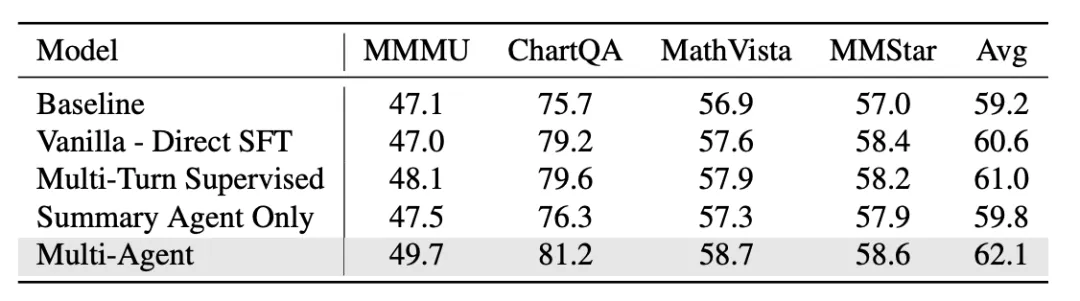

分析實驗

多智能體系統的有效性。針對 Insight-V 的設計,我們與其他可能的設計選擇進行了對比,包括直接進行微調、多輪對話監督、只訓練總結模型。結果顯示,多智能體設計的表現優于其他配置,突出了推理和總結分解的關鍵作用。

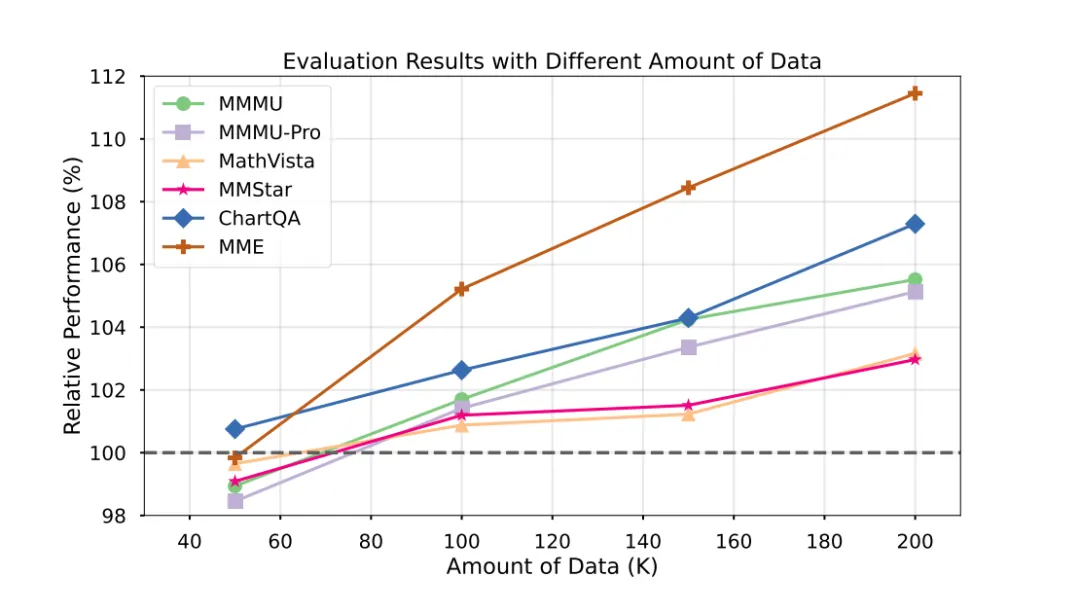

數據 Scaling Law 實驗。我們研究了數據擴展對于 Insight-V 的影響,尤其是對于推理模型的效果。結果表明,隨著推理模型訓練數據的擴展,推理模型的性能得到了顯著的提升。推理模型得益于數據擴展,能為總結模型提供更有價值的見解。

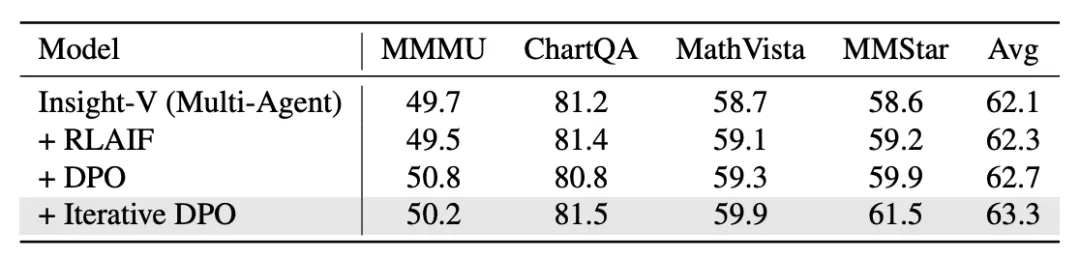

強化學習算法的效果。我們探究了不同的強化學習策略對于推理模型效果的影響。我們對比了使用 RLAIF 數據進行訓練,直接進行 DPO 以及 Insight-V 的多輪迭代式 DPO。結果顯示,相比其他方法,迭代直接偏好優化(Iterative DPO)逐步增強了模型的推理能力,從而帶來了性能的提升。

4. 案例分析

我們對 Insight-V 與思維鏈(Chain-of-Thought)以及通過直接監督微調學習進行了定性比較。對于 Insight-V 系統而言,其推理智能體能夠提供一個更加連貫且結構化的推理過程,從而引導總結智能體得出正確答案;然而,其他方法在面對復雜推理任務時會顯得吃力,無法解決這類具有挑戰性的問題。

5. 總結

在本文中,我們介紹了 Insight-V,這是一種新穎的系統,它將用于長鏈、高質量推理數據的可擴展數據生成系統與有效的多智能體訓練系統相結合,以增強多模態語言模型(MLLMs)的推理能力。通過開發該系統,我們提供了一種旨在提高推理性能的可擴展模型訓練方法。我們在各種基準測試中的廣泛評估證明了我們這種方法的有效性,為賦予多模態語言模型更強的推理能力鋪平了道路。