即插即用ChatTracker:多模態大模型重塑目標跟蹤

寫在前面 & 筆者的個人理解

視覺對象跟蹤旨在基于初始邊界框在視頻序列中定位目標對象。最近,視覺語言(VL)跟蹤器已經提出利用額外的自然語言描述來增強各種應用中的通用性。然而,VL跟蹤器在跟蹤性能方面仍然不如最先進的視覺跟蹤器(SoTA)。我們發現,這種劣勢主要是由于他們嚴重依賴手動文本注釋,其中包括頻繁提供模糊的語言描述。在本文中,我們提出了ChatTracker,利用多模態大語言模型(MLLM)中豐富的世界知識來生成高質量的語言描述并提高跟蹤性能。為此,我們提出了一種新的基于反射的提示優化模塊,通過跟蹤反饋迭代地改進目標的模糊和不準確的描述。為了進一步利用MLLM產生的語義信息,提出了一種簡單而有效的VL跟蹤框架,該框架可以很容易地集成為即插即用模塊,以提高VL和視覺跟蹤器的性能。實驗結果表明,我們提出的ChatTracker實現了與現有方法相當的性能。

總結來說,本文的主要貢獻如下:

- 我們提出了ChatTracker,這是一種利用MLLM進行視覺對象跟蹤的新框架。據我們所知,這是將MLLM納入跟蹤框架的第一項工作。它為現有的視覺和VL跟蹤器提供了即插即用的模塊增強功能,計算開銷有限。

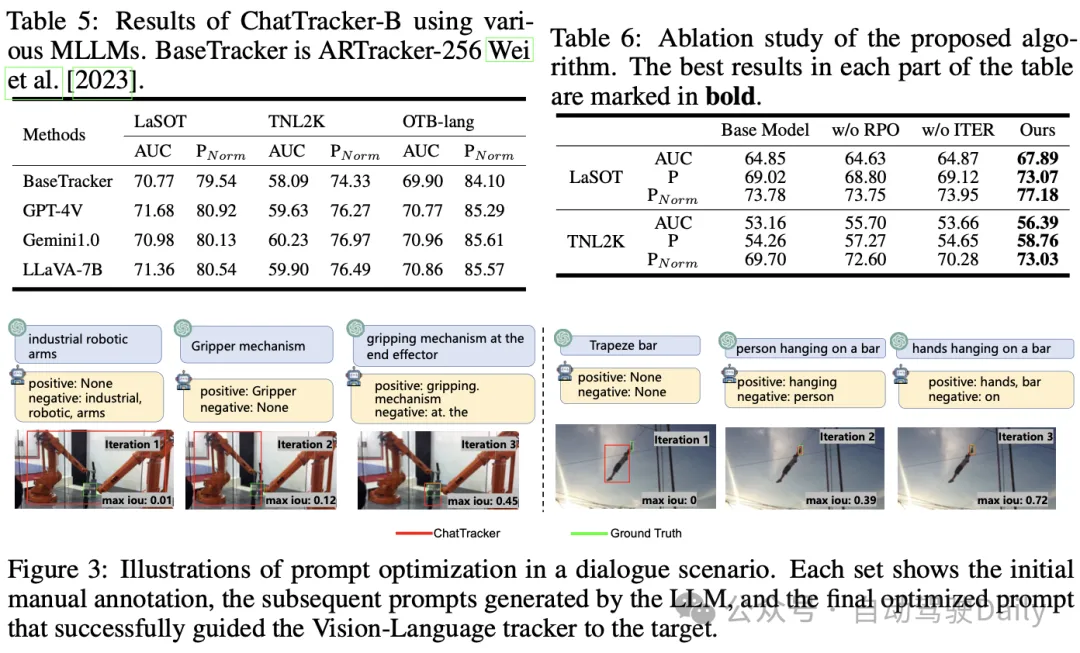

- 我們引入了一個基于反射的提示優化(RPO)模塊,以縮小VL跟蹤器和MLLM之間的知識差距。通過反思跟蹤反饋,RPO模塊可以迭代優化MLLM的提示,最終為跟蹤目標生成準確和相關的描述。與數據集中的人工標注文本相比,這些描述在跟蹤性能和圖像文本對齊方面都更優越。

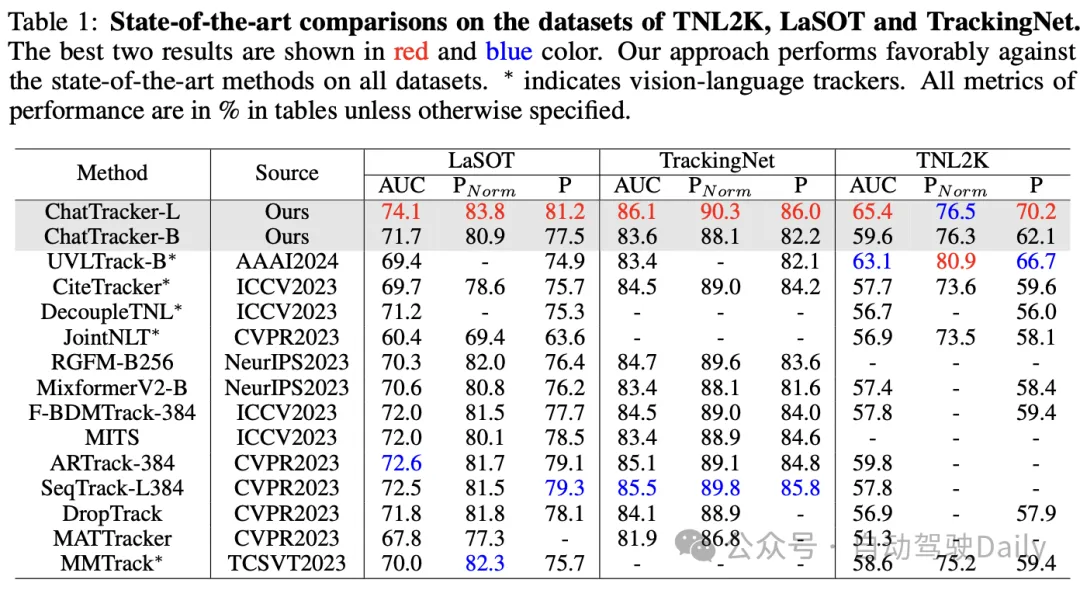

- 我們提出的ChatTracker在多個跟蹤數據集上實現了SoTA性能。我們進行了廣泛的實驗,包括消融研究,以證明所提出的方法及其各個模塊的有效性。

相關工作回顧

Vision-Language Trackers

視覺語言跟蹤方法Zhou等人、Ma和Wu等人探索了使用語言線索來增強視覺對象跟蹤。這些方法可以根據其文本來源進行分類:使用手動注釋文本的方法和從預定義詞典生成描述的方法。在第一類中,手動注釋文本已被廣泛用于目標跟蹤任務。LaSoT、TNL2K和MGIT等數據集為每個序列提供了手動注釋的語言描述。SNLT跟蹤器利用視覺和語言描述來預測目標狀態,然后動態組合這些預測以產生最終結果。JointNLT將視覺基礎和自然語言引導的跟蹤相結合,有效地滿足了這兩個過程的不同要求。第二類利用預定義的詞典生成語言描述。CiteTracker精心開發了一個類別詞匯表,其中包括目標的顏色、紋理和材料等屬性。在跟蹤過程中,它使用CLIP來比較圖像和文本之間的相似性,選擇與圖像非常匹配的文本作為目標的描述。與這些方法相反,我們的工作專門采用MLLM來獲取目標的精確文本描述。這種方法有效地消除了對手動文本注釋或預定義詞典的依賴。

Large Language Model in Vision Tasks

大語言模型(LLM),如ChatGPT和Llama是在廣泛的互聯網規模文本上訓練的自回歸模型。它們在權重中包含了廣泛的世界知識。最近,GPT-4V發布,因其出色的多模態感知和推理能力而立即引起了社區的關注。在此之后,使用CLIP模型對圖像進行分類,提高了分類任務的精度。這些進步主要針對基本的視覺識別,如分類和檢測。在這項工作中,我們致力于將LLM中包含的豐富世界知識整合到視覺對象跟蹤領域。

ChatTracker方法詳解

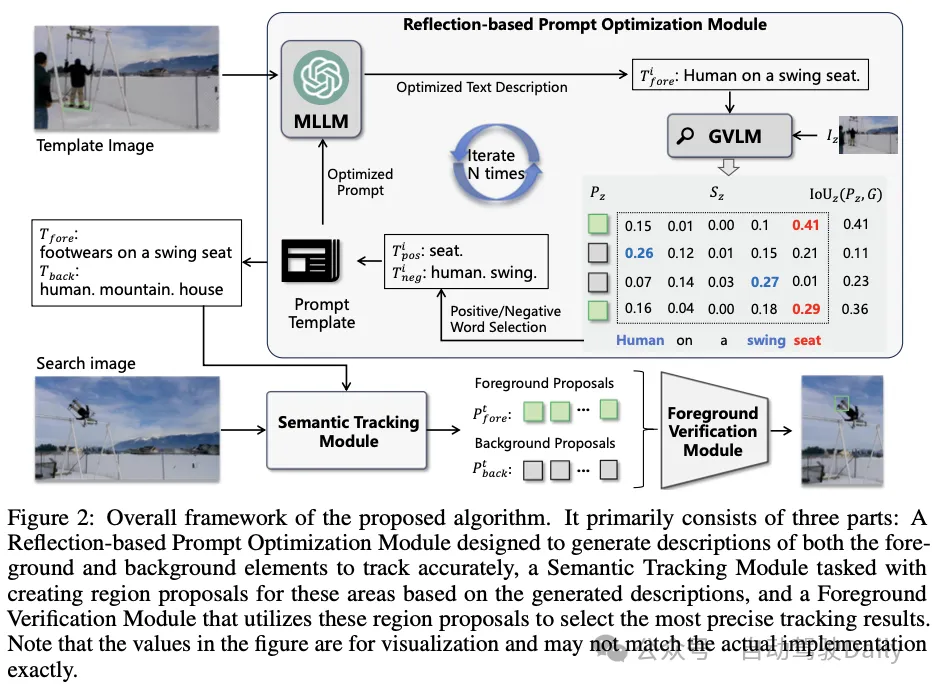

所提出的ChatTracker由三個部分組成:基于反射的提示優化(RPO)模塊、語義跟蹤模塊和前景驗證模塊。

Reflection-based Prompt Optimization Module

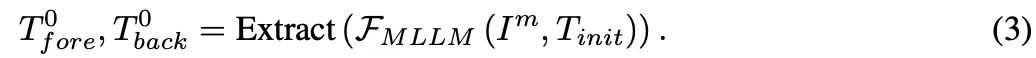

初始化。我們在第一幀I1中的跟蹤目標上繪制一個綠色邊界框,創建一個新的圖像輸入Im。預定義的人工提供的提示模板Tinit和Im被輸入到MLLM中,從而對前景和背景進行初始描述:

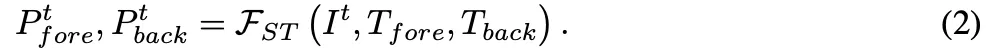

語義跟蹤模塊還包括一個現成的單對象視覺跟蹤器。最后,前景驗證模塊通過考慮前景建議、背景建議和模板之間的關系,選擇置信度最高的前景建議作為跟蹤結果。

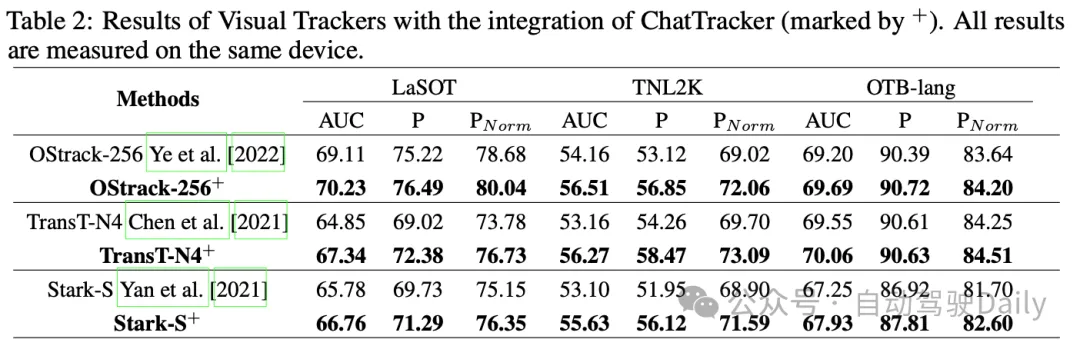

實驗結果

結論

在這項工作中,我們介紹了ChatTracker,這是第一種利用多模態大語言模型(MLLM)來提高視覺跟蹤性能的方法。我們提出了一種基于反射的提示優化(RPO)模塊,通過跟蹤反饋迭代地改進目標的模糊和不準確的語言描述。此外,提出了一種簡單而有效的視覺語言跟蹤框架,作為即插即用的方法來提高現有跟蹤器的性能。在多個數據集上的實驗結果表明,我們的方法優于最先進的方法。這表明,將MLLM納入視覺跟蹤對提高跟蹤性能有顯著效果。