「學(xué)術(shù)版ChatGPT」登場(chǎng)!Ai2打造科研效率神器OpenScholar,讓LLM幫你搞定文獻(xiàn)綜述

LLM集成到搜索引擎中,可以說(shuō)是當(dāng)下AI產(chǎn)品的一個(gè)熱門(mén)落地方向。

前有Perplexity橫空出世,后有谷歌Gemini和OpenAI的SearchGPT紛紛加入。

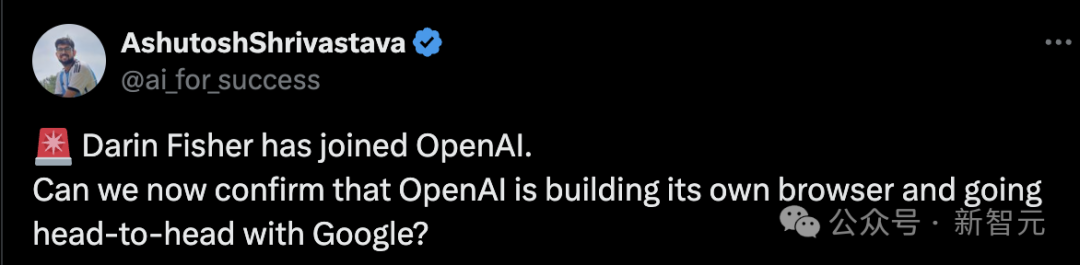

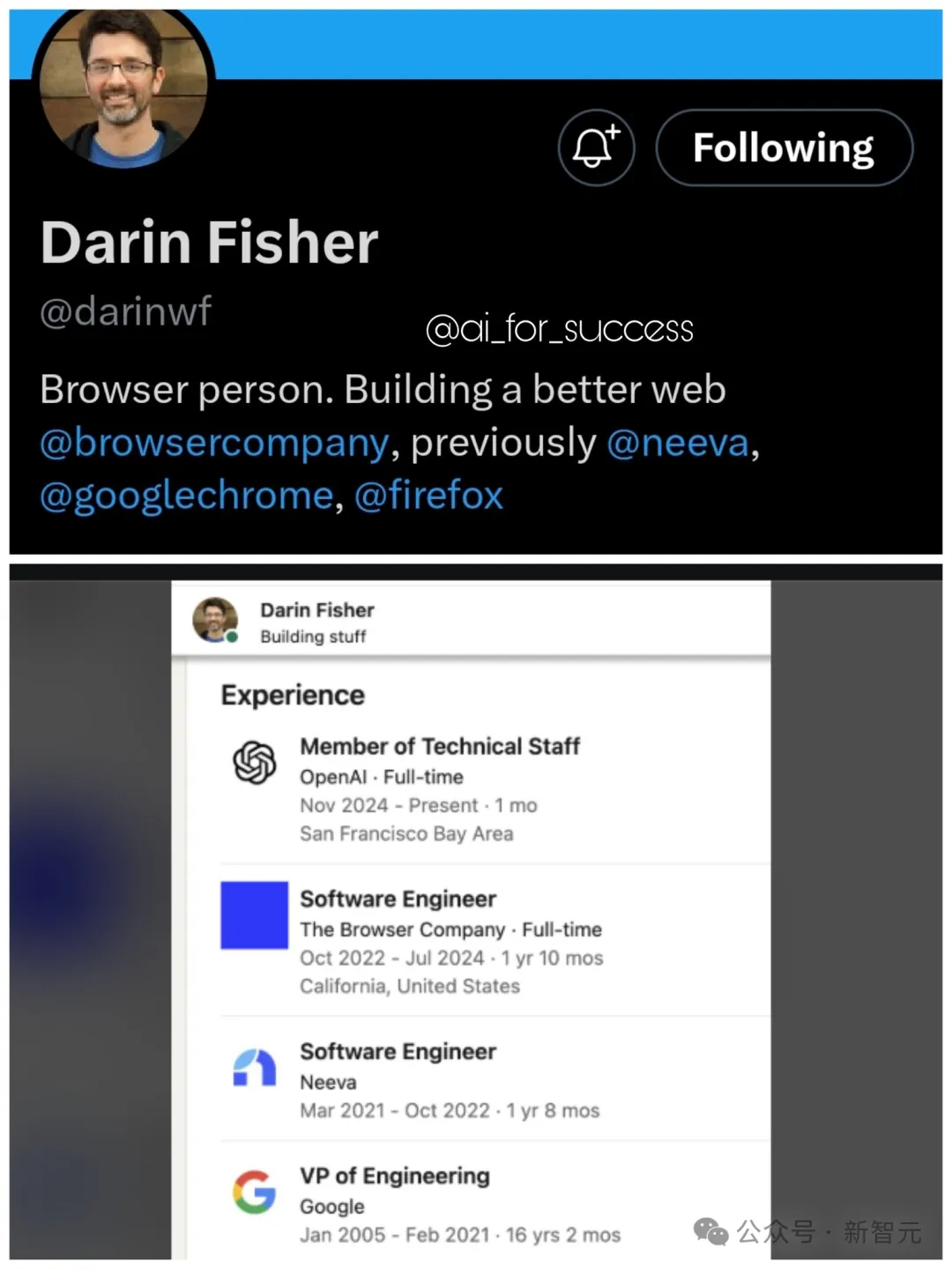

就在11月23日,有人發(fā)現(xiàn)搜索引擎大佬Darin Fisher正式加入OpenAI,這讓人更加確信:SearchGPT只是一個(gè)開(kāi)始,OpenAI也許會(huì)正式打造以LLM為基礎(chǔ)的搜索引擎和瀏覽器,和谷歌展開(kāi)一場(chǎng)正面battle。

圖片

圖片

圖片

圖片

雖然當(dāng)下的LLM可以應(yīng)付大多數(shù)場(chǎng)景下的常識(shí)問(wèn)答,但在學(xué)術(shù)打工人眼中,用AI進(jìn)行文獻(xiàn)搜索依舊缺陷重重,還是傳統(tǒng)的谷歌搜索和谷歌學(xué)術(shù)更好用。

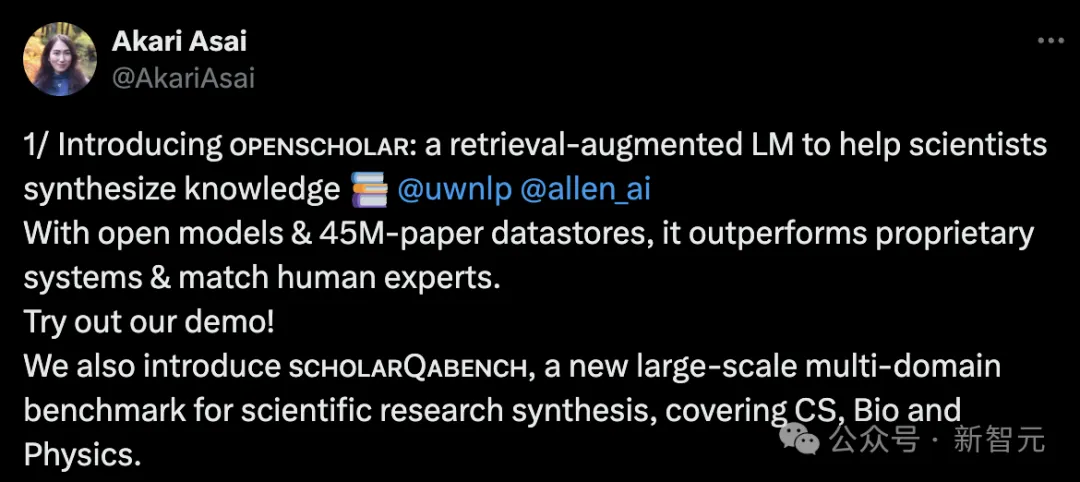

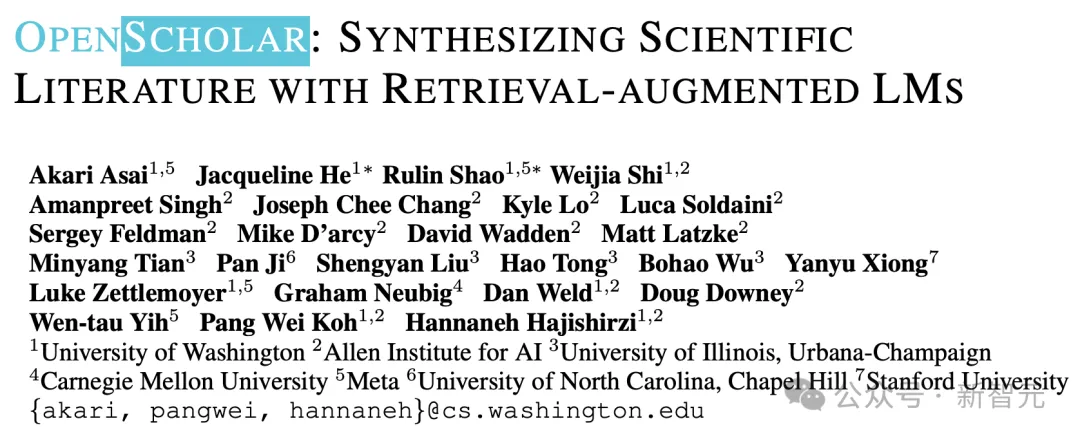

為了填補(bǔ)這方面的空白,華盛頓大學(xué)NLP實(shí)驗(yàn)室和Ai2、Meta等機(jī)構(gòu)合作,開(kāi)發(fā)了專(zhuān)門(mén)服務(wù)科研人的學(xué)術(shù)搜索工具OpenScholar。

圖片

圖片

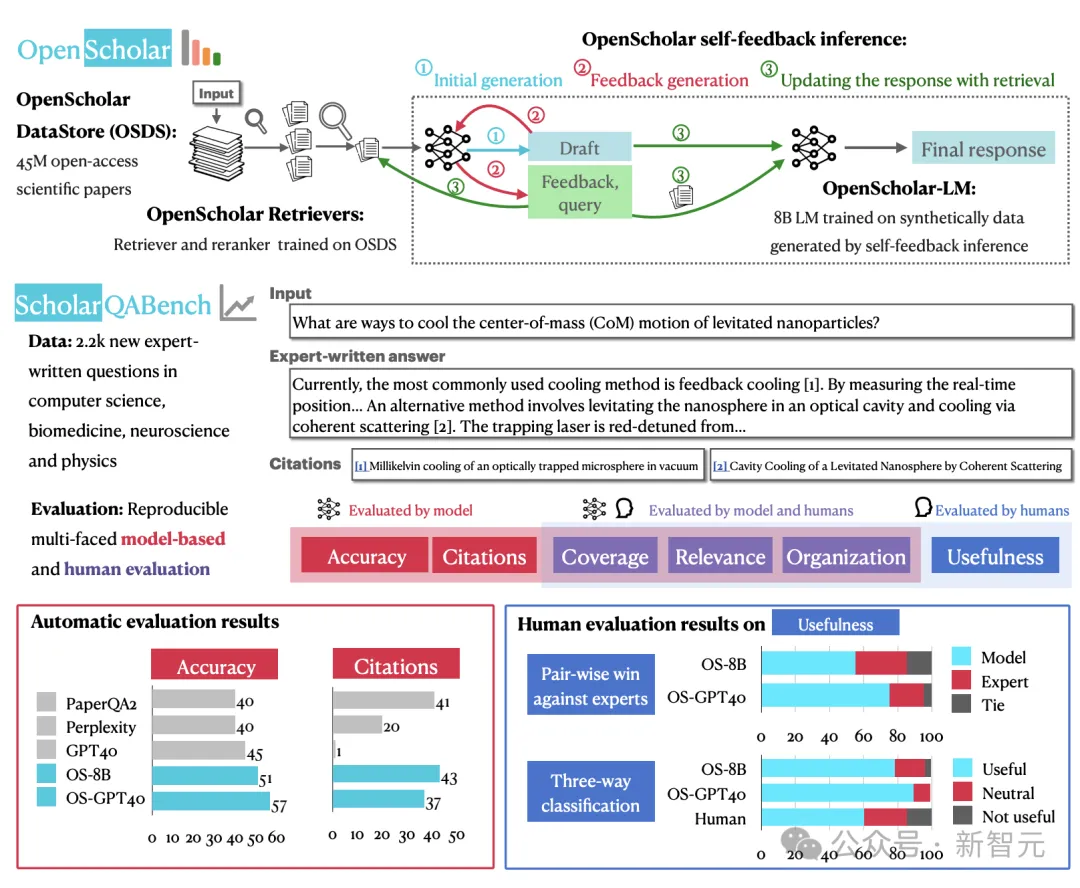

本質(zhì)上,OpenScholar是一個(gè)進(jìn)行過(guò)檢索增強(qiáng)的語(yǔ)言模型,外接一個(gè)包含4500萬(wàn)篇論文的數(shù)據(jù)庫(kù),性能可以優(yōu)于專(zhuān)有系統(tǒng),甚至媲美人類(lèi)專(zhuān)家。

為了方便自動(dòng)化評(píng)估,團(tuán)隊(duì)還一道推出了全新的大規(guī)模基準(zhǔn)ScholarQABench,覆蓋了CS、生物、物理等多個(gè)學(xué)科,用于評(píng)價(jià)模型在引用準(zhǔn)確性、涵蓋度和質(zhì)量的等方面的表現(xiàn)。

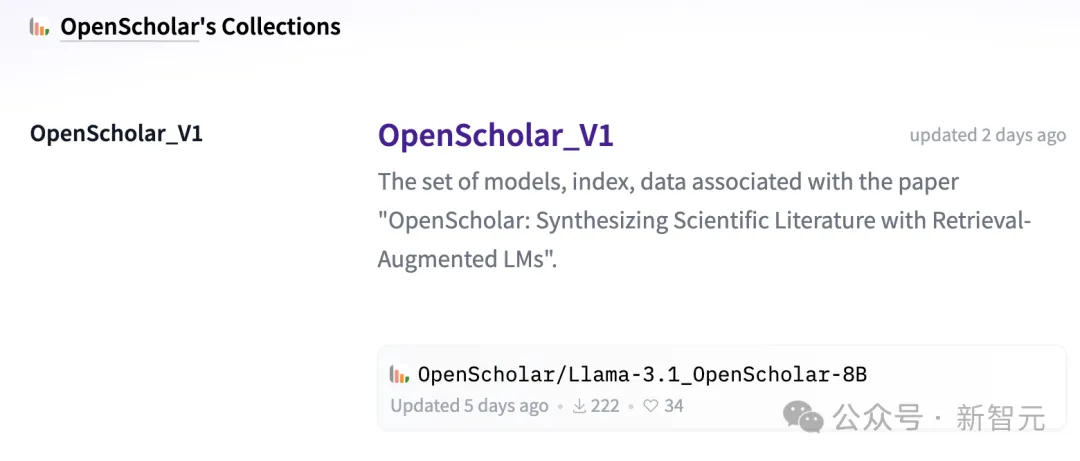

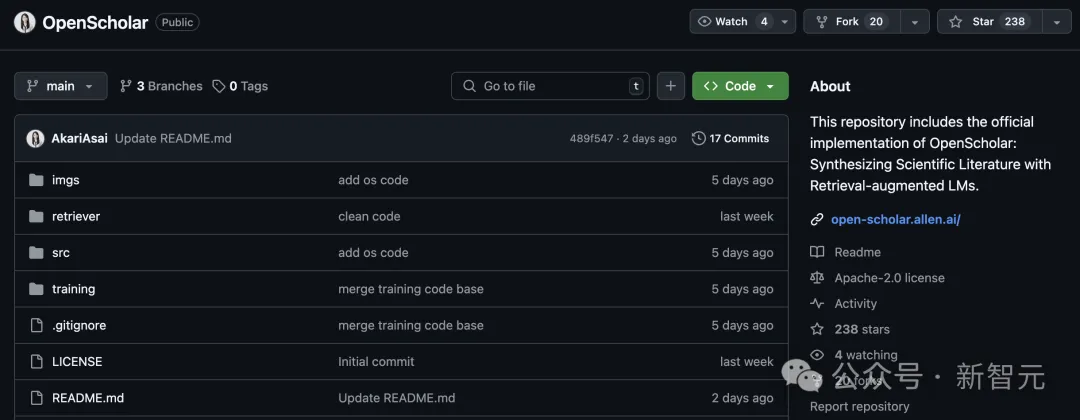

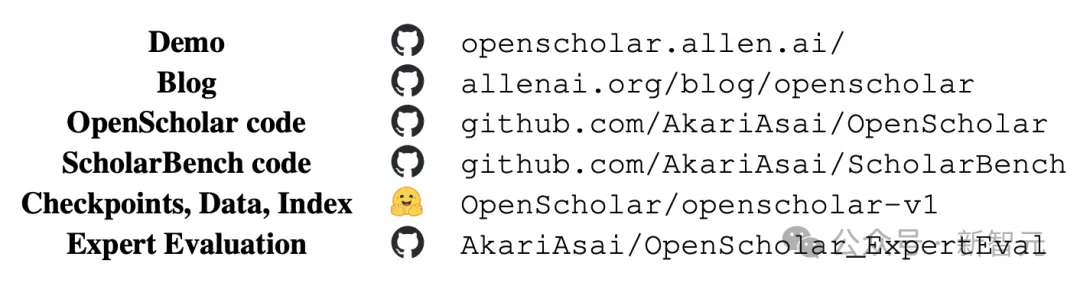

由UWNLP和Ai2兩大頂流機(jī)構(gòu)聯(lián)手,OpenScholar在開(kāi)源方面幾乎做到了無(wú)懈可擊。不僅放出了訓(xùn)練數(shù)據(jù)、代碼和模型檢查點(diǎn),還有ScholarQABench的全部數(shù)據(jù),以及用于專(zhuān)家評(píng)估的自動(dòng)化腳本。

圖片

圖片

倉(cāng)庫(kù)地址:https://huggingface.co/collections/OpenScholar/openscholar-v1-67376a89f6a80f448da411a6

圖片

圖片

倉(cāng)庫(kù)地址:https://github.com/AkariAsai/OpenScholar

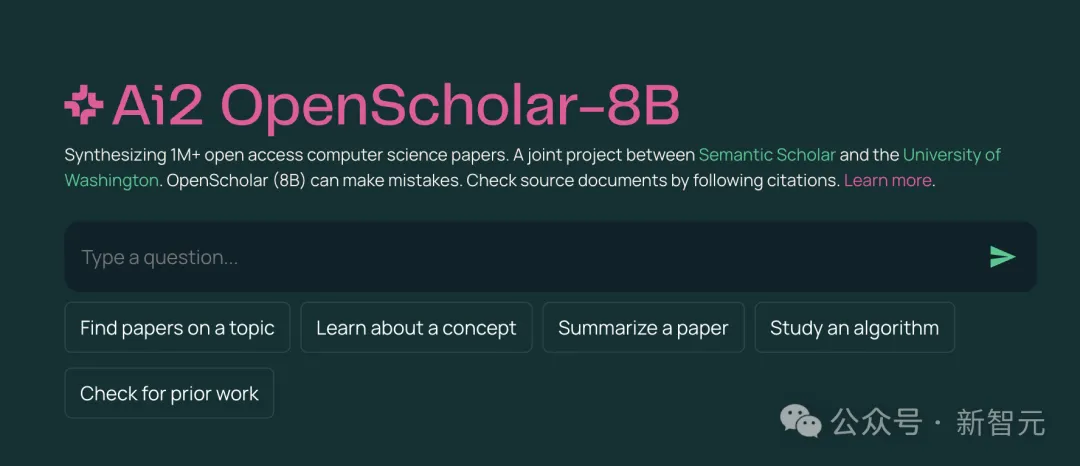

論文開(kāi)頭就給出了全部網(wǎng)址,此外團(tuán)隊(duì)還構(gòu)建了一個(gè)公開(kāi)可用的搜索demo,基于一個(gè)參數(shù)量為8B的語(yǔ)言模型,綜合了超過(guò)100萬(wàn)篇CS領(lǐng)域的專(zhuān)業(yè)文獻(xiàn)。

圖片

圖片

圖片

圖片

demo傳送門(mén):https://openscholar.allen.ai/

OpenScholar介紹

圖片

圖片

論文地址:https://arxiv.org/abs/2411.14199

閱讀文獻(xiàn)是科研工作的重要部分,不僅能知道同行們的最前沿進(jìn)展,也是構(gòu)建自己創(chuàng)新idea的重要來(lái)源。科學(xué)的進(jìn)步,依賴于研究者們綜合不斷增長(zhǎng)的文獻(xiàn)的能力。

然而,隨著發(fā)表的文獻(xiàn)數(shù)量越來(lái)越多,全部通讀已經(jīng)是不可能完成的任務(wù),因此就需要依賴實(shí)時(shí)更新的搜索工具,并能給出信息的準(zhǔn)確來(lái)源。

雖然LLM在成為科研助手方面非常有前景,但也面臨著重大挑戰(zhàn),包括幻覺(jué)、過(guò)于依賴過(guò)時(shí)的預(yù)訓(xùn)練數(shù)據(jù),并且缺乏透明的信息出處,條條對(duì)科研領(lǐng)域都是重大弊病。

就拿幻覺(jué)來(lái)說(shuō),實(shí)驗(yàn)中讓GPT-4引用最新文獻(xiàn)時(shí),它在CS、生物醫(yī)學(xué)等領(lǐng)域偽造引用的情況達(dá)到了78%~90%。

檢索增強(qiáng)(retrieval-augmented)的語(yǔ)言模型可以在推理時(shí)檢索并集成外部知識(shí)源,從而緩解上述問(wèn)題。然而,許多此類(lèi)系統(tǒng)依賴于黑盒API或通用的LLM ,既沒(méi)有針對(duì)文獻(xiàn)綜合的任務(wù)進(jìn)行優(yōu)化,也沒(méi)有搭配適合科研的開(kāi)放式、領(lǐng)域特定的檢索數(shù)據(jù)庫(kù)。

此外,LLM在科研文獻(xiàn)綜合任務(wù)上的評(píng)估也存在限制,現(xiàn)有的基準(zhǔn)大多規(guī)模較小或只針對(duì)單個(gè)學(xué)科,或者使用了過(guò)于簡(jiǎn)化的任務(wù)(如選擇題問(wèn)答)。

OpenScholar的提出就是旨在解決上述問(wèn)題。模型在推理時(shí)會(huì)檢索相關(guān)段落,并使用迭代式自反饋的生成方法來(lái)優(yōu)化輸出;搭配的專(zhuān)門(mén)基準(zhǔn)ScholarQABench旨在對(duì)開(kāi)放式科學(xué)問(wèn)答進(jìn)行現(xiàn)實(shí)且可重復(fù)的評(píng)估。

圖片

圖片

OpenScholar概述、ScholarQABench概述和自動(dòng)化&人類(lèi)專(zhuān)家評(píng)估結(jié)果

模型概述

對(duì)于OpenScholar而言,問(wèn)題定義如下:

給出一個(gè)科學(xué)查詢x ,任務(wù)是識(shí)別相關(guān)論文,綜合他們的發(fā)現(xiàn),并生成響應(yīng)y,其中應(yīng)附有一組引文, ??=c1, c2 ,…, cK。

為了遵循科學(xué)寫(xiě)作的標(biāo)準(zhǔn)實(shí)踐 ,每個(gè)引用ci對(duì)應(yīng)于現(xiàn)有科學(xué)文獻(xiàn)中的特定段落,并應(yīng)作為內(nèi)嵌引用提供,鏈接到相關(guān)文本范圍y。這些引文使研究人員能夠?qū)⑤敵鲎匪莸皆嘉墨I(xiàn),確保透明度和可驗(yàn)證性。

為了確保能檢索到相關(guān)論文并生成高質(zhì)量的輸出,OpenScholar由三個(gè)關(guān)鍵組件組成:數(shù)據(jù)庫(kù)?? 、檢索器? ,和負(fù)責(zé)生成的語(yǔ)言模型?? 。

推理過(guò)程從檢索器?開(kāi)始 ,它從包含大量已發(fā)表文獻(xiàn)的數(shù)據(jù)庫(kù)??中,根據(jù)與輸入查詢的語(yǔ)意相關(guān)性 x檢索到一組段落 ??={p1,p2,…,pN},作為下一步的上下文。

然后,負(fù)責(zé)生成的語(yǔ)言模型??根據(jù)段落??和輸入查詢x產(chǎn)生輸出y以及相應(yīng)的引文??, 這個(gè)過(guò)程可以形式化表示為:

其中,??中但每個(gè)ci對(duì)應(yīng)檢索到的特定段落?? ,負(fù)責(zé)生成的LM可以被靈活替換為各種縣城的模型,比如GPT-4o。

看起來(lái),OpenScholar的檢索和推理流程基本復(fù)刻了經(jīng)典RAG的流水線,但團(tuán)隊(duì)做出了以下兩方面的貢獻(xiàn):

- 新訓(xùn)練出了小而高效的生成模型OpenScholar-LM

- 開(kāi)發(fā)了自反饋檢索增強(qiáng)推理(elf-feedback retrieval-augmented inference),以提高可靠性和引用準(zhǔn)確性

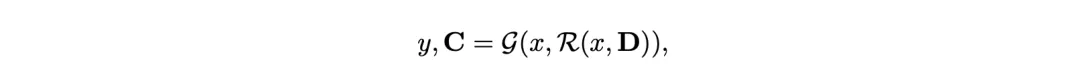

檢索與推理

檢索流程如下圖左半部分所示,由數(shù)據(jù)存儲(chǔ)??、bi-encoder檢索器θb_i,以及cross-encoder重排序器 θcross組成。最終,從數(shù)據(jù)庫(kù)??的4500萬(wàn)篇論文中篩選出N個(gè)最相關(guān)的段落。

圖片

圖片

在標(biāo)準(zhǔn)的檢索增強(qiáng)生成(RAG)中,生成器LM接收原始輸入x和檢索到的N個(gè)最相關(guān)段落??并生成輸出 y0 。雖然對(duì)于問(wèn)答等任務(wù)有效,但這種「一步登天」的生成方式可能會(huì)產(chǎn)生不符合要求的答案,或由于信息缺失而導(dǎo)致輸出不完整 。

為了應(yīng)對(duì)這些挑戰(zhàn),OpenScholar引入了一種帶有自我反饋的迭代生成方法,包括三個(gè)步驟:(1)初始響應(yīng)和反饋生成以輸出初始草稿y0以及一組反饋;(2)使用額外的搜索,根據(jù)上一步的反饋迭代改進(jìn)y0,以及(3)引文驗(yàn)證。

模型訓(xùn)練

由于缺乏針對(duì)該問(wèn)題的訓(xùn)練數(shù)據(jù),構(gòu)建能夠有效綜合科學(xué)文獻(xiàn)的強(qiáng)大LM非常具有挑戰(zhàn)性,之前的大多數(shù)工作并沒(méi)有設(shè)置開(kāi)放式檢索,而且是單論文任務(wù),而且依賴于沒(méi)有開(kāi)源的專(zhuān)有模型,這對(duì)復(fù)現(xiàn)性和推理成本提出了挑戰(zhàn)。

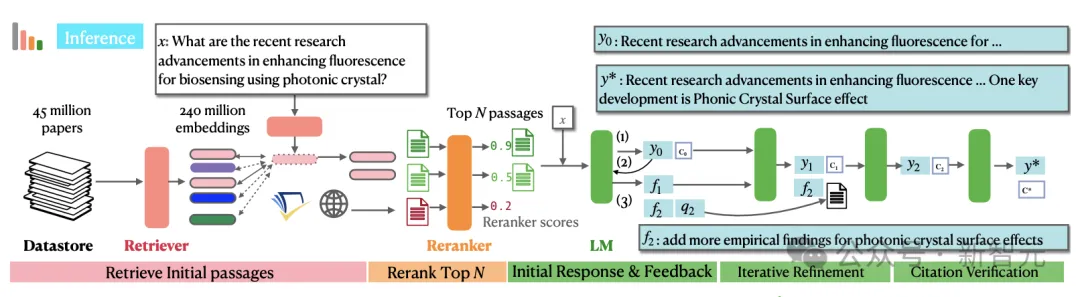

研究團(tuán)隊(duì)想到了采用上述的推理pipeline,通過(guò)自反饋合成高質(zhì)量的訓(xùn)練數(shù)據(jù),訓(xùn)練出「小而美」的OpenScholar LM模型,具體訓(xùn)練流程如下圖所示。

圖片

圖片

訓(xùn)練數(shù)據(jù)的生成主要包括三個(gè)步驟:

- 從數(shù)據(jù)庫(kù)??中篩選出最高引用量的論文

- 根據(jù)文章摘要生成一些有信息檢索目的的查詢

- 使用OpenScholar推理pipeline生成高質(zhì)量響應(yīng)

盡管合成數(shù)據(jù)是有效且可擴(kuò)展的,但也可能包含幻覺(jué)、語(yǔ)句重復(fù)、指令遵循有限等問(wèn)題,因此在上述步驟之后,團(tuán)隊(duì)還引入數(shù)據(jù)過(guò)濾步驟,包括「成對(duì)過(guò)濾」(pairwise-filtering)和標(biāo)題過(guò)濾。判斷并篩選出較高質(zhì)量的輸出。

從上述的合成管道中,可以得到三種類(lèi)型的訓(xùn)練數(shù)據(jù):答案生成(x→y),反饋生成(y0→??),以及反饋合并 (yt?1,ft→yt) 。論文指出,在訓(xùn)練期間結(jié)合中間結(jié)果和最終輸出有助于較小的語(yǔ)言模型學(xué)習(xí)生成更有效的反饋。

最后,研究人員將上述的合成數(shù)據(jù)與現(xiàn)有的通用領(lǐng)域+科學(xué)領(lǐng)域的指令調(diào)優(yōu)數(shù)據(jù)混合,并確保50%的訓(xùn)練數(shù)據(jù)來(lái)自科學(xué)領(lǐng)域。在這些數(shù)據(jù)上,團(tuán)隊(duì)將Llama 3.1 8B Instruct訓(xùn)練成了OpenScholar LM。

全新基準(zhǔn)ScholarQABench

ScholarQABench基準(zhǔn)旨在評(píng)估模型理解和綜合現(xiàn)有研究的能力。之前的基準(zhǔn)一般會(huì)預(yù)先劃定范圍,假設(shè)可以在某一篇論文中找到答案,但許多現(xiàn)實(shí)場(chǎng)景都需要識(shí)別多篇相關(guān)論文,并生成帶有準(zhǔn)確引用的長(zhǎng)文本輸出。

為了應(yīng)對(duì)這些挑戰(zhàn),研究人員整理了一個(gè)包含2967個(gè)文獻(xiàn)綜合問(wèn)題的數(shù)據(jù)集,以及由專(zhuān)家撰寫(xiě)的208個(gè)長(zhǎng)篇回答,涵蓋計(jì)算機(jī)科學(xué)、物理、生物醫(yī)學(xué)和神經(jīng)科學(xué)等4個(gè)學(xué)科。

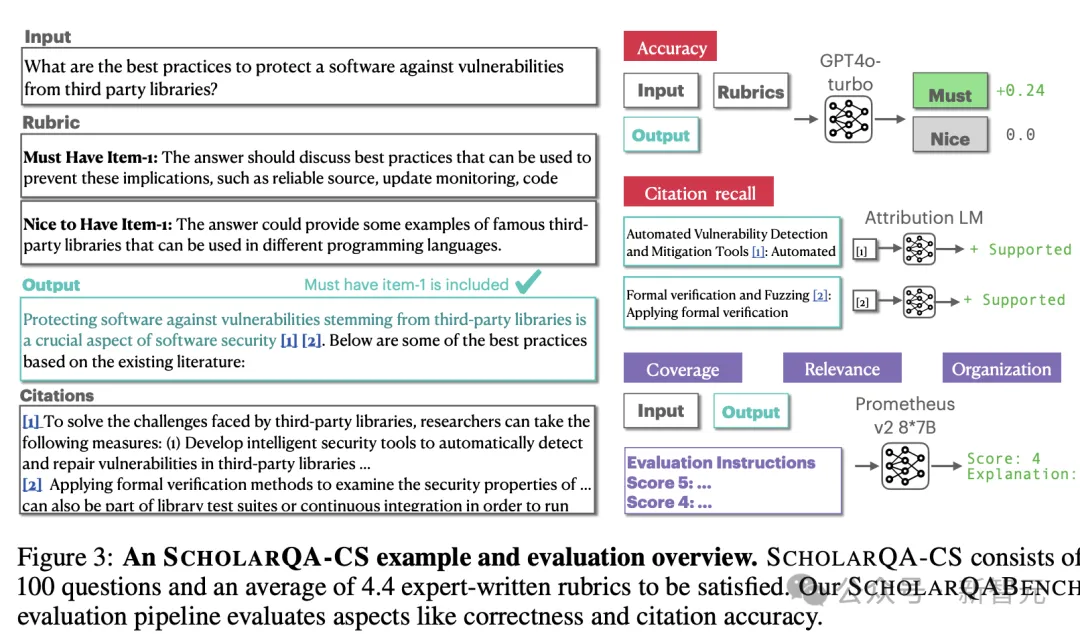

此外,基準(zhǔn)中引入了多方面的評(píng)估方案,結(jié)合了自動(dòng)指標(biāo)和人工評(píng)估,以衡量引文準(zhǔn)確性、事實(shí)正確性、內(nèi)容覆蓋率、連貫性和整體質(zhì)量,確保評(píng)估的穩(wěn)健和可重復(fù)性。

SchlarQA-CS的數(shù)據(jù)樣例和評(píng)估概述

SchlarQA-CS的數(shù)據(jù)樣例和評(píng)估概述

評(píng)估結(jié)果

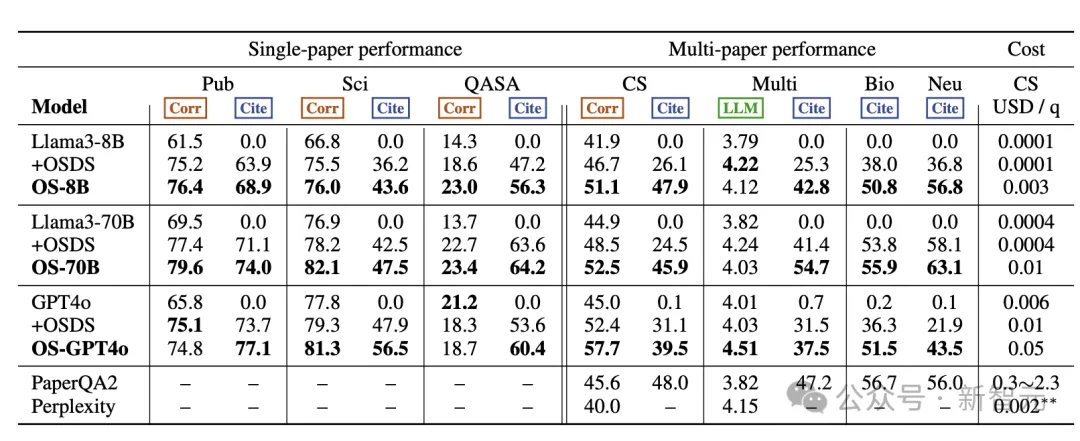

評(píng)估中使用了開(kāi)放權(quán)重模型Llama 3.1(8B、70B)以及專(zhuān)有模型GPT-4o(gpt-4o-2024-05-13)。

首先,在單論文任務(wù)中,每個(gè)LM在不連接外部檢索的情況下獨(dú)立生成答案,并提供所有參考論文的標(biāo)題。如果參考論文確實(shí)存在,則檢索相應(yīng)摘要以用作引文。

對(duì)于多論文任務(wù),團(tuán)隊(duì)還進(jìn)一步評(píng)估其他專(zhuān)有系統(tǒng),包括Perplexity Pro和PaperQA2,后者是一個(gè)并發(fā)文獻(xiàn)綜述智能體系統(tǒng),使用 GPT-4o進(jìn)行重排、總結(jié)和答案生成。

具體的評(píng)估結(jié)果如下表所示,其中+OSDS表示外接了數(shù)據(jù)庫(kù)OpenScholar-DataStore并檢索到top N段落拼接到原始輸入中;OS-8B模型經(jīng)過(guò)重新訓(xùn)練,OS-70B和OS-GPT-4o僅僅使用了團(tuán)隊(duì)自定義的推理pipeline。

圖片

圖片

總體而言, OpenScholar實(shí)現(xiàn)了SOTA性能,大大優(yōu)于GPT-4o和相應(yīng)的標(biāo)準(zhǔn)RAG版本,以及PaperQA2等專(zhuān)用的文獻(xiàn)綜述系統(tǒng)。

在單篇論文任務(wù)中, OpenScholar始終優(yōu)于其他模型。無(wú)論是否有檢索增強(qiáng),OS-8B和OS-70B均優(yōu)于原來(lái)的Llama 3.1模型,OS-70B在PubMedQA和QASA上甚至可以對(duì)打GPT-4o。

此外,OS-8B、OS-70B和OS-GPT4o在多論文任務(wù)中也表現(xiàn)出強(qiáng)大的性能,OS-GPT4o在Scholar-CS中比單獨(dú)的GPT-4o提高12.7%,比標(biāo)準(zhǔn)RAG版本提高了5.3 %。結(jié)合了重新訓(xùn)練過(guò)的OS-8B, OpenScholar 的性能顯著優(yōu)于使用現(xiàn)成的Llama 3.1 8B,說(shuō)明了特定領(lǐng)域訓(xùn)練的優(yōu)勢(shì)。

甚至,在多論文任務(wù)的很多指標(biāo)上,OpenScholar-8B的性能遠(yuǎn)遠(yuǎn)優(yōu)于GPT-4o、Perplexity Pro和PaperQA2。值得注意的是,通過(guò)利用輕量的bi-encodeer、cross-encoder構(gòu)建高效的檢索pipeline, OpenScholar-8B 和OpenScholar-GPT4o顯著降低了成本,在保持高性能的同時(shí)比PaperQA2便宜了幾個(gè)數(shù)量級(jí)。

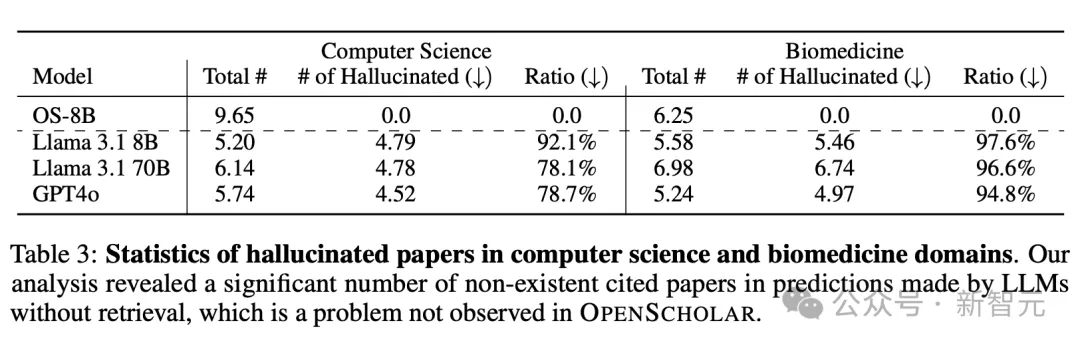

無(wú)論是單論文還是多論文任務(wù),沒(méi)有檢索增強(qiáng)的模型幾乎都表現(xiàn)的相當(dāng)糟糕,難以生成正確的引用,甚至?xí)a(chǎn)生嚴(yán)重的幻覺(jué),而增加了檢索之后都能大幅提升性能。

如表3所示,在沒(méi)有檢索增強(qiáng)的情況下,雖然GPT-4o和Llama等模型可以生成看起來(lái)靠譜的參考文獻(xiàn)列表,但其中78-98%的引文都是捏造的,而且這個(gè)問(wèn)題在生物醫(yī)學(xué)領(lǐng)域更加嚴(yán)重。即使指向了真實(shí)論文,大多也沒(méi)有相應(yīng)摘要的證實(shí),導(dǎo)致引文準(zhǔn)確性接近于零。

圖片

圖片

除了在ScholarQABench上進(jìn)行自動(dòng)評(píng)估外,團(tuán)隊(duì)還與來(lái)自計(jì)算機(jī)科學(xué)、物理學(xué)和生物醫(yī)學(xué)等領(lǐng)域的16名科學(xué)家合作,進(jìn)行了詳細(xì)的專(zhuān)家評(píng)估。

他們根據(jù)ScholarQABench中專(zhuān)家編寫(xiě)108個(gè)對(duì)文獻(xiàn)綜述問(wèn)題的答案,對(duì)OpenScholar的輸出進(jìn)行了成對(duì)和細(xì)粒度的評(píng)估。結(jié)果發(fā)現(xiàn),無(wú)論是使用GPT-4o還是經(jīng)過(guò)訓(xùn)練的8B模型,OpenScholar的表現(xiàn)始終優(yōu)于專(zhuān)家編寫(xiě)的答案,勝率分別為70%和51%。

相比之下,沒(méi)有檢索的單獨(dú)GPT-4o模型被認(rèn)為不如人類(lèi)專(zhuān)家有幫助,勝率僅為 31%。這表明OpenScholar生成的輸出更加全面、有條理,并且對(duì)于文獻(xiàn)綜述非常有用,不僅可以與專(zhuān)家撰寫(xiě)的答案相媲美,而且在某些情況下甚至超過(guò)了專(zhuān)家。

消融實(shí)驗(yàn)

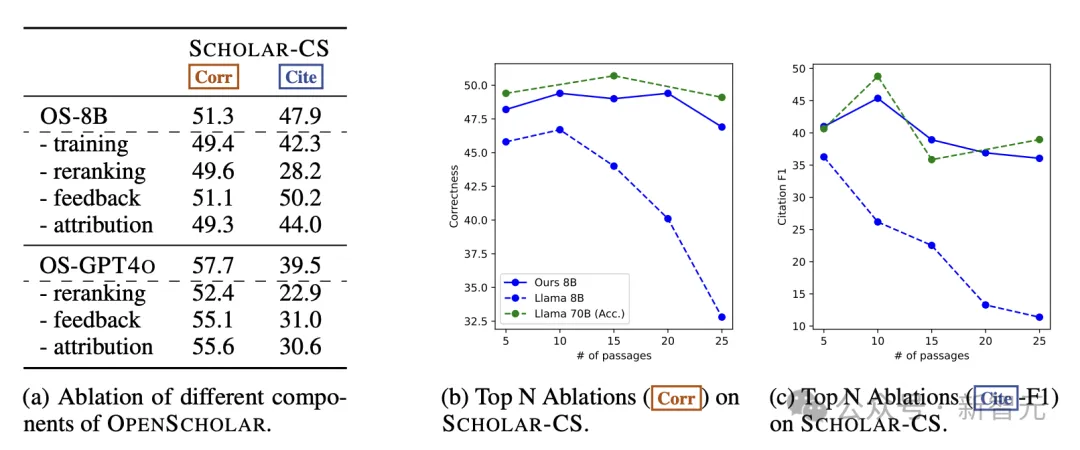

為了研究OpenScholar各個(gè)組件的有效性,作者進(jìn)行了詳細(xì)的消融實(shí)驗(yàn),涉及推理期的重排、反饋、查找文獻(xiàn)出處等步驟,并嘗試不進(jìn)行任何訓(xùn)練,直接使用原始的Llama3-8B模型。

如下圖所示,刪除這些組件會(huì)顯著影響模型輸出的整體正確性和引用準(zhǔn)確性。值得注意的是,刪除重排會(huì)導(dǎo)致模型性能大幅下降;相比8B模型,GPT-4o對(duì)刪除反饋循環(huán)更加敏感,這表明更強(qiáng)大的模型可以從自反饋循環(huán)中受益更多。

圖片

圖片

此外,取消論文出處的查找(attribution)會(huì)對(duì)引文準(zhǔn)確性和最終輸出正確性產(chǎn)生負(fù)面影響;經(jīng)過(guò)訓(xùn)練的OS-8B 與原始模型之間也存在顯著性能差距,這表明,對(duì)高質(zhì)量、特定領(lǐng)域數(shù)據(jù)的進(jìn)一步訓(xùn)練是構(gòu)建高效的、針對(duì)專(zhuān)門(mén)任務(wù)的語(yǔ)言模型的關(guān)鍵。

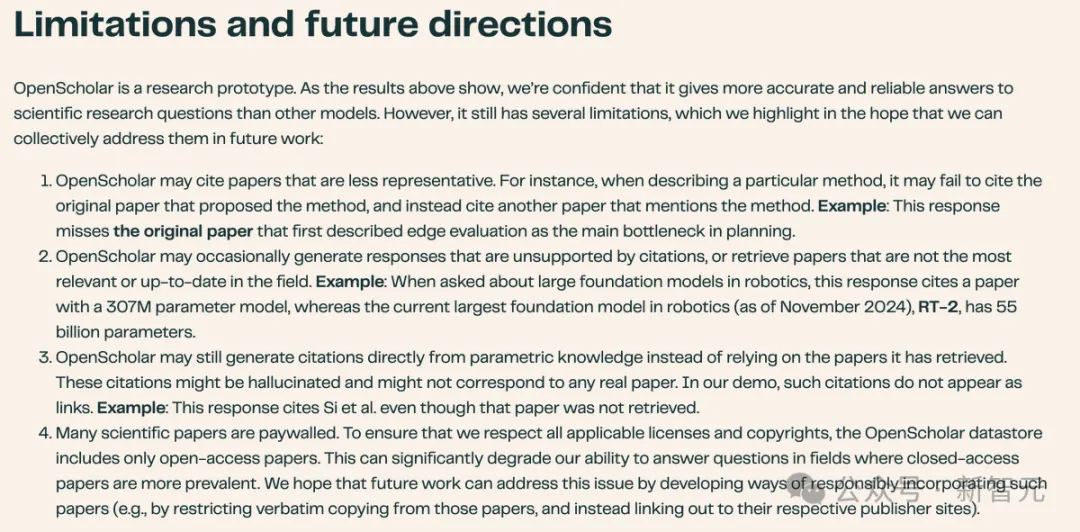

結(jié)論與局限性

盡管OpenScholar在ScholarQABench在評(píng)估中表現(xiàn)出了強(qiáng)大的性能,能夠成為支持科研人的效率工具,但負(fù)責(zé)標(biāo)注和評(píng)估的專(zhuān)家依舊發(fā)現(xiàn)了一些局限性。

圖片

圖片

首先,OpenScholar不能始終如一地檢索到最具代表性或相關(guān)性的論文,而且輸出總可能包含不準(zhǔn)確的事實(shí)信息,特別是在基于8B模型的版本中,科學(xué)知識(shí)和指令遵循能力有限。

未來(lái)的工作可以進(jìn)一步探索如何改進(jìn)OpenScholar-8B的訓(xùn)練。盡管OpenScholar-GPT4o具有競(jìng)爭(zhēng)力,但依賴于OpenAI的專(zhuān)有黑盒API,無(wú)法保證之后仍能精確復(fù)現(xiàn)當(dāng)下的結(jié)果。

此外,數(shù)據(jù)方面也存在諸多繁瑣且棘手的問(wèn)題。

第一,ScholarQABench聘請(qǐng)了領(lǐng)域?qū)<疫M(jìn)行數(shù)據(jù)標(biāo)注,他們都獲得了博士學(xué)位或正在從事相關(guān)研究。這種人工撰寫(xiě)答案的方式成本很高,因此評(píng)估數(shù)據(jù)集相對(duì)較小,比如,CS-LFQA包括110條數(shù)據(jù),專(zhuān)家編寫(xiě)的答案有108個(gè)。

這種數(shù)據(jù)集由于規(guī)模較小,更容易被注釋者的專(zhuān)業(yè)知識(shí)所影響,從而引入統(tǒng)計(jì)方差和潛在偏差。未來(lái)的研究需要探索,如何擴(kuò)大ScholarQABench的規(guī)模和范圍,實(shí)現(xiàn)更加自動(dòng)化的數(shù)據(jù)收集和標(biāo)注pipeline。

第二,最后, ScholarQABench主要關(guān)注計(jì)算機(jī)科學(xué)、生物醫(yī)學(xué)和物理學(xué)等領(lǐng)域,沒(méi)有社會(huì)科學(xué)和其他STEM學(xué)科的實(shí)例數(shù)據(jù)。因此,目前的研究結(jié)果可能無(wú)法完全推廣到其他領(lǐng)域,特別是在一些領(lǐng)域中,對(duì)論文數(shù)據(jù)的訪問(wèn)會(huì)受到更多限制。

最后,雖然OpenScholar在推理期沒(méi)有使用版權(quán)保護(hù)的論文,但如何確保檢索增強(qiáng)型的語(yǔ)言模型在訓(xùn)練和推理時(shí)做到對(duì)版權(quán)數(shù)據(jù)的公平使用,這方面的討論仍在進(jìn)行,也只能留待學(xué)界和業(yè)界在之后的工作中解決。

參考資料: