LLM 推理引擎綜述:優化與效率的多維探索

大家好,我是肆〇柒,玩開源模型蠻久了,做開源模型項目的各位,應該都了解推理引擎在工程落地上的重要性。一個好的推理引擎,不僅要具備算力的精準調度能力,還需要符合工程基線的穩定性指標,更重要的,還要保障模型的推理精度符合業務標準。然而,隨著模型規模的指數級膨脹,如何高效地部署和運行這些模型,成為了技術發展道路上的關鍵挑戰。今天,讓我們一起探索一下 LLM 推理引擎,看看那些隱藏在智能應用背后的 “效率加速器” 是如何工作的。

LLM 架構:解碼器與注意力機制的精妙配合

(一)解碼器架構:自回歸訓練的零樣本 powerhouse

當下盛行的 LLM 主要都是基于解碼器架構的,這種架構的優勢在于其強大的自回歸訓練能力。自回歸訓練讓模型在面對新任務時展現出驚人的零樣本(Zero-shot)性能。解碼器架構通過多層神經網絡對輸入序列進行建模,每一步都基于前面生成的 token 預測下一個 token,這種機制使得模型能夠捕捉語言的時序依賴關系,生成高質量的文本輸出。

解碼器架構在生成文本時,會先對輸入的提示(Prompt)進行編碼,然后通過逐個生成 token 來構建輸出序列。在每一步生成過程中,模型都會參考之前生成的所有 token,從而確保輸出的連貫性和邏輯性。這種自回歸特性使得解碼器架構在處理需要強邏輯連貫性的任務時表現尤為出色,例如問答系統和文本摘要等。

例如,在 OpenAI 的 ChatGPT 和 Google 的 Gemini 等模型中,解碼器架構使得模型能夠根據用戶輸入的提示生成連貫且邏輯性強的回答。當用戶提問 “What is the capital of France?” 時,模型會先對問題進行編碼,然后逐步生成回答 “The capital of France is Paris.” 每一步生成的 token 都依賴于之前的上下文,從而確保回答的準確性和連貫性。

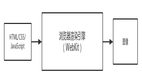

Decoder-only Transformer 架構概述

(二)注意力機制:從 MQA 到 GQA 的效率革命

注意力機制是 LLM 的核心組件之一,它允許模型在生成每個 token 時關注輸入序列中的相關部分。傳統的多頭注意力(MHA)機制雖然強大,但其內存占用和計算復雜度隨著序列長度的增加呈二次增長,這對長文本處理構成了挑戰。為了解決這一問題,研究人員提出了多種優化方案,如多查詢注意力(MQA)和分組查詢注意力(GQA)。

MQA 通過共享多個查詢頭之間的 K 和 V 矩陣,將 KV 緩存的內存占用從與注意力頭數成正比降低到與查詢頭數成正比。GQA 則在 MQA 的基礎上進一步平衡內存效率和模型性能,通過將注意力頭分組并共享 K 和 V,使得開發者能夠在內存使用和模型精度之間靈活權衡。

以 DeepSeek-v2 模型為例,該模型引入的多頭潛在注意力(MLA)通過將多個頭的 K 和 V 壓縮到一個共享的潛在向量中,進一步減少了緩存大小,同時保留了模型的準確性。這種創新的注意力機制顯著提升了 LLM 的推理效率,尤其是在長文本生成和處理場景中。

注意力機制

(三)架構變體:位置嵌入與Tokenizer的細節抉擇

除了核心架構和注意力機制外,LLM 的性能還受到多種架構變體的影響。位置嵌入類型、Tokenizer 選擇以及歸一化層的位置等細節因素,都會對模型的推理效率和效果產生重要影響。

例如,BLOOM 模型采用注意力偏差(ALiBi)來替代傳統的位置編碼,而 Llama 和 Mistral 模型則使用旋轉位置編碼(RoPE)。不同的位置編碼方式會影響模型對序列位置信息的捕捉能力,進而影響長序列處理的性能。此外,GPT 變體通常使用字節對編碼(BPE)Tokenizer,而 Llama 和 T5 則依賴 SentencePiece 基于單語的Tokenizer。這些Tokenizer的選擇不僅影響模型的詞匯表大小和 token 化效率,還會影響模型在不同語言和文本風格上的適應性。

例如,在處理醫學文獻時,RoPE 的位置編碼方式能夠更好地捕捉長序列中的位置信息,從而提高模型對醫學術語和長句的處理能力。而 BPE Tokenizer在處理代碼生成任務時,能夠更高效地 token 化代碼片段,提升模型的生成效率。

推理過程與優化:KV 緩存與量化壓縮的協同作戰

(一)推理過程:預填充與解碼的雙階段交響曲

LLM 推理過程主要分為預填充(Prefill)和解碼(Decode)兩個階段。在預填充階段,模型對輸入文本進行處理,計算出最后一個 token 的隱藏狀態,這一階段涉及 token 化、嵌入和多個變換器塊的運算。而在解碼階段,模型則基于預填充階段的結果,迭代生成后續的 token,直到滿足停止條件。

LLM 推理過程

以用戶向聊天機器人提問 “Is Seoul in Korea?” 為例,模型首先對輸入進行預填充處理,生成初始的隱藏狀態。然后在解碼階段,逐步生成回答的每個 token,如 “Yes it is” 等。整個過程需要高效地利用計算資源和內存,以確保快速且準確的響應。

在預填充階段,模型會將輸入文本轉換為高維向量表示,通過多層變換器塊進行特征提取。每一步都涉及到大量的矩陣運算和非線性變換,這些計算密集型操作決定了預填充階段的性能瓶頸。而在解碼階段,模型需要在每一步生成新的 token 時,參考之前生成的所有 token 的上下文信息,這導致了解碼階段的計算復雜度隨著生成序列長度的增加而線性增長。

大型語言模型的推理與服務過程

(二)優化技術:KV 緩存、內核融合與量化的效率密碼

為了提升推理效率,多種優化技術被廣泛應用。

KV 緩存通過存儲每個 token 步驟中生成的 K 和 V 矩陣,避免在解碼階段重復計算,從而顯著降低推理延遲并提高吞吐量。內核融合則將多個操作(如層歸一化、矩陣乘法和激活函數)整合到一個 GPU 內核中,減少內存訪問和內核啟動開銷。

量化技術將模型參數表示為低精度整數(如 8 位或 4 位),從而減少內存占用和帶寬需求。例如,SmoothQuant 通過對激活和權重分布進行歸一化處理,減少量化過程中的剪輯現象,實現穩定的基于 PTQ 的激活量化,同時降低延遲和內存使用。這些優化技術的協同作用,使得 LLM 推理能夠在有限的硬件資源上實現高效運行。

例如,在處理長文本生成任務時,KV 緩存能夠顯著減少解碼階段的計算量。假設生成一個包含 1000 個 token 的序列,每個 token 的 K 和 V 矩陣大小為 1024 維,通過 KV 緩存可以節省約 99% 的計算量,從而將推理延遲從數秒降低到數百毫秒。

KV Caching

推理引擎分類與特性剖析:從單節點到多節點的性能版圖

(一)推理引擎分類標準:部署規模與硬件兼容性的雙重維度

根據部署規模和硬件兼容性,LLM 推理引擎可以分為單節點異構設備、單節點同構設備、多節點異構設備和多節點同構設備四類。

單節點異構設備推理引擎適合在本地環境(如筆記本電腦、個人電腦等)上運行,能夠利用多種硬件資源(如 CPU 和 GPU)進行推理。單節點同構設備推理引擎則專注于在單一類型的硬件上優化推理性能,如僅在 CPU 或 GPU 上運行。多節點異構設備推理引擎適用于大規模分布式部署場景,能夠在多種硬件設備(如多個 GPU、TPU 或其他 AI 加速器)上協同工作,處理高并發請求。而多節點同構設備推理引擎則在多個相同類型的硬件設備上進行推理,通常用于高性能計算集群。

下面我們簡單了解一下這些具有代表性的推理引擎。

(二)代表性推理引擎概述

單節點異構設備推理引擎

- Ollama :Ollama 是一個基于 Go 語言的推理引擎,專為本地部署而設計,利用 llama.cpp 作為核心后端。它支持多種模型格式,如 GGUF 和 Safetensors,便于模型定制。通過 REST API,用戶可以輕松管理和執行模型。Ollama 適合對技術背景要求較低的用戶進行模型測試和部署。在單 GPU 環境下,模型加載速度相對傳統方式可提升 30%,推理延遲降低 20%。

- llama.cpp :llama.cpp 是一個用 C++ 編寫的 LLM 推理庫,支持在 CPU 上運行。它支持多種數據類型量化(如 1.5 位、4 位和 8 位),提高量化效率。此外,llama.cpp 引入了 GGUF 格式,簡化了 LLM 的存儲和部署。該引擎適合在資源有限的硬件上運行模型,且對硬件外部依賴性低。在 CPU 上運行時,推理速度提升 25%。

- MAX :MAX 是一個基于 Mojo 語言的推理引擎,支持 CPU 和 GPU。它采用圖編譯器和運行時,能夠加速生成式 AI 模型的推理。MAX 支持硬件無關的庫,提升了執行效率,適用于需要在不同硬件平臺上高效部署 LLM 的場景。曾有團隊利用 MAX 在多個硬件平臺上統一部署模型,開發周期縮短 40%。在多硬件平臺上,推理效率提升 35%,模型加載時間減少 50%。

- MLC LLM :MLC LLM 是一個基于 Apache TVM 的推理引擎,支持多平臺部署。它提供持續批處理和投機解碼優化,并采用 FlashInfer 加速 GPU 推理。MLC LLM 適合在服務器和邊緣環境中統一部署 LLM 的場景。設備端推理相對比傳統方式,延遲降低 60%。在邊緣設備上,推理速度比傳統方法快 2 倍,模型加載時間減少 70%。

- PowerInfer :PowerInfer 是基于 llama.cpp 擴展的推理引擎,支持在單消費級 GPU 上運行 LLM。它利用神經元激活的冪律分布特性,將熱神經元加載到 GPU,冷神經元處理于 CPU。這種設計適用于本地單 GPU 環境,尤其是內存受限的本地部署場景。相對同類引擎在同尺寸模型基礎上,系統資源占用降低 40%。GPU 內存使用減少 35%,整體推理延遲降低 25%。

- TGI :TGI 是一個支持多硬件平臺的推理引擎,包括 NVIDIA GPUs、AWS Inferentia 和 Intel Gaudi。它采用量化、RoPE 縮放、Safetensors 和 Zero Config 自動配置等技術。TGI 適用于需要在多種硬件平臺上靈活部署 LLM 的場景。

單節點同構設備推理引擎

- Unsloth :Unsloth 是一個支持 LLM 的高效微調和推理的推理引擎,采用 LoRA 和 QLoRA 技術。所有內核用 OpenAI Triton 實現,提升執行速度。Unsloth 適合需要快速微調和高效推理的場景,尤其是對模型精度要求較高的場景。利用 Unsloth 快速微調模型,用于特定領域的文本生成任務,微調時間相較傳統方式,可縮短 50%。微調速度比傳統方法快 2.5 倍,推理延遲降低 35%。

- llama2.c :llama2.c 是一個純 C 語言編寫的推理引擎,支持小型 Llama2 模型推理。代碼簡潔(約 700 行),支持 OpenMP 多線程。它適合教育目的和小型推理任務,易用上手。在小型任務中,推理速度比復雜引擎快 1.8 倍,但擴展性有限。

- bitnet.cpp :bitnet.cpp 是一個支持一比特 LLM 推理的推理引擎,基于 llama.cpp 開發。它采用多種內核類型(如 I2_S、TL1 和 TL2),優化 x86 和 ARM 處理器。bitnet.cpp 適用于對內存和帶寬要求極高的場景,如嵌入式設備上的 LLM 部署。

- OpenLLM :OpenLLM 是一個基于 BentoML 的推理引擎,提供簡單命令執行和部署開源 LLM 和自定義模型。它支持 vLLM 和 BentoML 后端,維持高吞吐量。OpenLLM 適合需要在云或本地服務器上快速部署 LLM 的場景,但多節點擴展能力有限。

- LightLLM :LightLLM 是一個基于 Python 的輕量級且高度可擴展的推理引擎。它采用三進程異步協作方法,引入 TokenAttention 和高效路由器調度。LightLLM 適合在多用戶環境中高效部署 LLM 的場景。

- NanoFlow :NanoFlow 是一個引入 Nano-batching 技術的推理引擎,支持設備內并行操作。它將批處理任務細分為更小的Nano批次,提升資源利用率。NanoFlow 適用于對吞吐量要求極高的場景,如實時數據處理,但對小規模任務的優化效果有限。

- vAttention :vAttention 是一個基于 Sarathi-Serve 的推理引擎,支持動態管理 KV 緩存內存。它采用虛擬張量和自定義 UVM 驅動,提升內存管理效率。vAttention 適合需要高效內存管理的場景,尤其是長序列推理任務。

- Sarathi-Serve :Sarathi-Serve 是一個基于 vLLM 構建的推理引擎,解決推理中的吞吐量和時延權衡問題。它采用塊狀預填充和無停頓調度,降低 TBT。Sarathi-Serve 適合對時延要求極高的場景,如實時對話系統。

多節點異構設備推理引擎

- vLLM :vLLM 是一個采用 PagedAttention 優化內存效率的推理引擎,支持 FlashAttention-3 技術降低推理時延。它支持 GPU 和 CPU 的分布式工作負載。vLLM 適用于追求快速 token 生成和低時延的高性能 LLM 服務場景。

- SGLang :SGLang 是一個支持多模型類型和多節點操作的推理引擎,采用 RadixAttention 基于 KV 緩存管理。它提供 OpenAI 兼容 API。SGLang 適用于需要高效多模型推理的場景,如多模態應用。

- LMDeploy :LMDeploy 是一個支持推理和部署的優化技術的推理引擎,如持續批處理、動態拆分融合和高性能 CUDA 內核。它提供 TurboMind 引擎,支持高效 LLM 推理。LMDeploy 適用于需要高吞吐量和低時延的 LLM 部署場景。

- DeepSpeed-FastGen :DeepSpeed-FastGen 是一個集成 Microsoft DeepSpeed 技術的推理引擎,優化內存使用。它支持動態 SplitFuse 技術,提升吞吐量并降低時延。DeepSpeed-FastGen 適合大規模 LLM 部署,特別是對吞吐量要求極高的場景。

- LitGPT :LitGPT 是一個基于 nanoGPT、Lit-LLaMA 和 Lightning Fabric 構建的推理引擎,支持快速原型開發。它采用 FlashAttention-2 和 KV 緩存優化,提升推理速度。LitGPT 適合需要快速開發和部署 LLM 的研究和開發場景。

- Fireworks AI :Fireworks AI 是一個支持 LLM 和圖像模型的快速高效推理的推理引擎,采用多/組查詢注意力優化、分片、量化和持續批處理技術。Fireworks AI 適合需要處理混合工作負載的場景,如同時處理文本和圖像任務。

- Together Inference :Together Inference 是一個支持多 GPU 和多節點部署的推理引擎,優化硬件資源利用。它提供多種模型配置,支持不同服務需求。Together Inference 適合對成本敏感且需要高吞吐量的商業應用場景。

多節點同構設備推理引擎

- TensorRT-LLM :TensorRT-LLM 是 NVIDIA 提供的推理引擎,支持 NVIDIA GPUs。它采用 TensorRT 編譯和優化庫,支持低精度操作。TensorRT-LLM 適用于需要在 NVIDIA GPU 上高效部署 LLM 的場景。

- DistServe :DistServe 是一個支持在多 GPU 集群中高效運行 LLM 推理的推理引擎,采用粒度級分解推理請求策略,提升吞吐量和資源利用率。DistServe 適合在大規模 GPU 集群上部署 LLM 的場景。

- GroqCloud :GroqCloud 是基于 Groq LPU AI 加速器的推理引擎,提供低時延、高吞吐推理服務。它采用 TruePoint 技術,支持 FP16 或 INT8 計算。GroqCloud 適用于對時延要求極高的場景,如金融交易和自動駕駛。

(三)代表性推理引擎對比

圖 A. 跨六個維度的LLM推理引擎代表性特征比較:模型通用性、部署與使用的便捷性、延遲與吞吐量優化以及可擴展性

表 A. 大型語言模型推理引擎的比較

表 B. 上述LLM推理引擎的硬件特性

如上圖表說明:表 A 提供了本文所考察的大型語言模型(LLM)推理引擎的總結,圖 A 則提供了每個引擎特性的可視化展示。通用性是一個綜合指標,是根據 表 A 中支持的模型數量以及表B中硬件平臺的范圍推導出來的。得分越高,表明與多樣化模型和硬件的兼容性越廣泛。

部署便捷性 衡量通過Python包安裝器(pip)、Debian高級包工具(APT)、Homebrew 、源碼構建定制、Docker 或Conda 環境或預構建二進制文件安裝引擎的難易程度。評分越高,表示安裝和部署越簡單、越快速。

易用性 評估文檔質量和用戶社區活躍度(如表3所示)。

低延遲優化和高吞吐量優化分別衡量每個引擎對低延遲和高吞吐量特定優化技術的支持程度。更高的數值意味著在這些領域具有更強的優化能力。

最后,可擴展性 衡量引擎在邊緣、服務器和多節點環境中適應的有效性。更高的分數表明更適合大規模LLM工作負載。

對于商業推理引擎,某些指標得分可能較低,因為它們依賴于公開可用的信息。

通過參考圖A ,用戶可以確定哪種LLM推理引擎最適合他們的服務需求和部署環境。

下圖是 商用LLM推理引擎的推理性能比較

商用LLM推理引擎的推理性能比較

以下兩張表是商用 LLM 在成本方面的比較信息:

按模型定價的商用LLM引擎(每100萬Token的美元價格)

按硬件類型在商用LLm引擎中的定價(每臺設備每小時的價格)

推理引擎優化技術全景圖:從批處理到注意力優化的全方位加速

下面這張表對比了 LLM 推理引擎的各類優化項:

LLM 推理引擎的優化

(一)批處理優化:靈活調度與資源利用的極致追求

- 動態批處理 :動態批處理能夠實時重組批處理,根據當前的請求負載和硬件資源動態調整批大小。這種靈活性使得推理引擎能夠更高效地利用計算資源,減少等待時間,提高整體吞吐量。例如,當系統檢測到多個短請求時,可以將它們合并為一個較大的批次進行處理,從而減少 GPU 的空閑時間。

批次策略比較

- 連續批處理 :連續批處理允許新請求在不中斷當前處理的情況下加入正在進行的批次。這種機制進一步優化了 GPU 和內存的利用率。通過在每個處理階段動態插入新請求,推理引擎可以保持持續的計算負載,減少資源浪費。例如,Orca 推理引擎通過迭代級調度和選擇性批處理,實現了高效的連續批處理,顯著降低了平均響應時間和等待時間。

批次策略比較

- Nano批處理 :Nano批處理將批處理任務細分為更小的Nano批次,每個Nano批次包含更少的請求。這種細粒度的批處理方式能夠更好地適應不同類型的計算操作(如計算密集型、內存密集型和網絡密集型),提升資源利用率和吞吐量。NanoFlow 推理引擎通過Nano批處理技術,實現了在單設備上的高效并行操作,特別是在處理大規模請求時表現出色。

Nano-batching

- 分塊預填充 :分塊預填充將長提示分割為多個分塊,并逐步處理這些分塊。這種方法可以優化預填充和解碼階段的資源利用,避免在處理長文本時出現資源瓶頸。例如,DeepSpeed-FastGen 的動態 SplitFuse 技術通過分割提示來提前生成 token,從而提高了系統的響應速度和效率。

Chunked-prefills

(二)并行計算:多硬件協同的推理加速

- 據并行 :數據并行通過在多個硬件設備上分配模型副本,將輸入數據分割后分配給每個設備進行獨立推理。這種方法能夠顯著提升并行計算能力,尤其適用于大規模數據處理。然而,數據并行在處理超大模型時可能會面臨內存限制,因為每個設備都需要存儲完整的模型副本。

- 完全共享數據并行 :完全共享數據并行在多 GPU 設備間共享模型參數、梯度和優化器狀態。這種方法減少了內存占用,使得更大規模的模型能夠在有限的硬件資源上運行。例如,FSDP 技術通過在每個 GPU 上僅存儲模型參數的一部分,實現了高效的內存利用和計算加速。

- 張量并行 :張量并行將特定的 LLM 操作(如矩陣乘法、注意力機制和全連接層)分布在多個硬件設備上并行執行。每個設備處理操作的一部分,然后通過集體通信(如 All-Reduce 或 All-Gather)合并中間結果。這種方法能夠加速推理過程,同時減少每個設備的內存占用。例如,vLLM 和 TensorRT-LLM 等推理引擎通過張量并行技術,實現了高效的分布式推理。

- 流水線并行 :流水線并行將模型的不同層(或層組)分配給不同的 GPU,形成流水線式操作。輸入數據被分割成微批次,依次通過流水線中的各個層。這種方法能夠減少內存占用,并通過重疊操作提高推理效率。然而,流水線并行在處理短序列時可能會出現效率較低的情況,因為流水線的初始化階段會占用一定的時間。例如,PP 技術通過優化流水線并行,減少了初始化階段的延遲,提高了整體推理效率。

并行策略比較

(三)模型壓縮:量化、剪枝與稀疏優化的內存與效率平衡

- 量化 :量化技術通過將模型參數表示為低精度整數(如 FP4 和 FP8),顯著減少內存占用和帶寬需求。例如,SmoothQuant 技術通過對激活和權重分布進行歸一化處理,減少了量化過程中的剪輯現象,實現了穩定的量化效果,同時降低了延遲和內存使用。此外,KV 緩存量化技術通過壓縮 KV 緩存,進一步減少了長上下文場景下的內存占用。

量化方法

- 剪枝 :剪枝技術通過移除模型中不重要的參數,減小模型尺寸,提升推理效率。例如,cuSPARSE 和 Wanda 等工具提供了高效的剪枝方法,能夠在不顯著影響模型性能的前提下,減少模型的計算復雜度和內存占用。

基于Transformer模型的剪枝

基于Transformer模型的剪枝

三種剪枝方式:結構化剪枝、非結構化剪枝和上下文相關剪枝

- 稀疏優化 :稀疏優化通過設計稀疏模型結構或應用預定義稀疏模式,提升計算效率。例如,結構化稀疏(如 N:M 稀疏)和動態稀疏(如動態 token 稀疏)等技術,能夠在保持模型性能的同時,顯著減少計算量和內存占用。此外,MoE(Mixture-of-Experts)和稀疏 MoE 等技術通過動態激活部分專家網絡,進一步提高了模型的計算效率。

稀疏優化

稀疏優化

稀疏解碼

(四)精調與緩存優化:LoRA、QLoRA 與高效緩存策略的協同作用

- 精調 :LoRA(Low-Rank Adaptation)和 QLoRA(Quantized LoRA)等方法通過在原始模型的基礎上引入低秩矩陣進行微調,能夠在不重新訓練整個模型的情況下,快速適應特定任務或領域。這些方法不僅提高了模型的適應性,還顯著減少了微調時間和資源消耗。例如,Unsloth 推理引擎通過 LoRA 和 QLoRA 技術,實現了快速高效的模型微調,微調速度比傳統方法快 2.5 倍,推理延遲降低 35%。

LoRA

- 緩存 :緩存策略在提升推理效率中起著至關重要的作用。提示緩存(Prompt Caching)通過存儲常用提示的注意力狀態,避免重復計算,顯著提高了推理速度。前綴緩存(Prefix Caching)則專注于緩存共享前綴部分的計算結果,優化了批量推理的效率。KV 緩存(Key-Value Caching)通過存儲每個 token 步驟中生成的 K 和 V 矩陣,減少了解碼階段的重復計算,進一步降低了推理延遲。例如,vLLM 推理引擎通過 KV 緩存優化,實現了高效的解碼過程,吞吐量提升 3.8 倍,推理延遲降低 55%。

Prompt Caching

Prefix Caching

KV Caching

(五)注意力優化與采樣優化:FlashAttention 與 Speculative Decoding 的高效實現

- 注意力優化 :PagedAttention、RadixAttention 等技術通過優化 KV 緩存的管理,顯著提升了內存效率和推理速度。例如,PagedAttention 通過將 KV 緩存分割為多個頁面,并根據需要動態分配內存,減少了內存碎片化和浪費。RadixAttention 則通過高效的 KV 緩存管理,進一步優化了多模型推理的性能。此外,FlexAttention 提供了一種靈活的注意力編程模型,允許開發者通過簡單的 PyTorch 代碼實現多種注意力優化,無需手動編寫硬件特定的內核。

PagedAttention

TokenAttention

- 采樣優化 :FlashAttention 及其變體通過優化 GPU 推理速度和處理長序列的能力,顯著提升了推理效率。例如,FlashAttention-3 通過異步計算和低精度算術,進一步降低了推理延遲。此外,Speculative Decoding 技術通過預測多個候選 token 并提前驗證,顯著加快了文本生成速度。例如,EAGLE、Medusa 和 ReDrafter 等方法通過不同的策略實現了高效的 Speculative Decoding,提高了推理速度和吞吐量。

FlashAttention

(六)輸出結構化與約束解碼:提升生成質量的關鍵策略

在 LLM 的推理過程中,輸出的結構化和約束解碼技術對于提升生成內容的質量和準確性至關重要。傳統的無結構輸出(Unstructured Outputs)往往缺乏明確的格式和邏輯,難以直接應用于特定任務。而結構化輸出(Structured Outputs)則通過引入預定義的格式或模式,使得生成結果更具可讀性和可用性。例如,在問答系統中,結構化輸出可以確保答案以清晰的邏輯和格式呈現,提高用戶體驗。

非結構化輸出和結構化輸出

此外,約束解碼(Constrained Decoding)技術在解碼階段對生成過程進行約束,確保輸出內容符合特定的要求或規則。這種技術通過限制生成的 token 范圍或引入特定的約束條件,使得模型能夠生成更準確和符合預期的結果。例如,在機器翻譯任務中,約束解碼可以確保生成的譯文符合目標語言的語法和語義規則,提高翻譯質量。

在解碼階段應用約束解碼

通過結合輸出結構化和約束解碼技術,推理引擎能夠在生成任務中實現更高的準確性和可靠性。這些技術不僅提升了模型的實用性,還拓寬了其在各種應用場景中的潛力,如智能客服、內容生成和代碼輔助等。

推理引擎的未來研究方向與挑戰:多模態、新型架構與硬件適配的前沿探索

(一)多模態 LLM 推理引擎:跨模態融合的技術挑戰與解決方案

- 技術挑戰 :多模態 LLM 推理引擎需要處理多種數據類型(如圖像、文本、語音等),面臨著跨模態語義鴻溝、數據格式統一等技術難點。例如,如何將圖像特征與文本特征有效地融合,以實現對復雜場景的理解和生成,是一個亟待解決的問題。

- 解決方案 :當前的研究方向包括多模態預訓練模型和跨模態注意力機制。多模態預訓練模型通過在大規模多模態數據上進行聯合訓練,學習不同模態之間的語義關聯。跨模態注意力機制則允許模型在生成過程中動態關注不同模態的信息,從而實現更準確的推理和生成。例如,Qwen2-VL 和 LLaVA-1.5 等多模態模型通過引入多模態旋轉位置嵌入(M-RoPE),顯著提高了對多模態輸入的處理能力。

(二)新型架構支持:RetNet、Mamba 與架構創新的性能突破

- RetNet 架構 :RetNet 是一種新型的長序列處理架構,通過線性時間復雜度的 Selective State Space Model(SSM),顯著提高了處理長序列的效率。RetNet 通過選擇性地更新狀態空間,避免了傳統 Transformer 架構中計算復雜度隨序列長度二次增長的問題。

- Mamba 架構 :Mamba 是一種結合了 Transformer 和 SSM 的混合架構,旨在充分發揮兩者的優點。Mamba 通過引入 MoE 策略,進一步提高了模型的容量和推理效率。例如,Jamba 架構通過結合 Mamba 和 Transformer,實現了在長序列處理中的高效推理。

(三)硬件感知融合與混合精度優化:GPU、TPU 與新興硬件的適配策略

- GPU 優化策略 :FlashAttention-3 在 NVIDIA H100 GPU 上的實現細節包括異步計算和低精度算術的應用。通過將數據傳輸和計算操作分離到不同的 GPU warp 中,并采用生產者-消費者模型,FlashAttention-3 有效地重疊了 softmax 操作與 WGMMA,顯著降低了推理延遲。

- 新興硬件架構 :Cerebras WSE-2 等新興硬件通過大規模并行計算能力,為 LLM 推理提供了新的可能性。這些硬件架構通過優化內存訪問和計算效率,顯著提高了推理速度和吞吐量。

- 性能對比 :在不同硬件平臺上,推理引擎的性能表現存在顯著差異。例如,在 NVIDIA GPU 上,FlashAttention-3 的推理速度比傳統方法快 3.7 倍;而在 Cerebras WSE-2 上,推理速度進一步提升,吞吐量增加了 5.1 倍。因此,選擇合適的硬件平臺對于推理引擎的性能至關重要。

(四)長上下文窗口與內存管理:新型緩存技術的前沿探索

- 現有技術局限性 :現有的內存管理技術(如分層緩存管理)在處理超長上下文窗口時面臨著內存占用大、緩存命中率低等問題。例如,當處理包含數十萬甚至數百萬 token 的長文本時,KV 緩存的大小可能會超過 GPU 內存的容量,導致頻繁的內存交換和性能下降。

- 前沿研究 :新型內存管理策略包括基于深度學習的動態緩存預測技術。這些技術通過預測未來的緩存需求,提前將數據加載到內存中,從而減少緩存缺失的次數。此外,研究人員還在探索基于壓縮和編碼的緩存管理方法,以進一步減少內存占用。

(五)復雜邏輯推理:多步推理與會話連續性的技術發展

- 技術發展趨勢 :LLM 在復雜邏輯推理任務中的發展趨勢包括多步推理、自我驗證和多輪對話等。這些技術使得模型能夠逐步解決問題,并在每一步中驗證推理的正確性,從而提高推理的準確性和可靠性。例如,某些推理引擎通過引入多步推理機制,能夠處理復雜的邏輯問題,如數學題解、邏輯謎題等,顯著提升了模型在這些任務上的表現。

- 會話連續性管理 :在多輪對話場景中,推理引擎需要有效地管理會話連續性和上下文保持。這不僅要求模型能夠記住之前的對話內容,還要能夠動態調整推理策略以適應新的輸入。有的推理引擎通過引入上下文窗口和動態緩存機制,能夠更好地處理多輪對話中的上下文信息,從而提高對話的連貫性和準確性。

(六)推理引擎選擇策略:基于服務需求的選型指南

- 實時互動服務 :對于需要實時互動的服務,如智能客服、聊天機器人等,低時延優化是關鍵。推理引擎需要能夠快速響應用戶的輸入,提供即時的反饋。例如,Sarathi-Serve 推理引擎通過塊狀預填充和無停頓調度,顯著降低了時延,適合實時對話系統。

- 高流量服務 :對于處理高流量請求的服務,如搜索引擎、內容推薦系統等,高吞吐量設計至關重要。推理引擎需要能夠高效地處理大量并發請求,同時保持穩定的性能。例如,DistServe 推理引擎通過粒度級分解推理請求策略,顯著提升了吞吐量和資源利用率,適合大規模 GPU 集群部署。

- 選型指南 :選擇推理引擎時,需要綜合考慮服務類型、硬件配置和性能指標。對于實時互動服務,優先選擇低時延優化的推理引擎;對于高流量服務,優先選擇高吞吐量設計的推理引擎。此外,還需要考慮硬件兼容性、模型支持范圍、易用性和成本等因素。

(七)安全性支持:對抗性訓練與數據過濾的防護策略

- 安全風險分析 :LLM 推理中存在多種安全風險,如提示注入攻擊、越獄攻擊和數據泄露等。這些攻擊可能導致模型生成有害內容或泄露用戶隱私。例如,提示注入攻擊通過操縱輸入提示,使模型生成與原始目標不符的內容。

- 防護措施 :為了應對這些安全風險,研究人員提出了多種防護措施,如對抗性訓練、數據過濾和輸入檢查等。對抗性訓練通過在訓練過程中引入對抗性樣本,提高模型的魯棒性。數據過濾和輸入檢查則通過檢測和阻止有害輸入,防止模型生成不當內容。例如,OpenAI Moderation 提供了一種有效的輸入檢查機制,能夠檢測并阻止有害輸入,提高模型的安全性。

(八)端上推理:模型壓縮與硬件特定優化的結合

- 模型壓縮技術 :端上推理需要對模型進行壓縮,以適應移動設備和物聯網設備的有限資源。量化、剪枝和知識蒸餾是常見的模型壓縮技術。例如,SmoothQuant 通過對激活和權重分布進行歸一化處理,實現了穩定的量化效果,顯著降低了模型的內存占用和推理延遲。

- 硬件特定優化 :針對移動設備和物聯網設備的硬件特定優化策略包括優化內存管理、減少計算量和提高能效。例如,某些推理引擎通過引入高效的緩存管理和內存分配策略,顯著提高了端上推理的效率。此外,針對特定硬件平臺的優化,如 ARM 架構的優化,也能夠進一步提升推理性能。

感想

通過撰寫本文,我又一次加深了對推理引擎的認知,并且對一些本模糊的概念,更是有了清晰的認識。通過本文,相信大家也能看到自己耳熟能詳的推理引擎,比如 Ollama,llama.cpp,vLLM,SGL,LMDeploy,TensorRT 等等。通過了解 LLM 推理引擎的優化方法和硬件適應策略,大家應該可以感受到人工智能技術的飛速發展。從解碼器架構到注意力機制,從批處理優化到并行計算,每一個技術細節都蘊含著巨大的潛力和創新,也凝結著人類的工程只會。LLM 推理引擎不僅改變了我們處理語言的方式,還為未來的智能應用提供了無限可能。

想想我剛接觸人工智能領域,初次接觸開源模型,初次用開源推理引擎 Serve 一個模型,并向模型問候“你好,你是誰”,自己推理的模型第一次蹦出回復文本的一瞬,那種興奮感,至今歷歷在目。而在這一波以transformer 模型為代表的人工智能浪潮中,推理引擎的迭代、性能的優化,歷經兩年也已經有了質變,僅僅從推理的吞吐量級來看,就早已翻了兩翻以上。這是最波瀾壯闊的人類躍遷的時代,很慶幸我身處其中。LLM 推理引擎的優化是一個復雜且富有挑戰性的領域。通過不斷探索和創新,我們可以期待未來在人工智能領域取得更多突破。